Python을 사용한 동적 웹 페이지 스크래핑 – 방법 가이드

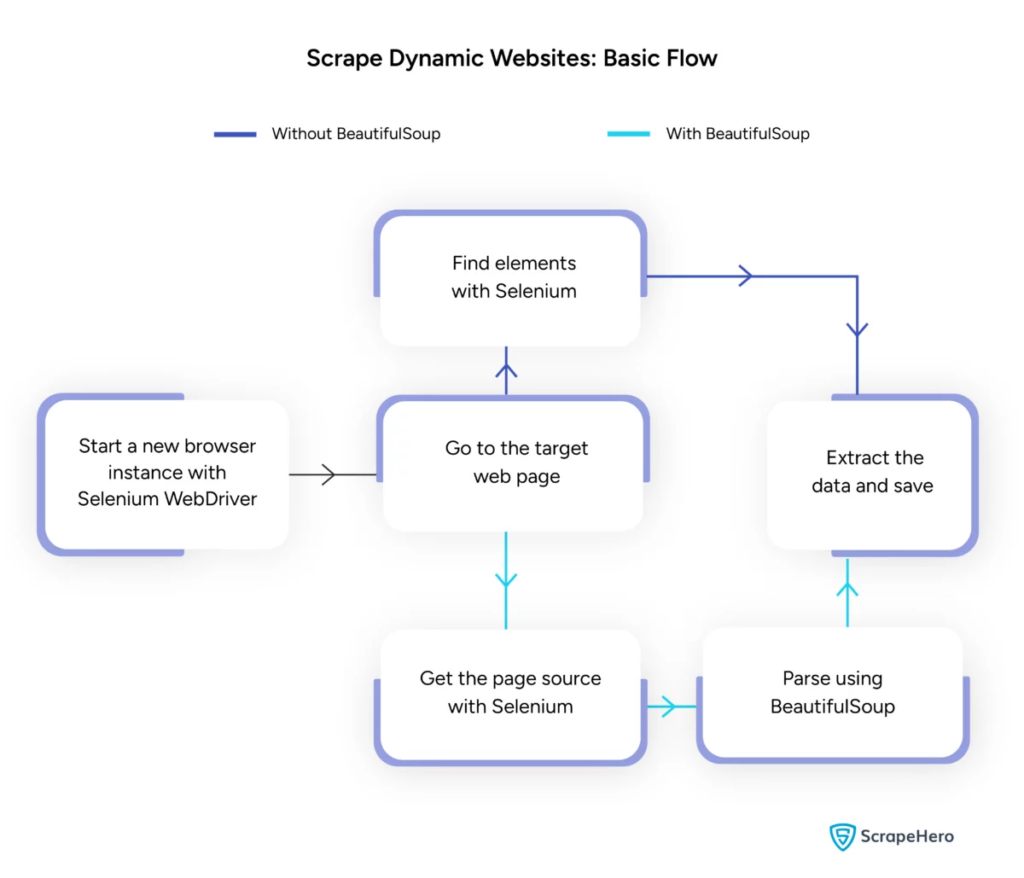

게시 됨: 2024-06-08동적 웹 스크래핑에는 JavaScript 또는 Python을 통해 실시간으로 콘텐츠를 생성하는 웹사이트에서 데이터를 검색하는 작업이 포함됩니다. 정적 웹 페이지와 달리 동적 콘텐츠는 비동기식으로 로드되므로 기존 스크래핑 기술은 비효율적입니다.

동적 웹 스크래핑은 다음을 사용합니다.

- AJAX 기반 웹사이트

- 단일 페이지 애플리케이션(SPA)

- 지연된 로딩 요소가 있는 사이트

주요 도구 및 기술:

- Selenium – 브라우저 상호 작용을 자동화합니다.

- BeautifulSoup – HTML 콘텐츠를 구문 분석합니다.

- 요청 – 웹페이지 콘텐츠를 가져옵니다.

- lxml - XML과 HTML을 구문 분석합니다.

동적 웹 스크래핑 Python을 사용하려면 실시간 데이터를 효과적으로 수집하기 위해 웹 기술에 대한 더 깊은 이해가 필요합니다.

이미지 출처: https://www.scrapehero.com/scrape-a-dynamic-website/

Python 환경 설정

동적 웹 스크래핑 Python을 시작하려면 환경을 올바르게 설정하는 것이 필수적입니다. 다음과 같이하세요:

- Python 설치 : Python이 컴퓨터에 설치되어 있는지 확인합니다. 최신 버전은 공식 Python 웹사이트에서 다운로드할 수 있습니다.

- 가상 환경 생성 :

가상 환경을 활성화합니다.

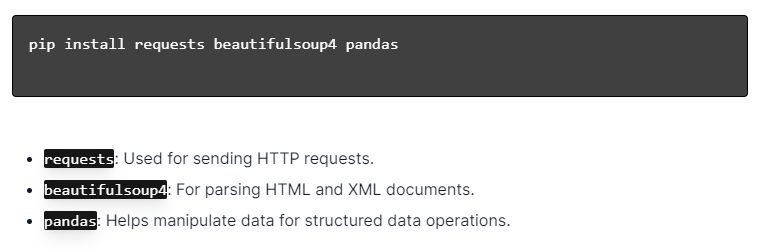

- 필수 라이브러리 설치 :

- 코드 편집기 설정 : PyCharm, VSCode 또는 Jupyter Notebook과 같은 IDE를 사용하여 스크립트를 작성하고 실행합니다.

- HTML/CSS 익히기 : 웹페이지 구조를 이해하면 데이터를 효과적으로 탐색하고 추출하는 데 도움이 됩니다.

이러한 단계는 동적 웹 스크래핑 Python 프로젝트를 위한 견고한 기반을 구축합니다.

HTTP 요청의 기본 이해

이미지 출처: https://developer.mozilla.org/en-US/docs/Web/HTTP/Overview

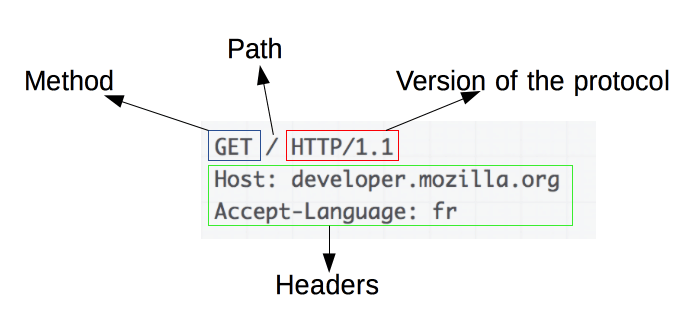

HTTP 요청은 웹 스크래핑의 기초입니다. 웹 브라우저나 웹 스크레이퍼와 같은 클라이언트가 서버에서 정보를 검색하려고 하면 HTTP 요청을 보냅니다. 이러한 요청은 특정 구조를 따릅니다.

- Method : GET, POST 등 수행할 작업입니다.

- URL : 서버의 리소스 주소입니다.

- 헤더 : 콘텐츠 유형 및 사용자 에이전트와 같은 요청에 대한 메타데이터입니다.

- Body : 일반적으로 POST와 함께 사용되는 요청과 함께 전송되는 선택적 데이터입니다.

효과적인 웹 스크래핑을 위해서는 이러한 구성 요소를 해석하고 구성하는 방법을 이해하는 것이 필수적입니다. 요청과 같은 Python 라이브러리는 이 프로세스를 단순화하여 요청을 정확하게 제어할 수 있습니다.

Python 라이브러리 설치

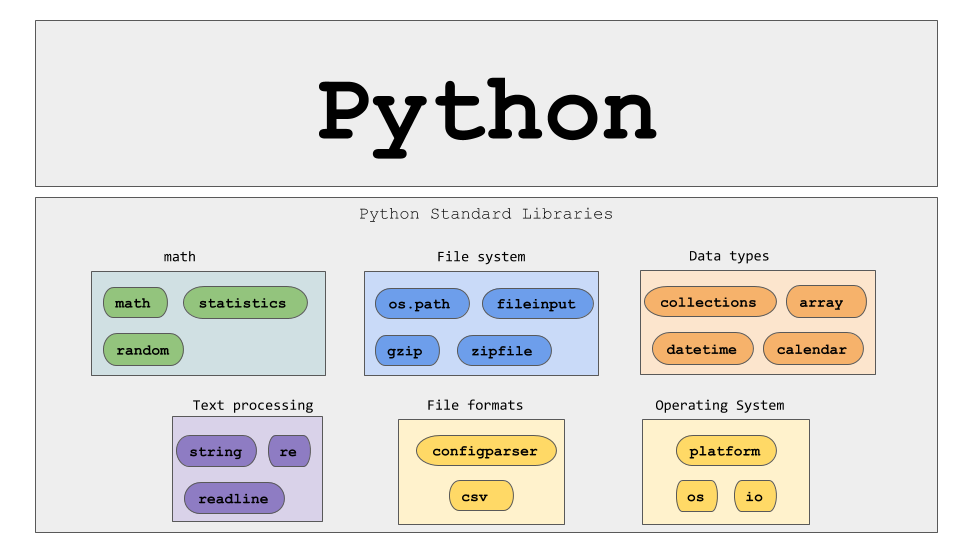

이미지 출처: https://ajaytech.co/what-are-python-libraries/

Python을 사용한 동적 웹 스크래핑의 경우 Python이 설치되어 있는지 확인하세요. 터미널이나 명령 프롬프트를 열고 pip를 사용하여 필요한 라이브러리를 설치합니다.

다음으로 다음 라이브러리를 스크립트로 가져옵니다.

이렇게 하면 각 라이브러리를 요청 전송, HTML 구문 분석, 효율적인 데이터 관리 등 웹 스크래핑 작업에 사용할 수 있게 됩니다.

간단한 웹 스크래핑 스크립트 작성

Python에서 기본 동적 웹 스크래핑 스크립트를 작성하려면 먼저 필요한 라이브러리를 설치해야 합니다. "요청" 라이브러리는 HTTP 요청을 처리하고 "BeautifulSoup"은 HTML 콘텐츠를 구문 분석합니다.

따라야 할 단계:

- 설치 종속성:

- 가져오기 라이브러리:

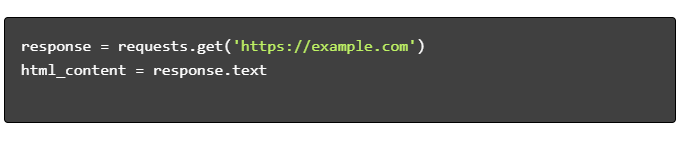

- HTML 콘텐츠 가져오기:

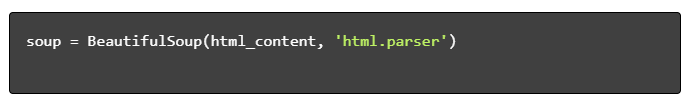

- HTML 구문 분석:

- 데이터 추출:

Python으로 동적 웹 스크래핑 처리

동적 웹사이트는 즉시 콘텐츠를 생성하므로 더 정교한 기술이 필요한 경우가 많습니다.

다음 단계를 고려하십시오.

- 대상 요소 식별 : 웹페이지를 검사하여 동적 콘텐츠를 찾습니다.

- Python 프레임워크 선택 : Selenium 또는 Playwright와 같은 라이브러리를 활용하세요.

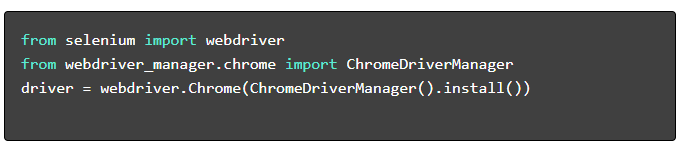

- 필수 패키지 설치 :

- WebDriver 설정 :

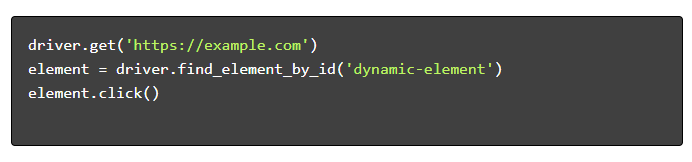

- 탐색 및 상호작용 :

웹 스크래핑 모범 사례

효율성과 합법성을 보장하려면 웹 스크래핑 모범 사례를 따르는 것이 좋습니다. 다음은 주요 지침과 오류 처리 전략입니다.

- Robots.txt 존중 : 대상 사이트의 robots.txt 파일을 항상 확인하세요.

- 조절 : 서버 과부하를 방지하기 위해 지연을 구현합니다.

- User-Agent : 잠재적인 차단을 방지하려면 사용자 정의 User-Agent 문자열을 사용하세요.

- 재시도 논리 : try-exc 블록을 사용하고 서버 시간 초과 처리를 위한 재시도 논리를 설정합니다.

- 로깅 : 디버깅을 위한 포괄적인 로그를 유지합니다.

- 예외 처리 : 특히 네트워크 오류, HTTP 오류 및 구문 분석 오류를 포착합니다.

- 보안 문자 감지 : 보안 문자를 감지하고 해결하거나 우회하기 위한 전략을 통합합니다.

일반적인 동적 웹 스크래핑 문제

보안 문자

많은 웹사이트에서는 자동화된 봇을 방지하기 위해 CAPTCHA를 사용합니다. 이를 우회하려면:

- 2Captcha와 같은 CAPTCHA 해결 서비스를 사용하세요.

- CAPTCHA 해결을 위해 사람의 개입을 구현합니다.

- 요청 속도를 제한하려면 프록시를 사용하세요.

IP 차단

사이트에서는 너무 많은 요청을 하는 IP를 차단할 수 있습니다. 이에 대응하려면 다음을 수행하십시오.

- 회전 프록시 사용.

- 요청 조절을 구현합니다.

- 사용자-에이전트 순환 전략을 사용합니다.

자바스크립트 렌더링

일부 사이트는 JavaScript를 통해 콘텐츠를 로드합니다. 다음을 통해 이 문제를 해결하세요.

- 브라우저 자동화를 위해 Selenium 또는 Puppeteer를 사용합니다.

- 동적 콘텐츠 렌더링을 위해 Scrapy-splash를 사용합니다.

- JavaScript와 상호 작용하기 위해 헤드리스 브라우저를 탐색합니다.

법적인 문제

웹 스크래핑은 때때로 서비스 약관을 위반할 수 있습니다. 다음을 통해 규정 준수를 보장합니다.

- 법률 자문을 컨설팅합니다.

- 공개적으로 접근 가능한 데이터를 스크랩합니다.

- robots.txt 지시문을 준수합니다.

데이터 분석

일관되지 않은 데이터 구조를 처리하는 것은 어려울 수 있습니다. 솔루션에는 다음이 포함됩니다.

- HTML 구문 분석을 위해 BeautifulSoup와 같은 라이브러리를 사용합니다.

- 텍스트 추출을 위해 정규식을 사용합니다.

- 구조화된 데이터에 JSON 및 XML 파서를 활용합니다.

스크랩된 데이터 저장 및 분석

스크랩된 데이터를 저장하고 분석하는 것은 웹 스크래핑의 중요한 단계입니다. 데이터를 저장할 위치는 볼륨과 형식에 따라 결정됩니다. 일반적인 저장소 옵션은 다음과 같습니다.

- CSV 파일 : 소규모 데이터 세트 및 간단한 분석에 적합합니다.

- 데이터베이스 : 구조화된 데이터를 위한 SQL 데이터베이스; 구조화되지 않은 경우 NoSQL입니다.

저장된 후에는 Python 라이브러리를 사용하여 데이터 분석을 수행할 수 있습니다.

- Pandas : 데이터 조작 및 정리에 이상적입니다.

- NumPy : 수치 연산에 효율적입니다.

- Matplotlib 및 Seaborn : 데이터 시각화에 적합합니다.

- Scikit-learn : 기계 학습을 위한 도구를 제공합니다.

적절한 데이터 저장 및 분석은 데이터 접근성과 통찰력을 향상시킵니다.

결론 및 다음 단계

동적 웹 스크래핑 Python을 살펴보았으므로 강조 표시된 도구와 라이브러리에 대한 이해를 세밀하게 조정하는 것이 중요합니다.

- 코드 검토 : 재사용성을 높이기 위해 최종 스크립트를 참조하고 가능한 경우 모듈화합니다.

- 추가 라이브러리 : 더 복잡한 요구 사항을 충족하려면 Scrapy 또는 Splash와 같은 고급 라이브러리를 탐색하세요.

- 데이터 스토리지 : 대규모 데이터 세트를 관리하려면 SQL 데이터베이스 또는 클라우드 스토리지와 같은 강력한 스토리지 옵션을 고려하세요.

- 법적 및 윤리적 고려 사항 : 잠재적인 침해를 방지하려면 웹 스크래핑에 대한 법적 지침을 최신 상태로 유지하세요.

- 다음 프로젝트 : 다양한 복잡성을 지닌 새로운 웹 스크래핑 프로젝트를 다루면 이러한 기술이 더욱 강화될 것입니다.

Python을 사용하여 전문적인 동적 웹 스크래핑을 프로젝트에 통합하려고 하시나요? 내부적으로 처리하는 복잡성 없이 대규모 데이터 추출이 필요한 팀을 위해 PromptCloud는 맞춤형 솔루션을 제공합니다. 강력하고 안정적인 솔루션을 위한 PromptCloud의 서비스를 살펴보세요. 오늘 저희에게 연락하십시오!