Zapobieganie upadkowi modelu sztucznej inteligencji: radzenie sobie z nieodłącznym ryzykiem związanym z syntetycznymi zbiorami danych

Opublikowany: 2023-10-05Sztuczna inteligencja (AI) znacząco zmieniła nasze codzienne życie, sugerując spersonalizowane treści na platformach streamingowych i umożliwiając asystentów cyfrowych na smartfonach. Teraz te postępy są możliwe dzięki wyrafinowanym modelom sztucznej inteligencji, które uczą się na podstawie ogromnych ilości danych.

Jak wynika z różnych raportów, treści generowane przez sztuczną inteligencję stają się coraz bardziej powszechne w Internecie i w nadchodzących latach mogą stanowić nawet 90% informacji dostępnych w Internecie.

Przy takim napływie informacji można śmiało powiedzieć, że w dzisiejszym, bogatym w dane świecie, sztuczna inteligencja stoi przed wyjątkowym wyzwaniem, jakim jest udławienie się nadmiarem danych.

Z raportów wynika ponadto, że znaczna ilość treści generowanych przez sztuczną inteligencję może przytłaczać ludzi nadmiarem informacji, utrudniając im określenie, co jest godne zaufania i zostało wygenerowane przez człowieka. Ponadto istnieją obawy dotyczące potencjalnej utraty miejsc pracy w dziedzinach kreatywnych, takich jak sztuka, dziennikarstwo i pisarstwo, a wszystko dlatego, że sztuczna inteligencja staje się coraz bardziej zdolna do tworzenia treści tradycyjnie tworzonych przez ludzi.

Jeśli chodzi o same systemy sztucznej inteligencji, pojawiają się nowe problemy, takie jak „załamanie modelu”, które odnosi się do problemu polegającego na tym, że modele sztucznej inteligencji trenowane na dużych zbiorach danych generują wyniki o niższej jakości, traktując priorytetowo wybory popularnych słów nad kreatywnymi alternatywami. „Modelowe zaburzenie autofagii” lub „sztuczna inteligencja Habsburgów” to kolejny problem, w przypadku którego systemy sztucznej inteligencji nadmiernie przeszkolone na podstawie wyników innych modeli sztucznej inteligencji mogą wykazywać niepożądane cechy lub mogą mieć uprzedzenia.

Wyzwania te mogą potencjalnie zaszkodzić jakości i niezawodności treści generowanych przez sztuczną inteligencję, niszcząc zaufanie do takich systemów i zwiększając przeciążenie informacyjne.

Nasz blog pomoże Ci zrozumieć wszystko, co jest związane z zapobieganiem załamaniom modeli AI. W miarę postępu rewolucji generatywnej sztucznej inteligencji stwarza ona poważne wyzwania i niepewność dla krajobrazu informacji online. Przejdźmy zatem do szczegółów.

Zrozumienie upadku modelu AI

W uczeniu maszynowym „załamanie modelu” odnosi się do sytuacji, w której model sztucznej inteligencji nie zapewnia szeregu przydatnych wyników. Zamiast tego generuje wąski zestaw powtarzalnych wyników o niskiej jakości. Ten problem może występować w różnych modelach, ale często można go zaobserwować podczas uczenia złożonych modeli, takich jak generatywne sieci przeciwstawne (GAN). Załamanie się modelu może ograniczyć jego zdolność do generowania różnorodnych i wartościowych wyników, wpływając na jego ogólną wydajność.

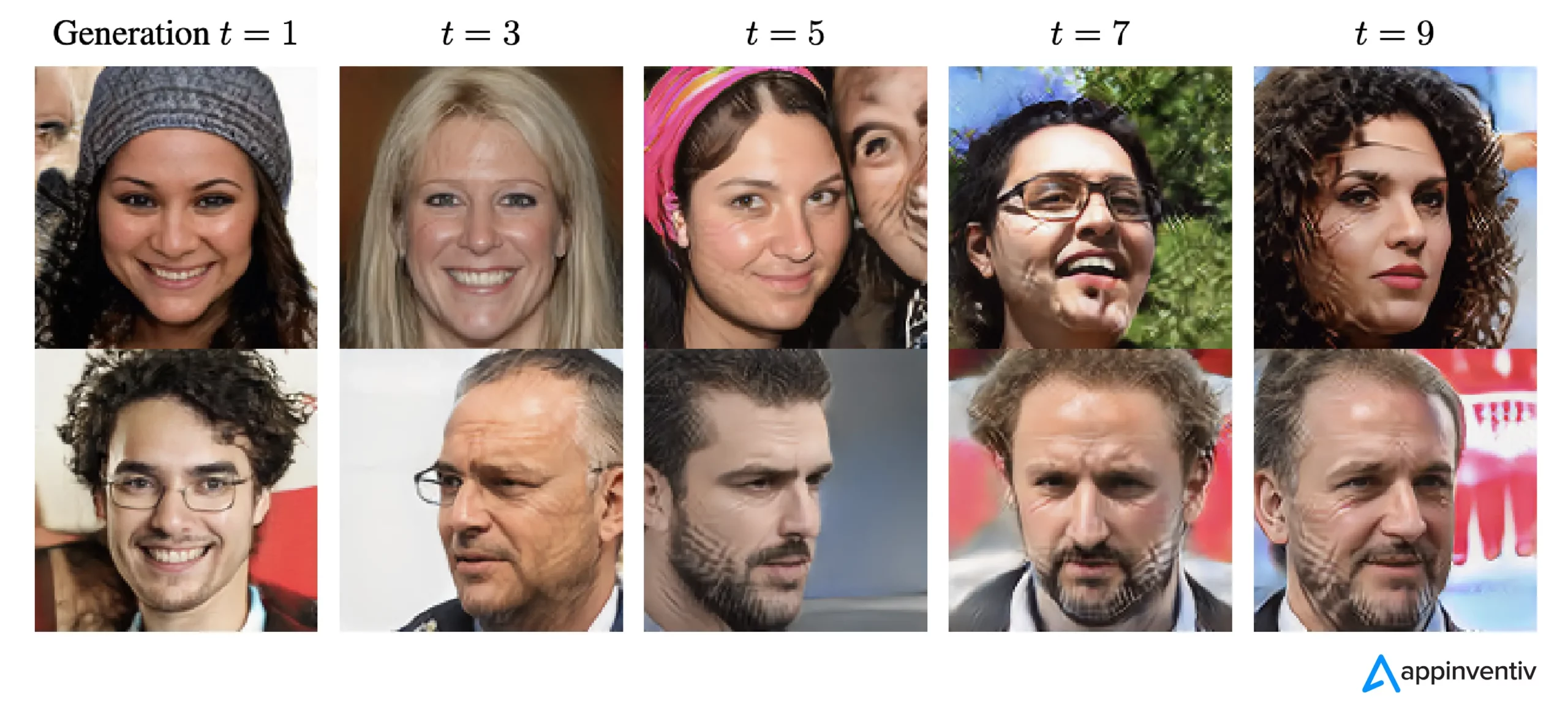

Zilustrujmy przykład zawalenia się modelu. Wyobraź sobie bardzo entuzjastycznego studenta sztuki reprezentującego nasz model sztucznej inteligencji, którego zadaniem jest tworzenie obrazów przedstawiających zebry. Ich grafika na początku robi wrażenie i wyraźnie przypomina zebry. Jednak w miarę upływu czasu ich obrazy stopniowo tracą podobieństwo do zebr, a jakość spada. Przypomina to „załamanie modelu” w uczeniu maszynowym, gdzie model sztucznej inteligencji, podobnie jak nasz student sztuki, początkowo działa dobrze, ale potem ma trudności z utrzymaniem podstawowych cech, do których został zaprojektowany.

W związku z ostatnimi postępami w dziedzinie sztucznej inteligencji badacze bardzo zainteresowali się wykorzystaniem sztucznych lub syntetycznych danych do uczenia nowych modeli sztucznej inteligencji w zakresie generowania obrazów i tekstu. Jednakże koncepcja zwana „modelowym zaburzeniem autofagii” (MAD) porównuje ten proces do pętli autodestrukcyjnej.

Jeśli nie będziemy regularnie dodawać nowych, rzeczywistych danych, jakość i różnorodność modeli sztucznej inteligencji, które tworzymy na podstawie danych syntetycznych, mogą z czasem się pogorszyć. Dlatego konieczne jest zachowanie równowagi między danymi syntetycznymi i rzeczywistymi, aby modele AI działały dobrze.

Równowaga ta ma kluczowe znaczenie, aby zapobiec pogorszeniu się jakości i różnorodności modeli w miarę ich dalszego uczenia się. Ustalenie, jak skutecznie wykorzystywać dane syntetyczne do zapobiegania załamaniom modeli sztucznej inteligencji, stanowi ciągłe wyzwanie, jeśli chodzi o ewolucję generatywnej sztucznej inteligencji i wykorzystanie danych syntetycznych.

Według The New Yorker, jeśli ChatGPT jest uważany za zwartą wersję Internetu, podobną do pliku JPEG kompresującego zdjęcie, to szkolenie przyszłych chatbotów na wynikach ChatGPT jest cyfrowo równoznaczne z wielokrotnym wykonywaniem kserokopii kserokopii, tak jak dawne czasy. Po prostu jakość obrazu z każdą iteracją będzie się pogarszać.

Aby zatem stawić czoła temu wyzwaniu, organizacje muszą skoncentrować się na udoskonaleniu swoich podejść, aby mieć pewność, że generatywne produkty AI w dalszym ciągu będą zapewniać dokładne odpowiedzi w cyfrowym krajobrazie.

[Przeczytaj także: Odpowiedzialna sztuczna inteligencja – radzenie sobie z wyzwaniami związanymi z adopcją za pomocą zasad przewodnich i strategii]

Jak dochodzi do załamania się modelu AI?

Załamanie modelu ma miejsce, gdy nowe modele AI są szkolone przy użyciu danych generowanych przez starsze modele. Te nowe modele opierają się na wzorcach widocznych w wygenerowanych danych. Upadek modelu opiera się na założeniu, że modele generatywne mają tendencję do powtarzania wzorców, których się już nauczyli, a informacje, jakie mogą z tych wzorców wydobyć, są ograniczone.

W przypadku załamania się modelu zdarzenia, które są prawdopodobne, są wyolbrzymiane, podczas gdy zdarzenia mniej prawdopodobne są niedoceniane. W przypadku wielu pokoleń w danych dominują prawdopodobne zdarzenia, a mniej powszechne, ale wciąż istotne części danych, zwane ogonami, maleją. Ogony te są niezbędne do utrzymania dokładności i różnorodności wyników modelu. W miarę postępu pokoleń dane stają się coraz bardziej błędne, a model coraz częściej błędnie je interpretuje.

Jak wynika z badań, wyróżnia się dwa rodzaje upadku modelu: wczesny i późny. Wczesne załamanie się modelu wiąże się z utratą przez model informacji o rzadkich zdarzeniach. W przypadku upadku późnego modelu model zaciera wyraźne wzorce w danych, w wyniku czego wyniki są w niewielkim stopniu podobne do oryginalnych danych.

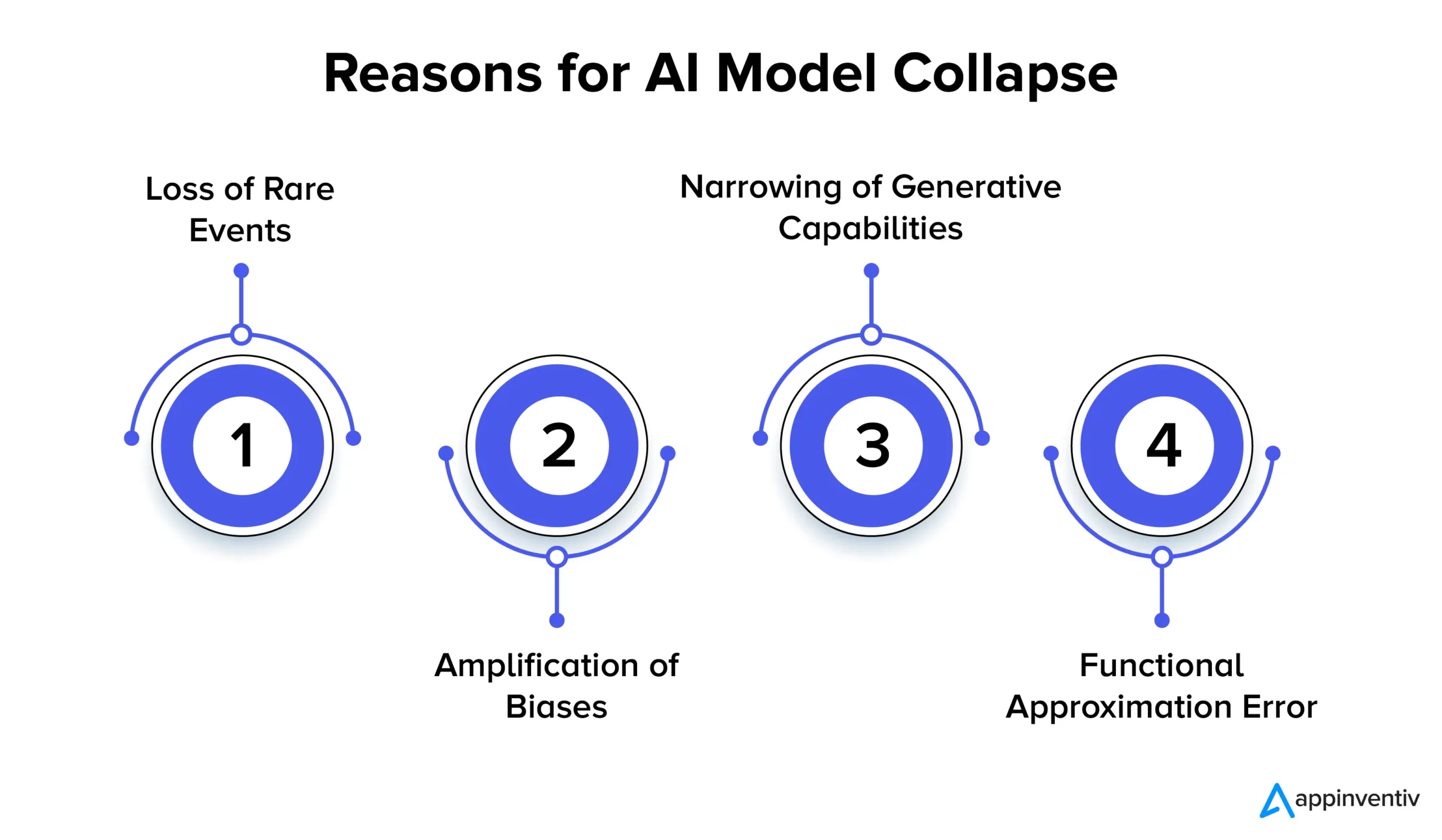

Przyjrzyjmy się szczegółowo wielu przyczynom upadku modelu AI poniżej:

Utrata rzadkich zdarzeń

Kiedy modele AI są wielokrotnie szkolone na danych generowanych przez ich poprzednie wersje, starają się skupić na typowych wzorcach i zapomnieć o rzadkich zdarzeniach. Zjawisko to jest podobne do utraty pamięci długotrwałej przez modele. Rzadkie zdarzenia często mają duże znaczenie, takie jak identyfikacja anomalii w procesach produkcyjnych lub wykrywanie oszukańczych transakcji. Na przykład w przypadku wykrywania oszustw określone wzorce językowe mogą sygnalizować oszukańcze zachowanie, dlatego niezwykle istotne jest zachowanie i nauczenie się tych rzadkich wzorców.

Wzmocnienie uprzedzeń

Każda iteracja szkolenia na danych wygenerowanych przez sztuczną inteligencję może wzmocnić istniejące błędy w danych szkoleniowych. Ponieważ dane wyjściowe modelu zwykle odzwierciedlają dane, na których był on szkolony, wszelkie odchylenia w tych danych mogą z czasem zostać wyolbrzymione. Może to prowadzić do wzmocnienia błędu systematycznego w różnych zastosowaniach sztucznej inteligencji. Wyniki mogą na przykład prowadzić do takich problemów, jak dyskryminacja, uprzedzenia rasowe i stronnicze treści w mediach społecznościowych. Dlatego też wdrożenie kontroli mających na celu wykrywanie i łagodzenie stronniczości jest niezwykle istotne.

Zawężanie możliwości generatywnych

W miarę jak modele sztucznej inteligencji będą nadal uczyć się na podstawie wygenerowanych danych, ich możliwości generacyjne mogą się zawęzić. Model ulega raczej wpływom własnych interpretacji rzeczywistości, tworząc coraz bardziej podobne treści, którym brakuje różnorodności i reprezentacji rzadkich wydarzeń. Może to prowadzić do utraty oryginalności. Na przykład, jeśli chodzi o modele wielkojęzyczne (LLM), odmiana ta nadaje każdemu pisarzowi lub artyście odrębny ton i styl.

Badania po prostu sugerują, że jeśli w procesie uczenia nie będą regularnie dodawane świeże dane, przyszłe modele sztucznej inteligencji mogą z czasem stać się mniej dokładne lub dawać mniej zróżnicowane wyniki.

Funkcjonalny błąd aproksymacji

Funkcjonalny błąd aproksymacji może wystąpić, gdy aproksymatory funkcji użyte w modelu nie są wystarczająco wyraziste. Chociaż błąd ten można złagodzić, stosując bardziej wyraziste modele, może on również wprowadzić szum i prowadzić do nadmiernego dopasowania. Aby zapobiec tym błędom, kluczowe jest znalezienie właściwej równowagi pomiędzy wyrazistością modelu a kontrolą szumów.

Konsekwencje upadku modelu: dlaczego stabilność modelu AI ma znaczenie?

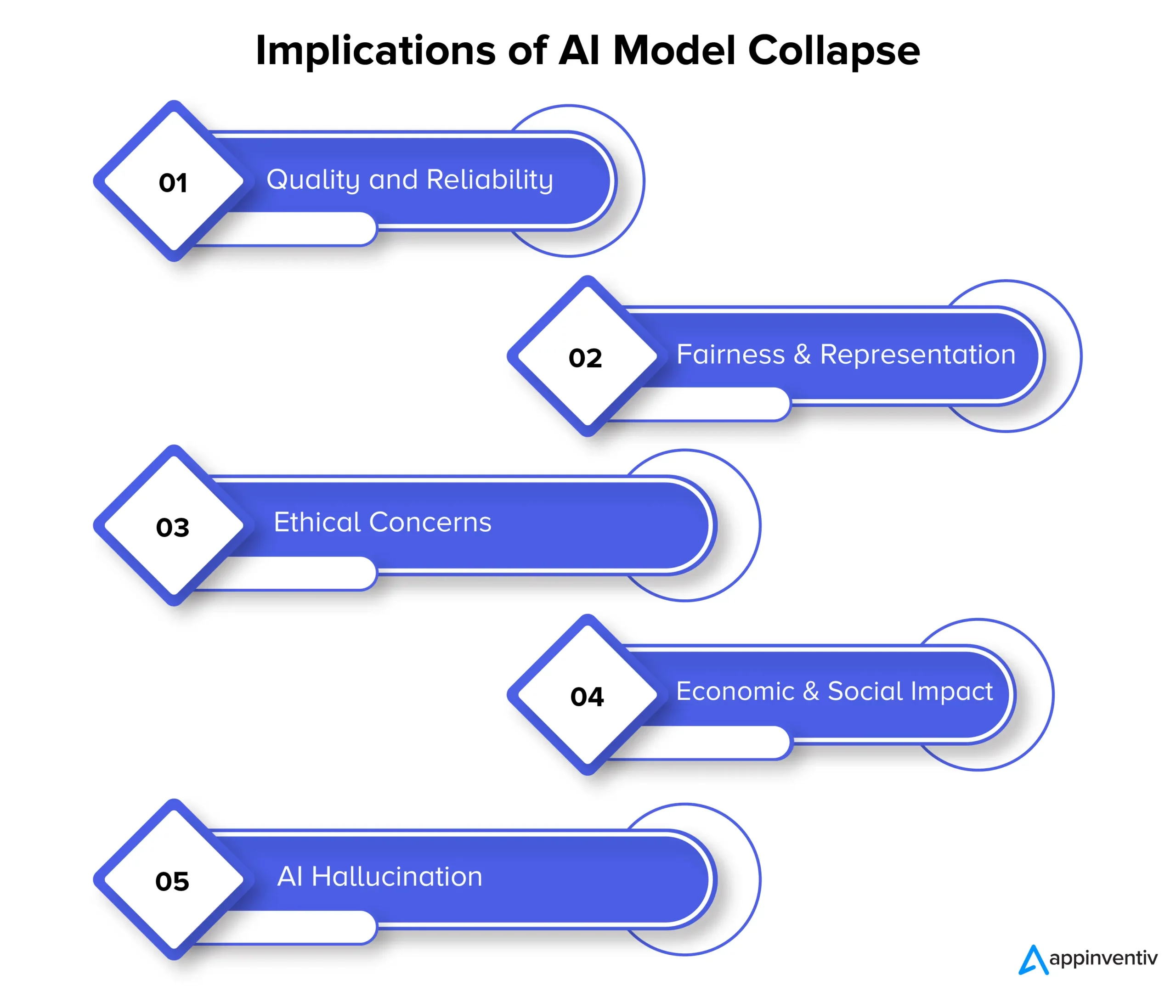

Upadek modelu może ostatecznie wpłynąć na jakość, niezawodność i uczciwość treści generowanych przez sztuczną inteligencję, co może dodatkowo stwarzać szereg zagrożeń dla organizacji. Przyjrzyjmy się szczegółowo konsekwencjom załamania się modelu poniżej:

Jakość i niezawodność

W miarę jak modele sztucznej inteligencji ulegają degeneracji w procesie uczenia się, generowane przez nie treści stają się mniej niezawodne, a ich jakość spada. Dzieje się tak, gdy modele odrywają się od pierwotnego rozkładu danych i w większym stopniu opierają się na własnych interpretacjach rzeczywistości. Na przykład model sztucznej inteligencji zaprojektowany do generowania wiadomości może generować niedokładne lub nawet całkowicie sfabrykowane artykuły.

Uczciwość i reprezentacja

Załamanie się modelu jest również powodem do obaw, jeśli chodzi o uczciwość i reprezentację wygenerowanej treści. Kiedy modele zapominają o rzadkich wydarzeniach i ograniczają swoje zdolności twórcze, treści związane z mniej powszechnymi tematami mogą być niewystarczająco reprezentowane. Prowadzi to do uprzedzeń, stereotypów i wykluczenia pewnych perspektyw.

Obawy etyczne

Upadek modelu stwarza poważne wątpliwości etyczne, zwłaszcza gdy treści generowane przez sztuczną inteligencję mogą wpływać na proces decyzyjny. Konsekwencje upadku modelu obejmują rozpowszechnianie stronniczych i niedokładnych treści, które mogą znacząco wpłynąć na życie ludzi, opinie i dostęp do możliwości.

Wpływ gospodarczy i społeczny

W skali gospodarczej i społecznej upadek modelu może wpłynąć na zaufanie i przyjęcie technologii sztucznej inteligencji. Jeśli nie można polegać na treściach generowanych przez sztuczną inteligencję, firmy i konsumenci mogą wahać się przed przyjęciem tych technologii. Może to mieć konsekwencje gospodarcze, a w konsekwencji zaufanie do technologii sztucznej inteligencji może zmniejszyć.

Halucynacje AI

Halucynacja AI ma miejsce, gdy modele AI tworzą pomysłowe lub nierealistyczne treści, które nie są zgodne z faktami lub są w jakikolwiek sposób spójne. Może to skutkować podaniem niedokładnych informacji, co może spowodować dezinformację lub zamieszanie. Jest to znacznie problematyczne w zastosowaniach takich jak generowanie wiadomości, diagnozowanie schorzeń lub tworzenie dokumentów prawnych, gdzie dokładność i niezawodność są niezwykle istotne.

Wyjaśnijmy kontekst na przykładzie halucynacji AI. Załóżmy, że istnieje model sztucznej inteligencji przeszkolony do generowania zdjęć zwierząt. Teraz, po zażądaniu zdjęcia zwierzęcia, model może stworzyć obraz „zebroida”, hybrydy zebry i konia. Chociaż ten obraz może wydawać się wizualnie realistyczny, należy pamiętać, że jest to jedynie wytwór wyobraźni modelu AI, ponieważ w prawdziwym świecie takie zwierzę nie istnieje.

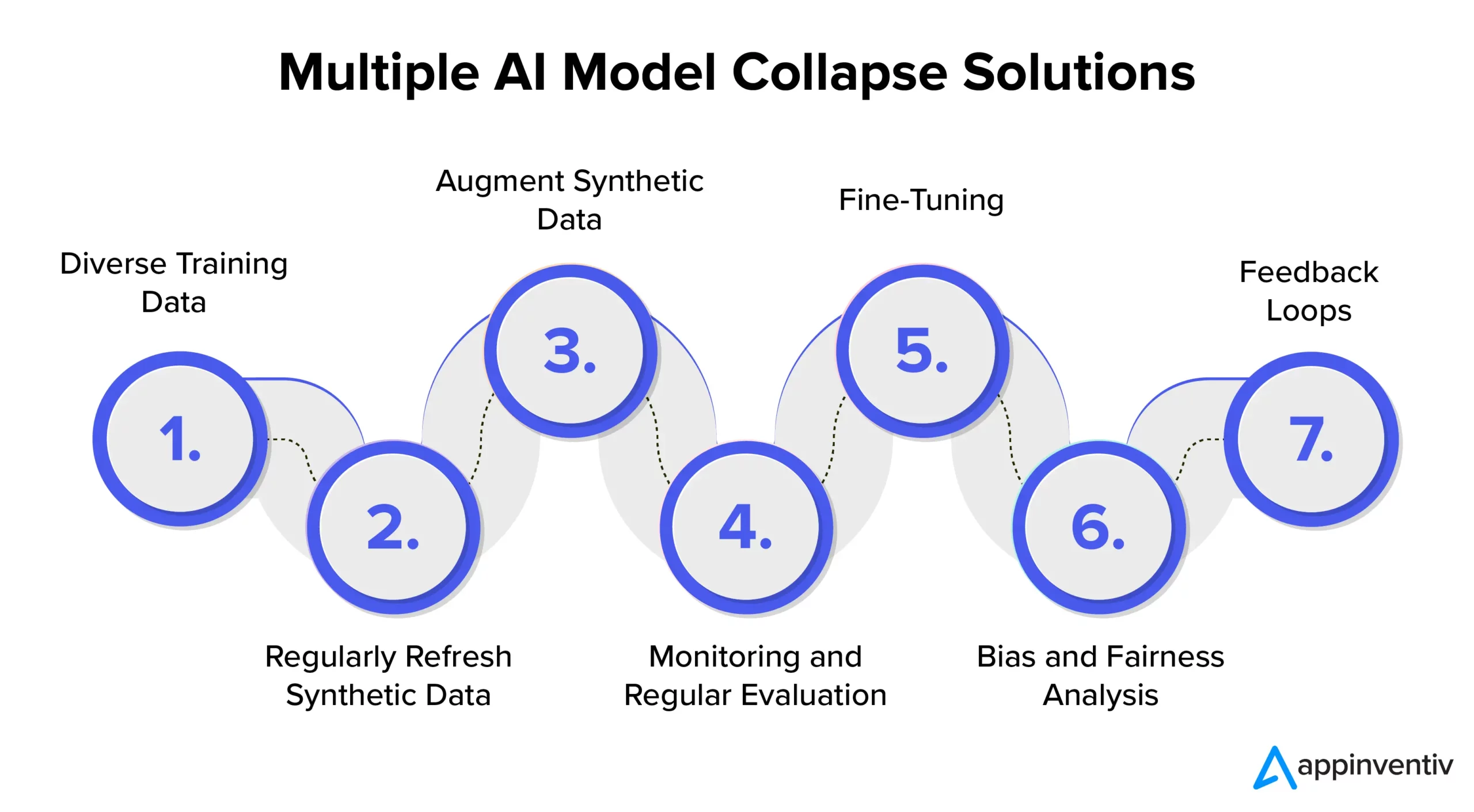

Zapobieganie zawaleniu się modelu AI: Zrozumienie rozwiązań związanych z zawaleniem się modelu AI

Aby zapewnić stabilność i niezawodność modelu sztucznej inteligencji, konieczne jest zbadanie strategii i najlepszych praktyk w zakresie skutecznego zapobiegania załamaniom modelu sztucznej inteligencji. Dlatego zaleca się współpracę z wyspecjalizowaną firmą zajmującą się rozwojem sztucznej inteligencji, taką jak Appinventiv, która może zapewnić specjalistyczną wiedzę i wskazówki dotyczące wdrażania tych środków zapobiegawczych, zapewniając jednocześnie ciągłe dostarczanie przez systemy sztucznej inteligencji wyników wysokiej jakości.

Zróżnicowane dane szkoleniowe

Aby skutecznie zaradzić załamaniu się modelu sztucznej inteligencji i zapobiec niepożądanym wynikom, kluczowe jest stworzenie zbioru danych szkoleniowych, który będzie obejmował różnorodne źródła i typy danych. Ten zbiór danych powinien składać się zarówno z danych syntetycznych wygenerowanych przez model, jak i danych ze świata rzeczywistego, które dokładnie odzwierciedlają złożoność problemu. Ważne jest regularne aktualizowanie tego zbioru danych o nowe i istotne informacje. Model jest wystawiony na działanie szerokiej gamy wzorców poprzez uwzględnienie różnorodnych danych szkoleniowych. Pomaga to zapobiegać stagnacji danych.

Regularnie odświeżaj dane syntetyczne

Załamanie się modelu wiąże się z ryzykiem, gdy modele sztucznej inteligencji w dużym stopniu opierają się na samodzielnie wygenerowanych danych. Aby skutecznie ograniczać ryzyko w sztucznej inteligencji, ważne jest regularne wprowadzanie do procesu szkoleniowego nowych, autentycznych, rzeczywistych danych. Ta praktyka zapewnia, że model pozostaje adaptacyjny i pozwala uniknąć utknięcia w powtarzalnej pętli. Może to pomóc w generowaniu różnorodnych i odpowiednich wyników.

Zwiększ dane syntetyczne

Udoskonalanie danych syntetycznych za pomocą technik powiększania danych to sprawdzona metoda zapobiegania załamaniu się modelu. Techniki te wprowadzają zmienność do danych syntetycznych, wykorzystując naturalne różnice w danych ze świata rzeczywistego. Dodanie kontrolowanego szumu do wygenerowanych danych zachęca model do uczenia się szerszego zakresu wzorców, zmniejszając ryzyko generowania powtarzalnych wyników.

Monitorowanie i regularna ocena

Regularne monitorowanie i ocena wydajności modelu AI ma kluczowe znaczenie dla wczesnego wykrywania załamania się modelu. Wdrożenie ram MLOps zapewnia ciągłe monitorowanie i zgodność z celami organizacji, umożliwiając w ten sposób szybkie interwencje i dostosowania.

[Przeczytaj także: Jak uniknąć naruszeń zasad podczas opracowywania produktów AI]

Strojenie

Ważne jest, aby rozważyć wdrożenie strategii dostrajania, aby utrzymać stabilność modelu i zapobiec zawaleniu się. Te strategie zapobiegania awariom modelu AI umożliwiają modelowi dostosowanie się do nowych danych przy jednoczesnym zachowaniu dotychczasowej wiedzy.

Analiza stronniczości i uczciwości

Rygorystyczna analiza stronniczości i uczciwości ma kluczowe znaczenie w zapobieganiu załamaniu się modelu i problemom etycznym. Istotne jest zidentyfikowanie i wyeliminowanie błędów w wynikach modelu. Można zachować wiarygodne i bezstronne wyniki modelu, aktywnie rozwiązując te problemy.

Pętle informacji zwrotnej

Wdrażanie pętli sprzężenia zwrotnego uwzględniających opinie użytkowników ma kluczowe znaczenie w zapobieganiu załamaniu się modelu. Dzięki konsekwentnemu gromadzeniu spostrzeżeń użytkowników można wprowadzać świadome korekty wyników modelu. Ten proces udoskonalania gwarantuje, że model pozostanie odpowiedni, niezawodny i zgodny z oczekiwaniami użytkownika.

W jaki sposób Appinventiv może pomóc w ograniczaniu ryzyka w modelach AI?

W ewoluującym krajobrazie sztucznej inteligencji wyzwania związane z upadkiem modeli budzą obawy zarówno gigantów technologicznych, jak i innowatorów. Długoterminowe pogarszanie się zbiorów danych modeli językowych i manipulacja treścią odcisnęły piętno na tym cyfrowym ekosystemie.

W miarę postępu sztucznej inteligencji istotne jest rozróżnienie między danymi generowanymi sztucznie a treściami generowanymi przez człowieka. Granica między prawdziwą treścią a tym, co generowane jest przez maszynę, staje się coraz bardziej zatarta.

Teraz, pośród tych wyzwań i zapobiegania awariom modeli sztucznej inteligencji, współpraca z wyspecjalizowaną firmą zajmującą się rozwojem sztucznej inteligencji, taką jak Appinventiv, może zapewnić Ci tak potrzebne pocieszenie. Dzięki specjalistycznej wiedzy w zakresie opracowywania modeli sztucznej inteligencji i zaangażowaniu w etyczne praktyki związane ze sztuczną inteligencją możemy pomóc Ci w poruszaniu się po złożoności sztucznej inteligencji, zapewniając jednocześnie niezawodność i integralność Twoich systemów sztucznej inteligencji.

Nasi eksperci mogą współpracować z Tobą, aby skutecznie zapobiegać załamaniom modeli AI, promować przejrzystość i budować przyszłość z autentycznymi treściami, które nie zagrażają autentyczności treści generowanych przez człowieka.

Rozumiemy, że szkolenie modeli AI przy użyciu świeżych, różnorodnych danych jest niezbędne, aby zapobiec degradacji modelu. Ocena modelu AI to kluczowy krok w procesie opracowywania modelu, który wykorzystuje metryki do oceny wydajności, wskazywania słabych punktów i zapewniania skutecznych prognoz na przyszłość.

Nasz zespół ekspertów może pomóc zapewnić, że Twoje systemy AI będą się nadal uczyć i dostosowywać do zmieniającego się krajobrazu cyfrowego. Skontaktuj się z naszymi ekspertami, aby zminimalizować ryzyko związane z upadkiem modeli i zapewnić ich skuteczność.

Często zadawane pytania

P. Co to jest upadek modelu AI?

A. Upadek modelu sztucznej inteligencji w uczeniu maszynowym odnosi się do tego, że model sztucznej inteligencji nie generuje różnorodnego zakresu użytecznych wyników. Zamiast tego generuje powtarzalne lub niskiej jakości wyniki. Problem ten może wystąpić w różnych typach modeli, ale jest szczególnie obserwowany podczas uczenia złożonych modeli, takich jak generatywne sieci kontradyktoryjne (GAN).

P. Jakie są najczęstsze przyczyny załamania się modelu AI?

A. Typowe przyczyny załamania się modelu sztucznej inteligencji obejmują utratę rzadkich zdarzeń, wzmocnienie błędów systematycznych, zawężenie możliwości generatywnych, błędy aproksymacji funkcjonalnej itp. Czynniki te mogą prowadzić do tworzenia modeli nieoptymalnych.

P. Jak mogę zapobiec zawaleniu się modelu AI?

O. Aby skutecznie zapobiegać załamaniom modelu sztucznej inteligencji, niezbędne jest wykorzystywanie różnych danych szkoleniowych przypominających świat rzeczywisty, ciągłe monitorowanie i ocenianie danych, naprawianie wszelkich błędów uprzedzeń oraz wdrażanie rygorystycznych testów i kontroli jakości. Współpraca z ekspertami AI w Appinventiv może zapewnić cenne spostrzeżenia i rozwiązania ograniczające ryzyko zawalenia się modelu.