Pod kodeksem: analiza podstawowych zagrożeń związanych ze sztuczną inteligencją i środków zaradczych

Opublikowany: 2023-09-25Organizacje szybko wkraczają w świat sztucznej inteligencji, aby przyspieszyć swoje procesy i zyskać przewagę konkurencyjną. Jednak ważne jest, aby zrozumieć, że ich podróż AI nie zawsze będzie pełna słońca i tęczy i może towarzyszyć pewnym ryzykom i wyzwaniom. Ponieważ technologia sztucznej inteligencji rozwija się szybko i z niespotykaną dotąd szybkością, organizacje muszą być przygotowane na globalną adaptację. Aby odnieść sukces w tym bezwzględnym cyfrowym ekosystemie, konieczne jest zrozumienie potencjalnych pułapek i przyjęcie najlepszych praktyk w zakresie poruszania się po wieloświecie sztucznej inteligencji.

W miarę ciągłego rozwoju sztucznej inteligencji rosną obawy dotyczące jej potencjalnych zagrożeń. Geoffrey Hinton, „ojciec chrzestny sztucznej inteligencji”, znany z godnej pochwały pracy w zakresie uczenia maszynowego i sieci neuronowych, przestrzegł, że systemy sztucznej inteligencji rozwijają się w niespotykanym dotąd tempie i mogą stwarzać ryzyko przejęcia kontroli, jeśli nie będą obsługiwane z należytym nadzorem. Następnie podkreślił istotną potrzebę proaktywnego zajęcia się tymi powiązanymi kwestiami.

W innym przypadku Elon Musk również opowiadał się za pauzą w eksperymentach związanych ze sztuczną inteligencją na dużą skalę. Obawy światowych przywódców dotyczące potencjalnych zagrożeń związanych ze sztuczną inteligencją odzwierciedlają fakt, że społeczność technologiczna musi dokładnie rozważyć konsekwencje i wyzwania etyczne, które mogą się pojawić w związku z rozwojem możliwości sztucznej inteligencji.

Obecnie, wraz z rozwojem świata, generatywna sztuczna inteligencja staje się coraz bardziej popularna. Ponieważ wielka władza często wiąże się z bezwarunkową odpowiedzialnością, wdrożenie generatywnej sztucznej inteligencji wiąże się również z pewnym ryzykiem etycznym.

Zatem jako właściciel firmy nadszedł czas, aby zrozumieć, że sztuczna inteligencja może przynieść ogromne korzyści, ale wiąże się również z pewnymi znanymi wyzwaniami, które pojawiają się podczas wprowadzania jakiejkolwiek nowej technologii do codziennych działań.

Organizacje muszą priorytetowo traktować odpowiedzialne użytkowanie, zapewniając dokładność, bezpieczeństwo, uczciwość, wzmocnienie pozycji i zrównoważony rozwój. W obliczu pewnych wyzwań i zagrożeń mogą polegać na wypróbowanych i przetestowanych najlepszych praktykach, które okazały się skuteczne w skutecznym wdrażaniu innych technologii. Strategie te mogą stanowić solidną podstawę do integracji sztucznej inteligencji z operacjami biznesowymi i ograniczania ryzyka związanego ze sztuczną inteligencją.

Ten blog pomoże Ci zrozumieć wszystko, co wiąże się z zagrożeniami związanymi ze sztuczną inteligencją dla Twojej firmy i sposobami je złagodzić. Zatem bez zbędnych ceregieli przejdźmy od razu do szczegółów.

Zrozumienie zagrożeń związanych ze sztuczną inteligencją

Według AI RMF 1.0, ram zarządzania ryzykiem sztucznej inteligencji, opublikowanych przez Narodowy Instytut Standardów i Technologii (NIST), ryzyko związane ze sztuczną inteligencją obejmuje potencjalne szkody dla osób, organizacji lub systemów wynikające z opracowywania i wdrażania systemów sztucznej inteligencji. Zagrożenia te mogą wynikać z różnych czynników, w tym danych wykorzystywanych do szkolenia sztucznej inteligencji, algorytmu sztucznej inteligencji, jej wykorzystania do wielu celów oraz interakcji z ludźmi. Przykłady zagrożeń i kontroli związanych ze sztuczną inteligencją są różne – od stronniczych narzędzi do zatrudniania po algorytmy powodujące załamanie rynku.

Proaktywne monitorowanie produktów i usług opartych na sztucznej inteligencji ma kluczowe znaczenie dla zapewnienia bezpieczeństwa danych i osób. Dlatego organizacja wierzy w zastosowanie rozwiązania do zarządzania ryzykiem, które może pomóc w skutecznej segregacji, weryfikacji i łagodzeniu tych ryzyk.

Identyfikacja zagrożeń i wyzwań związanych ze sztuczną inteligencją dla przedsiębiorstw

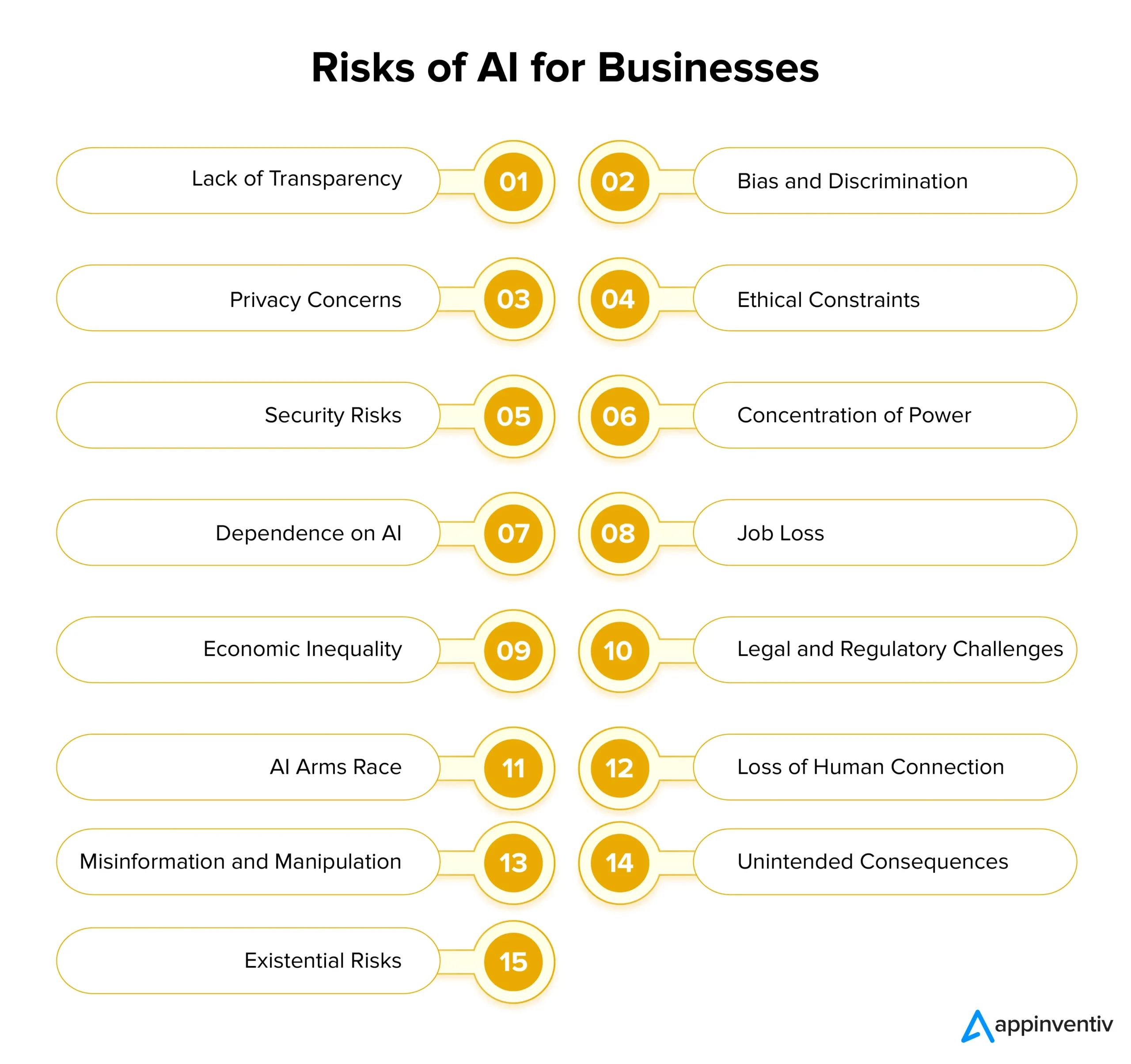

Sztuczna inteligencja oferuje przedsiębiorstwom ogromny potencjał, ale niesie ze sobą także znaczne ryzyko związane z jej wdrożeniem. Aby zapewnić odpowiedzialne przyjęcie sztucznej inteligencji, ważne jest, aby zrozumieć te wyzwania i stawić czoła tym wyzwaniom we właściwym czasie. Przyjrzyjmy się szczegółowo zagrożeniom i rozwiązaniom związanym ze sztuczną inteligencją dla firm poniżej:

Brak przejrzystości

Systemy sztucznej inteligencji często działają w sposób nieprzejrzysty, co utrudnia zrozumienie, w jaki sposób podejmują różne decyzje. Ten brak przejrzystości może prowadzić do braku zaufania wśród użytkowników i zainteresowanych stron. Aby rozwiązać ten problem, firmy powinny nadać priorytet przejrzystości, projektując modele i algorytmy sztucznej inteligencji, które zapewniają wgląd w ich procesy decyzyjne.

Można to w prosty sposób ułatwić, stosując przejrzystą dokumentację, zrozumiałe techniki sztucznej inteligencji i narzędzia do wizualizacji wyników opartych na sztucznej inteligencji. Należy zrozumieć, że przejrzysta sztuczna inteligencja zwiększa ogólne zaufanie między stronami i ich decyzjami oraz pomaga w przestrzeganiu przepisów.

Uprzedzenia i dyskryminacja

Systemy sztucznej inteligencji mogą z łatwością utrzymywać uprzedzenia społeczne znalezione w danych szkoleniowych. Może to prowadzić do stronniczego podejmowania decyzji, dyskryminacji i niesprawiedliwego traktowania niektórych grup. Aby zaradzić tym zagrożeniom związanym ze sztuczną inteligencją, organizacje powinny priorytetowo potraktować inwestowanie w zróżnicowane i reprezentatywne dane szkoleniowe, które mogą analizować.

Ponadto wdrożenie algorytmów wykrywania i korygowania błędów oraz przeprowadzanie regularnych audytów modeli sztucznej inteligencji może pomóc w identyfikacji i usuwaniu błędów w istniejących systemach. Etyczny rozwój sztucznej inteligencji musi priorytetowo traktować uczciwość i bezstronność jako podstawowe zasady.

Obawy dotyczące prywatności

Jednym z największych zagrożeń i wyzwań związanych ze sztuczną inteligencją jest zagrożenie prywatności. Sztuczna inteligencja często wymaga gromadzenia i analizowania ogromnych ilości danych osobowych, co budzi obawy dotyczące prywatności i bezpieczeństwa. Firmy muszą priorytetowo traktować ochronę danych, przestrzegając rygorystycznych przepisów dotyczących prywatności, wdrażając solidne środki cyberbezpieczeństwa i stosując techniki szyfrowania danych. Może to pomóc w ochronie prywatności użytkowników i utrzymaniu zaufania.

Ograniczenia etyczne

Systemy sztucznej inteligencji zaangażowane w podejmowanie kluczowych decyzji często stają przed dylematami etycznymi, które mogą mieć dalsze szkodliwe skutki społeczne. Organizacje powinny ustanowić wytyczne i zasady etyczne dotyczące rozwoju i wdrażania sztucznej inteligencji, aby zaradzić temu ryzyku. Względy etyczne powinny stanowić jeden z głównych elementów projektów AI, zapewniający zgodność sztucznej inteligencji z wartościami społecznymi i normami etycznymi.

Zagrożenia bezpieczeństwa

Wraz z postępem technologii sztucznej inteligencji rosną także zagrożenia bezpieczeństwa. Złośliwe działania mogą wykorzystywać systemy sztucznej inteligencji i powodować bardziej niebezpieczne cyberataki, stanowiąc poważne zagrożenie dla przedsiębiorstw. Organizacje powinny wdrożyć solidne środki bezpieczeństwa w celu ograniczenia zagrożeń bezpieczeństwa, w tym szyfrowanie, protokoły uwierzytelniania i systemy wykrywania zagrożeń oparte na sztucznej inteligencji. Bieżące monitorowanie i regularne sprawdzanie podatności mają kluczowe znaczenie dla zabezpieczenia wdrażania systemów sztucznej inteligencji.

Koncentracja mocy

Kiedy tylko kilka dużych firm i rządów kontroluje rozwój sztucznej inteligencji, może to spowodować niesprawiedliwość i zmniejszyć różnorodność zastosowań sztucznej inteligencji. Aby temu zapobiec, firmy powinny działać na rzecz szerszego udostępniania rozwoju sztucznej inteligencji wielu grupom. Mogą to zrobić, wspierając małe start-upy, zachęcając do nowych pomysłów i pomagając projektom AI typu open source. W ten sposób sztuczna inteligencja stanie się bardziej dostępna dla każdego.

Uzależnienie od sztucznej inteligencji

Nadmierne poleganie na systemach sztucznej inteligencji może prowadzić do utraty kreatywności, krytycznego myślenia i ludzkiej intuicji. Niezwykle istotne jest znalezienie równowagi między podejmowaniem decyzji wspomaganym przez sztuczną inteligencję a osądem człowieka. Na przykład badacze zwrócili uwagę na problem „załamania się modelu”, w przypadku którego generatywne modele sztucznej inteligencji szkolone na danych syntetycznych mogą dawać wyniki o niższej jakości, ponieważ po prostu traktują priorytetowo wybrane słowa zamiast kreatywnych alternatyw.

Firmy muszą szkolić swoich pracowników, aby współpracowali ze sztuczną inteligencją, aby uniknąć potencjalnych zagrożeń związanych ze sztuczną inteligencją. Zachęcanie do ciągłego uczenia się może pomóc organizacjom wykorzystać potencjał sztucznej inteligencji, jednocześnie zachowując umiejętności ludzkie. Oprócz tego wykorzystanie różnorodnych danych szkoleniowych i technik regularyzacji może również pomóc w łagodzeniu wyzwań związanych z załamaniem się modelu.

Utrata pracy

Automatyzacja oparta na sztucznej inteligencji może potencjalnie spowodować przeniesienie miejsc pracy w różnych branżach, przy czym głównym celem są pracownicy o niższych kwalifikacjach. Organizacje muszą aktywnie stawić czoła temu wyzwaniu, zapewniając swoim pracownikom możliwości uczenia się nowych metod i rozwoju wraz z postępem technologicznym. Promowanie uczenia się przez całe życie i zdolności adaptacyjnych ma zasadnicze znaczenie dla złagodzenia obaw związanych z utratą miejsc pracy w wielu sektorach.

Nierówność ekonomiczna

Nierówność ekonomiczna to kolejne z godnych uwagi zagrożeń i wyzwań związanych ze sztuczną inteligencją, o których firmy muszą być świadome. Sztuczna inteligencja może potencjalnie pogłębić nierówności ekonomiczne, ponieważ często przynosi korzyści bogatym ludziom i dużym firmom. Aby uczynić sztuczną inteligencję bardziej sprawiedliwą, decydenci i przedsiębiorstwa powinny zastanowić się nad sposobami włączenia większej liczby osób w rozwój sztucznej inteligencji. Mogą to zrobić, tworząc programy, które pozwolą większej liczbie osób korzystać z narzędzi AI.

Wyzwania prawne i regulacyjne

Sztuczna inteligencja wprowadza nowe zawiłości prawne i regulacyjne, w tym kwestie odpowiedzialności i praw własności intelektualnej. Ramy prawne muszą ewoluować, aby mogły działać równolegle z postępem technologicznym. Organizacje powinny być na bieżąco informowane o przepisach związanych ze sztuczną inteligencją i aktywnie współpracować z decydentami w celu kształtowania odpowiedzialnego zarządzania i praktyk w zakresie sztucznej inteligencji. Firmy mogą wykorzystywać sztuczną inteligencję do rozwiązań w zakresie ryzyka i zgodności, aby łatwo analizować ogromne ilości informacji i danych, identyfikując potencjalne ryzyko związane z zgodnością.

[Przeczytaj także: Jak uniknąć naruszeń zasad podczas opracowywania produktów AI]

Wyścig zbrojeń AI

Kiedy kraje wdają się w wyścig zbrojeń oparty na sztucznej inteligencji, może to oznaczać, że technologia sztucznej inteligencji rozwija się zbyt szybko, co może być niebezpieczne. Aby zapobiec tym zagrożeniom związanym ze sztuczną inteligencją, ważne jest zachęcanie do odpowiedzialnego rozwoju sztucznej inteligencji. Kraje powinny współpracować i zawierać porozumienia w sprawie wykorzystania sztucznej inteligencji w obronności. W ten sposób możemy zmniejszyć ryzyko wyrządzenia szkód przez sztuczną inteligencję w wyścigu o bardziej zaawansowaną technologię niż w innych krajach.

Utrata połączenia międzyludzkiego

Zwiększanie polegania na komunikacji i interakcjach opartych na sztucznej inteligencji może prowadzić do zmniejszenia empatii, umiejętności społecznych i powiązań międzyludzkich. Organizacje powinny nadać priorytet projektowaniu skoncentrowanemu na człowieku, podkreślając znaczenie utrzymywania znaczących interakcji międzyludzkich oprócz integracji sztucznej inteligencji.

Dezinformacja i manipulacja

Treści generowane przez sztuczną inteligencję, takie jak deepfakes, stwarzają znaczne ryzyko, przyczyniając się do rozpowszechniania fałszywych informacji i manipulowania opinią publiczną. Wdrożenie narzędzi opartych na sztucznej inteligencji do wykrywania dezinformacji i kampanii uświadamiających społeczeństwo może pomóc w zachowaniu integralności informacji w szybko rozwijającej się erze cyfrowej.

Niezamierzone konsekwencje

Ze względu na swoją złożoność systemy AI mogą wykazywać nieoczekiwane zachowania lub podejmować decyzje o nieprzewidzianych konsekwencjach. Rygorystyczne testy, walidacja i procesy ciągłego monitorowania są niezbędne, aby zidentyfikować i rozwiązać te problemy, zanim się eskalują i spowodują szkody.

Zagrożenia egzystencjalne

Stworzenie sztucznej inteligencji ogólnej (AGI) mądrzejszej od ludzi budzi duże obawy. Organizacje muszą upewnić się, że AGI podziela swoje wartości i cele, aby uniknąć strasznych konsekwencji. Wymaga to ostrożnego planowania długoterminowego, rygorystycznych zasad etycznych i współpracy na całym świecie, aby stawić czoła dużym ryzykom związanym z AGI.

Po przyjrzeniu się licznym wyzwaniom i zagrożeniom stwarzanym przez technologię sztucznej inteligencji oraz sposobom zarządzania niektórymi ryzykami związanymi ze sztuczną inteligencją, przejdźmy dalej i szczegółowo omówmy zarządzanie sztuczną inteligencją.

Zarządzanie sztuczną inteligencją w zarządzaniu ryzykiem

Skuteczne zarządzanie sztuczną inteligencją obejmuje identyfikację ryzyka związanego ze sztuczną inteligencją i zarządzanie nią za pomocą trzech kluczowych podejść:

Zasady: obejmują wytyczne ułatwiające rozwój systemów sztucznej inteligencji i ich wykorzystanie. Często są one zgodne ze standardami prawnymi i normami społecznymi.

Procesy: radzenie sobie z ryzykiem i potencjalnymi szkodami wynikającymi z wad projektowych i nieodpowiednich struktur zarządzania.

Świadomość etyczna: podejście to opiera się na poczuciu tego, co właściwe i dobre. Obejmuje przestrzeganie zasad, upewnianie się, że wszystko jest wykonywane prawidłowo, myślenie o własnej reputacji, bycie odpowiedzialnym społecznie oraz dopasowywanie się do wartości i przekonań organizacji.

Ograniczanie ryzyka związanego ze sztuczną inteligencją: jak zachować bezpieczeństwo dzięki sztucznej inteligencji

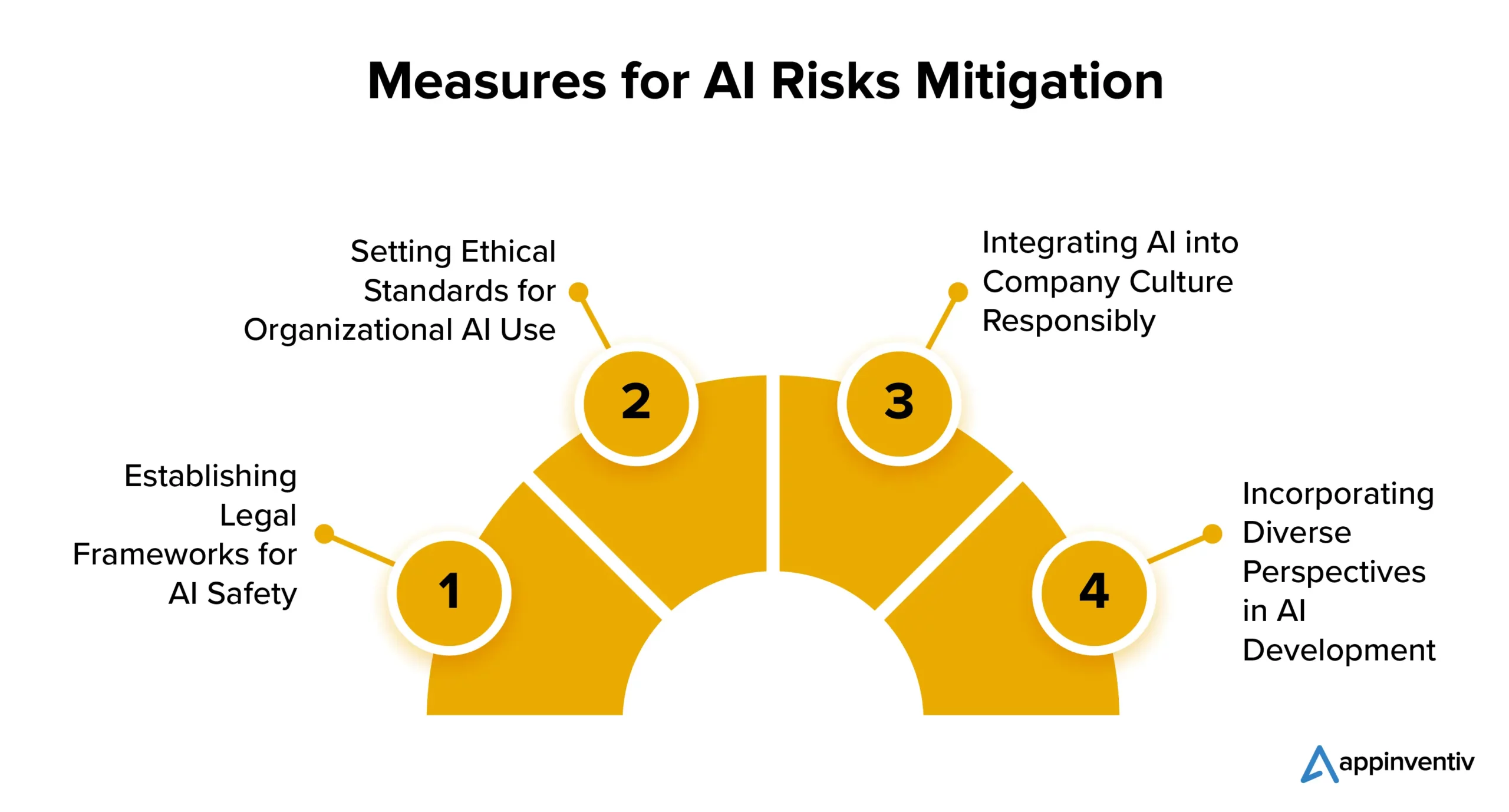

Oto kilka strategii, które firmy mogą zastosować, aby ograniczyć ryzyko związane z wdrożeniem sztucznej inteligencji:

Ustanawianie ram prawnych dla bezpieczeństwa sztucznej inteligencji

Wiele krajów koncentruje się na regulacjach dotyczących sztucznej inteligencji. Stany Zjednoczone i Unia Europejska pracują nad jasnym zestawem zasad kontroli rozprzestrzeniania się i wykorzystania sztucznej inteligencji. Chociaż niektóre technologie sztucznej inteligencji mogą napotkać ograniczenia, nie powinno to powstrzymywać przedsiębiorstw od odkrywania potencjału sztucznej inteligencji z korzyścią dla nich.

Ustanawianie standardów etycznych w zakresie wykorzystania sztucznej inteligencji w organizacji

Kluczowe znaczenie ma zrównoważenie przepisów z innowacjami. Sztuczna inteligencja ma kluczowe znaczenie dla postępu, dlatego organizacje powinny ustanowić standardy etycznego rozwoju i wykorzystania sztucznej inteligencji. Powinno to obejmować wdrożenie algorytmów monitorowania, wykorzystanie danych wysokiej jakości i przejrzystość w zakresie decyzji AI.

Odpowiedzialne integrowanie sztucznej inteligencji z kulturą firmy

Jedną z poszukiwanych strategii ograniczania ryzyka AI jest wprowadzenie AI do samej kultury firmy. Firmy mogą zintegrować sztuczną inteligencję ze swoją kulturą, ustanawiając akceptowalne wytyczne dotyczące technologii i procesów AI. Gwarantuje to, że sztuczna inteligencja będzie wykorzystywana w organizacji w sposób etyczny i odpowiedzialny, minimalizując w ten sposób prawdopodobne ryzyko związane ze sztuczną inteligencją.

Uwzględnianie różnych perspektyw w rozwoju sztucznej inteligencji

Twórcy sztucznej inteligencji powinni wziąć pod uwagę różne perspektywy, w tym te z różnych środowisk i dziedzin, takich jak prawo, filozofia i socjologia. To włączające podejście pomaga stworzyć odpowiedzialną sztuczną inteligencję, która przyniesie korzyści wszystkim.

W jaki sposób Appinventiv może pomóc w zapewnieniu najlepszych praktyk w zakresie rozwoju sztucznej inteligencji

Mimo że wykorzystanie sztucznej inteligencji stale rośnie, skuteczne zarządzanie ryzykiem nadal pozostaje niewystarczające. Wyzwanie polega na tym, że firmy często nie dostrzegają potrzeby interwencji ani praktyk w zakresie zrównoważonego rozwoju sztucznej inteligencji.

Według raportu MIT Sloan Management Review i Boston Consulting Group 42% respondentów uznało sztuczną inteligencję za najwyższy priorytet strategiczny, a tylko 19% potwierdziło, że ich organizacje wdrożyły odpowiedzialny program sztucznej inteligencji. Luka ta zwiększa ryzyko niepowodzenia i naraża firmy na problemy regulacyjne, finansowe i związane z reputacją spowodowane wdrożeniem sztucznej inteligencji.

Choć zarządzanie ryzykiem związanym ze sztuczną inteligencją można rozpocząć na dowolnym etapie projektu, istotne jest ustalenie ram zarządzania ryzykiem raczej wcześniej niż później. Może to zwiększyć zaufanie i umożliwić przedsiębiorstwom bezpieczne skalowanie.

Jako firma zajmująca się rozwojem sztucznej inteligencji, nasz zespół ma wieloletnie doświadczenie w tworzeniu rozwiązań AI, poparte silnym naciskiem na etykę i odpowiedzialność. Nasze udokumentowane osiągnięcia w różnych dziedzinach branży odzwierciedlają nasze zaangażowanie w dostosowywanie rozwiązań AI do podstawowych wartości i zasad etycznych.

Jesteśmy dobrze wyposażeni, aby pomóc Ci we wdrażaniu środków uczciwości, aby zapewnić, że Twoje rozwiązania biznesowe oparte na sztucznej inteligencji będą konsekwentnie podejmować bezstronne i bezstronne decyzje.

Niedawno opracowaliśmy YouComm, aplikację medyczną opartą na sztucznej inteligencji, która umożliwia pacjentom łączenie się z personelem szpitala za pomocą gestów dłoni i poleceń głosowych. Rozwiązanie jest obecnie wdrażane w ponad 5 sieciach szpitali w całych Stanach Zjednoczonych.

Skontaktuj się z naszymi ekspertami, aby w pełni zrozumieć powiązane zarządzanie ryzykiem AI w Twoim projekcie i dowiedzieć się, jak możesz je łatwo złagodzić.

Często zadawane pytania

P. Jakie są zagrożenia związane ze sztuczną inteligencją?

Odpowiedź: Sztuczna inteligencja niesie ze sobą nieodłączne ryzyko, w tym stronniczość, obawy dotyczące prywatności, dylematy etyczne i zagrożenia bezpieczeństwa. Może również prowadzić do przenoszenia stanowisk pracy, pogłębiać nierówności ekonomiczne oraz stwarzać wyzwania prawne i regulacyjne. Ponadto rozwój superinteligentnej sztucznej inteligencji budzi egzystencjalne obawy dotyczące dostosowania się do ludzkich wartości. Aby zapewnić odpowiedzialne i korzystne wykorzystanie technologii oraz uniknąć związanych z nią zagrożeń związanych ze sztuczną inteligencją, kluczowe znaczenie ma wdrożenie ostrożnego zarządzania, względów etycznych i środków regulacyjnych.

P. W jaki sposób można wykorzystać sztuczną inteligencję do ograniczenia ryzyka związanego ze sztuczną inteligencją?

O. Sztuczna inteligencja odgrywa znaczącą rolę w ograniczaniu ryzyka związanego ze sztuczną inteligencją, ułatwiając wykrywanie i korygowanie błędów stronniczości, analizy predykcyjne, monitorowanie bezpieczeństwa, wspieranie decyzji etycznych itp. Przyjrzyjmy się, jak możemy szczegółowo pomóc w ograniczaniu ryzyka związanego ze sztuczną inteligencją:

- Algorytmy sztucznej inteligencji mogą identyfikować i korygować błędy w danych, redukując stronnicze wyniki sztucznej inteligencji.

- Analityka predykcyjna może przewidywać ryzyko i umożliwiać podjęcie działań zapobiegawczych.

- Narzędzia cyberbezpieczeństwa oparte na sztucznej inteligencji mogą wykrywać zagrożenia oparte na sztucznej inteligencji i przeciwdziałać im.

- Sztuczna inteligencja może pomóc w podejmowaniu etycznych wyborów.

- Automatyzacja może zapewnić zgodność z przepisami, zmniejszając ryzyko związane z przestrzeganiem przepisów.