Ocena narzędzi do skrobania sieci: co przedsiębiorstwa muszą wiedzieć

Opublikowany: 2024-05-15Skanowanie sieci za pomocą zautomatyzowanych narzędzi do skrobania sieci ma kluczowe znaczenie dla organizacji chcących wykorzystać duże zbiory danych. Umożliwia automatyczne pobieranie odpowiednich informacji z różnych źródeł internetowych, co jest niezbędne do analizy opartej na danych.

Wydobywając aktualne trendy rynkowe, preferencje konsumentów i wiedzę o konkurencji, firmy mogą:

- Dokonuj świadomych wyborów strategicznych

- Dopasuj produkty do potrzeb klienta

- Optymalizuj ceny pod kątem konkurencyjności na rynku

- Zwiększ efektywność operacyjną

Co więcej, po połączeniu z narzędziami analitycznymi, zebrane dane stanowią podstawę modeli predykcyjnych, wzbogacając procesy decyzyjne. Ta wiedza o konkurencji motywuje przedsiębiorstwa do przewidywania zmian na rynku i aktywnego działania, utrzymując przewagę krytyczną w swoich sektorach.

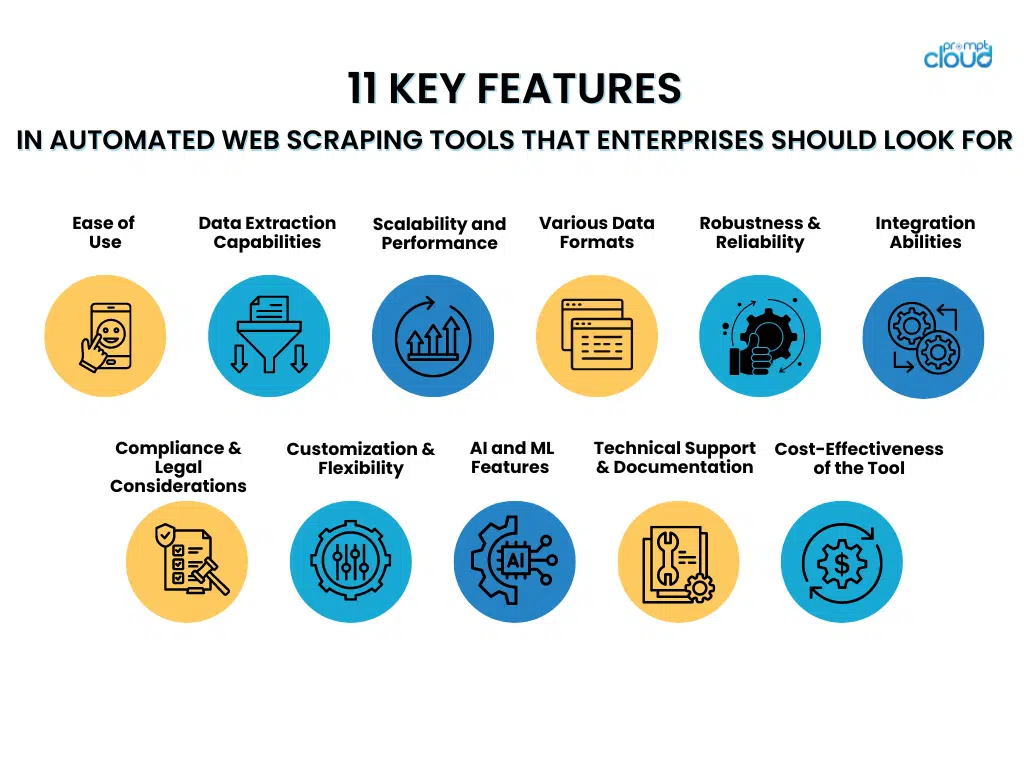

11 kluczowych funkcji automatycznych narzędzi do przeszukiwania sieci, których powinny szukać przedsiębiorstwa

- Łatwość użycia

Wybierając narzędzia do automatycznego przeglądania stron internetowych, firmy powinny preferować narzędzia wyposażone w łatwe w obsłudze interfejsy i łatwe w konfiguracji kroki. Narzędzia z intuicyjnymi interfejsami umożliwiają pracownikom efektywne korzystanie z nich bez konieczności przeprowadzania intensywnych szkoleń, co pozwala na skupienie się na wyszukiwaniu danych zamiast na opanowaniu skomplikowanych systemów.

Z drugiej strony nieskomplikowane metody konfiguracji ułatwiają szybkie wdrożenie tych narzędzi, minimalizując opóźnienia i przyspieszając drogę do cennych spostrzeżeń. Funkcje, które przyczyniają się do łatwości użytkowania, obejmują:

- Przejrzyste i proste menu nawigacyjne

- Funkcje „przeciągnij i upuść” do projektowania przepływu pracy

- Gotowe szablony do typowych zadań skrobania

- Kreatory krok po kroku prowadzące wstępną konfigurację

- Obszerna dokumentacja i samouczki ułatwiające naukę

Przyjazne dla użytkownika narzędzie maksymalizuje efektywność pracowników i pomaga utrzymać wysoki poziom produktywności.

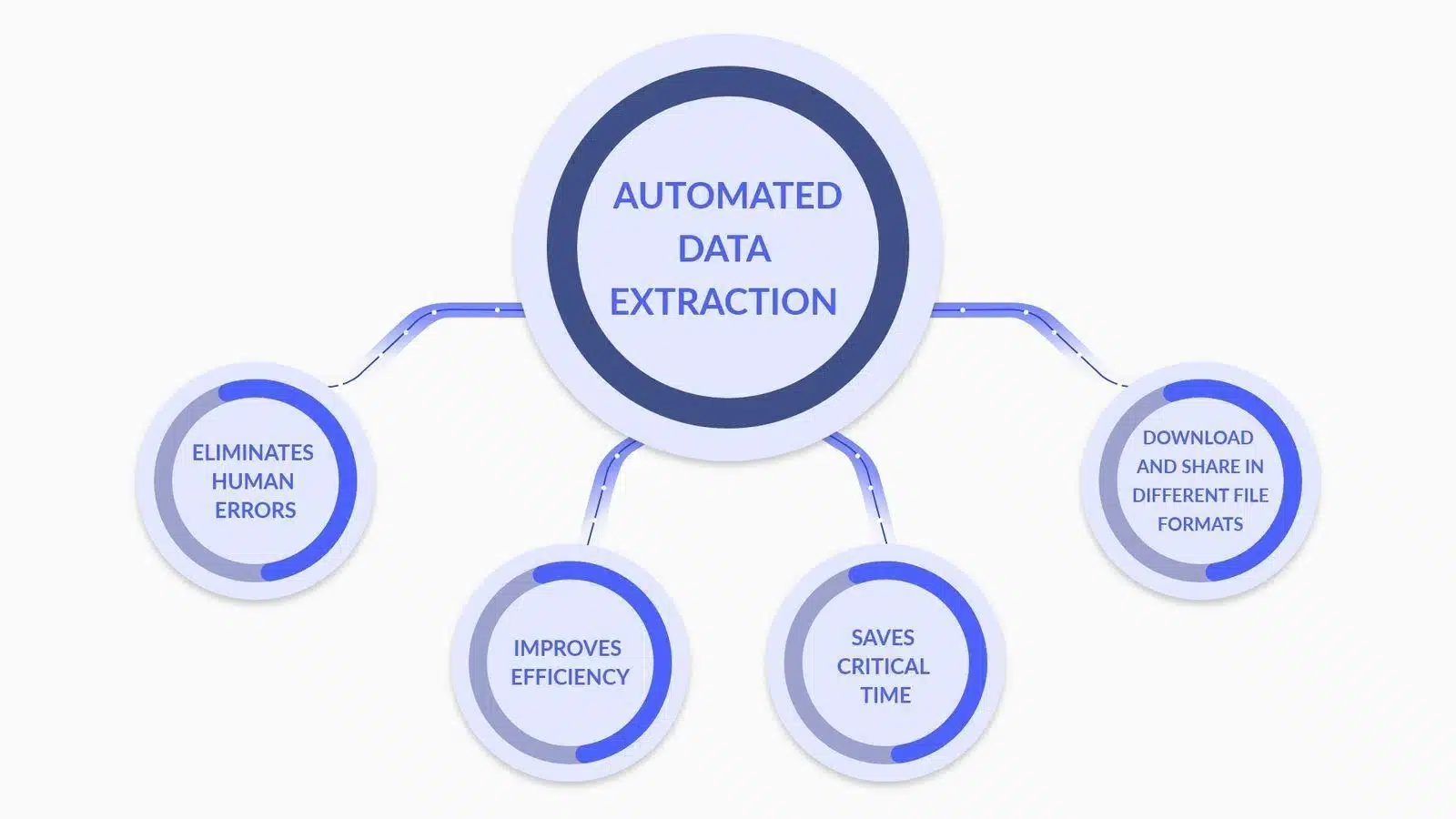

- Możliwości ekstrakcji danych

Źródło obrazu: Co to jest ekstrakcja danych? Oto, co musisz wiedzieć

Oceniając zautomatyzowane narzędzia do skrobania stron internetowych, przedsiębiorstwa powinny nadać priorytet zaawansowanym funkcjom analizowania i przekształcania danych, takim jak:

- Niestandardowe analizowanie danych : Możliwość dostosowywania parserów w celu dokładnej interpretacji złożonych struktur danych, w tym zawartości zagnieżdżonej i dynamicznej.

- Konwersja typów danych : narzędzia, które automatycznie konwertują wyodrębnione dane na użyteczne formaty (np. daty, liczby, ciągi znaków) w celu bardziej wydajnego przetwarzania danych.

- Obsługa wyrażeń regularnych : włączenie funkcji wyrażeń regularnych w celu zaawansowanego dopasowywania wzorców, co pozwala na precyzyjną ekstrakcję danych.

- Transformacja warunkowa : Możliwość zastosowania logiki warunkowej do wyodrębnionych danych, umożliwiając transformację w oparciu o określone kryteria lub wzorce danych.

- Czyszczenie danych : funkcje czyszczące i standaryzujące dane w fazie po ekstrakcji, aby zapewnić jakość i spójność danych.

- Integracja API : funkcje umożliwiające bezproblemową integrację z interfejsami API w celu dalszego przetwarzania i analizowania wyodrębnionych danych, zwiększając możliwości podejmowania decyzji.

Każda funkcja przyczynia się do bardziej niezawodnego i dokładnego procesu ekstrakcji danych, co ma kluczowe znaczenie w przypadku prób skrobania sieci na poziomie przedsiębiorstwa.

- Skalowalność i wydajność

Oceniając zautomatyzowane narzędzia do skrobania sieci, przedsiębiorstwa powinny priorytetowo potraktować skalowalność i atrybuty wydajności, które wspierają wydajne przetwarzanie ogromnych zbiorów danych.

Idealne narzędzie może sprawnie poradzić sobie ze znacznym wzrostem obciążenia bez utraty szybkości i dokładności. Przedsiębiorstwa muszą szukać takich funkcji, jak:

- Możliwości wielowątkowości umożliwiające współbieżne przetwarzanie danych

- Efektywne zarządzanie pamięcią w celu obsługi zadań skrobania na dużą skalę

- Dynamiczna alokacja zasobów na podstawie zapotrzebowania w czasie rzeczywistym

- Solidna infrastruktura, którą można skalować w poziomie lub w pionie

- Zaawansowane mechanizmy buforowania przyspieszające pobieranie danych

Zdolność narzędzia do utrzymywania wydajności pod obciążeniem zapewnia niezawodną ekstrakcję danych, nawet w godzinach szczytu lub podczas zwiększania skali operacji.

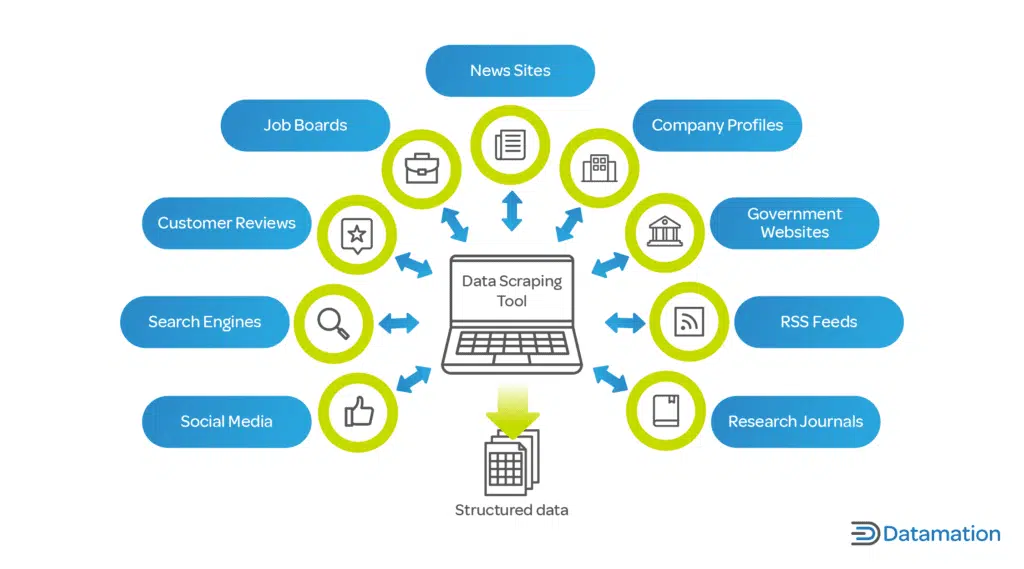

- Obsługa różnych formatów danych

Źródło obrazu: Co to jest skrobanie danych? Definicja i sposób użycia

Zautomatyzowane narzędzie do skrobania stron internetowych musi sprawnie obsługiwać różnorodne formaty danych. Przedsiębiorstwa często pracują z różnymi typami danych, a elastyczność w ekstrakcji danych ma kluczowe znaczenie:

- JSON: lekki format wymiany danych, który jest łatwy do odczytu i zapisu dla ludzi oraz łatwy do analizowania i generowania przez maszyny.

- CSV: Format wartości oddzielonych przecinkami to powszechny, prosty format plików używany w przypadku danych tabelarycznych. Większość narzędzi do skrobania powinna zapewniać opcję eksportu CSV.

- XML: Extensible Markup Language, bardziej złożony format, który zawiera metadane i może być używany w wielu branżach.

Możliwość wyodrębniania i eksportowania danych w tych formatach zapewnia kompatybilność z różnymi narzędziami i systemami analizy danych, oferując wszechstronne rozwiązanie spełniające wymagania przedsiębiorstw.

- Solidność i niezawodność

Kiedy przedsiębiorstwa wybierają zautomatyzowane narzędzia do skrobania sieci, muszą priorytetowo potraktować solidność i niezawodność. Kluczowe funkcje, które należy wziąć pod uwagę, obejmują:

- Kompleksowa obsługa błędów : doskonałe narzędzie powinno mieć możliwość automatycznego wykrywania i naprawiania błędów. Powinien rejestrować problemy i, jeśli to możliwe, ponawiać nieudane żądania bez ręcznej interwencji.

- Strategie minimalizacji przestojów : narzędzie powinno obejmować mechanizmy przełączania awaryjnego, takie jak serwery zapasowe lub alternatywne źródła danych, w celu utrzymania operacji w przypadku awarii źródeł głównych.

- Systemy ciągłego monitorowania : Monitorowanie w czasie rzeczywistym zapewnia natychmiastową identyfikację i wyeliminowanie wszelkich przestojów, minimalizując luki w danych.

- Konserwacja predykcyjna : wykorzystanie uczenia maszynowego do przewidywania potencjalnych punktów awarii może zapobiegawczo zapobiegać przestojom, zwiększając niezawodność systemu.

Inwestowanie w narzędzia, które podkreślają te aspekty solidności i niezawodności, może znacznie zmniejszyć ryzyko operacyjne związane ze skrobaniem sieci.

- Zdolności integracyjne

Oceniając zautomatyzowane narzędzia do skrobania sieci, przedsiębiorstwa muszą zagwarantować zdolność do płynnej integracji z bieżącymi potokami danych. Jest to niezbędne do utrzymania ciągłości przepływu danych i optymalizacji procesu. Narzędzie powinno:

- Oferuj interfejsy API lub konektory kompatybilne z istniejącymi bazami danych i platformami analitycznymi.

- Obsługa różnych formatów danych w celu płynnego importu/eksportu przy minimalnych zakłóceniach.

- Zapewnij funkcje automatyzacji, które mogą być wyzwalane przez zdarzenia w potoku danych.

- Ułatw sobie łatwe skalowanie bez konieczności obszernej rekonfiguracji w miarę ewolucji potrzeb w zakresie danych.

- Zgodność i względy prawne

Integrując zautomatyzowane narzędzie do przeszukiwania stron internetowych z działalnością przedsiębiorstwa, niezwykle ważne jest zapewnienie, że narzędzie to jest zgodne z ramami prawnymi. Funkcje, które należy wziąć pod uwagę, obejmują:

- Szacunek dla pliku robots.txt : narzędzie powinno automatycznie potwierdzać i stosować się do pliku robots.txt witryny, który określa uprawnienia do skrobania.

- Ograniczanie szybkości : Aby uniknąć zakłócającego obciążenia serwerów hosta, narzędzia muszą obejmować regulowane ograniczanie szybkości w celu kontrolowania częstotliwości żądań.

- Zgodność z zasadami ochrony danych : narzędzie powinno zostać zbudowane zgodnie z globalnymi przepisami dotyczącymi ochrony danych, takimi jak RODO lub CCPA, zapewniając, że dane osobowe są przetwarzane zgodnie z prawem.

- Świadomość własności intelektualnej : Narzędzie powinno posiadać mechanizmy zapobiegające naruszaniu praw autorskich podczas skrobania treści objętych prawami autorskimi.

- Przejrzystość agenta użytkownika : zdolność narzędzia do skrobania do dokładnej i przejrzystej identyfikacji w docelowych witrynach internetowych, zmniejszając ryzyko zwodniczych praktyk.

Uwzględnienie tych funkcji może pomóc w ograniczeniu ryzyka prawnego i ułatwić realizację odpowiedzialnej strategii skrobania, która szanuje zarówno treści zastrzeżone, jak i prywatność użytkowników.

- Personalizacja i elastyczność

Aby skutecznie spełnić swoje unikalne wymagania w zakresie gromadzenia danych, przedsiębiorstwa muszą wziąć pod uwagę możliwości dostosowywania i elastyczność zautomatyzowanego narzędzia do skrobania sieci jako kluczowe czynniki podczas oceny. Doskonałe narzędzie powinno:

- Oferuj przyjazny interfejs dla użytkowników nietechnicznych, aby dostosować parametry ekstrakcji danych.

- Zapewnij programistom zaawansowane opcje pisania niestandardowych skryptów lub korzystania z interfejsów API.

- Umożliwiają łatwą integrację z istniejącymi systemami i przepływami pracy w przedsiębiorstwie.

- Włącz planowanie działań skrobania, które będą uruchamiane poza godzinami szczytu, zmniejszając obciążenie serwerów i unikając potencjalnego ograniczania przepustowości witryny.

- Dostosuj się do różnych struktur witryn internetowych i typów danych, zapewniając obsługę szerokiego zakresu przypadków użycia.

Dostosowanie i elastyczność zapewniają, że narzędzie może ewoluować wraz ze zmieniającymi się potrzebami przedsiębiorstwa, maksymalizując wartość i skuteczność działań związanych z wyszukiwaniem stron internetowych.

- Zaawansowane funkcje sztucznej inteligencji i uczenia maszynowego

Wybierając narzędzie do automatycznego przeglądania stron internetowych, przedsiębiorstwa muszą rozważyć integrację zaawansowanej sztucznej inteligencji i uczenia maszynowego w celu poprawy dokładności danych. Funkcje te obejmują:

- Rozumienie kontekstowe : zastosowanie przetwarzania języka naturalnego (NLP) umożliwia narzędziu rozpoznanie kontekstu, redukując błędy w zeskrobanej treści.

- Rozpoznawanie wzorców : Algorytmy uczenia maszynowego identyfikują wzorce danych, ułatwiając dokładne wyodrębnianie informacji.

- Uczenie się adaptacyjne : narzędzie uczy się na podstawie poprzednich zadań skrobania, aby zoptymalizować procesy gromadzenia danych na potrzeby przyszłych zadań.

- Wykrywanie anomalii : systemy AI mogą wykrywać i korygować wartości odstające lub anomalie w zeskrobanych danych, zapewniając niezawodność.

- Walidacja danych : wykorzystanie sztucznej inteligencji do krzyżowej weryfikacji zebranych danych z wieloma źródłami zwiększa ważność informacji.

Wykorzystując te możliwości, przedsiębiorstwa mogą znacznie zmniejszyć niedokładności w swoich zbiorach danych, co prowadzi do bardziej świadomego podejmowania decyzji.

- Wsparcie techniczne i dokumentacja

Zaleca się, aby firmy preferowały zautomatyzowane narzędzia do skrobania sieci, które zapewniają obszerną pomoc techniczną i dokładną dokumentację. Ma to kluczowe znaczenie dla:

- Minimalizacja przestojów : szybkie, profesjonalne wsparcie zapewnia szybkie rozwiązywanie wszelkich problemów.

- Łatwość użycia : Dobrze zorganizowana dokumentacja pomaga w szkoleniu użytkowników i opanowaniu narzędzi.

- Rozwiązywanie problemów : dostępne przewodniki i zasoby umożliwiają użytkownikom samodzielne rozwiązywanie typowych problemów.

- Aktualizacje i ulepszenia : spójne wsparcie i przejrzysta dokumentacja są niezbędne do skutecznego poruszania się po aktualizacjach systemu i nowych funkcjach.

Wybór narzędzia z solidnym wsparciem technicznym i przejrzystą dokumentacją jest niezbędny do płynnego działania i skutecznego rozwiązywania problemów.

- Ocena opłacalności narzędzia

Przedsiębiorstwa powinny wziąć pod uwagę zarówno początkowe wydatki, jak i możliwy zwrot z inwestycji, oceniając oprogramowanie do automatyzacji web scrapingu. Kluczowe czynniki cenowe obejmują:

- Opłaty licencyjne lub koszty subskrypcji

- Koszty utrzymania i wsparcia

- Potencjalne oszczędności wynikające z automatyzacji

- Skalowalność i możliwość dostosowania do przyszłych potrzeb

Dokładna ocena zwrotu z inwestycji (ROI) narzędzia powinna uwzględniać jego potencjał w zakresie ograniczenia pracy ręcznej, zwiększenia precyzji danych i przyspieszenia procesu zdobywania spostrzeżeń. Ponadto przedsiębiorstwa powinny ocenić trwałe korzyści, takie jak zwiększona konkurencyjność wynikająca z wyborów opartych na danych. Porównanie tych pomiarów z kosztem narzędzia da wyraźny obraz jego opłacalności.

Wniosek

Wybierając narzędzie do automatycznego przeglądania stron internetowych, firmy powinny dokładnie rozważyć każdą funkcję w odniesieniu do swoich konkretnych wymagań. Niezbędne jest podkreślanie takich aspektów, jak skalowalność, precyzja danych, szybkość, legalność i efektywność kosztowa. Idealne narzędzie będzie wspierać cele firmy i płynnie integrować się z obecnymi systemami. Ostatecznie świadomy wybór wynika z dokładnego zbadania funkcji narzędzia i solidnego zrozumienia przyszłych potrzeb firmy w zakresie danych.