„Dlaczego” stojące za głównymi spadkami ruchu SERP w SaaS i nie tylko

Opublikowany: 2024-05-31Treść artykułu

Spadek ruchu w witrynie może wynikać z różnych przyczyn, w tym z trendów dotyczących słów kluczowych, prób rebrandingu i kar.

Jednak niektóre spadki są spowodowane nieuchwytnymi zmianami algorytmów wyszukiwania, które sprawiają, że firmy muszą szukać odpowiedzi, szczególnie w przestrzeni SaaS. Te aktualizacje algorytmów mogą mieć ogromny wpływ, wstrząsając stabilnością strategii marketingu organicznego. Niedawne dyskusje, takie jak ten tweet podkreślający zauważalny spadek ruchu w ClickUp w ciągu ostatnich kilku miesięcy, podkreślają te obawy.

Według Ahrefs, @clickup stracił w ciągu dwóch miesięcy około 50% ruchu organicznego.

Liczba ta wzrosła z 1,9 mln na początku lutego do 900 tys. obecnie.

pic.twitter.com/xUDOKkNieo

— Nico Cerdeira (Failory.com) (@nicocerdeira) 2 maja 2024 r.

Firmy SaaS i inne firmy muszą zachować czujność i dostosowywać się, aby poradzić sobie z tymi nieprzewidywalnymi zmianami w algorytmach wyszukiwarek i utrzymać swoją widoczność w Internecie. Zrozumienie zawiłości stojących za tymi spadkami ruchu ma kluczowe znaczenie dla utrzymania wzrostu i uniknięcia pułapek spadków wywołanych algorytmem.

Niepewność (i kontrowersje) w SEOlandzie

Obecnie w SEOlandzie panuje wiele niepewności i więcej niż trochę kontrowersji. Wynika to w dużej mierze z faktu, że zauważalny jest spadek całkowitego ruchu internetowego w różnych branżach.

Według raportu Contentsquare Digital Experience Benchmark Report 2024 , całkowita roczna zmiana ruchu w zeszłym roku wyniosła -3,6%. Spadek był jeszcze bardziej wyraźny w branżach takich jak usługi (-9,4%), energia, usługi komunalne i budownictwo (-8,3%) oraz oprogramowanie (-7,8%).

![Zmiana ruchu w ujęciu rocznym według branży [Contentsquare]](/uploads/article/23621/NXsGWAwvlNFBBqzK.png)

Od platform społecznościowych i forów po wydarzenia branżowe – marketerzy są szczególnie zaniepokojeni złotą gęsią wzrostu ruchu w sieci: wyszukiwaniem organicznym.

Analitycy rynku i firmy badawcze szacują wycenę globalnej branży SEO na około 70–80 miliardów dolarów . W tej przestrzeni działają największe firmy produkujące oprogramowanie, agencje i niezliczona liczba specjalistów, nie wspominając o wszystkich firmach, które opierają się na tej praktyce.

To zrozumiałe, że ludzie byliby tak zaniepokojeni trajektorią tej branży.

Wgłębianie się w przyczyny poważnych strat w ruchu w branży technologicznej i nie tylko

Jednym z głównych wyzwań dla branży SEO (a tak naprawdę każdej firmy, która potrzebuje cyfrowego śladu) jest to, że wyszukiwarki takie jak Google to czarna skrzynka.

Możemy analizować dane wejściowe (zapytania, witryny i strony internetowe) i śledzić dane wyjściowe (pozycję SERP), ale nikt z zewnątrz nie ma możliwości, aby w pełni wiedzieć wszystko, co ma wpływ na decyzje rankingowe. A według tysięcy dokumentów API wyszukiwarki Google, które wyciekły , czynniki rankingowe to coś, co do którego technologiczny gigant nie jest uczciwy.

Google próbuje oczyścić atmosferę, korzystając z informacji zwrotnych z Centrum wyszukiwania lub oświadczeń swojego łącznika ds. wyszukiwania i rzeczników takich jak John Mueller. Ale wciąż jest tak wiele, że nie wiemy. Na szczęście dzięki setkom tysięcy specjalistów SEO możliwe jest pozyskiwanie informacji wywiadowczych od społeczności.

Istnieje kilka głównych powodów, dla których główne witryny z branży technologicznej, medialnej i innych branż doświadczają tak poważnych zakłóceń w organicznym i ogólnym ruchu internetowym, a wszystkie one mają związek z działaniami podejmowanymi przez Google lub pojawieniem się sztucznej inteligencji:

- Przydatne treści, nadużycie reputacji i aktualizacje Google Core

- Rosnąca obecność dyskusji i treści forów tworzonych przez użytkowników

- Wzrost liczby treści generowanych przez sztuczną inteligencję

- Generacyjne doświadczenie wyszukiwania

Przyjrzyjmy się teraz każdemu z nich.

Aktualizacje Google Core

Według Seach Central Google wprowadza w ciągu roku kilka „znaczących, szeroko zakrojonych zmian w [swoich] algorytmach i systemach wyszukiwania”. Nierzadko zdarza się, że witryny o wysokich pozycjach po aktualizacji podstawowej doświadczają zmienności SERP — nawet jeśli „nie naruszyły zasad [Google] dotyczących spamu ani nie zostały poddane ręcznym lub algorytmicznym działaniom”.

Doświadczeni SEO wiedzą od ponad dziesięciu lat, że po aktualizacji rdzenia lub innej istotnej zmianie istnieje okres korekty i nie powinni reagować przesadnie. Uszkodzenia uboczne zazwyczaj z czasem ulegają naprawie (przynajmniej teoretycznie).

Ale aktualizacje z ostatnich kilku lat to inna historia.

Pomocna aktualizacja treści

Pierwsza aktualizacja Helpful Content Update (HCU) została uruchomiona w sierpniu 2022 r. jako próba automatycznego identyfikowania i kierowania treści tworzonych przede wszystkim w celu uzyskania dobrej pozycji w wyszukiwarkach, a nie pomagania użytkownikom. Pod koniec 2022 r. ta aktualizacja została rozszerzona poza witryny w języku angielskim na wszystkie języki.

We wrześniu 2023 r. Google ponownie zaktualizowało HCU w ramach dwutygodniowego wdrożenia, które pomogło w stworzeniu „ulepszonego klasyfikatora” z niewielką ilością szczegółów. Ta aktualizacja spowodowała znaczne spadki rankingów witryn internetowych z różnych branż, z których wiele jeszcze nie zostało przywrócone.

Szybka aktualizacja dotycząca witryn, na które ma wpływ wrześniowa aktualizacja HCU(X): Teraz, gdy minęły już dwa tygodnie od marcowej aktualizacji podstawowej, sprawdziłem dane dotyczące widoczności kilkuset witryn, na które miała wpływ wrześniowa aktualizacja HCU(X). Nie widziałem jeszcze żadnego, który wyzdrowiał. Właściwie większość spadła jeszcze bardziej (patrz… pic.twitter.com/MPFPGZdu9u

— Glenn Gabe (@glengabe) 21 marca 2024 r

W marcu Google włączył HCU do głównych systemów rankingowych, mając na celu redukcję nieprzydatnych treści o niskiej jakości o 40%. Według doniesień Google spełnił ten kryteria, ale jasne jest, że w tę sytuację zamieszanych jest także wielu niewinnych osób.

Aktualizacja spamu

Aby jeszcze bardziej skomplikować analizę problemu, integracja HCU w marcu 2024 r. zbiegła się z inną powiązaną zmianą w algorytmie Google: aktualizacją dotyczącą spamu. Google wdrożył tę aktualizację, aby zaradzić „spamowej treści o niskiej jakości”, obierając za cel trzy taktyki manipulacyjne :

- Skalowane nadużycia treści — wykorzystanie automatyzacji (inaczej sztucznej inteligencji lub młynów treści) do masowej produkcji treści kierowanych na popularne zapytania.

- Nadużycie wygasłych domen — kupowanie wygasłych domen i zmienianie ich przeznaczenia w celu zwiększenia widoczności treści o niskiej jakości.

- Nadużycie reputacji witryny — wykorzystanie wysokiego autorytetu witryny i reputacji marki do hostowania treści o niższej jakości od osób trzecich w celach rankingowych.

W ciągu ostatniego miesiąca aktualizacja dotycząca nadużyć w zakresie reputacji witryny wzbudziła duże zainteresowanie, zwłaszcza że wpłynęła na wiele szanowanych witryn internetowych, takich jak Reuters, The Washington Post, GQ i Wall Street Journal.

Glen Allsopp opisał zakres początkowego wpływu aktualizacji w tym tweecie:

Od marca monitoruję 2500 haseł związanych z kuponami, aby zobaczyć, co Google zmieni w swojej aktualizacji dotyczącej nadużycia reputacji witryny.

Dzisiaj rozpoczęły się ręczne działania i oto kilka wczesnych spostrzeżeń.

Śledziłem wiele treści stron trzecich niebędących kuponami, które miałem zamiar… pic.twitter.com/dCbPgOTD9Q

— Glen Allsopp (@ViperChill) 7 maja 2024 r

Ponieważ zmienność po aktualizacjach osiągnęła w ciągu ostatnich kilku lat nowy poziom, niezwykle ważne jest, aby marki zachowały czujność w monitorowaniu wydajności sieci i SERP.

Dyskusje i zawartość forum

Budowanie obecności na platformach forum, takich jak Reddit i Quora, jest kluczową częścią działań marketingowych, takich jak badania, dystrybucja treści i zaangażowanie społeczności. Cóż, teraz możesz dodać widoczność SERP do tej listy.

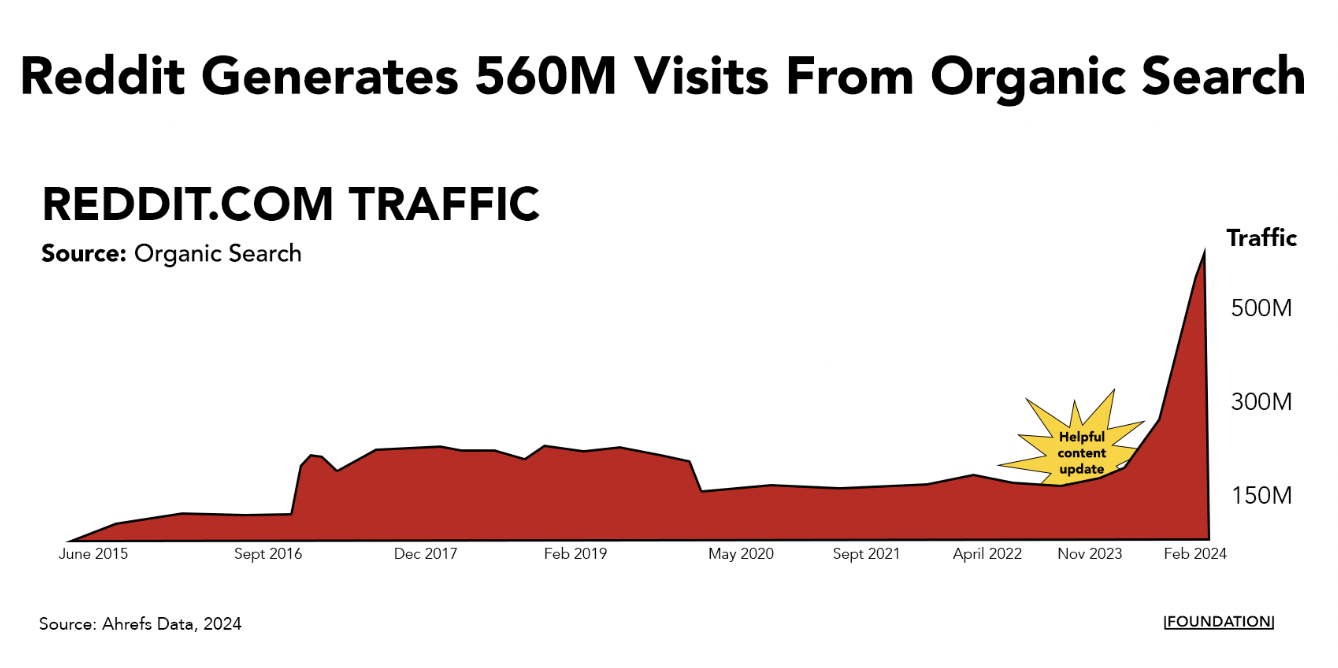

W ciągu ostatnich kilku lat Reddit i Quora zaczęły dominować na najwyższych pozycjach SERP dla kilku różnych zapytań. Podczas gdy ruch organiczny w witrynach biznesowych i medialnych spadł w zeszłym roku, Reddit i Quora odnotowały wykładniczy wzrost ruchu.

Sam Reddit generuje co miesiąc ponad 560 milionów odwiedzin z bezpłatnych wyników wyszukiwania i obecnie plasuje się w pierwszej trójce pod względem prawie 11 milionów słów kluczowych.

Ten rodzaj stromego nachylenia sugeruje, że w przypadku tego typu popularnych forów istnieje przewaga algorytmiczna. Współpracownik wyszukiwarki Google Mike Sullivan przyznał to w rozmowie z Lily Ray w X:

Jednostka ta pojawia się automatycznie, jeśli systemy uznają, że może być istotna i użyteczna. To nie jest tak, że ktoś powiedział „postaw to na pierwszym miejscu w przypadku tego konkretnego zapytania” – co wiem, że rozumiesz, ale inni czytający to mogą nie. To powiedziawszy, doceniam troskę i problem, i…

— Google SearchLiaison (@searchliaison) 3 kwietnia 2024 r

Z pewnością prawdą jest, że ludzie chętniej dyskutują na forach na tych platformach, szczególnie gdy szukają niefiltrowanych opinii na temat produktów i usług. (Cały czas korzystam z Reddit i Quora.)

To powiedziawszy, istnieje wiele przykładów przypadków, w których dany temat zasługuje na bardziej doświadczoną odpowiedź niż ta, którą można uzyskać w (przeważnie) anonimowych dyskusjach na Reddicie. Zapytania o Twoje pieniądze lub życie (YMYL) dotyczące na przykład ważnych tematów związanych ze zdrowiem i finansami.

Możliwe jest również, że mniejsze zmiany w algorytmie nadającym priorytet tego typu treściom przyniosą korzyści Redditowi i Quorze, ponieważ mają one tak ogromne witryny internetowe i poziomy uprawnień domeny.

Niezależnie od przyczyny nie wygląda na to, że Google w najbliższym czasie będzie uciekał od forów — właśnie ogłosił podpisanie dużej umowy z Redditem, w ramach której będzie wykorzystywać dane platformy do szkolenia swojej sztucznej inteligencji. To tylko kolejny z wielu powodów , dla których musisz zaistnieć na platformie.

Treści generowane przez sztuczną inteligencję

Treści generowane przez sztuczną inteligencję podbiły świat wkrótce po tym, jak ChatGPT zapoczątkował boom generatywnej sztucznej inteligencji kilka lat temu. Nawet niektóre główne marki SaaS, takie jak CNET, wykorzystały tę strategię.

W tym czasie było wielu guru marketingu i biznesu, którzy chcieli wykorzystać to jako taktykę hakowania wzrostu poprzez masową produkcję treści SEO. Na LinkedIn i X pojawiło się sporo znanych przykładów osób przechwalających się wynikami, jakie osiągnęły, publikując ogromną ilość treści generowanych przez sztuczną inteligencję.

Jednym z największych tego przykładów był napad na SEO, w ramach którego ktoś pobrał mapę witryny ze strony internetowej Exceljet, zamienił listę adresów URL na tytuły artykułów, a następnie za pomocą sztucznej inteligencji wygenerował ponad 1800 stron na dokładnie te same tematy. Strategia ta okazała się zaskakująco skuteczna, gdyż witryna zawierająca napady co miesiąc przynosiła setki tysięcy odwiedzin kosztem Exceljet.

Jednak eksperci śledzący tę strategię odkryli, że początkowe zyski, jakie firmy uzyskują z treści AI, często zanikają.

Na przykład Mark Williams-Cook prześledził wzrost i upadek wielu witryn internetowych, które zaangażowały się w strategie SEO Heist lub skalowanie AI. Większość z tych witryn odnotowuje znaczny wzrost ruchu organicznego w krótkim okresie – zwykle trwa to kilka miesięcy, ale w niektórych przypadkach może to potrwać dłużej – zanim nastąpi gwałtowny spadek, sygnalizujący, że algorytm się przyjął.

Niezła aktualizacja @sistrix dotycząca witryny „Napad na SEO”, która wykorzystywała sztuczną inteligencję do tworzenia treści. Wygląda na to, że wkrótce zakończy się w gorszym miejscu niż na początku. pic.twitter.com/SKY2ViXiwV

— Mark Williams-Cook (@markcandour) 4 grudnia 2023 r

Jeśli więc zauważasz znaczny spadek ruchu związanego z wyszukiwaniem, rozważ następujące kwestie:

- Czy Twoja firma korzysta ze sztucznej inteligencji do generowania dużej ilości (prawdopodobnie niskiej jakości) treści SEO na dużą skalę?

- Czy pojawiają się nowe witryny internetowe dokładnie w obrębie SERP, na które chcesz kierować reklamy?

Jeśli to pierwsze rozwiązanie, a już inwestujesz w tworzenie wysokiej jakości treści, najprawdopodobniej z czasem problem sam się rozwiąże. Jeśli to drugie, czas ulepszyć przepływ pracy z treściami AI .

Możesz skalować produkcję treści za pomocą sztucznej inteligencji, ale powinno to polegać nawzmacnianiu, a nie zastępowaniu zespołu. Pisarze mogą korzystać z narzędzi takich jak ChatGPT, Jasper lub Gemini, aby usprawnić tworzenie pomysłów, badania i etapy pośrednie, pozostawiając więcej czasu na kreatywne opowiadanie historii.

Aby uniknąć potencjalnych kar i utrzymać długoterminowy wzrost ruchu, upewnij się, że Twoje treści wspomagane sztuczną inteligencją dodają prawdziwą wartość, oferują unikalne spostrzeżenia i utrzymują wysoki standard jakości.

Sprawdź naszą listę kontrolną podnoszenia poziomu treści wspomaganą sztuczną inteligencją, aby dowiedzieć się, jak krok po kroku tworzyć treści o wysokiej wartości na dużą skalę.

Wyszukaj doświadczenie generatywne

Treści spamowe i napady na SEO to nie jedyny wpływ, jaki sztuczna inteligencja wywiera na SERP. Generatywna optymalizacja silnika może wpłynąć na wielkość ruchu, gdy ludzie zaczną korzystać ze sztucznej inteligencji zamiast tradycyjnych wyszukiwarek.

Google już się na to przygotowało. Firma ogłosiła nową funkcję podsumowań generowaną przez sztuczną inteligencję, przeglądy AI, obsługiwaną przez własny LLM. Obecnie jest wdrażany w USA i spotyka się z bardzo mieszanymi recenzjami .

Z wczesnego raportu Tomasza Rudzkiego i Ziptie.dev wynika, że przeglądy AI Google pojawiają się średnio w ponad 80% zapytań.

W szczególności badanie podkreśla, że niektóre nisze, takie jak FinTech, mogą być bezpieczniejsze w przypadku AIO niż inne. Jednak w przeważającej części dominują odpowiedzi SGE. Odpowiedzi wygenerowane przez sztuczną inteligencję pojawiają się automatycznie w około jednej trzeciej SERPów, podczas gdy przez resztę czasu użytkownicy muszą kliknąć, aby je wygenerować.

Co to wszystko oznacza dla marek? Nadszedł czas, aby nadać priorytet generatywnemu doświadczeniu wyszukiwania (SGE) — podróżom wyszukiwania, które są bardziej wciągające i spersonalizowane niż tradycyjne podróże dzięki sztucznej inteligencji.

Narzędzia takie jak ChatGPT, Gemini i Perplexity różnią się wyglądem od tradycyjnych SERP Google, ale zawierają adresy URL witryn, których używają do generowania wyników.

Jest jeszcze za wcześnie, aby dokładnie określić,jak bardzoSGE/GEO będzie się różnić od tradycyjnego SEO, ale z pewnością istnieją pewne podobieństwa. Aby zoptymalizować działania pod kątem SGE, firmy powinny skoncentrować się na dostarczaniu jasnych, zwięzłych i dokładnych informacji, które mogą być łatwo analizowane przez systemy sztucznej inteligencji. Obejmuje to dane strukturalne, dobrze sformatowane odpowiedzi na często zadawane pytania oraz treści, które bezpośrednio odnoszą się do intencji użytkownika.

Bądźcie pewni, jest to coś, co my w Fundacji i reszta branży będziemy uważnie obserwować w przyszłości.

Rozszerz swój zasięg poza wyszukiwanie dzięki silnikowi dystrybucji

Krajobraz bezpłatnych wyników wyszukiwania ulega znaczącym zmianom ze względu na aktualizacje algorytmów i rozwój sztucznej inteligencji – więc obawy są zrozumiałe. Ale ważniejsze jest działanie.

Z jednej strony firmy muszą się dostosować, koncentrując się na wysokiej jakości treściach zorientowanych na użytkownika i wykorzystując nowe możliwości, jakie dają technologie sztucznej inteligencji. Chociaż wpływ nowych przeglądów AI dopiero zaczyna być odczuwalny, ważne jest, aby rozszerzyć swój zasięg poza tradycyjne metody wyszukiwania.

Zainwestuj w podręcznik pełnej dystrybucji , aby mieć pewność, że możesz utrzymać i rozwijać swoją obecność w Internecie w tym rozwijającym się środowisku.