Skuteczne techniki indeksowania sieci w zastosowaniach Big Data

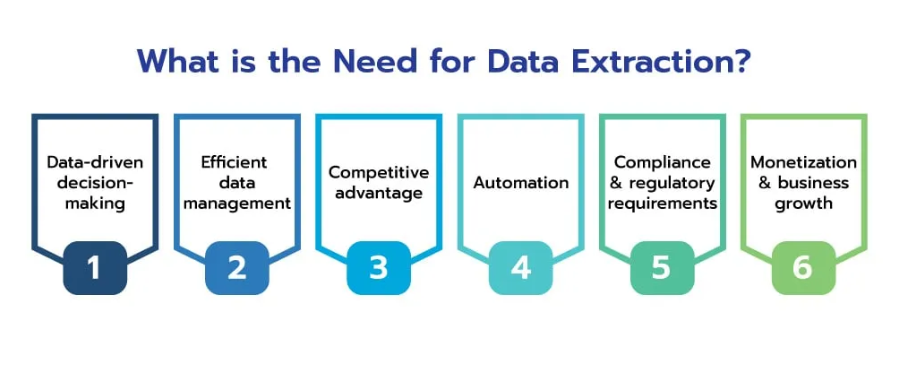

Opublikowany: 2024-06-06W epoce dużych zbiorów danych indeksowanie stron internetowych stało się niezbędnym procesem dla firm chcących wykorzystać ogromne bogactwo informacji dostępnych w Internecie. Skutecznie gromadząc, przetwarzając i analizując dane internetowe na dużą skalę, firmy mogą odblokować cenne spostrzeżenia i zyskać przewagę konkurencyjną w różnych branżach.

Dane internetowe mają ogromny potencjał, oferując głęboki wgląd w trendy rynkowe, zachowania konsumentów i krajobrazy konkurencyjne. Zdolność do skutecznego gromadzenia i analizowania tych danych może przekształcić surowe informacje w przydatne informacje, które pomogą w podejmowaniu strategicznych decyzji i rozwoju firmy.

źródło: scrapehero

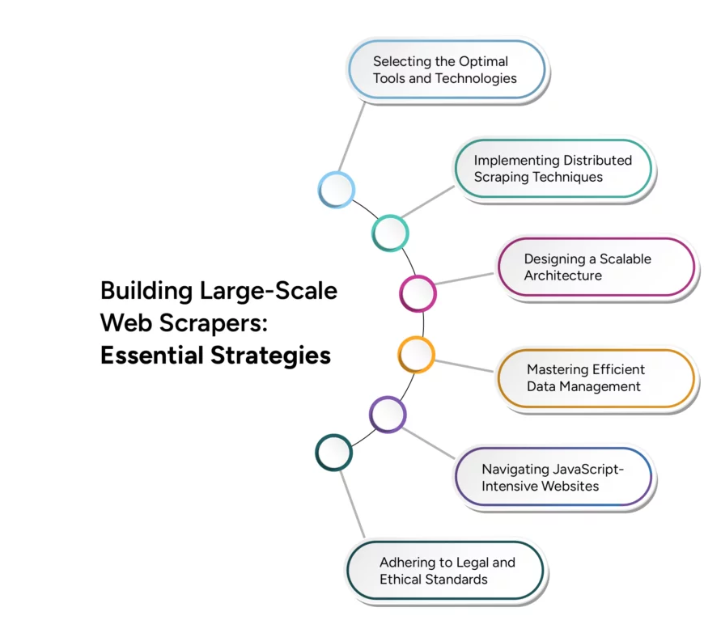

Jednakże przejście od skrobania sieci na małą skalę do przeszukiwania sieci na dużą skalę stwarza poważne wyzwania techniczne. Efektywne skalowanie wymaga dokładnego rozważenia różnych czynników, w tym infrastruktury, zarządzania danymi i wydajności przetwarzania. W tym artykule szczegółowo opisano zaawansowane techniki i strategie niezbędne do pokonania tych wyzwań, dzięki czemu operacje przeszukiwania sieci będą mogły rosnąć, aby sprostać wymaganiom aplikacji obsługujących duże zbiory danych.

Wyzwania związane z indeksowaniem stron internetowych pod kątem zastosowań Big Data

Indeksowanie witryn internetowych pod kątem zastosowań związanych z dużymi zbiorami danych wiąże się z kilkoma poważnymi wyzwaniami, którym firmy muszą sprostać, aby skutecznie wykorzystać moc ogromnych informacji dostępnych w Internecie. Zrozumienie i pokonanie tych wyzwań ma kluczowe znaczenie dla zbudowania solidnej i skalowalnej infrastruktury do przeszukiwania sieci.

Jednym z głównych wyzwań jest sama ilość i różnorodność danych w Internecie, która stale rośnie wykładniczo. Ponadto różnorodność typów danych, od tekstu i obrazów po filmy i treści dynamiczne, zwiększa złożoność procesu indeksowania witryn internetowych. Nowoczesne strony internetowe często wykorzystują dynamiczną treść generowaną przez JavaScript i AJAX, co utrudnia

tradycyjne roboty indeksujące przechwytujące wszystkie istotne informacje. Co więcej, strony internetowe mogą nakładać limity szybkości lub blokować adresy IP, aby zapobiec nadmiernemu indeksowaniu, co może zakłócić gromadzenie danych.

Zapewnienie dokładności i spójności danych zebranych z różnych źródeł może być trudne, szczególnie w przypadku dużych zbiorów danych. Skalowanie operacji przeszukiwania sieci w celu obsługi rosnącego obciążenia danych bez utraty wydajności jest poważnym wyzwaniem technicznym. Ponadto przestrzeganie prawnych i etycznych wytycznych dotyczących indeksowania witryn internetowych ma kluczowe znaczenie dla uniknięcia potencjalnych problemów prawnych i utrzymania dobrej reputacji. Efektywne zarządzanie zasobami obliczeniowymi w celu zrównoważenia szybkości indeksowania i opłacalności ma również kluczowe znaczenie.

Techniki efektywnej ekstrakcji danych

Wdrożenie zaawansowanych technik ekstrakcji danych gwarantuje, że zebrane dane są istotne, dokładne i gotowe do analizy. Oto kilka kluczowych technik zwiększania efektywności ekstrakcji danych:

- Przetwarzanie równoległe : Wykorzystaj przetwarzanie równoległe, aby rozdzielić zadania ekstrakcji danych na wiele wątków lub maszyn, zwiększając prędkość ekstrakcji danych poprzez jednoczesną obsługę wielu żądań i redukując całkowity czas wymagany do gromadzenia danych.

- Indeksowanie przyrostowe : zaimplementuj indeksowanie przyrostowe, aby aktualizować tylko te części zestawu danych, które uległy zmianie od ostatniego indeksowania, zmniejszając ilość przetwarzanych danych i obciążenie serwerów internetowych, dzięki czemu proces indeksowania jest bardziej wydajny i wymaga mniej zasobów.

- Przeglądarki bezobsługowe : używaj przeglądarek bezobsługowych, takich jak Puppeteer lub Selenium, do renderowania i interakcji z dynamiczną zawartością Internetu, umożliwiając dokładne wyodrębnianie danych ze stron internetowych, które w dużym stopniu opierają się na JavaScript i AJAX, zapewniając kompleksowe gromadzenie danych.

- Priorytetyzacja treści : nadaj priorytet treści na podstawie trafności i ważności, koncentrując się najpierw na danych o wysokiej wartości, zapewniając szybkie gromadzenie najważniejszych danych i optymalizując wykorzystanie zasobów i przydatność danych.

- Zasady planowania adresów URL i grzeczności : wdrażaj inteligentne zasady planowania adresów URL i zasady grzeczności, aby zarządzać częstotliwością żądań do pojedynczego serwera, zapobiegając przeciążeniu serwerów internetowych i zmniejszając ryzyko blokowania adresów IP, zapewniając stały dostęp do źródeł danych.

- Deduplikacja danych : Stosuj techniki deduplikacji danych, aby wyeliminować duplikaty wpisów podczas procesu wyodrębniania, poprawiając jakość danych i zmniejszając wymagania dotyczące przechowywania, zapewniając, że przechowywane i przetwarzane są wyłącznie unikalne dane.

Rozwiązania do przeszukiwania sieci w czasie rzeczywistym

Źródło: Średnie

W dzisiejszym dynamicznym środowisku cyfrowym możliwość wyodrębniania i przetwarzania danych w czasie rzeczywistym jest kluczowa

kluczowe dla przedsiębiorstw chcących utrzymać przewagę konkurencyjną. Rozwiązania do przeszukiwania sieci w czasie rzeczywistym umożliwiają ciągłe i natychmiastowe gromadzenie danych, umożliwiając natychmiastową analizę i podjęcie działań. Wdrożenie architektury sterowanej zdarzeniami może znacznie zwiększyć możliwości działania w czasie rzeczywistym, w którym roboty indeksujące są uruchamiane przez określone zdarzenia lub zmiany w sieci, zapewniając gromadzenie danych, gdy tylko staną się dostępne.

Skalowalność w wielojęzycznym przeszukiwaniu sieci

Globalny charakter Internetu wymaga możliwości przeszukiwania i przetwarzania danych w wielu językach, co stwarza wyjątkowe wyzwania wymagające specjalistycznych rozwiązań. Operacje indeksowania stron internetowych w celu obsługi treści wielojęzycznych obejmują wdrożenie algorytmów wykrywania języka w celu automatycznej identyfikacji języka stron internetowych i zapewnienia zastosowania odpowiednich technik przetwarzania specyficznych dla języka. Korzystanie z bibliotek i struktur analizujących obsługujących wiele języków, takich jak BeautifulSoup, zapewnia niezawodne narzędzia do wyodrębniania treści z różnych stron internetowych. Integracja skalowalnych usług tłumaczeniowych, takich jak Google Cloud Translation, z potokiem przetwarzania danych umożliwia tłumaczenie treści w czasie rzeczywistym, umożliwiając bezproblemową analizę w różnych językach.

Wniosek

źródło: groupbwt

W miarę wchodzenia w erę cyfrową znaczenie indeksowania witryn internetowych dla aplikacji wykorzystujących duże zbiory danych stale rośnie. Przyszłość indeksowania sieci leży w jego zdolności do wydajnego skalowania, dostosowywania się do dynamicznych środowisk internetowych i dostarczania informacji w czasie rzeczywistym. Postępy w sztucznej inteligencji i uczeniu maszynowym odegrają kluczową rolę w zwiększaniu możliwości robotów indeksujących, czyniąc je inteligentniejszymi i wydajniejszymi w przetwarzaniu ogromnych ilości danych.

Integracja systemów rozproszonych i infrastruktur opartych na chmurze jeszcze bardziej poprawi skalowalność, umożliwiając firmom łatwą obsługę coraz większych zbiorów danych. W miarę ciągłego rozwoju technologii przeszukiwania sieci nie tylko usprawnią one procesy gromadzenia danych, ale także zapewnią przedsiębiorstwom utrzymanie przewagi konkurencyjnej w stale zmieniającym się krajobrazie cyfrowym.

Korzystanie z tych osiągnięć to nie tylko opcja, ale konieczność dla organizacji, które chcą efektywnie wykorzystywać duże zbiory danych. Przyszłość indeksowania sieci zapowiada się na siłę transformacyjną, napędzającą innowacje i zapewniającą narzędzia potrzebne do uwolnienia pełnego potencjału ogromnego ekosystemu danych internetowych.

Przenieś swoje aplikacje Big Data na wyższy poziom dzięki konfigurowalnym usługom skrobania sieciowego PromptCloud, zapewniającym płynną integrację i skalowalność. Skontaktuj się z nami już dziś, aby wykorzystać moc zaawansowanego indeksowania sieci w swojej firmie.