Wysoce widoczne i niskiej jakości (lub nieprzydatne) – najniebezpieczniejsza kombinacja SEO

Opublikowany: 2024-01-08

Ponieważ pomagam firmom, na które duży wpływ miała „aktualizacja algorytmów upadku szaleństwa w 2023 r.”, po raz kolejny usłyszałem od kilku właścicieli witryn, którzy mieli najwyższy poziom ruchu tuż przed tym, jak zostali uderzeni. Wkrótce napiszę o tym więcej, ale obserwuję to już od dawna. Teraz, gdy przeczytaliśmy zeznania Google na temat Navboost i sygnałów interakcji użytkowników z najnowszego procesu antymonopolowego, przez głowę przeszło mi kilka pomysłów.

Pomagając firmom, na które mają wpływ ważne aktualizacje algorytmów (takie jak ogólne aktualizacje algorytmów), niezwykle ważne jest uruchomienie tak zwanego „raportu delta”, aby zidentyfikować najczęstsze zapytania i strony docelowe, które spadły podczas tych aktualizacji. Raporty różnicowe mogą być przydatne i pomóc właścicielom witryn określić, czy spadek wynikał z dostosowania trafności, zmiany zamiarów czy ogólnych problemów z jakością witryny. A jeśli problemem była jakość, wgłębienie się w zapytania i strony docelowe, które najczęściej spadały, może często przynieść ważne wnioski. Odkrycia te mogą pomóc zidentyfikować treści niskiej jakości, treści cienkie, treści AI niskiej jakości, bariery w zakresie doświadczenia użytkownika, agresywne reklamy, zwodniczą lub agresywną konfigurację partnerów i nie tylko.

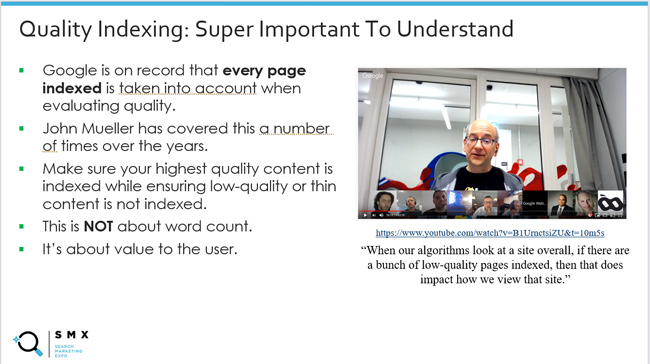

To również skłoniło mnie do ponownego zastanowienia się nad „indeksowaniem jakości”, które wielokrotnie omawiałem w moich postach i prezentacjach na temat głównych aktualizacji algorytmów. Dzięki temu masz pewność, że Twoje treści najwyższej jakości zostaną zaindeksowane, a treści o niskiej jakości lub cienkie nie będą indeksowane. Ten stosunek ma znaczenie. Dzieje się tak, ponieważ wiemy, że Google ocenia jakość każdej zaindeksowanej strony. John Mueller z Google wyjaśniał to wiele razy, a ja przez lata udostępniałem te klipy wideo.

Ale czy wszystkie rzeczy są sobie równe z punktu widzenia jakości? Innymi słowy, jeśli znajdziesz w swojej witrynie partię treści o niższej jakości, które nie pojawiają się często w wynikach wyszukiwania, czy jest to to samo, co treści o niższej jakości (lub treści nieprzydatne), które są dobrze widoczne w wynikach wyszukiwania?

Komentarze Johna Muellera na temat usuwania treści o niskiej jakości zmieniły się nieco na przestrzeni lat w tym zakresie. Zauważyłem to z czasem i zawsze budziło to moją ciekawość. John przeszedł od wyjaśnienia, że jeśli treść jest indeksowana, można ją ocenić pod kątem jakości, do wyjaśnienia, że w pierwszej kolejności skupi się na tym, co jest bardzo widoczne i niskiej jakości . Wyjaśnię więcej, dlaczego ma to całkowity sens (zwłaszcza na podstawie świeżych informacji z najnowszego procesu antymonopolowego Google).

Poniżej szybko omówię podstawowe informacje na temat sygnałów zaangażowania użytkowników i SEO, następnie omówię kilka interesujących komentarzy Johna Muellera z Google z ostatnich lat na temat usuwania treści o niskiej jakości, a następnie połączę to ze sobą Niedawne zeznanie Google na temat wykorzystania sygnałów interakcji użytkownika do wspomagania rankingu (np. Navboost).

Najpierw przespacerujmy się ścieżką historii i omówmy sygnały interakcji użytkowników oraz wpływ na SEO.

Sygnały interakcji użytkownika i SEO oraz niesamowita zdolność Google do zrozumienia szczęścia użytkownika:

Dzięki najnowszemu procesowi antymonopolowemu prowadzonemu przez Google dowiedzieliśmy się wiele o tym, jak Google wykorzystuje sygnały interakcji użytkowników do wpływania na rankingi. Na przykład Pandu Nayak z Google mówił o Navboost, o tym, jak Google zbiera dane o kliknięciach z 13 miesięcy (poprzednio 18 miesięcy) i jak te dane mogą pomóc Google zrozumieć poziom zadowolenia użytkowników (zadowoleni użytkownicy wyszukiwania).

Chociaż wiedza o Navboost zaskoczyła wiele osób (i słusznie), zawsze pojawiały się oznaki, że Google robi coś z danymi dotyczącymi zaangażowania użytkowników z punktu widzenia rankingów. Nikt tak naprawdę nie był tego pewien, ale trudno było zignorować tę koncepcję, przeglądając wiele witryn, które z czasem przestały działać w wyniku dużych aktualizacji algorytmów (zwłaszcza ogólnych aktualizacji rdzenia).

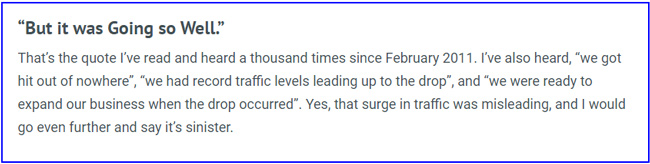

Na przykład w 2014 roku napisałem post o zwodniczym, złowrogim wzroście ruchu przed uderzeniem głównego algorytmu. Uwaga, Search Engine Watch ma problemy ze starszymi postami, więc zamieściłem link do wersji mojego postu z maszyny Wayback. Napisałem ten post po tym, jak wiele firm skontaktowało się ze mną w sprawie ogromnych hitów Pandy i wyjaśniło, że właśnie odnotowały najwyższy poziom ruchu w historii, aż do… awarii podczas następnej aktualizacji.

Wydawało mi się, że Google zyskał tak wiele informacji na podstawie tego, jak użytkownicy wchodzą w interakcję z treścią SERP, że ostatecznie przyczyniło się to do spadku. Innymi słowy, Google mógł na dużą skalę zaobserwować niezadowolenie użytkowników tych witryn. A potem bum, zatankowali.

Oto cytat z mojego artykułu o SEW:

Również AJ Kohn napisał w 2015 roku artykuł na temat CTR jako czynnika rankingowego. AJ przez lata pracowała także nad wieloma witrynami i miała poważne przeczucie, że sygnały interakcji użytkowników odgrywają rolę w rankingach. Oto zrzut ekranu z postu AJ-a odnoszącego się do ukrytych opinii użytkowników.

Dużo pisałem również o niebezpieczeństwie związanym z krótkim czasem przebywania i o tym, jak wdrożenie czegoś takiego jak skorygowany współczynnik odrzuceń może pomóc właścicielom witryn lepiej wyczuć treści, które nie spełniają lub przekraczają oczekiwania użytkowników. Ten post pochodzi z 2012 roku. Rozszerzyłem ten pomysł w innym poście z 2018 roku, dotyczącym stosowania kilku mechanizmów śledzenia jako miernika zadowolenia użytkowników (w tym dostosowanego współczynnika odrzuceń, śledzenia głębokości przewijania i czasu spędzonego na stronie). Uwaga: dotyczyło to GA3, a nie GA4.

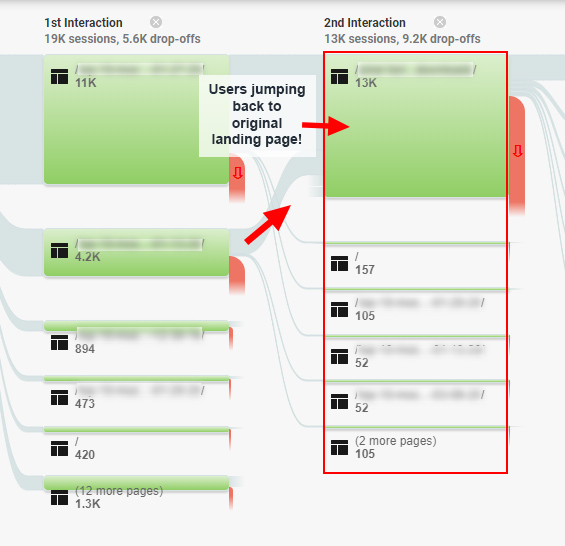

Świetnym przykładem tego, jak problemy z zaangażowaniem użytkowników mogą wpłynąć na SEO, jest studium przypadku, które napisałem w 2020 r. na temat „pułapki zaangażowania SEO”, w którym znalazłem użytkowników kręcących się w kółko po witrynie i jestem pewien, że ostatecznie wróciłem do SERP, aby uzyskać lepsze odpowiedzi. Ta witryna została dotknięta obszerną aktualizacją rdzenia i odzyskała siły po rozwiązaniu wielu z tych problemów. Więc tak, więcej negatywnych sygnałów dotyczących interakcji użytkownika do oceny przez Google.

Oto zrzut ekranu z tego posta przedstawiający raportowanie przepływu zachowań dla sfrustrowanych użytkowników:

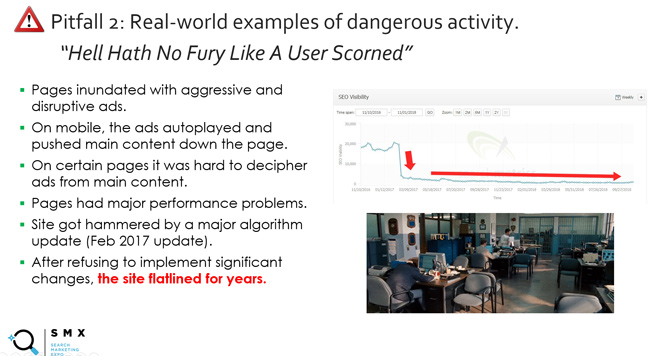

Jest też slajd (i motto), którego używam od dłuższego czasu w moich prezentacjach na temat ogólnych aktualizacji, zatytułowany: „Piekło nie zna takiej wściekłości, jak pogardzany użytkownik”. Dotyczy to czegoś więcej niż tylko jakości treści i obejmuje agresywną reklamę, bariery w zakresie doświadczenia użytkownika i nie tylko. Zasadniczo nie denerwuj użytkowników. Zapłacisz wysoką cenę. A tak przy okazji, jaki jest świetny sposób, aby Google mógł zrozumieć zirytowanych użytkowników? Cóż, śledząc sygnały interakcji użytkownika, takie jak krótki czas przebywania (ktoś szybko wraca do SERP po odwiedzeniu witryny Google).

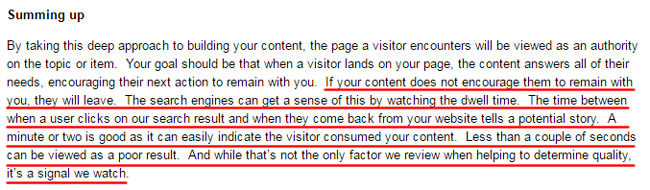

A jeśli chodzi o czas przebywania, jeden z moich ulubionych cytatów pochodzi sprzed wielu lat, kiedy Duane Forrester z Bing napisał post na blogu wyjaśniający, jak krótki czas oczekiwania może wpłynąć na widoczność w wynikach wyszukiwania. Duane nie pracuje już dla Binga, ale przez kilka lat był Mattem Cuttsem Binga. W tym poście, który został już usunięty (ale można go znaleźć za pomocą maszyny powrotnej), Duane wyjaśnił, co następuje:

„Jeśli Twoje treści nie zachęcą ich do pozostania z Tobą, odejdą. Wyszukiwarki mogą to wyczuć, obserwując czas przebywania. Czas między kliknięciem przez użytkownika naszego wyniku wyszukiwania a powrotem z Twojej witryny opowiada potencjalną historię. Minuta lub dwie wystarczą, ponieważ mogą łatwo wskazać, że odwiedzający zapoznał się z Twoją treścią. Mniej niż kilka sekund można uznać za słaby wynik. I chociaż nie jest to jedyny czynnik, który sprawdzamy, pomagając określić jakość, jest to sygnał, który obserwujemy”.

Następnie w innym poście na temat SEJ Duane powiedział dalej:

„Czas przebywania był jednym z tych pojęć, które po wyjaśnieniu miały sens i od razu stało się oczywiste, że taki miernik może być bardzo ważny przy określaniu zadowolenia poszukiwacza”.

Na koniec Duane wyjaśnił, że rozważano to „w oparciu o szereg czynników”, co ważne jest, aby zrozumieć. Wyjaśnił, że pogoń za czasem przebywania to zły pomysł. Wyjaśnił, że należy skupić się na wprowadzaniu szerszych ulepszeń witryny, które zwiększają zaangażowanie użytkowników (w wyniku tej pracy czas przebywania użytkowników może się wydłużyć). Dlatego też uważam, że podejście do naprawy oparte na „zlewie kuchennym” jest skuteczną metodą. Rozwiąż jak najwięcej problemów z jakością, a w przyszłości mogą wydarzyć się wspaniałe rzeczy.

Uwaga, nie skupiajcie się na ilości czasu, jaki Duane poświęcił w 2011 roku na „krótkie zaręczyny”… Jestem pewien, że to jeden z powodów usunięcia postu. W przypadku niektórych typów treści krótszy okres czasu jest całkowicie odpowiedni z punktu widzenia zaangażowania użytkownika. Jednak zrozumienie najważniejszej kwestii dotyczącej krótkiego czasu przebywania, zwłaszcza w przypadku wielu fragmentów treści witryny, jest niezwykle ważne. Tak było wtedy i na pewno jest teraz.

Główną kwestią, którą próbuję przekazać, jest to, że interakcja użytkownika zawsze wydawała się mieć jakieś znaczenie… tylko nie wiedzieliśmy dokładnie, jak. Tak było do czasu ujawnienia Navboost. Wkrótce opowiem o tym więcej.

Dlaczego „wysoce widoczne” jest ważne: komentarze Johna Muellera z Google.

OK, teraz przyjrzyjmy się bliżej temu, co nazywam „indeksowaniem jakości”. Powtarzam, oznacza to, że indeksowane są tylko treści najwyższej jakości, które mogą spełnić lub przekroczyć oczekiwania użytkowników, przy jednoczesnym zapewnieniu, że treści o niskiej jakości lub o niewielkiej treści nie będą indeksowane.

Google z czasem wyjaśniło, że przy ocenie jakości brane są pod uwagę wszystkie zaindeksowane strony. Omawiałem to wiele razy w moich postach na blogu i prezentacjach na temat głównych aktualizacji algorytmów (szczególnie jeśli chodzi o aktualizacje szerokiego rdzenia).

Oto John z 2017 roku, który wyjaśnia, że:

Jednak z biegiem czasu zauważyłem zmianę w odpowiedzi Johna na pytanie o usunięcie treści o niższej jakości. John zaczął wyjaśniać, że skoncentruje się na treściach „wysoce widocznych” i niższej jakości. Słyszałem to w kilku filmach ze spotkań w Search Central, a on opowiedział to także w wywiadzie dla Marie Haynes.

Oto kilka przykładów:

Po pierwsze, tutaj Jan wyjaśnia, że nie wszystkie rzeczy są równe pod względem treści. Google spróbuje znaleźć najważniejsze strony i skupić się na nich:

Oto John wyjaśniający, że Google może zrozumieć podstawową treść witryny, dokąd zmierzają odwiedzający itp.

A tutaj John wyjaśnia, że jeśli wiesz, że ludzie odwiedzają określone strony, warto najpierw zająć się stronami o niższej jakości (aby ludzie mogli pozostać):

Dlaczego więc jest to ważne? Cóż, teraz, gdy wiemy więcej o tym, jak Google wykorzystuje sygnały interakcji użytkowników do wpływania na widoczność i rankingi za pośrednictwem Navboost, to stwierdzenie Johna ma duży sens. Im więcej danych o interakcjach użytkowników ma Google dla kombinacji zapytań i stron docelowych, tym lepiej może zrozumieć zadowolenie użytkowników. Jeśli strona jest niskiej jakości i jest niewidoczna, Google nie ma danych o interakcjach użytkowników. Jasne, Google może używać innych sygnałów, przetwarzania języka naturalnego itp., aby lepiej zrozumieć treść, ale sygnały interakcji użytkownika świetnie wpływają na satysfakcję wyszukiwarki.

Zanim przejdziemy dalej, chciałem jasno powiedzieć, że nadal zajmę się wszystkimi problemami z jakością treści w witrynie (nawet tymi, które nie są „wyraźnie widoczne”), ale zacznę od najbardziej widocznych. Jest to ważna kwestia dla właścicieli witryn, którzy muszą sobie poradzić ze znacznym spadkiem liczby ogólnych aktualizacji podstawowych, aktualizacji przydatnych treści lub aktualizacji recenzji.

Proces antymonopolowy Google i sygnały zaangażowania użytkowników wpływające na rankingi.

Wspominałem już w tym poście o Navboost kilka razy i chciałem poruszyć tę kwestię w tym rozdziale. Nie będę się zbytnio zagłębiać, ponieważ zostało to ostatnio omówione w wielu innych postach branżowych, ale ważne jest, aby zrozumieć.

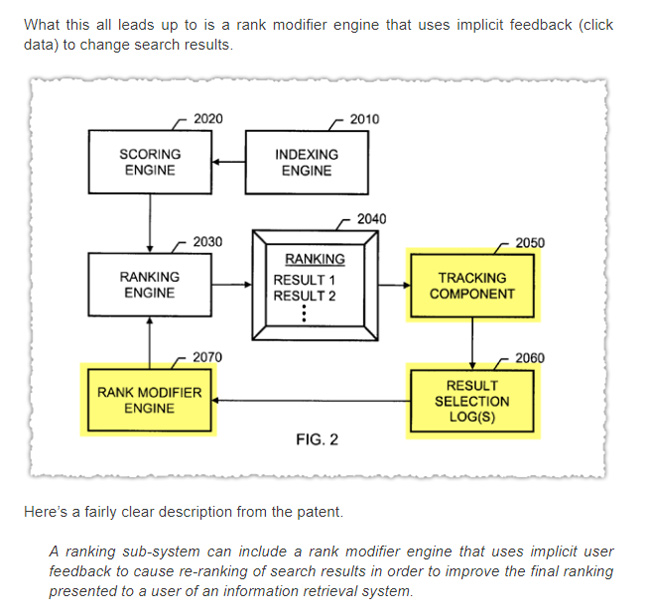

W swoim zeznaniu antymonopolowym złożonym przez Google Pandu Nayak wyjaśnił zastosowanie Navboost – systemu wykorzystującego dane o interakcjach użytkowników, aby pomóc Google zrozumieć poziom zadowolenia użytkowników. Zasadniczo umożliwia Google uczenie się od użytkowników w miarę upływu czasu i dostosowywanie rankingów na podstawie tych wniosków. Navboost nie jest oczywiście jedynym czynnikiem odgrywającym rolę, ale jest ważnym czynnikiem przy ustalaniu rankingów.

Oto Pandu Nayak na temat znaczenia Navboost:

— To znaczy, trudno jest ustalić taką kolejność rang. Powiem, że navboost jest ważny, prawda. Dlatego nie chcę tego w żaden sposób minimalizować. Ale powiem też, że jest mnóstwo innych sygnałów, które są również ważne, jak te, o których wspomniałem. I tak naprawdę nie da się wyłączyć niektórych z tych rzeczy. Nie wiem, co by oznaczało wyłączenie np. indeksu dokumentów. To w pewnym sensie najważniejsza rzecz, czyli słowa na stronie i tak dalej, prawda. Więc trochę trudno oceniać w ten sposób. Powiedziałbym więc, że navboost jest jednym z ważnych sygnałów, które mamy. ”

Jeśli więc strony są dobrze widoczne dla zapytania, Google aktywnie zbiera sygnały zaangażowania użytkowników dla tych adresów URL i kombinacji zapytań (obecnie zbiera dane o kliknięciach z 13 miesięcy). Navboost może wykorzystywać te sygnały interakcji użytkownika, aby pomóc systemom Google zrozumieć zadowolenie użytkowników (w tym zrozumienie czasu przebywania użytkownika, długich kliknięć, przewijania, najechania kursorem i nie tylko).

Z drugiej strony, jeśli strony nie są dobrze widoczne dla zapytań, Google nie może wykorzystać tych sygnałów interakcji użytkownika… lub niewystarczających sygnałów, aby wywrzeć wpływ. Nie oznacza to, że Google nie jest w stanie zrozumieć jakości strony, ale będzie brakowało mu rzeczywistych sygnałów użytkownika dla kombinacji zapytań i stron docelowych. A to jest niezwykle ważne.

Uwaga: jeśli chcesz dowiedzieć się więcej na temat sygnałów interakcji użytkowników z procesu antymonopolowego Google, AJ Kohn napisał świetny post zawierający te informacje w oparciu o zeznania Pandu Nayaka. Polecam przeczytać post AJ, jeśli jeszcze tego nie zrobiłeś, ponieważ omawia on więcej na temat Navboost, sygnałów interakcji użytkownika, CTR jako czynnika rankingowego itp.

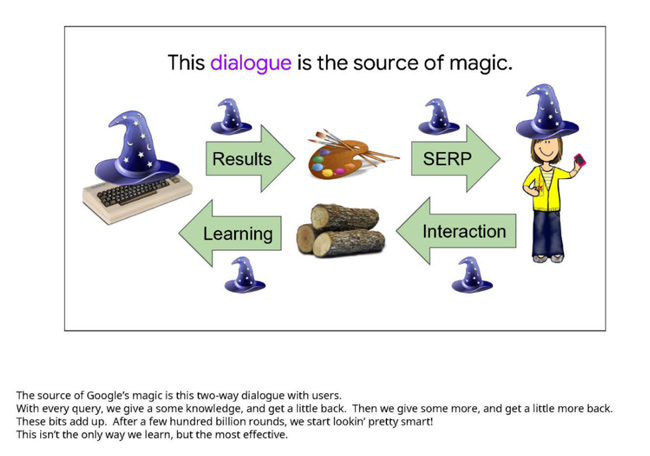

Oto slajd z prezentacji Google, która stanowiła dowód podczas procesu. Podkreśla znaczenie sygnałów interakcji użytkownika dla określenia zadowolenia poszukiwacza. Należy pamiętać, że ten slajd był sprzed kilku lat. Chodzi o „źródło magii Google”:

I nie zapomnij o algorytmach jakości na poziomie witryny:

Powtórzę jeszcze raz: nie chcę zaśmiecać tego posta zbyt dużą ilością informacji z procesu antymonopolowego, ale chodzi mi głównie o to, że „wyraźnie widoczna” treść w SERPach może pozyskać mnóstwo sygnałów interakcji użytkownika, które Google może wykorzystać jako czynnikiem rankingowym. Możliwe jest również, że Google może również wykorzystać te dane zbiorczo, aby wpłynąć na algorytmy jakości na poziomie witryny. Algorytmy na poziomie witryny mogą odegrać ogromną rolę w funkcjonowaniu witryn podczas ogólnych aktualizacji podstawowych (i innych ważnych aktualizacji algorytmów). To też omawiałem przez długi czas.

Co to oznacza dla Ciebie. Moja rekomendacja dla właścicieli witryn, na których mają wpływ główne aktualizacje algorytmów:

Właściciele witryn, na których duży wpływ mają aktualizacje algorytmów, powinni cofnąć się o krok i ogólnie przeanalizować witrynę pod kątem jakości. Jak wyjaśnił wcześniej John Mueller z Google, „jakość” to coś więcej niż tylko treść. Chodzi także o kwestie UX, sytuację reklamową, sposób prezentacji i nie tylko.

A teraz, mając potwierdzenie, że Google wykorzystuje sygnały interakcji użytkowników do wpływania na widoczność i rankingi za pomocą Navboost, przy podejmowaniu decyzji, czym się zająć, przesuwałbym „wysoce widoczne” adresy URL na listę. Tak, powinieneś rozwiązać wszystkie problemy z jakością, które zauważysz, nawet błędy, które mogą nie być dobrze widoczne, ale priorytetowo traktowałbym adresy URL, które były najbardziej widoczne przed poważną aktualizacją algorytmu. Więc tak, prowadzenie raportu delta stało się jeszcze ważniejsze.

Podsumowanie: ujawniaj wszystkie treści o niskiej jakości, ale zacznij od tych, które są „wysoce widoczne”.

Przez lata zawsze wyjaśniałem, że treść musi spełniać lub przekraczać oczekiwania użytkowników na podstawie zapytania. Teraz, dzięki najnowszym zeznaniom z procesu antymonopolowego prowadzonego przez Google, mamy niezbite dowody na to, że Google rzeczywiście wykorzystuje sygnały interakcji użytkowników do dostosowywania rankingów (i ewentualnie wpływania na algorytmy jakości na poziomie witryny). Jako właściciel witryny nie pozwól, aby treści niskiej jakości, cienkie lub nieprzydatne pozostały w SERP, z którymi użytkownicy mogliby się kontaktować. Jak widziałem przez lata w przypadku dużych aktualizacji algorytmów, nie skończy się to dobrze. Zdecydowanie rozwiąż wszystkie potencjalne problemy z jakością w witrynie, ale nie zapominaj o tym, co jest bardzo widoczne. To świetny punkt wyjścia do ogólnej poprawy jakości witryny.

GG