Jak unikać naruszeń zgodności podczas opracowywania produktów AI

Opublikowany: 2023-06-12Sztuczna inteligencja pozostaje najpopularniejszym trendem technologicznym od kilku lat dzięki swojemu wkładowi w sektory intensywnie korzystające z danych i maszyn, takie jak produkcja, opieka zdrowotna i finanse. Jednak dopiero od dwóch lat technologia ta cieszy się dużym zainteresowaniem użytkowników końcowych. Dzięki aplikacjom, takim jak generatory obrazów i tekstu, ludzie mogą teraz jednym kliknięciem tworzyć wizualizacje i teksty.

Chociaż wygląda na to, że te platformy AI produkują materiały od zera, tak nie jest – te platformy AI zostały przeszkolone w zakresie fragmentów pytań i jezior danych, które działają poprzez przetwarzanie archiwów tekstu i obrazów z Internetu. Chociaż podejście to jest przydatne dla użytkowników końcowych, wiąże się z ryzykiem prawnym, takim jak naruszenie praw autorskich, nieprzestrzeganie licencji open source i naruszenie praw własności intelektualnej itp. Te zagrożenia, jakie stwarza generatywna sztuczna inteligencja, nie są niezauważalne dla rządów na całym świecie i stale pojawiają się się z nowymi zasadami i karami za nieetyczne modele AI.

Dla firmy przygotowującej się do uruchomienia projektu AI kluczowe znaczenie ma zrozumienie ryzyka i zbudowanie systemu, który nie podlega radarowi prawnemu z powodu tych problemów etycznych. W tym artykule przyjrzymy się wielu aspektom zgodności AI podczas tworzenia oprogramowania — rodzajom kwestii prawnych, sposobom przygotowania się do regulacji AI oraz ustawom AI obowiązującym w różnych regionach.

Co to jest zgodność ze sztuczną inteligencją?

Jest to proces, który zapewnia zgodność aplikacji opartych na sztucznej inteligencji z regulacjami i prawami regionu, w którym działa. Oto różne czynniki, z których składa się kontrola zgodności ze sztuczną inteligencją:

Problemy prawne ze sztuczną inteligencją

O ile na poziomie mikro może się wydawać, że problemy z wykorzystaniem sztucznej inteligencji przez użytkowników końcowych ograniczają się do plagiatu lub dostępu do danych, których nie można udostępniać, o tyle na poziomie makro brak zgodności z AI stwarza większe wyzwania.

Zagrożenia wynikające z używania źle zbudowanego systemu AI mogą wpływać na uczciwą konkurencję, cyberbezpieczeństwo, ochronę konsumentów, a nawet prawa obywatelskie. Dlatego tak ważne jest, aby firmy i rządy zbudowały sprawiedliwy, etyczny model.

Prawo autorskie

Wraz z pojawieniem się generatywnej sztucznej inteligencji firmy zaczęły tworzyć materiały chronione prawem autorskim za pomocą technologii. Problem polega na tym, że nie można zrozumieć, czy dane zostały wygenerowane dzięki kreatywności autora, czy też autorem jest sztuczna inteligencja.

Aby zapewnić zgodność z prawem, Urząd ds. Praw Autorskich wydał Wytyczne dotyczące badania i rejestracji prac zawierających materiały wygenerowane przez sztuczną inteligencję. Stwierdza, co następuje –

- Prawo autorskie może chronić jedynie materiał wytworzony przez ludzką kreatywność.

- W przypadku prac z materiałem opartym na sztucznej inteligencji rozważone zostanie, czy wkłady sztucznej inteligencji wynikają z „mechanicznej reprodukcji”, czy też są „własną oryginalną koncepcją autora, której nadał widoczną formę za pomocą sztucznej inteligencji”.

- Wnioskodawcy mają obowiązek ujawnienia udziału treści opartych na sztucznej inteligencji w materiale przedłożonym do rejestracji.

Przeczytaj też: Koszt opracowania narzędzia AI do wykrywania treści w 2023 roku

Otwarte źródło

Generatory kodu oparte na sztucznej inteligencji często używają sztucznej inteligencji, aby pomóc programistom w automatycznym uzupełnianiu lub sugerowaniu kodu na końcu testów programistycznych lub danych wejściowych. Oto kilka wyzwań związanych z opracowywaniem zgodnych modeli sztucznej inteligencji wokół generatorów kodu —

- Czy trenowanie modeli AI za pomocą kodu open source oznacza naruszenie?

- Kto jest odpowiedzialny za spełnienie kryteriów zgodności open source – programista czy użytkownik?

- Czy użycie kodu opartego na sztucznej inteligencji przez programistów tworzących nowe oprogramowanie będzie wymagało licencji na aplikację w ramach otwartego oprogramowania?

Naruszenie własności intelektualnej

Na całym świecie złożono wiele pozwów o naruszenie narzędzi AI, oskarżając je o trenowanie swoich modeli lub generowanie danych wyjściowych na podstawie treści chronionych prawem własności intelektualnej osób trzecich.

Stronniczość etyczna

Odnotowano wiele incydentów, w których technologia rozpoznawania twarzy AI doprowadziła do dyskryminacji rasowej. Czy to było w przypadku, gdy w 2020 roku czarnoskórzy zostali aresztowani z powodu błędu komputera, czy w Zdjęciach Google oznaczających czarnych jako „goryle”. Niezależnie od tego, jak inteligentna jest ta technologia, nie można zignorować faktu, że jest ona tworzona przez ludzi z uprzedzeniami

Dla firm, które chcą budować podobne rozwiązania, bardzo ważne jest, aby nie dopuścić do wprowadzenia tych uprzedzeń do systemu.

Zgodność z RODO dla projektów AI

Biorąc to pod uwagę, kluczowe jest zrozumienie, dlaczego firmy nie budują zgodnych modeli AI pomimo surowych przepisów. Przyczyn może być kilka, począwszy od nieumiejętności poznania zgodności, braku zrozumienia przez programistów, a czasem zwykłej ignorancji. Jednak mogą za tym kryć się również pewne przyczyny funkcjonalne.

Przyjrzyjmy się kilku z nich z perspektywy zgodności z RODO dla projektów AI.

Ograniczenie celu

Zasada RODO nakłada na przedsiębiorców obowiązek informowania osób, których dane dotyczą, w jakim celu ich dane są gromadzone i przetwarzane. Wyzwanie polega na tym, że technologia wykorzystuje dane do znajdowania wzorców i uzyskiwania nowych informacji, ale może to nie być prawdziwym celem tych danych.

Dyskryminacja

RODO wymaga od programistów sztucznej inteligencji podjęcia kroków przeciwko dyskryminacyjnemu wpływowi, jaki może mieć ta technologia. Chociaż jest to etyczna potrzeba chwili, dla programisty działającego w szybko zmieniającym się scenariuszu społecznym przygotowanie modelu AI przeciwko wszelkiej dyskryminacji i niemoralnym wynikom może być wyzwaniem.

Minimalizacja danych

RODO mówi, że gromadzone informacje powinny być „odpowiednie, ograniczone i odpowiednie”. Oznacza to, że zespoły programistów AI powinny być bardzo ostrożne podczas korzystania z danych w swoich modelach i muszą mieć jasność co do ilości danych potrzebnych do ich projektu.

Nie da się tego jednak przewidzieć, dlatego zespoły muszą regularnie oceniać typ i ilość danych potrzebnych do spełnienia wymogu minimalizacji danych.

Przezroczystość

Wreszcie, użytkownicy powinni mieć wpływ na to, w jaki sposób ich dane są wykorzystywane przez strony trzecie, w tym celu firmy będą musiały jasno określić, jakich danych używają iw jaki sposób.

Problem polega na tym, że większość modeli AI działa w czarnych skrzynkach i nie jest jasne, w jaki sposób podejmują decyzje, zwłaszcza gdy mówimy o zaawansowanym oprogramowaniu.

Mimo że są to wszystkie problemy techniczne, jeśli chodzi o etykę IT, bardzo ważne jest, aby firmy nie wykorzystywały ich jako tarczy do opracowania wadliwego modelu sztucznej inteligencji. Aby zapewnić, że praktyka nie stanie się głównym nurtem, w skali globalnej weszło w życie kilka przepisów dotyczących sztucznej inteligencji.

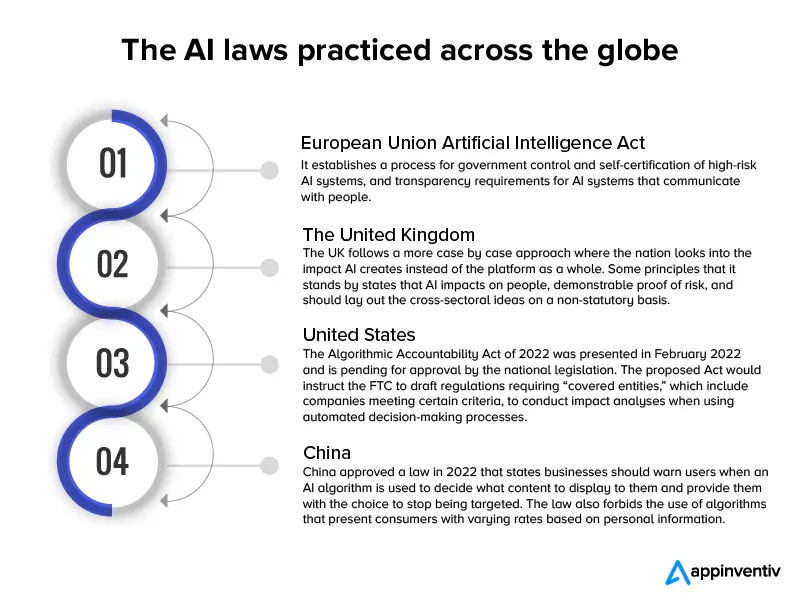

Prawie 60 krajów wprowadziło przepisy i regulacje dotyczące sztucznej inteligencji od 2017 r., co odpowiada szybkości, z jaką wdrażane są nowe modele sztucznej inteligencji.

Oto infografika przedstawiająca pokrótce te przepisy.

Teraz, gdy przyjrzeliśmy się wyzwaniom związanym z rozwojem sztucznej inteligencji z prawnego punktu widzenia i wstępnemu projektowi obowiązujących przepisów na poziomie globalnym, przejdźmy do sposobów, w jakie można zbudować zgodną aplikację AI.

Przeczytaj także: Ile kosztuje stworzenie zgodnego z prawem chatbota, takiego jak ChatGPT

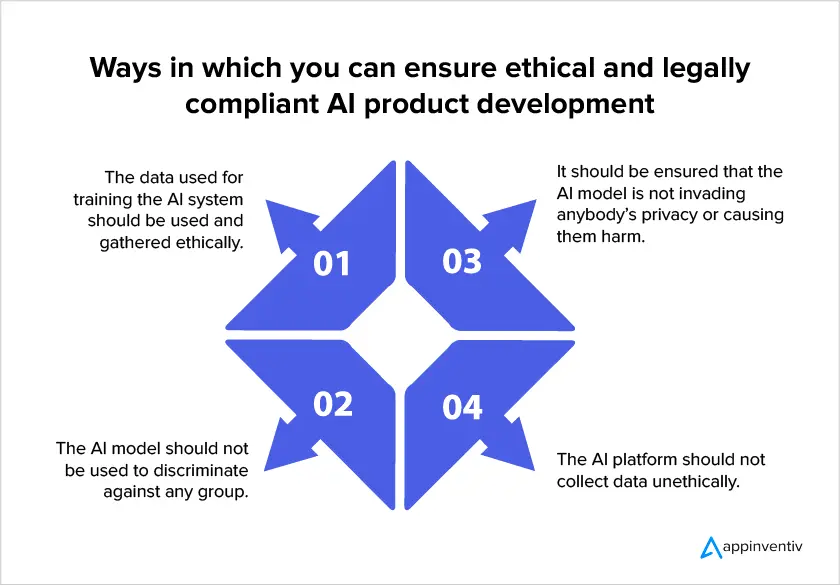

Jak opracować model sztucznej inteligencji sprzyjający zgodności

Ze względu na wzrost liczby przepisów dotyczących sztucznej inteligencji na poziomie globalnym, kluczowe znaczenie dla firm miało skupienie się na zgodności z prawem podczas tworzenia modeli AI. Oto kilka sposobów, w jakie firmy mogą upewnić się, że ich projekt jest zgodny z prawem, inwestując w usługi rozwoju sztucznej inteligencji.

- Upewnij się, że możesz używać danych

Zgodności AI stanowią, że prywatność użytkowników powinna być naczelną zasadą projektowania modeli. Oznacza to, że powinieneś ograniczyć do minimum ilość danych, które musisz zebrać, określić dokładny powód zbierania danych oraz czas, do którego będziesz wykorzystywać ich dane. Ostatecznie należy zauważyć, że użytkownicy powinni wyrazić zgodę na gromadzenie danych.

- Wytłumaczalne metody sztucznej inteligencji

Takie podejście pomaga rozwiązać problem efektu czarnej skrzynki, pomagając ludziom zrozumieć, co znajduje się w systemach sztucznej inteligencji i jak model podejmuje decyzje. To z kolei pomaga naukowcom poznać dokładną ilość danych, których będą potrzebować, aby poprawić dokładność modelu, aby spełnić wymagania dotyczące minimalizacji danych.

- Śledź zebrane dane

Zgodność ze sztuczną inteligencją wymaga od firm znajomości lokalizacji i wykorzystania zebranych danych osobowych. Właściwa kategoryzacja danych jest niezbędna do przestrzegania prawa użytkowników do informacji chronionych. Ponadto firmy muszą mieć podejście, aby wiedzieć, które informacje są przechowywane w jakim zbiorze danych, aby przygotować dokładne środki bezpieczeństwa.

- Zapoznaj się z zasadami przesyłania danych między krajami

W przypadku transgranicznego przesyłania danych w systemie AI twórcy powinni wziąć pod uwagę regulacje, które będą obowiązywały w krajach przyjmujących i odpowiednio zbudować odpowiednie mechanizmy przesyłania danych. Na przykład, jeśli RODO ma zastosowanie do przetwarzania danych, a dane osobowe są przekazywane do kraju spoza EOG, należy przeprowadzić odpowiednią ocenę skutków transferu.

Stosowanie takich podejść podczas opracowywania aplikacji AI w znacznym stopniu zapewnia właściwe uwzględnienie zagrożeń związanych z technologią. Jednak firmy i organy regulacyjne powinny mieć na uwadze fakt, że niemożliwe jest zabezpieczenie aplikacji przed każdym potencjalnym ryzykiem, ponieważ kontekst branżowy działa na zasadzie indywidualnego modelu. Z tego powodu rola menedżerów ds. ryzyka AI pozostanie kluczowa, ponieważ będą oni w stanie ocenić, kiedy potrzebna jest interwencja.

Mamy nadzieję, że artykuł pomógł Ci zrozumieć, czego możesz oczekiwać od struktury prawnej otaczającej technologię sztucznej inteligencji w nadchodzącym czasie oraz sposoby przygotowania się do zgodnego modelu sztucznej inteligencji.

Często zadawane pytania

P. Czy są jakieś problemy prawne związane ze sztuczną inteligencją?

Tak . Ze źle zbudowanym modelem sztucznej inteligencji może wiązać się szereg problemów prawnych i etycznych.

- Prawo autorskie

- Niewłaściwe użycie licencji open source

- Naruszenie własności intelektualnej

- Uprzedzenia etyczne, takie jak dyskryminacja rasowa.

P. Dlaczego trudno jest stworzyć zgodny z prawem model AI?

Odp. Z technicznego punktu widzenia zbudowanie zgodnej z prawem sztucznej inteligencji może być trudne, ponieważ podczas gdy technologia wykorzystuje dane klientów do znajdowania wzorców i uzyskiwania nowych informacji, trudno jest ustalić prawdziwy cel tych danych. Następnie zespoły programistów AI nigdy nie mogą być pewne co do ilości danych potrzebnych do ich projektu. Wreszcie, większość modeli AI działa w czarnych skrzynkach i nie jest jasne, w jaki sposób podejmują decyzje, zwłaszcza gdy mówimy o zaawansowanym oprogramowaniu.

P. Jak zapewnić zgodność z prawem w AI?

O. Chociaż prawa i przepisy dotyczące zgodności z prawem AI stale ewoluują, oto kilka rzeczy, które możesz zrobić, aby zapewnić, że Twój model jest jak najbliżej zgodności —

- Upewnij się, że możesz używać danych

- Wytłumaczalne metody sztucznej inteligencji

- Śledź zebrane dane

- Zapoznaj się z zasadami przesyłania danych między krajami