Czy atrybucja wielodotykowa jest martwa? Tworzenie lepszego rozwiązania do pomiaru wydajności

Opublikowany: 2023-05-04Odwieczny cel atrybucji marketingowej wydaje się prosty: dowiedzieć się, które punkty styku, kanały i/lub kampanie są najskuteczniejsze w kierowaniu klientów do konwersji.

W świecie cyfrowym nasza zdolność do przypisywania wpływu opiera się na deterministycznych identyfikatorach, które pozwalają nam łączyć ze sobą interakcje marketingowe. Następnie do tych interakcji stosowany jest model oparty na regułach lub oparty na danych w celu dostosowania wagi kredytu przypisanej do każdej interakcji na całej ścieżce klienta.

Tak więc atrybucja teoretycznie daje marketerom możliwość zrozumienia i oceny wartości różnych rodzajów interakcji z marką dla decyzji konsumenta o konwersji. Platoniczny ideał modelu atrybucji dawałby całościowy obraz każdego punktu kontaktu w podróży użytkownika i dokładnie oceniał jego znaczenie w doprowadzeniu ludzi do celu końcowego.

Niektóre modele zbliżyły się do siebie, na przykład atrybucja wielodotykowa, podczas gdy inne mają dobrze znane martwe punkty, takie jak ostatni dotyk.

Ale po prostu nie jest możliwe dokładne śledzenie każdego punktu kontaktu, który mógł mieć wpływ na zdarzenie konwersji. Prawdopodobnie nigdy nie będzie. A nawet gdyby tak było, atrybucja może nie dać nam pełnego obrazu, którego potrzebujemy.

Sama atrybucja jest z natury błędnym celem

Perfekcyjna atrybucja była marketingowym marzeniem od dawna; od czasów Johna Wanamakera marketerzy mają obsesję na punkcie idei uniwersalnych ram pomiarowych, które udowodnią, że kreują wartość.

Ale nawet gdybyś mógł zobaczyć wszystkie punkty styku i osiągnąć idealną holistyczną atrybucję, czy dałoby to wszystkie informacje potrzebne do zbudowania idealnej strategii marketingowej? W końcu uznanie ze swej natury zawsze polega na patrzeniu w lusterko wsteczne. Nie patrzy w przyszłość ani nie wskazuje drogi do przodu. Nie uwzględnia również krytycznych sygnałów inwestycji w media, takich jak malejące zyski.

Mierzenie wydajności powinno koncentrować się na wykorzystaniu danych, aby zrozumieć, gdzie powinien trafić kolejny najlepszy dolar, a nie tylko, jak daleko poszedł ostatni dolar. Musisz mieć możliwość przeglądania swoich danych i odpowiadania na pytania dotyczące przyszłości, takie jak:

- Gdzie możemy zwiększyć budżety, aby skalować konwersje przy zachowaniu obecnego ROAS?

- Jakie dźwignie mogę wykorzystać, aby zoptymalizować skuteczność kampanii?

Nie możesz odpowiedzieć na tego rodzaju pytania, jeśli patrzysz tylko na model, który przypisuje retroaktywny kredyt na niekompletnym zbiorze danych. Zimna, twarda prawda jest taka, że deterministyczne atrybucje wielodotykowe nie są lekarstwem na wszystko; jeśli jest to jedyny model, na którym polegasz przy podejmowaniu decyzji, nie może on dostarczyć tych odpowiedzi.

Wycofywanie danych utrudnia deterministyczną atrybucję wielodotykową

Niezależnie od tego, czy zgadzasz się z tym, że sama idea atrybucji prowadzi nas tylko częściowo do ostatecznego celu pomiaru, wszyscy możemy się zgodzić, że wielu marketerów nadal jest wiernych modelom atrybucji. Jak w przypadku wszystkich modeli, nie ma czegoś takiego jak idealne. Chociaż na przestrzeni lat poczyniono postępy, a na szczególną uwagę zasługuje atrybucja Google oparta na danych opartych na wartościach, wciąż istnieje wiele niewiadomych, jeśli chodzi o przyszłość atrybucji.

To dlatego, że obecny stan danych marketingowych tylko utrudnia sprawę. Ponieważ platformy takie jak Meta, Google i Snap mają trudności z radzeniem sobie z Apple App Tracking Transparency (ATT), dyrektorzy finansowi tych firm jako pierwsi przyznają, że deprecjonowanie danych jest ich największym wyzwaniem.

Przynajmniej niektóre praktyczne problemy z atrybucją są natury ludzkiej: ludzie mają obsesję na punkcie łączenia kropek i znajdowania wzorców, niezależnie od tego, czy faktycznie istnieją, czy nie. Często otrzymujemy od marketerów pytania o to, jak atrybucja działa w Google Analytics z powodu niespójności z innymi zbiorami danych.

Prawdopodobnie znasz to wyzwanie: interfejs Menedżera firmy na Facebooku twierdzi, że platforma wygenerowała 10 razy więcej konwersji niż to, co widzisz w Google Analytics. Więc który jest właściwy?

Odpowiedź brzmi: obaj się mylą, tylko na różne sposoby. Żadna ilość zabawnej matematyki (tj. obliczeń zastępczych, które patrzą na różnicę między dwoma punktami danych w czasie) nie pomoże rozwiązać równania i dokładnie obliczyć dokładnie, ile zasługi powinny uzyskać reklamy na Facebooku.

Ostatecznie jest to problem z obserwowalnością danych; dane są niepełne, ale i tak szukamy odpowiedzi.

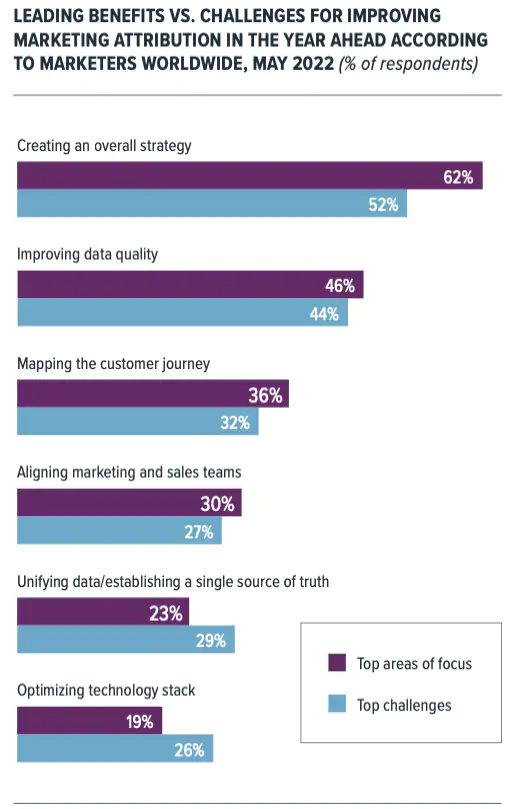

źródło: eMarketer

Jeśli jest to niejasne, pomyśl o tym w ten sposób: powiedzmy, że prowadzisz rozmowę telefoniczną z niejednolitym zasięgiem. Na każde 10 słów brakuje Ci jednego słowa. Są szanse, że nadal możesz zrozumieć istotę rozmowy, ponieważ masz tak wiele innych kontekstów.

Ale kiedy zaczniesz gubić całe zdania lub co drugie słowo, znajdziesz się w tarapatach. To dlatego, że dane wejściowe są zbyt ograniczone i fragmentaryczne, aby wyciągnąć dokładne wnioski. To właśnie dzieje się obecnie z deterministyczną atrybucją na wszystkich platformach reklamowych i jest to coś, czego żadne modelowanie nie może całkowicie rozwiązać.

Pamiętasz tę reklamę Super Bowl T-Mobile, w której Rob Gronkowski zaprasza Toma Brady'ego na emeryturę na Florydę, ale Brady słyszy tylko co drugie słowo i myśli, że Gronkowski każe mu iść pobawić się w Tampa Bay? To jest atrybucja dzisiaj. Taka jest rzeczywistość, z którą borykają się marki w przypadku utraty danych.

Jest to porównywalne ze sposobem, w jaki ChatGPT przewiduje najbardziej prawdopodobne następne słowo podczas kompilacji odpowiedzi. Często ma to sens, ale czasami ma halucynacje i mówi ci, że Elon Musk będzie następnym prezydentem Stanów Zjednoczonych.

Oczywiście w modelowaniu zawsze występuje pewien zakres błędów, ale jeśli utrata danych jest wystarczająco poważna, nie można zbudować dokładnego modelu. Wtedy prawdziwe pytanie zaczyna nabierać kształtu: na ile można ufać platformom reklamowym, że zrobią to dobrze?

Dlatego musisz rozszerzyć swój zestaw narzędzi pomiarowych.

Modelowanie miksu medialnego i testowanie inkrementalności może przybliżyć Cię do zrozumienia wpływu

Atrybucja jest nadal potężną konstrukcją, ale podstawowa metodologia musi się zmienić, aby mogła ewoluować w erę współczesną. Musisz zadać kilka trudnych pytań, aby dowiedzieć się, jaki zestaw narzędzi pomiarowych i ramy będą działać w Twojej organizacji, na przykład:

- Jakich pomiarów potrzebujesz, aby podejmować mądre decyzje dotyczące planowania inwestycji w różnych kanałach i platformach?

- Gdzie są najlepsze możliwości skalowania istniejącego miksu medialnego tak efektywnie, jak to tylko możliwe?

Jako branża przyzwyczailiśmy się myśleć o wyimaginowanej wersji doskonałego przypisania jako o wszystkim, ale zawsze miało to służyć jedynie jako drogowskaz.

To nie znaczy, że nie jest przydatne. Musisz jednak skoncentrować się na przyszłości i pozwolić, aby atrybucja była elementem procesu decyzyjnego, a nie jedynym arbitrem.

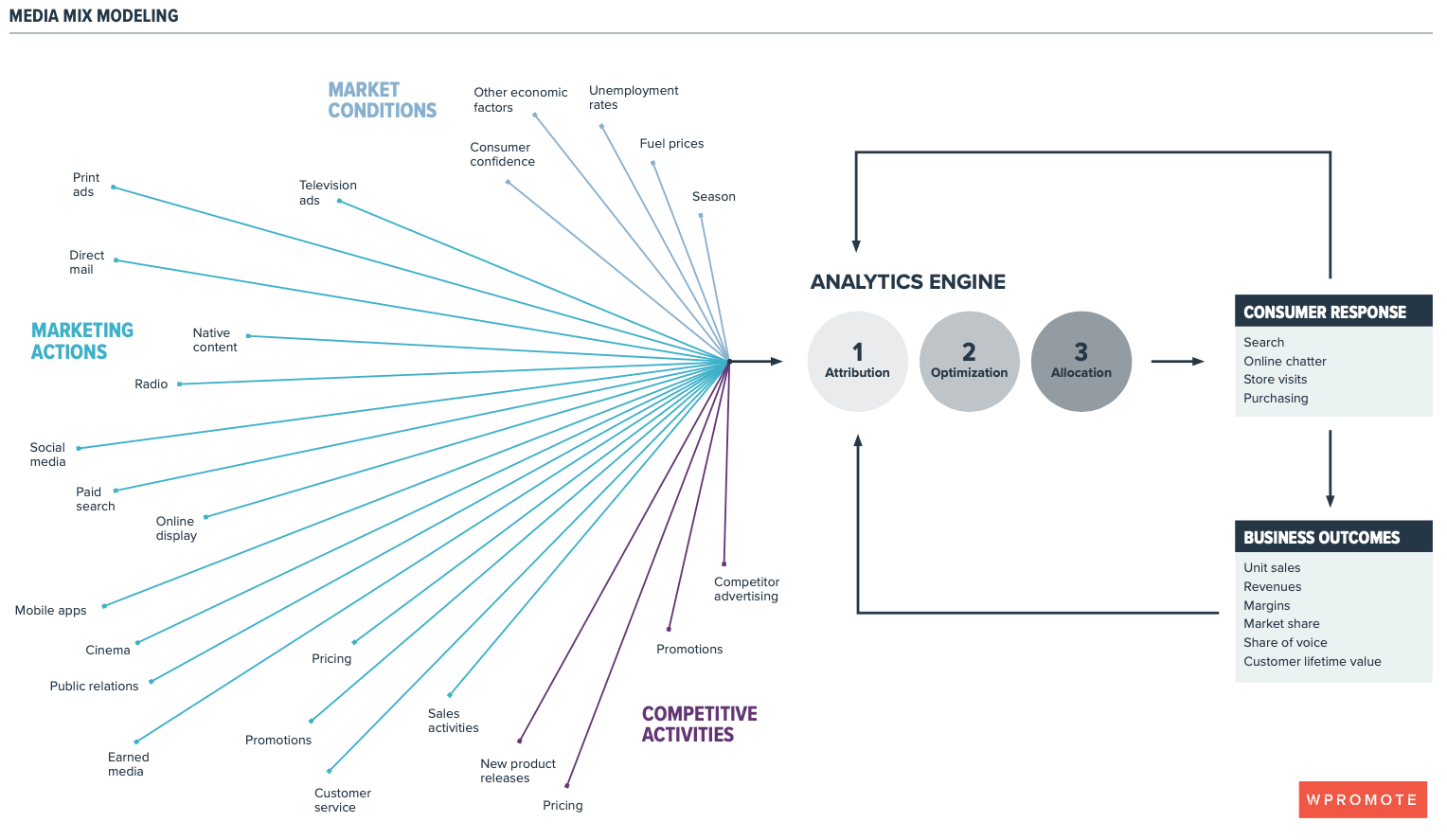

I chociaż nie ma idealnego rozwiązania, istnieje rozwiązanie niedoskonałe, które znacznie przybliża nas do celu: ujednolicona atrybucja połączona z modelowaniem miksu mediów (MMM), w którym wykorzystuje się pewne deterministyczne dane i model dla reszty. Celem jest wykorzystanie danych z przeszłości do przewidywania przyszłych inwestycji. Jest zakorzeniony we wzroście, a nie zakładnikiem wcześniejszych wyników.

Aby zrobić to dobrze, musisz zainwestować w solidne testy inkrementalności, które pomogą Ci zarówno zweryfikować modelowane dane dotyczące wydajności, jak i uzyskać jaśniejszy obraz tego, jak Twoje kampanie wpływają na pełną ścieżkę klienta.

Testowanie przyrostu geograficznego ma kluczowe znaczenie dla kalibracji modelowania media mix. Jest to również najpotężniejsze rozwiązanie pomiarowe, które pozwala określić, gdzie w danym momencie przeinwestowałeś lub niedoinwestowałeś.

Większość marek nie czuje się komfortowo z testowaniem przyrostowym. Niektórzy robili to już wcześniej, ale historycznie większość nie jest w tym świetna. Jeśli taka jest Twoja marka, potrzebujesz niezawodnych partnerów z przewidywalną metodologią dostosowaną do potrzeb i dziwactw Twoich wyjątkowych wyzwań biznesowych.

Nadszedł czas na przyszłościowe rozwiązanie, które integruje wiele narzędzi: ramy pomiaru wydajności

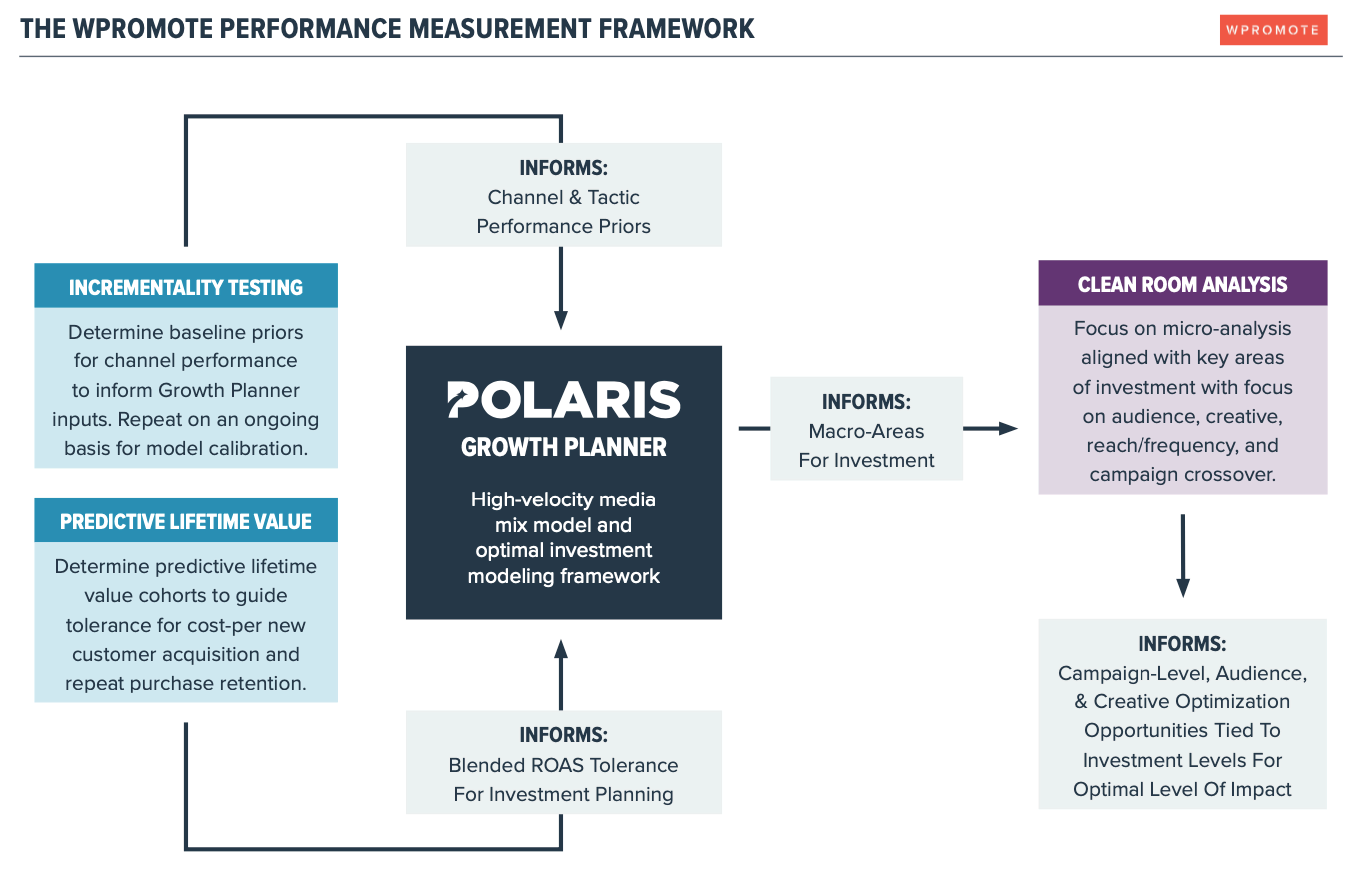

Jednym z największych wyzwań związanych z tradycyjnymi modelami miksu mediów jest szybkość działania. We Wpromote zbudowaliśmy model miksu mediów o dużej szybkości i narzędzie do planowania scenariuszy inwestycyjnych o nazwie Growth Planner jako część naszej platformy marketingowej Polaris, aby sprostać zarówno wyzwaniom związanym z deprecjacją danych, jak i możliwościom działania.

Growth Planner stanowi rdzeń naszych ram pomiaru wydajności. Zasadniczo prognozuje na cały rok klienta, aby znaleźć optymalną inwestycję dostępnych dolarów, aby osiągnąć cele w zakresie przychodów. Można go również wykorzystywać do cotygodniowych optymalizacji, aby Twoja marka mogła zachować elastyczność i dostosowywać się do nowych zmian.

Growth Planner analizuje wszystkie kanały marketingowe i całą ścieżkę, aby zmaksymalizować marże, ponieważ rentowność jest grą końcową. Mówi ci, jak inwestować w konkretną taktykę, w dół do kanału, w dół do miesiąca, tygodnia, dnia.

Upewniamy się, że model pozostaje uczciwy i jest coraz lepszy dzięki ciągłym testom przyrostowym, a my możemy wprowadzać do modelu dodatkowe zaawansowane dane wejściowe, takie jak przewidywana wartość w całym okresie życia, aby podejmować dalsze decyzje inwestycyjne. Następnie przekazujemy dane z Growth Planner do analizy czystych danych w kluczowych obszarach inwestycji.

Pomiar będzie nadal stanowił wyzwanie na platformach takich jak Google i Facebook oraz w kanałach medialnych, takich jak CTV. Jeśli naprawdę chcesz wiedzieć, jak faktycznie działa Twój marketing, musisz zacząć badać rozwiązania pomiarowe zgodne z prywatnością.