Odpowiedzialna sztuczna inteligencja – stawianie czoła wyzwaniom związanym z adopcją za pomocą zasad przewodnich i strategii

Opublikowany: 2023-09-08W epoce zdominowanej przez powszechne wdrażanie rozwiązań AI, nadanie priorytetu odpowiedzialnemu procesowi rozwoju przy jednoczesnym przestrzeganiu zasad bezpieczeństwa i etyki stało się dość istotne. Ponieważ możliwości tych systemów sztucznej inteligencji stale rosną i znajdują zastosowanie w różnych niszach przemysłowych, zapewnienie, że ich tworzenie jest zgodne z rygorystycznymi środkami bezpieczeństwa, musi być jednym z głównych priorytetów organizacji.

Jak zatem zapewnić, że ich systemy oparte na sztucznej inteligencji są etyczne i nie powodują żadnych niezamierzonych konsekwencji? Prostą odpowiedzią na tę zagadkę jest przestrzeganie zasad odpowiedzialnej sztucznej inteligencji.

Odpowiedzialna sztuczna inteligencja (RAI) odnosi się do kompleksowych ram sztucznej inteligencji, w których w centrum uwagi znajdują się względy etyczne i dobro społeczne. Charakteryzuje się odpowiedzialnym rozwojem i stosowaniem systemów sztucznej inteligencji zaprojektowanych w sposób zgodny z podstawowymi zasadami.

Zasady odpowiedzialnej sztucznej inteligencji pozwalają organizacjom skoncentrować się na przejrzystości, umożliwiając użytkownikom i interesariuszom zrozumienie wewnętrznego działania systemów sztucznej inteligencji. Ta przejrzystość toruje drogę do większego zaufania i odpowiedzialności, umożliwiając jednostkom zrozumienie, w jaki sposób podejmowane są decyzje AI. RAI aktywnie radzi sobie również z odchyleniami w algorytmach sztucznej inteligencji, inteligentnie zarządzając danymi i stosując środki uczciwości, aby zapewnić bezstronność wyników.

Ten blog pomoże Ci zrozumieć pięć zasad odpowiedzialnej sztucznej inteligencji i to, jak przestrzeganie ich może sprawić, że Twój system sztucznej inteligencji będzie sprawiedliwy i sprawiedliwy dla użytkowników. Oprócz przyjrzenia się korzyściom płynącym z wdrożenia odpowiedzialnej sztucznej inteligencji dla firm, pomożemy Ci również zrozumieć różne wyzwania, którym można stawić czoła, stosując usprawnione podejście.

Konieczność przyjęcia odpowiedzialnych strategii AI: łagodzenie ryzyka AI

W marcu 2016 r. Microsoft uruchomił na Twitterze chatbota opartego na sztucznej inteligencji o nazwie Tay. Celem Tay było uczenie się na podstawie interakcji z użytkownikami. Niestety, niektóre osoby zaczęły publikować w bocie obraźliwe treści, co spowodowało, że Tay odpowiedział obraźliwym językiem. W ciągu kilku godzin Tay przekształcił się w bota promującego mowę nienawiści i dyskryminację. Microsoft szybko przełączył Taya w tryb offline i przeprosił za niestosowne tweety bota. Ten incydent jest wyraźnym przykładem tego, jak sztuczna inteligencja może pójść nie tak, i od tego czasu miało miejsce wiele podobnych przypadków.

Sztuczna inteligencja ma ogromny potencjał, aby przynieść korzyści społeczeństwu, ale jak to ujął wujek Ben, „z wielką mocą wiąże się wielka odpowiedzialność”.

Kiedy wykorzystujesz sztuczną inteligencję do podejmowania ważnych decyzji biznesowych dotyczących wrażliwych danych, ważne jest, aby wiedzieć:

- Co robi sztuczna inteligencja i dlaczego?

- Czy dokonuje trafnych i sprawiedliwych wyborów?

- Czy jest to poszanowanie prywatności innych osób?

- Czy potrafisz kontrolować i mieć oko na tę potężną technologię?

Organizacje na całym świecie zdają sobie sprawę ze znaczenia strategii odpowiedzialnej sztucznej inteligencji, ale znajdują się na różnych etapach podróży do jej przyjęcia. Przyjęcie zasad odpowiedzialnej sztucznej inteligencji (RAI) jest najskuteczniejszą strategią ograniczania zagrożeń związanych ze sztuczną inteligencją.

Nadszedł zatem czas, aby ocenić swoje obecne praktyki i upewnić się, że dane są wykorzystywane w sposób odpowiedzialny i etyczny. Wczesne przyjęcie RAI nie tylko zmniejszy ryzyko związane z praktykami, ale także zapewni organizacjom przewagę nad konkurencją, zapewniając im przewagę konkurencyjną, której przekroczenie może być trudne w przyszłości.

Według ankiety MIT Sloan Survey 52% firm podejmuje kroki w kierunku odpowiedzialnych praktyk AI. Jednak ponad 79% tych firm przyznaje, że ich wysiłki są ograniczone pod względem skali i zakresu. W raporcie podkreślono rosnące znaczenie, jakie dla przedsiębiorstw ma sprostanie wyzwaniom i nadanie priorytetu odpowiedzialnej sztucznej inteligencji (RAI), w miarę jak rola sztucznej inteligencji w firmach stale rośnie. Aby kształtować zrównoważoną i odpowiedzialną przyszłość napędzaną sztuczną inteligencją, ustanowienie solidnych ram etycznych jest nie tylko wyborem, ale koniecznością.

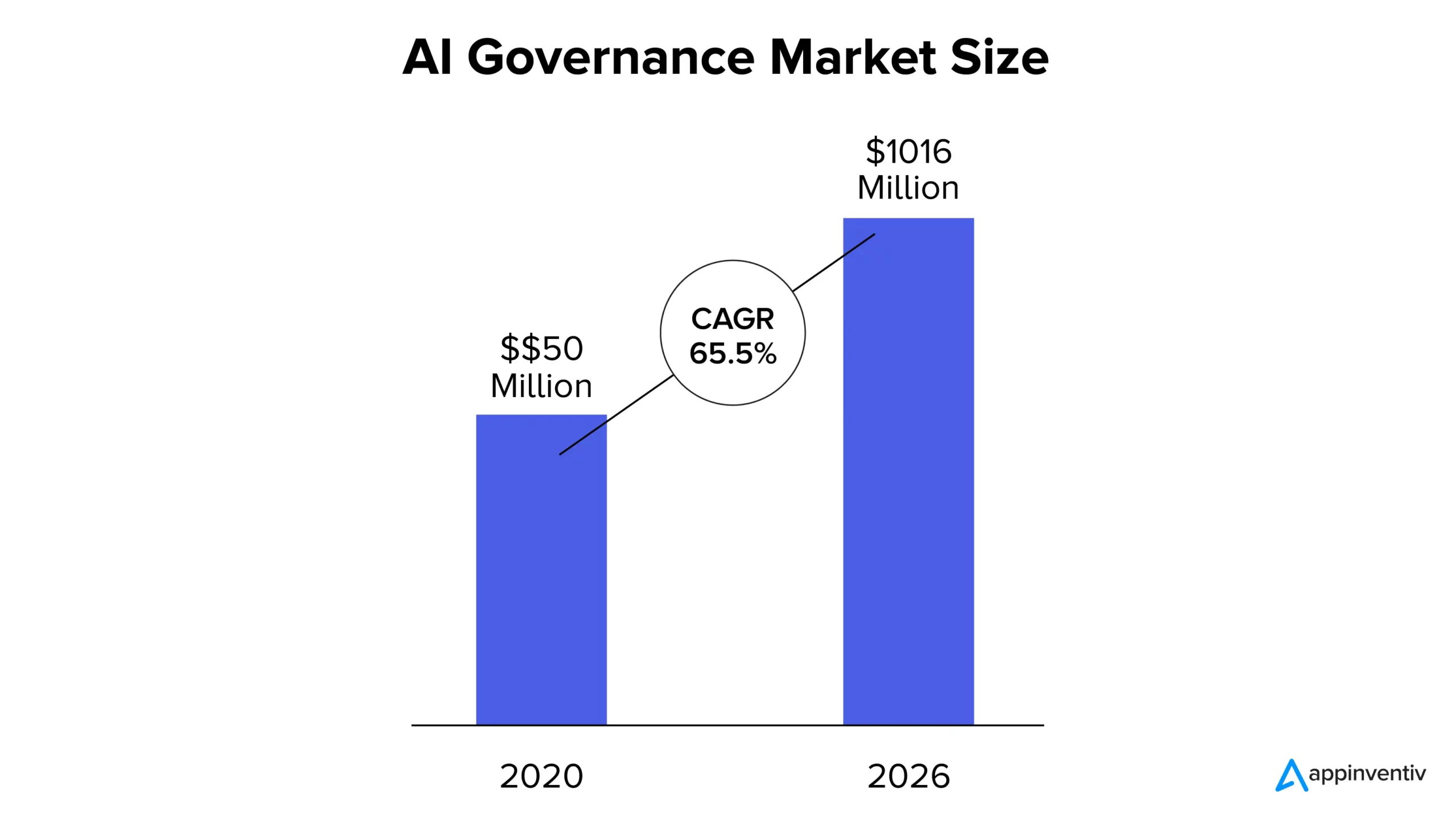

Obecnie, według raportu MarketsandMarkets, rynek zarządzania sztuczną inteligencją został wyceniony na 50 mln dolarów w 2020 r. i oczekuje się, że do 2026 r. osiągnie 1 016 mln dolarów, co oznacza CAGR na poziomie 65,5%. Rosnący udział w rynku można przypisać rosnącemu wzrostowi przejrzystości systemów sztucznej inteligencji, przestrzeganiu zgodności z przepisami i rosnącej potrzebie zaufania do rozwiązań opartych na sztucznej inteligencji.

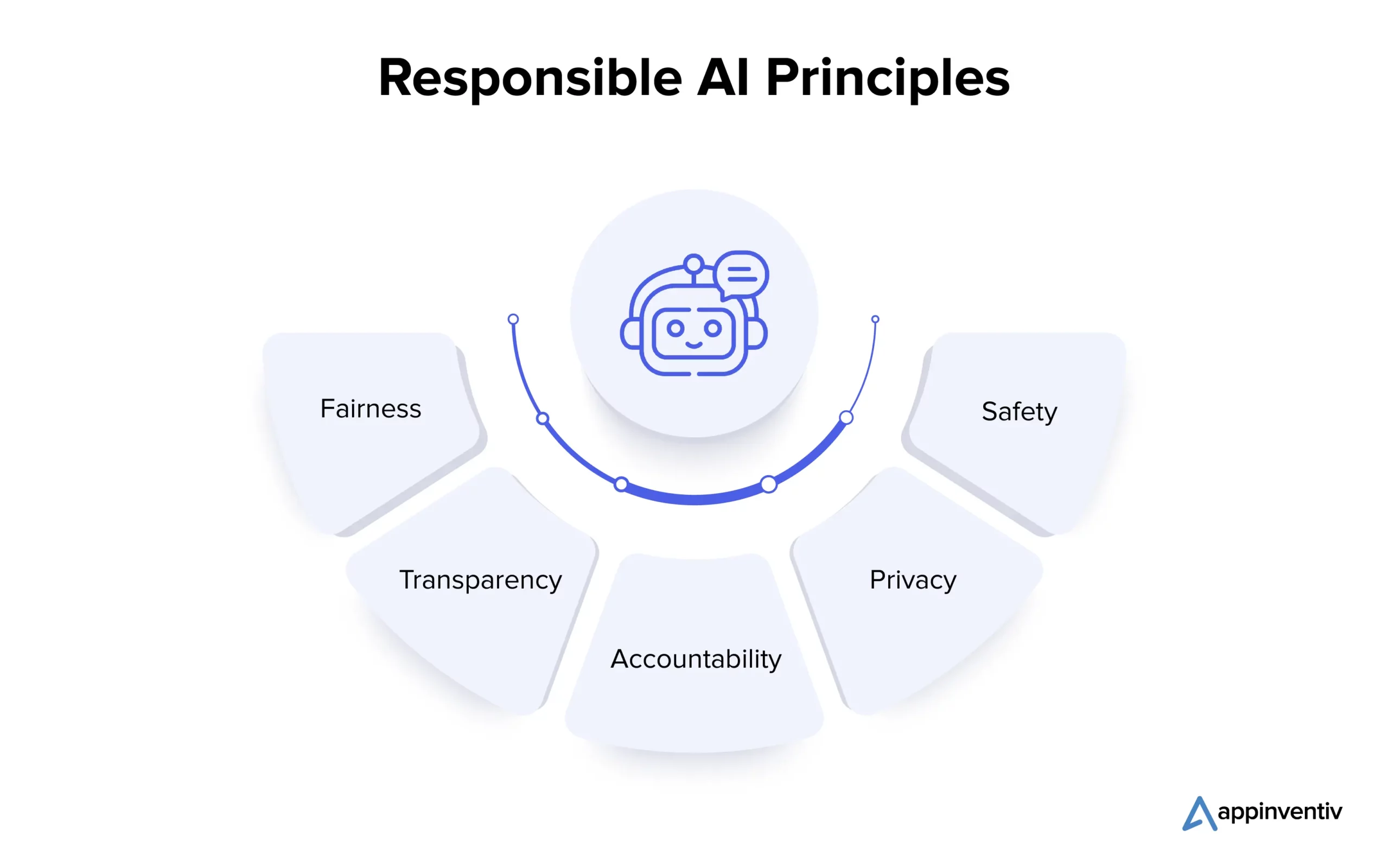

Jakie są zasady odpowiedzialnej sztucznej inteligencji?

Zrozumienie podstawowych zasad odpowiedzialnej sztucznej inteligencji jest niezbędne dla organizacji, które chcą etycznie poruszać się po złożonym krajobrazie sztucznej inteligencji. Przyjrzyjmy się szczegółowo wielu zasadom poniżej:

1. Uczciwość

Uczciwość w sztucznej inteligencji to podstawowa zasada, która pozwala wyeliminować uprzedzenia w systemach sztucznej inteligencji. Błędy mogą wystąpić podczas tworzenia algorytmu lub z powodu błędnie przedstawionych danych szkoleniowych. Analitycy danych wykorzystują techniki takie jak analiza danych do wykrywania i korygowania stronniczości, zapewniając, że systemy sztucznej inteligencji podejmują bezstronne decyzje i promują równe wyniki.

2. Przejrzystość

Przejrzystość w zakresie sztucznej inteligencji obejmuje dokumentowanie i wyjaśnianie kroków podjętych w trakcie jej opracowywania i wdrażania, tak aby była zrozumiała dla zainteresowanych stron. Techniki takie jak interpretowalne uczenie maszynowe ujawniają logikę decyzji AI, podczas gdy nadzór ludzki zapewnia zgodność etyczną i uzasadnienie.

3. Odpowiedzialność

Odpowiedzialność jest ściśle powiązana z przejrzystością i obejmuje ustanowienie mechanizmów pozwalających na pociągnięcie twórców i użytkowników sztucznej inteligencji do odpowiedzialności za wyniki i wpływ systemów sztucznej inteligencji. Wiąże się to z wdrożeniem wytycznych etycznych, wykorzystaniem narzędzi monitoringu oraz przeprowadzonym audytem. Środki te zapewniają, że systemy sztucznej inteligencji będą zapewniać pożądane wyniki, zapobiegać niezamierzonym szkodom i utrzymywać wiarygodność.

4. Prywatność

Prywatność ma kluczowe znaczenie dla ochrony danych osobowych osób fizycznych. Ekosystem AI polega na uzyskiwaniu zgody na gromadzenie danych, gromadzeniu jedynie niezbędnych danych i wykorzystywaniu ich wyłącznie zgodnie z przeznaczeniem. Do ochrony danych osobowych podczas opracowywania i produkcji modeli sztucznej inteligencji stosuje się techniki ochrony prywatności, takie jak prywatność różnicowa i techniki kryptograficzne.

5. Bezpieczeństwo

Programiści muszą nadać priorytet bezpieczeństwu odpowiedzialnej sztucznej inteligencji, w tym dobremu samopoczuciu fizycznemu i niefizycznemu. Aby to osiągnąć, na każdym etapie rozwoju systemu sztucznej inteligencji należy uwzględnić względy bezpieczeństwa. Na etapie projektowania kluczowe znaczenie ma zaangażowanie różnych interesariuszy w celu zidentyfikowania i zrozumienia potencjalnych zagrożeń. Ocena ryzyka, testowanie w różnych warunkach, nadzór człowieka oraz ciągłe monitorowanie i doskonalenie podczas produkcji są niezbędne, aby zapobiegać szkodom i utrzymywać niezawodność systemów AI.

Po zapoznaniu się z wieloma zasadami odpowiedzialnej sztucznej inteligencji, przejdźmy dalej i zrozummy wyzwania związane z przyjęciem rozwiązania.

Jakie wyzwania wiążą się z przyjęciem odpowiedzialnych rozwiązań AI?

Wdrożenie odpowiedzialnej sztucznej inteligencji to obiecująca podróż, która przyniesie przedsiębiorstwom wspaniałe nagrody, ale związane z nią najważniejsze wyzwania wymagają dokładnego rozważenia i proaktywnych rozwiązań. Przyjrzyjmy się im szczegółowo poniżej:

Wyjaśnialność i przejrzystość

Aby utrzymać zaufanie, systemy sztucznej inteligencji muszą być w stanie wyjaśnić, w jaki sposób i dlaczego generują określone wyniki. Brak przejrzystości może zmniejszyć zaufanie do tych systemów.

Bezpieczeństwo osobiste i publiczne

Systemy autonomiczne, takie jak samochody i roboty autonomiczne, mogą powodować zagrożenie dla bezpieczeństwa ludzi. Zapewnienie dobrostanu ludzi w takich kontekstach ma kluczowe znaczenie.

Automatyzacja i kontrola człowieka

Chociaż sztuczna inteligencja może zwiększyć produktywność, może zmniejszyć zaangażowanie ludzi i wiedzę specjalistyczną. Znalezienie równowagi w celu zapewnienia kontroli i nadzoru ze strony człowieka jest wyzwaniem.

Uprzedzenia i dyskryminacja

Mimo że systemy sztucznej inteligencji zaprojektowano tak, aby były neutralne, nadal mogą dziedziczyć błędy z danych szkoleniowych, co może prowadzić do niezamierzonej dyskryminacji. Zapobieganie takim uprzedzeniom jest niezwykle istotne.

Odpowiedzialność i regulacja

Wraz ze wzrostem ogólnej obecności sztucznej inteligencji mogą pojawić się kwestie odpowiedzialności i odpowiedzialności. Ustalenie, kto jest odpowiedzialny za wykorzystanie i niewłaściwe użycie systemu AI, jest złożone.

Bezpieczeństwo i prywatność

Sztuczna inteligencja wymaga szerokiego dostępu do danych, co może dodatkowo budzić obawy dotyczące naruszeń prywatności i bezpieczeństwa danych. Ochrona danych wykorzystywanych do szkoleń w zakresie sztucznej inteligencji jest niezbędna do ochrony ogólnej prywatności jednostki.

Teraz współpraca z renomowaną firmą zajmującą się tworzeniem aplikacji AI (np. Appinventiv), która przestrzega zasad odpowiedzialnej sztucznej inteligencji podczas procesu rozwoju, może pomóc firmom w skutecznym łagodzeniu związanych z tym wyzwań i zagrożeń.

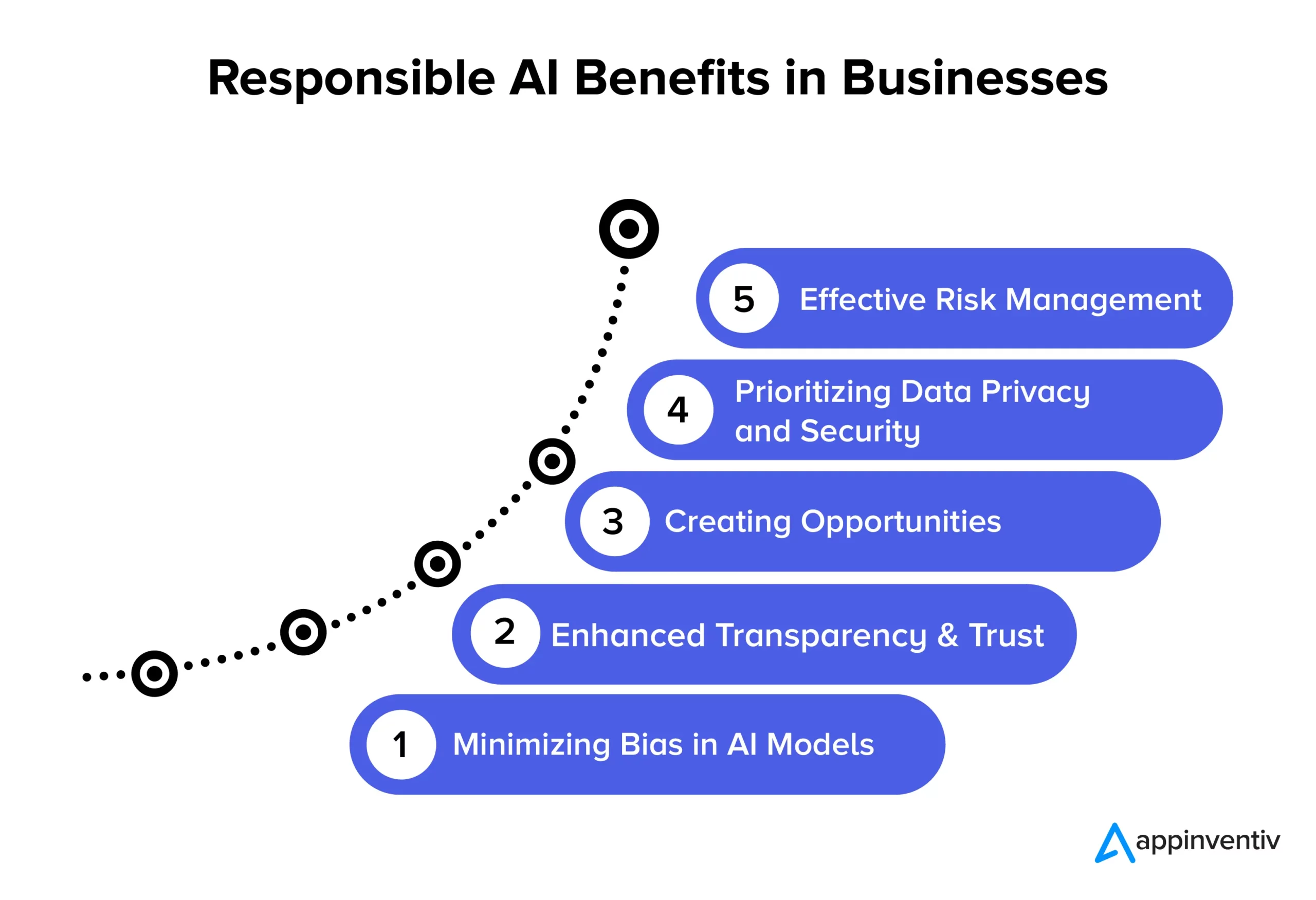

Korzyści z odpowiedzialnej sztucznej inteligencji dla firm

Przyjęcie zasad odpowiedzialnej sztucznej inteligencji toruje drogę wielu znaczącym korzyściom dla przedsiębiorstw i społeczeństwa. Przeanalizujmy je szczegółowo poniżej:

Minimalizowanie błędu systematycznego w modelach AI

Przestrzegając zasad odpowiedzialnej sztucznej inteligencji, firmy mogą skutecznie redukować błędy w swoich modelach sztucznej inteligencji i danych stanowiących podstawę ich szkolenia. To zmniejszenie stronniczości gwarantuje, że systemy sztucznej inteligencji zapewniają dokładniejsze i uczciwsze wyniki, które są poprawne pod względem etycznym i zmniejszają ryzyko zmiany danych w czasie. Ponadto minimalizacja stronniczości pomaga organizacjom uniknąć potencjalnych szkód dla użytkowników, które mogą wynikać z stronniczych wyników modelu sztucznej inteligencji, poprawiając ich reputację i zmniejszając odpowiedzialność.

Większa przejrzystość i zaufanie

Odpowiedzialne praktyki związane ze sztuczną inteligencją zwiększają przejrzystość i przejrzystość modeli sztucznej inteligencji. Pomaga to we wzmocnieniu zaufania między firmami a ich klientami. Ponadto sztuczna inteligencja staje się bardziej dostępna i zrozumiała dla szerszego grona odbiorców, co przynosi korzyści organizacjom i użytkownikom końcowym, umożliwiając szerszy zakres zastosowań i zwiększając efektywne wykorzystanie technologii sztucznej inteligencji.

Tworzenie możliwości

Przestrzeganie zasad odpowiedzialnej sztucznej inteligencji umożliwia programistom i użytkownikom prowadzenie otwartych rozmów na temat systemów sztucznej inteligencji. Jest to jedna z najbardziej poszukiwanych korzyści związanych z odpowiedzialną sztuczną inteligencją w przedsiębiorstwach. Tworzy przestrzeń, w której ludzie mogą wyrażać swoje pytania i obawy dotyczące technologii AI, umożliwiając firmom proaktywne rozwiązywanie tych problemów. To oparte na współpracy podejście do rozwoju sztucznej inteligencji skutkuje stworzeniem etycznie uzasadnionych i odpowiedzialnych społecznie rozwiązań w zakresie sztucznej inteligencji, które mogą poprawić reputację i konkurencyjność firmy.

Priorytetowe traktowanie prywatności i bezpieczeństwa danych

Odpowiedzialne rozwiązania AI pozwalają przedsiębiorstwom skoncentrować się w znacznym stopniu na ochronie prywatności i bezpieczeństwie danych. Oznacza to, że z danymi osobowymi lub wrażliwymi należy obchodzić się ostrożnie, chroniąc prawa osób fizycznych i zapobiegając naruszeniom danych. Kiedy firmy przestrzegają zasad odpowiedzialnej sztucznej inteligencji, zmniejszają ryzyko niewłaściwego wykorzystania danych, naruszenia przepisów i zniszczenia swojej reputacji. To mądry sposób na zapewnienie bezpieczeństwa danych i utrzymanie zaufania klientów.

Skuteczne zarządzanie ryzykiem

Odpowiedzialne praktyki związane ze sztuczną inteligencją wyznaczają jasne zasady etyczne i prawne dla systemów sztucznej inteligencji, co pomaga zmniejszyć ryzyko wystąpienia szkodliwych skutków. To zmniejszenie ryzyka przynosi korzyści wielu podmiotom, takim jak przedsiębiorstwa, pracownicy i społeczeństwo. Rozwiązując możliwe problemy etyczne i prawne, organizacje mogą uniknąć kosztownych procesów sądowych i zaszkodzić swojej reputacji.

Przykłady udanego odpowiedzialnego wdrożenia AI

Oto kilka godnych uwagi przykładów organizacji ze świata rzeczywistego, dla których priorytetem są etyczne i bezstronne praktyki związane ze sztuczną inteligencją:

Godne zaufania narzędzie IBM do rekrutacji AI

Duża amerykańska korporacja współpracowała z IBM w celu automatyzacji procesów rekrutacyjnych i nadania priorytetu uczciwości w procesach rekrutacyjnych opartych na sztucznej inteligencji. Ich celem było ułatwienie różnorodności i włączenia, przy jednoczesnym zachowaniu integralności modeli uczenia maszynowego. Wykorzystując IBM Watson Studio, narzędzie do monitorowania i zarządzania sztuczną inteligencją, skutecznie zidentyfikowali i zajęli się stronniczością w zatrudnianiu, zdobywając jednocześnie cenne informacje na temat podejmowania decyzji przez sztuczną inteligencję.

Ramy odpowiedzialnej sztucznej inteligencji w State Farm

State Farm, wiodąca firma ubezpieczeniowa w USA, włączyła sztuczną inteligencję do swojego procesu likwidacji szkód i wdrożyła odpowiedzialną strategię sztucznej inteligencji. Stworzyli system zarządzania, który pozwala na przypisanie odpowiedzialności za sztuczną inteligencję, co skutkuje szybszym i bardziej świadomym podejmowaniem decyzji. Model sztucznej inteligencji dynamicznego modelu oceny pojazdów (DVAM) firmy State Farm skutecznie przewiduje straty całkowite i zapewnia przejrzystość przetwarzania roszczeń ubezpieczeniowych.

Zespół odpowiedzialny za sztuczną inteligencję i lista kontrolna Grupy H&M

Grupa H&M, globalny sprzedawca detaliczny odzieży, włączyła sztuczną inteligencję do swoich działań, aby promować zrównoważony rozwój, optymalizować łańcuchy dostaw i ulepszać spersonalizowane doświadczenia klientów. Aby zapewnić odpowiedzialne wykorzystanie sztucznej inteligencji, w 2018 roku firma powołała dedykowany zespół ds. odpowiedzialnej sztucznej inteligencji. Zespół ten opracował praktyczną listę kontrolną, która identyfikuje i łagodzi potencjalne szkody związane ze sztuczną inteligencją oraz całym sercem przestrzega zasad odpowiedzialnej sztucznej inteligencji.

Uczciwość Google w uczeniu maszynowym

Google aktywnie pracowało również nad uwzględnieniem środków uczciwości w sztucznej inteligencji i uczeniu maszynowym. Opracowali narzędzia i zasoby, które pomagają programistom identyfikować i łagodzić błędy w modelach uczenia maszynowego.

GPT-3 OpenAI

OpenAI, firma stojąca za GPT-3, jest również kluczowym liderem w zakresie odpowiedzialnego podejścia do wdrażania sztucznej inteligencji. Wdrożyli mechanizmy dostrajające, aby uniknąć szkodliwych i stronniczych wyników, co dodatkowo potwierdza ich zaangażowanie w etyczną sztuczną inteligencję, nawet w zaawansowanych modelach NLP.

Przyszłość odpowiedzialnej sztucznej inteligencji z Appinventiv

Przyszłość odpowiedzialnej sztucznej inteligencji to ciągła podróż, w której organizacje znajdują się na różnych etapach rozwoju etycznego w zakresie technologii i wykorzystania danych. Jest to dynamiczna dziedzina skupiona na ustalaniu standardowych wytycznych dla różnych branż. Aby poznać zasady odpowiedzialnej sztucznej inteligencji w Twojej firmie, współpraca z Appinventiv to najlepszy wybór, jakiego może dokonać firma. Pomożemy Ci stworzyć etyczne, bezstronne i dokładne rozwiązania AI dostosowane do Twoich potrzeb.

Będąc wyspecjalizowaną firmą zajmującą się rozwojem sztucznej inteligencji, nasi programiści mają wieloletnie doświadczenie w opracowywaniu rozwiązań AI, stawiając na pierwszym miejscu etykę i odpowiedzialność. Mając udokumentowane doświadczenie w zakresie udanych projektów AI obejmujących wiele dziedzin przemysłowych, rozumiemy znaczenie dostosowania rozwiązań AI do wymaganych podstawowych wartości i zasad etycznych. Pomożemy Ci wdrożyć środki uczciwości, aby zapewnić, że Twoje rozwiązania biznesowe oparte na sztucznej inteligencji będą podejmować bezstronne decyzje.

Niedawno opracowaliśmy YouComm, aplikację medyczną opartą na sztucznej inteligencji, która łączy pacjentów z pielęgniarkami szpitalnymi za pomocą gestów dłoni i poleceń głosowych. Rozwiązanie jest obecnie wdrażane w ponad 5 sieciach szpitali w całych Stanach Zjednoczonych.

Skontaktuj się z naszymi ekspertami AI, aby zbudować rozwiązania AI, które zapewniają dokładne wyniki i są zgodne ze standardami etycznymi.

Często zadawane pytania

P. Jakie są przykłady odpowiedzialnej sztucznej inteligencji?

O. Oto kilka przykładów odpowiedzialnej sztucznej inteligencji w wielu dziedzinach przemysłu:

- Uczciwe algorytmy: systemy sztucznej inteligencji zaprojektowane tak, aby były sprawiedliwe i ograniczały błędy decyzyjne.

- Wyjaśnialna sztuczna inteligencja (XAI): podejmowanie decyzji AI w sposób zrozumiały.

- Łagodzenie uprzedzeń: ciągłe monitorowanie i ograniczanie uprzedzeń w sztucznej inteligencji.

- Komisje ds. etyki AI: Ustanawianie wewnętrznych komisji rewizyjnych ds. etycznej sztucznej inteligencji.

- Sztuczna inteligencja chroniąca prywatność: ochrona wrażliwych danych podczas korzystania z nich na potrzeby sztucznej inteligencji.

- Raporty przejrzystości: udostępnianie informacji o działaniu systemów AI i podejmowaniu decyzji.

- Odpowiedzialna edukacja w zakresie sztucznej inteligencji: szkolenie specjalistów AI w zakresie etyki i odpowiedzialności.

P. Jakie są skuteczne przypadki odpowiedzialnego użycia sztucznej inteligencji?

A. Oto kilka udanych przypadków odpowiedzialnego użycia sztucznej inteligencji:

- Diagnostyka opieki zdrowotnej: służy do poprawy wyników medycznych przy zachowaniu uczciwości i prywatności pacjenta.

- Usługi finansowe: Jest w stanie wyeliminować ryzyko związane z oszustwami i złośliwym oprogramowaniem. Odpowiedzialne rozwiązania oparte na sztucznej inteligencji mogą dodatkowo chronić dane klientów i zapewnić sprawiedliwe kredytowanie.

- Rekrutacja: pomaga w zmniejszeniu uprzedzeń, torując drogę do przyjęcia różnorodności i równych szans wśród użytkowników.

- Pojazdy autonomiczne: pomaga w priorytetowym traktowaniu bezpieczeństwa i przestrzeganiu standardów etycznych.

P: Czy odpowiedzialna sztuczna inteligencja jest procesem ciągłym, czy też firmy mogą wdrożyć ją raz i zapomnieć?

Odpowiedzialna sztuczna inteligencja to proces ciągły, który wymaga ciągłego monitorowania, aktualizacji i dostosowywania do zmieniających się standardów i przepisów etycznych. Dlatego zaleca się współpracę z wyspecjalizowaną firmą zajmującą się rozwojem sztucznej inteligencji, która może pomóc Ci w ostrożnym poruszaniu się po wodach.