Co to jest SEO techniczne?

Opublikowany: 2023-09-01Kiedy zaczniesz uczyć się SEO, wkrótce zdasz sobie sprawę, że istnieje wiele różnych aspektów, które musisz zrozumieć, aby odnieść sukces.

Od SEO na stronie po SEO na stronie i tworzenie treści. Aby zapewnić ranking swojej witryny tam, gdzie powinien, musisz dobrze to wszystko ogarnąć, niezależnie od konkretnej roli, jaką pełnisz w SEO.

W tym artykule zajmiemy się technicznym SEO. Dowiesz się dokładnie, co to jest, dlaczego jest to ważne dla stron internetowych i czym charakteryzuje się witryna dobrze zoptymalizowana pod względem technicznym.

Podamy Ci również szczegółowe informacje na temat technicznego działania SEO, od indeksowania i rankingu, a także tego, czego potrzebujesz, aby te trzy kroki dobrze ze sobą współdziałały.

Źródło obrazu: https://tsh.io/

Co to jest SEO techniczne?

Techniczne SEO to proces optymalizacji elementów witryny internetowej „za kulisami” w celu poprawy jej wydajności w wyszukiwarkach takich jak Google i Bing. Proces ten obejmuje takie kroki, jak ulepszanie znaczników i struktury witryny, aby zapewnić łatwe indeksowanie, indeksowanie i ranking (więcej o tym porozmawiamy później) przez boty wyszukiwarek, takie jak Googlebot. Zadania obejmują udoskonalenie szybkości witryny, utworzenie prostej i łatwej do zrozumienia architektury witryny, użycie adresów URL „przyjaznych SEO” oraz zastosowanie znaczników schematu w celu wzbogacenia wyników wyszukiwania.

Zasadniczo techniczne SEO tworzy silną bazę, która pomaga wyszukiwarkom w procesie podnoszenia rankingów witryny. Ostatecznie doprowadzi to do zwiększenia ruchu organicznego i poprawy doświadczenia użytkownika.

Pomyśl o swojej witrynie internetowej jak o dobrze zorganizowanej bibliotece. Techniczne SEO to etap schludnego ułożenia książek na półkach z przejrzystymi tagami (struktura adresu URL), ustawienia znaków zapewniających płynną nawigację (linki wewnętrzne) i stworzenia przyjaznej atmosfery (szybkość witryny). Kiedy biblioteka jest uporządkowana i zachęcająca, więcej odwiedzających może zlokalizować potrzebne książki (użytkownicy odkrywają treść), a bibliotekarze (boty wyszukiwarek) mogą kategoryzować i sugerować książki (indeksowanie i ranking).

Dlaczego techniczne SEO jest ważne?

Techniczne SEO jest niezwykle ważne dla zdecydowanej większości stron internetowych, ponieważ stanowi podstawę widoczności witryny w wyszukiwarkach i ogólnej wydajności. Oczywiście treść, którą publikujesz, jest kluczowa, ale brak odpowiedniej optymalizacji technicznej może uniemożliwić wyszukiwarkom skuteczne odkrywanie, indeksowanie i klasyfikowanie tych treści.

Znaczenie technicznego SEO można podsumować w następujący sposób:

Po pierwsze, zapewnia wyszukiwarkom skuteczne przeszukiwanie i indeksowanie treści. Optymalizując elementy, takie jak struktura witryny i nawigacja, techniczne SEO ułatwia sprawne indeksowanie Twojej witryny przez boty wyszukiwarek. Ta dostępność jest niezbędna, aby Twoje treści zostały odpowiednio zauważone i zaindeksowane.

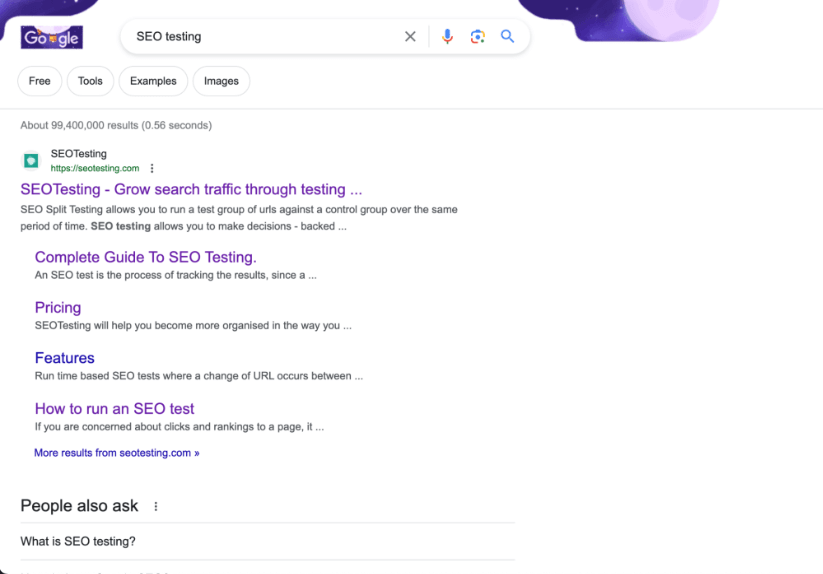

Możemy być trochę stronniczy, ale wierzymy, że nasza witryna internetowa jest doskonałym przykładem witryny o świetnej architekturze!

Po drugie, techniczne SEO bezpośrednio wpływa na rankingi w wyszukiwarkach. Szybkość witryny i responsywność na urządzeniach mobilnych to potwierdzone czynniki rankingowe w algorytmie wyszukiwania Google, a poza tym posiadanie dobrze zorganizowanego znacznika HTML odgrywa kluczową rolę w tym, jak wyszukiwarki oceniają jakość i trafność Twojej witryny. Dobrze zoptymalizowana strona internetowa ma większe szanse na wyższą pozycję w wyszukiwarkach.

Wreszcie, techniczne SEO przyczynia się do tego, że Twoja witryna internetowa ma doskonałe doświadczenie użytkownika. Podczas pracy nad technicznym SEO praktyki takie jak optymalizacja czasu ładowania strony i ulepszanie adresów URL również zwiększą zadowolenie użytkowników. Lepsze doświadczenie użytkownika prowadzi do zmniejszenia współczynnika odrzuceń i zwiększenia współczynnika zaangażowania, co pośrednio poprawi wydajność Twojej witryny w wynikach wyszukiwania.

Ostatecznie techniczne SEO służy jako kamień węgielny, na którym budowane są skuteczne strategie SEO! Gwarantuje to, że Twoje treści są nie tylko najwyższej jakości, ale także łatwe do odnalezienia i dostępne. To spodoba się zarówno wyszukiwarkom, jak i, co ważniejsze, użytkownikom.

Jakie są cechy strony internetowej zoptymalizowanej pod względem technicznym?

Niezależnie od tego, czy jest to witryna e-commerce generująca miliony funtów przychodów, czy witryna z broszurami prezentującymi usługi lokalnej firmy instalacyjnej, wszystkie witryny mają te same cechy, jeśli chodzi o dobrą optymalizację z technicznego punktu widzenia SEO .

To jest szybkie

Dobrze zoptymalizowana strona internetowa będzie szybko ładować się na wszystkich urządzeniach (komputer stacjonarny, tablet i telefon komórkowy) i warunkach sieciowych. Szybko ładujące się strony zwiększają wygodę użytkownika w Twojej witrynie i są preferowane przez wyszukiwarki, co potencjalnie prowadzi do wyższych rankingów.

Wiemy, że Google jako potwierdzony czynnik rankingowy wymienia zdanie podstawowych testów wskaźników sieciowych, co jest w ich przypadku rzadkością, dlatego kluczowe jest zapewnienie szybkości witryny i pomyślnego przejścia testów CWV.

Można go indeksować

Nie powinno to być oczywiste, ale strony internetowe powinny umożliwiać indeksowanie wyszukiwarek. Jeśli bot wyszukiwarki (np. Googlebot) nie może skutecznie indeksować Twojej witryny, wystąpią problemy z pozycją Twojej strony w SERP.

Pliki robots.txt i metatagi robots powinny być odpowiednio skonfigurowane. Pomoże to robotom wyszukiwarek wskazać, które strony należy przeszukiwać i indeksować, a które pozostawić w spokoju. Nie każda strona w Twojej witrynie powinna być indeksowana. Zwłaszcza strony administracyjne i strony zawierające dane klientów.

Zachowuje kapitał łącza

Strony internetowe, które są dobrze zoptymalizowane technicznie, robią wszystko, co w ich mocy, aby zachować jak najwięcej wartości linków.

Po pierwsze, witryna będzie wykorzystywać linki wewnętrzne, które kierują użytkowników (i boty wyszukiwarek) do odpowiednich treści w witrynie. Poprawia to nawigację w witrynie, pomaga rozpowszechniać kapitał linków do innych stron i pozwala dłużej zatrzymać użytkowników w witrynie.

Po drugie, witryna będzie całkowicie wolna (idealnie) od uszkodzonych linków i niepotrzebnych łańcuchów przekierowań. Zapewnia to bezproblemową obsługę użytkownika i sprawne indeksowanie przez wyszukiwarki.

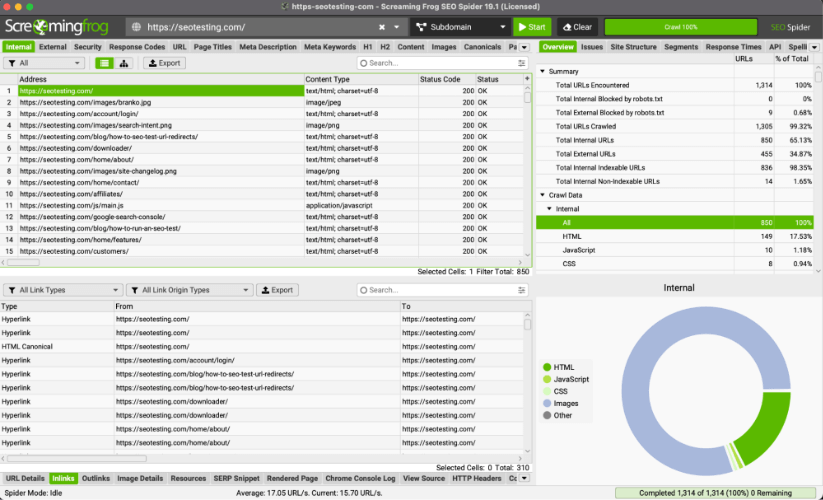

Wskazówka dla profesjonalistów: możesz użyć ScreamingFrog, aby zidentyfikować uszkodzone linki i przekierować łańcuchy, które nie muszą tam być.

Jest przyjazny dla urządzeń mobilnych

Wszystkie strony internetowe powinny być zaprojektowane tak, aby były responsywne i funkcjonalne na urządzeniach mobilnych. W związku ze stale rosnącym wykorzystaniem smartfonów do przeglądania (od 2023 r. 63% organicznego ruchu związanego z wynikami wyszukiwania Google w USA pochodzi z urządzeń mobilnych), kompatybilność z urządzeniami mobilnymi jest kluczowym czynnikiem wpływającym zarówno na wygodę użytkowników, jak i na rankingi.

To bezpieczne

Wszystkie strony internetowe powinny upewnić się, że korzystają z bezpiecznego protokołu HTTPS.

Dzięki temu masz pewność, że Twoja witryna ma odpowiednie szyfrowanie danych i zwiększy zaufanie użytkowników korzystających z Twojej witryny. Zaufanie to jest szczególnie ważne, gdy na stronach internetowych przekazywane są dane finansowe, np. dane dotyczące kart kredytowych.

Google potwierdziło również, że korzystanie z protokołu HTTPS jest czynnikiem rankingowym. Nie wiemy, jaką wagę przywiązuje do tego algorytm, ale możemy się domyślać, że ma to większe znaczenie w przypadku witryn YMYL (Your Money Your Life).

Wykorzystuje dane strukturalne

Na stronach internetowych zaimplementowano znaczniki schematu, aby zapewnić dodatkowy kontekst dotyczący treści. Umożliwi to wyszukiwarkom wyświetlanie fragmentów rozszerzonych w SERPach podczas wyświetlania Twojej witryny, zwiększając współczynniki klikalności i zwiększając ruch w Twojej witrynie.

Czołganie się

Pokrótce poruszyliśmy ten temat w naszym artykule o tym, jak nauczyć się SEO w 2023 roku, ale teraz przejdziemy przez cztery etapy technicznego SEO, które przeniosą Twoją witrynę ze stron HTML, CSS i JavaScript do rankingów w SERP. Indeksowanie, renderowanie, indeksowanie i ranking.

Pierwszym krokiem w tej podróży jest czołganie się.

Indeksowanie to proces, dzięki któremu wyszukiwarki takie jak Google i Bing systematycznie przeglądają zawartość witryn internetowych i dowiadują się o nich więcej. Celem indeksowania jest zebranie informacji o stronach internetowych, co obejmuje:

- Ich treść.

- Ich struktura.

- Inne istotne informacje.

Wyszukiwarki mogą następnie wykorzystać te dane do skutecznego indeksowania i pozycjonowania (porozmawiamy o tym później) oraz wyświetlania Twoich stron internetowych w SERPach.

Wyszukiwarki używają botów, zwanych robotami indeksującymi, do poruszania się po ogromnej liczbie stron internetowych. Roboty indeksujące zaczynają od odwiedzenia kilku znanych stron internetowych, często popularnych lub często aktualizowanych. Stamtąd korzystają z łączy znajdujących się na tych stronach, aby „odkrywać” nowe strony, które mogą następnie renderować, indeksować i oceniać.

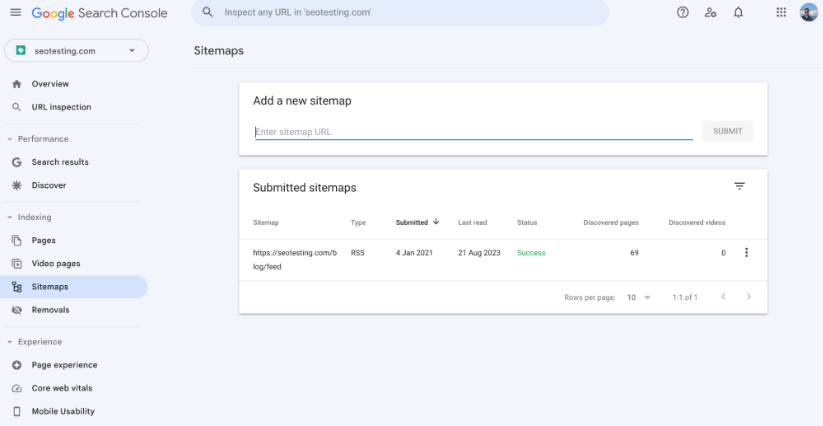

Mapa witryny XML

Mapa witryny XML to plik udostępniający wyszukiwarkom uporządkowaną listę wszystkich adresów URL w Twojej witrynie. Jest to narzędzie, które pomaga robotom wyszukiwarek zrozumieć organizację zawartości Twojej witryny i zapewnia skuteczne odnajdywanie i indeksowanie wszystkich ważnych stron.

Upewnienie się, że w Twojej witrynie znajduje się mapa witryny XML, jest niezbędne, jeśli chodzi o techniczne SEO, ponieważ pomaga w indeksowaniu stron na kilka różnych sposobów:

Posiadanie mapy witryny XML w witrynie zapewnia botom wyszukiwarek scentralizowaną listę adresów URL, które mają one przeszukiwać i indeksować. Pomoże Ci to upewnić się, że wszystkie najważniejsze strony, takie jak strony z listami produktów i strony z wyświetlaniem produktów, zostaną uwzględnione w indeksach wyszukiwarek i, miejmy nadzieję, na stronach wyników wyszukiwarek.

Możesz także użyć mapy witryny, aby określić priorytet i zmienić częstotliwość każdego adresu URL w swojej witrynie. Należy pamiętać, że wyszukiwarki mogą nie przestrzegać dokładnie tych zasad, ale dzięki temu roboty mogą zorientować się, jak ważne są różne strony w Twojej witrynie i jak często są one aktualizowane.

Podczas gdy wyszukiwarki na podstawie różnych czynników decydują, które strony należy przeszukać i zaindeksować w pierwszej kolejności, mapa witryny może pomóc w wyróżnieniu ważnych (lub nowo zaktualizowanych) stron. Może to skierować roboty wyszukiwarek na te strony i pomóc w ich szybkim przeszukaniu i zaindeksowaniu. Gdybyś nie miał mapy witryny, polegałbyś na robotach indeksujących, które automatycznie odnajdywałyby te strony, korzystając z łączy wewnętrznych i zewnętrznych itp. Jest to proces znacznie dłuższy.

Duże witryny, z setkami tysięcy (a nawet milionami adresów URL), mapami witryn (i wieloma mapami witryn) pomogą robotom indeksującym skuteczniej odkrywać każdą stronę, którą chcesz zaindeksować. Jest to świetna rzecz, ponieważ pomaga znacznie efektywniej zarządzać budżetem indeksowania. Nie stanowi to problemu w przypadku mniejszych witryn, ponieważ te małe witryny nie będą miały problemów z budżetem indeksowania.

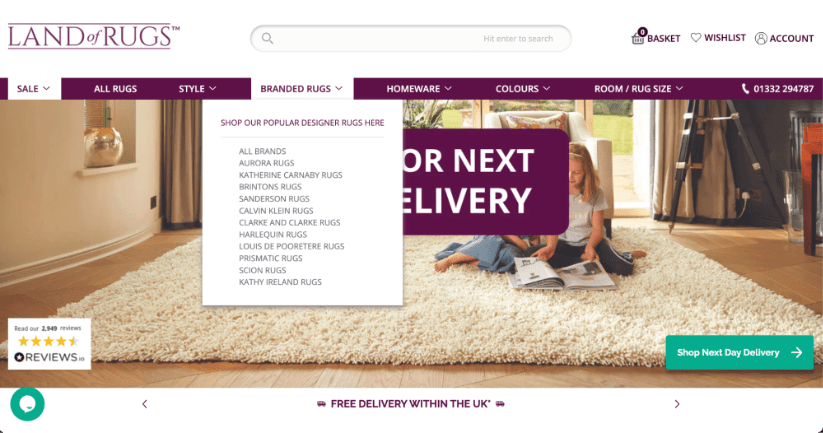

Struktura witryny

Struktura Twojej witryny będzie odgrywać kluczową rolę w określeniu sposobu, w jaki boty wyszukiwarek będą nawigować i indeksować jej zawartość. Dobrze zorganizowana struktura witryny nie tylko ułatwi robotom wyszukiwarek sprawne indeksowanie, ale także poprawi ogólne wrażenia, jakich doświadczają prawdziwi użytkownicy na Twojej witrynie.

Oto przykład witryny e-commerce z dobrą strukturą witryny. Dostęp do wszystkich ważnych stron (stron z listami produktów) w tym przykładzie można łatwo uzyskać z paska nawigacyjnego strony głównej, przekazując jak najwięcej linków do tych stron i zapewniając, że roboty indeksujące będą mogły je łatwo znaleźć.

Kiedy strony są zorganizowane w proste, łatwe do zrozumienia kategorie i podkategorie, robotom indeksującym znacznie łatwiej jest śledzić linki i systematycznie indeksować zawartość. Dzięki temu hierarchicznemu układowi najważniejsze strony znajdują się bliżej strony głównej, co zwiększa ich szanse na szybkie odkrycie i zaindeksowanie.

Linki wewnętrzne w strukturze witryny internetowej skuteczniej poprowadzą roboty wyszukiwarek przez różne sekcje witryny. Dobrze umieszczone i trafne linki wewnętrzne pomagają rozprowadzać kapitał linków na stronach, umożliwiając robotom indeksującym odkrycie znacznie szerszego zakresu treści, niż byłoby to możliwe bez umieszczania linków wewnętrznych w całej treści.

Należy unikać stron osieroconych (stron, do których nie prowadzą żadne linki), ponieważ stanowią one ogromne wyzwanie dla robotów indeksujących. Solidna struktura witryny z odpowiednimi linkami wewnętrznymi pozwala tego uniknąć.

Ogólnie rzecz biorąc, struktura Twojej witryny będzie stanowić kluczową strukturę kształtującą sposób, w jaki wyszukiwarki przeszukują i indeksują Twoją treść. Wdrażając przejrzystą hierarchię witryn, dodając odpowiednie linki kontekstowe i optymalizując alokację budżetu indeksowania (jeśli jest to wymagane), właściciele witryn i marketerzy mogą pozytywnie wpłynąć na sposób, w jaki wyszukiwarki indeksują ich witryny.

Struktura adresu URL

Struktura adresów URL Twojej witryny będzie miała bezpośredni wpływ na indeksowanie Twojej witryny. Zapewnienie dobrze zorganizowanej (i opisowej) struktury adresów URL zwiększy skuteczność robotów indeksujących w zrozumieniu zawartości każdej strony. Jasne (i krótkie) adresy URL zapewniają cenny kontekst dotyczący tematu i hierarchii lokalizacji strony w serwisie.

Na przykład adres URL wyglądający następująco: https://example.com/blog/head-topic-1 poinformuje robota wyszukiwarki, że ta strona jest istotną stroną w blogu i dotyczy jednego z kluczowych tematów witryny.

Z drugiej strony, zawiłe lub bezsensowne adresy URL (dobrym przykładem jest https://example.com/12642/test-category/test-page125253/) mogą dezorientować roboty poruszające się po Twojej witrynie. Utrudni to im możliwość interpretacji treści, a także trafności i znaczenia strony w Twojej witrynie. Czysta struktura adresów URL, pozbawiona zbędnych parametrów i symboli, zwiększy szanse na skuteczne indeksowanie Twoich stron.

Ponadto, chociaż nie jest to bezpośrednio związane z indeksowaniem, struktura adresów URL będzie miała bezpośredni wpływ na komfort korzystania z Twojej witryny i współczynniki klikalności. Zwięzły i trafny adres URL znacznie częściej przyciąga kliknięcia użytkowników w wynikach wyszukiwania, co może (pośrednio) wpłynąć na ogólny ranking Twojej witryny w wyszukiwarkach.

Pliki robots.txt

Plik robots.txt ma ogromną władzę nad sposobem, w jaki wyszukiwarki nawigują i indeksują Twoją witrynę. Dokument ten, znajdujący się w centrum Twojej witryny, zawiera szczegółowe wytyczne dla robotów indeksujących wyszukiwarek, określające sposób indeksowania Twojej witryny. W tym, które strony można indeksować, a które należy pozostawić w spokoju.

Na tym etapie warto zauważyć, że chociaż plik robots.txt może uniemożliwić robotom wejście na określone strony lub sekcje Twojej witryny, nie gwarantuje to, że Twoje strony nie będą indeksowane alternatywnymi sposobami. Niektóre wyszukiwarki mogą nadal rejestrować strony wykluczone z indeksowania, jeśli można je znaleźć w inny sposób, na przykład poprzez linki wewnętrzne w Twojej witrynie.

Jeśli plik robots.txt jest pełen błędów lub sztywnych zasad, może się okazać, że utrudnia to wyszukiwarkom indeksowanie ważnych treści, co może „rzucić cień” na wydajność Twojej witryny w SERP. Ważne jest, aby regularnie sprawdzać plik robots.txt, aby mieć pewność, że wszystkie reguły działają poprawnie.

Analiza pliku dziennika

Analiza plików dziennika Twojej witryny może mieć ogromny wpływ na sposób, w jaki wyszukiwarki ją indeksują, a marketerzy mogą to zrobić samodzielnie, korzystając z odpowiednich narzędzi! Pliki dziennika to zasadniczo zapisy pokazujące, które części Twojej witryny odwiedzają wyszukiwarki i jak często roboty wyszukiwarek odwiedzają te części Twojej witryny. Zasadniczo pozwala to określić, które strony w Twojej witrynie są postrzegane przez wyszukiwarki jako ważne, co pozwala Ci wykorzystać to do uzyskania przewagi.

Pomaga to marketerom zdecydować, na których stronach warto poświęcić więcej czasu (i potencjalnie pieniędzy), dzięki czemu wyszukiwarki będą zwracać uwagę na właściwe rzeczy. Ponadto analiza pliku dziennika może wykazać, czy wyszukiwarki uważają Twoją witrynę za łatwą do zrozumienia i nawigacji, czy też mają problemy. Może to pomóc w wprowadzeniu zmian, takich jak poprawienie sposobu łączenia stron (zazwyczaj poprzez linki wewnętrzne) lub lepsze uporządkowanie adresów internetowych.

Jedna z moich ulubionych przemówień na ten temat pochodzi od Matthew Barby’ego z 2018 r., kiedy był wiceprezesem ds. wzrostu organicznego w HubSpot. Znajdź dokładny fragment przemówienia o 25:07:

Wykonanie

Renderowanie odnosi się do procesu, w jaki wyszukiwarki analizują i rozumieją treść i strukturę Twojej witryny, aby określić jej ranking w SERP. Proces ten obejmuje dwa główne etapy: indeksowanie (o którym pisaliśmy) i indeksowanie (o czym porozmawiamy wkrótce).

Podczas indeksowania boty wyszukiwarek przemierzają sieć, odwiedzając strony internetowe i zbierając dane HTML. Jednak nie cała treść jest od razu widoczna w znacznikach HTML. Tutaj w grę wchodzi renderowanie.

Renderowanie wykracza poza podstawowe analizowanie kodu HTML i uwzględnia elementy dynamiczne często pojawiające się w nowoczesnych witrynach internetowych, które mogą nie być widoczne w surowym kodzie HTML. Obejmuje to treść ładowaną poprzez JavaScript, AJAX lub inne języki skryptowe, a także arkusz stylów CSS strony. Boty wyszukiwarek, próbując symulować doświadczenie użytkownika, wykonują JavaScript i zbierają w pełni wyrenderowaną treść. Treść ta jest następnie wykorzystywana do budowania indeksu, bazy danych zawierającej informacje o stronie internetowej.

Aby uzyskać optymalne wyniki SEO, ważne jest, aby Twoja witryna była łatwo renderowana przez boty wyszukiwarek. Wiąże się to z użyciem technik takich jak renderowanie po stronie serwera (SSR) lub wstępne renderowanie w przypadku witryn internetowych obciążonych dużą ilością JavaScript. Dostarczenie metadanych (takich jak metatagi i opisy) pomoże wyszukiwarkom zrozumieć kontekst i znaczenie treści. Właściwa obsługa tagów kanonicznych i zarządzanie przekierowaniami jest również ważna, aby zapobiec problemom z duplikacją treści.

Indeksowanie

Indeksowanie oznacza proces gromadzenia, organizowania i przechowywania informacji o stronach internetowych, dzięki czemu można je szybko wyszukać i wyświetlić w wynikach wyszukiwania, gdy użytkownik wyszuka odpowiednie zapytanie. Gdy robot sieciowy przeszuka stronę internetową i wyrenderuje jej zawartość, informacja zostanie dodana do indeksu wyszukiwarki.

Zasadniczo indeks jest ogromną bazą danych zawierającą informacje o zawartości witryny i strukturze stron internetowych w Internecie. Posiadanie dostępu do tej ogromnej bazy informacji pozwala wyszukiwarkom szybko reagować na zapytania użytkowników, odnajdując odpowiednie strony z indeksu i wyświetlając je w SERPach.

Podczas procesu indeksacji wyszukiwarki wyodrębniają z przeszukanych i renderowanych stron internetowych kluczowe informacje, takie jak treść, metadane, obrazy i łącza. Informacje te są następnie przechowywane w uporządkowany sposób, co umożliwia wyszukiwarkom szybkie dopasowywanie zapytań użytkowników do odpowiednich stron.

Jest kilka rzeczy, które powinieneś zrobić, aby skutecznie indeksować swoje strony.

Rozwiąż problemy związane z duplikacją treści i kanibalizmem słów kluczowych

Rozwiązanie problemów z duplikacją treści i kanibalizmem słów kluczowych przyniesie znaczne korzyści, jeśli chodzi o szybkie indeksowanie stron.

Pozbywając się zduplikowanych treści, zapobiegasz pomyłkom w wyszukiwarkach, umożliwiając dokładną identyfikację pierwotnej wersji treści.

Co więcej, rozwiązywanie problemów związanych z kanibalizmem słów kluczowych – gdy wiele stron kierowanych jest na te same słowa kluczowe – zapewnia wyszukiwarkom jasne sygnały dotyczące tego, na czym skupia się każda strona. Ta przejrzystość pomaga w skutecznym indeksowaniu i rankingu, ponieważ wyszukiwarki mogą zrozumieć dokładny cel wszystkich Twoich stron.

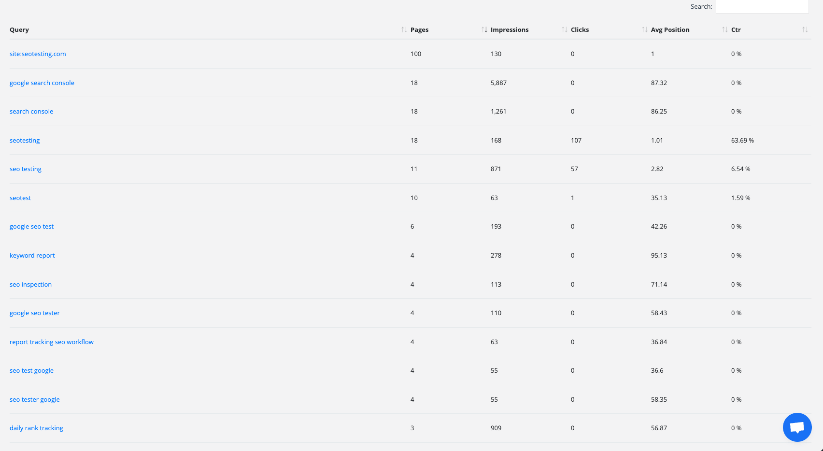

Obraz przedstawiający raport kanibalizacji słów kluczowych w ramach testów SEO. Ten raport może pomóc Ci szybko zidentyfikować i naprawić wszelkie problemy z kanibalizmem słów kluczowych w Twojej witrynie.

Optymalizacja metadanych (takich jak tagi tytułowe i metaopisy), a także dostosowywanie wewnętrznych struktur linków również pomoże w szybkim i łatwym indeksowaniu. Te działania, jeśli zostaną wykonane prawidłowo, kierują wyszukiwarki do najbardziej odpowiednich i najważniejszych stron.

Dodatkowo konsolidacja treści i unikanie kanibalizacji słów kluczowych skupi autorytet treści na jednej stronie. Spowoduje to wyższy autorytet strony, zachęcając wyszukiwarki do nadania priorytetu i umieszczenia tej wiarygodnej strony w bardziej widocznym miejscu w SERP.

Przekierowania audytowe

Sprawdzenie, jak działają przekierowania w Twojej witrynie, może pomóc poprawić szybkość indeksowania treści przez wyszukiwarki. Może również pomóc w ogólnej poprawie wydajności Twojej witryny. Przekierowania działają jak rynki, kierując w razie potrzeby zarówno użytkowników, jak i wyszukiwarki na różne strony. Jeśli nie będą dobrze zarządzane, mogą spowolnić proces indeksacji lub całkowicie uniemożliwić indeksowanie stron. Wykonując „audyt przekierowań”, możesz ulepszyć indeksowanie na kilka znaczących sposobów.

Po pierwsze, zajęcie się nadmiernymi przekierowaniami pomoże wyszukiwarkom efektywniej indeksować Twoją witrynę. Czasami mogą one napotkać wiele przekierowań, co może spowolnić indeksowanie Twojej treści. Znajdując i usuwając niepotrzebne przekierowania, możesz pomóc wyszukiwarkom w szybkim dostępie do Twoich treści, zwiększając ich szansę na szybsze indeksowanie (a tym samym ranking).

Ukończenie audytu przekierowań pozwoli Ci również uporać się z częstym problemem technicznym związanym z SEO. Łańcuchy przekierowań. Takie łańcuchy mogą mieć miejsce, gdy jedno przekierowanie prowadzi do drugiego, które prowadzi do kolejnego, a to prowadzi do kolejnego i tak dalej. Mogą dezorientować wyszukiwarki i pochłaniać zbyt dużo ich czasu. Wiemy, że jeśli bot wyszukiwarki będzie zbyt długo próbował zaindeksować stronę, przejdzie dalej i nie zaindeksuje tej strony. Audyt pozwoli Ci znaleźć i naprawić te łańcuchy, umożliwiając wyszukiwarkom bezproblemowe dotarcie do Twoich treści.

Wreszcie taki audyt pomoże wyszukiwarkom dokładnie zrozumieć Twoją witrynę. Jeśli przekierowania są dobrze zorganizowane, wyszukiwarki mogą lepiej zinterpretować znaczenie Twoich treści. Gdy wyszukiwarki lepiej zrozumieją znaczenie treści, Twoje ważne strony będą miały większą szansę na szybkie zaindeksowanie.

Napraw błędy HTTP i HTTPS

Naprawienie błędów HTTP i HTTPS jest niezbędne do zapewnienia prawidłowego indeksowania stron. Gdy boty wyszukiwarek napotykają tego typu błędy, mają trudności z dostępem do treści i zrozumieniem ich. Jeśli bot wyszukiwarki nie może uzyskać dostępu do Twojej treści ani jej zrozumieć, nie może jej zaindeksować.

Rozwiązanie tych problemów usprawnia indeksowanie w następujący sposób:

Po pierwsze, rozwiązanie błędów HTTP, takich jak „404 Not Found”, gwarantuje, że Twoje strony będą dostępne zarówno dla użytkowników, jak i wyszukiwarek. Gdy strony zwrócą te błędy, wyszukiwarki zinterpretują je jako brakującą treść, co doprowadzi do wykluczenia z wyników wyszukiwania. Naprawienie tych błędów zapewnia robotom „jasną ścieżkę” indeksowania Twoich treści, zwiększając szanse na ich zaindeksowanie i ranking.

Po drugie, przejście z HTTP na HTTPS ma kluczowe znaczenie dla bezpieczeństwa i indeksowania. W swoich algorytmach rankingowych wyszukiwarki w dużym stopniu traktują bezpieczne witryny internetowe (HTTPS) w stosunku do witryn niezabezpieczonych (HTTP). Google nawet to potwierdziło! Migrując do protokołu HTTPS i zapewniając użytkownikom bezpieczne przeglądanie, zwiększasz wiarygodność swojej witryny, pośrednio poprawiając jej zdolność do indeksowania i klasyfikowania.

Wreszcie, konsekwentna implementacja protokołu HTTPS i rozwiązywanie błędów związanych z protokołem HTTPS zapobiega napotykaniu przez użytkowników i wyszukiwarki problemów z „mieszaną treścią”. Mieszana treść ma miejsce, gdy na tej samej stronie ładowane są elementy bezpieczne i niezabezpieczone. Może to potencjalnie spowodować wyświetlenie ostrzeżeń dotyczących bezpieczeństwa i negatywnie wpłynąć na wygodę użytkownika.

Zasadniczo zajęcie się błędami HTTP i HTTPS usuwa bariery utrudniające wyszukiwarkom dostęp do treści i zrozumienie ich. To wysoce proaktywne podejście optymalizuje proces indeksowania, zwiększa widoczność w wynikach wyszukiwania i poprawia komfort użytkowania Twojej witryny.

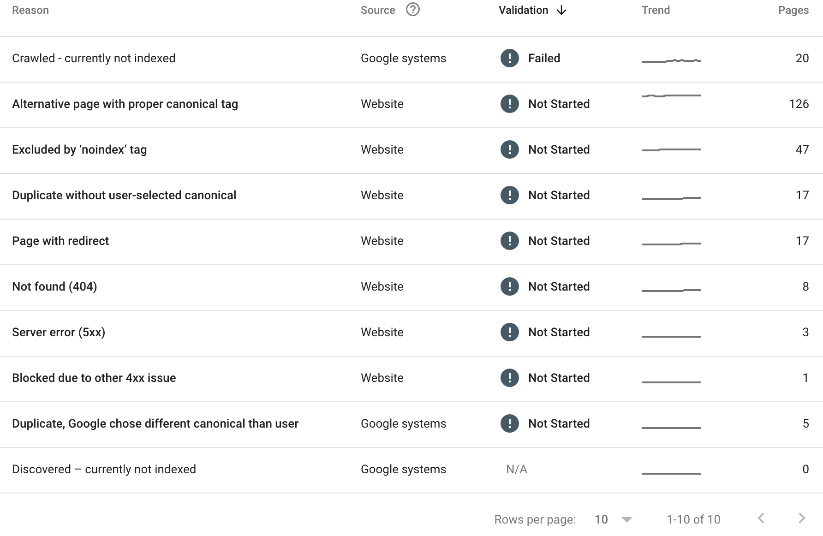

Sprawdź swój „Raport indeksowania strony” w Google Search Console

Google Search Console to kopalnia złota pozwalająca ocenić sposób indeksowania treści. W raporcie indeksowania stron będziesz mógł zobaczyć każdą stronę w Twojej witrynie, która nie została zaindeksowana. Będziesz także mógł zobaczyć powód, dla którego strona nie została zaindeksowana.

Oto przykład:

Z powyższego (Raport indeksowania stron SEOTesting) widzimy, że:

- Przeszukano 20 stron, ale obecnie nie są one indeksowane.

- 126 stron ma odpowiedni znacznik kanoniczny.

- 47 stron zostało wykluczonych tagiem „noindex”.

- Stwierdzono, że 17 stron to duplikaty, bez żadnej strony kanonicznej wybranej przez użytkownika.

- 17 stron ma włączone przekierowanie.

- 8 stron zwróciło błąd 404.

- 3 strony zwróciły błąd serwera 5xx.

- 1 strona została zablokowana z powodu innego problemu z 4xx.

- Znaleziono 5 stron jako duplikaty, a Google wybrał inną stronę kanoniczną.

Nie wszystkie z powyższych przyczyn stanowią problemy, ale warto dla nas, jako zespołu marketingowego, dowiedzieć się, dlaczego niektóre strony nie zostały zaindeksowane, i naprawić jak najwięcej z tych problemów.

Zaszeregowanie

Ranking wyszukiwarek jest zwieńczeniem procesów przeszukiwania, renderowania i indeksowania, podczas których wyszukiwarki ustalają kolejność, w jakiej strony internetowe pojawiają się w SERPach. Celem jest prezentowanie użytkownikom najbardziej odpowiednich i wartościowych treści na podstawie ich zapytań.

W swej istocie ranking opiera się na złożonych algorytmach, które oceniają różne czynniki w celu określenia trafności i autorytetu strony internetowej. Jednym z podstawowych aspektów jest trafność słów kluczowych – stopień dopasowania treści do słów i wyrażeń wpisywanych przez użytkowników podczas wyszukiwania. Strony z dużą trafnością słów kluczowych mają tendencję do lepszej pozycji w rankingu.

Jednak samo trafność słów kluczowych nie wystarczy. Wyszukiwarki biorą również pod uwagę jakość i autorytet strony internetowej. Linki zwrotne z renomowanych, wiarygodnych i odpowiednich (jest to niezwykle istotne) witryn są silnym wskaźnikiem wiarygodności strony. Im więcej wysokiej jakości linków zwrotnych znajduje się na stronie, tym większe jest prawdopodobieństwo, że zajmie ona wyższą pozycję w rankingu.

Doświadczenie użytkowników w Twojej witrynie również odgrywa ogromną rolę w rankingu. Strony, które ładują się szybko, są przyjazne dla urządzeń mobilnych i zapewniają użytkownikowi płynne przeglądanie, są bardzo preferowane przez wyszukiwarki. Angażujące i wartościowe treści, które zatrzymują użytkowników na Twojej stronie i przeglądają ją na dłużej, są także sygnałem dla wyszukiwarek, że Twoja witryna może być warta wyższej pozycji w rankingu.

Personalizacja to kolejny aspekt rankingu. Wyszukiwarki wezmą pod uwagę lokalizację użytkownika, historię wyszukiwania i preferencje, aby dostosować wyniki wyszukiwania i zapewnić użytkownikowi najlepsze możliwe doświadczenia. Oznacza to, że to samo zapytanie najprawdopodobniej da różne wyniki różnym użytkownikom.

Należy pamiętać, że niezależnie od tego, o czym wspominają inne wpisy na blogu, nie wiemy, jaką wagę Google (i inne wyszukiwarki) przypisuje różnym czynnikom w przypadku różnych zapytań. W przypadku jednego pytania być może będziesz musiał w większym stopniu polegać na wiarygodnych i odpowiednich linkach zwrotnych. Po drugie, może być konieczne zapewnienie odpowiedniego komfortu użytkowania. Wszystko sprowadza się do czasu spędzonego w branży, nauki algorytmu i ulepszania go w miarę upływu czasu.

Zrozumienie różnorodnych aspektów SEO jest niezbędne do osiągnięcia sukcesu w SERP. W tym artykule omówiono znaczenie technicznego SEO, cechy zoptymalizowanych witryn i mechanikę technicznego SEO od indeksowania do rankingu.

Techniczne SEO buduje silną bazę dla Twojej witryny, optymalizując elementy pod kątem lepszej szybkości i struktury. Poprawia to nawigację, zrozumienie treści i wygodę użytkownika.

Krótko mówiąc, techniczne SEO jest kluczowe. Naprawiając błędy i optymalizując strukturę witryny, będziesz w stanie zwiększyć swoją obecność w Internecie.

Chcesz usprawnić korzystanie z Google Search Console i przenieść swoje SEO na wyższy poziom, wdrażając testy SEO do swojej rutyny? Wypróbuj SEOTestowanie. Obecnie prowadzimy 14-dniowy bezpłatny okres próbny, do rejestracji nie jest wymagana karta kredytowa. Wypróbuj to narzędzie już dziś i daj nam znać, co myślisz!