Prawdziwy koszt budowy własnego robota sieciowego

Opublikowany: 2023-08-09Web scraping stał się najpopularniejszym sposobem agregowania danych z wielu źródeł i uzyskiwania ważnych informacji z Internetu. Ten proces jest wykorzystywany do tworzenia opartych na danych rozwiązań do wszystkiego, od dopasowywania cen w witrynach handlu elektronicznego po podejmowanie decyzji na giełdzie. Wraz ze wzrostem zapotrzebowania na skrobanie danych z sieci, narzędzia i usługi, które mogą ułatwić skrobanie sieci, również zalały Internet. Jednak wszystkie należą do jednej z 3 podkategorii-

- Stworzenie własnego narzędzia do zbierania danych z sieci przy użyciu bibliotek takich jak BeautifulSoup w Pythonie i wdrożenie go w usłudze w chmurze, takiej jak AWS.

- Korzystanie z półautomatycznego oprogramowania do skrobania, którego można użyć do chwytania części ekranu. Wstępna konfiguracja wymaga pewnej interwencji człowieka, ale powtarzające się zadania można zautomatyzować. Jednak stopień automatyzacji jest ograniczony, zespół produktowy lub biznesowy może napotkać stromą krzywą uczenia się korzystania z narzędzia, a nie wszystkie strony internetowe można zeskrobać za pomocą tych narzędzi. Dodatkowe trudności napotkasz w obsłudze stron internetowych, które generują dynamiczną zawartość przy użyciu technologii takiej jak javascript.

- Dostawcy DaaS, tacy jak PromptCloud, zapewniają niestandardowe źródło danych oparte na witrynach internetowych i punktach danych, które przesyłasz jako wymagania. Usługi te zazwyczaj obciążają Cię na podstawie ilości zużywanych danych – więc Twój miesięczny rachunek opiera się tylko na ilości zeskrobanych danych i byłby odpowiedni dla firm każdej wielkości.

Teraz wiele firm może sobie wyobrazić, że koszt związany z punktami b lub c jest zbyt wysoki i zdecydować się na samodzielne zbudowanie robota indeksującego. Dlaczego nie? Wystarczy wygooglować „Jak zbudować robota sieciowego?” dałoby ci 100 wyników. Kilka z nich może nawet działać w twoim przypadku użycia. Ale jaki jest prawdziwy koszt zbudowania robota sieciowego klasy korporacyjnej, wdrożenia go w chmurze oraz utrzymania i aktualizacji w miarę upływu czasu? Dowiedzmy Się.

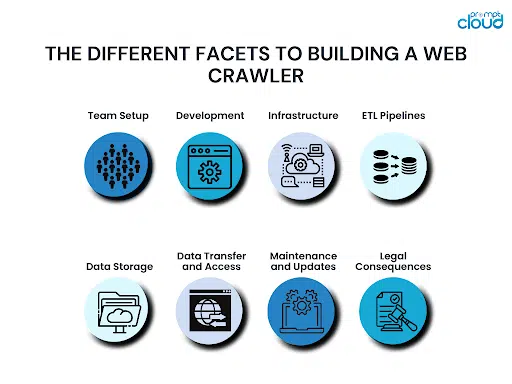

Różne aspekty budowania robota sieciowego

Tworząc robota sieciowego, należy pamiętać o różnych aspektach. Jeśli nie uwzględnisz wszystkich tych czynników, możesz odgryźć więcej, niż możesz przeżuć. To skończyłoby się zbyt dużym kosztem, nawet zanim dotarłbyś do mety, a wtedy utknąłbyś między kontynuacją lub rezygnacją z tego.

Konfiguracja zespołu:

Główne wymagania dotyczące budowania robota indeksującego to wiedza programistyczna i wcześniejsze doświadczenie w budowaniu robota indeksującego. Nawet jeśli masz zespół techniczny, może brakować kogoś z wcześniejszą wiedzą, aby poprowadzić stado. Bez kogoś z doświadczeniem możesz popełnić krytyczne błędy i nie zdawać sobie z nich sprawy, dopóki nie będzie za późno.

Rozwój:

Gdy zespół jest już gotowy, musi zabrać się za opracowanie robota indeksującego. Ten robot indeksujący powinien być w stanie zaindeksować wszystkie wymagane punkty danych ze wszystkich witryn na Twojej liście. W związku z tym nie tylko zbudowanie robota zajmie dużo czasu, ale także przetestowanie przypadków brzegowych i upewnienie się, że nie zepsuje się w żadnym momencie. W zależności od tego, jak duży i doświadczony jest Twój zespół, zbudowanie nowego robota internetowego od podstaw może zająć od kilku miesięcy do kilku kwartałów.

Infrastruktura:

Zbudowanie idealnego robota sieciowego jest trudne. Jeszcze trudniej jest zdecydować się na infrastrukturę chmurową o wysokim czasie działania, która będzie również zoptymalizowana pod kątem kosztów. Twoja infrastruktura infra będzie również musiała być skalowalna, tak aby można ją było skalować w miarę rozwoju firmy i kiedy trzeba będzie zbierać dane z większej liczby źródeł.

Potoki ETL:

Skrobanie potrzebnych punktów danych z wybranych stron internetowych może nie wystarczyć. Zwykle dane muszą również zostać znormalizowane, sformatowane, oczyszczone i posortowane przed zapisaniem na nośniku pamięci. Wszystko to wymagałoby większej mocy obliczeniowej. Ponieważ te potoki powodowałyby opóźnienia w przepływie danych, niezbędne byłoby uzyskanie odpowiedniej infrastruktury do skonfigurowania potoków ETL w chmurze.

Przechowywanie danych:

Gdy dane zostaną zeskrobane, wyczyszczone i gotowe, musisz umieścić je na odpowiednim nośniku pamięci. Może to być baza danych SQL lub NoSQL. Może to być również rozwiązanie do przechowywania danych, takie jak Redshift. Wybór bazy danych zależy od tego, ile danych chcesz przechowywać, jak często chcesz aktualizować lub pobierać dane, czy liczba kolumn może się zmienić w przyszłości i nie tylko. Podobnie jak pozostałe zasoby, baza danych również musi być hostowana w chmurze, więc należy również wziąć pod uwagę cenę.

Transfer i dostęp do danych:

Teraz, gdy zeskrobałeś dane i zapisałeś je w bazie danych, możesz chcieć je pobierać w określonych odstępach czasu lub nawet w sposób ciągły. Możesz tworzyć interfejsy API REST, aby zapewnić światu zewnętrznemu dostęp do swoich danych. Tworzenie i utrzymywanie warstwy dostępu do danych zajęłoby dużo czasu, a opłaty będą naliczane na podstawie ilości przesyłanych danych.

Konserwacja i aktualizacje:

Robot indeksujący nigdy nie jest ostateczny. To tylko wersja. Nowsza wersja musi zostać zbudowana, gdy tylko strona internetowa, z której pobiera dane, zostanie zmodyfikowana lub zaktualizowana. Dodanie złożonych stron internetowych do listy stron do zeskrobania może również wymagać aktualizacji twojego robota. Regularna konserwacja i monitorowanie zasobów w chmurze jest również niezbędna, aby zapewnić, że w systemie nie pojawiają się błędy, a zasoby obliczeniowe w chmurze są w dobrym stanie.

Konsekwencje prawne:

Podczas zbierania danych z sieci musisz przestrzegać pewnych praw obowiązujących w kraju. Byłyby to przepisy dotyczące ochrony danych obowiązujące w kraju, w którym prowadzisz działalność, a także przepisy krajów, których dane usuwasz. Wszelkie błędy mogą oznaczać kosztowne procesy sądowe. Czasami wypłaty, ugody lub opłaty prawne są wystarczająco dobre, aby pogrążyć firmę.

Lepsze rozwiązanie do skrobania stron internetowych klasy korporacyjnej

Największym kosztem, jaki płacisz za zbudowanie własnego rozwiązania do skrobania stron internetowych, nie są nawet pieniądze. Już czas — Twoja firma musi poczekać, aż rozwiązanie zacznie działać, doda nowe źródła i nie tylko. Zamiast tego rozsądnym wyborem byłoby w pełni funkcjonalne rozwiązanie DaaS, które zapewnia czyste, gotowe do użycia dane i łatwe opcje integracji. Właśnie dlatego nasz zespół w PromptCloud zapewnia naszym użytkownikom w pełni zarządzane rozwiązania do skrobania stron internetowych hostowane w chmurze.

Możesz zacząć korzystać z danych z dowolnego miejsca w sieci w zaledwie 3-etapowym procesie, w którym podajesz nam listę stron internetowych i punktów danych, sprawdzasz wyniki robota demonstracyjnego, a następnie przechodzisz do ostatecznej integracji. Ponieważ jest to rozwiązanie oparte na chmurze, pobieramy opłaty tylko na podstawie ilości zużywanych danych – dzięki temu rozwiązanie jest dostępne dla firm każdej wielkości. Wykonanie szczegółowej kalkulacji pokaże, jak faktycznie oszczędzasz pieniądze, wybierając zarządzane rozwiązanie DaaS, a nie budując własnego robota indeksującego.

Aby uzyskać więcej informacji, skontaktuj się z naszym zespołem sprzedaży pod adresem [email protected]