Techniki skrobania stron internetowych 2023 — kompletny przewodnik

Opublikowany: 2023-07-06W rozległym świecie internetowych poszukiwań skarbów, web scraping stał się najlepszym narzędziem do wydobywania cennych klejnotów informacji. Niezależnie od tego, czy jesteś samotnym poszukiwaczem przygód, czy przedsiębiorcą żądnym danych, przeglądanie stron internetowych to niezawodny kilof w Twoim cyfrowym zestawie narzędzi.

Jednak nie wszystkie techniki web scrapingu są sobie równe. To jak wybór idealnej wędki do danego zadania. W końcu nie wziąłbyś małego haczyka, aby złapać tak kolosalne stworzenie, jak Moby Dick, prawda? Na tym blogu ujawnimy sekrety ręcznych, automatycznych i zaawansowanych technik skrobania sieci.

Wyobraź sobie, że tworzysz drużynę superbohaterów, z których każdy ma swoje specjalne moce i słabości. Podobnie każde podejście do skrobania ma swoje mocne strony i ograniczenia.

Ale nie zapominajmy o znaczeniu odpowiedzialnych działań w web scrapingu. Tak jak rycerz nigdy nie złamałby przysięgi, tak samo kluczowe jest etyczne skrobanie i przestrzeganie warunków korzystania ze stron internetowych, które chcesz zeskrobać.

Zautomatyzowane techniki skrobania sieci

Zautomatyzowane skrobanie stron internetowych odnosi się do procesu korzystania z oprogramowania lub narzędzi do automatycznego wyodrębniania danych ze stron internetowych. To zautomatyzowane podejście eliminuje potrzebę ręcznego kopiowania i wklejania danych, umożliwiając efektywne zbieranie danych na dużą skalę z różnych źródeł online.

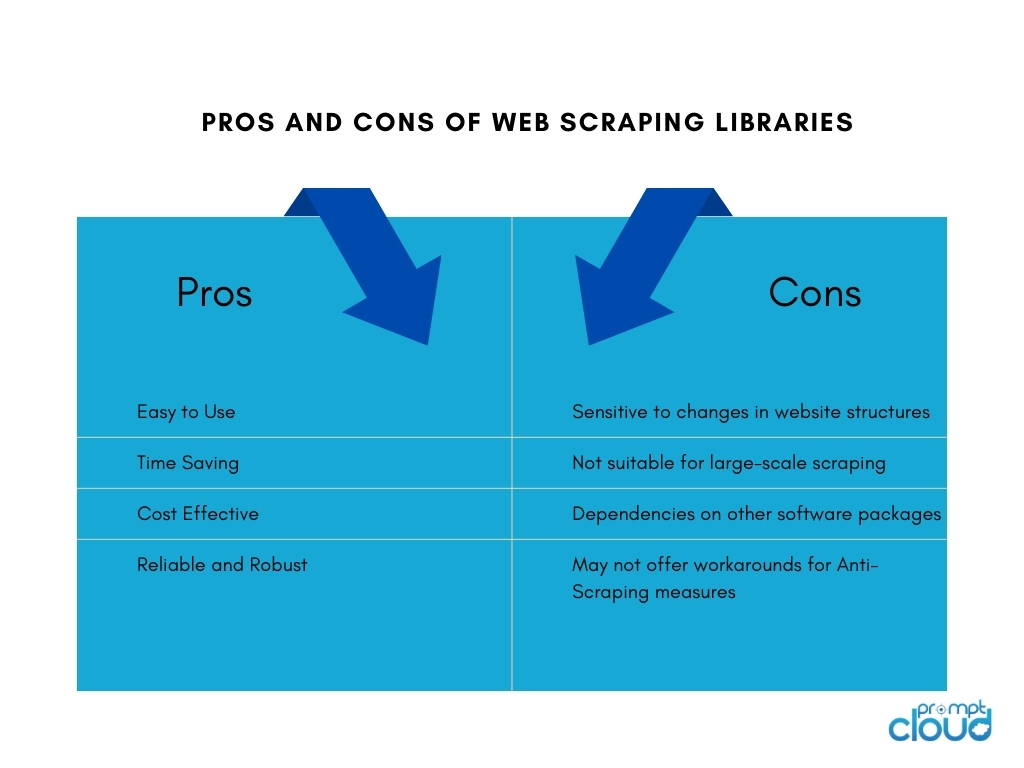

1. Biblioteki do skrobania sieci

Biblioteki skrobania stron internetowych to narzędzia programowe lub struktury, które zapewniają gotowe funkcje i narzędzia ułatwiające zadania skrobania stron internetowych. Oferują uproszczony i wydajny sposób na wykonanie web scrapingu bez konieczności pisania wszystkiego od zera. Oszczędzają czas, zwiększają produktywność i umożliwiają wydajniejsze gromadzenie danych z różnych źródeł online.

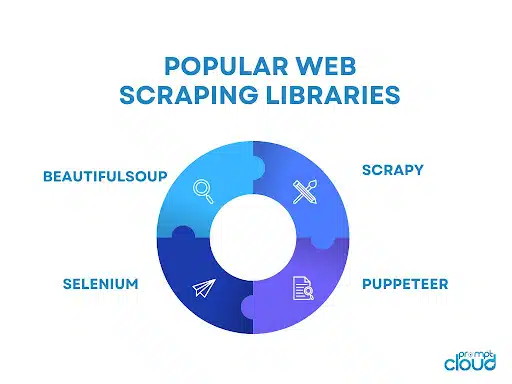

Niektóre z popularnych bibliotek do skrobania stron internetowych obejmują:

- BeautifulSoup: powszechnie używana biblioteka Pythona do przeglądania stron internetowych, która zapewnia intuicyjny interfejs API do analizowania dokumentów HTML i XML, umożliwiając użytkownikom bezproblemową nawigację i wyodrębnianie danych.

- Scrapy: potężna platforma Pythona do skrobania stron internetowych, która zapewnia kompleksowy zestaw narzędzi do budowania skalowalnych i wydajnych robotów indeksujących, z funkcjami takimi jak automatyczne ograniczanie żądań, potoki elementów i wbudowana obsługa stronicowania.

- Selenium: wszechstronna biblioteka, która umożliwia zautomatyzowane interakcje przeglądarki w celu przeglądania stron internetowych, szczególnie przydatna w przypadku dynamicznych treści i stron internetowych zawierających dużo JavaScript.

- Puppeteer: biblioteka Node.js, która zapewnia interfejs API wysokiego poziomu do kontrolowania bezgłowej przeglądarki Chrome lub Chromium, umożliwiając przeglądanie stron internetowych i interakcję ze stronami internetowymi za pomocą JavaScript.

2. Narzędzia i usługi do skrobania stron internetowych

Narzędzia do skrobania sieci

Narzędzia do skrobania stron internetowych to aplikacje lub platformy zaprojektowane specjalnie do automatyzacji i uproszczenia procesu skrobania stron internetowych. Narzędzia te często zapewniają przyjazny dla użytkownika interfejs, który pozwala użytkownikom określić dane, które chcą wyodrębnić ze stron internetowych, bez konieczności posiadania rozległej wiedzy programistycznej.

Zwykle oferują takie funkcje, jak wybieranie elementów danych metodą „wskaż i kliknij”, możliwości planowania i monitorowania oraz opcje eksportu danych. Narzędzia do skrobania stron internetowych mogą być korzystne dla osób lub firm, które wymagają ekstrakcji danych bez potrzeby posiadania rozległego kodu lub zasobów programistycznych.

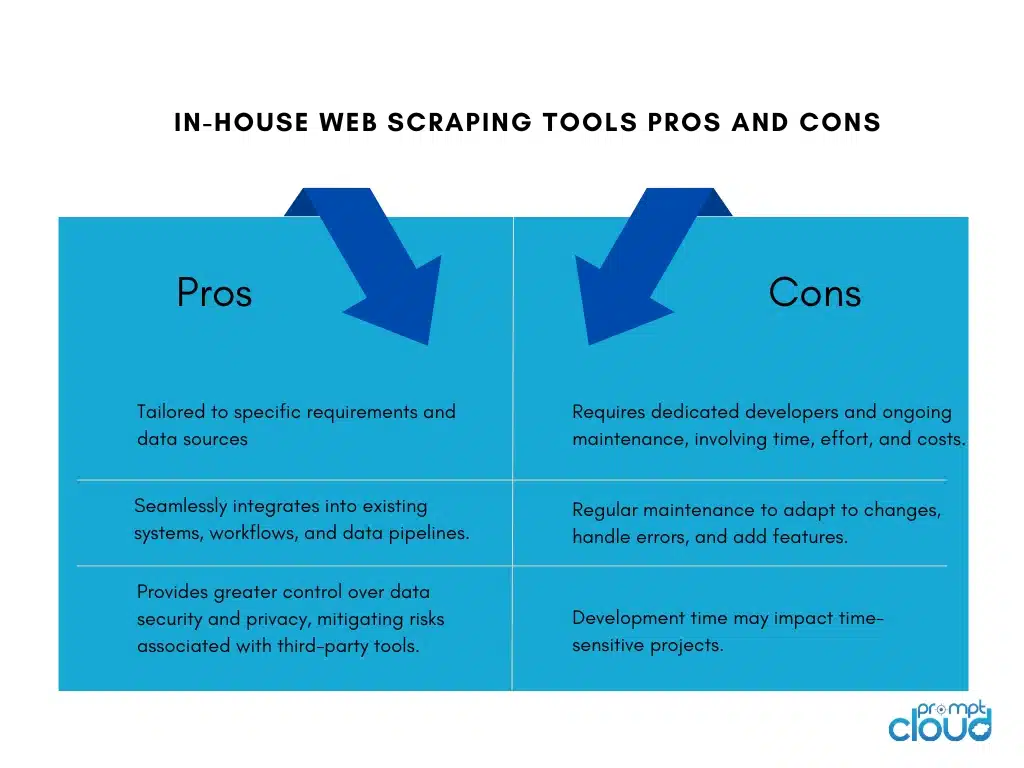

Tworzenie wewnętrznych narzędzi do skrobania stron internetowych

Zbudowanie wewnętrznego narzędzia do skrobania stron internetowych dla firmy ma swoje zalety i wady:

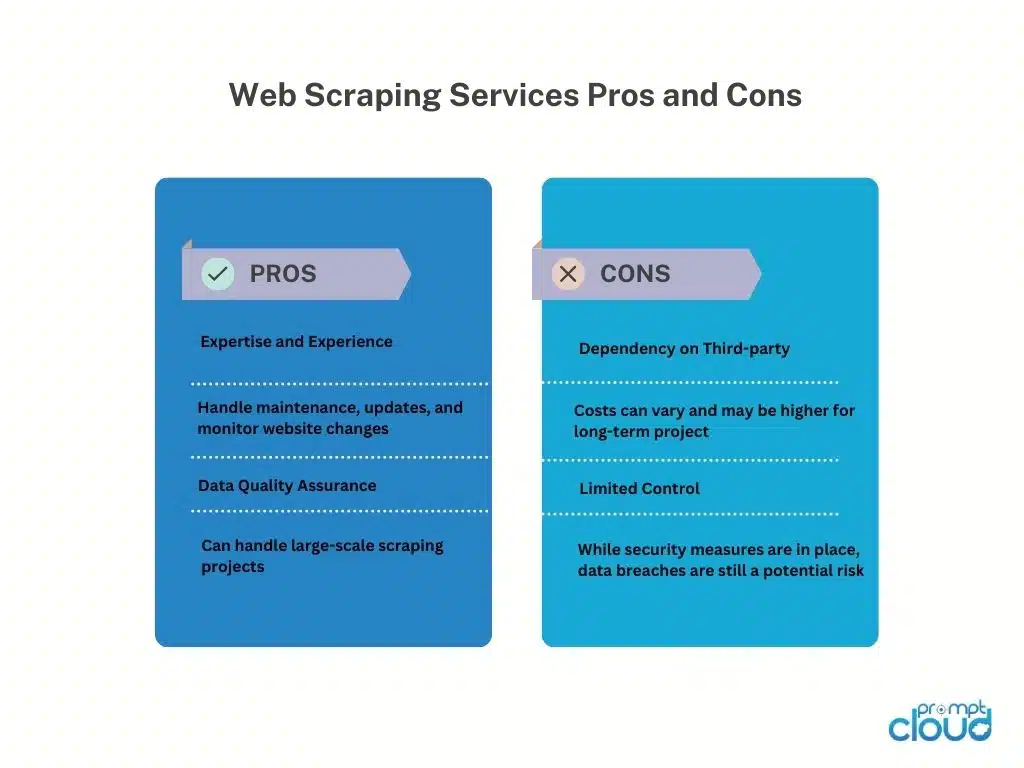

Usługi skrobania stron internetowych

Dostawcy usług Web Scraping oferują wyspecjalizowane usługi ekstrakcji danych ze stron internetowych. Dostawcy ci zazwyczaj dysponują infrastrukturą, narzędziami i wiedzą specjalistyczną przeznaczoną do obsługi zadań związanych z przeglądaniem stron internetowych w imieniu klientów.

Oto zalety i wady korzystania z dostawców usług web scrapingu:

Interfejsy API do skrobania stron internetowych

Web scraping API zapewnia programistyczny interfejs, który umożliwia programistom dostęp i pobieranie danych ze stron internetowych przy użyciu standardowych metod. Te interfejsy API oferują bardziej ustrukturyzowane i kontrolowane podejście do skrobania sieci w porównaniu z tradycyjnymi technikami skrobania. Deweloperzy mogą wysyłać żądania do API, określając potrzebne dane i otrzymując zebrane dane w ustrukturyzowanym formacie, takim jak JSON lub XML.

Zalety

Interfejsy API skrobania sieci upraszczają proces skrobania, umożliwiając programistom skupienie się na integracji interfejsu API i obsłudze danych. Oferują niezawodność i wydajność dzięki konserwacji dostawcy i mogą obejmować funkcje, takie jak uwierzytelnianie i ograniczanie szybkości. Interfejsy API pomagają również zachować zgodność z warunkami świadczenia usług i wymogami prawnymi.

Cons

Korzystanie z interfejsów API skrobania sieci ma ograniczenia. Dostępność i możliwości danych zależą od dostawcy interfejsu API, z możliwymi ograniczeniami dotyczącymi obsługiwanych witryn internetowych i limitów skrobania. Poleganie na zewnętrznym interfejsie API wprowadza zależność od dostępności i wydajności dostawcy, wpływając na pobieranie danych. Ponadto mogą wystąpić koszty związane z użytkowaniem na dużą skalę lub komercyjnym.

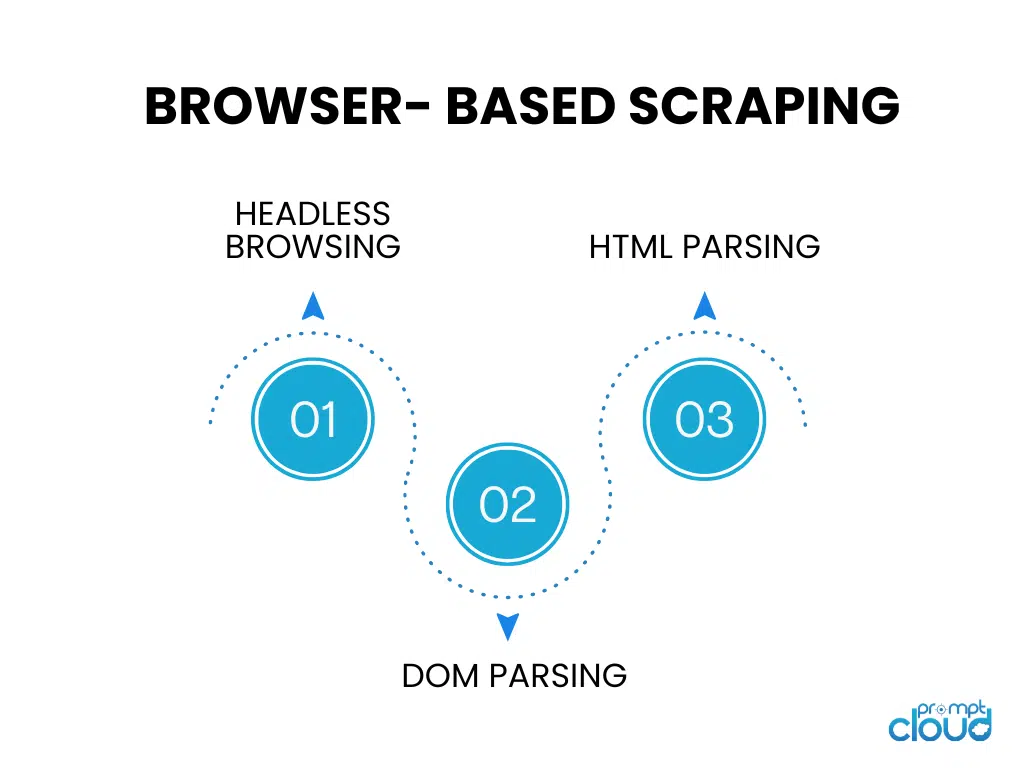

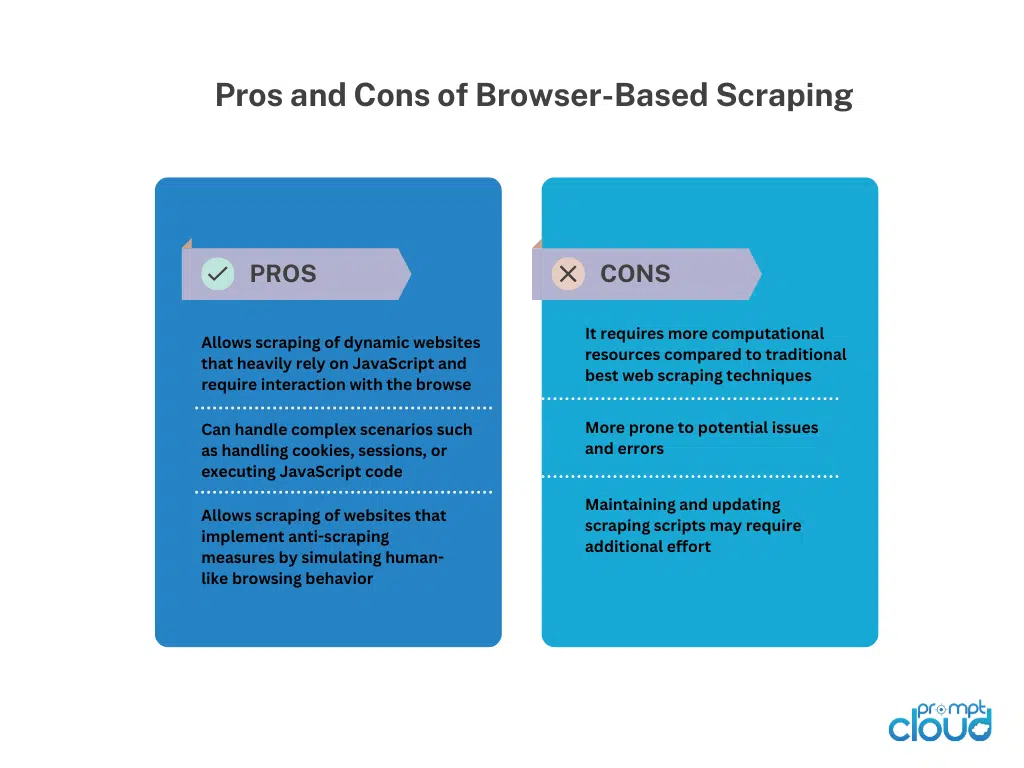

Skrobanie oparte na przeglądarce

Bezgłowe przeglądanie

Bezgłowe przeglądanie uruchamia przeglądarkę internetową bez graficznego interfejsu użytkownika, umożliwiając automatyczne przeglądanie i interakcję ze stronami internetowymi za pomocą kodu. Jest idealny do skrobania dynamicznych stron internetowych, które w dużym stopniu polegają na renderowaniu po stronie klienta.

Analiza DOM

Analiza DOM polega na manipulowaniu strukturą HTML strony internetowej poprzez dostęp do jej Document Object Model. Umożliwia to ukierunkowane wyodrębnianie elementów, atrybutów lub tekstu programowo.

Analiza HTML

Analiza składni HTML analizuje kod źródłowy HTML strony internetowej w celu wyodrębnienia żądanych danych. Wykorzystuje biblioteki lub parsery do interpretacji struktury HTML i identyfikowania określonych tagów, atrybutów lub wzorców do ekstrakcji danych. Analiza składni HTML jest powszechnie używana do zeskrobywania statycznych stron internetowych bez wykonywania JavaScript.

Ręczne techniki skrobania sieci

Ręczne techniki skrobania sieci

Ręczne web scraping odnosi się do procesu ręcznego wydobywania danych ze stron internetowych, bez użycia zautomatyzowanych narzędzi lub skryptów. Obejmuje interwencję człowieka w celu poruszania się po stronach internetowych, wyszukiwania odpowiednich informacji i wydobywania danych przy użyciu różnych technik.

Techniki ręcznego skrobania stron internetowych:

Przechwytywanie ekranu: Ta technika obejmuje przechwytywanie zrzutów ekranu lub filmów ze stron internetowych w celu wyodrębnienia danych wizualnych, takich jak obrazy, wykresy lub tabele, które są trudne do przeanalizowania programowego.Ręczna ekstrakcja z przechwyconych nośników umożliwia odzyskanie danych.

Wprowadzanie danych: Podczas wprowadzania danych wymagane informacje są ręcznie kopiowane ze stron internetowych i wprowadzane do żądanego formatu, takiego jak arkusze kalkulacyjne lub bazy danych.Obejmuje nawigację po stronach internetowych, wybieranie danych i wprowadzanie ich do docelowego miejsca docelowego. Wprowadzanie danych jest odpowiednie dla danych strukturalnych, które można łatwo kopiować i wklejać.

Ręczne skrobanie stron internetowych zapewnia elastyczność w przypadku złożonych stron internetowych, interaktywności JavaScript lub środków zapobiegających skrobaniu. Jest to jednak czasochłonne, mniej odpowiednie do zadań na dużą skalę i podatne na błędy ludzkie. Wymaga ludzkiego wysiłku, dbałości o szczegóły i starannego wykonania.

Techniki hybrydowego skrobania sieci

Hybrydowy web scraping łączy zautomatyzowane narzędzia i ręczną interwencję w celu wydajnego i dokładnego pozyskiwania danych ze stron internetowych. Zautomatyzowane narzędzia obsługują powtarzalne zadania, takie jak nawigacja i wyodrębnianie danych strukturalnych, podczas gdy techniki ręczne, takie jak przechwytywanie ekranu lub wprowadzanie danych, rozwiązują złożone scenariusze i dane wizualne/nieustrukturyzowane.

Hybrid Web Scraping oferuje skalowalność i szybkość automatyzacji, a także elastyczność ludzkiej oceny. Pasuje do stron internetowych o zróżnicowanej strukturze, dynamicznej zawartości lub środkach zapobiegających skrobaniu. Wybór zależy od złożoności strony internetowej, typu danych i dostępnych zasobów, zapewniając zrównoważone podejście do kompleksowej ekstrakcji danych.