Prevenindo o colapso do modelo de IA: abordando o risco inerente de conjuntos de dados sintéticos

Publicados: 2023-10-05A Inteligência Artificial (IA) transformou significativamente a nossa vida quotidiana, sugerindo conteúdos personalizados em plataformas de streaming e permitindo assistentes digitais em smartphones. Agora, esses avanços são possíveis graças a modelos sofisticados de IA que aprendem com grandes quantidades de dados.

De acordo com vários relatórios, o conteúdo gerado pela IA está a tornar-se cada vez mais predominante na Internet, compreendendo potencialmente até 90% da informação online nos próximos anos.

Com um tal afluxo de informações, pode-se facilmente dizer que, no mundo atual, rico em dados, a IA enfrenta um desafio único, que está a sufocar com a sua abundância de dados.

Os relatórios sugerem ainda que a quantidade significativa deste conteúdo gerado pela IA pode sobrecarregar as pessoas com informações excessivas, dificultando-lhes a determinação do que é confiável e gerado pelo homem. Além disso, existem preocupações sobre a potencial perda de empregos em áreas criativas como a arte, o jornalismo e a escrita, tudo porque a IA está a tornar-se mais capaz de produzir conteúdos tradicionalmente criados por humanos.

Chegando aos próprios sistemas de IA, existem questões emergentes como o “colapso do modelo”, que se refere a um problema em que os modelos de IA treinados em grandes conjuntos de dados produzem resultados de qualidade inferior, priorizando escolhas de palavras comuns em vez de alternativas criativas. “Transtorno de Autofagia Modelo” ou “IA de Habsburgo” é outra preocupação onde os sistemas de IA excessivamente treinados nos resultados de outros modelos de IA podem exibir características indesejáveis ou podem ter preconceitos.

Estes desafios podem prejudicar potencialmente a qualidade e a fiabilidade dos conteúdos gerados pela IA, destruindo a confiança nesses sistemas e agravando a sobrecarga de informação.

Nosso blog ajudará você a entender tudo relacionado à prevenção de colapso de modelos de IA. À medida que a revolução da IA generativa avança, ela traz desafios e incertezas significativos para o panorama da informação online. Então, vamos mergulhar de frente nos detalhes.

Compreendendo o colapso do modelo de IA

No aprendizado de máquina, “colapso do modelo” refere-se a uma situação em que o modelo de IA falha em fornecer uma variedade de resultados úteis. Em vez disso, produz um conjunto restrito de resultados repetitivos ou de baixa qualidade. Esse problema pode ocorrer em vários modelos, mas é frequentemente observado durante o treinamento de modelos complexos, como redes adversárias generativas (GANs). O colapso do modelo pode prejudicar a capacidade do modelo de gerar resultados diversos e valiosos, impactando seu desempenho geral.

Vamos ilustrar um exemplo de colapso de modelo. Imagine um estudante de arte altamente entusiasmado representando nosso modelo de IA, cuja tarefa é criar pinturas de zebras. No início, sua arte é impressionante e lembra claramente zebras. No entanto, suas pinturas perdem gradualmente a semelhança com as zebras à medida que continuam, e a qualidade diminui. Isto é semelhante ao “colapso do modelo” na aprendizagem automática, onde o modelo de IA, tal como o nosso estudante de arte, inicialmente tem um bom desempenho, mas depois luta para manter as características essenciais para as quais foi concebido.

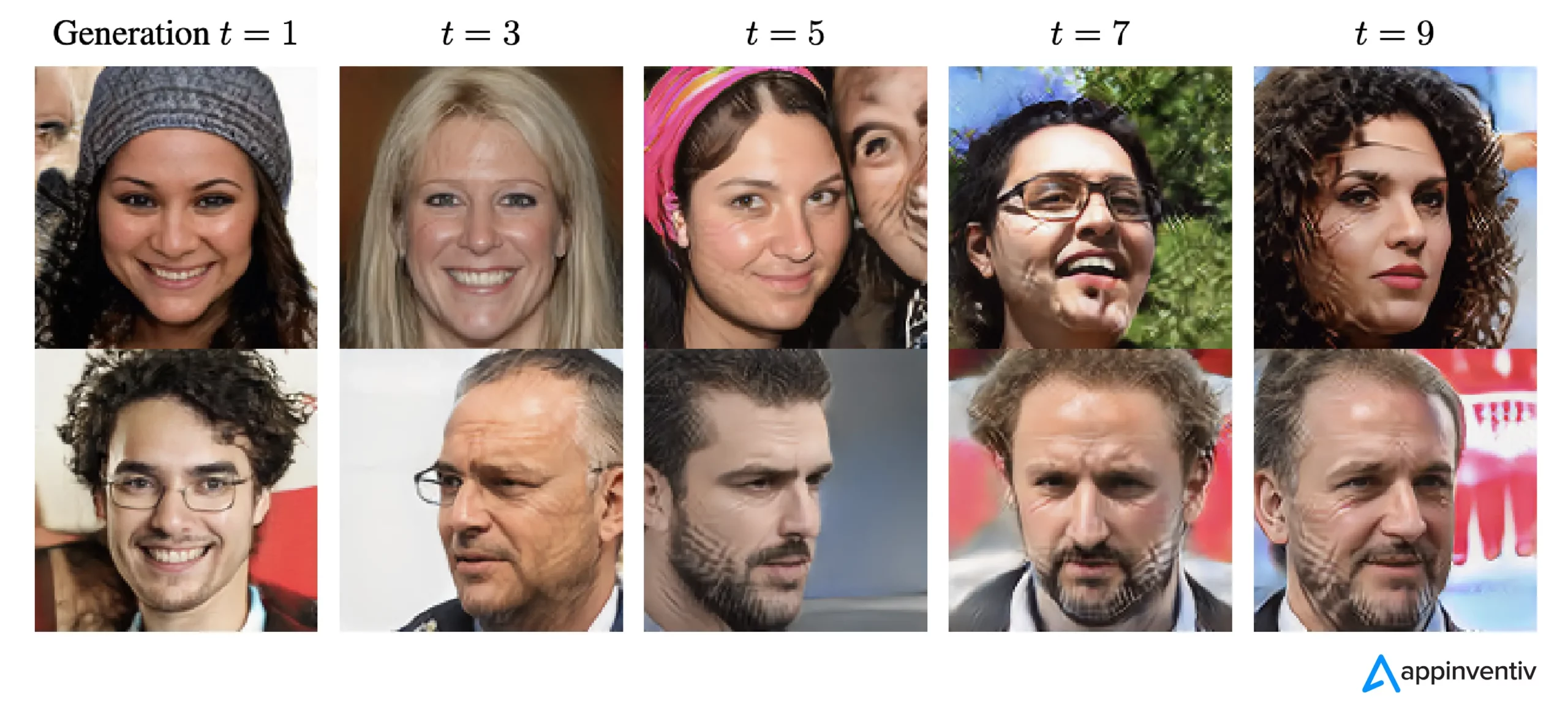

De acordo com os recentes avanços em IA, os pesquisadores ficaram muito interessados em usar dados artificiais ou sintéticos para treinar novos modelos de IA quando se trata de gerar imagens e texto. No entanto, um conceito chamado 'Transtorno Modelo de Autofagia' (MAD) compara esse processo a um ciclo autodestrutivo.

A menos que continuemos adicionando regularmente novos dados do mundo real, a qualidade e a variedade dos modelos de IA que criamos usando dados sintéticos poderão piorar com o tempo. Portanto, é essencial encontrar um equilíbrio entre dados sintéticos e reais para manter o bom desempenho dos modelos de IA.

Este equilíbrio é crucial para evitar um declínio na qualidade e diversidade dos modelos à medida que continuam a aprender. Descobrir como usar dados sintéticos de forma eficaz para a prevenção do colapso de modelos de IA é um desafio constante quando se trata da evolução da IA generativa e do uso de dados sintéticos.

De acordo com o The New Yorker, se o ChatGPT for considerado uma versão compacta da Internet, semelhante à de um arquivo JPEG compactando uma fotografia, então treinar os futuros chatbots com base nos resultados do ChatGPT é digitalmente equivalente a fazer repetidamente fotocópias de fotocópias, assim como o Velhos tempos. Simplesmente, a qualidade da imagem tende a piorar a cada iteração.

Assim, para superar este desafio, as organizações precisam de se concentrar em refinar as suas abordagens para garantir que estes produtos generativos de IA continuam a fornecer respostas precisas neste cenário digital.

[Leia também: IA responsável – Enfrentando os desafios da adoção com princípios e estratégias orientadoras]

Como acontece o colapso do modelo de IA?

O colapso do modelo ocorre quando novos modelos de IA são treinados usando dados gerados por modelos mais antigos. Estes novos modelos baseiam-se nos padrões observados nos dados gerados. O colapso do modelo está enraizado na ideia de que os modelos generativos tendem a repetir padrões que já aprenderam e há um limite para a informação que podem extrair desses padrões.

Em casos de colapso do modelo, os eventos que são prováveis de acontecer são exagerados, enquanto os eventos menos prováveis são subestimados. Ao longo de várias gerações, os eventos prováveis dominam os dados, e as partes menos comuns, mas ainda cruciais dos dados, chamadas caudas, diminuem. Essas caudas são essenciais para manter a precisão e a diversidade dos resultados do modelo. À medida que as gerações avançam, os erros dominam os dados e o modelo os interpreta cada vez mais mal.

Segundo a pesquisa, existem dois tipos de colapso do modelo: precoce e tardio. O colapso inicial do modelo envolve a perda de informações do modelo sobre eventos raros. No colapso tardio do modelo, o modelo confunde padrões distintos nos dados, resultando em resultados que têm pouca semelhança com os dados originais.

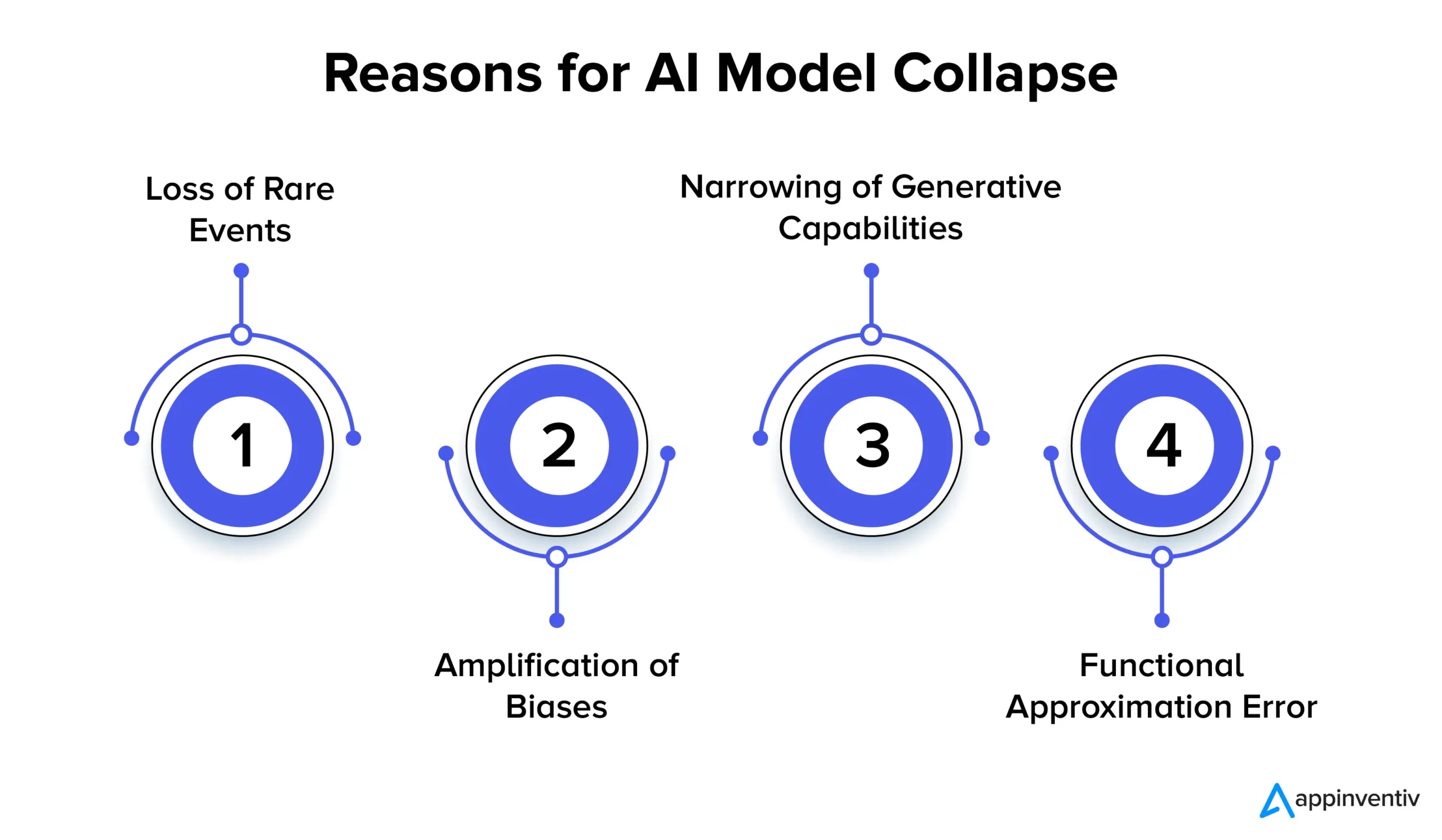

Vejamos em detalhes os vários motivos para o colapso do modelo de IA abaixo:

Perda de eventos raros

Quando os modelos de IA são repetidamente treinados em dados gerados pelas suas versões anteriores, tentam concentrar-se em padrões comuns e esquecer eventos raros. Este fenômeno é semelhante aos modelos que perdem a memória de longo prazo. Eventos raros costumam ter uma importância significativa, como a identificação de anomalias em processos de fabricação ou a detecção de transações fraudulentas. Por exemplo, quando se trata de detecção de fraudes, padrões de linguagem específicos podem sinalizar comportamento fraudulento, tornando crucial reter e aprender esses padrões raros.

Amplificação de preconceitos

Cada iteração de treinamento em dados gerados por IA pode amplificar as tendências existentes nos dados de treinamento. Como a saída do modelo geralmente reflete os dados nos quais ele foi treinado, quaisquer distorções nesses dados podem ser exageradas com o tempo. Isto pode levar à amplificação do viés em várias aplicações de IA. Por exemplo, os resultados podem levar a questões como discriminação, preconceito racial e conteúdo tendencioso nas redes sociais. Assim, a implementação de controles para detectar e mitigar preconceitos é extremamente essencial.

Estreitamento de Capacidades Gerativas

À medida que os modelos de IA continuam a aprender com os dados gerados, as suas capacidades geradoras podem diminuir. O modelo torna-se bastante influenciado pelas suas próprias interpretações da realidade, produzindo conteúdos cada vez mais semelhantes que carecem de diversidade e representação de acontecimentos raros. Isso pode levar à perda de originalidade. Por exemplo, quando se trata de Large Language Models (LLMs), a variação confere a cada escritor ou artista seu tom e estilo distintos.

A investigação sugere simplesmente que, se novos dados não forem adicionados regularmente durante o processo de formação, os futuros modelos de IA poderão acabar por se tornar menos precisos ou produzir resultados menos variados ao longo do tempo.

Erro de aproximação funcional

Um erro de aproximação funcional pode ocorrer quando os aproximadores de funções usados no modelo não são suficientemente expressivos. Embora esse erro possa ser mitigado pelo emprego de modelos mais expressivos, ele também pode introduzir ruído e levar ao sobreajuste. Encontrar o equilíbrio certo entre a expressividade do modelo e o controle de ruído é crucial para evitar esses erros.

Implicações do colapso do modelo: Por que a estabilidade do modelo de IA é importante?

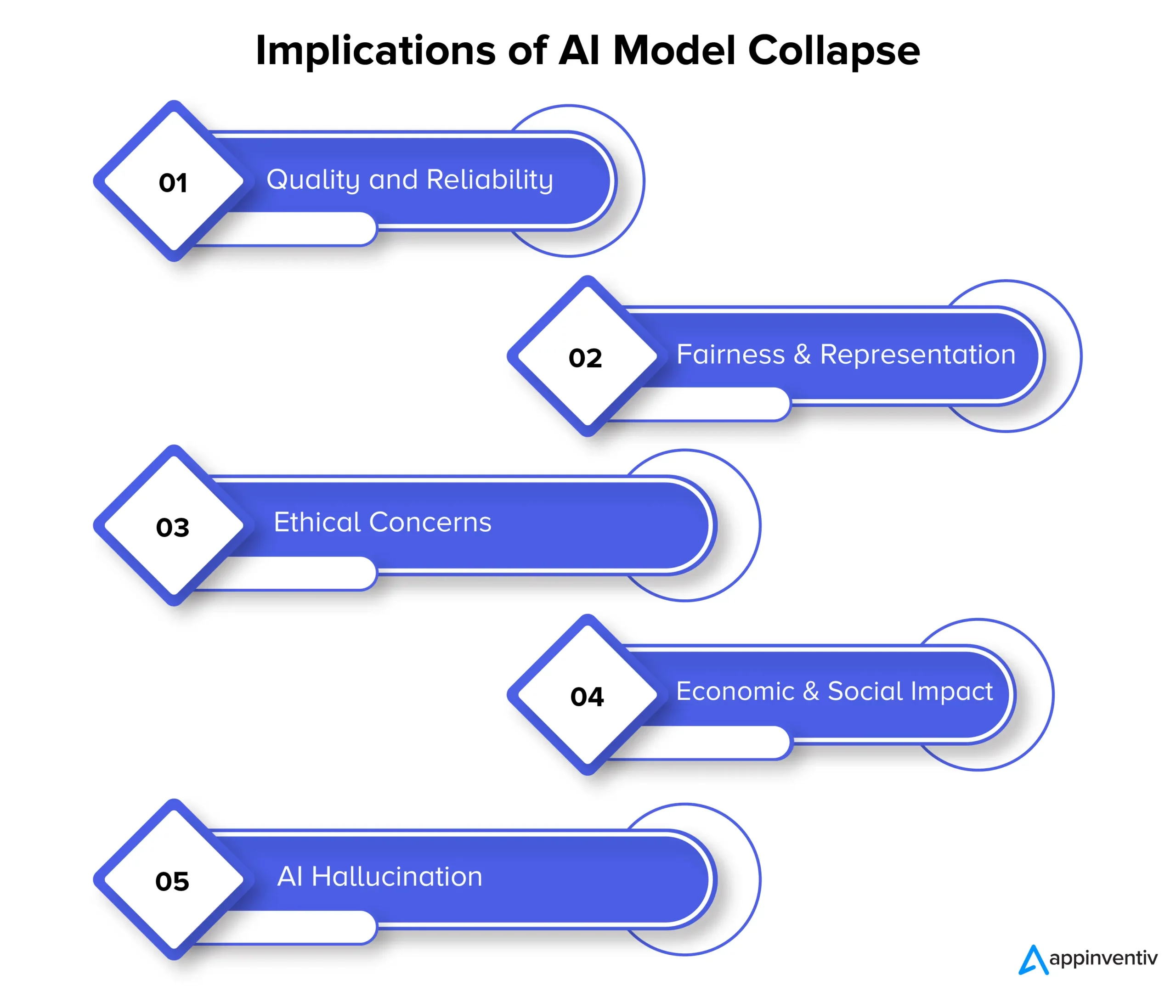

O colapso do modelo pode, em última análise, impactar a qualidade, a confiabilidade e a imparcialidade do conteúdo gerado por IA, o que pode representar ainda mais vários riscos para as organizações. Vejamos a implicação do colapso do modelo em detalhes abaixo:

Qualidade e Confiabilidade

À medida que os modelos de IA degeneram na sua aprendizagem, o conteúdo que geram torna-se menos fiável e a sua qualidade degrada-se. Isto acontece quando os modelos se distanciam da distribuição original dos dados e confiam mais nas suas próprias interpretações da realidade. Por exemplo, um modelo de IA concebido para a geração de notícias pode produzir artigos noticiosos imprecisos ou mesmo completamente fabricados.

Justiça e Representação

O colapso do modelo também é motivo de preocupação quando se trata de justiça e representação do conteúdo gerado. Quando os modelos esquecem eventos raros e limitam as suas capacidades geradoras, o conteúdo relacionado com tópicos menos comuns pode ser representado de forma inadequada. Isso leva a preconceitos, estereótipos e à exclusão de certas perspectivas.

Preocupações éticas

O colapso do modelo levanta preocupações éticas significativas, especificamente quando o conteúdo gerado pela IA tem o poder de influenciar a tomada de decisões. As consequências do colapso do modelo incluem a disseminação de conteúdos tendenciosos e imprecisos, que podem impactar significativamente a vida das pessoas, as opiniões e o acesso a oportunidades.

Impacto Económico e Social

À escala económica e social, o colapso do modelo pode influenciar a confiança e a adoção de tecnologias de IA. Se não for possível confiar no conteúdo gerado pela IA, as empresas e os consumidores poderão hesitar em adotar estas tecnologias. Isto pode ter implicações económicas e, consequentemente, a confiança nas tecnologias de IA pode prejudicar.

Alucinação de IA

A alucinação de IA ocorre quando os modelos de IA criam conteúdo imaginativo ou irreal que não se alinha com os fatos ou é coerente de alguma forma. Isso pode resultar em informações imprecisas, potencialmente causando desinformação ou confusão. É significativamente problemático em aplicações como geração de notícias, diagnóstico de condições médicas ou criação de documentos legais onde a precisão e a confiabilidade são extremamente vitais.

Vamos explicar o contexto com um exemplo de alucinação de IA. Suponha que exista um modelo de IA treinado para gerar imagens de animais. Agora, ao solicitar a foto de um animal, o modelo pode produzir a imagem de um “zebroide”, um híbrido entre uma zebra e um cavalo. Embora esta imagem possa parecer visualmente realista, é vital compreender que é apenas uma criação da imaginação do modelo de IA, uma vez que tal animal não existe no mundo real.

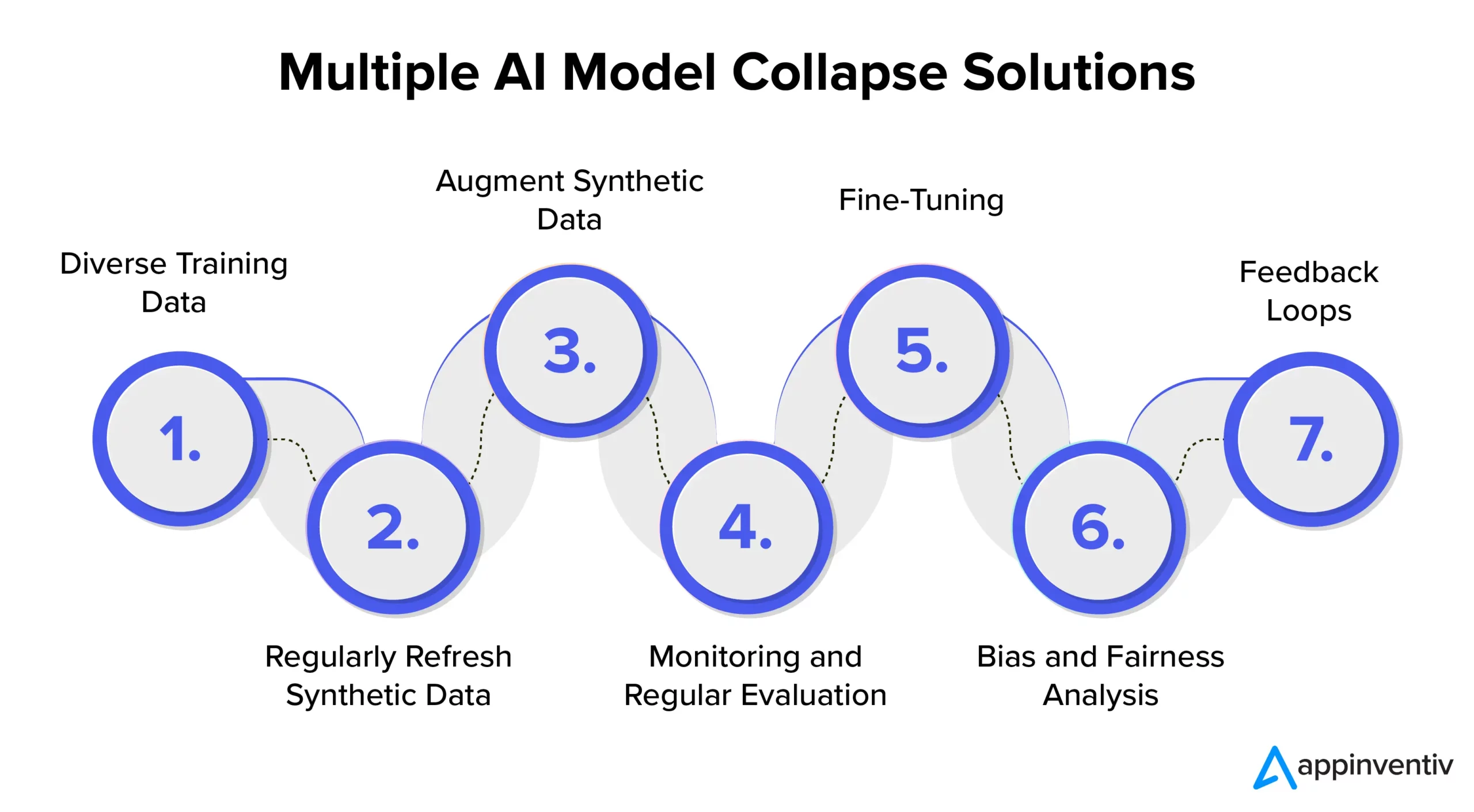

Prevenção de colapso do modelo de IA: Compreendendo as soluções de colapso do modelo de IA

Para garantir a estabilidade e fiabilidade do modelo de IA, é essencial explorar estratégias e melhores práticas para abordar eficazmente a prevenção do colapso do modelo de IA. Portanto, é recomendável fazer parceria com uma empresa dedicada ao desenvolvimento de IA, como a Appinventiv, que possa fornecer experiência e orientação na implementação dessas medidas preventivas, garantindo ao mesmo tempo que seus sistemas de IA forneçam consistentemente resultados de alta qualidade.

Dados de treinamento diversos

Para abordar eficazmente o colapso do modelo de IA e prevenir resultados indesejados, é crucial organizar um conjunto de dados de formação que inclua uma variedade de fontes e tipos de dados. Este conjunto de dados deve consistir tanto em dados sintéticos gerados pelo modelo quanto em dados do mundo real que representem com precisão as complexidades do problema. É importante atualizar regularmente este conjunto de dados com informações novas e relevantes. O modelo é exposto a uma ampla gama de padrões ao incorporar diversos dados de treinamento. Isso ajuda a prevenir a estagnação de dados.

Atualize regularmente os dados sintéticos

O colapso do modelo é um risco quando os modelos de IA dependem fortemente dos seus próprios dados gerados. Para uma mitigação eficaz dos riscos na IA, é importante introduzir regularmente dados novos, autênticos e do mundo real no pipeline de formação. Essa prática garante que o modelo permaneça adaptativo e evita ficar preso em um loop repetitivo. Isto pode ajudar a gerar resultados diversos e relevantes.

Aumente os dados sintéticos

Aprimorar dados sintéticos por meio de técnicas de aumento de dados é um método comprovado para evitar o colapso do modelo. Essas técnicas introduzem variabilidade nos dados sintéticos usando as variações naturais dos dados do mundo real. Adicionar ruído controlado aos dados gerados incentiva o modelo a aprender uma gama mais ampla de padrões, reduzindo as chances de gerar resultados repetitivos.

Monitoramento e Avaliação Regular

Monitorar e avaliar regularmente o desempenho do modelo de IA é crucial para a detecção precoce do colapso do modelo. A implementação de uma estrutura MLOps garante monitoramento e alinhamento contínuos com os objetivos de uma organização, permitindo assim intervenções e ajustes oportunos.

[Leia também: Como evitar violações de conformidade durante o desenvolvimento de produtos de IA]

Afinação

É importante considerar a implementação de estratégias de ajuste fino para manter a estabilidade do modelo e evitar o colapso. Estas estratégias para prevenir falhas no modelo de IA permitem que o modelo se adapte a novos dados, preservando ao mesmo tempo o seu conhecimento anterior.

Análise de preconceito e justiça

O preconceito rigoroso e a análise de justiça são cruciais para prevenir o colapso do modelo e questões éticas. É essencial identificar e abordar preconceitos nos resultados do modelo. Você pode manter resultados de modelos confiáveis e imparciais abordando ativamente essas preocupações.

Ciclos de feedback

A implementação de ciclos de feedback que incorporem o feedback do usuário é crucial para evitar o colapso do modelo. Ao coletar consistentemente insights dos usuários, ajustes informados podem ser feitos nos resultados do modelo. Este processo de refinamento garante que o modelo permaneça relevante, confiável e alinhado às expectativas do usuário.

Como a Appinventiv pode ajudar na mitigação de riscos em modelos de IA?

No cenário em evolução da IA, os desafios colocados pelo colapso do modelo têm sido uma preocupação tanto para os gigantes da tecnologia como para os inovadores. A deterioração a longo prazo dos conjuntos de dados de modelos linguísticos e a manipulação de conteúdos deixaram a sua marca neste ecossistema digital.

À medida que a IA avança, é vital diferenciar entre dados gerados artificialmente e conteúdo gerado por humanos. A linha entre o conteúdo genuíno e o que é gerado por uma máquina está se tornando cada vez mais tênue.

Agora, em meio a esses desafios e evitando falhas no modelo de IA, a parceria com uma empresa dedicada ao desenvolvimento de IA como a Appinventiv pode fornecer o consolo necessário. Com experiência no desenvolvimento de modelos de IA e um compromisso dedicado com práticas éticas de IA, podemos ajudá-lo a navegar pelas complexidades da IA, garantindo ao mesmo tempo a confiabilidade e a integridade dos seus sistemas de IA.

Nossos especialistas podem trabalhar com você para abordar de forma eficaz a prevenção do colapso do modelo de IA, promover a transparência e construir um futuro com conteúdo autêntico que não comprometa a autenticidade do conteúdo gerado por humanos.

Entendemos que treinar modelos de IA com dados novos e diversos é essencial para evitar a degradação do modelo. A avaliação do modelo de IA é uma etapa fundamental em nosso processo de desenvolvimento de modelo que emprega métricas para avaliar o desempenho, identificar pontos fracos e garantir previsões futuras eficazes.

Nossa equipe de especialistas pode ajudar a garantir que seus sistemas de IA continuem aprendendo e se adaptando ao cenário digital em evolução. Entre em contacto com os nossos especialistas para mitigar os riscos associados ao colapso do modelo e garantir a sua eficácia.

Perguntas frequentes

P. O que é o colapso do modelo de IA?

A. O colapso do modelo de IA no aprendizado de máquina refere-se à falha do modelo de IA em produzir uma gama diversificada de resultados úteis. Em vez disso, gera resultados repetitivos ou de baixa qualidade. Este problema pode ocorrer em diferentes tipos de modelos, mas é particularmente observado durante o treinamento de modelos complexos como redes adversárias generativas (GANs).

P. Quais são as causas comuns do colapso do modelo de IA?

R. As causas comuns do colapso do modelo de IA incluem perda de eventos raros, amplificação de preconceitos, estreitamento de capacidades geradoras, erros de aproximação funcional, etc.

P. Como posso evitar o colapso do modelo de IA?

R. Para uma prevenção eficaz do colapso do modelo de IA, é vital usar dados de treinamento diferentes e semelhantes ao mundo real, monitorar e avaliar continuamente os dados, corrigir quaisquer preconceitos e implementar testes rigorosos e controle de qualidade. A parceria com os especialistas em IA da Appinventiv pode oferecer insights e soluções valiosas para mitigar os riscos de colapso do modelo.