Avaliando ferramentas de web scraping: o que as empresas precisam saber

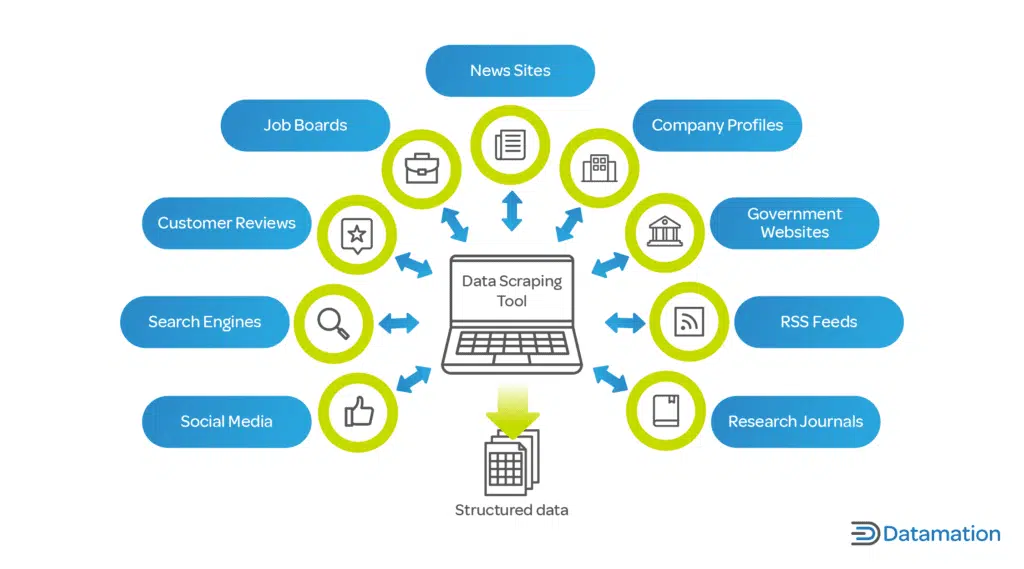

Publicados: 2024-05-15Web scraping por meio de ferramentas automatizadas de web scraping é fundamental para organizações que buscam aproveitar big data. Ele permite a coleta automatizada de informações relevantes de várias fontes da web, o que é essencial para análises baseadas em dados.

Ao extrair tendências atuais do mercado, preferências do consumidor e insights competitivos, as empresas podem:

- Faça escolhas estratégicas informadas

- Adaptar produtos às necessidades do cliente

- Otimize os preços para a competitividade do mercado

- Aumente a eficiência operacional

Além disso, quando combinados com ferramentas analíticas, os dados extraídos sustentam modelos preditivos, enriquecendo os processos de tomada de decisão. Esta inteligência competitiva impulsiona as empresas a antecipar as mudanças do mercado e a agir de forma proativa, mantendo uma vantagem crítica nos seus respetivos setores.

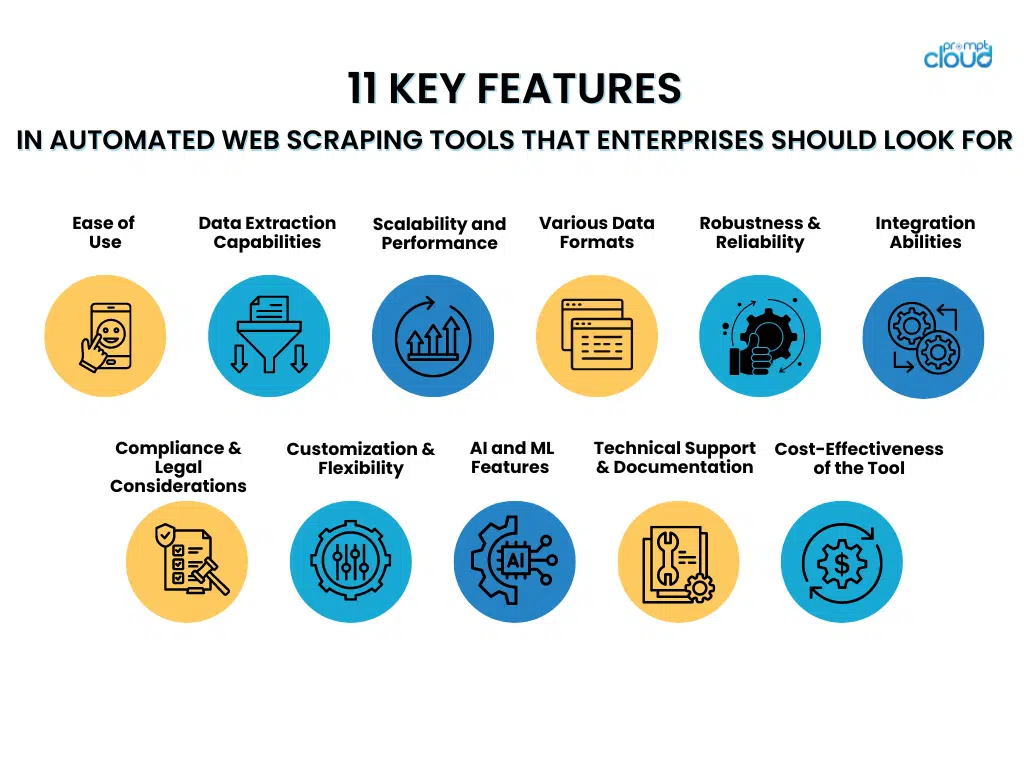

11 recursos principais em ferramentas automatizadas de web scraping que as empresas devem procurar

- Fácil de usar

Ao escolher ferramentas automatizadas de web scraping, as empresas devem dar preferência àquelas que apresentam interfaces fáceis de usar e etapas de configuração fáceis. Ferramentas com interfaces intuitivas permitem que a equipe as utilize de forma eficiente sem treinamento extensivo, permitindo maior foco na recuperação de dados em vez de dominar sistemas complexos.

Por outro lado, métodos de configuração descomplicados facilitam a implantação imediata dessas ferramentas, minimizando atrasos e acelerando a jornada em direção a insights valiosos. Os recursos que contribuem para a facilidade de uso incluem:

- Menus de navegação claros e diretos

- Funcionalidades de arrastar e soltar para design de fluxo de trabalho

- Modelos pré-construídos para tarefas comuns de raspagem

- Assistentes passo a passo orientando a configuração inicial

- Documentação abrangente e tutoriais para facilitar o aprendizado

Uma ferramenta fácil de usar maximiza a eficiência dos funcionários e ajuda a manter altos níveis de produtividade.

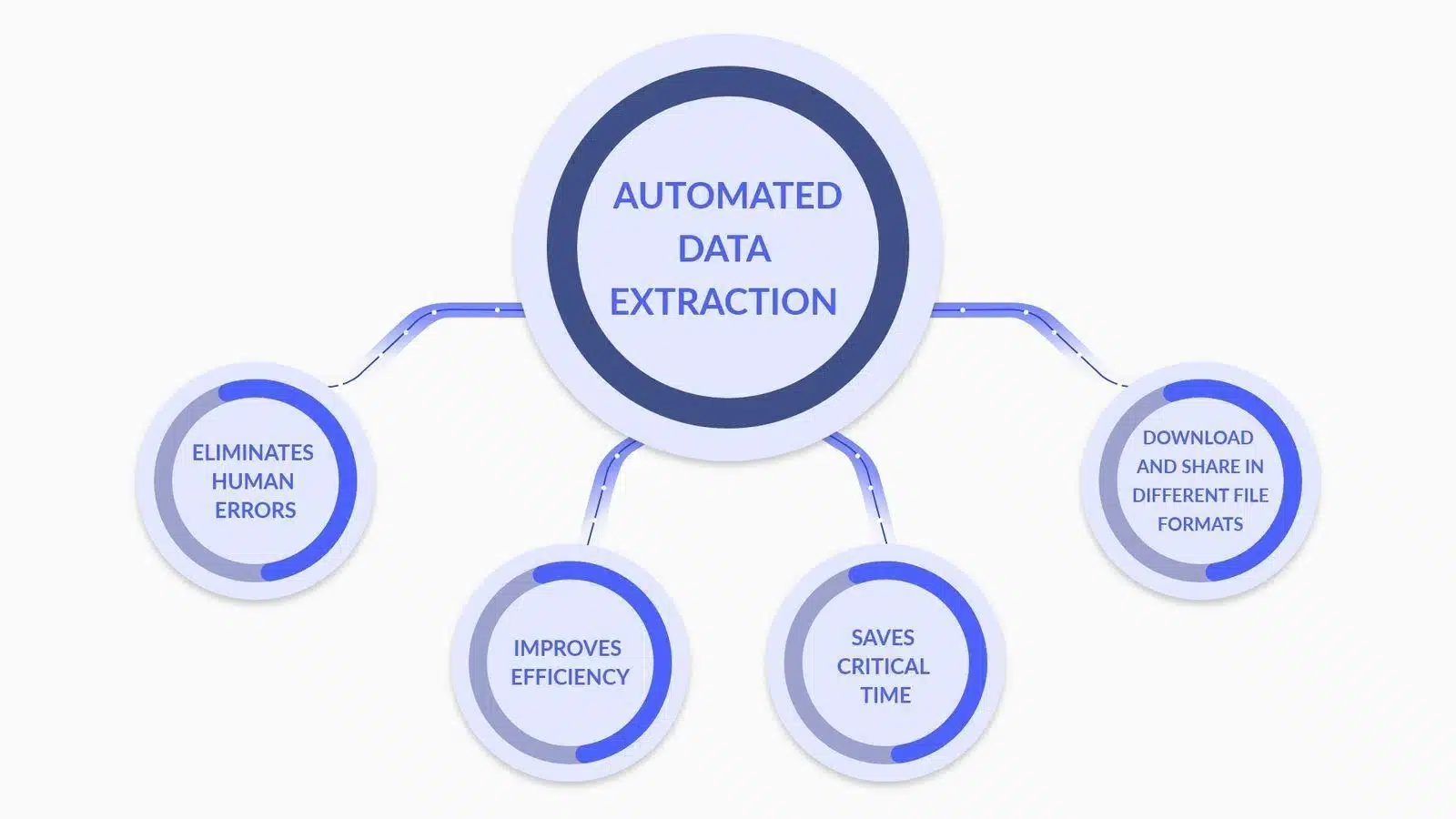

- Capacidades de extração de dados

Fonte da imagem: O que é extração de dados? Aqui está o que você precisa saber

Ao avaliar ferramentas automatizadas de web scraping, as empresas devem priorizar recursos avançados de análise e transformação de dados, como:

- Análise de dados personalizada : a capacidade de personalizar analisadores para interpretar com precisão estruturas de dados complexas, incluindo conteúdo aninhado e dinâmico.

- Conversão de tipo de dados : ferramentas que convertem automaticamente os dados extraídos em formatos utilizáveis (por exemplo, datas, números, strings) para um processamento de dados mais eficiente.

- Suporte a expressões regulares : inclusão de recursos de regex para correspondência sofisticada de padrões, permitindo extração precisa de dados.

- Transformação Condicional : A capacidade de aplicar lógica condicional aos dados extraídos, permitindo a transformação com base em critérios ou padrões de dados específicos.

- Limpeza de Dados : Funções que limpam e padronizam os dados na fase pós-extração para garantir a qualidade e consistência dos dados.

- Integração de API : Facilidades para integração perfeita com APIs para processar e analisar ainda mais os dados extraídos, aprimorando os recursos de tomada de decisão.

Cada recurso contribui para um processo de extração de dados mais robusto e preciso, fundamental para esforços de web scraping de nível empresarial.

- Escalabilidade e desempenho

Ao avaliar ferramentas automatizadas de web scraping, as empresas devem priorizar atributos de escalabilidade e desempenho que apoiam o processamento eficiente de vastos conjuntos de dados.

Uma ferramenta ideal pode gerenciar habilmente um aumento significativo na carga de trabalho sem comprometer a velocidade ou a precisão. As empresas devem procurar recursos como:

- Capacidades multi-threading que permitem processamento de dados simultâneo

- Gerenciamento de memória eficiente para lidar com tarefas de raspagem em grande escala

- Alocação dinâmica de recursos com base em demandas em tempo real

- Infraestrutura robusta que pode ser dimensionada horizontal ou verticalmente

- Mecanismos avançados de cache para acelerar a recuperação de dados

A capacidade da ferramenta de manter o desempenho sob carga garante uma extração confiável de dados, mesmo durante horários de pico ou durante a expansão das operações.

- Suporte para vários formatos de dados

Fonte da imagem: O que é extração de dados? Definição e como usá-lo

Uma ferramenta automatizada de web scraping deve lidar com diversos formatos de dados com proficiência. As empresas geralmente trabalham com vários tipos de dados, e a flexibilidade na extração de dados é fundamental:

- JSON: um formato leve de intercâmbio de dados que é fácil de ser lido e escrito por humanos e fácil de ser analisado e gerado por máquinas.

- CSV: O formato de valores separados por vírgula é um formato de arquivo simples e comum usado para dados tabulares. A maioria das ferramentas de scraping deve fornecer uma opção de exportação CSV.

- XML: Extensible Markup Language, um formato mais complexo que inclui metadados e pode ser usado em uma ampla variedade de setores.

A capacidade de extrair e exportar dados nestes formatos garante compatibilidade com diferentes ferramentas e sistemas de análise de dados, oferecendo uma solução versátil para os requisitos empresariais.

- Robustez e Confiabilidade

Quando as empresas escolhem ferramentas automatizadas de web scraping, elas devem priorizar robustez e confiabilidade. Os principais recursos a serem considerados incluem:

- Tratamento abrangente de erros : uma ferramenta superior deve ter a capacidade de detectar e corrigir erros automaticamente. Ele deve registrar os problemas e, quando possível, tentar novamente as solicitações com falha sem intervenção manual.

- Estratégias de minimização do tempo de inatividade : A ferramenta deve incluir mecanismos de failover, como servidores de backup ou fontes de dados alternativas, para manter as operações quando as fontes primárias falharem.

- Sistemas de monitoramento contínuo : O monitoramento em tempo real garante que qualquer tempo de inatividade seja imediatamente identificado e resolvido, minimizando lacunas de dados.

- Manutenção preditiva : utilizar o aprendizado de máquina para prever possíveis pontos de falha pode evitar preventivamente tempos de inatividade, tornando o sistema mais confiável.

Investir em ferramentas que enfatizem esses aspectos de robustez e confiabilidade pode reduzir significativamente os riscos operacionais associados ao web scraping.

- Habilidades de integração

Ao avaliar ferramentas automatizadas de web scraping, as empresas devem garantir sua capacidade de integração fluida com os pipelines de dados atuais. Isso é essencial para manter a continuidade do fluxo de dados e otimizar o processo. A ferramenta deve:

- Ofereça APIs ou conectores compatíveis com bancos de dados e plataformas analíticas existentes.

- Suporta vários formatos de dados para importação/exportação contínua, garantindo interrupções mínimas.

- Forneça recursos de automação que podem ser acionados por eventos no pipeline de dados.

- Facilite o dimensionamento fácil sem reconfiguração extensa à medida que as necessidades de dados evoluem.

- Conformidade e considerações legais

Ao integrar uma ferramenta automatizada de web scraping nas operações empresariais, é crucial garantir que a ferramenta esteja em conformidade com as estruturas legais. Os recursos a serem considerados incluem:

- Respeito pelo Robots.txt : a ferramenta deve reconhecer e obedecer automaticamente ao arquivo robots.txt do site, que descreve as permissões de raspagem.

- Limitação de taxa : para evitar uma carga perturbadora nos servidores host, as ferramentas devem incluir limitação de taxa ajustável para controlar a frequência das solicitações.

- Conformidade com a privacidade de dados : a ferramenta deve ser construída em alinhamento com as regulamentações globais de proteção de dados, como GDPR ou CCPA, garantindo que os dados pessoais sejam tratados legalmente.

- Conscientização sobre Propriedade Intelectual : A ferramenta deve ter mecanismos para evitar a violação de direitos autorais ao copiar conteúdo protegido por direitos autorais.

- Transparência do agente do usuário : a capacidade da ferramenta de raspagem de se identificar de forma precisa e transparente para sites de destino, reduzindo o risco de práticas enganosas.

A inclusão desses recursos pode ajudar a mitigar riscos legais e facilitar uma estratégia de scraping responsável que respeite tanto o conteúdo proprietário quanto a privacidade do usuário.

- Personalização e flexibilidade

Para atender efetivamente aos seus requisitos exclusivos de coleta de dados, as empresas devem considerar os recursos de personalização e flexibilidade de uma ferramenta automatizada de web scraping como fatores cruciais durante a avaliação. Uma ferramenta superior deve:

- Ofereça uma interface amigável para usuários não técnicos personalizarem os parâmetros de extração de dados.

- Fornece opções avançadas para os desenvolvedores escreverem scripts personalizados ou usarem APIs.

- Permita fácil integração com sistemas e fluxos de trabalho existentes na empresa.

- Permita o agendamento de atividades de scraping para execução fora dos horários de pico, reduzindo a carga nos servidores e evitando possíveis estrangulamentos do site.

- Adapte-se a diferentes estruturas de sites e tipos de dados, garantindo que uma ampla variedade de casos de uso possa ser tratada.

A personalização e a flexibilidade garantem que a ferramenta possa evoluir com as novas necessidades da empresa, maximizando o valor e a eficácia dos esforços de web scraping.

- Recursos avançados de IA e aprendizado de máquina

Ao selecionar uma ferramenta automatizada de web scraping, as empresas devem considerar a integração de IA avançada e aprendizado de máquina para melhorar a precisão dos dados. Esses recursos incluem:

- Compreensão contextual : A aplicação de processamento de linguagem natural (PNL) permite que a ferramenta discerna o contexto, reduzindo erros em conteúdo copiado.

- Reconhecimento de padrões : Algoritmos de aprendizado de máquina identificam padrões de dados, facilitando a extração precisa de informações.

- Aprendizagem adaptativa : a ferramenta aprende com tarefas de raspagem anteriores para otimizar os processos de coleta de dados para tarefas futuras.

- Detecção de anomalias : os sistemas de IA podem detectar e corrigir valores discrepantes ou anomalias nos dados extraídos, garantindo confiabilidade.

- Validação de dados : O uso de IA para verificação cruzada de dados extraídos com múltiplas fontes aumenta a validade das informações.

Ao aproveitar estas capacidades, as empresas podem diminuir substancialmente as imprecisões nos seus conjuntos de dados, levando a uma tomada de decisões mais informada.

- Suporte Técnico e Documentação

É aconselhável que as empresas dêem preferência a ferramentas automatizadas de web scraping que venham com ampla assistência técnica e documentação completa. Isto é crucial para:

- Minimização do tempo de inatividade : O suporte rápido e profissional garante que todos os problemas sejam resolvidos rapidamente.

- Facilidade de uso : Documentação bem organizada auxilia no treinamento do usuário e no domínio da ferramenta.

- Solução de problemas : guias e recursos acessíveis permitem que os usuários solucionem problemas comuns de forma independente.

- Atualizações e upgrades : suporte consistente e documentação clara são vitais para navegar com eficiência pelas atualizações do sistema e novos recursos.

A escolha de uma ferramenta com suporte técnico robusto e documentação clara é essencial para uma operação perfeita e uma solução eficiente de problemas.

- Avaliando a relação custo-benefício da ferramenta

As empresas devem levar em consideração as despesas iniciais e o possível ROI ao avaliar o software de automação para web scraping. Os principais fatores de preços incluem:

- Taxas de licença ou custos de assinatura

- Despesas de manutenção e suporte

- Potencial economia de custos com a automação

- Escalabilidade e adaptabilidade às necessidades futuras

Uma avaliação completa do retorno do investimento (ROI) de uma ferramenta deve levar em consideração seu potencial para diminuir o trabalho manual, aumentar a precisão dos dados e acelerar o processo de obtenção de insights. Além disso, as empresas devem avaliar vantagens duradouras, como a melhoria da competitividade resultante de escolhas baseadas em dados. Comparar essas medições com o custo da ferramenta oferecerá uma visão distinta de sua relação custo-benefício.

Conclusão

Ao escolher uma ferramenta automatizada de web scraping, as empresas devem considerar meticulosamente cada recurso em relação aos seus requisitos específicos. Enfatizar aspectos como escalabilidade, precisão dos dados, velocidade, legalidade e economia é essencial. A ferramenta ideal apoiará os objetivos da empresa e se integrará perfeitamente aos sistemas atuais. No final, uma escolha esclarecida resulta de um exame minucioso dos recursos da ferramenta e de uma compreensão sólida das necessidades futuras de dados do negócio.