Altamente visível e de baixa qualidade (ou inútil) – uma combinação de SEO mais perigosa

Publicados: 2024-01-08

Como tenho ajudado empresas que foram fortemente impactadas pelas “atualizações de algoritmos insanos da queda de 2023”, ouvi mais uma vez vários proprietários de sites que tiveram seus níveis mais altos de tráfego logo antes de serem atingidos. Falarei mais sobre isso em breve, mas é algo que já vejo há muito tempo. E agora que lemos o testemunho do Google sobre o Navboost e os sinais de interação do usuário no último julgamento antitruste, várias ideias estão passando pela minha cabeça.

Ao ajudar as empresas afetadas por grandes atualizações de algoritmos (como atualizações principais amplas), é muito importante executar o que chamo de “relatório delta” para identificar as principais consultas e páginas de destino que caíram durante essas atualizações. Os relatórios Delta podem ser poderosos e ajudar os proprietários de sites a determinar se uma queda foi devido a ajustes de relevância, mudanças de intenção ou problemas gerais de qualidade do site. E se a qualidade era o problema, investigar as consultas e as páginas de destino que mais caíram pode gerar descobertas importantes. E essas descobertas podem ajudar a identificar conteúdo de baixa qualidade, conteúdo superficial, conteúdo de IA de baixa qualidade, barreiras de experiência do usuário, publicidade agressiva, configuração de afiliado enganosa ou agressiva e muito mais.

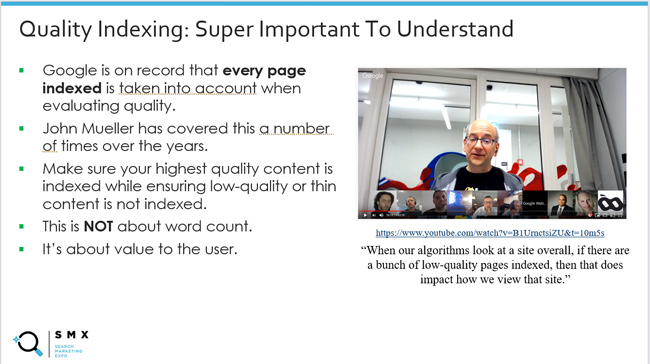

Isso também me fez pensar mais uma vez em “indexação de qualidade”, que abordei muitas vezes em minhas postagens e apresentações sobre as principais atualizações de algoritmos. Isso garante que seu conteúdo da mais alta qualidade seja indexado, ao mesmo tempo que garante que conteúdo de baixa qualidade ou limitado não seja indexado. Essa proporção é importante. Isso porque sabemos que o Google leva em consideração todas as páginas indexadas ao avaliar a qualidade. John Mueller, do Google, explicou isso várias vezes e eu compartilhei esses videoclipes ao longo dos anos.

Mas todas as coisas são criadas iguais do ponto de vista da qualidade? Em outras palavras, se você encontrar um lote de lixo de qualidade inferior em seu site que não aparece com frequência nos resultados da pesquisa, isso é o mesmo que conteúdo de qualidade inferior (ou conteúdo inútil) altamente visível nos resultados da pesquisa?

Os comentários de John Mueller sobre a remoção de conteúdo de baixa qualidade mudaram ligeiramente ao longo dos anos nesse aspecto. Percebi isso com o passar do tempo e isso sempre despertou minha curiosidade. John passou da explicação de que, se um conteúdo for indexado, sua qualidade pode ser avaliada, até a explicação de que ele se concentraria primeiro no que é altamente visível e de baixa qualidade . Explicarei mais sobre por que isso faz todo o sentido (especialmente com novas informações do último teste antitruste do Google).

Abaixo, abordarei rapidamente algumas informações básicas sobre sinais de envolvimento do usuário e SEO, depois abordarei alguns comentários interessantes de John Mueller do Google ao longo dos anos sobre a remoção de conteúdo de baixa qualidade e, em seguida, associarei isso a O testemunho recente do Google sobre como aproveitar os sinais de interação do usuário para auxiliar na classificação (ou seja, Navboost).

Primeiro, vamos percorrer o histórico e discutir os sinais de interação do usuário e o impacto do SEO.

Sinais de interação do usuário e SEO e a incrível capacidade do Google de compreender a felicidade do usuário:

Com o mais recente teste antitruste do Google, aprendemos muito sobre como o Google aproveita os sinais de interação do usuário para impactar as classificações. Por exemplo, Pandu Nayak do Google falou sobre o Navboost, como o Google coleta 13 meses de dados de cliques (anteriormente 18 meses) e como esses dados podem ajudar o Google a entender a felicidade do usuário (usuários de pesquisa satisfeitos).

Embora aprender sobre o Navboost tenha surpreendido muitas pessoas (com razão), sempre houve sinais de que o Google estava fazendo algo com os dados de envolvimento do usuário do ponto de vista de classificação. Ninguém sabia ao certo, mas era difícil ignorar o conceito ao pesquisar muitos sites que caíram ao longo do tempo com base em atualizações importantes de algoritmos (especialmente atualizações principais amplas).

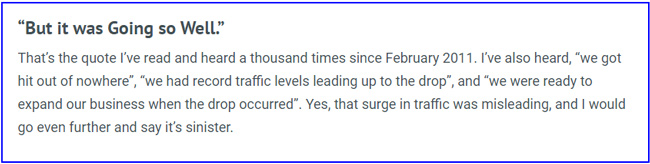

Por exemplo, escrevi uma postagem em 2014 sobre o aumento sinistro e enganoso no tráfego antes de um grande algoritmo ser atingido. Observe que o Search Engine Watch está tendo problemas com postagens mais antigas, então criei um link para a versão da máquina de retorno da minha postagem. Escrevi esse post depois de muitas empresas entrarem em contato comigo sobre os grandes sucessos do Panda e explicarem que tinham acabado de experimentar os níveis mais altos de tráfego de todos os tempos, até que… travaram com a próxima atualização.

Para mim, parecia que o Google estava ganhando tanta inteligência com base na forma como os usuários se interagiam com o conteúdo das SERPs que acabou contribuindo para a queda. Em outras palavras, o Google poderá ver usuários insatisfeitos em grande escala nesses sites. E então bum, eles afundaram.

Aqui está uma citação do meu artigo SEW:

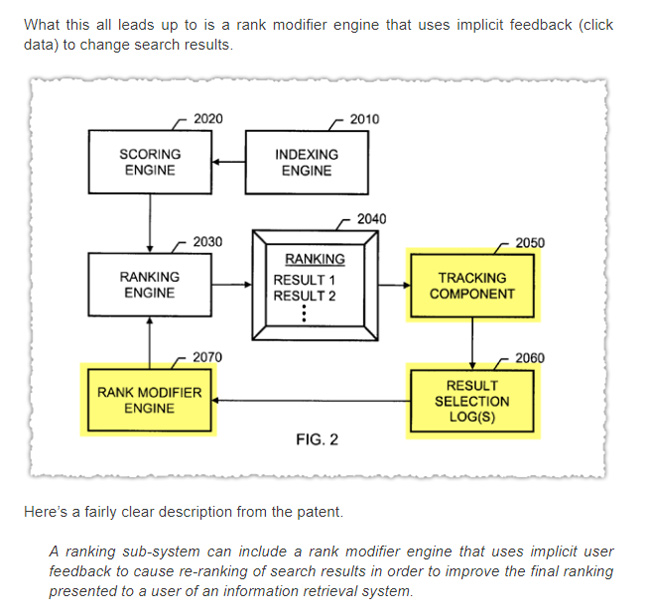

Além disso, AJ Kohn também escreveu um artigo em 2015 sobre o CTR como fator de classificação. AJ também trabalhou em muitos sites ao longo dos anos e tinha um sério palpite de que os sinais de interação do usuário desempenhavam um papel nas classificações. Aqui está uma captura de tela da postagem de AJ fazendo referência ao feedback implícito do usuário.

Também escrevi muito sobre o perigo do baixo tempo de permanência e como a implementação de algo como a taxa de rejeição ajustada pode ajudar os proprietários de sites a ter uma noção melhor do conteúdo que não atende ou excede as expectativas do usuário. Essa postagem é de 2012. E ampliei essa ideia com outra postagem em 2018 sobre o uso de vários mecanismos de rastreamento como um proxy para a felicidade do usuário (incluindo taxa de rejeição ajustada, rastreamento de profundidade de rolagem e tempo na página). Observe que isso foi para GA3, não GA4.

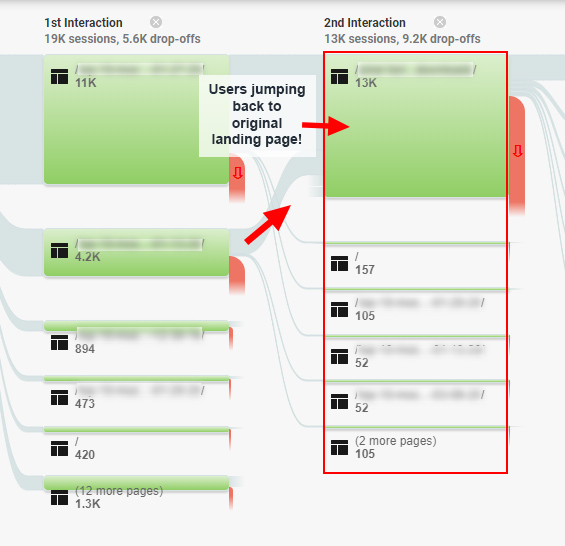

E como um ótimo exemplo de como os problemas de engajamento do usuário podem impactar o SEO, houve um estudo de caso que escrevi em 2020 sobre a “armadilha do engajamento do SEO”, onde encontrei usuários correndo em círculos em torno de um site, e tenho certeza que no final das contas voltei para os SERPs, para melhores respostas. Esse site foi atingido por uma ampla atualização central e se recuperou depois de resolver muitos desses problemas. Então, sim, mais sinais negativos de interação do usuário para o Google avaliar.

Aqui está uma captura de tela dessa postagem mostrando relatórios de fluxo de comportamento para usuários frustrados:

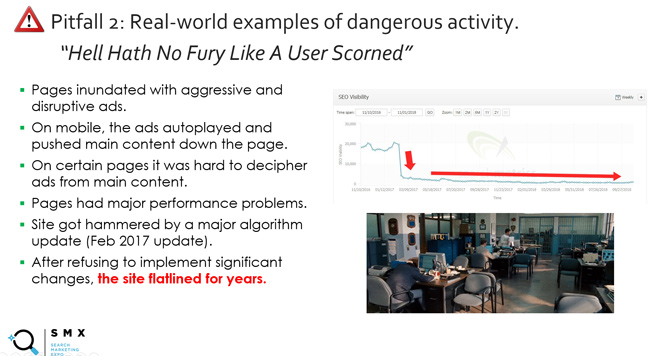

E há o slide (e o lema) que venho usando há muito tempo em minhas apresentações sobre amplas atualizações principais, intitulado “O inferno não tem fúria como a de um usuário desprezado”. Isso se refere a mais do que apenas a qualidade do conteúdo e inclui publicidade agressiva, barreiras à experiência do usuário e muito mais. Basicamente, não irrite os usuários. Você pagará um preço alto. E, a propósito, qual seria uma ótima maneira de o Google entender os usuários irritados? Bem, rastreando sinais de interação do usuário, como baixo tempo de permanência (alguém voltando rapidamente para as SERPs após visitar um site do Google).

E sobre o tema do tempo de permanência, uma das minhas citações favoritas foi de anos atrás, quando Duane Forrester do Bing escreveu uma postagem no blog explicando como o baixo tempo de permanência poderia impactar a visibilidade da pesquisa. Duane não trabalha mais para o Bing, mas foi o Matt Cutts do Bing por vários anos. Nessa postagem, que já foi excluída (mas pode ser encontrada na máquina wayback), Duane explicou o seguinte:

“Se o seu conteúdo não os encoraja a permanecer com você, eles irão embora. Os motores de busca podem ter uma ideia disso observando o tempo de permanência. O tempo entre o momento em que um usuário clica em nosso resultado de pesquisa e o momento em que ele retorna do seu site conta uma história em potencial. Um ou dois minutos é bom, pois pode indicar facilmente que o visitante consumiu seu conteúdo. Menos de alguns segundos podem ser considerados um resultado ruim. E embora esse não seja o único fator que analisamos quando ajudamos a determinar a qualidade, é um sinal que observamos.”

Então, em outra postagem no SEJ, Duane continuou dizendo:

“O tempo de permanência era um daqueles conceitos que fazia todo o sentido depois de explicado, e ficou imediatamente óbvio que tal métrica poderia ser muito importante para determinar a satisfação do pesquisador.”

E por fim, Duane explicou que foi considerado “numa mistura de fatores”, o que é importante compreender. Ele explicou que perseguir o tempo de permanência era uma má ideia. Ele explicou que devemos nos concentrar em fazer melhorias mais amplas em um site que aumente o envolvimento do usuário (e o tempo de permanência pode aumentar como resultado desse trabalho). É também por isso que acredito que a abordagem de remediação da “pia da cozinha” é um caminho poderoso a seguir. Resolva o maior número possível de problemas de qualidade e grandes coisas poderão acontecer no futuro.

Observe, não se concentre na quantidade de tempo que Duane forneceu em 2011 para um “compromisso curto”… Tenho certeza de que esse é um dos motivos pelos quais a postagem foi removida. Para alguns tipos de conteúdo, um período de tempo mais curto é totalmente aceitável do ponto de vista do envolvimento do usuário. Mas o ponto principal sobre o baixo tempo de permanência, especialmente quando visto em muitos conteúdos de um site, é muito importante de entender. Foi então, e certamente é agora.

O ponto principal que estou tentando transmitir é que a interação do usuário sempre pareceu ser um fator de alguma forma... só não sabíamos exatamente como. Isso até o Navboost ser exposto. Abordarei mais sobre isso em breve.

Por que “altamente visível” é importante: comentários de John Mueller do Google.

OK, agora vamos dar uma olhada mais de perto no que chamo de “indexação de qualidade”. Novamente, isso significa garantir que apenas o conteúdo da mais alta qualidade que possa atender ou exceder as expectativas do usuário seja indexado, ao mesmo tempo que garante que conteúdo de baixa qualidade ou limitado não seja indexado.

O Google explicou ao longo do tempo que todas as páginas indexadas são levadas em consideração na avaliação da qualidade. Já abordei isso muitas vezes em minhas postagens e apresentações sobre as principais atualizações de algoritmos (especialmente ao cobrir atualizações básicas amplas).

Aqui está John de 2017 explicando isso:

Mas com o tempo, notei uma mudança na resposta de John quando questionado sobre a remoção de conteúdo de qualidade inferior. John começou a explicar que se concentraria em conteúdo “altamente visível” e de qualidade inferior. Ouvi isso em vários vídeos de hangouts do Search Central, e ele também abordou isso em uma entrevista com Marie Haynes.

Aqui estão vários exemplos:

Primeiro, aqui está João explicando que nem todas as coisas são iguais em termos de conteúdo. O Google tentará descobrir as páginas mais importantes e focar nelas:

Aqui está John explicando que o Google pode entender o conteúdo principal de um site, para onde os visitantes estão indo, etc.

E aqui está John explicando que se você sabe que as pessoas estão visitando determinadas páginas, então faria sentido abordar primeiro essas páginas de qualidade inferior (para que as pessoas possam permanecer por aqui):

Então, por que isto é importante? Bem, agora que sabemos mais sobre como o Google aproveita os sinais de interação do usuário para impactar a visibilidade e as classificações por meio do Navboost, essa afirmação de John faz muito sentido. Quanto mais dados de interação do usuário o Google tiver para combinações de consulta e página de destino, mais ele poderá compreender a felicidade do usuário. Se uma página for de baixa qualidade e não estiver visível, o Google não terá dados de interação do usuário. Claro, o Google pode usar outros sinais, processamento de linguagem natural, etc. para entender melhor o conteúdo, mas os sinais de interação do usuário são incríveis para compreender a satisfação do usuário.

Observe que, antes de prosseguir, eu queria deixar claro que ainda resolveria todos os problemas de qualidade de conteúdo de um site (mesmo aqueles que não são “altamente visíveis”), mas começaria com os mais visíveis. Esse é um ponto importante para proprietários de sites que lidam com uma grande queda em atualizações básicas amplas, atualizações de conteúdo úteis ou atualizações de avaliações.

O teste antitruste do Google e os sinais de envolvimento do usuário que influenciam as classificações.

Mencionei o Navboost várias vezes neste post e gostaria de abordá-lo nesta seção. Não vou me aprofundar muito, já que isso foi abordado em vários outros posts do setor recentemente, mas é importante entender.

No depoimento antitruste do Google, Pandu Nayak explicou o uso do Navboost, um sistema para aproveitar os dados de interação do usuário para ajudar o Google a entender a felicidade do usuário. Basicamente, permite que o Google aprenda com seus usuários ao longo do tempo e ajuste as classificações com base nesses aprendizados. Obviamente, o Navboost não é o único fator em jogo, mas é um fator importante na determinação das classificações.

Aqui está Pandu Nayak sobre a importância do Navboost:

“Quero dizer, é difícil dar uma ordem de classificação como esta. Direi que o navboost é importante, certo. Então não quero minimizá-lo de forma alguma. Mas direi também que existem muitos outros sinais que também são importantes, como os que mencionei. E você realmente não pode desligar algumas dessas coisas. Não sei o que significaria desligar o índice dos documentos. De certa forma, isso é a coisa mais importante, as palavras na página e assim por diante, certo. Portanto, é um pouco difícil julgar dessa forma. Então eu diria que o navboost é um dos sinais importantes que temos. ”

Portanto, se as páginas são altamente visíveis para uma consulta, o Google está coletando ativamente sinais de envolvimento do usuário para esses URLs e combinações de consulta (agora coletando 13 meses de dados de cliques). E o Navboost pode usar esses sinais de interação do usuário para ajudar os sistemas do Google a entender a felicidade do usuário (incluindo a compreensão do tempo de permanência, cliques longos, rolagens, movimentos do mouse e muito mais).

E, por outro lado, se as páginas não forem altamente visíveis para consultas, o Google não poderá aproveitar esses sinais de interação do usuário... ou não terá sinais suficientes para causar impacto. Isso não significa que o Google não consiga entender a qualidade da página, mas faltarão sinais reais do usuário para essas combinações de consulta e página de destino. E isso é extremamente importante.

Observe que se você estiver interessado em aprender mais sobre os sinais de interação do usuário no teste antitruste do Google, AJ Kohn escreveu uma ótima postagem cobrindo essas informações com base no depoimento de Pandu Nayak. Eu recomendo a leitura da postagem de AJ, caso ainda não o tenha feito, pois ela cobre mais sobre Navboost, sinais de interação do usuário, CTR como fator de classificação, etc.

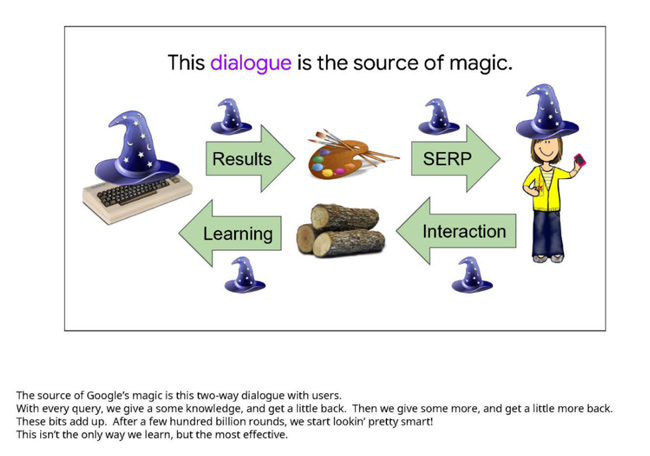

Aqui está um slide de uma apresentação do Google que serviu de prova durante o julgamento. Ele ressalta a importância dos sinais de interação do usuário para determinar a satisfação do pesquisador. Lembre-se de que este slide foi de vários anos atrás. É sobre a “fonte da magia do Google”:

E não se esqueça dos algoritmos de qualidade no nível do site:

Novamente, não quero sobrecarregar esta postagem com muitas informações do julgamento antitruste, mas meu ponto principal é que o conteúdo “altamente visível” nas SERPs pode obter muitos sinais de interação do usuário, que o Google pode usar como um fator para classificações. Também é possível que o Google também use esses dados de forma agregada para influenciar algoritmos de qualidade no nível do site. E esses algoritmos no nível do site podem desempenhar um papel importante no desempenho dos sites durante amplas atualizações principais (e outras atualizações importantes de algoritmos). Eu também cobri isso há muito tempo.

O que isso significa para você. Minha recomendação para proprietários de sites afetados por atualizações importantes de algoritmos:

Para proprietários de sites fortemente afetados por atualizações importantes de algoritmos, é importante dar um passo atrás e analisar um site como um todo a partir de uma perspectiva de qualidade. E como John Mueller, do Google, explicou anteriormente, “qualidade” é mais do que apenas conteúdo. É também sobre questões de UX, a situação da publicidade, como as coisas são apresentadas e muito mais.

E agora, com a confirmação de que o Google aproveita os sinais de interação do usuário para impactar a visibilidade e as classificações por meio do Navboost, eu colocaria URLs “altamente visíveis” na lista ao decidir o que abordar. Sim, você deve resolver todos os problemas de qualidade que surgir, até mesmo o lixo que pode não ser altamente visível, mas eu priorizaria os URLs que eram mais visíveis, levando a uma grande atualização do algoritmo. Então, sim, gerar um relatório delta ficou ainda mais importante.

Resumo: Mostre todo o conteúdo de baixa qualidade, mas comece com o que é “altamente visível”.

Ao longo dos anos, sempre expliquei que o conteúdo precisa atender ou superar as expectativas do usuário com base na consulta. Agora, com o último testemunho do julgamento antitruste do Google, temos evidências concretas de que o Google está de fato aproveitando os sinais de interação do usuário para ajustar as classificações (e possivelmente influenciar os algoritmos de qualidade no nível do site). Como proprietário de um site, não deixe que conteúdo de baixa qualidade, limitado ou inútil permaneça nas SERPs para os usuários interagirem. Como tenho visto ao longo dos anos com grandes atualizações de algoritmos, isso não vai acabar bem. Definitivamente, resolva todos os possíveis problemas de qualidade em um site, mas não negligencie o que é altamente visível. Esse é um ótimo lugar para começar a melhorar a qualidade geral do site.

GG