Dimensionando operações de extração de dados: dicas de especialistas para lidar com grandes volumes de dados

Publicados: 2024-05-25À medida que a demanda por dados cresce, também aumentam os desafios associados ao dimensionamento das operações de coleta de dados. Web scraping em grande escala não envolve apenas aumentar a quantidade de dados coletados; trata-se de manter a qualidade, garantir a eficiência e superar obstáculos técnicos e legais.

Imagine uma empresa de varejo começando com uma modesta operação de coleta de dados, coletando informações sobre preços e produtos de alguns sites concorrentes. Inicialmente, essa configuração funciona perfeitamente, fornecendo insights valiosos para a tomada de decisões estratégicas. No entanto, à medida que a empresa se expande e começa a atingir um mercado mais amplo, a necessidade de web scraping em grande escala de centenas ou mesmo milhares de sites torna-se aparente. A infraestrutura inicial, que era adequada para operações de pequena escala, agora sofre com o aumento da carga, levando a um desempenho mais lento e a possíveis imprecisões de dados.

Além disso, lidar com fontes web diversas e dinâmicas adiciona outra camada de complexidade. Os sites frequentemente atualizam suas estruturas, implementam medidas anti-scraping ou exigem extração de dados de conteúdo complexo renderizado em JavaScript. Esses desafios exigem soluções robustas e adaptáveis que possam ser dimensionadas perfeitamente, sem comprometer a qualidade ou a legalidade dos dados.

Web scraping em grande escala não envolve apenas lidar com mais dados, mas fazê-lo de uma forma eficiente, confiável e em conformidade com os padrões legais. Envolve a escolha das ferramentas e tecnologias certas, a construção de uma infraestrutura robusta e a implementação de pipelines de processamento de dados eficientes. Compreender os desafios da web scraping em grande escala e desenvolver estratégias para superá-los é essencial para as empresas que buscam aproveitar todo o potencial da raspagem de dados.

Nº 1: Escolhendo as ferramentas e tecnologias certas

A seleção das ferramentas e tecnologias apropriadas é a base das operações de web scraping em grande escala. Estruturas de raspagem avançadas, como Scrapy, Beautiful Soup e Selenium, oferecem funcionalidades robustas que podem lidar com tarefas complexas de raspagem. Essas ferramentas são excelentes para projetos menores e mais gerenciáveis, mas à medida que a escala e a complexidade das operações de coleta de dados aumentam, são necessárias soluções mais poderosas e flexíveis.

É aqui que entram em ação os provedores de serviços de web scraping, como o PromptCloud. PromptCloud oferece uma solução abrangente de extração de dados de ponta a ponta, projetada para ser dimensionada perfeitamente de acordo com as necessidades do negócio. Ao contrário das ferramentas tradicionais, o PromptCloud fornece um serviço totalmente gerenciado que cuida de tudo, desde a configuração da infraestrutura de scraping até a entrega de dados.

Nº 2: Construindo uma infraestrutura robusta

Uma infraestrutura robusta é crucial para apoiar operações de web scraping em grande escala. Isso inclui servidores poderosos, amplas soluções de armazenamento e conexões de Internet de alta velocidade. Aproveitar serviços de infraestrutura em nuvem, como Amazon Web Services (AWS), Google Cloud Platform (GCP) ou Microsoft Azure, garante escalabilidade e confiabilidade, permitindo que as empresas escalem suas operações conforme necessário.

Configurar e gerenciar sua própria infraestrutura pode exigir muitos recursos e ser complexo. PromptCloud oferece uma solução simplificada que elimina esses desafios. Ao fornecer um serviço de coleta de dados totalmente gerenciado, o PromptCloud cuida dos requisitos de infraestrutura, garantindo que suas operações funcionem de maneira suave e eficiente.

Nº 3: Garantindo qualidade e precisão dos dados em escala

Manter a qualidade e a precisão dos dados é um desafio significativo ao lidar com grandes conjuntos de dados. À medida que o volume de dados cresce, o potencial de erros e inconsistências aumenta, tornando crucial a implementação de procedimentos robustos de validação e limpeza de dados. Garantir que os dados coletados sejam confiáveis e utilizáveis é essencial para tomar decisões de negócios informadas e manter a integridade de suas análises.

Os sites mudam frequentemente suas estruturas, o que pode atrapalhar as operações de coleta de dados e levar a imprecisões. Monitorar e atualizar regularmente seus scripts de scraping é essencial para se adaptar a essas mudanças e garantir a precisão contínua dos dados coletados.

PromptCloud fornece uma solução abrangente para manter a qualidade e a precisão dos dados em escala. Ao aproveitar seus serviços de web scraping e de coleta de dados gerenciados em grande escala, você pode garantir que seus processos de coleta de dados permaneçam robustos e confiáveis.

Nº 4: Aproveitando soluções em nuvem para escalabilidade

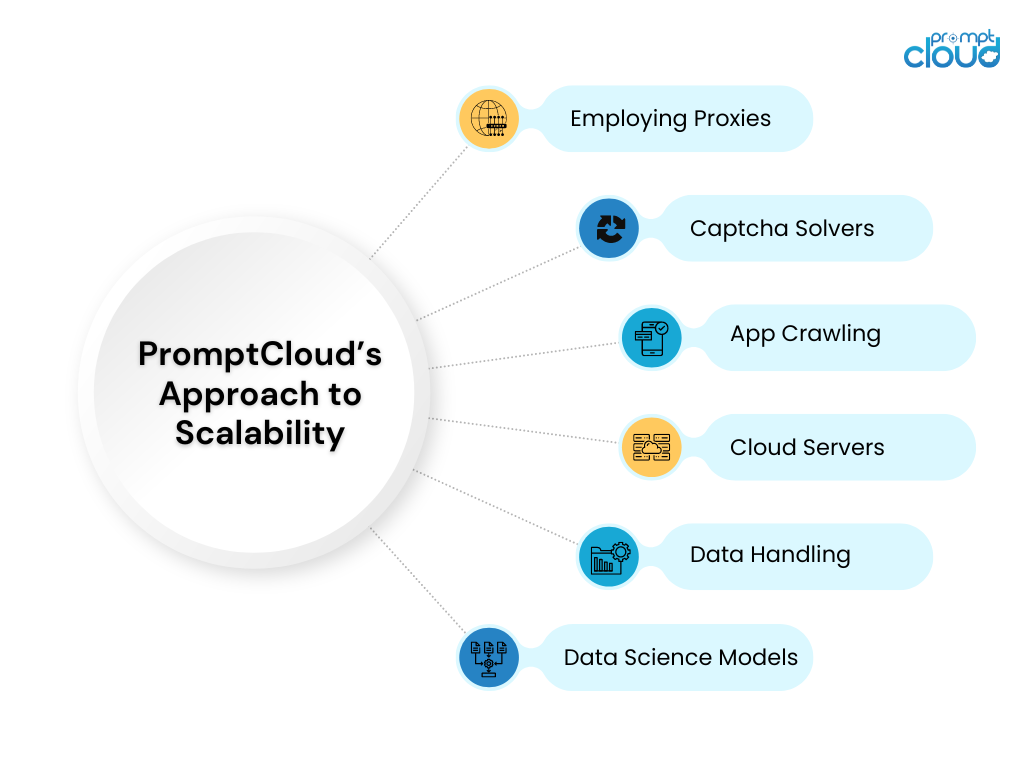

As soluções em nuvem oferecem escalabilidade incomparável para operações de coleta de dados. Serviços como AWS EC2 e Google Cloud Compute Engine permitem que as empresas aumentem ou diminuam seus recursos de computação com base na demanda. Essa flexibilidade garante que as operações de coleta de dados possam lidar com cargas de trabalho variadas sem comprometer o desempenho.

PromptCloud aproveita ao máximo as soluções em nuvem para oferecer um serviço de web scraping escalonável e eficiente em grande escala. Ao integrar-se às principais plataformas de nuvem, o PromptCloud garante que suas operações de coleta de dados possam lidar com qualquer volume de dados com facilidade.

Nº 5: Lidando com armazenamento e gerenciamento de dados

Soluções eficazes de armazenamento e gerenciamento de dados são vitais para lidar com grandes volumes de dados copiados. À medida que a quantidade de dados aumenta, garantir que eles sejam armazenados com segurança e possam ser acessados rapidamente torna-se cada vez mais importante.

PromptCloud oferece soluções abrangentes de armazenamento e gerenciamento de dados como parte de seus serviços gerenciados de coleta de dados. Ao utilizar soluções de armazenamento escalonáveis e implementar as melhores práticas de gerenciamento de dados, o PromptCloud garante que seus dados sejam armazenados com segurança e possam ser acessados com eficiência.

Dimensionando operações de web scraping com PromptCloud

Dimensionar operações de web scraping para lidar com grandes volumes de dados apresenta inúmeros desafios, desde manter a qualidade dos dados e gerenciar o armazenamento até garantir recuperação e processamento eficientes. No entanto, com as estratégias e ferramentas certas, estes desafios podem ser enfrentados de forma eficaz, permitindo que as empresas aproveitem todo o potencial da web scraping para obterem vantagem competitiva e uma tomada de decisão informada.

PromptCloud oferece um conjunto abrangente de soluções projetadas para lidar com as complexidades do web scraping em grande escala. Ao aproveitar tecnologias avançadas e infraestrutura robusta, garantimos que suas operações de raspagem de dados sejam escalonáveis, eficientes e confiáveis. Pronto para escalar suas operações de raspagem na web e desbloquear todo o potencial de seus dados? Faça parceria com a PromptCloud para aproveitar nossas soluções de ponta e serviços especializados. Contate-nos hoje para agendar uma demonstração e ver nossas soluções em ação.