O que é SEO técnico?

Publicados: 2023-09-01Quando você começar a aprender SEO, logo perceberá que há muitas facetas diferentes que você precisa entender para ter sucesso.

Do SEO na página ao SEO na página e criação de conteúdo. Você precisa ter um entendimento firme de tudo, não importa sua função específica no SEO, para obter a classificação do seu site onde precisa estar.

Neste artigo, exploraremos o SEO técnico. Você aprenderá exatamente o que é, por que é importante para sites e as características de um site bem otimizado do ponto de vista técnico.

Também forneceremos informações detalhadas sobre como funciona o SEO técnico, desde o rastreamento e indexação até a classificação e o que você precisa para que essas três etapas funcionem bem juntas.

Crédito da imagem: https://tsh.io/

O que é SEO técnico?

SEO técnico é o processo de otimização dos elementos “nos bastidores” de um site para melhorar seu desempenho em mecanismos de busca como Google e Bing. Este processo inclui etapas como melhorar a marcação e estrutura do site para garantir fácil rastreamento, indexação e classificação (falaremos mais sobre isso mais tarde) por bots de mecanismos de pesquisa como o Googlebot. As tarefas abrangem o refinamento da velocidade do site, a criação de uma arquitetura de site simples e fácil de entender, o uso de URLs "amigáveis para SEO" e a aplicação de marcação de esquema para resultados de pesquisa enriquecidos.

Essencialmente, o SEO técnico cria uma base sólida que auxilia os mecanismos de pesquisa no processo de elevação da classificação de um site. Em última análise, isso levará a um aumento do tráfego orgânico e a uma experiência de usuário aprimorada.

Pense no seu site como uma biblioteca bem organizada. SEO técnico é a etapa de arquivar livros ordenadamente com tags claras (sua estrutura de URL), configurar sinais para uma navegação tranquila (seus links internos) e criar um ambiente acolhedor (velocidade do site). Quando a biblioteca é organizada e convidativa, mais visitantes podem localizar os livros de que necessitam (usuários descobrindo conteúdo) e bibliotecários (bots de mecanismos de busca) podem categorizar e sugerir livros (indexação e classificação).

Por que o SEO técnico é importante?

O SEO técnico é extremamente importante para a grande maioria dos sites, pois constitui a base para a visibilidade do mecanismo de pesquisa e o desempenho geral do site. É claro que o conteúdo que você publica é crucial, mas a falta de otimização técnica adequada pode impedir que os mecanismos de pesquisa descubram, indexem e classifiquem esse conteúdo de maneira eficaz.

A importância do SEO técnico pode ser resumida da seguinte forma:

Em primeiro lugar, garante que os motores de busca possam rastrear e indexar eficazmente o seu conteúdo. Ao otimizar elementos como a estrutura e a navegação do seu site, o SEO técnico facilita o rastreamento suave do seu site por bots de mecanismos de pesquisa. Essa acessibilidade é vital para garantir que seu conteúdo seja notado e indexado de forma adequada.

Podemos ser um pouco tendenciosos, mas acreditamos que nosso site é um ótimo exemplo de site com ótima arquitetura!

Em segundo lugar, o SEO técnico influencia diretamente as classificações do seu mecanismo de pesquisa. A velocidade do site e a capacidade de resposta móvel são fatores de classificação confirmados no algoritmo de pesquisa do Google e, além disso, ter uma marcação HTML bem estruturada desempenha um papel vital na forma como os mecanismos de pesquisa avaliam a qualidade e relevância do seu site. Um site bem otimizado tem maior probabilidade de ter uma classificação mais elevada nos motores de busca.

Por fim, o SEO técnico contribui para que seu site tenha uma ótima experiência de usuário. Enquanto você trabalha em seu SEO técnico, práticas como otimizar o tempo de carregamento da página e melhorar URLs também aumentarão a satisfação do usuário. Uma experiência de usuário aprimorada leva à redução das taxas de rejeição e ao aumento das taxas de engajamento, o que melhorará indiretamente o desempenho do seu site nas pesquisas.

Em última análise, o SEO técnico serve como a base sobre a qual são construídas estratégias eficazes de SEO! Isso garante que seu conteúdo não seja apenas de primeira linha, mas também detectável e acessível. Isso atrairá os mecanismos de pesquisa e, mais importante, os usuários.

Quais são as características de um site tecnicamente otimizado?

Não importa o site, seja um site de comércio eletrônico que gera milhões de libras em receitas ou um site de brochura apresentando os serviços de uma empresa de encanamento local, todos os sites têm as mesmas características quando se trata de serem bem otimizados do ponto de vista técnico de SEO .

É rápido

Um site bem otimizado carregará rapidamente em todos os dispositivos (desktop, tablet e celular) e condições de rede. As páginas de carregamento rápido melhoram a experiência do usuário em seu site e são preferidas pelos mecanismos de pesquisa, levando potencialmente a classificações mais altas.

Sabemos que o Google lista a aprovação nos principais testes vitais da web como um fator de classificação confirmado, o que é raro para eles, portanto, garantir que seu site seja rápido e passe nos testes CWV é crucial.

É rastreável

Isso deveria ser óbvio, mas os sites devem ser rastreáveis pelos mecanismos de pesquisa. Se um bot de mecanismo de pesquisa (como o Googlebot) não conseguir rastrear seu site de maneira eficaz, você encontrará problemas com a classificação de sua página nas SERPs.

Arquivos Robots.txt e metatags de robôs devem ser configurados corretamente. Isso ajudará a orientar os bots dos mecanismos de pesquisa sobre quais páginas rastrear e indexar e quais páginas deixar de lado. Nem todas as páginas do seu site devem ser rastreadas. Especialmente páginas de administração e páginas que contêm dados de clientes.

Preserva o patrimônio do link

Sites bem otimizados tecnicamente fazem tudo o que podem para preservar o máximo possível de valor de link.

Em primeiro lugar, o site usará links internos que guiarão os usuários (e os bots dos mecanismos de pesquisa) para o conteúdo relevante do site. Isso melhora a navegação no site, ajuda a distribuir o valor do link para outras páginas e mantém os usuários no site por mais tempo.

Em segundo lugar, o site estará totalmente livre (de preferência) de links quebrados e cadeias de redirecionamento desnecessárias. Isso garante uma experiência de usuário perfeita e rastreamento eficiente pelos mecanismos de pesquisa.

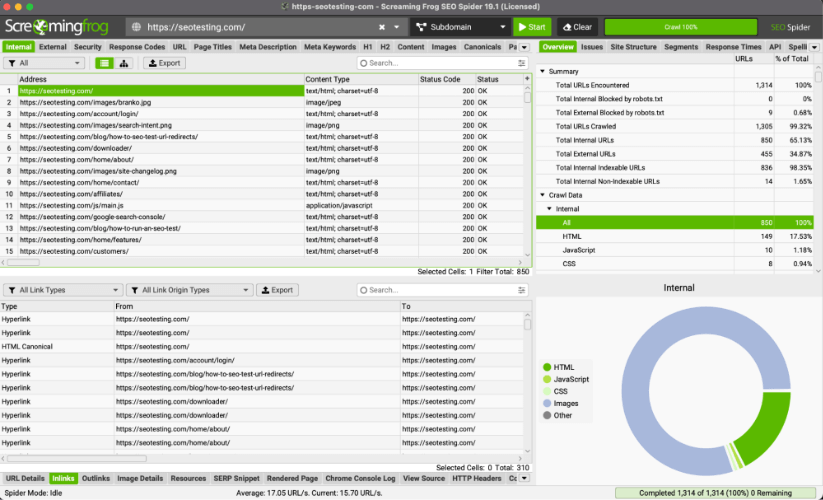

Dica profissional: você pode usar o ScreamingFrog para identificar links quebrados e redirecionar cadeias que não precisam estar lá.

É compatível com dispositivos móveis

Todos os sites devem ser projetados para serem responsivos e funcionais em dispositivos móveis. Com o uso cada vez maior de smartphones para navegação (em 2023, 63% do tráfego de pesquisa orgânica do Google nos EUA se origina de dispositivos móveis), a compatibilidade com dispositivos móveis é um fator crucial tanto na experiência do usuário quanto nas classificações.

É seguro

Todos os sites devem garantir que seus sites usem o protocolo HTTPS seguro.

O que isso faz é garantir que seu site tenha criptografia de dados adequada e aumentará a confiança que os usuários têm ao usar seu site. Esta confiança é especialmente importante quando dados financeiros são transmitidos em websites, tais como informações de cartão de crédito.

O Google também confirmou que o uso do protocolo HTTPS é um fator de classificação. Não sabemos qual o peso que o algoritmo atribui a isso, mas podemos adivinhar que isso é mais um fator quando se trata de sites YMYL (Your Money Your Life).

Ele usa dados estruturados

A marcação de esquema é implementada em sites para fornecer contexto adicional sobre o conteúdo. Isso permitirá que os mecanismos de pesquisa exibam rich snippets nas SERPs ao exibir seu site, aumentando as taxas de cliques e trazendo mais tráfego para seu site.

Rastejando

Abordamos esse assunto brevemente em nosso artigo sobre como aprender SEO em 2023, mas agora passaremos pelas quatro etapas do SEO técnico que levam seu site das páginas HTML, CSS e JavaScript às classificações no SERP. Rastreamento, renderização, indexação e classificação.

O primeiro passo nesta jornada é engatinhar.

Rastreamento refere-se ao processo pelo qual mecanismos de busca como Google e Bing navegam sistematicamente e aprendem mais sobre o conteúdo de sites na internet. O objetivo do rastreamento é coletar informações sobre páginas da web, o que inclui:

- Seu conteúdo.

- Sua estrutura.

- Outra informação relevante.

Os mecanismos de pesquisa podem então usar esses dados para indexar e classificar com eficácia (falaremos sobre isso mais tarde) e exibir suas páginas da web nas SERPs.

Os mecanismos de pesquisa usam bots, chamados crawlers, para navegar pela enorme quantidade de páginas da web online. Os rastreadores começam visitando algumas páginas da web conhecidas, geralmente páginas populares ou atualizadas com frequência. A partir daí, eles seguem os links encontrados nessas páginas para “descobrir” novas páginas que podem então renderizar, indexar e classificar.

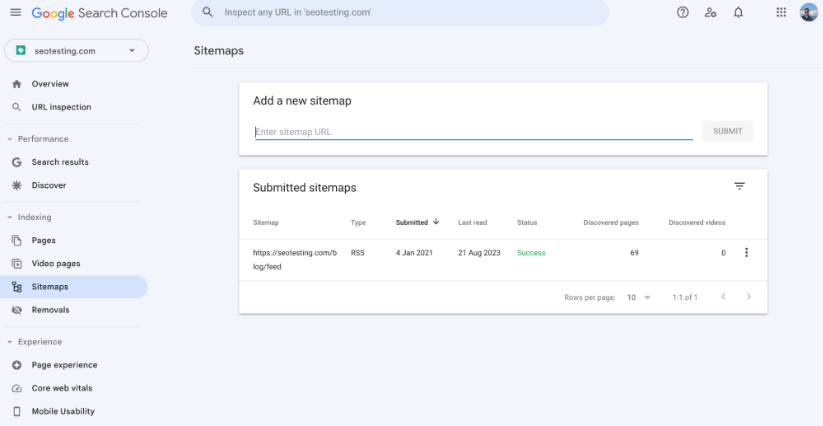

Mapa do site XML

Um sitemap XML é um arquivo que fornece aos mecanismos de pesquisa uma lista estruturada de todos os URLs do seu site. É uma ferramenta que ajuda os rastreadores dos mecanismos de pesquisa a compreender a organização do conteúdo do seu site e garante que eles possam descobrir e indexar todas as suas páginas importantes de maneira eficaz.

Garantir que você tenha um mapa do site XML em seu site é essencial quando se trata de SEO técnico, pois ajuda a rastrear suas páginas de várias maneiras diferentes:

Ter um mapa do site XML em seu site fornece aos bots de mecanismos de pesquisa uma lista centralizada de URLs que você gostaria que eles rastreassem e indexassem. Isso o ajudará a garantir que todas as suas páginas essenciais, como páginas de listagem de produtos e páginas de exibição de produtos, sejam incluídas nos índices dos mecanismos de pesquisa e, esperançosamente, nas páginas de resultados dos mecanismos de pesquisa.

Você também pode usar o mapa do site para especificar a prioridade e alterar a frequência de cada URL do seu site. É importante observar que os mecanismos de pesquisa podem não seguir exatamente essas regras, mas isso pode dar aos rastreadores uma ideia da importância das diferentes páginas do seu site e da frequência com que elas são atualizadas.

Embora os mecanismos de pesquisa usem vários fatores para decidir quais páginas rastrear e indexar primeiro, o mapa do site pode ajudar a destacar páginas importantes (ou recém-atualizadas). Isso pode guiar os bots dos mecanismos de pesquisa até essas páginas e ajudar a rastreá-las e indexá-las rapidamente. Se você não tivesse um mapa do site, estaria contando com rastreadores para encontrar essas páginas automaticamente, por meio do uso de links internos e externos, etc. O que é um processo muito mais longo.

Sites grandes, com centenas de milhares (ou até milhões de URLs), mapas de sites (e vários mapas de sites) ajudarão os rastreadores a descobrir cada página que você deseja indexar com mais eficiência. Isso é ótimo, pois ajuda você a gerenciar seu orçamento de rastreamento com muito mais eficiência. Isso não é um problema para sites menores, pois esses sites pequenos não terão problemas com seu orçamento de rastreamento.

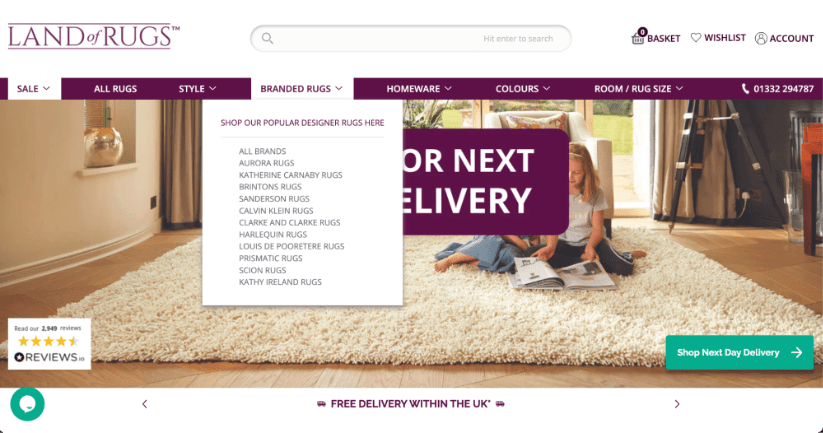

Estrutura do site

A estrutura do seu site desempenhará um papel crucial na determinação de como os bots dos mecanismos de pesquisa navegam e indexam seu conteúdo. Uma estrutura de site bem organizada não apenas facilitará o rastreamento eficiente por bots de mecanismos de pesquisa, mas também melhorará a experiência geral que os usuários reais têm em seu site.

Aqui está um exemplo de site de comércio eletrônico com uma boa estrutura de site. Todas as páginas importantes (páginas de lista de produtos) neste exemplo são facilmente acessadas a partir da barra de navegação da página inicial, transmitindo o máximo possível de valor de link para essas páginas e garantindo que os rastreadores possam encontrá-las facilmente.

Quando as páginas são organizadas em categorias e subcategorias simples e fáceis de entender, fica muito mais fácil para os rastreadores seguirem links e indexarem conteúdo de forma sistemática. Esse arranjo hierárquico garante que páginas cruciais estejam mais próximas da página inicial, aumentando suas chances de serem descobertas e indexadas rapidamente.

Os links internos na estrutura de um site guiarão os rastreadores dos mecanismos de pesquisa por diferentes seções do seu site de maneira mais eficaz. Links internos relevantes e bem posicionados ajudam a distribuir o valor do link entre as páginas, permitindo que os rastreadores descubram uma gama muito mais ampla de conteúdo do que conseguiriam sem que links internos fossem colocados em todo o seu conteúdo.

As páginas órfãs (páginas sem links apontando para elas) devem ser evitadas, pois representam um enorme desafio para os rastreadores. Uma estrutura de site robusta, com links internos adequados, evita isso.

No geral, a estrutura do seu site servirá como uma estrutura crucial que molda a forma como os mecanismos de pesquisa rastreiam e indexam o seu conteúdo. Ao implementar uma hierarquia de sites clara, adicionar links contextuais relevantes e otimizar a alocação de orçamento de rastreamento (se necessário), os proprietários de sites e profissionais de marketing podem influenciar positivamente a forma como os mecanismos de pesquisa rastreiam seus sites.

Estrutura de URL

A estrutura de URL do seu site terá um impacto direto no rastreamento do seu site. Garantir que você tenha uma estrutura de URL bem organizada (e descritiva) aumentará a eficiência dos rastreadores na compreensão do conteúdo de cada página. URLs claros (e curtos) fornecem um contexto valioso sobre o tópico e a hierarquia da localização da página no site.

Por exemplo, um URL parecido com: https://example.com/blog/head-topic-1 informará ao rastreador do mecanismo de pesquisa que esta página é essencial no blog, sobre um dos principais tópicos do site.

Por outro lado, URLs complicados ou sem sentido (um bom exemplo é https://example.com/12642/test-category/test-page125253/) podem confundir os rastreadores quando eles navegam em seu site. Isso prejudicará a capacidade de interpretação do conteúdo, bem como a relevância e importância da página do seu site. Uma estrutura de URL limpa, sem parâmetros e símbolos desnecessários, aumentará as chances de suas páginas serem rastreadas de forma eficaz.

Além disso, embora não esteja diretamente relacionado ao rastreamento, a estrutura do seu URL terá um impacto direto na experiência do usuário e nas taxas de cliques do seu site. Um URL conciso e relevante tem muito, muito mais probabilidade de atrair cliques de usuários nos resultados de pesquisa, o que pode (indiretamente) impactar a classificação geral do mecanismo de pesquisa do seu site.

Arquivos Robots.txt

Seu arquivo robots.txt tem um enorme poder sobre como os mecanismos de pesquisa navegam e rastreiam seu site. Este documento, situado no núcleo do seu site, detalha as diretrizes para os rastreadores dos mecanismos de pesquisa, ditando como o seu site deve ser rastreado. Incluindo quais páginas podem ser rastreadas e quais páginas devem ser deixadas de lado.

É importante notar neste estágio que, embora seu arquivo robots.txt possa impedir a entrada de rastreadores em páginas ou seções específicas de seu site, ele não garante que suas páginas não serão rastreadas por caminhos alternativos. Alguns mecanismos de pesquisa ainda podem registrar páginas que serão excluídas do rastreamento se forem encontradas por outras formas, por exemplo, links internos em seu site.

Se o seu arquivo robots.txt estiver repleto de erros ou regras rígidas, você pode descobrir que isso impede que os mecanismos de pesquisa rastreiem conteúdo importante, o que pode “lançar uma sombra” no desempenho do seu site nas SERPs. É importante ficar de olho no arquivo robots.txt regularmente para garantir que todas as regras estejam funcionando corretamente.

Análise de arquivo de log

A análise dos arquivos de log do seu site pode ter um grande impacto na forma como os mecanismos de pesquisa rastreiam o seu site, e isso é algo que os próprios profissionais de marketing podem fazer com as ferramentas certas! Os arquivos de log são, essencialmente, registros que mostram quais partes do seu site os mecanismos de pesquisa visitam e com que frequência os rastreadores dos mecanismos de pesquisa visitam essas partes do seu site. Essencialmente, isso permite determinar quais páginas do seu site são consideradas importantes pelos mecanismos de pesquisa, permitindo que você use isso para obter vantagem.

Isso ajuda os profissionais de marketing a decidir em quais páginas vale a pena gastar mais tempo (e potencialmente dinheiro), garantindo que os mecanismos de pesquisa prestem atenção às coisas certas. Além disso, a análise do arquivo de log pode mostrar se os mecanismos de pesquisa estão achando seu site fácil de entender e navegar ou se estão tendo problemas. Isso pode orientar mudanças, como corrigir a forma como as páginas estão conectadas (geralmente por meio de links internos) ou organizar melhor os endereços da web.

Uma das minhas palestras favoritas sobre isso é de Matthew Barby, de 2018, quando ele era vice-presidente de crescimento orgânico da HubSpot, encontre o segmento exato da palestra às 25h07:

Renderização

Renderização refere-se ao processo de como os motores de busca analisam e entendem o conteúdo e a estrutura do seu site, para determinar sua classificação nas SERPs. Esse processo envolve duas etapas principais, rastreamento (que abordamos) e indexação (sobre a qual falaremos em breve).

Durante o rastreamento, os bots dos mecanismos de pesquisa percorrem a web, visitando páginas da web e coletando dados HTML. No entanto, nem todo o conteúdo fica imediatamente visível na marcação HTML. É aqui que a renderização entra em jogo.

A renderização vai além da análise básica do HTML, levando em consideração os elementos dinâmicos frequentemente apresentados em sites modernos que podem não ser visíveis no HTML bruto. Isto inclui conteúdo carregado através de JavaScript, AJAX ou outras linguagens de script, bem como a folha de estilo CSS da página. Os bots de mecanismos de busca, em sua tentativa de simular a experiência do usuário, executam JavaScript e reúnem o conteúdo totalmente renderizado. Esse conteúdo é então usado para construir um índice, um banco de dados de informações sobre a página da web.

Para obter resultados ideais de SEO, é crucial garantir que seu site seja facilmente renderizado por bots de mecanismos de pesquisa. Isso envolve o uso de técnicas como renderização no servidor (SSR) ou pré-renderização para sites com muito JavaScript. Fornecer metadados (como meta tags e descrições) ajudará os mecanismos de pesquisa a compreender o contexto e o significado do conteúdo. O manuseio adequado de tags canônicas e o gerenciamento de redirecionamentos também são importantes para evitar problemas de conteúdo duplicado.

Indexação

Indexação refere-se ao processo de coleta, organização e armazenamento de informações sobre páginas da web para que possam ser recuperadas rapidamente e exibidas nos resultados da pesquisa quando um usuário pesquisa uma consulta relevante. Depois que um rastreador da web rastreia uma página da web e renderiza seu conteúdo, as informações são adicionadas ao índice do mecanismo de pesquisa.

O índice, essencialmente, é um enorme banco de dados que contém informações sobre o conteúdo do site e a estrutura das páginas da web na Internet. Ter acesso a este vasto banco de dados de informações permite que os mecanismos de pesquisa respondam rapidamente às dúvidas dos usuários, encontrando páginas relevantes no índice e exibindo-as nas SERPs.

Durante o processo de indexação, os mecanismos de pesquisa extraem informações importantes das páginas da web rastreadas e renderizadas, como conteúdo, metadados, imagens e links. Essas informações são então armazenadas de maneira estruturada, o que permite que os mecanismos de pesquisa correspondam rapidamente às consultas dos usuários com páginas relevantes.

Existem algumas coisas que você deve fazer para ajudar a indexar suas páginas com eficiência.

Resolva problemas de conteúdo duplicado e canibalização de palavras-chave

Resolver problemas de conteúdo duplicado e canibalização de palavras-chave oferecerá benefícios significativos quando se trata de indexar suas páginas rapidamente.

Ao se livrar do conteúdo duplicado, você evita qualquer confusão para os mecanismos de pesquisa, permitindo identificar com precisão a versão principal do seu conteúdo.

Além do mais, resolver problemas de canibalização de palavras-chave – onde várias páginas têm como alvo as mesmas palavras-chave – fornece sinais claros aos mecanismos de pesquisa sobre o foco de cada página. Essa clareza ajuda na indexação e classificação eficientes, pois os mecanismos de pesquisa podem entender a finalidade exata de todas as suas páginas.

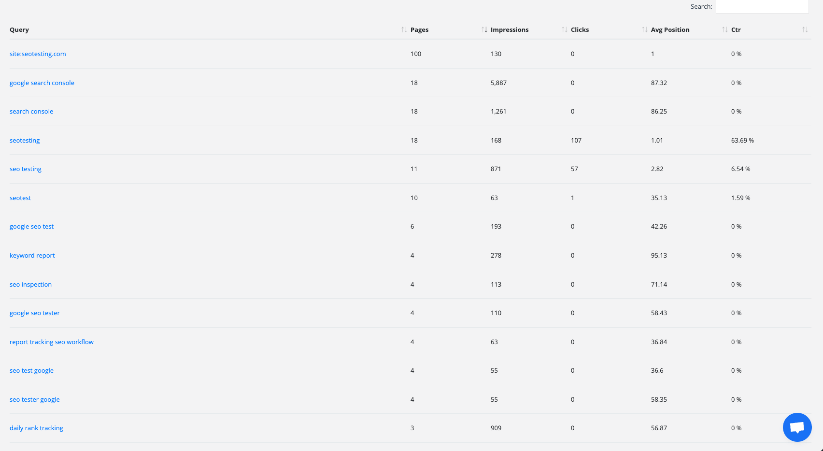

Uma imagem mostrando o Relatório de canibalização de palavras-chave no SEOTesting. Este relatório pode ajudá-lo a identificar e corrigir rapidamente quaisquer problemas de canibalização de palavras-chave em seu site.

Otimizar metadados (como tags de título e meta descrições), bem como ajustar estruturas de links internos, também ajudará a contribuir para uma indexação rápida e fácil. Essas ações, quando feitas corretamente, direcionam os mecanismos de busca para as páginas mais relevantes e importantes.

Além disso, consolidar o conteúdo e evitar a canibalização de palavras-chave concentrará a autoridade do seu conteúdo em uma única página. Isso resultará em maior autoridade da página, incentivando os mecanismos de pesquisa a priorizar e classificar essa página oficial com mais destaque nas SERPs.

Redirecionamentos de auditoria

Examinar como funcionam os redirecionamentos do seu site pode ajudar a melhorar a rapidez com que os mecanismos de pesquisa indexam o seu conteúdo. Também pode ajudar a melhorar o desempenho geral do seu site. Os redirecionamentos agem como mercados, orientando os usuários e os mecanismos de pesquisa para páginas diferentes quando necessário. Se não forem bem gerenciados, eles podem retardar o processo de indexação ou impedir completamente a indexação das páginas. Ao realizar uma "auditoria de redirecionamento", você pode aprimorar a indexação de diversas maneiras significativas.

Em primeiro lugar, lidar com redirecionamentos excessivos ajudará os mecanismos de pesquisa a trabalhar de forma mais eficaz ao indexar o seu site. Às vezes, eles podem encontrar vários redirecionamentos, o que pode retardar a indexação do seu conteúdo. Ao encontrar e remover redirecionamentos desnecessários, você pode ajudar os mecanismos de pesquisa a acessar seu conteúdo rapidamente, dando-lhes uma chance melhor de serem indexados (e, portanto, classificados) rapidamente também.

Concluir uma auditoria de redirecionamento também permitirá que você resolva um problema técnico comum de SEO. Redirecionar cadeias. Essas cadeias podem acontecer quando um redirecionamento leva a outro, que leva a outro, que leva a outro, e assim por diante. Eles podem confundir os mecanismos de pesquisa e consumir muito tempo. Sabemos que quando um bot de mecanismo de pesquisa demora muito para tentar indexar uma página, ele seguirá em frente e não indexará essa página. Uma auditoria permitirá que você encontre e corrija essas cadeias, permitindo que os mecanismos de pesquisa alcancem seu conteúdo sem problemas.

Por fim, uma auditoria como essa ajudará os mecanismos de pesquisa a compreender o seu site com precisão. Quando os redirecionamentos são bem estruturados, os mecanismos de busca podem interpretar melhor a importância do seu conteúdo. Quando os mecanismos de pesquisa entendem melhor a importância do seu conteúdo, suas páginas importantes têm mais chances de serem indexadas rapidamente.

Corrigir erros de HTTP e HTTPS

A correção de erros de HTTP e HTTPS é vital para garantir que suas páginas sejam indexadas corretamente. Quando os bots dos mecanismos de pesquisa encontram esses tipos de erros, eles têm dificuldade em acessar e compreender o seu conteúdo. Quando um bot de mecanismo de pesquisa não consegue acessar ou compreender seu conteúdo, ele não consegue indexá-lo.

A solução desses problemas melhora a indexação das seguintes maneiras:

Em primeiro lugar, resolver erros HTTP como “404 Not Found” garante que suas páginas sejam acessíveis tanto aos usuários quanto aos mecanismos de pesquisa. Quando as páginas retornam esses erros, os mecanismos de pesquisa os interpretam como conteúdo ausente, levando à exclusão dos resultados da pesquisa. A correção desses erros dá aos rastreadores um “caminho claro” para indexar seu conteúdo, aumentando as chances de indexá-lo e classificá-lo.

Em segundo lugar, a transição de HTTP para HTTPS é crucial para segurança e indexação. Os mecanismos de pesquisa priorizam fortemente sites seguros (HTTPS) em vez de sites não seguros (HTTP) em seus algoritmos de classificação. O Google até confirmou isso! Ao migrar para HTTPS e garantir uma experiência de navegação segura aos usuários, você aumenta a credibilidade do seu site, melhorando indiretamente sua capacidade de indexação e classificação.

Por último, a implementação consistente de HTTPS e a resolução de erros relacionados a HTTPS evitam que usuários e mecanismos de pesquisa encontrem problemas de “conteúdo misto”. O conteúdo misto ocorre quando elementos seguros e não seguros são carregados na mesma página. Isso poderia causar avisos de segurança e impactar negativamente a experiência do usuário.

Em essência, lidar com erros de HTTP e HTTPS remove barreiras que impedem os mecanismos de pesquisa de acessar e compreender o seu conteúdo. Essa abordagem altamente proativa otimiza o processo de indexação, aumenta a visibilidade nos resultados de pesquisa e melhora a experiência do usuário em seu site.

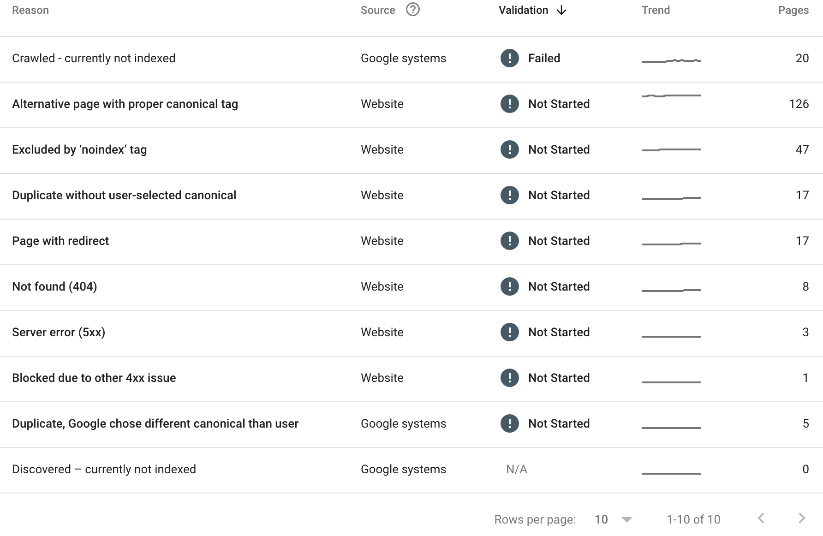

Veja o seu “Relatório de indexação de páginas” no Google Search Console

O Google Search Console é uma mina de ouro para avaliar como seu conteúdo está sendo indexado. No Relatório de indexação de páginas, você poderá ver todas as páginas do seu site que não foram indexadas. Você também poderá ver o motivo pelo qual a página não foi indexada.

Aqui está um exemplo:

Acima (Relatório de indexação de páginas do SEOTesting), podemos ver que:

- 20 páginas foram rastreadas, mas não estão indexadas no momento.

- 126 páginas possuem uma tag canônica adequada.

- 47 páginas foram excluídas pela tag 'noindex'.

- Descobriu-se que 17 páginas eram duplicadas, sem nenhum canônico selecionado pelo usuário.

- 17 páginas têm um redirecionamento em vigor.

- 8 páginas retornaram um erro 404.

- 3 páginas retornaram um erro de servidor 5xx.

- 1 página foi bloqueada devido a outro problema 4xx.

- 5 páginas foram encontradas como duplicadas e o Google escolheu um canônico diferente.

Nem todos os motivos acima são problemas, mas vale a pena para nós, como equipe de marketing, descobrir por que certas páginas não foram indexadas e corrigir o máximo possível desses problemas.

Classificação

A classificação dos mecanismos de pesquisa é o culminar dos processos de rastreamento, renderização e indexação, onde os mecanismos de pesquisa determinam a ordem em que as páginas da web aparecem nas SERPs. O objetivo é apresentar aos usuários o conteúdo mais relevante e valioso, com base em suas consultas de pesquisa.

Basicamente, a classificação depende de algoritmos complexos que avaliam uma variedade de fatores para determinar a relevância e autoridade de uma página da web. Um dos aspectos fundamentais é a relevância da palavra-chave – quão bem o conteúdo corresponde às palavras e frases que os usuários inserem em suas pesquisas. Páginas com alta relevância de palavras-chave tendem a ter melhor classificação.

No entanto, a relevância da palavra-chave por si só não é suficiente. Os motores de busca também consideram a qualidade e autoridade do site. Backlinks de sites confiáveis, confiáveis e relevantes (isso é crucial), são um forte indicador da credibilidade de uma página. Quanto mais backlinks de alta qualidade uma página tiver, maior será a probabilidade de ela ter uma classificação mais elevada.

A experiência que os usuários estão tendo em seu site também desempenha um papel importante na classificação. Páginas que carregam rapidamente, são compatíveis com dispositivos móveis e fornecem uma experiência de navegação tranquila para o usuário são fortemente preferidas pelos mecanismos de pesquisa. Conteúdo envolvente e valioso que mantém os usuários em seu site, navegando, por mais tempo, também sinaliza aos mecanismos de pesquisa que pode valer a pena ter uma classificação mais elevada do seu site.

A personalização é outro aspecto da classificação. Os mecanismos de pesquisa levarão em consideração a localização, o histórico de pesquisa e as preferências do usuário para personalizar os resultados da pesquisa e oferecer ao usuário a melhor experiência possível. Isso significa que a mesma consulta provavelmente produzirá resultados diferentes para usuários diferentes.

É importante lembrar que, não importa o que outras postagens de blog mencionem, não sabemos qual o peso que o Google (e outros mecanismos de busca) atribui a diferentes fatores para diferentes consultas. Para uma pergunta, talvez você precise confiar mais em backlinks confiáveis e relevantes. Por outro lado, você pode precisar garantir que sua experiência de usuário seja correta. Tudo isso se resume ao tempo na indústria, aprendendo o algoritmo e melhorando à medida que avança.

Compreender os diversos aspectos do SEO é vital para o sucesso nas SERPs. Este artigo explorou a importância do SEO técnico, as características dos sites otimizados e a mecânica do SEO técnico, desde o rastreamento até a classificação.

O SEO técnico constrói uma base sólida para o seu site, otimizando elementos para melhor velocidade e estrutura. Isso melhora a navegação, a compreensão do conteúdo e a experiência do usuário.

Resumindo, o SEO técnico é fundamental. Ao corrigir erros e otimizar a estrutura do site, você poderá aumentar sua presença online.

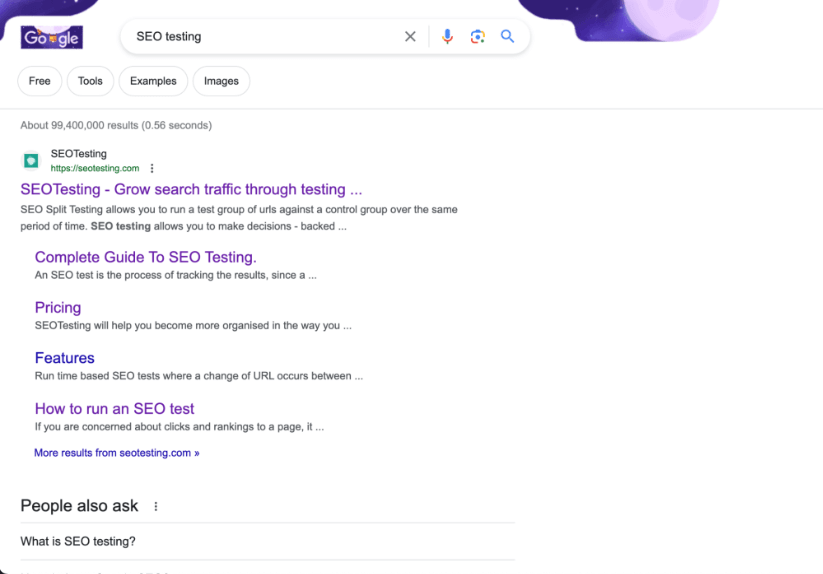

Quer turbinar o uso do Google Search Console e levar seu SEO para o próximo nível, implementando testes de SEO em sua rotina? Experimente o SEOTesting. No momento, estamos executando um teste gratuito de 14 dias, sem necessidade de cartão de crédito para se inscrever. Experimente a ferramenta hoje e diga-nos o que você pensa!