Desafios e soluções de web scraping: navegando pelas complexidades

Publicados: 2023-09-13Web scraping tornou-se uma técnica inestimável para extrair dados de sites. Se você precisa coletar informações para fins de pesquisa, rastrear preços ou tendências ou automatizar determinadas tarefas on-line, o web scraping pode economizar tempo e esforço. Navegar pelas complexidades dos sites e enfrentar vários desafios de web scraping pode ser uma tarefa difícil. Neste artigo, nos aprofundaremos na simplificação do processo de web scraping, obtendo uma compreensão abrangente dele. Abordaremos as etapas envolvidas, selecionando as ferramentas apropriadas, identificando os dados de destino, navegando nas estruturas do site, lidando com autenticação e captcha e lidando com conteúdo dinâmico.

Compreendendo a raspagem da Web

Web scraping é o procedimento de extração de dados de sites por meio da análise e análise de código HTML e CSS. Engloba o envio de solicitações HTTP para páginas web, recuperando o conteúdo HTML e posteriormente extraindo as informações pertinentes. Embora a web scraping manual por meio da inspeção do código-fonte e da cópia de dados seja uma opção, muitas vezes é ineficiente e demorada, especialmente para coleta extensa de dados.

Para automatizar o processo de web scraping, linguagens de programação como Python e bibliotecas como Beautiful Soup ou Selenium, bem como ferramentas dedicadas de web scraping como Scrapy ou Beautiful Soup podem ser empregadas. Essas ferramentas oferecem funcionalidades para interagir com sites, analisar HTML e extrair dados de forma eficiente.

Desafios de raspagem na Web

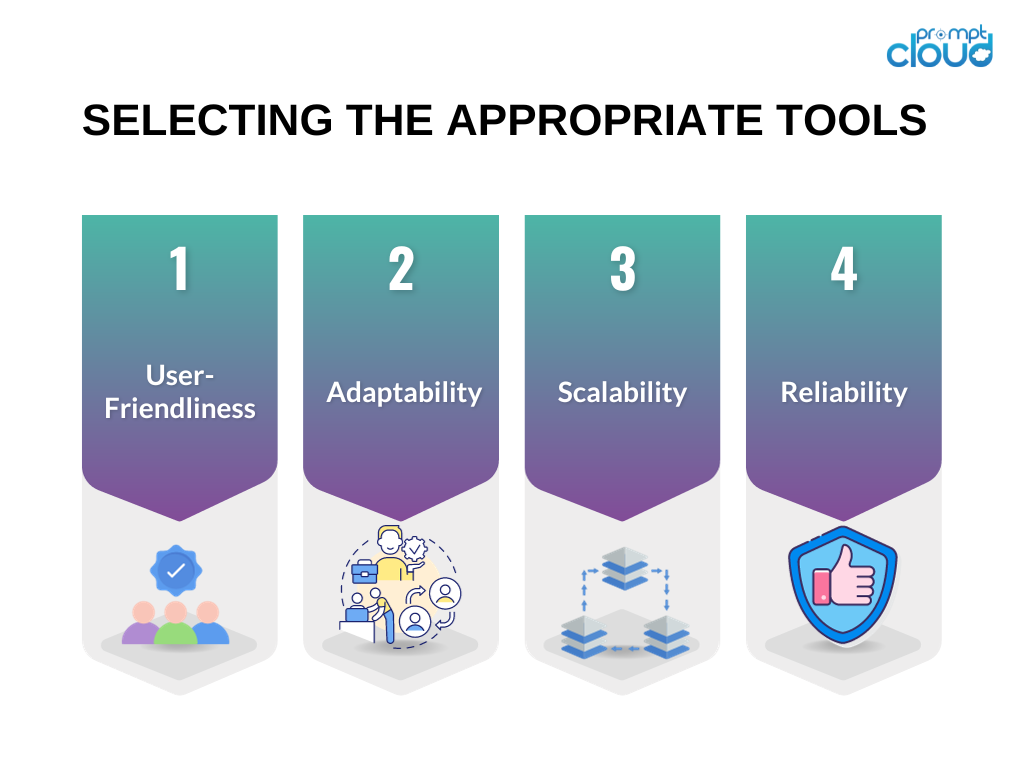

Selecionando as ferramentas apropriadas

Selecionar as ferramentas certas é crucial para o sucesso de seu esforço de web scraping. Aqui estão algumas considerações ao escolher as ferramentas para seu projeto de web scraping:

Facilidade de uso : Priorize ferramentas com interfaces amigáveis ou que forneçam documentação clara e exemplos práticos.

Adaptabilidade : Opte por ferramentas capazes de lidar com diversos tipos de sites e se adaptar às mudanças nas estruturas dos sites.

Escalabilidade : se sua tarefa de coleta de dados envolve uma quantidade substancial de dados ou requer recursos avançados de web scraping, considere ferramentas que possam lidar com grandes volumes e oferecer recursos de processamento paralelo.

Confiabilidade : certifique-se de que as ferramentas estejam equipadas para gerenciar vários tipos de erros, como tempos limite de conexão ou erros de HTTP, e venham com mecanismos integrados de tratamento de erros.

Com base nesses critérios, ferramentas amplamente utilizadas como Beautiful Soup e Selenium são frequentemente recomendadas para projetos de web scraping.

Identificando dados de destino

Antes de iniciar um projeto de web scraping, é essencial identificar os dados alvo que você deseja extrair de um site. Podem ser informações sobre produtos, artigos de notícias, postagens em mídias sociais ou qualquer outro tipo de conteúdo. Compreender a estrutura do site de destino é crucial para extrair com eficácia os dados desejados.

Para identificar os dados de destino, você pode usar ferramentas de desenvolvedor de navegador, como Chrome DevTools ou Firefox Developer Tools. Essas ferramentas permitem inspecionar a estrutura HTML de uma página da web, identificar os elementos específicos que contêm os dados necessários e compreender os seletores CSS ou expressões XPath necessários para extrair esses dados.

Navegando nas estruturas do site

Os sites podem ter estruturas complexas com elementos HTML aninhados, conteúdo JavaScript dinâmico ou solicitações AJAX. Navegar por essas estruturas e extrair as informações relevantes requer análises e estratégias cuidadosas.

Aqui estão algumas técnicas para ajudá-lo a navegar em estruturas complexas de sites:

Use seletores CSS ou expressões XPath : ao compreender a estrutura do código HTML, você pode usar seletores CSS ou expressões XPath para direcionar elementos específicos e extrair os dados desejados.

Lidar com paginação : se os dados de destino estiverem espalhados por várias páginas, você precisará implementar a paginação para extrair todas as informações. Isso pode ser feito automatizando o processo de clicar nos botões “próximo” ou “carregar mais” ou construindo URLs com parâmetros diferentes.

Lidar com elementos aninhados : às vezes, os dados de destino são aninhados em vários níveis de elementos HTML. Nesses casos, você precisa percorrer os elementos aninhados usando relacionamentos pai-filho ou irmãos para extrair as informações desejadas.

Lidando com autenticação e Captcha

Alguns sites podem exigir autenticação ou apresentar captchas para evitar raspagem automatizada. Para superar esses desafios de web scraping, você pode usar as seguintes estratégias:

Gerenciamento de sessão : mantenha o estado da sessão com cookies ou tokens para lidar com os requisitos de autenticação.

Falsificação de agente de usuário : emule diferentes agentes de usuário para aparecerem como usuários regulares e evitar a detecção.

Serviços de resolução de captchas : use serviços de terceiros que podem resolver captchas automaticamente em seu nome.

Lembre-se de que, embora a autenticação e os captchas possam ser ignorados, você deve garantir que suas atividades de web scraping estejam em conformidade com os termos de serviço e as restrições legais do site.

Lidando com conteúdo dinâmico

Os sites costumam usar JavaScript para carregar conteúdo dinamicamente ou buscar dados por meio de solicitações AJAX. Os métodos tradicionais de web scraping podem não capturar esse conteúdo dinâmico. Para lidar com conteúdo dinâmico, considere as seguintes abordagens:

Use navegadores headless : ferramentas como o Selenium permitem que você controle navegadores reais de forma programática e interaja com o conteúdo dinâmico.

Utilize bibliotecas de web scraping : Certas bibliotecas como Puppeteer ou Scrapy-Splash podem lidar com renderização de JavaScript e extração de conteúdo dinâmico.

Ao usar essas técnicas, você pode garantir a remoção de sites que dependem fortemente de JavaScript para entrega de conteúdo.

Implementando tratamento de erros

A raspagem da Web nem sempre é um processo tranquilo. Os sites podem alterar suas estruturas, retornar erros ou impor limitações às atividades de scraping. Para mitigar os riscos associados a esses desafios de web scraping, é importante implementar mecanismos de tratamento de erros:

Monitore as alterações do site : verifique regularmente se a estrutura ou o layout do site mudou e ajuste seu código de scraping de acordo.

Mecanismos de nova tentativa e tempo limite : implemente mecanismos de nova tentativa e tempo limite para lidar com erros intermitentes, como tempos limite de conexão ou erros de HTTP normalmente.

Registrar e tratar exceções : capture e trate diferentes tipos de exceções, como erros de análise ou falhas de rede, para evitar que seu processo de scraping falhe completamente.

Ao implementar técnicas de tratamento de erros, você pode garantir a confiabilidade e robustez do seu código de web scraping.

Resumo

Concluindo, os desafios do web scraping podem ser facilitados pela compreensão do processo, escolha das ferramentas certas, identificação dos dados alvo, navegação nas estruturas do site, tratamento da autenticação e captchas, tratamento do conteúdo dinâmico e implementação de técnicas de tratamento de erros. Seguindo essas práticas recomendadas, você pode superar as complexidades do web scraping e coletar com eficiência os dados necessários.