Un ghid complet pentru web scraping

Publicat: 2023-09-14În era digitală, unde există o mulțime de informații disponibile pe internet, poate fi o sarcină descurajantă să colectezi și să colectezi manual date de pe diverse site-uri web. Aici este locul în care web scraping este utilă.

Ce este Web Scraping?

Web scraping se referă la extragerea automată a datelor de pe site-uri web. Cu ajutorul unui software specializat, cunoscut în mod obișnuit ca web scrapers sau web crawler, companiile pot colecta date din diverse surse online și le pot converti într-un format structurat.

Web scraping implică navigarea prin site-uri web și extragerea unor puncte de date specifice care sunt relevante pentru nevoile dvs. de afaceri. Utilizând instrumente și servicii web scraping, companiile pot automatiza procesul de colectare și extragere a datelor, economisind astfel timp și resurse.

Imaginați-vă că conduceți o afacere de comerț electronic și doriți să urmăriți prețurile concurenților dvs. În loc să vizitați manual site-ul web al fiecărui concurent și să notați prețurile, puteți utiliza un web scraper pentru a extrage automat prețurile. Acest lucru nu numai că vă economisește timp, dar vă asigură și că aveți informații exacte și actualizate. Serviciile de web scraping pot fi utilizate în diverse scopuri, cum ar fi cercetarea de piață, generarea de clienți potențiali, analiza sentimentelor și multe altele. Posibilitățile sunt nesfârșite.

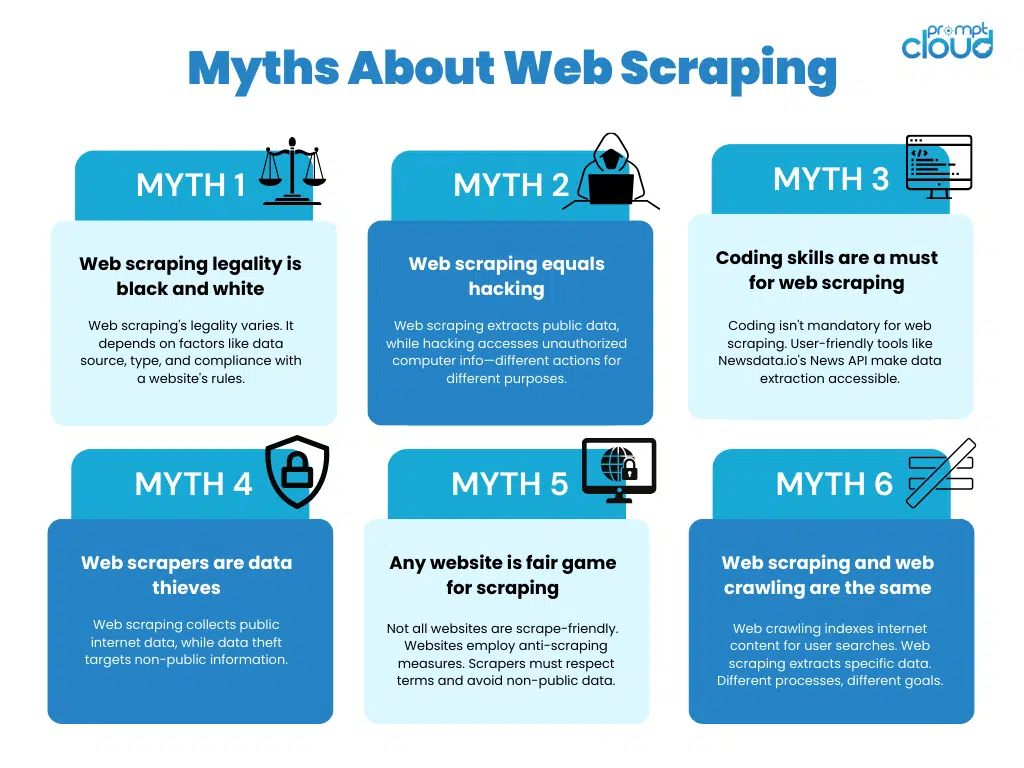

Web Scraping este legal?

Deși web scraping oferă numeroase avantaje, este esențial pentru companii să înțeleagă și să adere la îndrumările legale și etice în jurul utilizării sale. Ignorarea sau utilizarea greșită a acestor ghiduri poate duce la repercusiuni juridice sau la deteriorarea reputației unei companii. Să explorăm în detaliu considerentele cheie.

Considerații juridice în Web Scraping

Atunci când vă implicați în activități de web scraping, este esențial să respectați legile aplicabile, cum ar fi cele care guvernează drepturile de proprietate intelectuală, termenii și condițiile site-ului web și reglementările privind protecția datelor. Nerespectarea acestui lucru poate duce la consecințe juridice care pot varia de la avertismente și amenzi până la procese.

Drepturile de proprietate intelectuală protejează creațiile minții umane, cum ar fi invențiile, operele literare și artistice și simbolurile, numele și imaginile utilizate în comerț. Web scraping trebuie să respecte aceste drepturi, fără a încălca materialele protejate prin drepturi de autor sau mărcile comerciale. Este esențial să înțelegem domeniul de aplicare al utilizării loiale și să ne asigurăm că conținutul răzuit nu încalcă nicio lege privind proprietatea intelectuală.

Termenii și condițiile site-ului sunt acorduri legale între proprietarul site-ului și utilizatorii acestuia. Acești termeni includ adesea prevederi care interzic în mod explicit scraping-ul web sau impun restricții specifice privind utilizarea acestuia. Este esențial să revizuiți termenii și condițiile fiecărui site web înainte de a-l răzui pentru a asigura conformitatea. Încălcarea acestor termeni poate duce la acțiuni în justiție, inclusiv scrisori de încetare și renunțare sau chiar procese pentru încălcarea contractului.

Reglementările privind protecția datelor , cum ar fi Regulamentul general privind protecția datelor (GDPR) în Uniunea Europeană, reglementează colectarea și prelucrarea datelor cu caracter personal. Activitățile de web scraping trebuie să respecte aceste reglementări obținând acordul necesar din partea utilizatorilor înainte de a colecta informațiile lor personale. În plus, companiile trebuie să gestioneze și să stocheze datele răzuite în siguranță pentru a preveni accesul neautorizat sau încălcarea datelor.

Orientări etice pentru web scraping

Etica joacă un rol vital în web scraping. Companiile ar trebui să se asigure că respectă drepturile proprietarilor de site-uri web și acordă prioritate confidențialității utilizatorilor. Este esențial să solicitați consimțământul, atunci când este necesar, și să evitați eliminarea informațiilor sensibile sau protejate prin drepturi de autor.

Transparența și responsabilitatea ar trebui să fie principiile directoare atunci când se utilizează web scraping în scopuri comerciale. Comunicarea clară a scopului activității de scraping și oferirea utilizatorilor cu opțiunea de a renunța poate ajuta la construirea încrederii și la menținerea standardelor etice. În plus, companiile ar trebui să implementeze măsuri pentru a proteja datele răzuite și pentru a preveni utilizarea greșită sau accesul neautorizat.

În plus, companiile ar trebui să ia în considerare impactul web scraping asupra performanței site-ului web. Scrapingul excesiv poate pune presiune pe server și poate afecta negativ experiența utilizatorului pentru alți vizitatori. Implementarea tehnicilor de scraping care minimizează impactul asupra performanței site-ului web, cum ar fi utilizarea intervalelor de scraping adecvate și respectarea fișierelor robots.txt, este esențială pentru a menține practicile etice.

Respectând cerințele legale și liniile directoare etice, companiile se pot asigura că activitățile lor de web scraping sunt desfășurate în mod responsabil și fără a provoca rău altora. Este întotdeauna recomandabil să consultați profesioniști din domeniul juridic pentru a asigura conformitatea cu legile și reglementările specifice aplicabile jurisdicției în care are loc răzuirea.

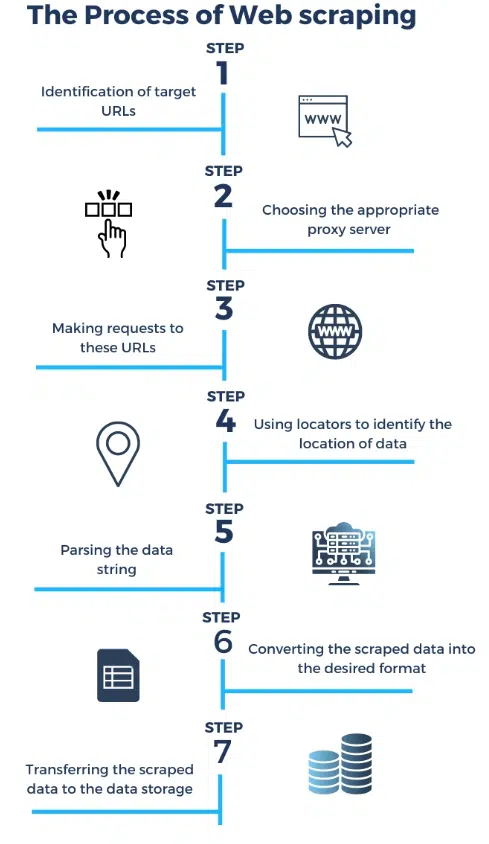

Cum funcționează un Web Scraper?

Sursa: https://research.aimultiple.co

Web scraping urmează un proces structurat. Primul pas implică trimiterea unei cereri către serverul unui site web țintă. Această solicitare este similară cu cea pe care o trimite browserul dvs. atunci când vizitați un site web. Serverul răspunde apoi la cerere trimițând înapoi codul HTML al paginii web.

Odată ce web scraper primește codul HTML, începe să îl analizeze pentru a extrage datele dorite . Analiza implică analiza structurii codului HTML și identificarea elementelor specifice care conțin datele care vă interesează. Acestea pot fi orice, de la prețurile produselor până la recenziile clienților.

După extragerea datelor, web scraper le poate stoca într-un format structurat , cum ar fi o foaie de calcul sau o bază de date. Acest lucru permite companiilor să acceseze și să analizeze cu ușurință datele colectate.

Web scraping poate fi un proces complex, mai ales atunci când aveți de-a face cu site-uri web care au conținut dinamic sau necesită autentificare. Cu toate acestea, cu instrumentele și serviciile potrivite de web scraping, companiile pot depăși aceste provocări și pot valorifica puterea serviciilor de web scraping pentru a obține informații valoroase și a rămâne în fața concurenței.

Tipuri de Web Scrapers

Web scrapers sunt instrumente software concepute pentru a extrage date de pe site-uri web. Ele vin în diferite tipuri și pot fi clasificate în funcție de funcționalitatea, scopul și modul în care accesează și analizează conținutul web. Iată câteva tipuri diferite de răzuitoare web:

Raclete de bază:

- HTML Scrapers : Acestea răzuiesc date din paginile HTML prin analizarea marcajului. Pot extrage text, link-uri și alte elemente din paginile web.

- Text Scrapers : Acestea se concentrează pe extragerea conținutului text din pagini web, cum ar fi articole, postări de blog sau articole de știri.

Raclete avansate:

- Scraper-uri dinamice de conținut : acestea pot răzui site-uri web cu conținut bazat pe JavaScript. Ei folosesc browsere fără cap sau instrumente de automatizare precum Selenium pentru a interacționa cu paginile web și pentru a extrage date.

- API Scrapers : acestea interacționează direct cu API-urile web pentru a prelua date structurate. Multe site-uri web oferă API-uri pentru accesarea datelor lor într-un format structurat.

Raclete cu scop specific:

- E-commerce Scrapers : concepute pentru a extrage informații despre produse, prețuri și recenzii de pe site-urile de comerț electronic.

- Social Media Scrapers : Acestea colectează date de pe platformele de social media precum Twitter, Facebook sau Instagram, inclusiv postări, comentarii și profiluri de utilizator.

- News Scrapers : concentrat pe extragerea articolelor de știri, titlurilor și informațiilor conexe de pe site-urile web de știri.

- Job Scrapers : Colectați liste de locuri de muncă și date conexe de pe site-urile web de căutare de locuri de muncă.

- Real Estate Scrapers : extrageți liste de proprietăți, prețuri și detalii de pe site-urile imobiliare.

Răzuitoare de imagine și media:

- Image Scrapers : descărcați imagini de pe site-uri web, adesea folosite pentru seturi de date de imagini sau colecții de fotografii stoc.

- Video Scrapers : Colectați conținut video și metadate de pe site-uri web precum YouTube sau Vimeo.

Raclete de monitorizare și alertă:

- Scrapers de detectare a modificărilor : monitorizează continuu site-urile web pentru modificări și anunță utilizatorii când sunt îndeplinite anumite criterii (de exemplu, scăderi de preț, actualizări de conținut).

Raclete personalizate:

- Raclete personalizate dezvoltate pentru cazuri de utilizare specifice, unice. Acestea sunt adesea create de furnizorii de servicii de web scraping pentru a îndeplini cerințele specifice de extragere a datelor.

Python: Instrumentul suprem pentru Web Scraping

Python a apărut ca limbajul de bază pentru web scraping și nu este întâmplător. Popularitatea sa în acest domeniu este susținută de mai multe motive convingătoare.

Versatilitate și ușurință în învățare

Simplitatea și lizibilitatea Python îl fac o alegere ideală pentru web scraping, indiferent de experiența dvs. de programare. Codul său este asemănător cu limba engleză simplă, făcându-l accesibil atât pentru începători, cât și pentru dezvoltatorii experimentați.

Ecosistemul bogat al bibliotecilor

Python se mândrește cu o comoară de biblioteci concepute în mod explicit pentru web scraping. Printre acestea se remarcă BeautifulSoup și Scrapy. Aceste biblioteci abstrac sarcini complexe, cum ar fi analizarea HTML și efectuarea de solicitări HTTP, simplificând semnificativ procesul de scraping.

Sprijin activ al comunității

Python este susținut de o comunitate de dezvoltatori vibrantă și entuziastă. Nenumărate resurse online, tutoriale și forumuri sunt disponibile pentru a vă ajuta cu provocările legate de web scraping, asigurându-vă că nu rămâneți niciodată blocat fără îndrumare.

Compatibilitate între platforme

Python rulează fără probleme pe diverse sisteme de operare, de la Windows la macOS și Linux. Această compatibilitate între platforme înseamnă că scripturile dvs. de web scraping pot funcționa constant în diferite medii.

Analiza robustă a datelor

Cu capacitățile sale de manipulare a șirurilor, Python excelează la navigarea și extragerea datelor din pagini web, chiar și atunci când are de-a face cu structuri complicate ale paginilor. BeautifulSoup, în special, simplifică analizarea documentelor HTML și XML.

Gestionarea cererilor HTTP

Biblioteca de „cereri” a lui Python simplifică procesul de realizare a solicitărilor HTTP, care este fundamentală pentru web scraping. Se ocupă de sarcini obișnuite, cum ar fi solicitările GET și POST, gestionarea cookie-urilor și redirecționările, făcându-vă eforturile de scraping fără probleme. Python web scraping este utilizat pe scară largă în aceste zile.

Integrare cu instrumente de automatizare

Pentru site-urile web cu conținut dinamic, Python se joacă bine cu instrumente de automatizare precum Selenium. Acest lucru vă permite să interacționați cu pagini la fel ca un utilizator uman, asigurând accesul la conținut care necesită interacțiunea utilizatorului.

Prelucrarea și analiza datelor

Bibliotecile Python de procesare și analiză a datelor, cum ar fi Pandas și NumPy, facilitează curățarea, transformarea și analiza datelor extrase în timpul web scraping. Acest lucru înseamnă că puteți transforma datele brute în informații utile.

Practici etice de răzuire

Flexibilitatea lui Python permite implementarea practicilor etice de scraping. Puteți respecta termenii și condițiile site-ului web, puteți respecta regulile robots.txt și puteți gestiona ratele de solicitare pentru a minimiza riscul blocării IP.

Integrare cu baze de date și API-uri

Versatilitatea lui Python se extinde la capacitatea sa de a se conecta la diferite baze de date și API-uri web. Acest lucru vă permite să stocați și să preluați date răzuite pentru analize ulterioare sau integrare în aplicațiile dvs.

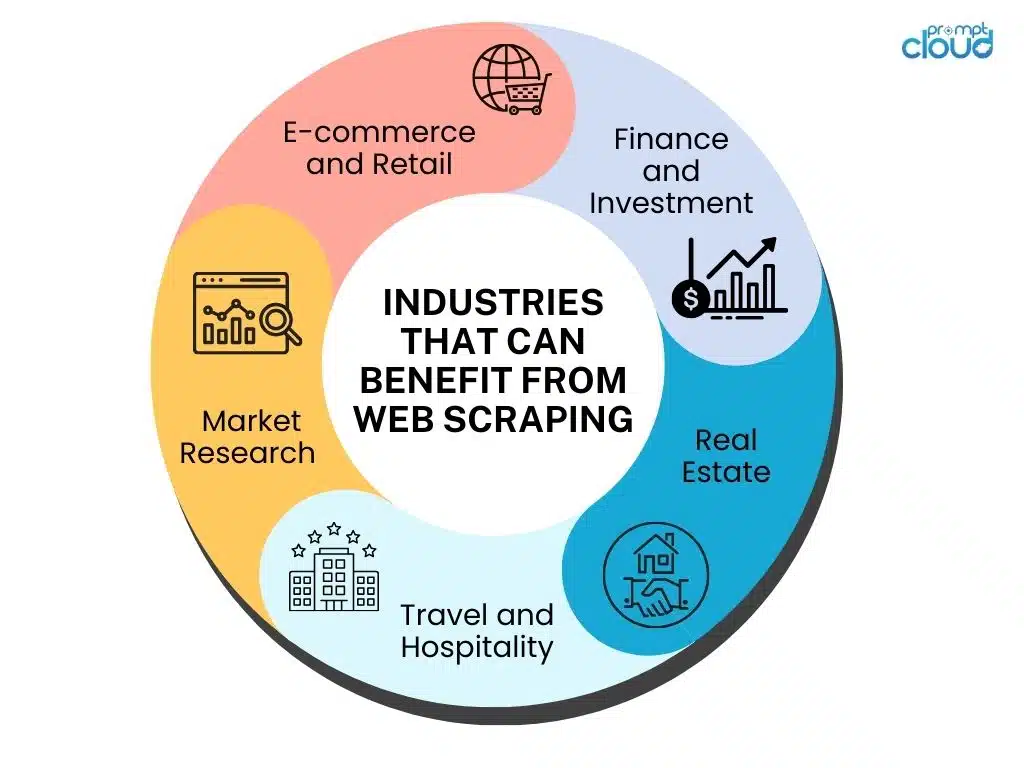

Beneficiile de afaceri ale Web Scraping

Web scraping oferă numeroase beneficii care pot avea un impact semnificativ asupra afacerilor din diverse industrii. Să explorăm câteva domenii cheie în care web scraping se poate dovedi neprețuit.

Îmbunătățirea cercetării de piață – Cercetarea de piață formează baza oricărei afaceri de succes. Cu web scraping, companiile pot aduna o mulțime de informații despre concurenții lor, tendințele pieței, strategiile de preț și preferințele clienților. Analizând aceste date, companiile pot lua decizii mai informate și pot elabora strategii eficiente pentru a rămâne în fața concurenței.

De exemplu, web scraping poate ajuta companiile să urmărească strategiile de prețuri ale concurenților lor în timp real. Prin monitorizarea prețurilor produselor sau serviciilor similare, companiile își pot ajusta propriile strategii de preț pentru a rămâne competitive. În plus, web scraping poate oferi informații despre sentimentul clienților prin analizarea recenziilor online și a postărilor pe rețelele sociale. Aceste informații pot ajuta companiile să înțeleagă preferințele clienților și să își adapteze produsele sau serviciile în consecință.

Creșterea generării de clienți potențiali – Generarea de clienți potențiali de calitate este crucială pentru creșterea afacerii. Web scraping permite companiilor să extragă informații de contact, cum ar fi adrese de e-mail și numere de telefon, de pe site-uri web și directoare. Aceste date pot fi apoi folosite pentru campanii de marketing țintite, crescând șansele de a ajunge la potențiali clienți și de a genera clienți potențiali.

În plus, web scraping poate ajuta companiile să identifice potențiale clienți potențiali prin monitorizarea forumurilor online, platformelor de social media și site-urilor web specifice industriei. Analizând discuțiile și interacțiunile, companiile pot identifica persoane sau organizații care își exprimă o nevoie sau un interes pentru produsele sau serviciile lor. Această abordare proactivă a generării de clienți potențiali poate îmbunătăți semnificativ ratele de conversie și poate stimula creșterea afacerii.

Raționalizarea colectării datelor – Datele sunt esențiale pentru luarea deciziilor, iar web scraping simplifică procesul de colectare a datelor. În loc să viziteze manual mai multe site-uri web și să copieze informații, companiile pot automatiza procesul de extragere a datelor. Web scraping permite companiilor să adune volume mari de date rapid și eficient, permițând analize mai precise și informații mai rapide.

De exemplu, web scraping poate fi folosit pentru a colecta date de pe site-urile de comerț electronic pentru a analiza tendințele produselor, comportamentul clienților și modelele de prețuri. Aceste informații pot ajuta companiile să își optimizeze ofertele de produse, să îmbunătățească satisfacția clienților și să identifice noi oportunități de piață. În plus, web scraping poate fi utilizat pentru a colecta date de pe site-uri web de știri, bloguri și publicații din industrie, oferind companiilor informații actualizate despre evoluțiile și tendințele industriei.

Serviciile de web scraping joacă un rol crucial în îmbunătățirea cercetării de piață, în creșterea generării de clienți potențiali și în eficientizarea colectării datelor pentru companii. Prin valorificarea puterii web scraping, companiile pot obține un avantaj competitiv, pot lua decizii informate și pot stimula creșterea în peisajul digital de astăzi.

Noțiuni introductive cu Web Scraping

Să analizăm câteva aspecte cheie de luat în considerare atunci când încorporăm web scraping în operațiunile tale.

Alegerea celor mai bune instrumente de răzuire web

Când vine vorba de web scraping, aveți două opțiuni principale: utilizarea instrumentelor de web scraping sau externalizarea sarcinii către furnizorii de servicii de web scraping. Să începem prin a explora diferitele aspecte ale instrumentelor de scraping web:

Există o gamă largă de instrumente de scraping web disponibile pe piață. Este esențial să vă evaluați nevoile afacerii și să selectați un instrument care oferă caracteristicile necesare, scalabilitate și ușurință în utilizare. Efectuați cercetări amănunțite și luați în considerare factori precum capacitățile de extragere a datelor, opțiunile de personalizare și asistența pentru clienți înainte de a lua o decizie. Unii factori de luat în considerare sunt:

- Ușurință în utilizare : instrumentele de scraping web vin cu interfețe ușor de utilizat și necesită cunoștințe minime de codare. Ele oferă o funcție de scraping vizual care vă permite să selectați cu ușurință datele de care aveți nevoie de pe un site web. Unele instrumente populare de răzuire web includ Beautiful Soup, Scrapy și Octoparse.

- Flexibilitate: Cu instrumentele de scraping web, vă puteți personaliza scripturile de scraping în funcție de cerințele dumneavoastră specifice. Acestea oferă flexibilitatea de a extrage date de pe mai multe site-uri web simultan, de a gestiona pagini web complexe și de a extrage date în diferite formate, cum ar fi CSV, JSON sau XML.

- Cost : instrumentele de scraping web sunt, în general, mai rentabile în comparație cu externalizarea sarcinii către furnizorii de servicii. Majoritatea instrumentelor oferă versiuni gratuite cu funcții limitate, în timp ce versiunile plătite oferă funcționalități avansate și asistență.

- Întreținere și actualizări : pe măsură ce tehnologia evoluează, site-urile web își schimbă adesea structura, ceea ce face necesară actualizarea scripturilor de scraping. Instrumentele web scraping necesită întreținere și actualizări regulate pentru a asigura extragerea exactă și continuă a datelor.

Evaluarea furnizorilor de servicii Web Scraping

În timp ce instrumentele de scraping web pot fi o alegere excelentă pentru persoane fizice sau proiecte la scară mică, este posibil să nu fie întotdeauna cea mai bună soluție pentru companiile cu nevoi complexe de scraping. Pentru a lua o decizie informată, luați în considerare următorii factori atunci când evaluați furnizorii de servicii de web scraping:

- Scalabilitate : Furnizorii de servicii au infrastructura și resursele necesare pentru a gestiona eficient proiectele de web scraping la scară largă. Aceștia pot gestiona scrape-uri simultane, pot oferi acces la mai multe servere proxy pentru a ocoli restricțiile site-ului web și pot asigura extragerea neîntreruptă a datelor.

- Calitatea datelor : Furnizorii de servicii web scraping sunt specializați în furnizarea de date de înaltă calitate și exacte. Aceștia pot naviga mai eficient în provocări precum CAPTCHA, site-uri web dinamice și modificarea structurilor paginilor, rezultând date fiabile și consecvente.

- Conformitate legală : web scraping poate fi o zonă gri juridică, iar furnizorii de servicii sunt bine versați în navigarea complexităților legale. Acestea asigură conformitatea cu termenii și condițiile site-ului web, legile privind drepturile de autor și reglementările privind protecția datelor, reducând riscul consecințelor legale.

- Personalizare și asistență : Furnizorii de servicii oferă soluții personalizate pentru a satisface cerințele dumneavoastră specifice de răzuire. Aceștia pot gestiona sarcini complexe de extragere a datelor, pot oferi formatare personalizată a datelor și pot oferi suport tehnic continuu.

De ce să alegeți furnizorii de servicii de scraping web în locul instrumentelor

Deși instrumentele de web scraping au meritele lor, există motive convingătoare pentru care companiile ar trebui să ia în considerare externalizarea web scraping către furnizorii de servicii:

- Expertiză și experiență : Furnizorii de servicii de scraping web sunt specializați în extragerea datelor și au o experiență vastă în gestionarea unei game largi de proiecte de scraping. Ei posedă expertiza necesară pentru a depăși provocările și pentru a oferi rezultate fiabile.

- Concentrați-vă pe competențele de bază : externalizarea web scraping permite companiilor să se concentreze pe competențele lor de bază în loc să investească timp și resurse în stăpânirea instrumentelor și tehnicilor de scraping. Acest lucru permite companiilor să-și prioritizeze activitățile cheie și să stimuleze creșterea.

- Cost-eficiente : Spre deosebire de credința populară, furnizorii de servicii de web scraping pot oferi adesea economii de costuri pe termen lung. Ele pot furniza mai rapid date precise și relevante, permițând companiilor să ia prompt decizii bazate pe date, ceea ce duce la o eficiență operațională îmbunătățită.

- Economisește timp și efort : furnizorii de servicii de web scraping se ocupă de întregul proces de web scraping, de la extragerea datelor până la gestionarea întreținerii și actualizărilor. Acest lucru eliberează timpul și efortul echipei tale, permițându-le să se concentreze pe analiza datelor extrase și să obțină informații valoroase.

Web scraping este un instrument valoros pentru companiile care doresc să valorifice puterea datelor. În timp ce instrumentele de web scraping pot fi utile pentru proiecte la scară mică, externalizarea către furnizorii de servicii de web scraping oferă numeroase avantaje, inclusiv scalabilitate, calitatea datelor, conformitatea legală, personalizare și asistență profesională. Evaluând cu atenție cerințele dumneavoastră și luând în considerare acești factori, puteți lua o decizie informată care se potrivește cel mai bine nevoilor afacerii dumneavoastră.