Prevenirea colapsului modelului AI: abordarea riscului inerent al seturilor de date sintetice

Publicat: 2023-10-05Inteligența artificială (AI) ne-a transformat în mod semnificativ viața de zi cu zi, sugerând conținut personalizat pe platformele de streaming și permițând asistenți digitali pe smartphone-uri. Acum, aceste progrese sunt posibile de modele AI sofisticate care învață din cantități mari de date.

Conform diverselor rapoarte, conținutul generat de inteligență artificială devine din ce în ce mai răspândit pe internet, putând cuprinde până la 90% din informațiile online în următorii ani.

Cu un astfel de aflux de informații, se poate spune cu ușurință că în lumea de astăzi bogată în date, AI se confruntă cu o provocare unică și care se sufocă cu abundența sa de date.

Rapoartele sugerează în continuare că cantitatea semnificativă a acestui conținut generat de inteligență artificială poate copleși oamenii cu informații excesive, făcându-le dificil să determine ce este demn de încredere și ce este generat de oameni. În plus, există îngrijorări cu privire la potențiala pierdere de locuri de muncă în domenii creative, cum ar fi arta, jurnalismul și scrisul, totul pentru că AI devine din ce în ce mai capabil să producă conținut creat în mod tradițional de oameni.

În ceea ce privește sistemele AI în sine, există probleme emergente, cum ar fi „Colapsul modelului”, care se referă la o problemă în care modelele AI care sunt antrenate pe seturi mari de date produc rezultate de calitate inferioară, acordând prioritate alegerilor de cuvinte comune față de alternativele creative. „Tulburarea de autofagie model” sau „AI Habsburg” este o altă preocupare în care sistemele AI instruite excesiv pe rezultatele altor modele AI pot prezenta caracteristici nedorite sau pot avea părtiniri.

Aceste provocări pot afecta calitatea și fiabilitatea conținutului generat de AI, distrugând încrederea în astfel de sisteme și agravând supraîncărcarea de informații.

Blogul nostru vă va ajuta să înțelegeți tot ce este legat de abordarea prevenirii colapsului modelului AI. Pe măsură ce revoluția AI generativă progresează, aceasta aduce provocări și incertitudini semnificative pentru peisajul informațional online. Așadar, să ne aruncăm în detalii direct.

Înțelegerea colapsului modelului AI

În învățarea automată, „colapsul modelului” se referă la o situație în care modelul AI nu reușește să ofere o varietate de rezultate utile. În schimb, produce un set restrâns de rezultate repetitive sau de calitate scăzută. Această problemă poate apărea în diferite modele, dar este adesea observată în timpul antrenamentului de modele complexe, cum ar fi rețelele adverse generative (GAN). Prăbușirea modelului poate împiedica capacitatea modelului de a genera rezultate diverse și valoroase, având un impact asupra performanței sale generale.

Să ilustrăm un exemplu de colaps de model. Imaginați-vă un student de artă foarte entuziast reprezentând modelul nostru AI, care are sarcina de a crea picturi cu zebre. La început, opera lor de artă este impresionantă și seamănă distinct cu zebrele. Cu toate acestea, picturile lor își pierd treptat asemănarea cu zebrele pe măsură ce continuă, iar calitatea scade. Acest lucru este similar cu „colapsul modelului” în învățarea automată, unde modelul AI, ca studentul nostru la arte, inițial are performanțe bune, dar apoi se luptă să mențină caracteristicile esențiale pentru care a fost proiectat.

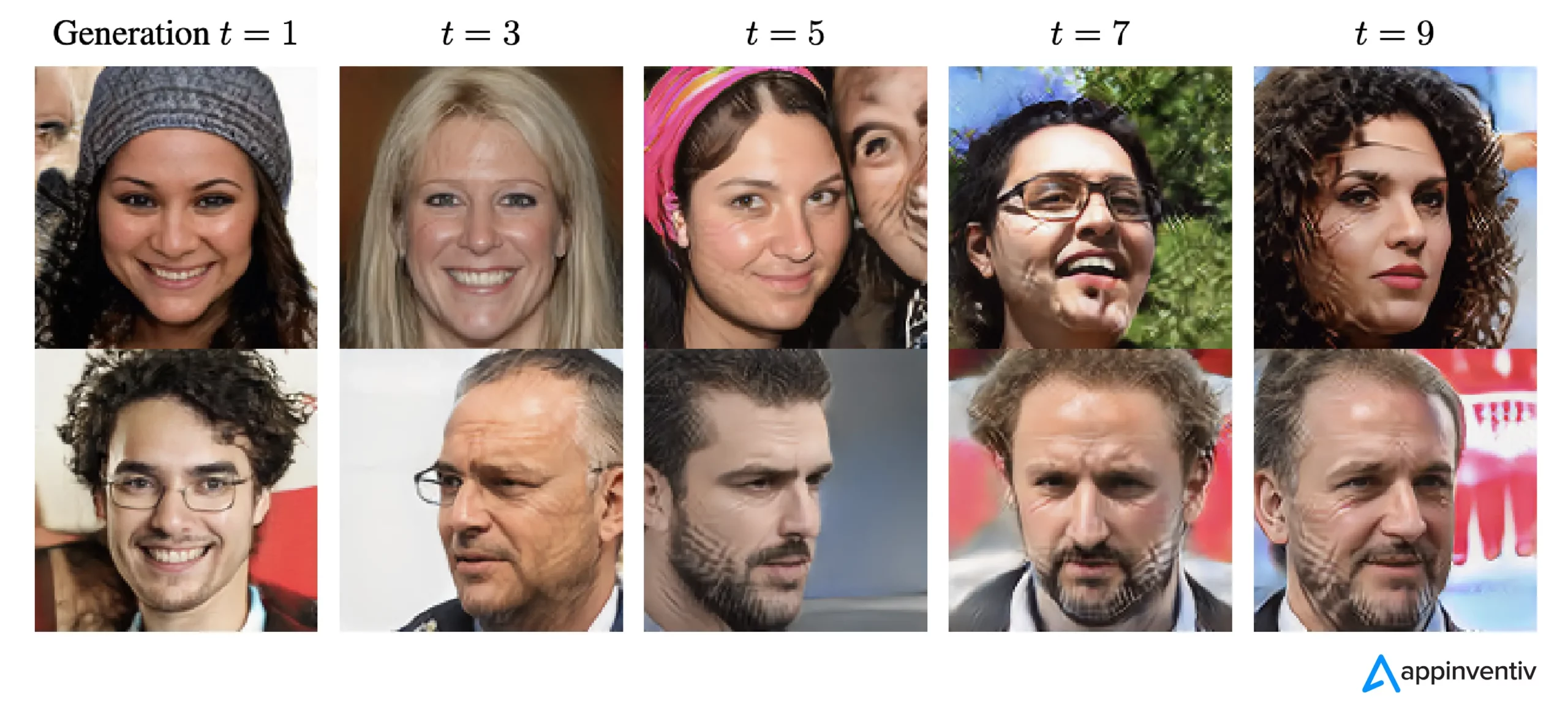

Conform recentelor progrese în AI, cercetătorii au devenit foarte interesați de utilizarea datelor artificiale sau sintetice pentru a antrena noi modele AI atunci când vine vorba de generarea de imagini și text. Cu toate acestea, un concept numit „Model Autophagy Disorder” (MAD) compară acest proces cu o buclă autodistructivă.

Dacă nu continuăm să adăugăm în mod regulat date proaspete din lumea reală, calitatea și varietatea modelelor AI pe care le creăm folosind date sintetice s-ar putea înrăutăți în timp. Prin urmare, este esențial să găsim un echilibru între datele sintetice și cele reale pentru a menține performanța optimă a modelelor AI.

Acest echilibru este crucial pentru a preveni o scădere a calității și diversității modelelor pe măsură ce acestea continuă să învețe. A afla cum să utilizați în mod eficient datele sintetice pentru prevenirea colapsului modelului AI este o provocare continuă când vine vorba de evoluția AI generativă și de utilizarea datelor sintetice.

Potrivit The New Yorker, dacă ChatGPT este considerată o versiune compactă a internetului, similară cu cea a unui fișier JPEG care comprimă o fotografie, atunci antrenarea viitorilor chatbot cu privire la rezultatele ChatGPT este echivalent digital cu a face în mod repetat fotocopii ale fotocopiilor, la fel ca și zile vechi. Pur și simplu, calitatea imaginii se va înrăutăți cu fiecare iterație.

Astfel, pentru a depăși această provocare, organizațiile trebuie să se concentreze pe rafinarea abordărilor lor pentru a se asigura că aceste produse AI generative continuă să ofere răspunsuri precise în acest peisaj digital.

[Citiți și: IA responsabilă – Abordarea provocărilor de adopție cu principii și strategii directoare]

Cum se întâmplă colapsul modelului AI?

Colapsul modelului are loc atunci când noile modele AI sunt antrenate folosind date generate de modele mai vechi. Aceste noi modele se bazează pe modelele văzute în datele generate. Colapsul modelului are rădăcinile în ideea că modelele generative tind să repete modele pe care le-au învățat deja și există o limită a informațiilor pe care le pot extrage din aceste modele.

În cazurile de prăbușire a modelului, evenimentele care sunt probabil să se întâmple sunt exagerate, în timp ce evenimentele mai puțin probabile sunt subestimate. De-a lungul mai multor generații, evenimentele probabile domină datele, iar părțile mai puțin comune, dar totuși cruciale ale datelor, numite cozi, se diminuează. Aceste cozi sunt esențiale pentru a menține acuratețea și diversitatea rezultatelor modelului. Pe măsură ce generațiile progresează, erorile cuceresc datele, iar modelul le interpretează din ce în ce mai greșit.

Potrivit cercetării, există două tipuri de colaps de model: precoce și târzie. Colapsul timpuriu al modelului implică pierderea de informații despre evenimente rare. În colapsul tardiv al modelului, modelul estompează modele distincte în date, rezultând rezultate care se aseamănă puțin cu datele originale.

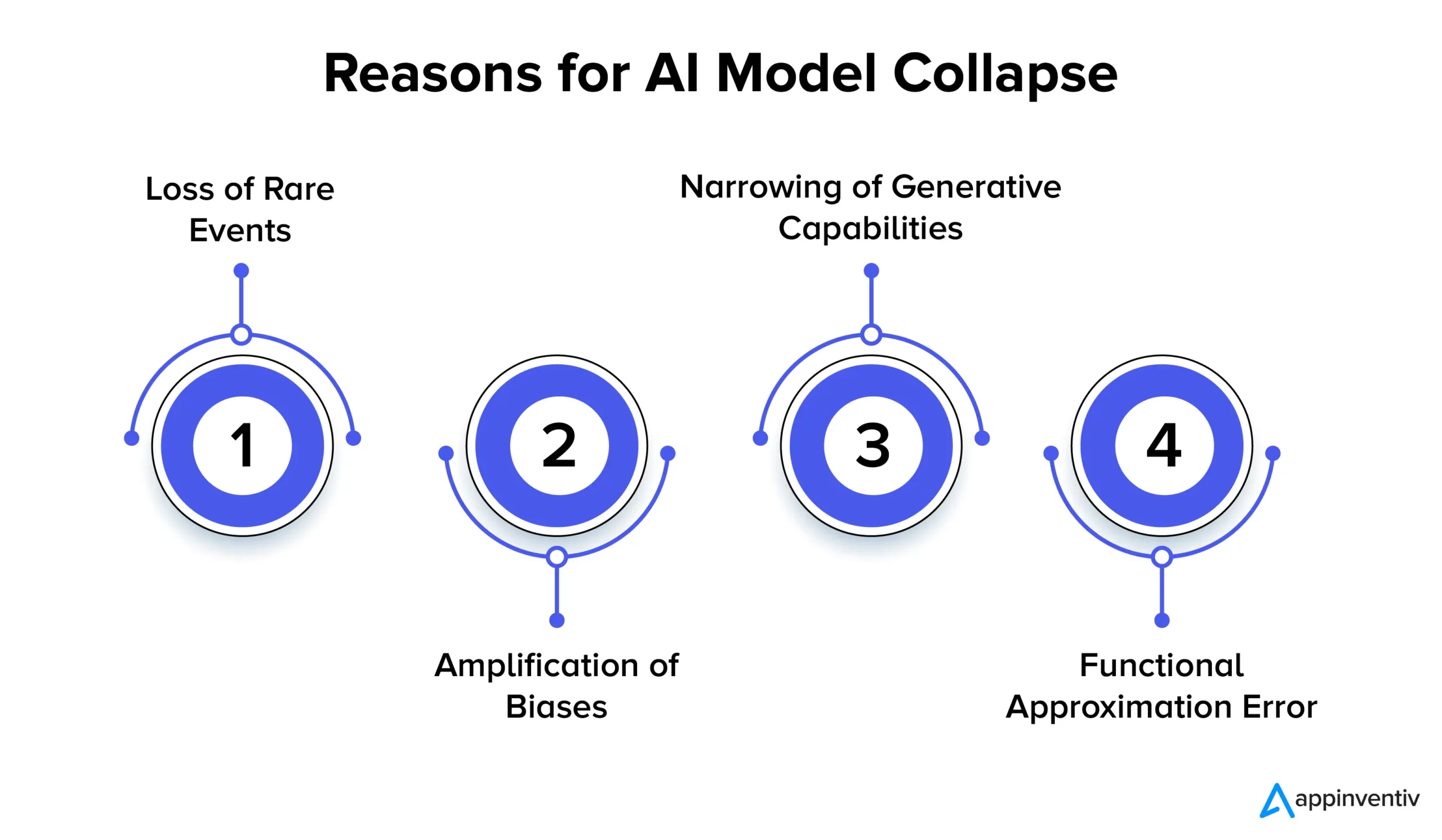

Să ne uităm mai jos la mai multe motive pentru colapsul modelului AI:

Pierderea evenimentelor rare

Când modelele AI sunt antrenate în mod repetat pe datele generate de versiunile lor anterioare, ele încearcă să se concentreze pe tipare comune și să uite evenimente rare. Acest fenomen este similar cu modelele care își pierd memoria pe termen lung. Evenimentele rare au adesea o importanță semnificativă, cum ar fi identificarea anomaliilor în procesele de producție sau detectarea tranzacțiilor frauduloase. De exemplu, când vine vorba de detectarea fraudelor, anumite modele de limbaj pot semnala un comportament fraudulos, ceea ce face esențială păstrarea și învățarea acestor modele rare.

Amplificarea părtinirilor

Fiecare iterație de antrenament pe datele generate de AI poate amplifica părtinirile existente în datele de antrenament. Deoarece rezultatul modelului reflectă, de obicei, datele pe care a fost antrenat, orice prejudecată din acele date poate fi exagerată cu timpul. Acest lucru poate duce la amplificarea părtinirii în diverse aplicații AI. De exemplu, rezultatele pot duce la probleme precum discriminarea, prejudecățile rasiale și conținutul părtinitor al rețelelor sociale. Astfel, implementarea controalelor pentru a detecta și a atenua părtinirea este extrem de esențială.

Îngustarea capacităților generative

Pe măsură ce modelele AI continuă să învețe din datele lor generate, capacitățile lor generative se pot restrânge. Modelul devine mai degrabă influențat de propriile interpretări ale realității, producând conținut din ce în ce mai asemănător, căruia îi lipsește diversitatea și reprezentarea unor evenimente rare. Acest lucru poate duce la o pierdere a originalității. De exemplu, când vine vorba de modele de limbaj mari (LLM), variația conferă fiecărui scriitor sau artist tonul și stilul lor distinct.

Cercetările sugerează pur și simplu că, dacă date noi nu sunt adăugate în mod regulat în timpul procesului de instruire, viitoarele modele AI ar putea ajunge să devină mai puțin precise sau să producă rezultate mai puțin variate în timp.

Eroare de aproximare funcțională

O eroare de aproximare funcțională poate apărea atunci când aproximatorii de funcție utilizați în model nu sunt suficient de expresivi. Deși această eroare poate fi atenuată prin folosirea unor modele mai expresive, ea poate, de asemenea, să introducă zgomot și să conducă la supraadaptare. Găsirea echilibrului corect între expresivitatea modelului și controlul zgomotului este crucială pentru a preveni aceste erori.

Implicațiile colapsului modelului: de ce este importantă stabilitatea modelului AI?

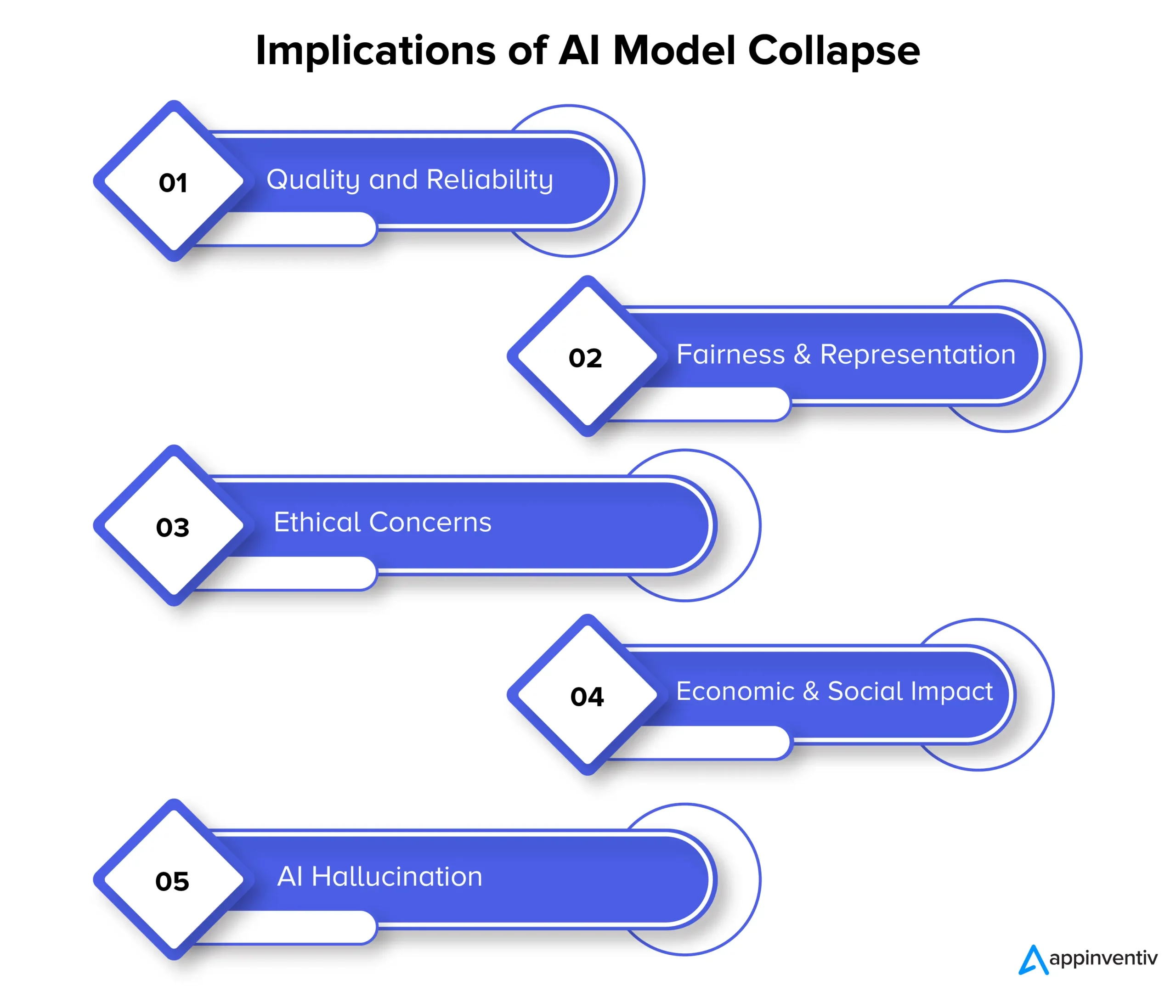

Colapsul modelului poate afecta în cele din urmă calitatea, fiabilitatea și corectitudinea conținutului generat de AI, ceea ce poate prezenta și mai multe riscuri pentru organizații. Să ne uităm mai jos la implicația colapsului modelului în detaliu:

Calitate și fiabilitate

Pe măsură ce modelele AI degenerează în procesul de învățare, conținutul pe care îl generează devine mai puțin fiabil, iar calitatea lor se degradează. Acest lucru se întâmplă atunci când modelele se desprind de distribuția originală a datelor și se bazează mai mult pe propriile interpretări ale realității. De exemplu, un model AI conceput pentru generarea de știri poate produce articole de știri inexacte sau chiar complet fabricate.

Corectitudine și reprezentare

Colapsul modelului este, de asemenea, un motiv de îngrijorare când vine vorba de corectitudine și reprezentare a conținutului generat. Atunci când modelele uită evenimente rare și își limitează abilitățile generative, conținutul legat de subiecte mai puțin obișnuite poate fi reprezentat inadecvat. Acest lucru duce la părtiniri, stereotipuri și excluderea anumitor perspective.

Preocupări etice

Colapsul modelului ridică preocupări etice semnificative, în special atunci când conținutul generat de AI are puterea de a influența luarea deciziilor. Consecințele prăbușirii modelului includ răspândirea conținutului părtinitor și inexact, care poate avea un impact semnificativ asupra vieților oamenilor, opiniilor și accesului la oportunități.

Impactul economic și social

La scară economică și socială, colapsul modelului poate influența încrederea și adoptarea tehnologiilor AI. Dacă nu se poate baza pe conținutul generat de inteligență artificială, companiile și consumatorii pot ezita să adopte aceste tehnologii. Acest lucru poate avea implicații economice, iar încrederea în tehnologiile AI poate împiedica în consecință.

AI Halucinație

Halucinația AI este atunci când modelele AI creează conținut imaginativ sau nerealist care nu se aliniază cu faptele sau este coerent în vreun fel. Acest lucru poate duce la informații inexacte, care pot cauza informații greșite sau confuzie. Este semnificativ problematică în aplicații precum generarea de știri, diagnosticarea afecțiunilor medicale sau crearea de documente legale în care acuratețea și fiabilitatea sunt extrem de vitale.

Să explicăm contextul cu un exemplu de halucinație AI. Să presupunem că există un model AI care este antrenat pentru a genera imagini cu animale. Acum, la solicitarea unei imagini a unui animal, modelul ar putea produce o imagine a unui „zebrod”, un hibrid între o zebră și un cal. Deși această imagine poate părea vizual realistă, este vital să înțelegem că este doar o creație a imaginației modelului AI, deoarece nu există un astfel de animal în lumea reală.

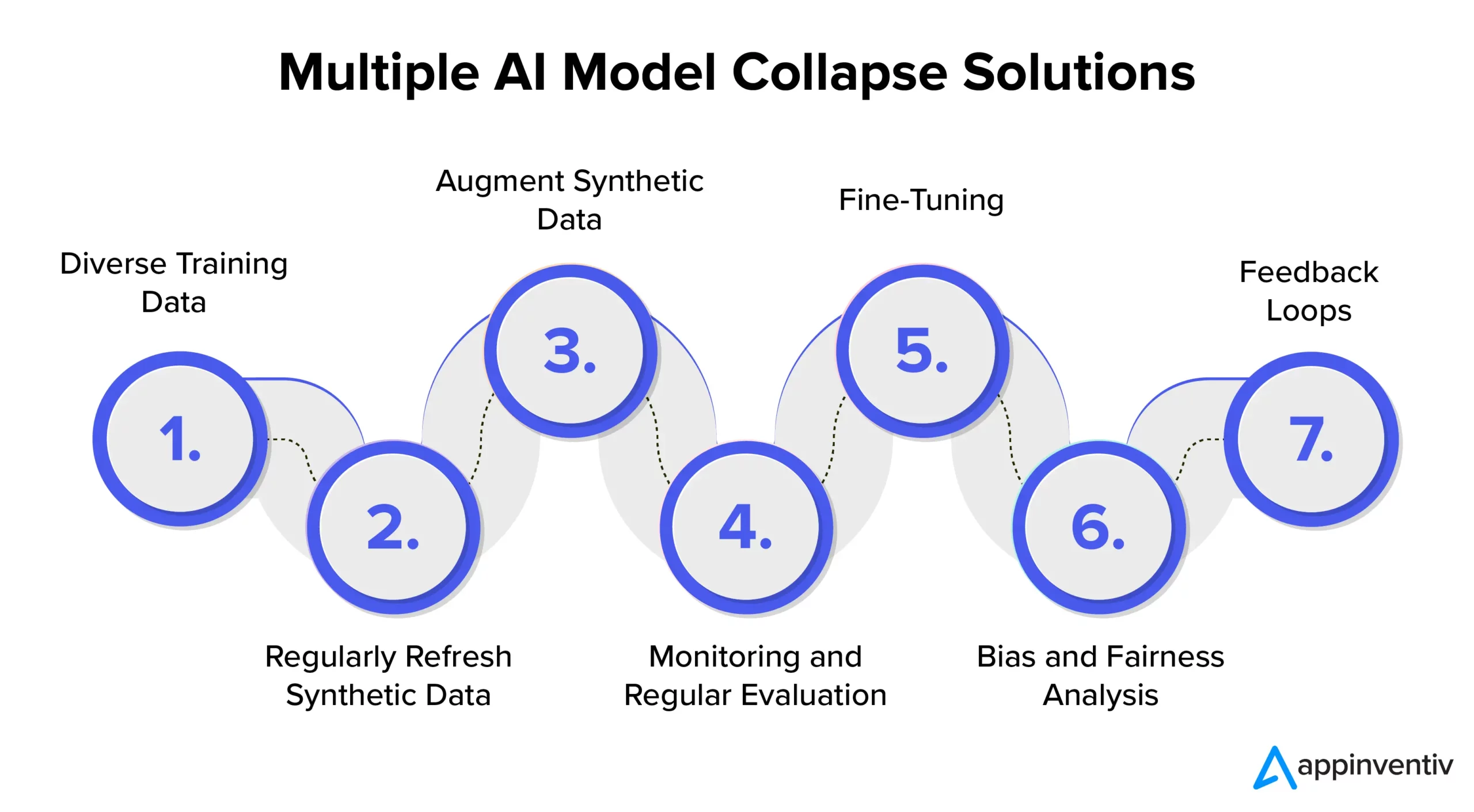

Prevenirea colapsului modelului AI: înțelegerea soluțiilor de colaps al modelului AI

Pentru a asigura stabilitatea și fiabilitatea modelului AI, este esențial să se exploreze strategii și cele mai bune practici pentru a aborda în mod eficient prevenirea colapsului modelului AI. Prin urmare, este recomandat să colaborați cu o firmă de dezvoltare AI dedicată, cum ar fi Appinventiv, care poate oferi expertiză și îndrumări în implementarea acestor măsuri preventive, asigurându-vă în același timp că sistemele dvs. AI oferă rezultate de înaltă calitate.

Date diverse de antrenament

Pentru a aborda eficient colapsul modelului AI și pentru a preveni rezultatele nedorite, este esențial să creați un set de date de antrenament care să includă o varietate de surse și tipuri de date. Acest set de date ar trebui să conțină atât date sintetice generate de model, cât și date din lumea reală care reprezintă cu exactitate complexitățile problemei. Este important să actualizați în mod regulat acest set de date cu informații noi și relevante. Modelul este expus la o gamă largă de modele prin încorporarea diverselor date de antrenament. Acest lucru ajută la prevenirea stagnării datelor.

Actualizează în mod regulat datele sintetice

Colapsul modelului este un risc atunci când modelele AI se bazează în mare măsură pe propriile date generate. Pentru atenuarea eficientă a riscurilor în IA, este important să introduceți în mod regulat date noi, autentice, din lumea reală în canalul de instruire. Această practică asigură că modelul rămâne adaptiv și evită să rămână blocat într-o buclă repetitivă. Acest lucru poate ajuta la generarea de rezultate diverse și relevante.

Mărirea datelor sintetice

Îmbunătățirea datelor sintetice prin tehnici de creștere a datelor este o metodă dovedită pentru a preveni colapsul modelului. Aceste tehnici introduc variabilitate în datele sintetice folosind variațiile naturale ale datelor din lumea reală. Adăugarea de zgomot controlat la datele generate încurajează modelul să învețe o gamă mai largă de modele, reducând șansele de a genera rezultate repetitive.

Monitorizare și evaluare periodică

Monitorizarea și evaluarea periodică a performanței modelului AI este crucială pentru detectarea timpurie a colapsului modelului. Implementarea unui cadru MLOps asigură monitorizarea continuă și alinierea la obiectivele unei organizații, permițând astfel intervenții și ajustări în timp util.

[Citiți și: Cum să evitați încălcările conformității în timp ce dezvoltați produse AI]

Reglaj fin

Este important să luați în considerare implementarea strategiilor de reglare fină pentru a menține stabilitatea modelului și a preveni colapsul. Aceste strategii pentru prevenirea eșecului modelului AI permit modelului să se adapteze la date noi, păstrând în același timp cunoștințele anterioare.

Analiza de părtinire și corectitudine

Prejudecățile riguroase și analiza echității sunt cruciale în prevenirea colapsului modelului și a problemelor etice. Este esențial să se identifice și să se abordeze părtinirile din rezultatele modelului. Puteți menține rezultate fiabile și imparțial ale modelului abordând în mod activ aceste preocupări.

Bucle de feedback

Implementarea buclelor de feedback care încorporează feedback-ul utilizatorului este crucială în prevenirea colapsului modelului. Prin colectarea consecventă a informațiilor utilizatorilor, pot fi făcute ajustări informate ale rezultatelor modelului. Acest proces de rafinare garantează că modelul rămâne relevant, fiabil și aliniat cu așteptările utilizatorilor.

Cum poate Appinventiv să ajute la reducerea riscurilor în modelele AI?

În peisajul evolutiv al inteligenței artificiale, provocările generate de colapsul modelului au fost o preocupare atât pentru giganții din tehnologie, cât și pentru inovatori. Deteriorarea pe termen lung a seturilor de date model de limbaj și manipularea conținutului și-au pus amprenta asupra acestui ecosistem digital.

Pe măsură ce AI avansează, este vital să se facă diferența între datele generate artificial și conținutul generat de oameni. Linia dintre conținutul autentic și ceea ce este generat de o mașină devine din ce în ce mai neclară.

Acum, în mijlocul acestor provocări și prevenirea eșecului modelului AI, parteneriatul cu o companie de dezvoltare AI dedicată, precum Appinventiv, vă poate oferi mângâierea atât de necesară. Având experiență în dezvoltarea modelelor de inteligență artificială și un angajament dedicat față de practicile etice de inteligență artificială, vă putem ajuta să navigați prin complexitățile inteligenței artificiale, asigurând în același timp fiabilitatea și integritatea sistemelor dvs. de inteligență artificială.

Experții noștri pot colabora cu dvs. în abordarea eficientă a prevenirii colapsului modelului AI, să promoveze transparența și să construiască un viitor cu conținut autentic care să nu compromită autenticitatea conținutului generat de oameni.

Înțelegem că antrenarea modelelor AI cu date proaspete și diverse este esențială pentru a preveni degradarea modelului. Evaluarea modelului de inteligență artificială este un pas esențial în procesul nostru de dezvoltare a modelului, care utilizează valori pentru a evalua performanța, a identifica punctele slabe și a asigura previziuni viitoare eficiente.

Echipa noastră de experți vă poate ajuta să vă asigurați că sistemele dvs. AI continuă să învețe și să se adapteze la peisajul digital în evoluție. Luați legătura cu experții noștri pentru a reduce riscurile asociate colapsului modelului și pentru a asigura eficacitatea acestora.

Întrebări frecvente

Î. Ce este colapsul modelului AI?

A. Colapsul modelului AI în învățarea automată se referă la eșecul modelului AI de a produce o gamă variată de rezultate utile. În schimb, generează rezultate repetitive sau de calitate scăzută. Această problemă poate apărea în diferite tipuri de modele, dar este observată în special în timpul antrenamentului de modele complexe, cum ar fi rețelele adverse generative (GAN).

Î. Care sunt cauzele comune ale colapsului modelului AI?

A. Cauzele comune ale colapsului modelului AI includ pierderea evenimentelor rare, amplificarea distorsiunilor, restrângerea capacităților generative, erori funcționale de aproximare etc. Acești factori pot duce la modele care produc rezultate suboptime.

Î. Cum pot preveni prăbușirea modelului AI?

A. Pentru prevenirea eficientă a colapsului modelului AI, este vitală utilizarea datelor de antrenament diferite și asemănătoare lumii reale, monitorizarea și evaluarea continuă a datelor, remedierea oricăror părtiniri și implementarea testării riguroase și a controlului calității. Parteneriatul cu experții AI de la Appinventiv vă poate oferi informații și soluții valoroase pentru a atenua riscurile de colaps al modelului.