Tehnici eficiente de crawling web pentru aplicații de date mari

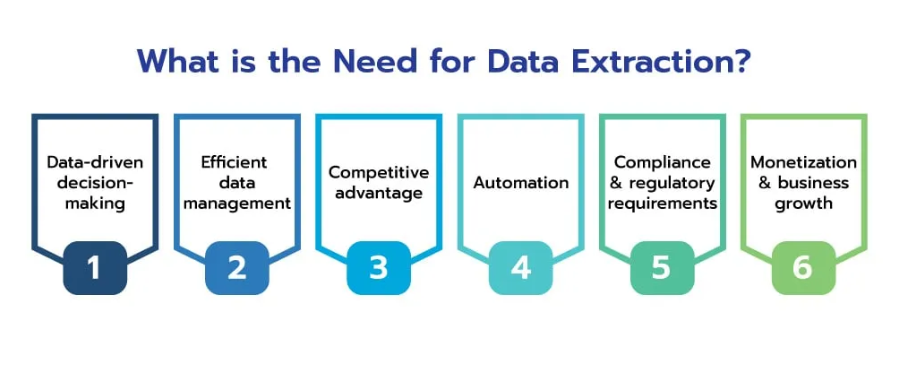

Publicat: 2024-06-06În era datelor mari, accesarea cu crawlere a site-urilor web a devenit un proces indispensabil pentru companiile care urmăresc să valorifice bogăția imensă de informații disponibile online. Prin colectarea, procesarea și analizarea eficientă a datelor web la scară, companiile pot debloca informații valoroase și pot obține un avantaj competitiv în diverse industrii.

Datele web au un potențial imens, oferind perspective profunde asupra tendințelor pieței, comportamentul consumatorilor și peisajele competitive. Capacitatea de a colecta și analiza eficient aceste date poate transforma informațiile brute în inteligență acționabilă, stimulând procesul de luare a deciziilor strategice și creșterea afacerii.

Sursa: scrapehero

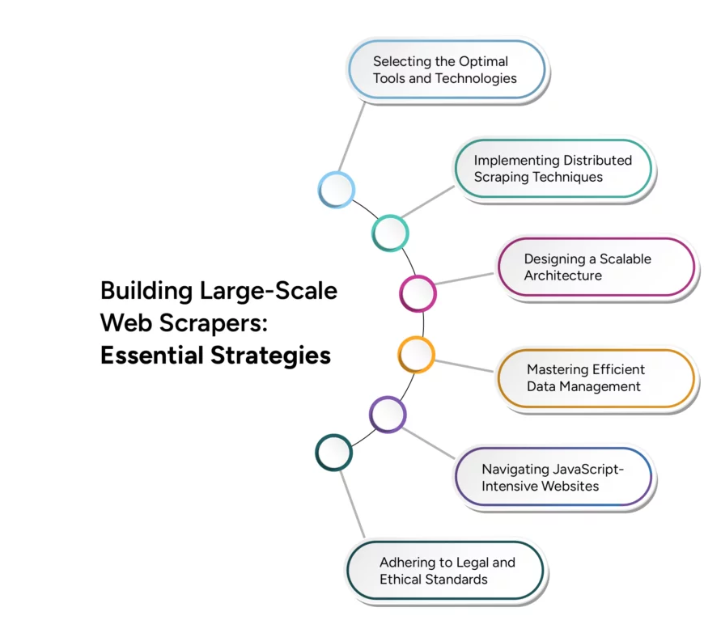

Cu toate acestea, trecerea de la web scraping la scară mică la crawling la scară largă prezintă provocări tehnice semnificative. Scalare eficientă necesită o luare în considerare atentă a diferiților factori, inclusiv infrastructura, managementul datelor și eficiența procesării. Acest articol analizează tehnicile și strategiile avansate necesare pentru a depăși aceste provocări, asigurându-vă că operațiunile dvs. de crawling pe web pot crește pentru a satisface cerințele aplicațiilor de date mari.

Provocările accesării cu crawlere a site-urilor web pentru aplicații de date mari

Accesarea cu crawlere a site-urilor web pentru aplicații de date mari prezintă câteva provocări semnificative pe care companiile trebuie să le abordeze pentru a valorifica în mod eficient puterea vastelor informații online. Înțelegerea și depășirea acestor provocări este crucială pentru construirea unei infrastructuri robuste și scalabile de crawling web.

Una dintre provocările principale este volumul și varietatea de date de pe web, care continuă să crească exponențial. În plus, diversitatea tipurilor de date, de la text și imagini la videoclipuri și conținut dinamic, adaugă complexitate procesului de accesare cu crawlere a site-urilor web. Site-urile web moderne folosesc adesea conținut dinamic generat de JavaScript și AJAX, ceea ce îngreunează acest lucru

crawlerele tradiționale pentru a captura toate informațiile relevante. Mai mult, site-urile web pot impune limite de rată sau pot bloca adrese IP pentru a preveni accesarea cu crawlere excesivă, ceea ce poate perturba eforturile de colectare a datelor.

Asigurarea acurateței și consecvenței datelor colectate din diverse surse poate fi dificilă, mai ales atunci când aveți de-a face cu seturi de date mari. Scalarea operațiunilor de crawling pe web pentru a gestiona încărcările crescânde de date fără a compromite performanța este o provocare tehnică majoră. În plus, respectarea regulilor legale și etice pentru accesarea cu crawlere a site-urilor web este crucială pentru a evita potențialele probleme juridice și pentru a menține o bună reputație. Gestionarea eficientă a resurselor de calcul pentru a echilibra viteza de crawling și eficiența costurilor este, de asemenea, esențială.

Tehnici pentru extragerea eficientă a datelor

Implementarea tehnicilor avansate de extragere a datelor asigură că datele colectate sunt relevante, exacte și gata pentru analiză. Iată câteva tehnici cheie pentru îmbunătățirea eficienței extragerii datelor:

- Procesare paralelă : utilizați procesarea paralelă pentru a distribui sarcinile de extragere a datelor pe mai multe fire sau mașini, crescând viteza de extragere a datelor prin gestionarea simultană a mai multor solicitări și reducând timpul total necesar pentru colectarea datelor.

- Accesare cu crawlere incrementală : implementați accesarea cu crawlere incrementală pentru a actualiza doar părțile setului de date care s-au modificat de la ultima accesare cu crawlere, reducând cantitatea de date procesate și încărcarea pe serverele web, făcând procesul de accesare cu crawlere mai eficient și mai puțin intensiv în resurse.

- Browsere fără cap : utilizați browsere fără cap precum Puppeteer sau Selenium pentru redarea și interacțiunea cu conținut web dinamic, permițând extragerea precisă a datelor de pe site-uri web care se bazează în mare măsură pe JavaScript și AJAX, asigurând o colectare completă a datelor.

- Prioritizarea conținutului : prioritizează conținutul pe baza relevanței și importanței, concentrându-se mai întâi pe datele de mare valoare, asigurându-se că cele mai importante date sunt colectate prompt și optimizând utilizarea resurselor și relevanța datelor.

- Politici de programare URL și politețe : implementați politici inteligente de programare URL și politețe pentru a gestiona frecvența solicitărilor către un singur server, prevenind supraîncărcarea serverelor web și reducând riscul blocării IP, asigurând acces susținut la sursele de date.

- Deduplicarea datelor : Folosiți tehnici de deduplicare a datelor pentru a elimina intrările duplicate în timpul procesului de extracție, îmbunătățind calitatea datelor și reducând cerințele de stocare, asigurându-vă că numai datele unice sunt stocate și procesate.

Soluții de crawling web în timp real

Sursa: Mediu

În peisajul digital cu ritm rapid de astăzi, capacitatea de a extrage și procesa date în timp real este

crucial pentru întreprinderile care doresc să mențină un avantaj competitiv. Soluțiile de crawling web în timp real permit colectarea continuă și instantanee a datelor, permițând analiză și acțiune imediată. Implementarea unei arhitecturi bazate pe evenimente poate îmbunătăți semnificativ capabilitățile în timp real, unde crawlerele sunt declanșate de evenimente sau modificări specifice de pe web, asigurând că datele sunt colectate de îndată ce acestea devin disponibile.

Scalabilitate în accesarea cu crawlere web în mai multe limbi

Natura globală a internetului necesită capacitatea de a accesa cu crawlere și de a procesa date în mai multe limbi, prezentând provocări unice care necesită soluții specializate. Operațiunile de accesare cu crawlere a site-urilor web pentru a gestiona conținutul multilingv implică implementarea algoritmilor de detectare a limbii pentru a identifica automat limba paginilor web și pentru a se asigura că sunt aplicate tehnicile de procesare adecvate specifice limbii. Utilizarea bibliotecilor de analiză și a cadrelor care acceptă mai multe limbi, cum ar fi BeautifulSoup, oferă instrumente robuste pentru extragerea conținutului din diverse pagini web. Integrarea serviciilor de traducere scalabile, cum ar fi Google Cloud Translation, în conducta de procesare a datelor permite traducerea în timp real a conținutului, permițând o analiză fără întreruperi în diferite limbi.

Concluzie

Sursa: groupbwt

Pe măsură ce trecem mai departe în era digitală, importanța accesării cu crawlere a site-urilor web pentru aplicațiile de date mari continuă să crească. Viitorul crawling-ului web constă în capacitatea sa de a scala eficient, de a se adapta la mediile web dinamice și de a oferi informații în timp real. Progresele în inteligența artificială și învățarea automată vor juca un rol esențial în îmbunătățirea capacităților crawlerelor web, făcându-le mai inteligente și mai eficiente în procesarea unor cantități mari de date.

Integrarea sistemelor distribuite și a infrastructurilor bazate pe cloud va îmbunătăți în continuare scalabilitatea, permițând companiilor să gestioneze cu ușurință seturi de date din ce în ce mai mari. Pe măsură ce tehnologiile de accesare cu crawling pe web continuă să evolueze, ele nu numai că vor îmbunătăți procesele de colectare a datelor, ci și vor asigura că întreprinderile își pot menține un avantaj competitiv într-un peisaj digital în continuă schimbare.

Îmbrățișarea acestor progrese nu este doar o opțiune, ci și o necesitate pentru organizațiile care își propun să utilizeze în mod eficient datele mari. Viitorul crawling-ului web promite să fie o forță de transformare, care stimulează inovația și oferă instrumentele necesare pentru a debloca întregul potențial al vastului ecosistem de date web.

Du-ți aplicațiile de date mari la următorul nivel cu serviciile de scraping web personalizabile ale PromptCloud, cu integrare și scalabilitate perfectă. Contactați-ne astăzi pentru a valorifica puterea crawling-ului web avansat pentru afacerea dvs.