Costul real al construirii propriului dvs. crawler web

Publicat: 2023-08-09Web scraping a devenit cea mai comună modalitate de a agrega date din mai multe surse și de a obține informații vitale de pe internet. Acest proces este utilizat pentru a permite soluții bazate pe date la orice, de la potrivirea prețurilor pe site-urile web de comerț electronic până la luarea deciziilor pe piața de valori. Odată cu creșterea cererii de scraping de date de pe web, instrumentele și serviciile care pot face web scraping mai ușoară au inundat și internetul. Cu toate acestea, toate acestea aparțin uneia dintre cele 3 subcategorii -

- Crearea unui instrument intern de scraping web folosind biblioteci precum BeautifulSoup în Python și implementarea acestuia într-un serviciu cloud precum AWS.

- Folosind un software de răzuire semi-automat care poate fi folosit pentru a prinde părți ale ecranului. Este necesară o intervenție umană pentru configurarea inițială, dar sarcinile repetate pot fi automatizate. Cu toate acestea, gradul de automatizare este limitat, echipa de produs sau de afaceri se poate confrunta cu o curbă abruptă de învățare pentru a utiliza instrumentul și nu toate site-urile web pot fi răzuite folosind aceste instrumente. Veți găsi dificultăți suplimentare în gestionarea site-urilor web care generează conținut dinamic folosind tehnologii precum javascript.

- Furnizorii DaaS precum PromptCloud vă oferă un flux de date personalizat bazat pe site-urile web și punctele de date pe care le trimiteți ca cerințe. Aceste servicii vă taxează de obicei în funcție de cantitatea de date pe care o consumați, astfel încât factura dvs. lunară se bazează doar pe cantitatea de date răzuite și s-ar potrivi companiilor de toate dimensiunile.

Acum multe companii își pot imagina că costul asociat cu punctele b sau c este prea mare și decid să construiască singure un crawler web. De ce nu? Doar căutând pe Google „Cum să construiți un crawler web?” ți-ar da 100 de rezultate. Câteva dintre ele pot funcționa chiar și pentru cazul dvs. de utilizare. Dar care este costul real pentru construirea unui crawler web de nivel enterprise, implementarea lui în cloud și întreținerea și actualizarea lui în timp? Să aflăm.

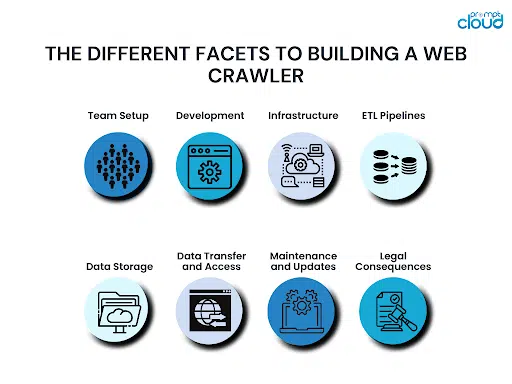

Diferite fațete pentru construirea unui crawler web

Când construiți un crawler web, există diverse aspecte de reținut. Dacă nu luați în considerare toate acestea, puteți ajunge să mușcați mai mult decât puteți mesteca. Asta ar ajunge să te coste prea mult chiar înainte de a ajunge la linia de sosire și atunci ai rămâne blocat între a continua sau a renunța la ea.

Configurarea echipei:

Cerințele majore pentru construirea unui crawler web ar fi cunoștințele de programare și experiența anterioară de a construi un crawler web. Chiar dacă aveți o echipă de tehnologie, este posibil să vă lipsească cineva cu cunoștințe anterioare care să conducă grupul. Fără cineva cu experiență, s-ar putea să ajungi să faci greșeli critice și să nu le realizezi până nu este prea târziu.

Dezvoltare:

Odată ce ai pregătit echipa, ea trebuie să se apuce de dezvoltarea crawler-ului tău web. Acest crawler ar trebui să poată accesa cu crawlere toate punctele de date necesare de pe toate site-urile web din lista dvs. Prin urmare, va dura mult timp nu doar pentru a construi crawler-ul, ci și pentru a testa carcasele marginale și pentru a vă asigura că nu se rupe în niciun moment. În funcție de cât de mare și de experiență este echipa ta, construirea unui nou crawler web de la zero poate dura de la câteva luni până la câteva trimestre.

Infrastructură:

Construirea crawlerului web perfect este dificilă. Decizia asupra unei infrastructuri cloud cu timp de funcționare ridicat, care va fi, de asemenea, optimizată pentru cost, este și mai dificilă. De asemenea, infrastructura dvs. va trebui să fie scalabilă, astfel încât să se poată scala pe măsură ce afacerea dvs. crește și când trebuie să colectați date din mai multe surse.

Conducte ETL:

S-ar putea să nu fie suficientă eliminarea punctelor de date de care aveți nevoie de pe site-urile web alese. De obicei, datele trebuie, de asemenea, normalizate, formatate, curățate și sortate înainte de a fi stocate într-un mediu de stocare. Toate acestea ar necesita mai multă putere de calcul. Deoarece aceste conducte ar adăuga un decalaj în fluxul de date, obținerea infrastructurii corecte pentru a vă configura conductele ETL pe cloud ar fi vitală.

Stocare a datelor:

Odată ce datele dvs. sunt răzuite, curățate și gata, va trebui să le puneți într-un mediu de stocare adecvat. Aceasta poate fi o bază de date SQL sau NoSQL. Ar putea fi, de asemenea, o soluție de depozitare a datelor, cum ar fi Redshift. Alegerea bazei de date va depinde de cât de multe date doriți să stocați, cât de des doriți să actualizați sau să preluați datele, dacă numărul de coloane se poate schimba în viitor și multe altele. La fel ca și restul resurselor, și baza de date trebuie să fie găzduită în cloud, așa că și prețul trebuie luat în considerare.

Transfer de date și acces:

Acum că ați răzuit datele și le-ați stocat într-o bază de date, poate doriți să le preluați la anumite intervale sau chiar continuu. Puteți crea API-uri REST pentru a acorda lumii exterioare acces la datele dvs. Construirea și menținerea stratului de acces la date ar dura timp și veți fi taxat pe baza volumului de transfer de date pe care îl faceți.

Întreținere și actualizări:

Un crawler web nu este niciodată final. Este doar o versiune. O versiune mai nouă trebuie să fie construită de îndată ce orice site web de la care scoate datele este modificat sau actualizat. Adăugarea de site-uri web complexe la lista de site-uri web de răzuit poate necesita, de asemenea, actualizarea crawler-ului. Întreținerea și monitorizarea regulată a resurselor dvs. Cloud sunt, de asemenea, vitale pentru a vă asigura că nu apar erori în sistem și că resursele dvs. de calcul Cloud sunt sănătoase.

Consecințe juridice:

Când răzuiți date de pe web, trebuie să respectați anumite legi ale țării. Acestea ar fi legile privind protecția datelor din țara în care operezi, precum și legile țărilor ale căror date le răzuiești. Orice greșeală poate însemna procese costisitoare. Uneori, plățile, decontările sau taxele legale sunt suficient de bune pentru a distruge o companie.

Cea mai bună soluție de scraping web de nivel Enterprise

Cel mai mare cost pe care îl plătiți pentru construirea propriei soluții de web scraping nu sunt nici măcar banii. Este timpul – afacerea dvs. trebuie să aștepte ca soluția să funcționeze, să fie adăugate noi surse și multe altele. În schimb, alegerea unei soluții DaaS complet funcționale care vă oferă date curate, gata de utilizat și opțiuni de integrare ușoare ar fi o alegere înțeleaptă. Acesta este motivul pentru care echipa noastră de la PromptCloud oferă utilizatorilor noștri soluții de scraping web complet gestionate, găzduite pe cloud.

Puteți începe să utilizați date de oriunde pe web într-un proces în doar 3 pași în care ne oferiți o listă de site-uri web și puncte de date, validați rezultatele unui crawler demonstrativ și apoi treceți la integrarea finală. Fiind o soluție bazată pe cloud, vă taxăm doar în funcție de cantitatea de date pe care o consumați – astfel soluția este accesibilă companiilor de toate dimensiunile. Efectuarea unui calcul detaliat vă va arăta cum economisiți bani atunci când alegeți o soluție DaaS gestionată față de construirea propriului crawler web.

Pentru mai multe detalii, contactați echipa noastră de vânzări la sales@promptcloud.com