Web Scraping Techniques 2023 – Un ghid complet

Publicat: 2023-07-06În lumea vastă a vânătorii de comori online, web scraping a devenit instrumentul suprem pentru extragerea de pietre prețioase de informații. Indiferent dacă ești un aventurier singuratic sau o întreprindere avidă de date, web scraping este târnăcoaica de încredere din setul tău de instrumente digitale.

Cu toate acestea, nu toate tehnicile de web scraping sunt create egale. Este ca și cum ai alege undița perfectă pentru sarcina la îndemână. La urma urmei, nu ai aduce un cârlig mic pentru a prinde o creatură colosală precum Moby Dick, nu? În acest blog, vom dezvălui secretele din spatele tehnicilor manuale, automate și avansate de web scraping.

Imaginați-vă că adunați o echipă de supereroi, fiecare cu propriile puteri și slăbiciuni speciale. De asemenea, fiecare abordare de scraping are punctele sale forte și limitările sale.

Dar să nu uităm de importanța acțiunilor responsabile în web scraping. Așa cum un cavaler nu și-ar încălca niciodată jurământul, este esențial să răzbuneți din punct de vedere etic și să respectați termenii și condițiile site-urilor web pe care doriți să le eliminați.

Tehnici automate de răzuire web

Web scraping automat se referă la procesul de utilizare a software-ului sau a instrumentelor pentru a extrage automat date de pe site-uri web. Această abordare automată elimină necesitatea copierii și lipirii manuale a datelor, permițând colectarea eficientă și la scară largă a datelor din diverse surse online.

1. Biblioteci web scraping

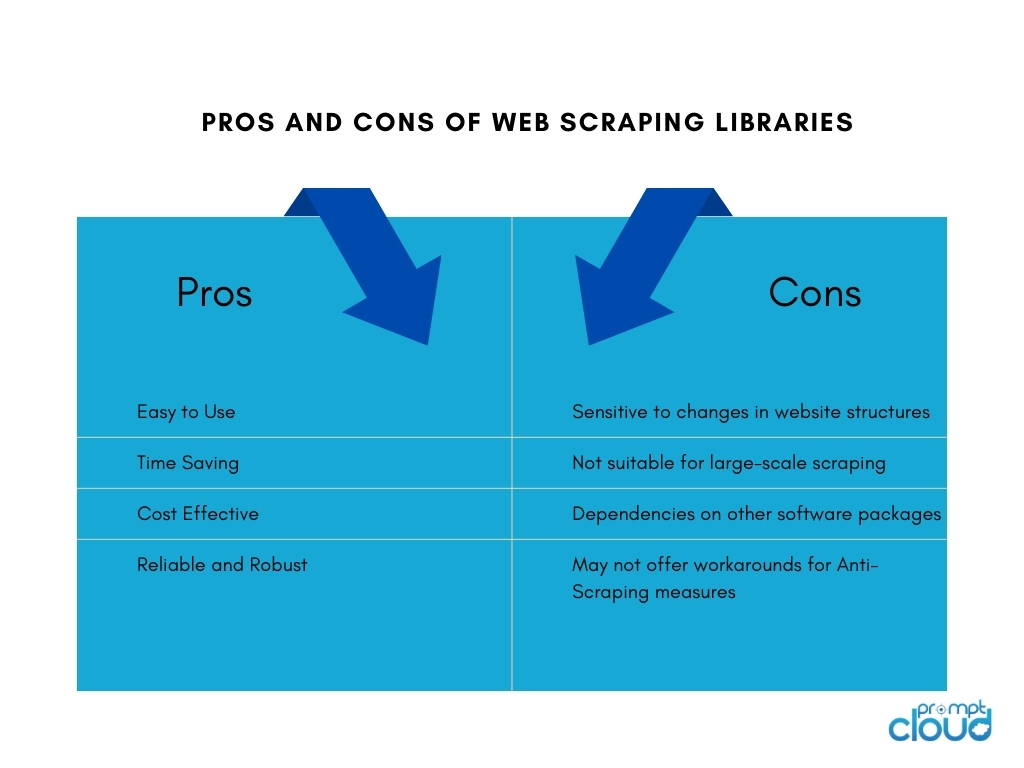

Bibliotecile de web scraping sunt instrumente software sau cadre care oferă funcții și utilități pre-construite pentru a facilita sarcinile de web scraping. Ele oferă o modalitate simplificată și eficientă de a efectua web scraping fără a fi nevoie să scrieți totul de la zero. Ele economisesc timp, cresc productivitatea și permit o colectare mai eficientă a datelor din diverse surse online.

Unele dintre bibliotecile populare de web scraping includ:

- BeautifulSoup: O bibliotecă Python utilizată pe scară largă pentru web scraping, care oferă un API intuitiv pentru a analiza documente HTML și XML, permițând utilizatorilor să navigheze și să extragă date fără efort.

- Scrapy: un cadru Python puternic pentru web scraping, care oferă un set cuprinzător de instrumente pentru construirea de crawler-uri web scalabile și eficiente, cu caracteristici precum limitarea automată a cererilor, pipeline de articole și suport încorporat pentru gestionarea paginației.

- Selenium: o bibliotecă versatilă care permite interacțiuni automate cu browser pentru web scraping, deosebit de utilă atunci când se ocupă cu conținut dinamic și site-uri web cu JavaScript.

- Puppeteer: O bibliotecă Node.js care oferă un API de nivel înalt pentru a controla un browser Chrome sau Chromium fără cap, permițând web scraping și interacțiunea cu paginile web folosind JavaScript.

2. Instrumente și servicii Web Scraping

Instrumente de răzuire web

Instrumentele web scraping sunt aplicații software sau platforme concepute special pentru automatizarea și simplificarea procesului de web scraping. Aceste instrumente oferă adesea o interfață ușor de utilizat, care permite utilizatorilor să specifice datele pe care doresc să le extragă de pe site-uri web fără a necesita cunoștințe extinse de programare.

De obicei, oferă caracteristici precum selecția prin punct și clic a elementelor de date, capabilități de programare și monitorizare și opțiuni de export de date. Instrumentele web scraping pot fi benefice pentru persoanele fizice sau companiile care necesită extragerea datelor fără a fi nevoie de resurse extinse de codare sau dezvoltare.

Construirea de instrumente interne de răzuire web

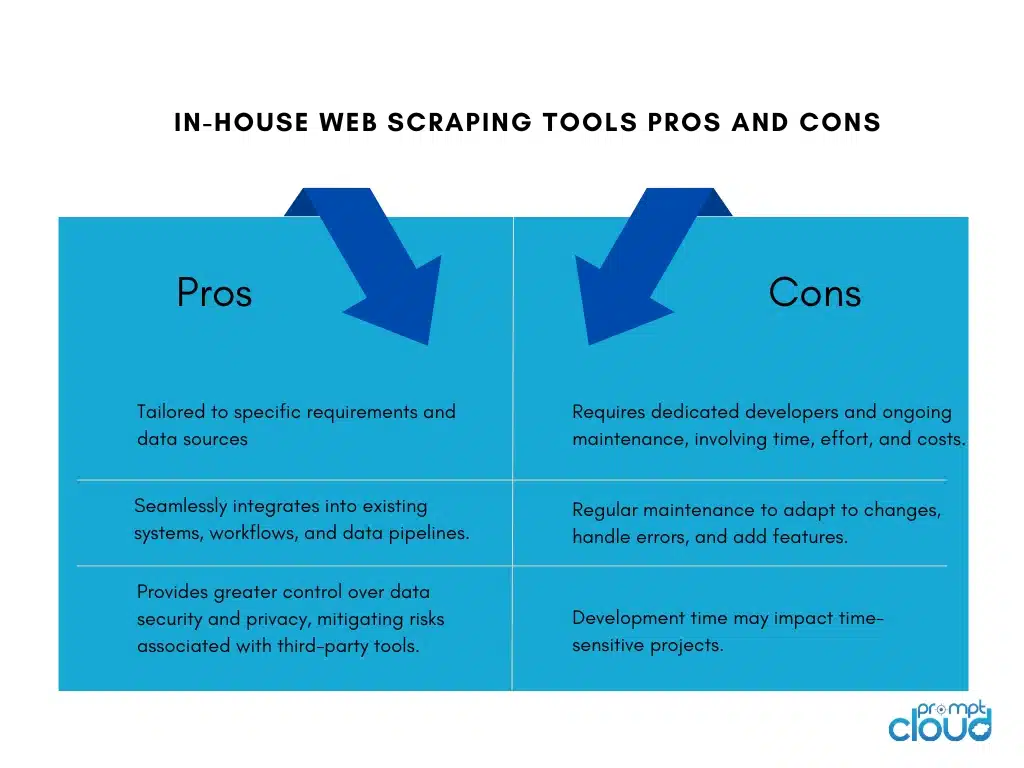

Construirea unui instrument intern de scraping web pentru o companie are avantajele și dezavantajele sale:

Servicii de web scraping

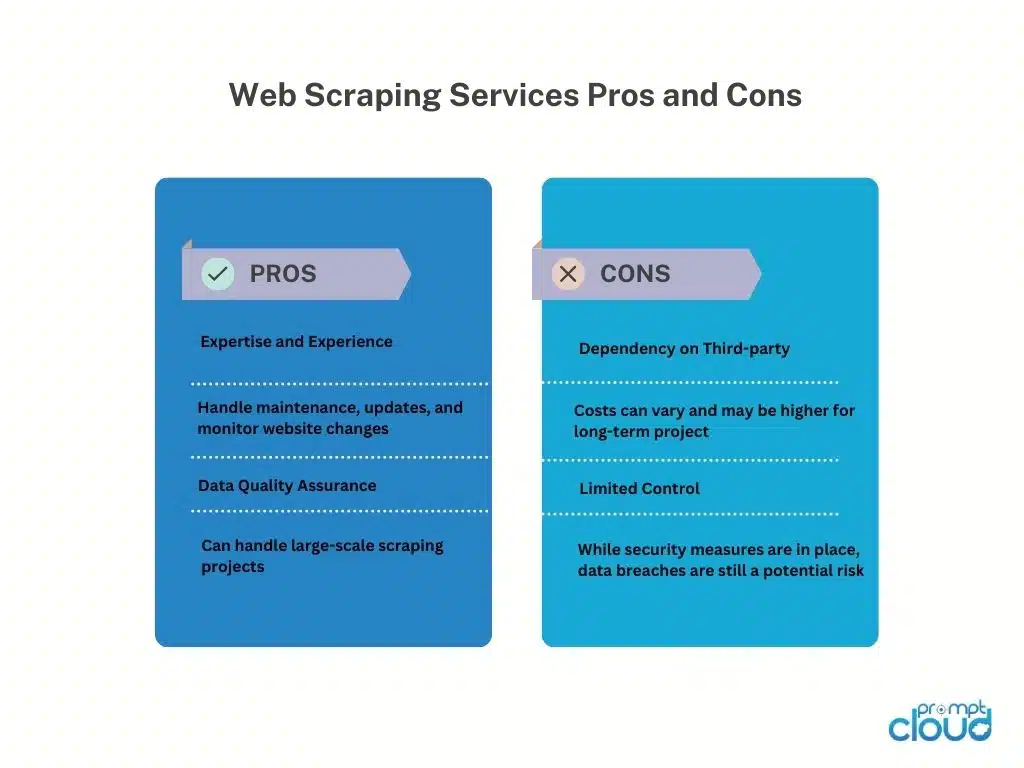

Furnizorii de servicii de scraping web oferă servicii specializate pentru extragerea datelor de pe site-uri web. Acești furnizori au de obicei infrastructură, instrumente și expertiză dedicate gestionării sarcinilor de web scraping în numele clienților.

Iată avantajele și dezavantajele utilizării furnizorilor de servicii de web scraping:

API-uri Web Scraping

API-urile Web scraping oferă o interfață programatică care permite dezvoltatorilor să acceseze și să recupereze date de pe site-uri web folosind metode standardizate. Aceste API-uri oferă o abordare mai structurată și controlată a web scraping în comparație cu tehnicile tradiționale de scraping. Dezvoltatorii pot trimite cereri către API, specificând datele de care au nevoie și primind datele răzuite într-un format structurat, cum ar fi JSON sau XML.

Pro

API-urile de scraping web simplifică procesul de scraping, permițând dezvoltatorilor să se concentreze pe integrarea API-ului și pe manipularea datelor. Ele oferă fiabilitate și performanță datorită întreținerii furnizorului și pot include caracteristici precum autentificarea și limitarea ratei. API-urile ajută, de asemenea, la respectarea termenilor și cerințelor legale.

Contra

Utilizarea API-urilor web scraping are limitări. Disponibilitatea și capabilitățile datelor depind de furnizorul de API, cu posibile restricții asupra site-urilor web acceptate și limite de scraping. Dependența de API-ul extern introduce dependența de disponibilitatea și performanța furnizorului, influențând recuperarea datelor. În plus, pot exista costuri asociate utilizării de volum mare sau comerciale.

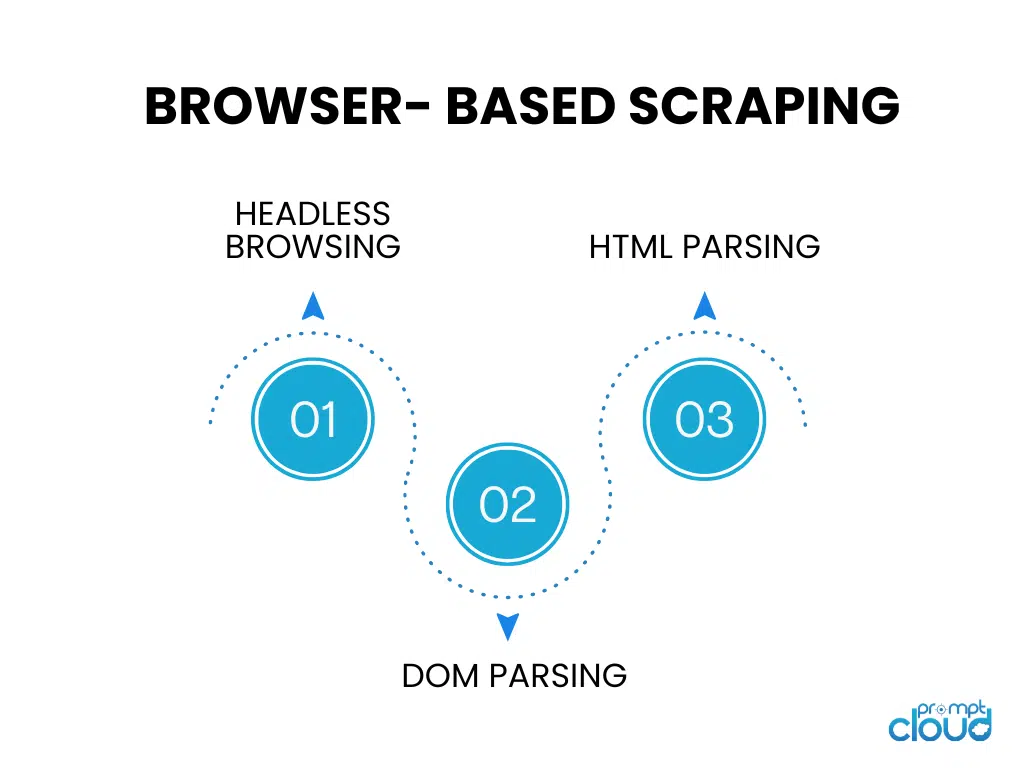

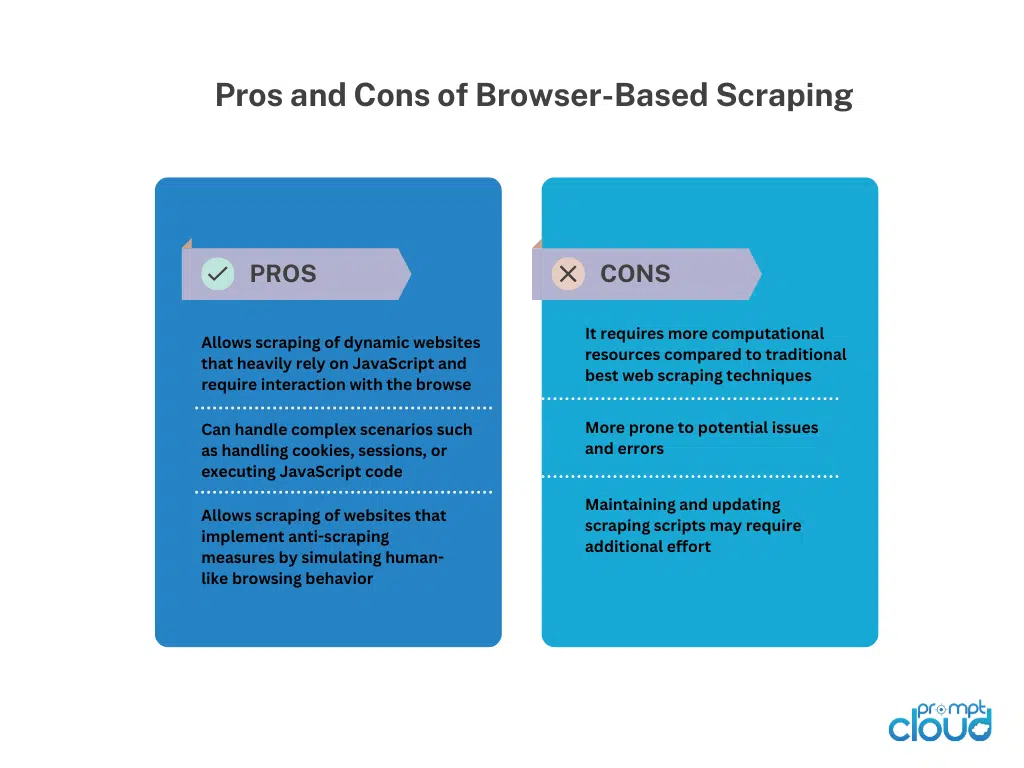

Scraping bazat pe browser

Navigare fără cap

Navigarea fără cap rulează un browser web fără o interfață grafică cu utilizatorul, permițând navigarea automată și interacțiunea cu site-urile web folosind cod. Este ideal pentru scraping site-uri web dinamice care se bazează în mare măsură pe randarea la nivelul clientului.

Analiza DOM

Analiza DOM implică manipularea structurii HTML a unei pagini web prin accesarea modelului obiect document. Acest lucru permite extragerea țintită a elementelor, atributelor sau textului în mod programatic.

Analiza HTML

Analiza HTML analizează codul sursă HTML al unei pagini web pentru a extrage datele dorite. Utilizează biblioteci sau analizoare pentru a interpreta structura HTML și pentru a identifica etichete, atribute sau modele specifice pentru extragerea datelor. Analiza HTML este folosită în mod obișnuit pentru răzuirea paginilor web statice fără executarea JavaScript.

Tehnici manuale de răzuire pe web

Tehnici manuale de răzuire pe web

Web scraping manual se referă la procesul de extragere manuală a datelor de pe site-uri web, fără utilizarea de instrumente sau scripturi automate. Aceasta implică intervenția umană pentru a naviga pe site-uri web, a căuta informații relevante și a extrage date folosind diverse tehnici.

Tehnici de răzuire manuală pe web:

Captură de ecran: această tehnică implică capturarea de capturi de ecran sau videoclipuri ale paginilor web pentru a extrage date vizuale precum imagini, diagrame sau tabele care sunt dificil de analizat programatic.Extragerea manuală din mediul capturat permite recuperarea datelor.

Introducerea datelor: în introducerea datelor, informațiile necesare sunt copiate manual din paginile web și introduse într-un format dorit, cum ar fi foi de calcul sau baze de date.Aceasta implică navigarea în paginile web, selectarea datelor și introducerea acestora în destinația țintă. Introducerea datelor este potrivită pentru date structurate care pot fi ușor copiate și lipite.

Scraping manual web oferă flexibilitate atunci când aveți de-a face cu site-uri web complexe, interactivitate JavaScript sau măsuri anti-scraping. Cu toate acestea, este consumator de timp, mai puțin potrivit pentru sarcini la scară largă și predispus la erori umane. Necesită efort uman, atenție la detalii și execuție atentă.

Tehnici hibride de scraping Web

Scrapingul web hibrid combină instrumente automate și intervenția manuală pentru extragerea eficientă și precisă a datelor de pe site-uri web. Instrumentele automate gestionează sarcini repetitive, cum ar fi navigarea și extragerea datelor structurate, în timp ce tehnicile manuale, cum ar fi capturarea ecranului sau introducerea de date, abordează scenarii complexe și date vizuale/nestructurate.

Hybrid Web Scraping oferă scalabilitate și viteză de automatizare, împreună cu flexibilitatea raționamentului uman. Se potrivește site-urilor web cu structuri diverse, conținut dinamic sau măsuri anti-scraping. Alegerea depinde de complexitatea site-ului web, tipul de date și resursele disponibile, oferind o abordare echilibrată pentru extragerea completă a datelor.