Предотвращение коллапса модели ИИ: устранение риска, присущего синтетическим наборам данных

Опубликовано: 2023-10-05Искусственный интеллект (ИИ) значительно изменил нашу повседневную жизнь, предлагая персонализированный контент на платформах потокового вещания и предоставляя цифровых помощников на смартфонах. Теперь эти достижения стали возможными благодаря сложным моделям искусственного интеллекта, которые обучаются на огромных объемах данных.

Согласно различным отчетам, контент, созданный искусственным интеллектом, становится все более распространенным в Интернете и в ближайшие годы потенциально будет составлять до 90% онлайн-информации.

При таком притоке информации можно легко сказать, что в современном мире, богатом данными, ИИ сталкивается с уникальной проблемой: он задыхается от обилия данных.

В отчетах также предполагается, что значительный объем этого контента, созданного ИИ, может перегрузить людей избыточной информацией, что затрудняет определение того, что заслуживает доверия и создано людьми. Кроме того, существуют опасения по поводу потенциальной потери рабочих мест в творческих областях, таких как искусство, журналистика и писательство, и все потому, что ИИ становится все более способным создавать контент, традиционно создаваемый людьми.

Что касается самих систем искусственного интеллекта, возникают такие проблемы, как «коллапс модели», который относится к проблеме, когда модели искусственного интеллекта, обученные на больших наборах данных, дают результаты более низкого качества из-за того, что отдают предпочтение обычному выбору слов над творческими альтернативами. «Модельное расстройство аутофагии» или «Габсбургский ИИ» — еще одна проблема, когда системы ИИ, чрезмерно обученные на результатах других моделей ИИ, могут проявлять нежелательные функции или иметь предвзятость.

Эти проблемы потенциально могут нанести вред качеству и надежности контента, создаваемого ИИ, разрушая доверие к таким системам и увеличивая информационную перегрузку.

Наш блог поможет вам понять все, что касается предотвращения коллапса модели ИИ. По мере развития генеративной революции искусственного интеллекта она порождает серьезные проблемы и неопределенности для информационного онлайн-пространства. Итак, давайте углубимся в детали.

Понимание коллапса модели ИИ

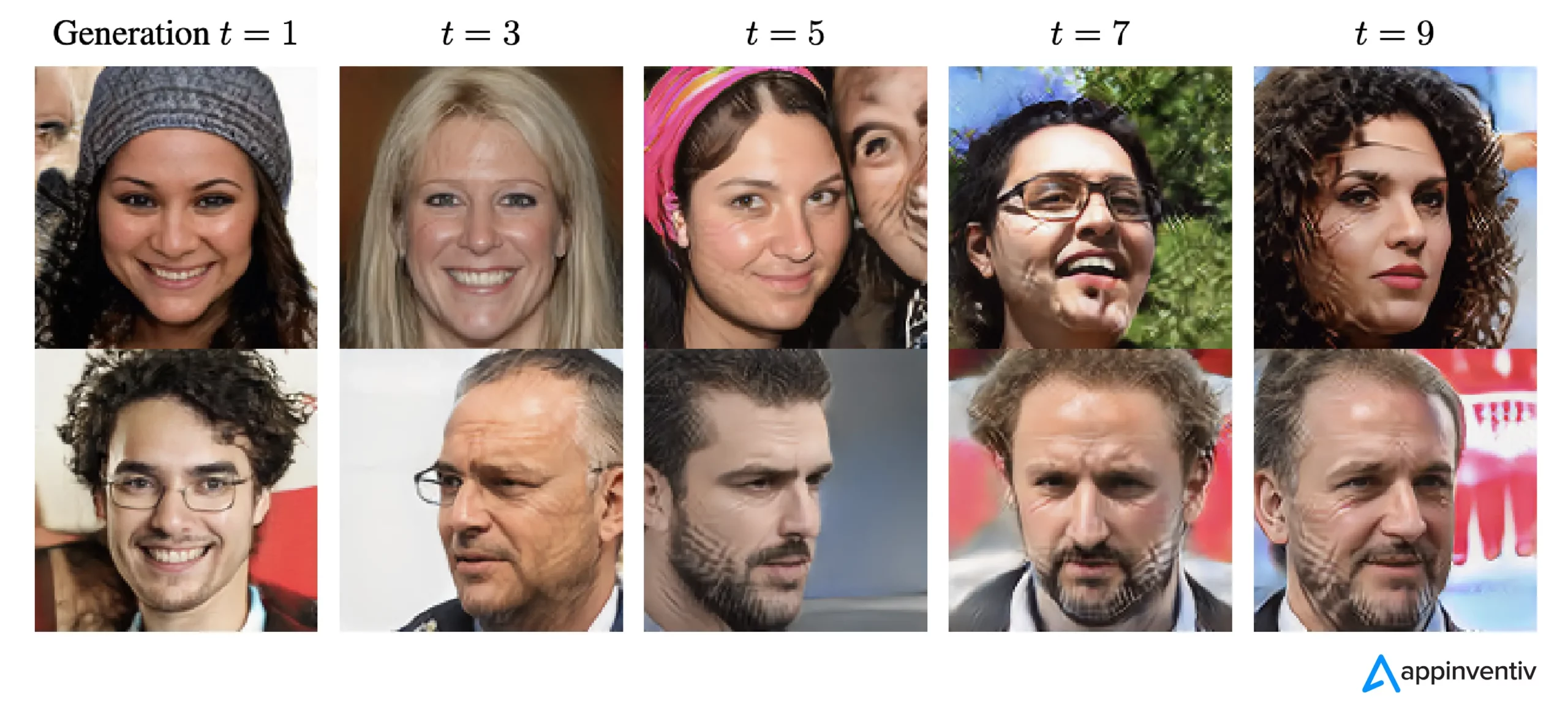

В машинном обучении «коллапс модели» относится к ситуации, когда модель ИИ не может обеспечить множество полезных результатов. Вместо этого он дает узкий набор повторяющихся или некачественных результатов. Эта проблема может возникнуть в различных моделях, но она часто наблюдается при обучении сложных моделей, таких как генеративно-состязательные сети (GAN). Коллапс модели может затруднить ее способность генерировать разнообразные и ценные результаты, влияя на ее общую производительность.

Проиллюстрируем пример коллапса модели. Представьте себе увлеченного студента-художника, представляющего нашу модель искусственного интеллекта, которому поручено создавать картины с изображением зебр. Вначале их работы впечатляют и отчетливо напоминают зебр. Однако их картины постепенно теряют сходство с зебрами, а качество снижается. Это похоже на «коллапс модели» в машинном обучении, когда модель ИИ, как и наш студент-художник, сначала работает хорошо, но затем с трудом сохраняет основные характеристики, для которых она была разработана.

Учитывая недавние достижения в области ИИ, исследователи стали очень заинтересованы в использовании искусственных или синтетических данных для обучения новых моделей ИИ, когда дело доходит до генерации изображений и текста. Однако концепция под названием «Модельное расстройство аутофагии» (MAD) сравнивает этот процесс с циклом саморазрушения.

Если мы не продолжим регулярно добавлять свежие реальные данные, качество и разнообразие моделей ИИ, которые мы создаем с использованием синтетических данных, со временем могут ухудшиться. Поэтому важно найти баланс между синтетическими и реальными данными, чтобы модели ИИ работали хорошо.

Этот баланс имеет решающее значение для предотвращения снижения качества и разнообразия моделей по мере их дальнейшего обучения. Поиск того, как эффективно использовать синтетические данные для предотвращения коллапса модели ИИ, является постоянной проблемой, когда речь идет об эволюции генеративного ИИ и использовании синтетических данных.

По данным The New Yorker, если ChatGPT считается компактной версией Интернета, подобной JPEG-файлу, сжимающему фотографию, то обучение будущих чат-ботов на результатах ChatGPT в цифровом виде эквивалентно многократному копированию фотокопий, как старые времена. Проще говоря, качество изображения обязательно будет ухудшаться с каждой итерацией.

Таким образом, чтобы преодолеть эту проблему, организациям необходимо сосредоточиться на совершенствовании своих подходов, чтобы продукты генеративного искусственного интеллекта продолжали обеспечивать точные ответы в этой цифровой среде.

[Также читайте: Ответственный ИИ: решение проблем внедрения с помощью руководящих принципов и стратегий]

Как происходит коллапс модели ИИ?

Коллапс модели происходит, когда новые модели ИИ обучаются с использованием данных, сгенерированных старыми моделями. Эти новые модели основаны на закономерностях, наблюдаемых в сгенерированных данных. Коллапс модели основан на идее о том, что генеративные модели имеют тенденцию повторять шаблоны, которые они уже изучили, и существует предел информации, которую они могут извлечь из этих шаблонов.

В случаях коллапса модели события, которые могут произойти, преувеличиваются, а менее вероятные события недооцениваются. На протяжении нескольких поколений вероятные события доминируют в данных, а менее распространенные, но все же важные части данных, называемые хвостами, уменьшаются. Эти хвосты необходимы для поддержания точности и разнообразия результатов модели. По мере развития поколений ошибки побеждают данные, и модель все чаще неверно их интерпретирует.

Согласно исследованию, существует два типа краха модели: ранний и поздний. Ранний крах модели приводит к потере модели информации о редких событиях. При коллапсе поздней модели модель размывает отдельные закономерности в данных, в результате чего выходные данные мало похожи на исходные данные.

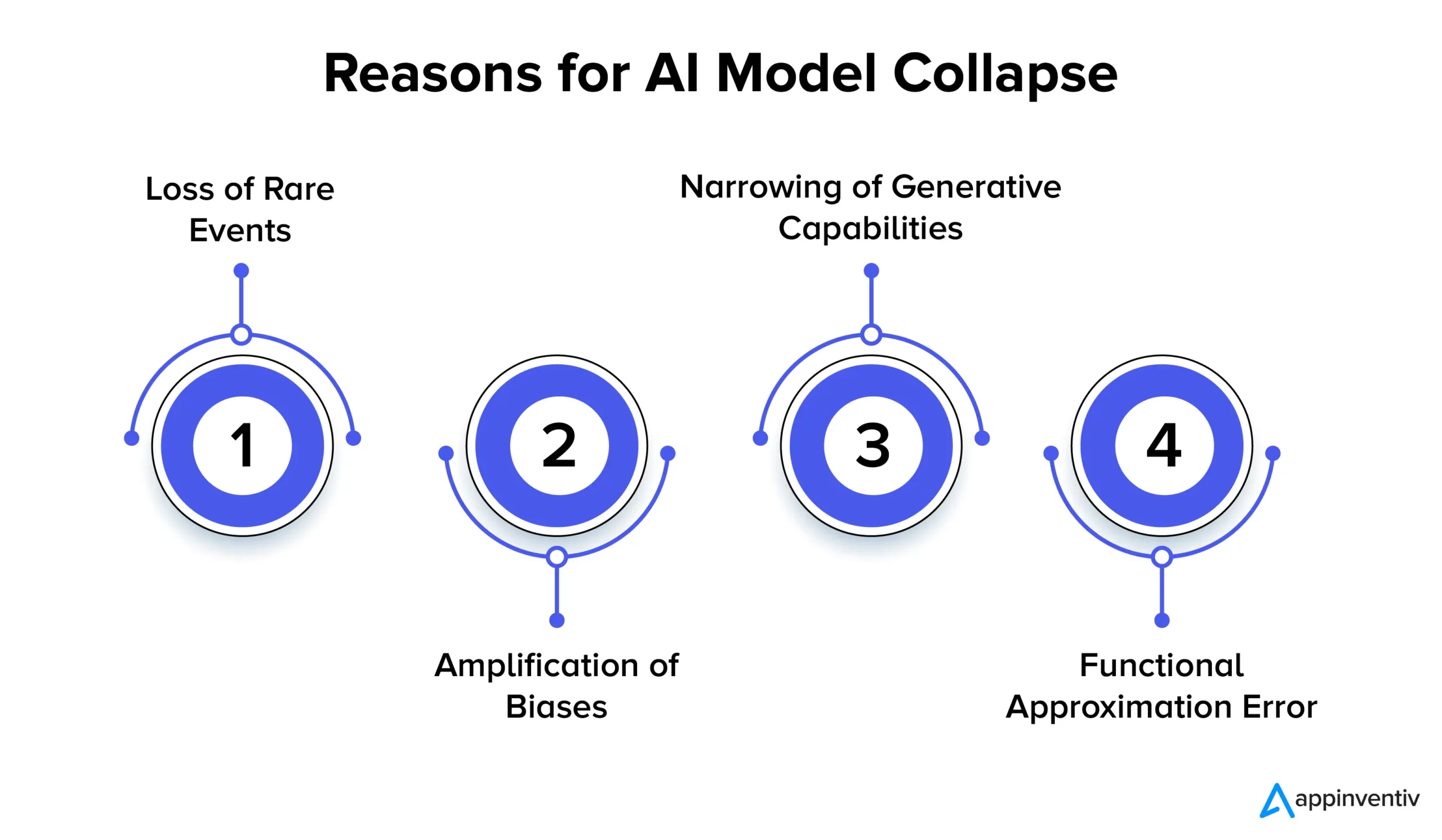

Давайте подробно рассмотрим несколько причин краха модели ИИ ниже:

Потеря редких событий

Когда модели ИИ неоднократно обучаются на данных, сгенерированных их предыдущими версиями, они пытаются сосредоточиться на общих закономерностях и забыть о редких событиях. Это явление похоже на то, как модели теряют долговременную память. Редкие события часто имеют большое значение, например выявление аномалий в производственных процессах или обнаружение мошеннических транзакций. Например, когда дело доходит до обнаружения мошенничества, определенные языковые шаблоны могут сигнализировать о мошенническом поведении, поэтому крайне важно сохранять и изучать эти редкие шаблоны.

Усиление предубеждений

Каждая итерация обучения на данных, сгенерированных ИИ, может усиливать существующие предвзятости в обучающих данных. Поскольку выходные данные модели обычно отражают данные, на которых она была обучена, любые отклонения в этих данных со временем могут преувеличиваться. Это может привести к усилению смещения в различных приложениях искусственного интеллекта. Например, результаты могут привести к таким проблемам, как дискриминация, расовая предвзятость и предвзятый контент в социальных сетях. Таким образом, крайне важно внедрить меры контроля для выявления и смягчения предвзятости.

Сужение генеративного потенциала

Поскольку модели ИИ продолжают учиться на основе сгенерированных данных, их генеративные возможности могут сузиться. Модель оказывается под влиянием собственных интерпретаций реальности, создавая все более схожий контент, которому не хватает разнообразия и представления редких событий. Это может привести к потере оригинальности. Например, когда дело доходит до моделей большого языка (LLM), их вариации придают каждому писателю или художнику свой особый тон и стиль.

Исследования просто показывают, что если свежие данные не добавляются регулярно в процессе обучения, будущие модели ИИ со временем могут стать менее точными или давать менее разнообразные результаты.

Ошибка функционального приближения

Ошибка функциональной аппроксимации может возникнуть, когда аппроксиматоры функций, используемые в модели, недостаточно выразительны. Хотя эту ошибку можно смягчить за счет использования более выразительных моделей, она также может внести шум и привести к переобучению. Нахождение правильного баланса между выразительностью модели и контролем шума имеет решающее значение для предотвращения этих ошибок.

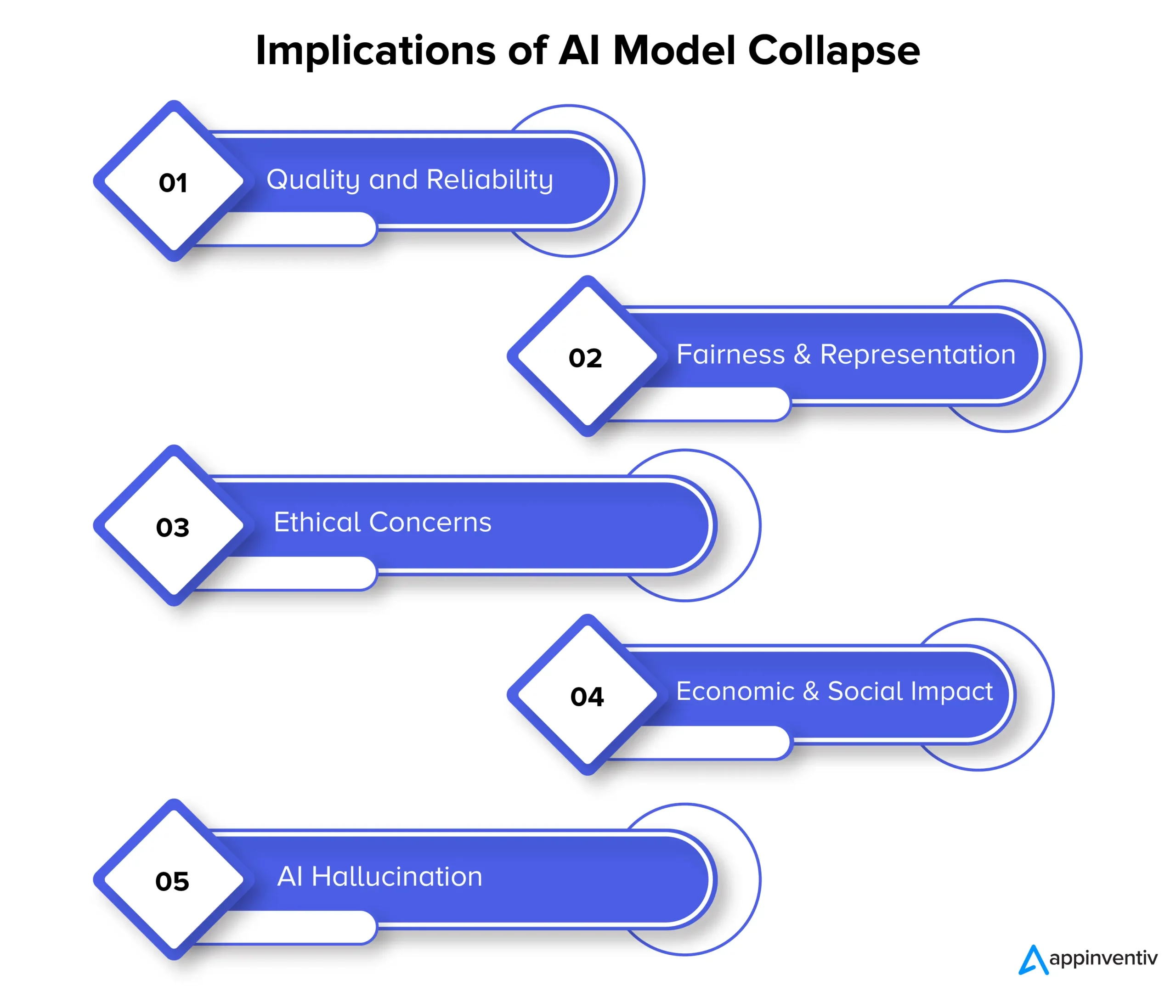

Последствия коллапса модели: почему важна стабильность модели ИИ?

Крах модели может в конечном итоге повлиять на качество, надежность и справедливость контента, создаваемого ИИ, что также может создать ряд рисков для организаций. Давайте подробно рассмотрим последствия коллапса модели ниже:

Качество и надежность

По мере того, как модели ИИ деградируют в процессе обучения, генерируемый ими контент становится менее надежным, а его качество ухудшается. Это происходит, когда модели отрываются от исходного распределения данных и больше полагаются на собственные интерпретации реальности. Например, модель ИИ, предназначенная для генерации новостей, может создавать неточные или даже полностью сфабрикованные новостные статьи.

Справедливость и представительство

Коллапс модели также является поводом для беспокойства, когда речь идет о справедливости и представлении созданного контента. Когда модели забывают редкие события и ограничивают свои творческие способности, контент, относящийся к менее распространенным темам, может быть представлен неадекватно. Это приводит к предвзятости, стереотипам и исключению определенных точек зрения.

Этические проблемы

Крах модели вызывает серьезные этические проблемы, особенно когда контент, созданный ИИ, может влиять на принятие решений. Последствия краха модели включают распространение предвзятого и неточного контента, который может существенно повлиять на жизнь, мнения и доступ людей к возможностям.

Экономическое и социальное воздействие

В экономическом и социальном масштабе крах модели может повлиять на доверие и внедрение технологий искусственного интеллекта. Если на контент, созданный искусственным интеллектом, нельзя положиться, предприятия и потребители могут не решиться использовать эти технологии. Это может иметь экономические последствия, и, как следствие, может пострадать доверие к технологиям искусственного интеллекта.

ИИ Галлюцинация

Галлюцинации ИИ — это когда модели ИИ создают воображаемый или нереалистичный контент, который не соответствует фактам или каким-либо образом несогласован. Это может привести к получению неточной информации, что может привести к дезинформации или путанице. Это существенно проблематично в таких приложениях, как создание новостей, диагностика заболеваний или создание юридических документов, где точность и надежность чрезвычайно важны.

Давайте объясним контекст на примере галлюцинации ИИ. Предположим, существует модель ИИ, обученная генерировать изображения животных. Теперь при запросе изображения животного модель может создать изображение «зеброида», гибрида зебры и лошади. Хотя это изображение может показаться визуально реалистичным, важно понимать, что это всего лишь плод воображения модели ИИ, поскольку в реальном мире такого животного не существует.

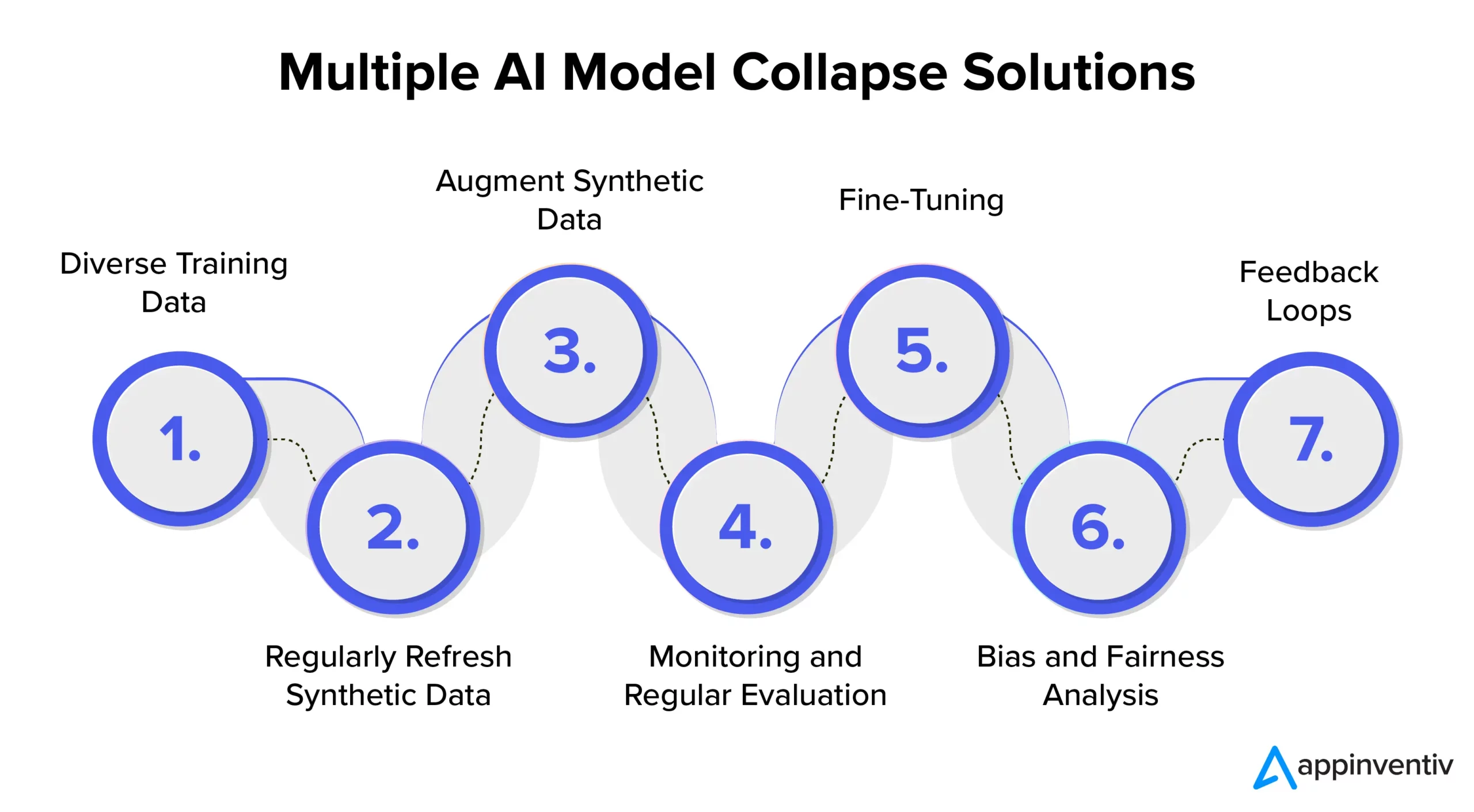

Предотвращение коллапса модели ИИ: понимание решений коллапса модели ИИ

Чтобы обеспечить стабильность и надежность модели ИИ, важно изучить стратегии и лучшие практики для эффективного предотвращения разрушения модели ИИ. Таким образом, рекомендуется сотрудничать со специализированной фирмой по разработке искусственного интеллекта, такой как Appinventiv, которая может предоставить экспертные знания и рекомендации по реализации этих превентивных мер, одновременно гарантируя, что ваши системы искусственного интеллекта постоянно обеспечивают высококачественные результаты.

Разнообразные тренировочные данные

Для эффективного устранения коллапса модели ИИ и предотвращения нежелательных результатов крайне важно создать набор обучающих данных, включающий различные источники и типы данных. Этот набор данных должен состоять как из синтетических данных, сгенерированных моделью, так и из реальных данных, которые точно отражают сложность проблемы. Важно регулярно обновлять этот набор данных новой и актуальной информацией. Модель подвергается воздействию широкого спектра шаблонов за счет включения разнообразных обучающих данных. Это помогает предотвратить застой данных.

Регулярно обновляйте синтетические данные

Коллапс модели представляет собой риск, когда модели ИИ в значительной степени полагаются на собственные данные. Для эффективного снижения рисков в сфере ИИ важно регулярно вводить в процесс обучения новые, достоверные, реальные данные. Такая практика гарантирует, что модель останется адаптивной и не застрянет в повторяющемся цикле. Это может помочь в получении разнообразных и актуальных результатов.

Дополните синтетические данные

Улучшение синтетических данных с помощью методов увеличения данных — проверенный метод предотвращения разрушения модели. Эти методы вносят изменчивость в синтетические данные, используя естественные вариации реальных данных. Добавление контролируемого шума к сгенерированным данным побуждает модель изучать более широкий диапазон закономерностей, уменьшая вероятность генерации повторяющихся результатов.

Мониторинг и регулярная оценка

Регулярный мониторинг и оценка производительности модели ИИ имеет решающее значение для раннего обнаружения разрушения модели. Внедрение структуры MLOps обеспечивает постоянный мониторинг и соответствие целям организации, тем самым обеспечивая своевременное вмешательство и корректировку.

[Также читайте: Как избежать нарушений соответствия при разработке продуктов искусственного интеллекта]

Тонкая настройка

Важно рассмотреть возможность реализации стратегий точной настройки для поддержания стабильности модели и предотвращения коллапса. Эти стратегии предотвращения сбоев модели ИИ позволяют модели адаптироваться к новым данным, сохраняя при этом предыдущие знания.

Анализ предвзятости и справедливости

Строгий анализ предвзятости и справедливости имеет решающее значение для предотвращения краха модели и этических проблем. Крайне важно выявлять и устранять отклонения в результатах модели. Вы можете поддерживать надежные и объективные результаты модели, активно решая эти проблемы.

Петли обратной связи

Внедрение циклов обратной связи, включающих обратную связь с пользователем, имеет решающее значение для предотвращения коллапса модели. Последовательно собирая мнения пользователей, можно вносить обоснованные корректировки в выходные данные модели. Этот процесс уточнения гарантирует, что модель останется актуальной, надежной и соответствующей ожиданиям пользователей.

Как Appinventiv может помочь в снижении рисков в моделях искусственного интеллекта?

В развивающемся мире искусственного интеллекта проблемы, возникающие из-за краха модели, беспокоят как технологических гигантов, так и новаторов. Долгосрочное ухудшение наборов данных языковых моделей и манипулирование контентом оставили свой след в этой цифровой экосистеме.

По мере развития ИИ жизненно важно различать искусственно сгенерированные данные и контент, созданный человеком. Граница между подлинным контентом и тем, что создается машиной, становится все более размытой.

Теперь, среди этих проблем и предотвращения сбоев модели ИИ, партнерство со специализированной компанией по разработке ИИ, такой как Appinventiv, может дать вам столь необходимое утешение. Обладая опытом в разработке моделей ИИ и приверженностью этическим практикам ИИ, мы можем помочь вам разобраться в сложностях ИИ, обеспечивая при этом надежность и целостность ваших систем ИИ.

Наши эксперты могут работать с вами над эффективным предотвращением разрушения модели искусственного интеллекта, обеспечением прозрачности и построением будущего с аутентичным контентом, который не ставит под угрозу подлинность контента, созданного человеком.

Мы понимаем, что обучение моделей ИИ свежими и разнообразными данными имеет важное значение для предотвращения деградации модели. Оценка модели ИИ — это ключевой шаг в нашем процессе разработки модели, в котором используются метрики для оценки производительности, выявления слабых мест и обеспечения эффективных прогнозов на будущее.

Наша команда экспертов может помочь гарантировать, что ваши системы искусственного интеллекта продолжат учиться и адаптироваться к развивающейся цифровой среде. Свяжитесь с нашими экспертами, чтобы снизить риски, связанные с крахом моделей, и обеспечить их эффективность.

Часто задаваемые вопросы

Вопрос. Что такое коллапс модели ИИ?

А. Коллапс модели ИИ в машинном обучении означает неспособность модели ИИ производить разнообразные полезные результаты. Вместо этого он генерирует повторяющиеся или некачественные результаты. Эта проблема может возникать в моделях разных типов, но особенно она наблюдается при обучении сложных моделей, таких как генеративно-состязательные сети (GAN).

Вопрос. Каковы распространенные причины краха модели ИИ?

A. Общие причины краха модели ИИ включают потерю редких событий, усиление систематических ошибок, сужение генеративных возможностей, ошибки функциональной аппроксимации и т. д. Эти факторы могут привести к тому, что модели будут давать неоптимальные результаты.

Вопрос. Как предотвратить разрушение модели ИИ?

О. Для эффективного предотвращения коллапса модели ИИ жизненно важно использовать различные обучающие данные, аналогичные реальным, постоянный мониторинг и оценку данных, исправление любых ошибок и внедрение тщательного тестирования и контроля качества. Сотрудничество с экспертами в области искусственного интеллекта из Appinventiv может предложить вам ценную информацию и решения для снижения рисков разрушения модели.