Под кодексом: анализ фундаментальных рисков ИИ и мер противодействия им

Опубликовано: 2023-09-25Организации быстро погружаются с головой в мир искусственного интеллекта, чтобы ускорить свои процессы и получить конкурентное преимущество. Однако очень важно понимать, что их путь к искусственному интеллекту не всегда будет солнечным и радужным и может сопровождаться определенными рисками и проблемами. Поскольку технология искусственного интеллекта развивается с беспрецедентной скоростью, организации должны быть готовы к глобальной адаптации. Чтобы добиться успеха в этой жестокой цифровой экосистеме, крайне важно понимать потенциальные ловушки и использовать лучшие практики навигации по мультивселенной искусственного интеллекта.

Поскольку искусственный интеллект продолжает развиваться, растет беспокойство по поводу его потенциальных опасностей. Джеффри Хинтон, «Крестный отец искусственного интеллекта», известный своими похвальными работами в области машинного обучения и нейронных сетей, предупредил, что системы искусственного интеллекта развиваются беспрецедентными темпами и могут представлять риск захвата контроля, если не будут осуществляться с должным надзором. Он далее подчеркнул жизненно важную необходимость активного решения этих связанных проблем.

В другом случае Илон Маск также высказался за паузу в крупномасштабных экспериментах с искусственным интеллектом. Эти опасения мировых лидеров по поводу потенциальных рисков ИИ отражают то, что технологическому сообществу необходимо тщательно рассмотреть последствия и этические проблемы, которые могут возникнуть с развитием возможностей ИИ.

Сейчас, по мере развития мира, генеративный ИИ имеет тенденцию становиться широко популярным. Поскольку великая держава часто влечет за собой безусловную ответственность, внедрение генеративного ИИ также сопряжено с определенным этическим риском.

Итак, как владельцу бизнеса, пора понять, что ИИ может принести огромную пользу, но он также сопряжен с некоторыми знакомыми проблемами, которые возникают при внедрении любой новой технологии в вашу повседневную деятельность.

Организации должны уделять приоритетное внимание ответственному использованию, обеспечивая точность, безопасность, честность, расширение возможностей и устойчивость. Столкнувшись с определенными проблемами и рисками, они могут положиться на проверенные и проверенные лучшие практики, доказавшие свою эффективность при успешном внедрении других технологий. Эти стратегии могут послужить прочной основой для интеграции ИИ в ваши бизнес-операции и снижения рисков, связанных с ИИ.

Этот блог поможет вам понять все, что связано с рисками ИИ для вашего бизнеса и способами их снижения. Итак, без лишних слов, давайте углубимся в детали.

Понимание рисков ИИ

Согласно AI RMF 1.0, системе управления рисками искусственного интеллекта, выпущенной Национальным институтом стандартов и технологий (NIST), риски ИИ включают в себя потенциальный вред отдельным лицам, организациям или системам, возникающий в результате разработки и развертывания систем ИИ. Эти риски могут быть результатом различных факторов, включая данные, используемые для обучения ИИ, алгоритм ИИ, его использование для различных целей и взаимодействие с людьми. Примеры рисков и средств контроля ИИ варьируются от инструментов предвзятого найма до алгоритмов, вызывающих крах рынка.

Упреждающий мониторинг продуктов и услуг на основе искусственного интеллекта имеет решающее значение для обеспечения безопасности данных и отдельных лиц. Таким образом, организация верит в необходимость использования решения по управлению рисками, которое может помочь эффективно сортировать, проверять и снижать эти риски.

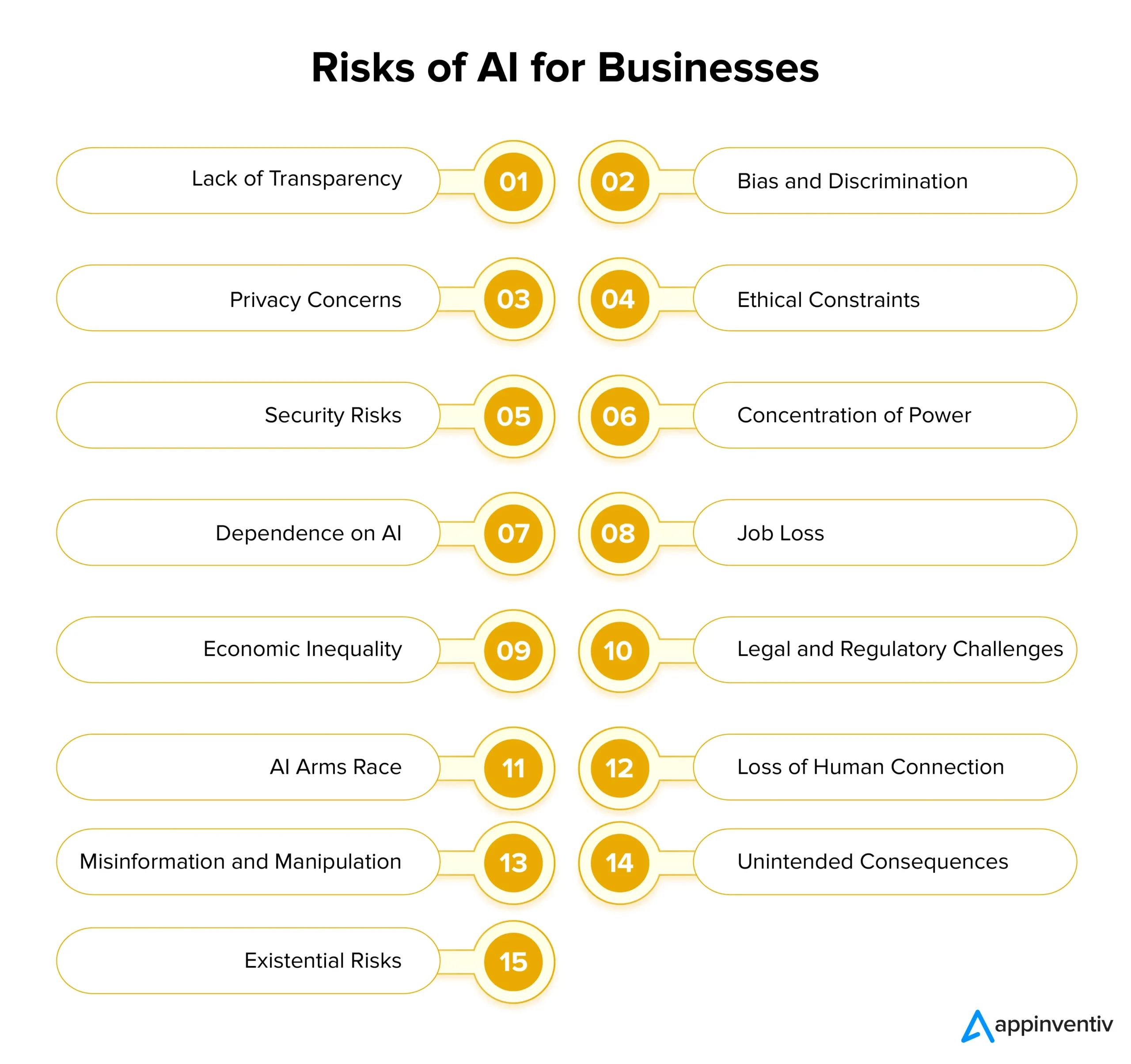

Определение рисков и проблем ИИ для бизнеса

ИИ предлагает огромный потенциал для бизнеса, но также несет значительные риски при его внедрении. Чтобы обеспечить ответственное внедрение ИИ, крайне важно понимать и решать эти проблемы в нужное время. Давайте подробно рассмотрим риски и решения ИИ для бизнеса ниже:

Отсутствие прозрачности

Системы искусственного интеллекта часто работают непрозрачно, что затрудняет понимание того, как они принимают некоторые решения. Отсутствие прозрачности может привести к недоверию среди пользователей и заинтересованных сторон. Чтобы решить эту проблему, предприятиям следует уделять приоритетное внимание прозрачности, разрабатывая модели и алгоритмы искусственного интеллекта, которые дают представление о процессах принятия решений.

Этому можно легко способствовать, используя четкую документацию, объяснимые методы искусственного интеллекта и инструменты для визуализации результатов, получаемых с помощью искусственного интеллекта. Важно понимать, что прозрачный ИИ повышает общее доверие между сторонами и их решениями, а также способствует соблюдению нормативных требований.

Предвзятость и дискриминация

Системы искусственного интеллекта могут легко поддерживать социальные предубеждения, обнаруженные в их обучающих данных. Это может привести к предвзятому принятию решений, дискриминации и несправедливому обращению с определенными группами. Чтобы устранить эти риски, связанные с ИИ, организациям следует уделить приоритетное внимание инвестированию в разнообразные и репрезентативные данные обучения, которые они смогут проанализировать.

Кроме того, внедрение алгоритмов обнаружения и коррекции предвзятости и проведение регулярных проверок моделей ИИ могут помочь выявить и устранить предвзятости в существующих системах. При разработке этического ИИ приоритетом должны стать справедливость и беспристрастность в качестве основных принципов.

Проблемы конфиденциальности

Одним из крупнейших рисков и проблем ИИ является угроза конфиденциальности. ИИ часто требует сбора и анализа огромных объемов персональных данных, что вызывает проблемы конфиденциальности и безопасности. Предприятия должны уделять приоритетное внимание защите данных, соблюдая строгие правила конфиденциальности, внедряя надежные меры кибербезопасности и применяя методы шифрования данных. Это может помочь защитить конфиденциальность пользователей и сохранить доверие.

Этические ограничения

Системы искусственного интеллекта, участвующие в принятии важных решений, часто сталкиваются с этическими дилеммами, которые могут в дальнейшем иметь разрушительные последствия для общества. Чтобы устранить этот риск, организациям следует установить этические руководящие принципы и принципы разработки и внедрения ИИ. Этические соображения должны быть одним из основных компонентов проектов ИИ, гарантируя, что ИИ соответствует общественным ценностям и этическим нормам.

Риски безопасности

По мере развития технологий искусственного интеллекта растут и риски безопасности. Вредоносные действия могут использовать системы искусственного интеллекта и создавать более опасные кибератаки, создавая значительную угрозу для бизнеса. Организациям следует внедрить надежные меры безопасности для снижения рисков безопасности, включая шифрование, протоколы аутентификации и системы обнаружения угроз на основе искусственного интеллекта. Постоянный мониторинг и регулярные проверки уязвимостей имеют решающее значение для защиты развертывания систем искусственного интеллекта.

Концентрация власти

Когда всего несколько крупных компаний и правительств контролируют разработку ИИ, это может сделать ситуацию несправедливой и сократить разнообразие вариантов использования ИИ. Чтобы предотвратить это, предприятиям следует работать над более широким распространением разработки ИИ среди нескольких групп. Они могут добиться этого, поддерживая небольшие стартапы, поощряя новые идеи и помогая проектам искусственного интеллекта с открытым исходным кодом. Таким образом, ИИ становится более доступным для всех.

Зависимость от ИИ

Чрезмерная зависимость от систем искусственного интеллекта может привести к потере творческих способностей, критического мышления и человеческой интуиции. Крайне важно найти баланс между принятием решений с помощью ИИ и человеческим суждением. Например, исследователи выдвинули на первый план проблему «коллапса модели», когда генеративные модели ИИ, обученные на синтетических данных, могут давать результаты более низкого качества, потому что они просто отдают предпочтение обычному выбору слов над творческими альтернативами.

Предприятия должны обучать своих сотрудников работе вместе с ИИ, чтобы избежать потенциальных рисков, связанных с ИИ. Поощрение непрерывного обучения может помочь организациям использовать потенциал ИИ, сохраняя при этом человеческие навыки. В дополнение к этому, использование разнообразных обучающих данных и методов регуляризации также может помочь смягчить проблемы, связанные с коллапсом модели.

Потеря работы

Автоматизация на основе искусственного интеллекта может привести к вытеснению рабочих мест в различных отраслях, при этом наибольшей мишенью станут низкоквалифицированные работники. Организации должны активно решать эту проблему, предоставляя своим сотрудникам возможности изучать новые меры и расти вместе с технологическими достижениями. Содействие обучению на протяжении всей жизни и повышению адаптивности имеет важное значение для смягчения опасений, связанных с потерей рабочих мест во многих секторах.

Экономическое неравенство

Экономическое неравенство — еще один из заметных рисков и проблем ИИ, о которых необходимо знать предприятиям. ИИ потенциально может усугубить экономическое неравенство, поскольку он часто приносит пользу богатым людям и крупным компаниям. Чтобы сделать ИИ более справедливым, политики и предприятия должны подумать о том, как вовлечь больше людей в разработку ИИ. Они могут сделать это, создав программы, которые позволят большему количеству людей использовать инструменты искусственного интеллекта.

Правовые и нормативные проблемы

ИИ создает новые юридические и нормативные сложности, включая вопросы ответственности и прав интеллектуальной собственности. Правовые рамки должны развиваться так, чтобы они могли развиваться параллельно с технологическими достижениями. Организации должны быть в курсе правил, связанных с ИИ, и активно взаимодействовать с политиками для формирования ответственного управления и практики ИИ. Компании могут использовать ИИ для решений по управлению рисками и обеспечению соответствия, чтобы легко анализировать огромные объемы информации и данных, одновременно выявляя потенциальные риски, связанные с соблюдением требований.

[Также читайте: Как избежать нарушений соответствия при разработке продуктов искусственного интеллекта]

Гонка вооружений ИИ

Когда страны вступают в гонку вооружений в области искусственного интеллекта, это может означать, что технология искусственного интеллекта развивается слишком быстро, и это может быть опасно. Чтобы предотвратить эти риски, связанные с ИИ, важно поощрять ответственную разработку ИИ. Страны должны работать вместе и заключать соглашения о том, как ИИ может использоваться в обороне. Таким образом, мы можем снизить риск нанесения вреда ИИ в гонке за более передовыми технологиями, чем в других странах.

Потеря человеческой связи

Растущая зависимость от коммуникации и взаимодействия, основанных на искусственном интеллекте, может привести к снижению эмпатии, социальных навыков и человеческих связей. Организациям следует отдавать приоритет дизайну, ориентированному на человека, подчеркивая важность поддержания значимого человеческого взаимодействия в дополнение к интеграции ИИ.

Дезинформация и манипулирование

Создаваемый искусственным интеллектом контент, такой как дипфейки, представляет значительный риск, поскольку способствует распространению ложной информации и манипулированию общественным мнением. Внедрение инструментов на основе искусственного интеллекта для обнаружения дезинформации и кампаний по повышению осведомленности общественности может помочь сохранить целостность информации в этот быстро развивающийся цифровой век.

Непреднамеренные последствия

Из-за своей сложности системы ИИ могут демонстрировать неожиданное поведение или принимать решения с непредвиденными последствиями. Тщательное тестирование, проверка и непрерывный мониторинг необходимы для выявления и решения этих проблем до того, как они обострятся и причинят вред.

Экзистенциальные риски

Создание общего искусственного интеллекта (AGI), который будет умнее человека, вызывает большие опасения. Организации должны убедиться, что AGI разделяет ее ценности и цели, чтобы избежать ужасных последствий. Это требует тщательного долгосрочного планирования, строгих этических правил и совместной работы по всему миру, чтобы справиться с большими рисками, связанными с ОИИ.

Рассмотрев многочисленные проблемы и риски, связанные с технологией ИИ, а также то, как можно осуществлять управление определенными рисками ИИ, давайте продолжим и подробно рассмотрим управление ИИ.

Управление ИИ для управления рисками

Эффективное управление ИИ предполагает выявление и управление рисками ИИ с помощью трех ключевых подходов:

Принципы: они включают в себя рекомендации, которые облегчают разработку систем искусственного интеллекта и их использование. Они часто соответствуют законодательным стандартам и социальным нормам.

Процессы: устранение рисков и потенциального вреда, возникающих из-за недостатков проектирования и неадекватных структур управления.

Этическое сознание. Этот подход основан на понимании того, что правильно и хорошо. Это включает в себя соблюдение правил, проверку правильности выполнения действий, заботу о своей репутации, социальную ответственность и соответствие ценностям и убеждениям организации.

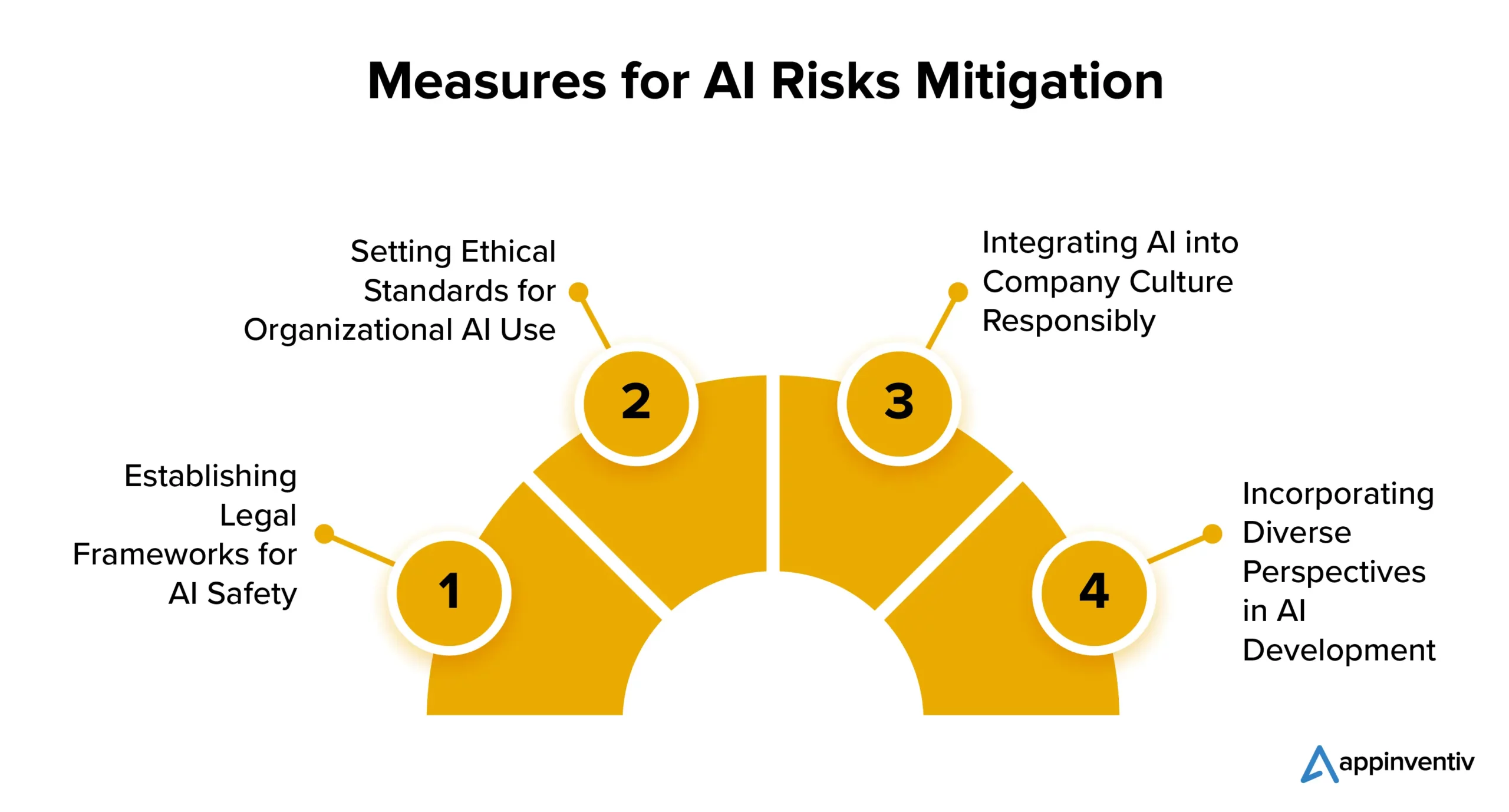

Снижение рисков ИИ: как оставаться в безопасности с помощью искусственного интеллекта

Вот несколько стратегий, которые предприятия могут использовать, чтобы снизить риски внедрения ИИ:

Создание правовой базы для безопасности ИИ

Многие страны уделяют особое внимание регулированию ИИ. США и Европейский Союз работают над четким набором правил по контролю за распространением и использованием ИИ. Хотя некоторые технологии искусственного интеллекта могут столкнуться с ограничениями, это не должно мешать компаниям изучать потенциал искусственного интеллекта в своих интересах.

Установление этических стандартов для использования искусственного интеллекта в организациях

Крайне важно сбалансировать регулирование с инновациями. ИИ жизненно важен для прогресса, поэтому организациям следует установить стандарты этической разработки и использования ИИ. Это должно включать внедрение алгоритмов мониторинга, использование высококачественных данных и прозрачность решений ИИ.

Ответственная интеграция искусственного интеллекта в корпоративную культуру

Одна из востребованных стратегий снижения рисков, связанных с ИИ, включает внедрение ИИ в саму культуру компании. Компании могут интегрировать ИИ в свою культуру, установив приемлемые рекомендации по технологиям и процессам ИИ. Это гарантирует, что ИИ используется в организации этично и ответственно, тем самым снижая возможные риски, связанные с ИИ.

Учет различных точек зрения в разработке ИИ

Разработчики ИИ должны учитывать различные точки зрения, в том числе из разных областей и областей, таких как право, философия и социология. Такой инклюзивный подход помогает создать ответственный ИИ, который принесет пользу всем.

Как Appinventiv может помочь обеспечить лучшие практики разработки искусственного интеллекта

Несмотря на то, что внедрение ИИ продолжает расти, эффективное управление рисками по-прежнему отстает. Проблема заключается в том, что компании часто не осознают необходимости вмешательства, а также практики устойчивого развития искусственного интеллекта.

Согласно отчету MIT Sloan Management Review и Boston Consulting Group, 42% респондентов считают ИИ главным стратегическим приоритетом, и только 19% подтвердили, что их организации внедрили ответственную программу ИИ. Этот разрыв повышает риск неудачи и делает компании уязвимыми для нормативных, финансовых и репутационных проблем, вызванных внедрением ИИ.

Хотя управление рисками ИИ может начаться на любом этапе проекта, крайне важно как можно раньше создать систему управления рисками. Это может повысить доверие и позволить предприятиям уверенно масштабироваться.

Как специализированная компания по разработке искусственного интеллекта, наша команда имеет многолетний опыт создания решений искусственного интеллекта, подкрепленный сильным упором на этику и ответственность. Наш проверенный опыт работы в различных отраслях промышленности отражает наше стремление привести решения искусственного интеллекта в соответствие с основными ценностями и этическими принципами.

Мы хорошо подготовлены, чтобы помочь вам во внедрении мер справедливости, чтобы гарантировать, что ваши бизнес-решения на основе искусственного интеллекта постоянно принимают беспристрастные и непредвзятые решения.

Недавно мы разработали YouComm, медицинское приложение на базе искусственного интеллекта, которое позволяет пациентам связываться с персоналом больницы с помощью жестов и голосовых команд. В настоящее время решение внедрено в более чем 5 сетях больниц по всей территории США.

Свяжитесь с нашими экспертами, чтобы получить полное представление об управлении рисками, связанными с искусственным интеллектом, для вашего проекта и о том, как вы можете легко их снизить.

Часто задаваемые вопросы

Вопрос. Каковы риски ИИ?

А. ИИ несет в себе присущие риски, включая предвзятость, проблемы конфиденциальности, этические дилеммы и угрозы безопасности. Это также может привести к сокращению рабочих мест, усугублению экономического неравенства и созданию правовых и нормативных проблем. Кроме того, развитие сверхразумного ИИ вызывает экзистенциальные опасения по поводу соответствия человеческим ценностям. Чтобы обеспечить ответственное и выгодное использование технологии и избежать связанных с ней рисков, связанных с ИИ, крайне важно обеспечить тщательное управление, этические соображения и нормативные меры.

Вопрос. Как можно использовать ИИ для снижения рисков, связанных с ИИ?

А. ИИ играет важную роль в снижении рисков ИИ, способствуя обнаружению и исправлению предвзятости, прогнозному анализу, мониторингу безопасности, поддержке этических решений и т. д. Давайте посмотрим, как мы можем помочь в снижении рисков ИИ в деталях:

- Алгоритмы ИИ могут выявлять и исправлять искажения в данных, уменьшая искажения результатов ИИ.

- Прогнозная аналитика может предвидеть риски и принимать превентивные меры.

- Инструменты кибербезопасности на основе ИИ могут обнаруживать и противодействовать угрозам на основе ИИ.

- ИИ может помочь сделать этический выбор.

- Автоматизация может обеспечить соблюдение нормативных требований, снижая риски, связанные с соблюдением требований.