«Почему» стоит за резким падением трафика в поисковой выдаче в SaaS и за его пределами

Опубликовано: 2024-05-31Содержание статьи

Падение посещаемости веб-сайта может быть вызвано множеством причин, включая тенденции ключевых слов, усилия по ребрендингу и штрафы.

Однако некоторый спад вызван неуловимыми изменениями в алгоритмах поиска, которые заставляют компании искать ответы, особенно в сфере SaaS. Эти обновления алгоритмов могут оказать глубокое влияние, пошатнув стабильность стратегий органического маркетинга. Недавние обсуждения, такие как этот твит, в котором подчеркивается заметное падение трафика ClickUp за последние несколько месяцев, подчеркивают эти опасения.

По данным Ahrefs, @clickup потерял около 50% органического трафика за два месяца.

Они выросли с 1,9 млн в начале февраля до 900 тыс. на данный момент.

pic.twitter.com/xUDOKkNio

– Нико Сердейра (Failory.com) (@nicocerdeira), 2 мая 2024 г.

SaaS-компаниям и другим компаниям необходимо сохранять бдительность и адаптироваться, чтобы ориентироваться в этих непредсказуемых изменениях в алгоритмах поисковых систем и поддерживать свою видимость в Интернете. Понимание сложностей, лежащих в основе этих спадов трафика, имеет решающее значение для поддержания роста и избежания ловушек спада, вызванного алгоритмами.

Неопределенность (и противоречия) в SEOland

В наши дни в SEOland много неопределенности и немало споров. В немалой степени это связано с тем фактом, что наблюдается заметное снижение общего веб-трафика в разных отраслях.

Согласно сравнительному отчету Contentsquare по цифровому опыту за 2024 год , общее изменение трафика по сравнению с прошлым годом составило -3,6%. Падение было еще более выраженным в таких отраслях, как услуги (-9,4%), энергетика, коммунальные услуги и строительство (-8,3%) и программное обеспечение (-7,8%).

![Изменение трафика в годовом сопоставлении по отраслям [Contentsquare]](/uploads/article/23621/NXsGWAwvlNFBBqzK.png)

От социальных платформ и форумов до отраслевых мероприятий маркетологи особенно обеспокоены золотым гусем роста веб-трафика: органическим поиском.

Аналитики рынка и исследовательские фирмы оценивают глобальную SEO-индустрию в 70–80 миллиардов долларов . В этой сфере работают крупные компании-разработчики программного обеспечения, агентства и бесчисленное множество специалистов, не говоря уже обо всех предприятиях, которые полагаются на эту практику.

Понятно, что люди так обеспокоены развитием этой отрасли.

Разбираемся в причинах крупных потерь трафика в сфере технологий и за их пределами

Одна из главных проблем для индустрии SEO (и для любой компании, которой нужен цифровой след) заключается в том, что поисковые системы, такие как Google, являются черным ящиком.

Мы можем анализировать входные данные (запросы, веб-сайты и веб-страницы) и отслеживать результаты (позицию в поисковой выдаче), но никто со стороны не может полностью знать все, что влияет на решения о ранжировании. И, согласно тысячам просочившихся документов Google Search API , технический гигант не честен с факторами ранжирования.

Google действительно пытается прояснить ситуацию с помощью отзывов от Search Central или заявлений их представителей по поиску и таких представителей, как Джон Мюллер. Но есть еще так много того, чего мы не знаем. К счастью, благодаря сотням тысяч SEO-специалистов, можно получить некоторую информацию с помощью краудсорсинга.

Есть несколько основных причин, по которым крупные сайты в сфере технологий, СМИ и других отраслей испытывают такие серьезные сбои с точки зрения органического и общего веб-трафика, и все они связаны либо с действиями Google, либо с появлением искусственного интеллекта:

- Полезный контент, злоупотребление репутацией и обновления ядра Google

- Растущее присутствие пользовательских дискуссий и контента на форумах.

- Рост контента, созданного искусственным интеллектом

- Опыт генерации поиска

Давайте теперь посмотрим на каждый из них.

Обновления ядра Google

По данным Seach Central , Google в течение года вносит несколько «значительных и широких изменений в [свои] поисковые алгоритмы и системы». Веб-сайты с высоким рейтингом нередко испытывают нестабильность результатов поиска после обновления ядра — даже если «они не нарушали политику [Google] в отношении спама и не подвергались ручным или алгоритмическим действиям».

Опытные оптимизаторы уже более десяти лет знают, что после обновления ядра или других значительных изменений наступает период исправлений, и не следует слишком остро реагировать. Сопутствующий ущерб обычно со временем восстанавливается (по крайней мере, теоретически).

Но обновления за последние несколько лет — это совсем другая история.

Полезное обновление контента

Первое обновление полезного контента (HCU) было запущено в августе 2022 года как попытка автоматически идентифицировать и нацеливать контент, созданный в первую очередь для высоких позиций в поисковых системах, а не для помощи пользователям. В конце 2022 года это обновление было распространено за пределы англоязычных веб-сайтов на все языки.

В сентябре 2023 года Google снова обновил HCU в течение двух недель, что помогло создать «улучшенный классификатор» с небольшим количеством деталей. Это обновление привело к значительному снижению рейтинга веб-сайтов в разных отраслях, многие из которых еще не восстановились.

Краткая информация о сайтах, на которые повлиял сентябрьский HCU(X). Теперь, когда прошло две недели после мартовского основного обновления, я просчитал показатели видимости для нескольких сотен сайтов, на которые повлиял сентябрьский HCU(X). Я еще не видел ни одного выздоровевшего. На самом деле, большинство из них упали еще больше (см.… pic.twitter.com/MPFPGZdu9u

– Гленн Гейб (@glenngabe) 21 марта 2024 г.

В марте этого года Google включил HCU в основные системы ранжирования с целью сократить бесполезный и некачественный контент на 40%. Сообщается, что Google соответствует этому стандарту, но ясно, что многие невинные свидетели также вовлечены в эту ситуацию.

Спам-обновление

Чтобы еще больше усложнить анализ проблемы, интеграция HCU в марте 2024 года совпала с другим соответствующим изменением в алгоритме Google: обновлением спама. Google выпустил это обновление для борьбы со «спамом и некачественным контентом», используя три манипулятивные тактики :

- Масштабированное злоупотребление контентом — использование автоматизации (также известной как ИИ или контент-фабрики) для массового производства контента, ориентированного на популярные поисковые запросы.

- Злоупотребление просроченными доменами — покупка доменов с истекшим сроком действия и их повторное использование для повышения видимости некачественного контента.

- Злоупотребление репутацией сайта — использование высокого авторитета сайта и репутации бренда для размещения некачественного контента от третьих лиц в целях ранжирования.

За последний месяц сообщение о злоупотреблении репутацией сайта привлекло большое внимание, особенно потому, что оно затронуло ряд уважаемых веб-сайтов, таких как Reuters, The Washington Post, GQ и Wall Street Journal.

Глен Олсопп обрисовал степень первоначального воздействия обновления в этом твите:

С марта я отслеживаю 2500 условий, связанных с купонами, чтобы увидеть, что Google меняет в своем обновлении о злоупотреблениях репутацией сайта.

Сегодня начались ручные действия, и вот некоторые первые выводы.

Я отслеживал много стороннего контента, не связанного с купонами, который собирался… pic.twitter.com/dCbPgOTD9Q

– Глен Олсопп (@ViperChill) 7 мая 2024 г.

Поскольку за последние несколько лет волатильность после обновлений достигла новых высот, крайне важно, чтобы бренды бдительно следили за эффективностью веб-страниц и поисковой выдачи.

Обсуждения и контент форума

Создание присутствия на форумных платформах, таких как Reddit и Quora, является ключевой частью маркетинговой деятельности, такой как исследования, распространение контента и взаимодействие с сообществом. Что ж, теперь вы можете добавить видимость результатов поиска в этот список.

За последние несколько лет Reddit и Quora начали доминировать на верхних позициях поисковой выдачи по нескольким различным запросам. В то время как органический трафик для деловых и медиа-сайтов в прошлом году упал, Reddit и Quora продемонстрировали экспоненциальный рост трафика.

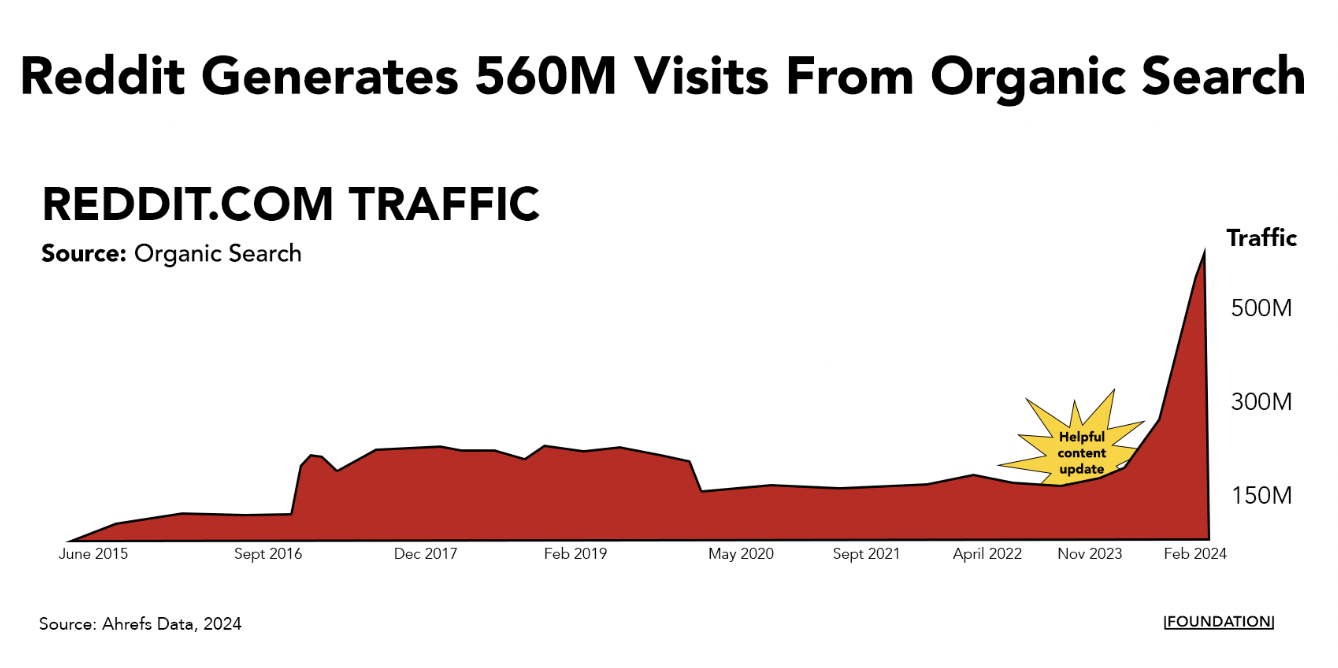

Один только Reddit генерирует более 560 миллионов посещений из органического поиска каждый месяц и теперь входит в тройку лучших по почти 11 миллионам ключевых слов.

Такой крутой уклон предполагает, что у таких популярных форумов есть алгоритмическое преимущество. Ответственный за поиск в Google Майк Салливан признал это в разговоре с Лили Рэй на X:

Этот модуль появляется автоматически, если системы считают, что он может быть актуальным и полезным. Я не говорю, что кто-то сказал «поставьте это первым для этого конкретного запроса» — я знаю, что вы это понимаете, но другие, читающие это, возможно, нет. Тем не менее, я понимаю беспокойство и проблему, и я…

– Google SearchLiaison (@searchliaison) 3 апреля 2024 г.

Это, безусловно, правда, что люди тяготеют к обсуждениям на форумах на этих платформах, особенно когда они ищут нефильтрованные мнения о продуктах и услугах. (Я постоянно использую Reddit и Quora таким образом.)

Тем не менее, существует множество примеров случаев, когда рассматриваемая тема заслуживает более опытного ответа, чем вы получаете в (в основном) анонимных обсуждениях на Reddit. Например, запросы «Ваши деньги или ваша жизнь» (YMYL) касаются важных тем, связанных со здоровьем и финансами.

Также возможно, что небольшие изменения в алгоритме, определяющем приоритетность этого типа контента, принесут пользу Reddit и Quora, поскольку у них такие огромные веб-сайты и уровни авторитетности домена.

Какой бы ни была причина, не похоже, что Google в ближайшее время откажется от форумов — они только что объявили о крупной сделке с Reddit, согласно которой они будут использовать данные платформы для обучения своего ИИ. Это еще одна из многих причин , по которым вам необходимо закрепиться на платформе.

Контент, созданный искусственным интеллектом

Контент, созданный искусственным интеллектом, покорил мир вскоре после того, как ChatGPT несколько лет назад положил начало буму генеративного искусственного интеллекта. Даже некоторые крупные SaaS-бренды, такие как CNET, использовали эту стратегию.

В то время были самые разные гуру маркетинга и бизнеса, стремившиеся использовать это в качестве тактики хакерского роста путем массового производства SEO-контента. В LinkedIn и X было немало громких примеров, когда люди хвастались результатами, которых они достигли, выпуская огромное количество контента, созданного ИИ.

Одним из ярких примеров этого является SEO-ограбление, когда кто-то взял карту сайта с веб-сайта под названием Exceljet, превратил список URL-адресов в заголовки статей, а затем использовал искусственный интеллект для создания более 1800 страниц по тем же темам. Эта стратегия сработала на удивление хорошо: сайт ограбления приносил сотни тысяч посещений в месяц за счет Exceljet.

Однако эксперты, отслеживающие эту стратегию, обнаружили, что первоначальные выгоды, которые компании получают от контента ИИ, часто исчезают.

Марк Уильямс-Кук , например, отследил взлет и падение ряда веб-сайтов, которые использовали стратегии SEO Heist или AI-масштабирования. На большинстве этих сайтов наблюдается значительный рост органического трафика в краткосрочной перспективе — обычно в течение нескольких месяцев, но в некоторых случаях он может быть дольше — прежде чем произойдет резкий спад, который сигнализирует о том, что алгоритм прижился.

Хорошее обновление @sistrix веб-сайта «SEO-ограбление», на котором для создания контента использовался искусственный интеллект. Похоже, все закончится еще хуже, чем когда началось. pic.twitter.com/SKY2ViXiwV

– Марк Уильямс-Кук (@markcandour), 4 декабря 2023 г.

Итак, если вы испытываете значительное снижение поискового трафика, учтите следующее:

- Использует ли ваша компания ИИ для создания большого количества (вероятно, некачественного) SEO-контента в больших масштабах?

- Появляются ли новые веб-сайты именно в тех результатах поиска, на которые вы пытаетесь ориентироваться?

Если первое, и вы уже инвестируете в создание качественного контента, то, скорее всего, со временем проблема решится сама собой. Если последнее, то пришло время повысить уровень вашего рабочего процесса с AI-контентом .

Вы можете масштабировать производство контента с помощью ИИ, но речь должна идти обувеличении, а не замене вашей команды. Писатели могут использовать такие инструменты, как ChatGPT, Jasper или Gemini, чтобы упростить выработку идей, исследования и промежуточные шаги, оставляя больше времени для творческого рассказывания историй.

Чтобы избежать потенциальных штрафов и поддерживать долгосрочный рост трафика, убедитесь, что ваш контент с использованием искусственного интеллекта приносит реальную ценность, предлагает уникальную информацию и поддерживает высокие стандарты качества.

Ознакомьтесь с нашим контрольным списком повышения уровня контента с помощью искусственного интеллекта, чтобы получить пошаговое руководство по созданию ценного контента в большом масштабе.

Поисковый генеративный опыт

Спам-контент и SEO-кражи — не единственное влияние, которое ИИ оказывает на результаты поиска. Генеративная оптимизация может повлиять на объем трафика, поскольку люди начнут использовать ИИ вместо традиционных поисковых систем.

Google уже подготовился к этому. Компания анонсировала новую функцию сводных данных, генерируемую искусственным интеллектом, «Обзоры ИИ», основанную на собственном LLM. В настоящее время он внедряется в США и получил очень неоднозначные отзывы .

Ранний отчет Томаша Рудзки и Ziptie.dev показывает, что обзоры искусственного интеллекта Google появляются в среднем более чем в 80% запросов.

В частности, в исследовании подчеркивается, что некоторые ниши, такие как FinTech, могут быть более безопасными от AIO, чем другие. Но по большей части ответы SGE доминируют. Эти ответы, сгенерированные искусственным интеллектом, автоматически появляются примерно в трети поисковой выдачи, а в остальное время пользователям необходимо щелкнуть мышью, чтобы сгенерировать их.

Итак, что все это означает для брендов? Пришло время уделить приоритетное внимание генеративному опыту поиска (SGE) — поисковым маршрутам, которые благодаря ИИ более захватывающие и персонализированные, чем традиционные путешествия.

Хотя они сильно отличаются от традиционных результатов поиска Google, такие инструменты, как ChatGPT, Gemini и Perplexity, включают URL-адреса сайтов, которые они используют для получения результатов.

Пока еще слишком рано говорить,насколькоSGE/GEO будет отличаться от традиционного SEO, но некоторые сходства определенно есть. Чтобы оптимизировать SGE, компаниям следует сосредоточиться на предоставлении четкой, краткой и точной информации, которая может быть легко проанализирована системами искусственного интеллекта. Сюда входят структурированные данные, хорошо отформатированные ответы на распространенные вопросы и контент, который напрямую соответствует намерениям пользователя.

Будьте уверены, мы в Foundation и остальная часть отрасли будем внимательно следить за этим в будущем.

Расширьте свой охват за пределы поиска с помощью механизма распространения

Ландшафт органического поиска претерпевает значительные изменения из-за обновлений алгоритмов и развития искусственного интеллекта — и беспокойство вполне понятно. Но что важнее, так это действие.

С одной стороны, компаниям необходимо адаптироваться, сосредоточив внимание на высококачественном, ориентированном на пользователя контенте и используя новые возможности, предоставляемые технологиями искусственного интеллекта. Несмотря на то, что влияние новых AI Overivews только начинает ощущаться, важно расширить свой охват за пределы традиционных методов поиска.

Инвестируйте в полную схему распространения, чтобы гарантировать, что вы сможете поддерживать и расширять свое присутствие в Интернете в этой развивающейся среде.