Эффективные методы веб-сканирования для приложений с большими данными

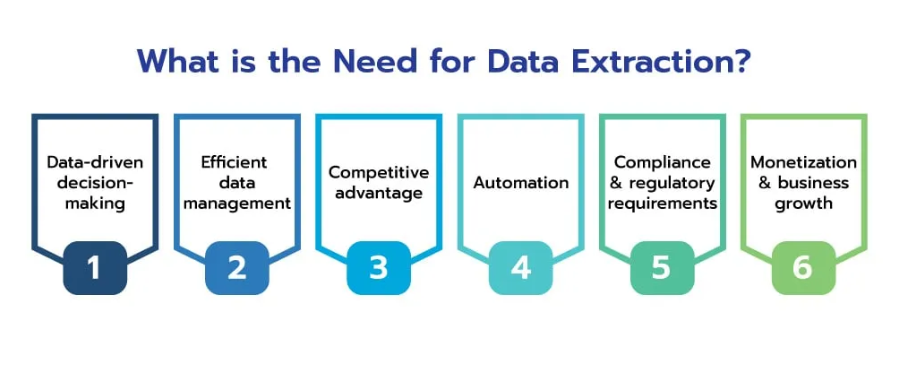

Опубликовано: 2024-06-06В эпоху больших данных сканирование веб-сайтов стало незаменимым процессом для предприятий, стремящихся использовать огромное количество информации, доступной в Интернете. Эффективно собирая, обрабатывая и анализируя веб-данные в больших масштабах, компании могут получить ценную информацию и получить конкурентное преимущество в различных отраслях.

Веб-данные обладают огромным потенциалом, предлагая глубокое понимание рыночных тенденций, поведения потребителей и конкурентной среды. Способность эффективно собирать и анализировать эти данные может превратить необработанную информацию в полезную информацию, способствующую принятию стратегических решений и росту бизнеса.

Источник: Scrapehero

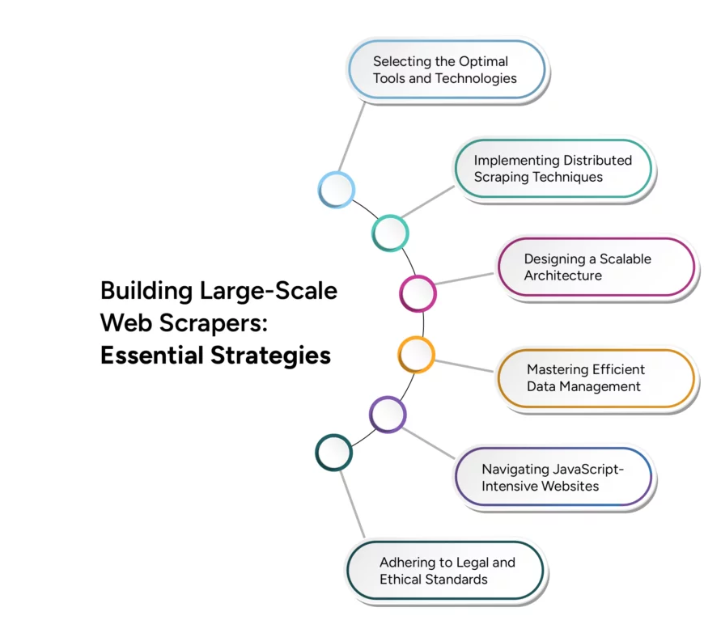

Однако переход от мелкомасштабного парсинга веб-страниц к крупномасштабному сканированию веб-страниц представляет собой серьезные технические проблемы. Эффективное масштабирование требует тщательного рассмотрения различных факторов, включая инфраструктуру, управление данными и эффективность обработки. В этой статье рассматриваются передовые методы и стратегии, необходимые для преодоления этих проблем, гарантирующие, что ваши операции веб-сканирования могут расти в соответствии с требованиями приложений для обработки больших данных.

Проблемы сканирования веб-сайтов для приложений с большими данными

Сканирование веб-сайтов для приложений с большими данными представляет собой несколько серьезных проблем, которые предприятия должны решить, чтобы эффективно использовать возможности огромных объемов онлайн-информации. Понимание и преодоление этих проблем имеет решающее значение для создания надежной и масштабируемой инфраструктуры сканирования веб-страниц.

Одной из основных проблем является огромный объем и разнообразие данных в сети, которое продолжает расти в геометрической прогрессии. Кроме того, разнообразие типов данных — от текста и изображений до видео и динамического контента — усложняет процесс сканирования веб-сайтов. Современные веб-сайты часто используют динамический контент, созданный с помощью JavaScript и AJAX, что затрудняет

традиционные сканеры для сбора всей необходимой информации. Более того, веб-сайты могут налагать ограничения на скорость или блокировать IP-адреса, чтобы предотвратить чрезмерное сканирование, что может помешать сбору данных.

Обеспечение точности и согласованности данных, собранных из различных источников, может быть затруднено, особенно при работе с большими наборами данных. Масштабирование операций веб-сканирования для обработки растущих объемов данных без ущерба для производительности является серьезной технической проблемой. Кроме того, соблюдение юридических и этических принципов сканирования веб-сайтов имеет решающее значение для предотвращения потенциальных юридических проблем и поддержания хорошей репутации. Эффективное управление вычислительными ресурсами для обеспечения баланса между скоростью сканирования и экономической эффективностью также имеет решающее значение.

Методы эффективного извлечения данных

Внедрение передовых методов извлечения данных гарантирует, что собранные данные актуальны, точны и готовы к анализу. Вот некоторые ключевые методы повышения эффективности извлечения данных:

- Параллельная обработка . Используйте параллельную обработку для распределения задач извлечения данных по нескольким потокам или машинам, увеличивая скорость извлечения данных за счет одновременной обработки нескольких запросов и сокращая общее время, необходимое для сбора данных.

- Инкрементное сканирование . Внедрите добавочное сканирование для обновления только тех частей набора данных, которые изменились с момента последнего сканирования, что снижает объем обрабатываемых данных и нагрузку на веб-серверы, делая процесс сканирования более эффективным и менее ресурсоемким.

- Безголовые браузеры : используйте безголовые браузеры, такие как Puppeteer или Selenium, для рендеринга и взаимодействия с динамическим веб-контентом, обеспечивая точное извлечение данных с веб-сайтов, которые в значительной степени полагаются на JavaScript и AJAX, обеспечивая комплексный сбор данных.

- Приоритизация контента : расставьте приоритеты контента на основе релевантности и важности, уделяя внимание в первую очередь ценным данным, гарантируя быстрый сбор наиболее важных данных и оптимизируя использование ресурсов и актуальность данных.

- Политики планирования URL-адресов и вежливости . Внедрите интеллектуальные политики планирования URL-адресов и вежливости для управления частотой запросов к одному серверу, предотвращения перегрузки веб-серверов и снижения риска блокировки IP-адресов, обеспечивая постоянный доступ к источникам данных.

- Дедупликация данных . Используйте методы дедупликации данных для устранения повторяющихся записей в процессе извлечения, повышения качества данных и снижения требований к хранению за счет обеспечения хранения и обработки только уникальных данных.

Решения для веб-сканирования в реальном времени

Источник: Средний

В современном быстро меняющемся цифровом мире возможность извлекать и обрабатывать данные в режиме реального времени становится все более важной.

имеет решающее значение для предприятий, стремящихся сохранить конкурентное преимущество. Решения для сканирования веб-страниц в реальном времени обеспечивают непрерывный и мгновенный сбор данных, что позволяет немедленно анализировать и принимать меры. Внедрение архитектуры, управляемой событиями, может значительно расширить возможности работы в режиме реального времени, когда сканеры запускаются при определенных событиях или изменениях в сети, гарантируя сбор данных, как только они становятся доступными.

Масштабируемость при многоязычном веб-сканировании

Глобальный характер Интернета требует возможности сканирования и обработки данных на нескольких языках, что создает уникальные проблемы, требующие специализированных решений. Операции сканирования веб-сайтов для обработки многоязычного контента включают реализацию алгоритмов определения языка для автоматического определения языка веб-страниц и обеспечения применения соответствующих методов обработки, зависящих от языка. Использование библиотек синтаксического анализа и платформ, поддерживающих несколько языков, таких как BeautifulSoup, предоставляет надежные инструменты для извлечения контента с различных веб-страниц. Интеграция масштабируемых сервисов перевода, таких как Google Cloud Translation, в конвейер обработки данных позволяет переводить контент в режиме реального времени, обеспечивая бесперебойный анализ на разных языках.

Заключение

Источник: группаbwt

По мере того, как мы продвигаемся дальше в эпоху цифровых технологий, важность сканирования веб-сайтов для приложений с большими данными продолжает расти. Будущее веб-сканирования заключается в его способности эффективно масштабироваться, адаптироваться к динамичной веб-среде и предоставлять аналитическую информацию в режиме реального времени. Достижения в области искусственного интеллекта и машинного обучения будут играть ключевую роль в расширении возможностей веб-сканеров, делая их умнее и эффективнее при обработке огромных объемов данных.

Интеграция распределенных систем и облачных инфраструктур еще больше улучшит масштабируемость, позволяя предприятиям с легкостью обрабатывать все более крупные наборы данных. Поскольку технологии веб-сканирования продолжают развиваться, они не только улучшат процессы сбора данных, но и обеспечат сохранение конкурентоспособности предприятий в постоянно меняющемся цифровом мире.

Использование этих достижений — не просто вариант, а необходимость для организаций, стремящихся эффективно использовать большие данные. Будущее веб-сканирования обещает стать преобразующей силой, стимулирующей инновации и предоставляющей инструменты, необходимые для раскрытия всего потенциала огромной экосистемы веб-данных.

Поднимите свои приложения для обработки больших данных на новый уровень с помощью настраиваемых сервисов очистки веб-страниц PromptCloud с бесшовной интеграцией и масштабируемостью. Свяжитесь с нами сегодня, чтобы использовать возможности расширенного веб-сканирования для вашего бизнеса.