Как объяснимый ИИ может открыть путь к ответственному и этичному развитию искусственного интеллекта

Опубликовано: 2023-09-01Благодаря преобразующим моментам, сочетающим в себе инновации и изобретательность, таким как запуск OpenAI ChatGPT в ноябре 2022 года, представление об искусственном интеллекте, контролирующем нашу жизнь, больше не является научной фантастикой.

Переломный момент запуска ChatGPT положил начало тому, что в отрасли называют «кембрийским взрывом искусственного интеллекта».

Однако речь идет не только об использовании ИИ для получения прибыли в бизнесе, что в настоящее время является центром этого взрыва. В основе этой эволюции лежит призыв сосредоточиться на объяснимости ИИ. Это гарантирует, что достижения в области ИИ будут одновременно мощными и прозрачными, что имеет основополагающее значение для этической разработки ИИ.

Искусственный интеллект уже принимает за нас решения во многих областях. Но непонимание того, как ИИ принимает эти решения, остается узким местом. Это одно из объяснимых преимуществ ИИ, которое предприниматели и технические эксперты не могут себе позволить игнорировать.

По мере развития технологий перед техническими экспертами стоит двоякая задача: расширить границы того, чего может достичь ИИ, обеспечивая при этом прозрачность, подотчетность и этическую обоснованность его работы. Это подчеркивает роль объяснимого ИИ в современных технологиях.

Экономический потенциал ИИ

Потенциал генеративного ИИ совершить революцию в производительности не просто теоретический; оно будет иметь ощутимые экономические последствия в глобальном масштабе. Согласно отчету McKinsey за июнь 2023 года под названием «Экономический потенциал генеративного ИИ: следующий рубеж производительности», генеративный ИИ может принести добавленную стоимость от 2,6 до 4,4 триллионов долларов в год в 63 проанализированных вариантах использования. Существуют также объяснимые варианты использования ИИ, которые могут принести пользу отраслям множеством новых способов.

Читайте также: Как генеративный искусственный интеллект для бизнеса формирует отрасли

Газета Washington Post сообщила, что более 11 000 компаний использовали инструменты OpenAI, предоставленные облачным подразделением Microsoft, подчеркнув тенденции внедрения, сопровождающие этот потенциал. Эти цифры отражают возможности и ответственность технологических лидеров, ориентирующихся в этом меняющемся мире.

По мере того, как преобразующий потенциал ИИ становится очевидным, все больше внимания уделяется объяснимым принципам ИИ, гарантируя, что эти мощные инструменты работают с ясностью, контролем и этическими соображениями. Объяснимые приложения ИИ должны стать краеугольным камнем в технологической отрасли.

Тем не менее, понимание объяснимых преимуществ ИИ и других связанных с ним аспектов — это только начало. Поэтому, прежде чем подробно обсуждать нюансы разработки объяснимого ИИ, мы должны сначала понять, почему это важно.

Тайна моделей искусственного интеллекта: навигация по «черному ящику»

Как и все значительные достижения, ИИ приносит проблемы, некоторые из которых глубоко связаны с его структурой. Одной из таких граней этой тайны является «черный ящик». Представление закрытой операционной модели, которая работает, но даже разработчики иногда не могут объяснить, как она работает. В индустрии искусственного интеллекта это известно как загадка черного ящика.

Такое отсутствие прозрачности неприемлемо для многих, особенно для тех, кто отвечает за важные деловые или общественные решения. Искусственный интеллект, который функционирует без объяснимости, рискует подорвать доверие, особенно когда возможны физические и материальные потери.

Непредвиденные последствия: когда ИИ сходит с рельсов

Последствия необъяснимых решений ИИ могут варьироваться от незначительной неэффективности до значительных социальных последствий. Рассмотрим финансовый сектор: система ИИ может отказать в выдаче кредита физическому лицу без предоставления четкого обоснования.

Такое решение, лишенное прозрачности, может привести к юридическим осложнениям и репутационному ущербу. В более широком масштабе, в здравоохранении, непостижимый ИИ может отдавать приоритет лечению одному пациенту над другим, что может привести к изменению его жизни или даже к ее окончанию.

Реальные примеры неожиданных результатов и неудач ИИ

Несколько инцидентов подчеркивают непредвиденные последствия применения ИИ. Трагический инцидент 2018 года с беспилотным автомобилем Uber подчеркивает ужасные последствия того, что ИИ неправильно интерпретирует окружающую среду. Известный алгоритм здравоохранения, в котором обнаружено расовое предубеждение, является суровым напоминанием о том, что ИИ, каким бы продвинутым он ни был, может непреднамеренно увековечивать человеческие предубеждения, если его не понимать и не контролировать должным образом.

Список можно продолжить, начиная с Тэя из Microsoft, который написал в Твиттере такие вещи, как «Гитлер был прав», до американского гражданина, получающего щедрые счета по кредитной карте. Без ограждений и возможности интерпретировать решения, принимаемые ИИ, подобные случаи будут продолжаться, отсюда и необходимость объяснения.

Бизнес-кейс: объяснимые преимущества ИИ

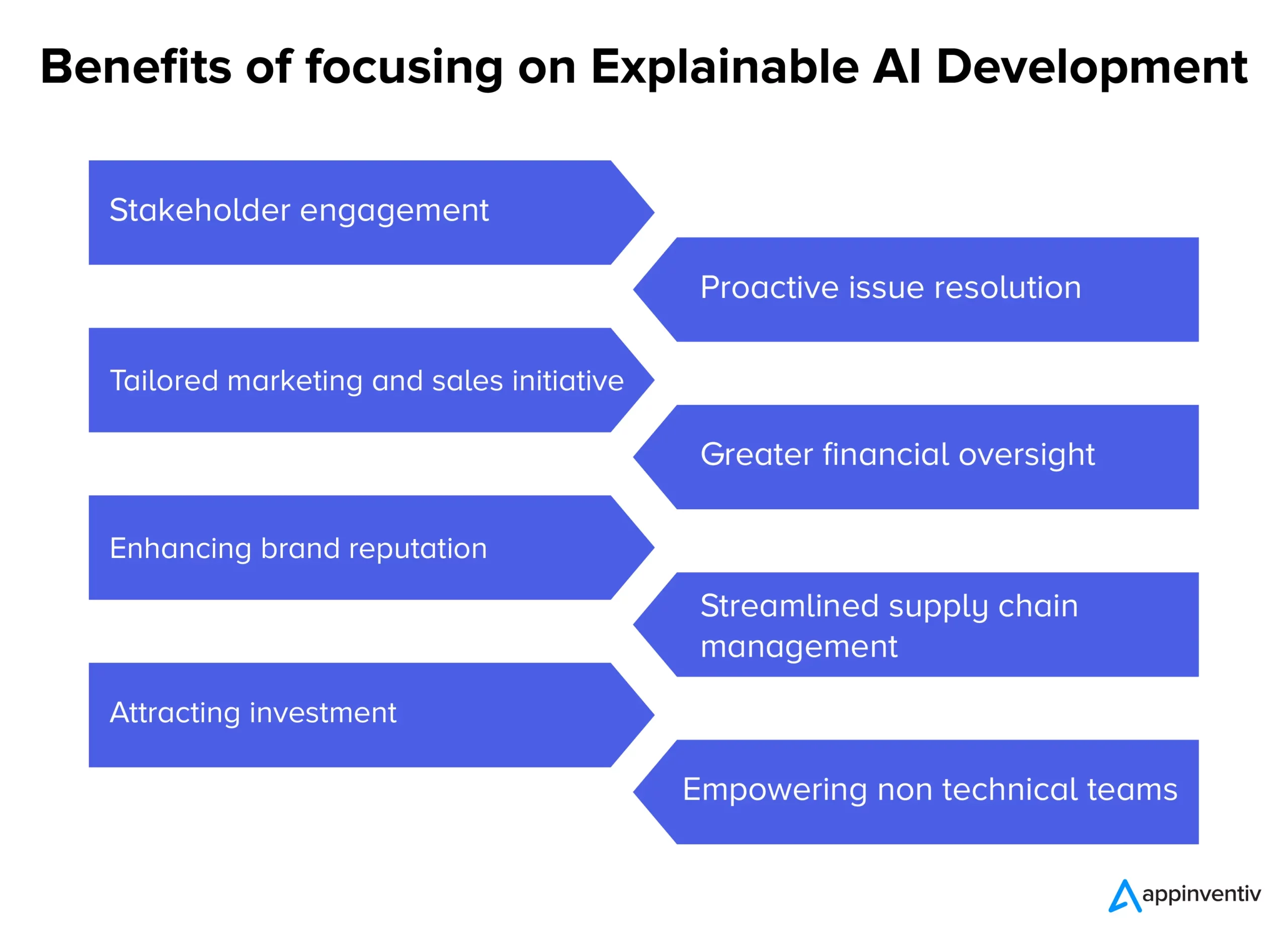

Поскольку системы искусственного интеллекта все чаще стимулируют амбиции, присущая им непрозрачность вызвала разговоры о необходимости прозрачности. Помимо технических дискуссий, существует серьезное бизнес-обоснование, лежащее в основе внедрения объяснимого ИИ. Вот различные объяснимые преимущества ИИ для бизнеса в разных отраслях.

- Вовлечение и доверие заинтересованных сторон. Прозрачные процессы принятия решений с помощью ИИ могут способствовать более глубокому чувству вовлеченности и уверенности среди внутренних команд и внешних партнеров.

- Упреждающее решение проблем: до того, как проблемы обострятся, объяснимый ИИ может выявить потенциальные проблемные области, обеспечивая своевременное вмешательство и принятие решений.

- Индивидуальные инициативы в области маркетинга и продаж. Компании могут создавать более персонализированные и эффективные кампании, понимая «почему», лежащее в основе потребительской информации, основанной на искусственном интеллекте.

- Усиление финансового контроля. Когда финансовые модели и прогнозы, основанные на искусственном интеллекте, прозрачны, потенциальные аномалии или области роста можно легче выявлять и устранять.

- Повышение репутации бренда. Компании, известные своим этичным и прозрачным внедрением искусственного интеллекта, скорее всего, будут пользоваться повышенной репутацией бренда.

- Оптимизированное управление цепочками поставок. Благодаря четкой аналитике, основанной на искусственном интеллекте, процессы цепочки поставок можно оптимизировать более эффективно, от управления запасами до логистики.

- Привлечение инвестиций. Для инвесторов прозрачность ИИ может означать приверженность компании ответственным инновациям, что делает его более привлекательным инвестиционным предложением.

- Расширение возможностей нетехнических команд: объяснимый ИИ гарантирует, что идеи и решения, основанные на ИИ, будут доступны и действенны для команд без глубоких технических знаний, что способствует сотрудничеству между отделами.

Поскольку компании ориентируются в сложной обстановке современной эпохи, полагаться на решения «черного ящика» может оказаться рискованно. Обеспечение прозрачности процессов ИИ — это не просто технологический апгрейд; это бизнес-необходимость, обеспечивающая соответствие каждого шага, поддерживаемого ИИ, более широким организационным целям и ценностям, что означает роль объяснимого ИИ. Это также объяснимые варианты использования ИИ, на которых обычно фокусируются предприниматели и разработчики ИИ.

План объяснимой модели ИИ

Теперь, когда влияние искусственного интеллекта на нашу повседневную жизнь становится все более очевидным с каждым днем, становится критически важным обеспечить, чтобы машины, которым мы доверяем принятие важных решений, были точными и прозрачными в своей работе.

Разработка объяснимой модели ИИ — это не просто программирование; это процесс, который включает в себя стратегическое планирование, тщательное тестирование и итеративную доработку, основанную на объяснимых принципах ИИ и объяснимых инструментах ИИ. Вот пошаговое руководство и объяснимые методы искусственного интеллекта, которые гарантируют, что модели искусственного интеллекта, которые мы разрабатываем, объяснимы и интерпретируемы, а также соответствуют законодательству.

- Понимание проблемной области. Прежде чем погрузиться в разработку модели, мы четко понимаем проблемную область и участвующих заинтересованных сторон. Чего ожидают пользователи? Какие решения примет ИИ и какое влияние окажут эти решения — вот некоторые из вопросов, на которые мы находим ответы.

- Выбор подходящих данных. Качество и актуальность данных напрямую влияют на способность ИИ быть точным и объяснимым. При разработке нашей модели ИИ мы гарантируем, что данные будут чистыми, разнообразными и свободными от предвзятости.

- Выбор правильной модели. Хотя некоторые модели, такие как глубокие нейронные сети, более сложны и их труднее интерпретировать, другие, такие как деревья решений или линейная регрессия, могут обеспечить большую прозрачность. Мы выбираем баланс между сложностью и ясностью при разработке объяснимых моделей ИИ.

- Итеративное тестирование: мы регулярно тестируем модель с различными наборами данных, чтобы обеспечить стабильную производительность. Отзывы об этих тестах могут способствовать доработкам и улучшениям.

- Интеграция инструментов объяснительности: такие инструменты, как LIME или SHAP, помогают разрушить прогнозы модели, предлагая понимание того, какие функции повлияли на конкретное решение.

- Документация: Полная документация помогает нам в проверке, проверке и развертывании модели. Это гарантирует, что все заинтересованные стороны понимают работу и ограничения ИИ, от разработчиков до конечных пользователей.

Баланс между производительностью модели и интерпретируемостью

Одной из наиболее серьезных проблем при разработке объяснимого программного обеспечения для искусственного интеллекта является баланс между производительностью модели и ее интерпретируемостью. Хотя сложные модели могут обеспечить более высокую точность, они часто делают это за счет прозрачности. И наоборот, более простые модели могут быть легче понять, но они не могут эффективно отражать нюансы данных. Чтобы найти правильный баланс, мы учитываем следующее:

- Простота модели и сложность: мы определяем минимальный уровень сложности, необходимый для достижения удовлетворительной производительности. Если достаточно более простой модели, она может быть лучшим выбором для обеспечения объяснимости.

- Использование методов объяснения. Такие методы, как ранжирование важности функций или методы, не зависящие от модели, могут помочь сделать сложные модели более интерпретируемыми.

- Цикл обратной связи: мы поддерживаем постоянный цикл обратной связи с конечными пользователями, чтобы понять, ясны ли решения ИИ и есть ли возможности для повышения прозрачности.

Хотя путь к созданию объяснимого ИИ может показаться сложным, он необходим. По мере дальнейшей интеграции ИИ в наши системы и процессы обеспечение этих высокопроизводительных и прозрачных моделей будет иметь решающее значение для устойчивого доверия и эффективности.

Как Appinventiv может помочь вам в разработке объяснимых моделей искусственного интеллекта?

Имея почти девятилетний опыт разработки продуктов искусственного интеллекта, мы в Appinventiv понимаем различные тонкости, связанные с разработкой моделей искусственного интеллекта, и объяснимые преимущества искусственного интеллекта. Разработав множество платформ и приложений на основе искусственного интеллекта, в том числе Mudra (приложение для личных финансов на основе искусственного интеллекта), наши инженеры обладают знаниями в предметной области и контролем, необходимыми для перехода к объяснимой разработке искусственного интеллекта.

Каким бы ни был ваш проект ИИ, мы, как ведущая компания по разработке ИИ, можем обеспечить интерпретируемость и объяснимость вашей модели ИИ, чтобы вы могли с уверенностью доверять решениям, принимаемым моделями. Связаться

сегодня, чтобы начать путь к ответственному ИИ.

Часто задаваемые вопросы

Вопрос. Что такое объяснимый ИИ?

Ответ. Объяснимый ИИ — это сдвиг парадигмы в разработке ИИ, который требует разработки моделей ИИ таким образом, чтобы можно было отслеживать решения, принятые моделью ИИ, и пользователи могли понять, как модель ИИ принимает решения.

Вопрос. Как работает объяснимый ИИ?

Ответ. Объяснимый ИИ работает путем интеграции ключевых элементов объяснимости в модели ИИ во время разработки, что может помочь определить, как модель ИИ приняла конкретное решение.

Вопрос. Почему важен объяснимый ИИ?

О. Объяснимый ИИ важен, потому что непонимание того, как модель ИИ принимает за нас решения, может привести к некоторым тяжелым последствиям, а в худших случаях может означать ощутимый вред компаниям или пользователям рассматриваемой модели ИИ.