Обновление полезного контента Google (HCU) и опасность некачественного контента, создаваемого пользователями с помощью ИИ

Опубликовано: 2023-11-06Включает советы и рекомендации, которые помогут владельцам сайтов ориентироваться в тройке AI UGC (обнаружение, объем и скорость низкокачественного контента, создаваемого пользователями AI).

Термин «низкокачественный пользовательский контент, созданный искусственным интеллектом» звучит громко, но это важная тема для владельцев сайтов, которые разрешают публикацию пользовательского контента на своих сайтах. И недавно я столкнулся с несколькими трудными ситуациями, основанными на тщательном анализе сентябрьского обновления полезного контента (HCU). Я не думаю, что кто-то еще затронул тему влияния пользовательского контента с помощью полезного обновления контента, поэтому я хотел быстро осветить эту тему в этом посте.

С момента запуска первого HCU в августе 2022 года я видел множество примеров серьезного удара по низкокачественному ИИ-контенту. Я упоминал об этом несколько раз, рассказывая о выпусках HCU в августе 2022 года, HCU в декабре 2022 года, а теперь и о более агрессивном сентябрьском HCU(X). Но дело было скорее в том, что владелец сайта активно использовал ИИ для публикации низкокачественного (и бесполезного) контента на своем сайте. Таким образом, со временем на сайтах появилось много некачественного ИИ-контента, и HCU подверглось критике.

Сегодня я имею в виду других людей, добавляющих на ваш сайт низкокачественный AI-контент через UGC. Другими словами, что, если люди, отправляющие пользовательский контент, используют ИИ для быстрого создания этого контента? А что, если этот контент более низкого качества, не отредактирован для повышения ценности, не усовершенствован, чтобы быть по-настоящему информативным и т. д.? Да, это может быть проблематично, и владельцы сайтов, разрешающие пользовательский контент, начинают замечать, что эта проблема становится все более серьезной. А некоторые сайты, которые связались со мной после сентябрьского HCU, пострадали очень сильно, и их видимость в поиске сильно упала.

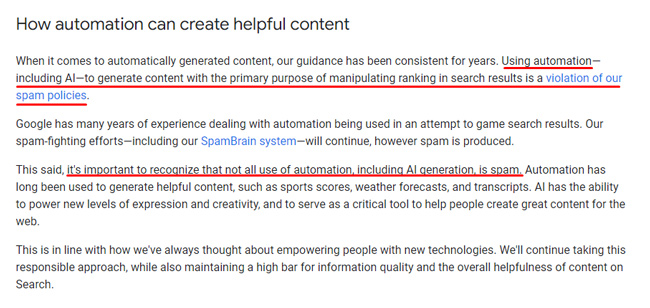

Напоминание о позиции Google в отношении контента ИИ: речь идет о качестве.

Важно помнить, что Google не против всего контента ИИ. Это против некачественного AI-контента . Так что, если кто-то использует ИИ для создания контента, редактирует и уточняет этот контент, чтобы убедиться, что он точный, ценный и т. д., то это может быть совершенно нормально. Но если кто-то просто экспортирует контент, созданный искусственным интеллектом, и публикует его в больших масштабах, то он готовит свой сайт к уничтожению либо полезным обновлением контента, либо даже широким обновлением ядра.

Вот абзац из сообщения Google об ИИ-контенте, где Дэнни Салливан объясняет, что у них есть проблемы с ИИ-контентом , основной целью которого является манипулирование рейтингом в результатах поиска :

Коварное распространение некачественного пользовательского контента, созданного искусственным интеллектом:

По моему мнению и на основе того, что я видел при анализе многих сайтов, пострадавших от HCU, низкокачественный контент ИИ в больших масштабах может быть невероятно опасным. А если пользовательский контент является основной частью контента вашего сайта, вам следует внимательно следить за качеством. Так было с пользовательским контентом в течение очень долгого времени, но теперь пользователям стало намного проще использовать инструменты создания ИИ для создания ответов на форумах, сайтах вопросов и ответов и т. д.

И только потому, что кто-то другой разместил контент на вашем сайте, вы по-прежнему несете ответственность. Google объяснял это много раз за последние годы. Ниже я включил лишь один из нескольких твитов, которыми я делился на протяжении многих лет, о Google, объясняющих, что пользовательский контент будет учитываться при оценке качества. Если он находится на вашем сайте и проиндексирован, это учитывается при оценке качества.

Умеренный уровень пользовательского контента:

Со времен средневековой Панды (около 2011 года) я всегда объяснял, что владельцам сайтов необходимо тщательно модерировать пользовательский контент. В противном случае со временем может появиться и накапливаться контент более низкого качества. И когда это произойдет, вы настраиваете свой сайт на серьезный удар по серьезному обновлению алгоритма. Так что мой совет сейчас тот же, но с небольшим изменением ИИ. Теперь я также буду искать некачественный AI-контент , а не обычный UGC-спам. Лучшие инструменты обнаружения контента с помощью ИИ продолжают совершенствоваться и могут помочь пометить контент с высокой вероятностью, что он был создан с помощью ИИ.

Ниже я приведу несколько советов для владельцев сайтов, которые могут иметь дело с некачественным контентом, созданным пользователями с помощью ИИ. Опять же, ко мне обратилось несколько сайтов, где эта проблема возникла за последний год или около того…

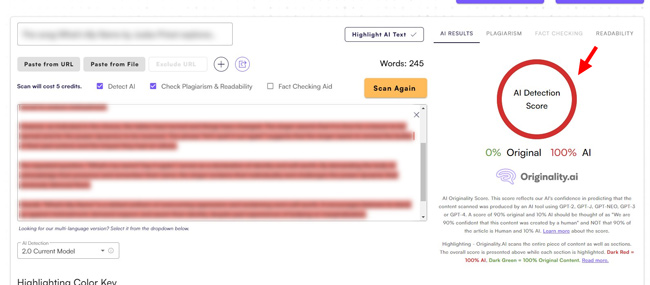

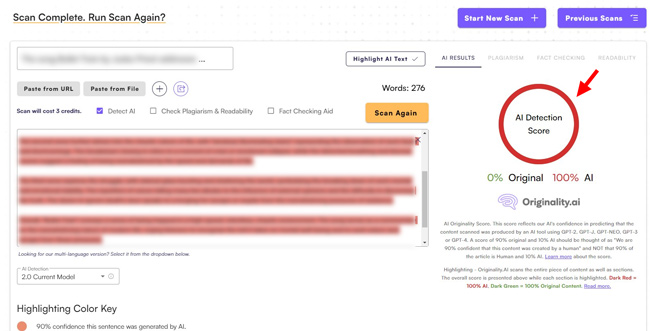

Обнаружение, объем и темп: тройка AI UGC

Помимо простого определения контента, созданного ИИ, вы можете проверить объем ответов от пользователей и скорость их отправки. Один владелец сайта недавно обратился ко мне и показал пользователя, который отправил много ответов за короткий период времени. При обработке этих ответов с помощью инструмента обнаружения контента ИИ все они вернулись со 100% вероятностью, что контент был создан с помощью ИИ. Например, вы можете увидеть два из этих материалов ниже.

Таким образом, сочетание объема, темпа и довольно очевидного ИИ-контента дало хороший пример того, как пользователь использует ИИ для создания тонны пользовательского контента на рассматриваемом сайте.

Обратите внимание: это крупномасштабный сайт, поэтому этот один пользователь, вероятно, не окажет большого влияния. Но со временем, если другие пользователи сделают то же самое, это может привести к проблемам с точки зрения качества. Владелец сайта поступил разумно, обратившись ко мне по этому поводу. Они обработали этого пользователя и могли бы разработать процесс выявления закономерностей, который мог бы помочь выявить людей, пытающихся обмануть систему с помощью низкокачественного пользовательского контента, созданного ИИ.

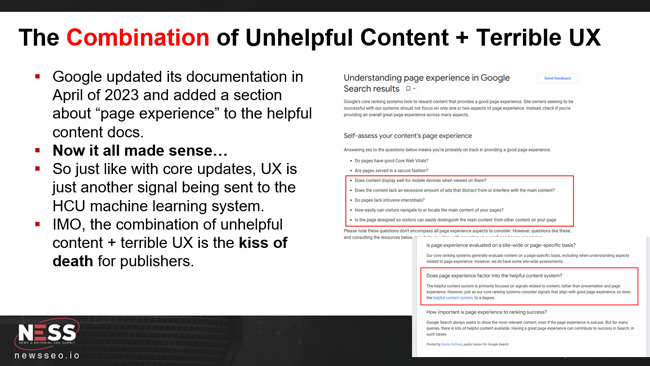

И помните, сентябрьский HCU, похоже, включил в уравнение UX (что я неоднократно наблюдал, анализируя множество пострадавших сайтов). Таким образом, барьеры пользовательского опыта, такие как агрессивная реклама, всплывающие окна, межстраничные объявления и многое другое, могут способствовать созданию «бесполезного контента». Поэтому, если вы объедините низкокачественный пользовательский контент, созданный искусственным интеллектом, с ужасным UX, у вас могут возникнуть серьезные проблемы с роумингом HCU в сети. Остерегаться.

Заключение: предупреждение для владельцев сайтов, принимающих пользовательский контент.

Опять же, я хотел осветить эту тему для любого сайта, публикующего пользовательский контент. Даже если у вас более крупный сайт с огромным количеством контента, я был бы очень осторожен с размещением на нем любого типа некачественного контента. И теперь, благодаря простоте инструментов создания контента с помощью искусственного интеллекта, вы должны быть осторожны, не допуская размещения на сайте низкокачественного контента, созданного пользователями с помощью искусственного интеллекта. Опять же, несколько компаний обратились ко мне после сильного удара, и это явно было частью проблемы.

Закончу этот пост несколькими советами и рекомендациями для владельцев сайтов:

- Тщательная модерация с использованием искусственного интеллекта. Если вы принимаете на своем сайте пользовательский контент, вы уже должны тщательно модерировать его с точки зрения качества. Но теперь вам также следует следить за отправляемым AI- контентом более низкого качества.

- Скорость отправки. Одним из тревожных сигналов может быть скорость отправки определенными пользователями. Например, я объяснил ранее, что компания, которая обратилась ко мне после того, как уведомила о материалах, которые показались мне немного неуместными… Когда я покопался в этом пользователе, за очень короткий период времени было получено множество предложений. И после обработки этих материалов с помощью инструментов обнаружения контента ИИ возникла 100% вероятность того, что эти материалы были созданы с помощью ИИ.

- Лаборатория тестирования. Я рекомендую создать лабораторию тестирования, которая будет использовать несколько инструментов обнаружения контента с использованием искусственного интеллекта. Инструменты не идеальны, но они хорошо обнаруживают низкокачественный контент, созданный ИИ. Разработайте процедуру проверки помеченного контента. Далее я расскажу об API, которые могут помочь в массовой проверке контента.

- API — ваш друг: некоторые инструменты обнаружения контента AI имеют API, которые позволяют вам массово проверять контент. Если у вас крупномасштабный сайт с большим количеством пользовательского контента, то использование API может быть разумным решением. Например, GPTZero, Originality.ai и другие имеют API, которые вы можете использовать для проверки контента в большом масштабе.

- Политика в отношении контента ИИ для контента, созданного пользователями: необходимо иметь политику в отношении контента ИИ, к которому пользователи смогут получить доступ и который будет легко понять. Убедитесь, что пользователи понимают, что разрешено, а что запрещено , включая то, что вы будете делать, если будет обнаружен некачественный контент AI.

- Что касается индексирования, будьте быстры, будьте решительны: и, наконец, быстро разбирайтесь с материалами ИИ и следите за тем, чтобы они не индексировались (или не оставались в индексе). Как я уже неоднократно рассказывал в постах и презентациях об основных обновлениях алгоритма, все проиндексированные страницы принимаются во внимание, когда Google оценивает качество. Поэтому сосредоточьтесь на том, что я называю «качественной индексацией», и убедитесь, что низкокачественный контент, созданный пользователями ИИ, не индексируется.

Краткое описание: следите за пользовательским контентом с элементами искусственного интеллекта.

Для сайтов, которые принимают пользовательский контент, всегда было важно тщательно модерировать этот контент с точки зрения качества. А теперь, благодаря инструментам генерации контента на основе искусственного интеллекта, с пользовательским контентом стало сложнее справиться, а модерация стала немного сложнее. Я рекомендую просмотреть советы и рекомендации, которые я предоставил в этом посте, чтобы создать процесс выявления потенциальных проблем, а затем быстро их решать. Это лучший способ поддерживать высокий уровень «индексации качества», что важно для предотвращения проблем, связанных с крупными обновлениями алгоритмов, такими как обновление полезного контента и обширные обновления ядра.

ГАРАНТИРОВАННАЯ ПОБЕДА