Как избежать нарушений при разработке продуктов ИИ

Опубликовано: 2023-06-12Искусственный интеллект остается главной технологической тенденцией в течение нескольких лет благодаря его вкладу в такие отрасли, как производство, здравоохранение и финансы, интенсивно работающие с данными и машинами. Однако только в последние два года эта технология вызвала большой интерес у конечных пользователей. Благодаря таким приложениям, как генераторы изображений и текста, люди теперь могут создавать изображения и тексты одним щелчком мыши.

Хотя кажется, что эти платформы ИИ создают материал с нуля, это совсем не так — эти платформы ИИ были обучены работе с фрагментами вопросов и озерами данных, которые работают, обрабатывая архивы текста и изображений из Интернета. Несмотря на то, что этот подход полезен для конечных пользователей, он сопряжен с юридическими рисками, такими как нарушение авторских прав, несоблюдение лицензий с открытым исходным кодом, нарушение прав интеллектуальной собственности и т. д. с новыми правилами и наказаниями за неэтичные модели искусственного интеллекта.

Для компании, готовящейся к запуску своего проекта ИИ, очень важно понимать риски и создавать систему, которая не попадает под юридический радар из-за этих этических проблем. В этой статье мы собираемся погрузиться во многие аспекты соблюдения требований ИИ во время разработки программного обеспечения — типы юридических вопросов, способы подготовки к регулированию ИИ и акты ИИ, принятые в разных регионах.

Что такое соответствие ИИ?

Это процесс, который обеспечивает соответствие приложений на основе ИИ правилам и законам региона, в котором они работают. Вот различные факторы, из которых состоит проверка соответствия ИИ:

Юридические проблемы с искусственным интеллектом

Хотя на микроуровне может показаться, что проблемы с использованием ИИ конечными пользователями ограничиваются плагиатом или доступом к данным, которыми нельзя делиться, на макроуровне несоблюдение требований ИИ вызывает более серьезные проблемы.

Угрозы, связанные с использованием плохо построенной системы искусственного интеллекта, могут повлиять на честную конкуренцию, кибербезопасность, защиту прав потребителей и даже гражданские права. Поэтому для компаний и правительств крайне важно построить справедливую и этичную модель.

Авторские права

С появлением генеративного ИИ предприятия начали создавать материалы, защищенные авторским правом, с помощью технологий. Проблема заключается в невозможности понять, были ли данные созданы творческим путем автора или автором является ИИ.

Чтобы обеспечить соблюдение закона, Бюро регистрации авторских прав выпустило Руководство по проверке и регистрации произведений, содержащих материалы, созданные ИИ. В нем указано следующее –

- Авторское право может защищать только материал, созданный в результате творчества человека.

- В случае работ с материалом на основе ИИ будет рассматриваться вопрос о том, является ли вклад ИИ результатом «механического воспроизведения» или является «собственной оригинальной концепцией автора, которой они придали видимую форму посредством ИИ.

- Заявители обязаны раскрывать информацию об использовании контента на основе ИИ в материалах, представляемых на регистрацию.

Читайте также: Стоимость разработки инструмента обнаружения контента с помощью ИИ в 2023 году

Открытый источник

Генераторы кода на основе ИИ часто используют ИИ, чтобы помочь разработчикам в автозаполнении или предложении кода после тестов или входных данных для разработчиков. Вот некоторые проблемы, связанные с разработкой совместимых моделей ИИ на основе генераторов кода:

- Является ли обучение моделей ИИ с открытым исходным кодом нарушением?

- Кто отвечает за соответствие критериям соответствия с открытым исходным кодом — разработчик или пользователь?

- Будет ли использование кода на основе ИИ разработчиками, создающими новое программное обеспечение, требовать, чтобы приложение было лицензировано с открытым исходным кодом?

Нарушение прав интеллектуальной собственности

Во всем мире против инструментов ИИ было подано множество исков о нарушении прав, обвиняя их в том, что они обучают свои модели или генерируют выходные данные на основе стороннего контента, защищенного интеллектуальной собственностью.

Этическая предвзятость

Было много случаев, когда технология распознавания лиц ИИ приводила к расовой дискриминации. Будь то случай, когда в 2020 году чернокожие были арестованы из-за компьютерной ошибки или в Google Фото чернокожие были помечены как «гориллы». Независимо от того, насколько умна технология, нельзя игнорировать тот факт, что она создана людьми с предубеждениями.

Для компаний, стремящихся создавать аналогичные решения, крайне важно не допустить, чтобы эти предубеждения проникли в систему.

Соответствие GDPR для проектов ИИ

При этом крайне важно понять, почему предприятиям не удается создавать модели искусственного интеллекта, соответствующие требованиям, несмотря на строгие правила. Причин тому может быть несколько, начиная от незнания соответствия, непонимания разработчиков, а иногда и простого незнания. Однако за этим могут стоять и некоторые функциональные причины.

Давайте рассмотрим некоторые из них с точки зрения соответствия GDPR для проектов ИИ.

Ограничение цели

Принцип GDPR требует, чтобы предприятия информировали субъектов данных о целях, для которых их информация собирается и обрабатывается. Проблема заключается в том, что технология использует данные для поиска закономерностей и получения новой информации, но это может не быть реальной целью этих данных.

Дискриминация

GDPR требует, чтобы разработчики ИИ предпринимали шаги против дискриминационного воздействия, которое может нести технология. Несмотря на то, что это этическая необходимость, для разработчика, работающего с быстро меняющимся социальным сценарием, подготовка модели ИИ к любой дискриминации и аморальному результату может стать сложной задачей.

Минимизация данных

GDPR говорит, что собранная информация должна быть «адекватной, ограниченной и актуальной». Это означает, что команды разработчиков ИИ должны быть очень осторожны при использовании данных для своих моделей и должны иметь четкое представление о количестве данных, необходимых для их проекта.

Однако это непредсказуемо, поэтому команды должны регулярно оценивать тип и количество данных, которые им необходимы для выполнения требований по минимизации данных.

Прозрачность

Наконец, пользователи должны иметь право голоса в отношении того, как их данные используются третьими сторонами, для этого компаниям необходимо четко понимать, какие данные они используют и как.

Проблема в том, что большинство моделей ИИ работают в черных ящиках, и непонятно, как они принимают решения, особенно когда мы говорим о продвинутом программном обеспечении.

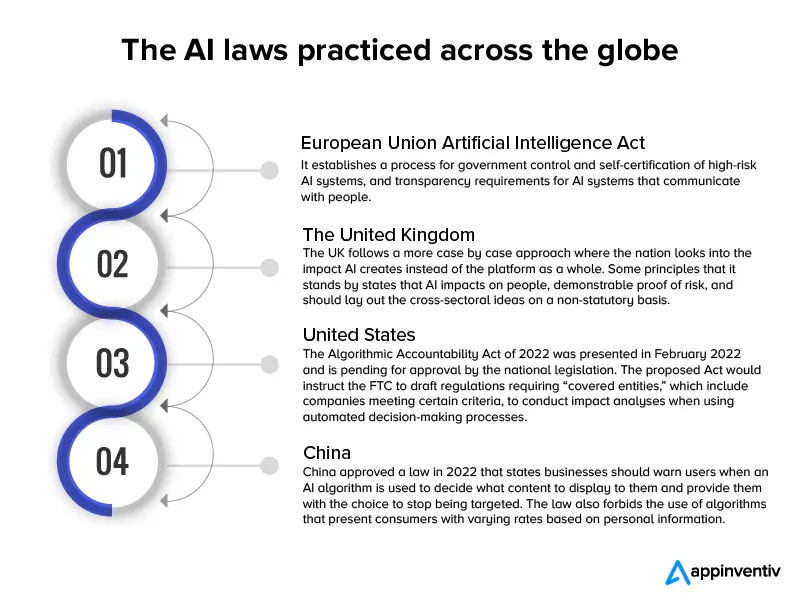

Несмотря на то, что все это настоящие технические проблемы, когда дело доходит до ИТ-этики, очень важно, чтобы компании не использовали их в качестве щита для разработки дефектной модели ИИ. Чтобы эта практика не стала мейнстримом, в глобальном масштабе было принято несколько законов об искусственном интеллекте.

С 2017 года почти 60 стран ввели законы и правила в области искусственного интеллекта, что соответствует скорости внедрения новых моделей ИИ.

Вот инфографика, дающая краткий обзор этих законов.

Теперь, когда мы рассмотрели проблемы разработки ИИ с юридической точки зрения и черновой вариант применимых законов на глобальном уровне, давайте перейдем к способам создания совместимого приложения ИИ.

Также читайте: Сколько стоит разработка юридически совместимого чат-бота, такого как ChatGPT

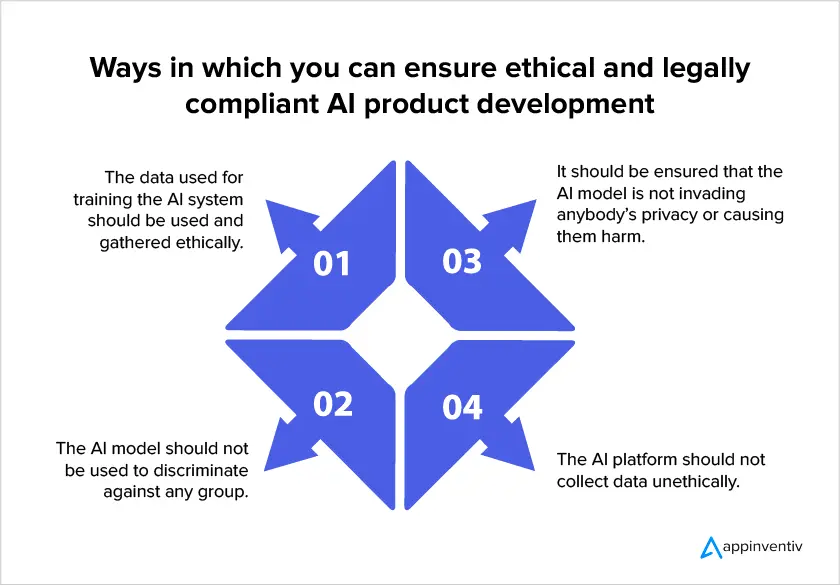

Как разработать модель искусственного интеллекта, отвечающую требованиям

В связи с усилением регулирования ИИ на глобальном уровне для компаний стало критически важным сосредоточиться на соблюдении законодательства при создании моделей ИИ. Вот несколько способов, которыми компании могут обеспечить соответствие своего проекта законодательству при инвестировании в услуги по разработке ИИ.

- Убедитесь, что вам разрешено использовать данные

В соответствии с требованиями ИИ говорится, что конфиденциальность пользователей должна быть руководящим принципом разработки модели. Это означает, что вы должны свести к минимуму объем данных, которые необходимо собрать, указать точную причину сбора данных, а также время, до которого вы будете использовать их данные. В конечном счете, важно отметить, что пользователи должны дать свое согласие на сбор данных.

- Объяснимые методы ИИ

Этот подход помогает устранить эффект черного ящика, помогая людям понять, что находится внутри систем ИИ и как модель принимает решения. Это, в свою очередь, помогает исследователям узнать точное количество данных, которое им потребуется для повышения точности модели в соответствии с требованиями минимизации данных.

- Следите за собранными данными

Соответствие требованиям ИИ требует, чтобы предприятия знали местонахождение и использование собранных персональных данных. Правильная категоризация данных необходима для соблюдения прав пользователей на защищенную информацию. Кроме того, у предприятий должен быть подход, чтобы знать, какая информация хранится в каком наборе данных, чтобы подготовить точные меры безопасности.

- Понимать правила передачи данных между странами

Когда в системе ИИ происходит трансграничная передача данных, разработчикам следует учитывать правила, которые будут применяться в принимающих странах, и соответствующим образом создавать соответствующие механизмы передачи данных. Например, если GDPR применим к обработке данных и персональные данные передаются в страну, не входящую в ЕЭЗ, необходимо провести надлежащую оценку последствий передачи.

Использование таких подходов при разработке приложений ИИ имеет большое значение для обеспечения надлежащего устранения рисков, связанных с технологией. Однако компании и регулирующие органы должны помнить о том, что невозможно защитить приложение от всех потенциальных рисков, поскольку отраслевой контекст работает по индивидуальной модели. Из-за этого роль риск-менеджеров ИИ останется критически важной, поскольку они смогут оценить, когда необходимо вмешательство.

Мы надеемся, что статья помогла вам понять, чего ожидать от правовой структуры, связанной с технологией ИИ в ближайшее время, и как подготовиться к модели ИИ, соответствующей требованиям.

Часто задаваемые вопросы

В. Есть ли юридические проблемы с искусственным интеллектом?

А. Да. Может возникнуть ряд юридических и этических проблем, связанных с плохо построенной моделью искусственного интеллекта.

- Авторские права

- Злоупотребление лицензией с открытым исходным кодом

- Нарушение прав интеллектуальной собственности

- Этические предубеждения, такие как расовая дискриминация.

В. Почему сложно создать юридически совместимую модель ИИ?

О. С технической точки зрения может быть сложно создать юридически совместимый ИИ, потому что, хотя технология использует данные клиентов для поиска закономерностей и получения новой информации, становится трудно установить реальную цель этих данных. Далее, команды разработчиков ИИ никогда не могут быть уверены в количестве данных, необходимых для их проекта. Наконец, большинство моделей ИИ работают в «черных ящиках», и непонятно, как они принимают решения, особенно когда мы говорим о продвинутом программном обеспечении.

В. Как обеспечить соблюдение законодательства в области ИИ?

О. Хотя законы и нормативные акты, касающиеся соблюдения требований законодательства в области ИИ, постоянно развиваются, вот некоторые вещи, которые вы можете сделать, чтобы ваша модель была максимально приближена к соответствию:

- Убедитесь, что вам разрешено использовать данные

- Объяснимые методы ИИ

- Следите за собранными данными

- Понимать правила передачи данных между странами