Ответственный ИИ: решение проблем усыновления с помощью руководящих принципов и стратегий

Опубликовано: 2023-09-08В эпоху широкого распространения решений искусственного интеллекта стало весьма важно уделять приоритетное внимание ответственному процессу разработки, соблюдая при этом принципы безопасности и этики. Поскольку возможности этих систем искусственного интеллекта продолжают расширяться и находить применение в различных промышленных нишах, обеспечение соответствия их создания строгим мерам безопасности должно быть одним из главных приоритетов организации.

Итак, как можно гарантировать, что их системы на основе ИИ этичны и не вызовут каких-либо непредвиденных последствий? Простой ответ на эту загадку — соблюдение принципов ответственного ИИ.

Ответственный ИИ (RAI) относится к комплексной системе искусственного интеллекта, в которой этические соображения и общественное благосостояние занимают центральное место. Он предполагает ответственную разработку и применение систем искусственного интеллекта, разработанных в соответствии с фундаментальными принципами.

Принципы ответственного ИИ позволяют организациям сосредоточиться на прозрачности, позволяя пользователям и заинтересованным сторонам понять внутреннюю работу систем ИИ. Эта прозрачность открывает путь к повышению доверия и подотчетности, позволяя людям понять, как принимаются решения ИИ. RAI также активно борется с предвзятостью в алгоритмах ИИ, разумно управляя данными и применяя меры справедливости, чтобы гарантировать беспристрастность и объективность результатов.

Этот блог поможет вам понять пять ответственных принципов ИИ и то, как их соблюдение может сделать вашу систему ИИ справедливой и справедливой для пользователей. Помимо рассмотрения преимуществ внедрения ответственного ИИ для бизнеса, мы также поможем вам понять различные проблемы, которые можно решить, приняв оптимизированный подход.

Необходимость принятия ответственных стратегий ИИ: снижение рисков, связанных с ИИ

В марте 2016 года Microsoft запустила в Твиттере чат-бота с искусственным интеллектом под названием Tay. Целью Tay было извлечь уроки из взаимодействия с пользователями. К сожалению, некоторые люди начали публиковать в боте оскорбительный контент, в результате чего Тэй ответил оскорбительным языком. За считанные часы Тэй превратился в бота, пропагандирующего разжигание ненависти и дискриминацию. Microsoft быстро отключила Тая и извинилась за неуместные твиты бота. Этот инцидент является наглядным примером того, как ИИ может пойти не так, и с тех пор произошло много подобных случаев.

ИИ обладает огромным потенциалом принести пользу обществу, но, как говорит дядя Бен, «с большой силой приходит и большая ответственность».

Когда вы используете ИИ для принятия важных бизнес-решений, связанных с конфиденциальными данными, важно знать:

- Что делает ИИ и почему?

- Делает ли он точный и справедливый выбор?

- Уважает ли это частную жизнь людей?

- Сможете ли вы контролировать и следить за этой мощной технологией?

Организации по всему миру осознают важность стратегии ответственного ИИ, но находятся на разных этапах ее внедрения. Принятие принципов ответственного ИИ (RAI) — наиболее эффективная стратегия снижения рисков, связанных с ИИ.

Таким образом, пришло время оценить вашу текущую практику и обеспечить ответственное и этичное использование данных. Раннее внедрение RAI не только снизит риски, связанные с этой практикой, но и позволит организациям опередить конкурентов, предоставив им конкурентное преимущество, которое, возможно, будет сложно превзойти в будущем.

По данным опроса MIT Sloan Survey, 52% компаний предпринимают шаги в направлении ответственной практики искусственного интеллекта. Однако более 79% этих компаний признают, что их усилия ограничены по масштабу и масштабу. В отчете подчеркивается растущая важность для бизнеса решения этих проблем и определения приоритета ответственного ИИ (RAI), поскольку роль ИИ в компаниях продолжает возрастать. Чтобы сформировать устойчивое и ответственное будущее, основанное на искусственном интеллекте, создание прочной этической основы является не просто выбором, но и необходимым.

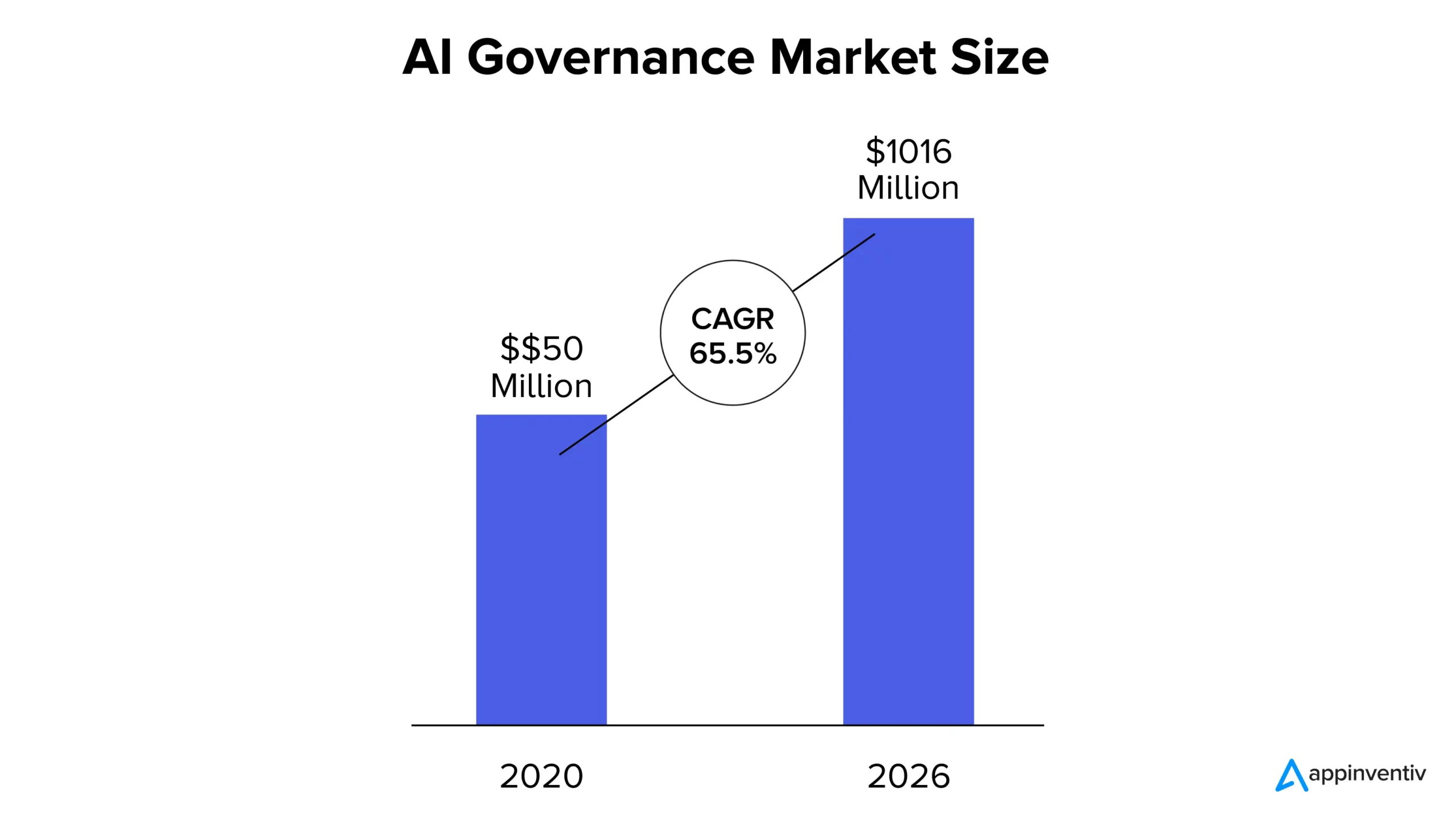

Теперь, согласно отчету MarketsandMarkets, рынок управления ИИ оценивался в 50 миллионов долларов в 2020 году и, как ожидается, достигнет 1016 миллионов долларов к 2026 году, при этом среднегодовой темп роста составит 65,5%. Увеличение доли рынка можно объяснить растущим ростом прозрачности систем искусственного интеллекта, соблюдением нормативных требований и растущей потребностью в доверии к решениям на основе искусственного интеллекта.

Каковы принципы ответственного ИИ?

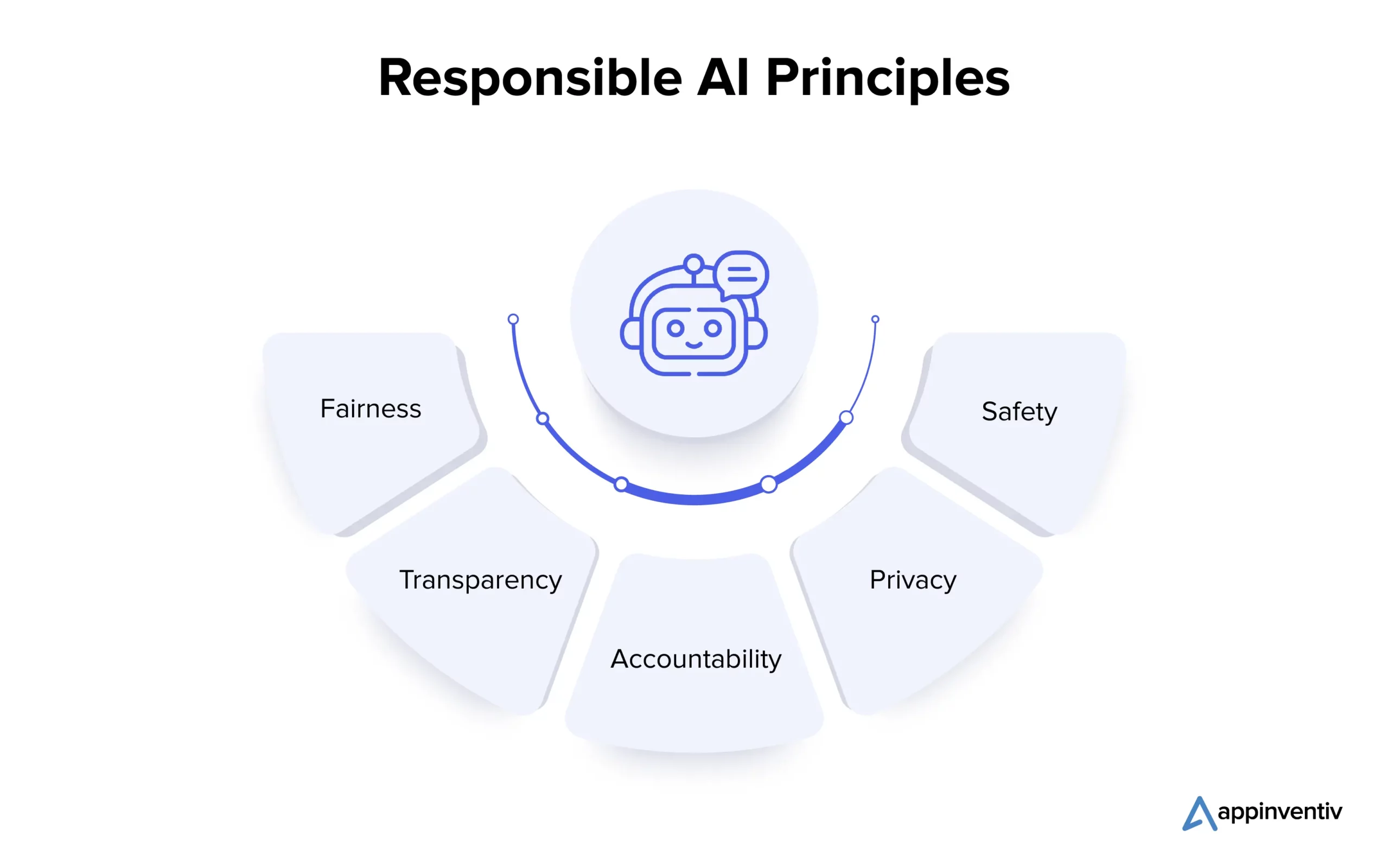

Понимание основных принципов ответственного ИИ жизненно важно для организаций, стремящихся этически ориентироваться в сложном ландшафте ИИ. Давайте рассмотрим несколько принципов подробно ниже:

1. Справедливость

Справедливость в ИИ — это фундаментальный принцип, который устраняет предвзятости в системах ИИ. Смещения могут возникнуть во время создания алгоритма или из-за искажения обучающих данных. Ученые, работающие с данными, используют такие методы, как анализ данных, для обнаружения и исправления предвзятости, гарантируя, что системы ИИ принимают объективные решения и способствуют равным результатам.

2. Прозрачность

Прозрачность ИИ предполагает документирование и объяснение шагов, предпринятых при его разработке и внедрении, делая его понятным для заинтересованных сторон. Такие методы, как интерпретируемое машинное обучение, раскрывают логику решений ИИ, а человеческий надзор обеспечивает этическое соответствие и обоснованность.

3. Подотчетность

Подотчетность тесно связана с прозрачностью и включает в себя создание механизмов, позволяющих разработчикам и пользователям ИИ нести ответственность за результаты и влияние систем ИИ. Это предполагает внедрение этических принципов, использование инструментов мониторинга и проведение аудита. Эти меры гарантируют, что системы искусственного интеллекта принесут желаемые результаты, предотвратят непреднамеренный вред и сохранят надежность.

4. Конфиденциальность

Конфиденциальность имеет решающее значение для защиты личной информации людей. Экосистема ИИ предполагает получение согласия на сбор данных, сбор только необходимых данных и их использование исключительно по назначению. Методы сохранения конфиденциальности, такие как дифференциальная конфиденциальность и криптографические методы, используются для защиты личных данных во время разработки и производства моделей ИИ.

5. Безопасность

Разработчики должны уделять приоритетное внимание безопасности в ответственном ИИ, включая физическое и нефизическое благополучие. Для достижения этой цели вопросы безопасности должны быть интегрированы на каждом этапе разработки системы ИИ. На этапе проектирования решающее значение имеет привлечение различных заинтересованных сторон для выявления и понимания потенциальных рисков. Оценка рисков, тестирование в различных условиях, человеческий надзор, а также постоянный мониторинг и совершенствование во время производства необходимы для предотвращения вреда и поддержания надежности систем искусственного интеллекта.

Рассмотрев многочисленные принципы ответственного ИИ, давайте двинемся дальше и поймем проблемы, связанные с принятием решения.

Каковы проблемы при принятии ответственных решений в области искусственного интеллекта?

Внедрение ответственного ИИ — это многообещающий путь, который принесет большие выгоды для бизнеса, но его критические проблемы требуют тщательного рассмотрения и упреждающих решений. Давайте рассмотрим их подробно ниже:

Объясняемость и прозрачность

Системы искусственного интеллекта должны иметь возможность разъяснять, как и почему они дают конкретные результаты, чтобы поддерживать доверие. Отсутствие прозрачности может снизить доверие к этим системам.

Личная и общественная безопасность

Автономные системы, такие как беспилотные автомобили и роботы, могут создавать риски для безопасности человека. Обеспечение благополучия людей в таких условиях имеет решающее значение.

Автоматизация и контроль человека

Хотя ИИ может повысить производительность, он может снизить участие и опыт человека. Достижение баланса для обеспечения человеческого контроля и надзора является непростой задачей.

Предвзятость и дискриминация

Несмотря на то, что системы искусственного интеллекта созданы нейтральными, они все равно могут унаследовать предвзятость обучающих данных, что потенциально может привести к непреднамеренной дискриминации. Предотвращение подобных предубеждений имеет жизненно важное значение.

Подотчетность и регулирование

С ростом общего присутствия ИИ могут возникнуть вопросы ответственности и ответственности. Определить, кто несет ответственность за использование или неправильное использование системы ИИ, сложно.

Безопасность и конфиденциальность

ИИ требует обширного доступа к данным, что может еще больше вызвать обеспокоенность по поводу нарушений конфиденциальности и безопасности данных. Защита данных, используемых для обучения ИИ, важна для защиты общей конфиденциальности человека.

Теперь партнерство с авторитетной фирмой по разработке приложений искусственного интеллекта (например, Appinventiv), которая придерживается принципов ответственного искусственного интеллекта в процессе разработки, может помочь предприятиям эффективно снизить связанные с этим проблемы и риски.

Преимущества ответственного ИИ для бизнеса

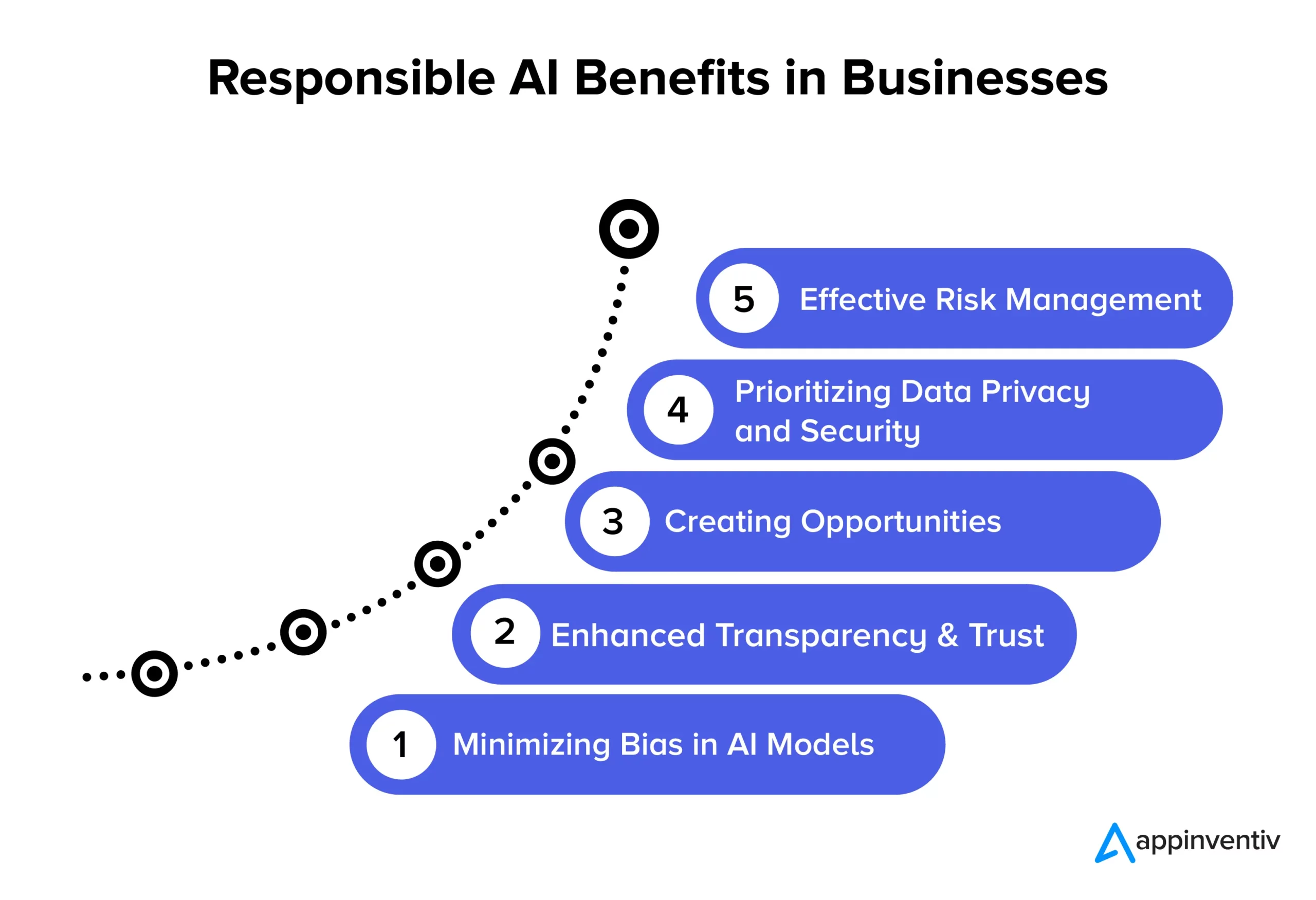

Принятие принципов ответственного ИИ открывает путь к множеству существенных преимуществ для бизнеса и общества. Давайте рассмотрим их подробно ниже:

Минимизация систематической ошибки в моделях искусственного интеллекта

Придерживаясь принципов ответственного ИИ, компании могут эффективно уменьшить предвзятость в своих моделях ИИ и базовых данных, используемых для их обучения. Такое уменьшение предвзятости гарантирует, что системы ИИ будут предоставлять более точные и справедливые результаты, которые являются этически правильными и снижают риск изменения данных с течением времени. Кроме того, минимизация предвзятости помогает организациям избежать потенциального вреда для пользователей, который может возникнуть в результате предвзятых результатов модели ИИ, повышая их репутацию и снижая ответственность.

Повышенная прозрачность и доверие

Ответственные методы ИИ повышают ясность и прозрачность моделей ИИ. Это помогает укрепить доверие между предприятиями и их клиентами. Кроме того, ИИ становится более доступным и понятным для более широкой аудитории, что приносит пользу организациям и конечным пользователям за счет расширения спектра приложений и повышения эффективности использования технологий ИИ.

Создание возможностей

Соблюдение принципов ответственного ИИ дает разработчикам и пользователям возможность открыто обсуждать системы ИИ. Это одно из самых востребованных преимуществ ответственного ИИ в бизнесе. Это создает пространство, где люди могут высказывать свои вопросы и опасения по поводу технологий искусственного интеллекта, что позволяет предприятиям активно решать эти проблемы. Такой совместный подход к разработке ИИ приводит к созданию этически обоснованных и социально ответственных решений ИИ, которые могут повысить репутацию и конкурентоспособность компании.

Приоритет конфиденциальности и безопасности данных

Ответственные решения в области искусственного интеллекта позволяют предприятиям сосредоточиться на защите конфиденциальности и безопасности данных. Это означает, что с личными или конфиденциальными данными обращаются осторожно, защищая права отдельных лиц и предотвращая утечку данных. Когда компании следуют принципам ответственного ИИ, они снижают вероятность неправильного использования данных, нарушения правил и нанесения ущерба своей репутации. Это разумный способ обеспечить безопасность данных и сохранить доверие клиентов.

Эффективное управление рисками

Ответственная практика ИИ устанавливает четкие этические и правовые правила для систем ИИ, что помогает снизить вероятность вредных последствий. Такое снижение риска приносит пользу многим субъектам, таким как предприятия, сотрудники и общество. Организации могут избежать дорогостоящих судебных исков и нанести ущерб своей репутации при решении возможных этических и юридических проблем.

Примеры успешного внедрения ответственного ИИ

Вот несколько примечательных реальных примеров организаций, которые отдают приоритет этичным и объективным практикам ИИ:

Надежный инструмент рекрутинга с использованием искусственного интеллекта от IBM

Крупная корпорация США сотрудничала с IBM, чтобы автоматизировать процессы найма и сделать приоритетными вопросы справедливости в процессах найма, основанных на искусственном интеллекте. Их цель заключалась в том, чтобы способствовать разнообразию и инклюзивности, сохраняя при этом целостность своих моделей машинного обучения. Используя IBM Watson Studio, инструмент мониторинга и управления искусственным интеллектом, они успешно выявили и устранили предвзятость при приеме на работу, одновременно получив ценную информацию о процессе принятия решений с помощью искусственного интеллекта.

Система ответственного искусственного интеллекта совхоза

State Farm, ведущая страховая компания в США, внедрила искусственный интеллект в свой процесс обработки претензий и внедрила ответственную стратегию искусственного интеллекта. Они создали систему управления для распределения ответственности за ИИ, что привело к более быстрому и обоснованному принятию решений. Модель искусственного интеллекта State Farm Dynamic Vehicle Assessment Model (DVAM) эффективно прогнозирует общие потери и обеспечивает прозрачность обработки страховых претензий.

Ответственная команда по искусственному интеллекту H&M Group и контрольный список

H&M Group, глобальный ритейлер модной одежды, интегрировал искусственный интеллект в свою деятельность, чтобы обеспечить устойчивое развитие, оптимизировать цепочки поставок и улучшить персонализированное обслуживание клиентов. В 2018 году компания создала специальную команду по ответственному использованию ИИ, чтобы обеспечить ответственное использование ИИ. Эта команда разработала практический контрольный список, который выявляет и смягчает потенциальный вред, связанный с ИИ, и полностью придерживается принципов ответственного ИИ.

Справедливость Google в машинном обучении

Google также активно работает над включением мер справедливости в искусственный интеллект и машинное обучение. Они разработали инструменты и ресурсы, которые помогут разработчикам выявлять и смягчать предвзятость в их моделях машинного обучения.

GPT-3 от OpenAI

OpenAI, компания, разработавшая GPT-3, также является ключевым лидером в ответственном подходе к развертыванию ИИ. Они внедрили механизмы тонкой настройки, чтобы избежать вредных и предвзятых результатов, что еще раз доказывает их приверженность этичному ИИ даже в продвинутых моделях НЛП.

Будущее ответственного искусственного интеллекта с Appinventiv

Будущее ответственного ИИ — это постоянное путешествие, в котором организации находятся на разных стадиях этического развития в отношении технологий и использования данных. Это динамичная область, ориентированная на создание стандартизированных руководств для различных отраслей. Чтобы ориентироваться в принципах ответственного ИИ для вашего бизнеса, партнерство с Appinventiv — лучший выбор, который может сделать бизнес. Мы можем помочь вам создать этичные, объективные и точные решения в области искусственного интеллекта, адаптированные к вашим потребностям.

Будучи специализированной компанией по разработке искусственного интеллекта, наши разработчики обладают многолетним опытом разработки решений искусственного интеллекта, уделяя приоритетное внимание этике и ответственности. Имея подтвержденный опыт успешных проектов в области искусственного интеллекта, охватывающих множество промышленных областей, мы понимаем важность согласования решений искусственного интеллекта с необходимыми основными ценностями и этическими принципами. Мы можем помочь вам реализовать меры справедливости, чтобы ваши бизнес-решения на основе искусственного интеллекта принимали беспристрастные решения.

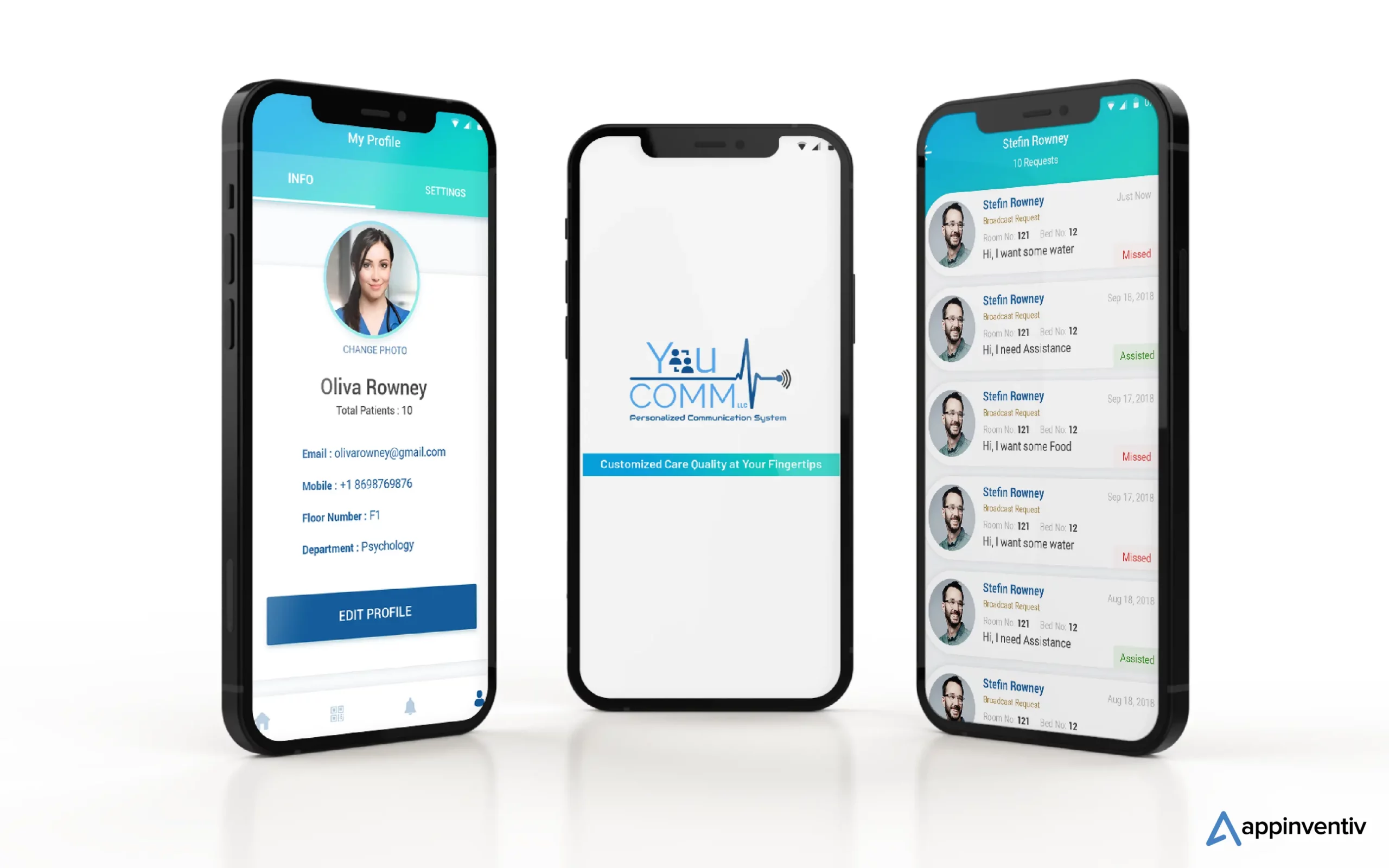

Недавно мы разработали YouComm, медицинское приложение на основе искусственного интеллекта, которое связывает пациентов с медсестрами больниц с помощью жестов и голосовых команд. В настоящее время решение внедрено в более чем 5 больничных сетях по всей территории США.

Свяжитесь с нашими экспертами по искусственному интеллекту, чтобы создать решения искусственного интеллекта, которые обеспечивают точные результаты и соответствуют этическим стандартам.

Часто задаваемые вопросы

Вопрос. Каковы примеры ответственного ИИ?

Ответ . Вот несколько примеров ответственного ИИ в различных отраслях промышленности:

- Справедливые алгоритмы: системы искусственного интеллекта спроектированы так, чтобы быть справедливыми и уменьшать предвзятость решений.

- Объяснимый ИИ (XAI): делает решения ИИ понятными.

- Смягчение предвзятости: постоянный мониторинг и снижение предвзятости в ИИ.

- Комитеты по этике ИИ: создание внутренних наблюдательных советов по этике ИИ.

- ИИ, сохраняющий конфиденциальность: защита конфиденциальных данных при их использовании для ИИ.

- Отчеты о прозрачности: рассказываем о том, как системы искусственного интеллекта работают и принимают решения.

- Ответственное образование в области искусственного интеллекта: обучение специалистов в области искусственного интеллекта этике и ответственности.

Вопрос. Каковы примеры успешного использования ответственного ИИ?

А. Вот несколько успешных примеров использования ответственного ИИ:

- Диагностика здравоохранения: используется для улучшения медицинских результатов, обеспечивая справедливость и конфиденциальность пациентов.

- Финансовые услуги: способны устранить риски, связанные с мошенничеством и вредоносным ПО. Ответственные решения на основе искусственного интеллекта могут дополнительно защитить данные клиентов и обеспечить справедливое кредитование.

- Набор персонала: помогает уменьшить предвзятость, одновременно открывая путь к обеспечению разнообразия и равных возможностей среди пользователей.

- Автономные транспортные средства: помогают расставить приоритеты в вопросах безопасности и соблюдения этических стандартов.

Вопрос. Является ли ответственный ИИ постоянным процессом или компании могут внедрить его один раз и забыть о нем?

Ответ. Ответственный ИИ — это непрерывный процесс, требующий постоянного мониторинга, обновления и адаптации к меняющимся этическим стандартам и правилам. Поэтому рекомендуется сотрудничать со специализированной фирмой по разработке искусственного интеллекта, которая поможет вам осторожно путешествовать по водам.