Что такое техническое SEO?

Опубликовано: 2023-09-01Когда вы начнете изучать SEO, вы вскоре поймете, что существует множество различных аспектов, которые вам необходимо понять, чтобы добиться успеха.

От внутреннего SEO до внутреннего SEO и создания контента. Вам необходимо четко понимать все это, независимо от вашей конкретной роли в SEO, чтобы добиться рейтинга вашего сайта там, где он должен быть.

В этой статье мы рассмотрим техническое SEO. Вы узнаете, что это такое, почему это важно для веб-сайтов и особенности веб-сайта, хорошо оптимизированного с технической точки зрения.

Мы также дадим вам краткую информацию о том, как работает техническое SEO, от сканирования и индексирования до ранжирования, а также о том, что вам нужно, чтобы эти три шага работали вместе хорошо.

Изображение предоставлено: https://tsh.io/

Что такое техническое SEO?

Техническое SEO — это процесс оптимизации «закулисных» элементов веб-сайта для улучшения его производительности в поисковых системах, таких как Google и Bing. Этот процесс включает в себя такие шаги, как улучшение разметки и структуры веб-сайта, чтобы обеспечить легкое сканирование, индексацию и ранжирование (подробнее об этом мы поговорим позже) с помощью роботов поисковых систем, таких как Googlebot. Задачи включают в себя повышение скорости веб-сайта, создание простой и понятной архитектуры сайта, использование «SEO-дружественных» URL-адресов и применение разметки схемы для расширенных результатов поиска.

По сути, техническое SEO создает прочную базу, которая помогает поисковым системам повышать рейтинг веб-сайта. В конечном итоге это приведет к увеличению органического трафика и улучшению пользовательского опыта.

Думайте о своем веб-сайте как о хорошо организованной библиотеке. Техническое SEO — это этап аккуратного раскладывания книг по полкам с четкими тегами (ваша структура URL), установки знаков для плавной навигации (ваши внутренние ссылки) и создания гостеприимной атмосферы (скорость сайта). Когда библиотека упорядочена и привлекательна, больше посетителей могут найти нужные им книги (пользователи, обнаруживающие контент), а библиотекари (боты поисковых систем) могут классифицировать и предлагать книги (индексирование и ранжирование).

Почему техническое SEO важно?

Техническое SEO невероятно важно для подавляющего большинства веб-сайтов, поскольку оно формирует основу для видимости сайта в поисковых системах и общей производительности. Конечно, публикуемый вами контент имеет решающее значение, но отсутствие надлежащей технической оптимизации может помешать поисковым системам эффективно обнаруживать, индексировать и ранжировать этот контент.

Значение технического SEO можно резюмировать следующим образом:

Во-первых, это гарантирует, что поисковые системы смогут эффективно сканировать и индексировать ваш контент. Оптимизируя такие элементы, как структура и навигация вашего веб-сайта, техническое SEO способствует беспрепятственному сканированию вашего веб-сайта роботами поисковых систем. Эта доступность жизненно важна для обеспечения того, чтобы ваш контент был замечен и правильно проиндексирован.

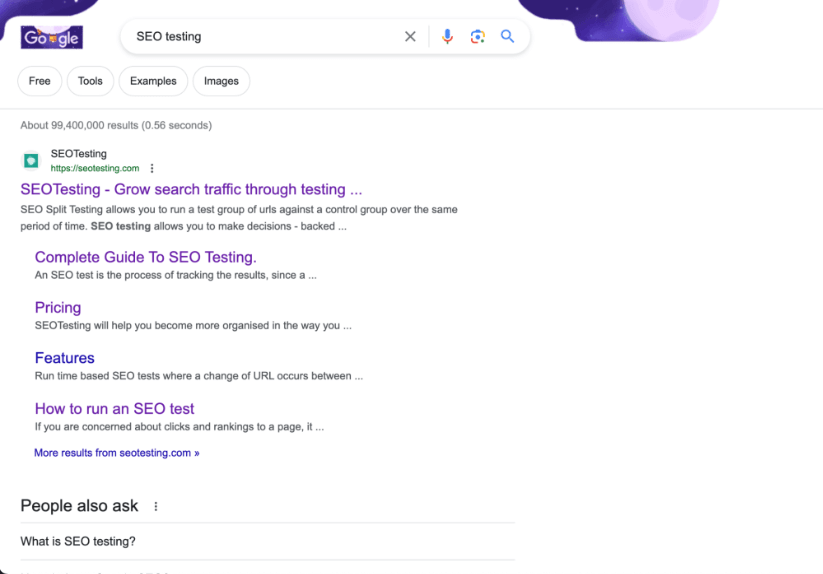

Возможно, мы немного предвзяты, но мы считаем, что наш веб-сайт является отличным примером сайта с великолепной архитектурой!

Во-вторых, техническое SEO напрямую влияет на ваш рейтинг в поисковых системах. Скорость веб-сайта и скорость реагирования на мобильные устройства являются подтвержденными факторами ранжирования в поисковом алгоритме Google, и, кроме того, наличие хорошо структурированной HTML-разметки играет жизненно важную роль в том, как поисковые системы оценивают качество и релевантность вашего веб-сайта. Хорошо оптимизированный веб-сайт имеет больше шансов занять более высокие позиции в поисковых системах.

Наконец, техническое SEO способствует тому, чтобы ваш сайт был удобным для пользователей. Пока вы работаете над техническим SEO, такие методы, как оптимизация времени загрузки страниц и улучшение URL-адресов, также повысят удовлетворенность пользователей. Улучшение пользовательского опыта приводит к снижению показателей отказов и повышению уровня вовлеченности, что косвенно улучшит эффективность вашего сайта в поиске.

В конечном счете, техническое SEO служит краеугольным камнем, на котором строятся эффективные стратегии SEO! Это гарантирует, что ваш контент не только первоклассный, но и легко находимый и доступный. Это понравится как поисковым системам, так и, что более важно, пользователям.

Каковы особенности технически оптимизированного веб-сайта?

Независимо от веб-сайта, будь то сайт электронной коммерции, приносящий миллионы фунтов дохода, или веб-сайт-брошюра, демонстрирующая услуги местной сантехнической компании, все веб-сайты имеют одинаковые характеристики, когда речь идет о хорошей оптимизации с технической точки зрения SEO. .

Это быстро

Хорошо оптимизированный веб-сайт будет быстро загружаться на всех устройствах (настольных компьютерах, планшетах и мобильных устройствах) и при любых сетевых условиях. Страницы с быстрой загрузкой улучшают впечатление пользователя от вашего сайта и пользуются популярностью у поисковых систем, что потенциально может привести к более высокому рейтингу.

Мы знаем, что Google указывает прохождение основных веб-тестов как подтвержденный фактор ранжирования, что для них является редкостью, поэтому обеспечение быстрой работы вашего веб-сайта и прохождения тестов CWV имеет решающее значение.

Это можно сканировать

Это должно быть несложно, но веб-сайты должны быть доступны для сканирования поисковыми системами. Если бот поисковой системы (например, Googlebot) не может эффективно сканировать ваш сайт, вы обнаружите проблемы с рейтингом вашей страницы в результатах поиска.

Файлы robots.txt и метатеги robots должны быть правильно настроены. Это поможет поисковым ботам указать, какие страницы сканировать и индексировать, а какие оставить в покое. Не каждая страница вашего сайта должна сканироваться. Особенно страницы администратора и страницы, содержащие данные клиентов.

Это сохраняет ссылочный капитал

Веб-сайты, которые технически хорошо оптимизированы, делают все возможное, чтобы сохранить как можно больше ссылочной массы.

Во-первых, на веб-сайте будут использоваться внутренние ссылки, которые направляют пользователей (и ботов поисковых систем) к соответствующему контенту сайта. Это улучшает навигацию по веб-сайту, помогает распределять ссылочную массу на другие страницы и дольше удерживает пользователей на веб-сайте.

Во-вторых, сайт будет полностью свободен (в идеале) от битых ссылок и ненужных цепочек редиректов. Это обеспечивает удобство взаимодействия с пользователем и эффективное сканирование поисковыми системами.

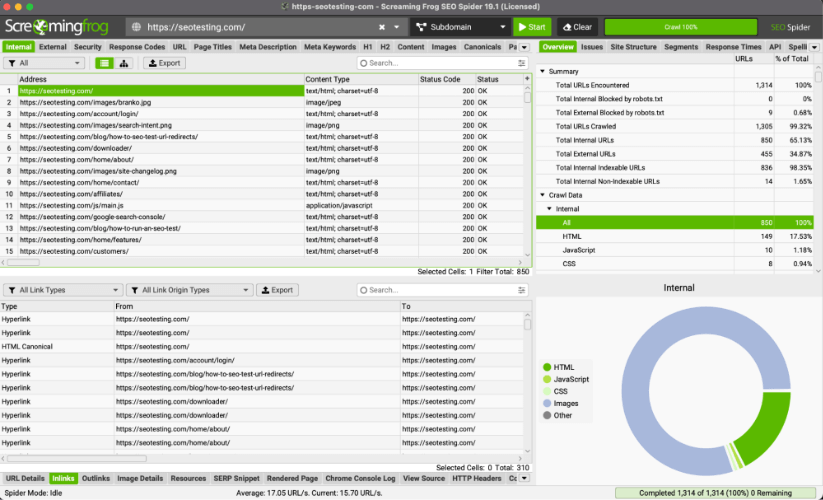

Совет для профессионалов: вы можете использовать ScreamingFrog для выявления неработающих ссылок и цепочек перенаправления, которых там быть не должно.

Это удобно для мобильных устройств

Все веб-сайты должны быть адаптивными и функциональными на мобильных устройствах. Учитывая постоянно растущее использование смартфонов для просмотра страниц (по состоянию на 2023 год 63% органического поискового трафика Google в США приходится на мобильные устройства), удобство для мобильных устройств становится решающим фактором как для пользовательского опыта, так и для рейтинга.

Это безопасно

Все веб-сайты должны обеспечить использование безопасного протокола HTTPS.

Это гарантирует, что на вашем веб-сайте установлено адекватное шифрование данных, и повысит доверие пользователей при использовании вашего веб-сайта. Это доверие особенно важно, когда на веб-сайтах передаются финансовые данные, например данные кредитной карты.

Google также подтвердил, что использование протокола HTTPS является фактором ранжирования. Мы не знаем, какой вес придает этому алгоритм, но можем предположить, что это более важный фактор при работе с веб-сайтами YMYL (Ваши деньги, ваша жизнь).

Он использует структурированные данные

Разметка схемы реализуется на веб-сайтах для предоставления дополнительного контекста содержимого. Это позволит поисковым системам отображать расширенные фрагменты в результатах поиска при показе вашего веб-сайта, повышая рейтинг кликов и привлекая больше трафика на ваш сайт.

Ползание

Мы кратко рассмотрели эту тему в нашей статье о том, как изучить SEO в 2023 году, а теперь пройдемся по четырем этапам технического SEO, которые выведут ваш веб-сайт со страниц HTML, CSS и JavaScript на позиции в поисковой выдаче. Сканирование, рендеринг, индексирование и ранжирование.

Первый шаг в этом путешествии — ползание.

Сканирование — это процесс, с помощью которого поисковые системы, такие как Google и Bing, систематически просматривают и изучают содержимое веб-сайтов в Интернете. Целью сканирования является сбор информации о веб-страницах, включая:

- Их содержание.

- Их структура.

- Другая важная информация.

Затем поисковые системы могут использовать эти данные для эффективной индексации и ранжирования (мы поговорим об этом позже) и отображения ваших веб-страниц в результатах поиска.

Поисковые системы используют ботов, называемых сканерами, для навигации по огромному количеству веб-страниц в Интернете. Сканеры начинают с посещения нескольких известных веб-страниц, часто популярных или часто обновляемых. Оттуда они переходят по ссылкам, найденным на этих страницах, чтобы «открыть» новые страницы, которые они затем могут отображать, индексировать и ранжировать.

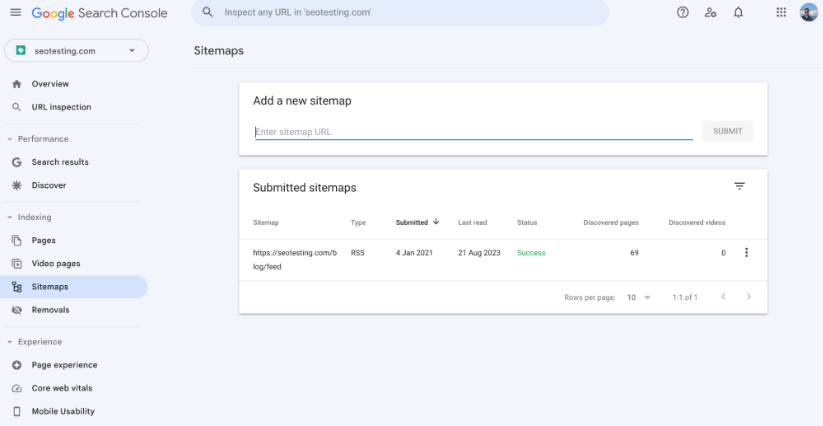

XML-карта сайта

Карта сайта XML — это файл, который предоставляет поисковым системам структурированный список всех URL-адресов вашего веб-сайта. Это инструмент, который помогает сканерам поисковых систем понять организацию контента вашего веб-сайта и гарантирует, что они смогут эффективно обнаруживать и индексировать все ваши важные страницы.

Наличие XML-карты сайта на вашем веб-сайте очень важно, когда дело касается технического SEO, поскольку оно помогает сканировать ваши страницы несколькими различными способами:

Наличие XML-карты сайта на вашем сайте предоставляет ботам поисковых систем централизованный список URL-адресов, которые вы хотели бы, чтобы они сканировали и индексировали. Это поможет вам гарантировать, что все ваши основные страницы, такие как страницы со списком продуктов и страницы отображения продуктов, включены в индексы поисковых систем и, возможно, в страницы результатов поисковых систем.

Вы также можете использовать карту сайта, чтобы указать приоритет и изменить частоту каждого URL-адреса на вашем сайте. Важно отметить, что поисковые системы могут не следовать этим правилам в точности, но это может дать сканерам представление о важности различных страниц вашего веб-сайта и о том, как часто они обновляются.

В то время как поисковые системы используют различные факторы, чтобы решить, какие страницы сканировать и индексировать в первую очередь, ваша карта сайта может помочь выделить важные (или недавно обновленные) страницы. Это может направить ботов поисковых систем на эти страницы и помочь быстро их сканировать и индексировать. Если бы у вас не было карты сайта, вы бы полагались на то, что сканеры будут автоматически находить эти страницы с помощью внутренних и внешних ссылок и т. д. Это гораздо более длительный процесс.

Большие сайты с сотнями тысяч (или даже миллионами URL-адресов) и картами сайта (и несколькими картами сайта) помогут сканерам более эффективно обнаруживать каждую страницу, которую вы хотите проиндексировать. Это отличная вещь, поскольку она помогает вам гораздо эффективнее управлять своим краулинговым бюджетом. Это не проблема для небольших веб-сайтов, поскольку у этих небольших сайтов не будет проблем с бюджетом сканирования.

Структура сайта

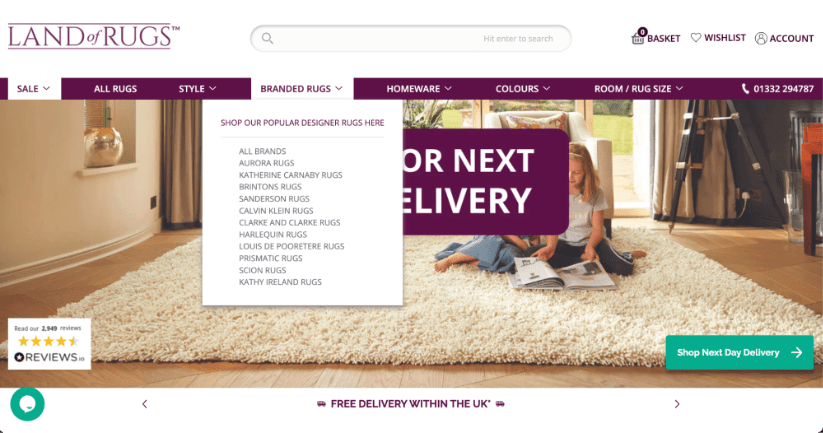

Структура вашего веб-сайта будет играть решающую роль в определении того, как роботы поисковых систем будут перемещаться и индексировать его контент. Хорошо организованная структура сайта не только облегчит эффективное сканирование поисковыми роботами, но и улучшит общее впечатление от вашего сайта для реальных пользователей.

Вот пример сайта электронной коммерции с хорошей структурой сайта. Ко всем важным страницам (страницам со списком продуктов) в этом примере легко получить доступ из панели навигации домашней страницы, что позволяет передать на эти страницы как можно больше ссылочной массы и гарантировать, что сканеры смогут легко их найти.

Когда страницы организованы в простые, понятные категории и подкатегории, сканерам становится намного проще переходить по ссылкам и систематически индексировать контент. Такое иерархическое расположение гарантирует, что важные страницы располагаются ближе к главной странице, что повышает их шансы на быстрое обнаружение и индексацию.

Внутренние ссылки в структуре веб-сайта будут более эффективно направлять сканеров поисковых систем по различным разделам вашего сайта. Хорошо расположенные и релевантные внутренние ссылки помогают распределять ссылочную массу между страницами, позволяя сканерам обнаруживать гораздо более широкий спектр контента, чем они могли бы без размещения внутренних ссылок по всему контенту.

Страницы-сироты (страницы, на которые нет ссылок) следует избегать, поскольку они представляют собой огромную проблему для сканеров. Надежная структура сайта с правильными внутренними ссылками позволяет избежать этого.

В целом структура вашего веб-сайта будет служить важной основой, определяющей, как поисковые системы сканируют и индексируют ваш контент. Внедряя четкую иерархию сайтов, добавляя соответствующие контекстные ссылки и оптимизируя распределение бюджета сканирования (при необходимости), владельцы веб-сайтов и маркетологи могут положительно влиять на то, как поисковые системы сканируют их веб-сайты.

Структура URL

Структура URL-адреса вашего веб-сайта будет иметь прямое влияние на сканирование вашего веб-сайта. Наличие хорошо организованной (и описательной) структуры URL-адресов повысит эффективность сканеров при понимании содержимого каждой страницы. Четкие (и короткие) URL-адреса предоставляют ценный контекст темы и иерархии расположения страниц на веб-сайте.

Например, URL-адрес вида https://example.com/blog/head-topic-1 сообщит сканеру поисковой системы, что эта страница является важной страницей в блоге, посвященной одной из ключевых тем веб-сайта.

С другой стороны, запутанные или бессмысленные URL-адреса (хороший пример — https://example.com/12642/test-category/test-page125253/) могут сбить с толку сканеров при навигации по вашему сайту. Это помешает им интерпретировать контент, а также релевантности и важности страницы вашего сайта. Чистая структура URL-адресов без ненужных параметров и символов повысит вероятность эффективного сканирования ваших страниц.

Кроме того, структура вашего URL-адреса, хотя и не имеет прямого отношения к сканированию, будет иметь прямое влияние на удобство использования вашего веб-сайта и рейтинг кликов. Краткий и релевантный URL-адрес с гораздо большей вероятностью привлечет пользовательские клики в результатах поиска, что может (косвенно) повлиять на общий рейтинг вашего сайта в поисковых системах.

Файлы robots.txt

Ваш файл robots.txt имеет огромную власть над тем, как поисковые системы перемещаются и сканируют ваш сайт. Этот документ, расположенный в основе вашего сайта, содержит подробные рекомендации для сканеров поисковых систем, определяющие, как следует сканировать ваш сайт. В том числе, какие страницы можно сканировать, а какие следует оставить в покое.

На этом этапе стоит отметить, что, хотя ваш файл robots.txt может блокировать доступ сканеров к определенным страницам или разделам вашего веб-сайта, он не гарантирует, что ваши страницы не будут сканироваться альтернативными способами. Некоторые поисковые системы по-прежнему могут регистрировать страницы, исключенные из сканирования, если они найдены другими способами, например, по внутренним ссылкам на вашем сайте.

Если ваш файл robots.txt полон ошибок или жестких правил, вы можете обнаружить, что это мешает поисковым системам сканировать важный контент, что может «бросить тень» на эффективность вашего сайта в результатах поиска. Важно регулярно следить за файлом robots.txt, чтобы убедиться, что все правила работают правильно.

Анализ файла журнала

Анализ файлов журналов вашего веб-сайта может оказать огромное влияние на то, как поисковые системы сканируют ваш веб-сайт, и это то, что маркетологи могут сделать сами, используя правильные инструменты! Файлы журналов, по сути, представляют собой записи, которые показывают, какие части вашего веб-сайта посещают поисковые системы и как часто сканеры поисковых систем посещают эти части вашего веб-сайта. По сути, это позволяет вам определить, какие страницы вашего веб-сайта считаются важными для поисковых систем, что позволяет вам использовать это для получения преимущества.

Это помогает маркетологам решить, на какие страницы стоит потратить больше времени (и, возможно, денег), гарантируя, что поисковые системы обращают внимание на правильные вещи. Кроме того, анализ файла журнала может показать, считают ли поисковые системы ваш веб-сайт простым для понимания и навигации или у них возникли проблемы. Это может способствовать изменениям, например, исправлению способа соединения страниц (обычно посредством внутренних ссылок) или лучшей организации веб-адресов.

Одно из моих любимых выступлений на эту тему принадлежит Мэтью Барби, сделанному еще в 2018 году, когда он был вице-президентом по органическому росту в HubSpot. Точный фрагмент выступления можно найти на 25:07:

Рендеринг

Рендеринг — это процесс того, как поисковые системы анализируют и понимают содержание и структуру вашего веб-сайта, чтобы определить его рейтинг в результатах поиска. Этот процесс включает в себя два основных этапа: сканирование (о котором мы уже говорили) и индексирование (о котором мы скоро поговорим).

Во время сканирования боты поисковых систем перемещаются по сети, посещая веб-страницы и собирая данные HTML. Однако не весь контент сразу виден в разметке HTML. Здесь в игру вступает рендеринг.

Рендеринг выходит за рамки базового анализа HTML и учитывает динамические элементы, часто присутствующие на современных веб-сайтах, которые могут быть не видны в необработанном HTML. Сюда входит контент, загруженный с помощью JavaScript, AJAX или других языков сценариев, а также таблица стилей CSS страницы. Боты поисковых систем, пытаясь имитировать взаимодействие с пользователем, выполняют JavaScript и собирают полностью визуализированный контент. Этот контент затем используется для создания индекса — базы данных информации о веб-странице.

Для достижения оптимальных результатов SEO крайне важно убедиться, что ваш сайт легко отображается роботами поисковых систем. Это предполагает использование таких методов, как рендеринг на стороне сервера (SSR) или предварительный рендеринг для веб-сайтов с большим количеством JavaScript. Предоставление метаданных (например, метатегов и описаний) поможет поисковым системам понять контекст и значение контента. Правильная обработка канонических тегов и управление перенаправлениями также важны для предотвращения проблем с дублированием контента.

Индексирование

Индексирование — это процесс сбора, организации и хранения информации о веб-страницах, чтобы ее можно было быстро получить и отобразить в результатах поиска, когда пользователь выполняет поиск по соответствующему запросу. После того как поисковый робот просканировал веб-страницу и отобразил ее содержимое, информация добавляется в индекс поисковой системы.

Индекс, по сути, представляет собой огромную базу данных, содержащую информацию о содержимом веб-сайта и структуре веб-страниц в Интернете. Доступ к этой обширной базе данных позволяет поисковым системам быстро реагировать на запросы пользователей, находя соответствующие страницы из индекса и отображая их в результатах поиска.

В процессе индексации поисковые системы извлекают ключевую информацию из просканированных и отображаемых веб-страниц, такую как контент, метаданные, изображения и ссылки. Затем эта информация сохраняется в структурированном виде, что позволяет поисковым системам быстро сопоставлять запросы пользователей с соответствующими страницами.

Есть несколько вещей, которые вам следует сделать, чтобы обеспечить эффективную индексацию ваших страниц.

Решение проблем дублирования контента и каннибализации ключевых слов

Решение проблем дублирования контента и каннибализации ключевых слов даст значительные преимущества, когда дело доходит до быстрой индексации ваших страниц.

Избавившись от дублированного контента, вы предотвратите путаницу для поисковых систем и сможете точно определить основную версию вашего контента.

Более того, решение проблем каннибализации ключевых слов, когда несколько страниц ориентированы на одни и те же ключевые слова, дает поисковым системам четкие сигналы о фокусе каждой страницы. Эта ясность помогает эффективно индексировать и ранжировать, поскольку поисковые системы могут понять точную цель всех ваших страниц.

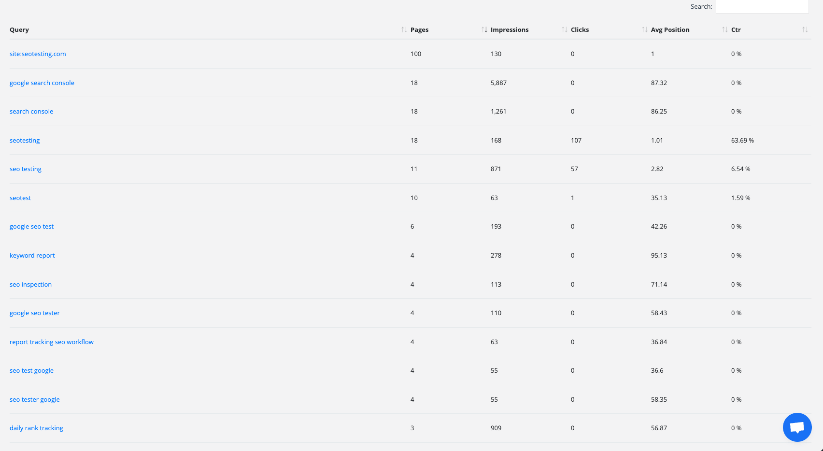

Изображение, показывающее отчет о каннибализации ключевых слов в рамках SEOTesting. Этот отчет может помочь вам быстро выявить и устранить любые проблемы каннибализации ключевых слов на вашем веб-сайте.

Оптимизация метаданных (таких как теги заголовков и метаописания), а также настройка внутренних структур ссылок также помогут ускорить и упростить индексацию. Эти действия, если они выполнены правильно, направляют поисковые системы на наиболее релевантные и важные страницы.

Кроме того, консолидация контента и избежание каннибализации ключевых слов сконцентрируют авторитет вашего контента на одной странице. Это приведет к повышению авторитета страницы, побуждая поисковые системы расставлять приоритеты и занимать более видное место этой авторитетной страницы в результатах поиска.

Аудит перенаправлений

Изучение того, как работают перенаправления вашего веб-сайта, может помочь улучшить скорость индексации вашего контента поисковыми системами. Это также может помочь повысить общую производительность вашего сайта. Перенаправления действуют как рынки, направляя как пользователей, так и поисковые системы на разные страницы, когда это необходимо. Если ими не управлять должным образом, они могут замедлить процесс индексации или вообще остановить индексацию страниц. Выполняя «аудит перенаправления», вы можете улучшить индексацию несколькими значимыми способами.

Во-первых, устранение чрезмерных перенаправлений поможет поисковым системам работать более эффективно при индексировании вашего веб-сайта. Иногда они могут столкнуться с несколькими перенаправлениями, которые могут замедлить индексацию вашего контента. Находя и удаляя ненужные перенаправления, вы можете помочь поисковым системам быстро получить доступ к вашему контенту, давая им больше шансов на быструю индексацию (и, следовательно, ранжирование).

Завершение аудита перенаправления также позволит вам решить распространенную техническую проблему SEO. Цепочки перенаправления. Такие цепочки могут возникать, когда один редирект ведет к другому, который ведет к другому, который ведет к другому и так далее. Они могут запутать поисковые системы и отнять у них слишком много времени. Мы знаем, что когда бот поисковой системы слишком долго пытается проиндексировать страницу, он перейдет дальше и не проиндексирует эту страницу. Аудит позволит вам найти и исправить эти цепочки, что позволит поисковым системам без проблем получить доступ к вашему контенту.

Наконец, подобный аудит поможет поисковым системам точно понять ваш сайт. Когда перенаправления хорошо структурированы, поисковые системы могут лучше интерпретировать важность вашего контента. Когда поисковые системы лучше понимают важность вашего контента, ваши важные страницы имеют больше шансов на быструю индексацию.

Исправить ошибки HTTP и HTTPS

Исправление ошибок HTTP и HTTPS жизненно важно для обеспечения правильной индексации ваших страниц. Когда боты поисковых систем сталкиваются с ошибками такого типа, им трудно получить доступ к вашему контенту и понять его. Если бот поисковой системы не может получить доступ к вашему контенту или понять его, он не сможет его проиндексировать.

Решение этих проблем улучшает индексацию следующими способами:

Во-первых, устранение ошибок HTTP, таких как «404 Not Found», гарантирует, что ваши страницы будут доступны как пользователям, так и поисковым системам. Когда страницы возвращают эти ошибки, поисковые системы интерпретируют их как отсутствующий контент, что приводит к исключению из результатов поиска. Исправление этих ошибок дает сканерам «ясный путь» для индексации вашего контента, увеличивая шансы на его индексацию и ранжирование.

Во-вторых, переход с HTTP на HTTPS имеет решающее значение для безопасности и индексации. В своих алгоритмах ранжирования поисковые системы отдают приоритет безопасным веб-сайтам (HTTPS) над незащищенными веб-сайтами (HTTP). Гугл это даже подтвердил! Перейдя на HTTPS и обеспечив пользователям безопасный просмотр, вы повысите доверие к своему сайту, косвенно улучшив его способность индексироваться и ранжироваться.

Наконец, последовательная реализация HTTPS и устранение ошибок, связанных с HTTPS, не позволяют пользователям и поисковым системам сталкиваться с проблемами «смешанного контента». Смешанное содержимое возникает, когда безопасные и незащищенные элементы загружаются на одну и ту же страницу. Это потенциально может привести к появлению предупреждений безопасности и отрицательно повлиять на взаимодействие с пользователем.

По сути, устранение ошибок HTTP и HTTPS устраняет барьеры, которые мешают поисковым системам получить доступ к вашему контенту и понять его. Этот высокоактивный подход оптимизирует процесс индексации, повышает видимость в результатах поиска и повышает удобство использования вашего сайта.

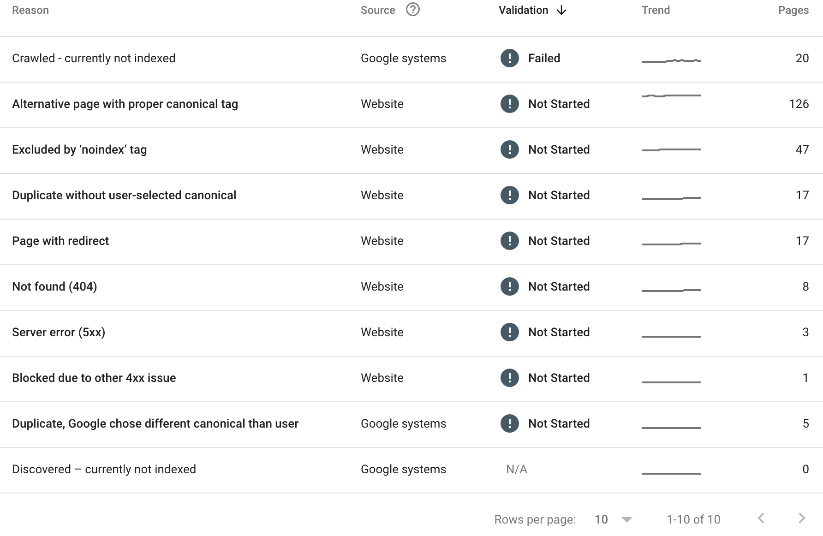

Посмотрите свой «Отчет об индексировании страниц» в консоли поиска Google.

Консоль поиска Google — это золотая жила для оценки того, как индексируется ваш контент. В отчете об индексировании страниц вы сможете увидеть каждую страницу вашего сайта, которая не была проиндексирована. Вы также сможете увидеть причину, по которой страница не проиндексирована.

Вот пример:

В приведенном выше отчете об индексировании страниц SEOTesting мы видим, что:

- 20 страниц просканированы, но в настоящее время не проиндексированы.

- 126 страниц имеют правильный канонический тег.

- 47 страниц были исключены по тегу noindex.

- Обнаружено, что 17 страниц являются дубликатами, без выбранных пользователем канонических страниц.

- На 17 страницах установлен редирект.

- 8 страниц вернули ошибку 404.

- 3 страницы вернули ошибку сервера 5xx.

- 1 страница заблокирована из-за другой проблемы с 4xx.

- 5 страниц оказались дубликатами, и Google выбрал другую канонику.

Не все из вышеперечисленных причин являются проблемами, но нам, как маркетинговой команде, стоит выяснить, почему определенные страницы не были проиндексированы, и исправить как можно больше из этих проблем.

Рейтинг

Рейтинг в поисковых системах — это кульминация процессов сканирования, рендеринга и индексирования, при которых поисковые системы определяют порядок, в котором веб-страницы появляются в результатах поиска. Цель — предоставить пользователям наиболее релевантный и ценный контент на основе их поисковых запросов.

По своей сути ранжирование опирается на сложные алгоритмы, которые оценивают множество факторов для определения релевантности и авторитетности веб-страницы. Одним из фундаментальных аспектов является релевантность ключевых слов — насколько хорошо контент соответствует словам и фразам, которые пользователи вводят в поиск. Страницы с высокой релевантностью ключевых слов, как правило, имеют более высокий рейтинг.

Однако одной лишь релевантности ключевых слов недостаточно. Поисковые системы также учитывают качество и авторитетность сайта. Обратные ссылки с авторитетных, авторитетных и актуальных (это очень важно) сайтов являются сильным индикатором надежности страницы. Чем больше качественных обратных ссылок имеет страница, тем больше вероятность, что она получит более высокий рейтинг.

Опыт пользователей на вашем сайте также играет огромную роль в рейтинге. Страницы, которые загружаются быстро, удобны для мобильных устройств и обеспечивают удобство просмотра для пользователя, пользуются большой популярностью у поисковых систем. Привлекательный и ценный контент, который удерживает пользователей на вашем сайте и позволяет просматривать его дольше, также сигнализирует поисковым системам о том, что ваш сайт, возможно, заслуживает более высокого рейтинга.

Персонализация — еще один аспект ранжирования. Поисковые системы будут учитывать местоположение пользователя, историю поиска и предпочтения для адаптации результатов поиска, чтобы предоставить пользователю наилучшие впечатления. Это означает, что один и тот же запрос, скорее всего, даст разные результаты для разных пользователей.

Важно помнить, что независимо от того, что упоминается в других сообщениях в блогах, мы не знаем, какой вес Google (и другие поисковые системы) придают различным факторам для разных запросов. В одном вопросе вам, возможно, придется больше полагаться на авторитетные и релевантные обратные ссылки. С другой стороны, вам может потребоваться убедиться, что ваш пользовательский опыт на высоте. Все сводится к времени, проведенному в отрасли, изучению алгоритма и его совершенствованию по мере продвижения.

Понимание различных аспектов SEO жизненно важно для успеха в поисковой выдаче. В этой статье рассматривается важность технического SEO, особенности оптимизированных сайтов и механизм технического SEO от сканирования до ранжирования.

Техническое SEO создает прочную основу для вашего веб-сайта, оптимизируя элементы для повышения скорости и структуры. Это улучшает навигацию, понимание контента и удобство использования.

Короче говоря, техническое SEO является ключевым моментом. Исправив ошибки и оптимизировав структуру сайта, вы сможете улучшить свое присутствие в Интернете.

Хотите расширить возможности использования Google Search Console и вывести SEO на новый уровень, внедрив SEO-тестирование в свою повседневную жизнь? Попробуйте SEO-тестирование. В настоящее время мы проводим 14-дневную бесплатную пробную версию, для регистрации не требуется кредитная карта. Попробуйте этот инструмент сегодня и дайте нам знать, что вы думаете!