Истинная стоимость создания собственного веб-краулера

Опубликовано: 2023-08-09Веб-скрапинг стал наиболее распространенным способом сбора данных из нескольких источников и извлечения важной информации из Интернета. Этот процесс используется для предоставления решений с поддержкой данных для всего, от сопоставления цен на веб-сайтах электронной коммерции до принятия решений на фондовом рынке. С ростом спроса на сбор данных из Интернета инструменты и сервисы, облегчающие сбор данных из Интернета, также заполонили Интернет. Однако все они относятся к одной из 3 подкатегорий:

- Создание собственного инструмента для парсинга веб-страниц с использованием таких библиотек, как BeautifulSoup, на Python и его развертывание в облачной службе, такой как AWS.

- Использование полуавтоматического программного обеспечения для очистки, которое можно использовать для захвата частей экрана. Для первоначальной настройки требуется некоторое вмешательство человека, но повторяющиеся задачи можно автоматизировать. Однако степень автоматизации ограничена, продукт или бизнес-группа могут столкнуться с крутой кривой обучения использованию инструмента, и не все веб-сайты можно очистить с помощью этих инструментов. Вы столкнетесь с дополнительными трудностями при работе с веб-сайтами, которые генерируют динамический контент с использованием таких технологий, как javascript.

- Поставщики DaaS, такие как PromptCloud, предоставляют вам настраиваемый поток данных на основе веб-сайтов и точек данных, которые вы отправляете в качестве требований. Эти службы обычно взимают плату в зависимости от объема данных, которые вы потребляете, поэтому ваш ежемесячный счет зависит только от объема очищенных данных и подходит для компаний любого размера.

Теперь многие компании могут решить, что затраты, связанные с пунктами b или c, слишком высоки, и решить самостоятельно создать поисковый робот. Почему нет? Просто погуглите «Как создать поисковый робот?» даст вам сотни результатов. Некоторые из них могут даже подойти для вашего варианта использования. Но какова реальная стоимость создания поискового робота корпоративного класса, его развертывания в облаке, а также его поддержки и обновления с течением времени? Давай выясним.

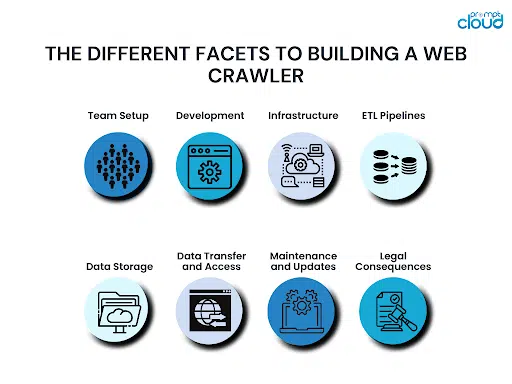

Различные аспекты создания веб-краулера

При создании поискового робота необходимо помнить о различных аспектах. Если вы не учтете все это, вы можете откусить больше, чем сможете прожевать. В конечном итоге это обойдется вам слишком дорого еще до того, как вы доберетесь до финишной черты, и тогда вы застрянете между тем, продолжать или отказаться от этого.

Настройка команды:

Основными требованиями для создания поискового робота будут знания в области программирования и предыдущий опыт создания поискового робота. Даже если у вас есть техническая команда, вам может не хватать кого-то с предыдущими знаниями, чтобы возглавить группу. Без кого-то с опытом вы можете в конечном итоге совершать критические ошибки и не осознавать их, пока не станет слишком поздно.

Разработка:

Когда у вас есть готовая команда, они должны приступить к разработке вашего поискового робота. Этот сканер должен иметь возможность сканировать все точки данных, необходимые для всех веб-сайтов в вашем списке. Следовательно, потребуется значительное время не только для создания сканера, но и для тестирования пограничных случаев и обеспечения того, чтобы он не сломался в любой момент. В зависимости от того, насколько велика и опытна ваша команда, создание нового поискового робота с нуля может занять от нескольких месяцев до нескольких кварталов.

Инфраструктура:

Создать идеальный поисковый робот сложно. Еще сложнее принять решение об облачной инфраструктуре с длительным временем безотказной работы, которая также будет оптимизирована по стоимости. Ваша инфраструктура также должна быть масштабируемой, чтобы ее можно было масштабировать по мере роста вашего бизнеса и когда вам нужно собирать данные из большего количества источников.

ETL-конвейеры:

Может быть недостаточно извлечения нужных вам точек данных с выбранных вами веб-сайтов. Обычно данные также необходимо нормализовать, отформатировать, очистить и отсортировать, прежде чем они будут сохранены на носителе. Все это потребует большей вычислительной мощности. Поскольку эти конвейеры добавят задержку в потоке данных, крайне важно получить правильную инфраструктуру для настройки конвейеров ETL в облаке.

Хранилище данных:

После того, как ваши данные будут очищены, очищены и готовы, вам нужно будет поместить их на подходящий носитель для хранения. Это может быть база данных SQL или NoSQL. Это также может быть решение для хранения данных, такое как Redshift. Выбор базы данных будет зависеть от того, сколько данных вы хотите хранить, как часто вы хотите обновлять или извлекать данные, может ли количество столбцов измениться в будущем и многое другое. Как и остальные ресурсы, база данных также должна быть размещена в облаке, поэтому необходимо учитывать и цену.

Передача данных и доступ:

Теперь, когда вы собрали данные и сохранили их в базе данных, вы можете захотеть получать их через определенные промежутки времени или даже постоянно. Вы можете создавать REST API, чтобы предоставить внешнему миру доступ к вашим данным. Создание и поддержка уровня доступа к данным потребует времени, и с вас будет взиматься плата в зависимости от объема передаваемых данных.

Обслуживание и обновления:

Поисковый робот никогда не бывает окончательным. Это просто версия. Более новая версия должна быть создана, как только любой веб-сайт, с которого он собирает данные, будет изменен или обновлен. Добавление сложных веб-сайтов в список веб-сайтов для очистки может также потребовать обновления вашего поискового робота. Регулярное обслуживание и мониторинг ваших облачных ресурсов также жизненно важны для предотвращения появления ошибок в системе и работоспособности ваших облачных вычислительных ресурсов.

Правовые последствия:

Собирая данные из Интернета, вы должны придерживаться определенных законов страны. Это могут быть законы о защите данных страны, в которой вы работаете, а также законы стран, чьи данные вы очищаете. Любые ошибки могут означать дорогостоящие судебные процессы. Иногда выплаты, расчеты или судебные издержки достаточно хороши, чтобы разорить компанию.

Лучшее решение для парсинга веб-страниц корпоративного уровня

Самая большая стоимость, которую вы платите за создание собственного решения для веб-скрейпинга, — это даже не деньги. Пришло время — ваш бизнес должен ждать, пока решение будет готово и запущено, будут добавлены новые источники и т.д. Вместо этого будет разумным выбором полнофункциональное решение DaaS, которое предоставит вам чистые, готовые к использованию данные и простые варианты интеграции. Вот почему наша команда в PromptCloud предоставляет нашим пользователям полностью управляемые решения для парсинга веб-страниц, размещенные в облаке.

Вы можете начать использовать данные из любого места в Интернете, выполнив всего 3 шага, в ходе которых вы предоставляете нам список веб-сайтов и точек данных, проверяете результаты демо-краулера, а затем переходите к окончательной интеграции. Поскольку это облачное решение, мы взимаем плату только в зависимости от объема потребляемых вами данных, поэтому решение доступно для компаний любого размера. Выполнение подробного расчета покажет вам, как вы на самом деле экономите деньги при переходе на управляемое решение DaaS по сравнению с созданием собственного поискового робота.

Для получения более подробной информации свяжитесь с нашим отделом продаж по адресу sales@promptcloud.com .