Какие технологии используют поисковые системы для сканирования веб-сайтов?

Опубликовано: 2023-03-02

Если вы когда-нибудь задумывались над тем, какие технологии используют поисковые системы для сканирования веб-сайтов, приготовьтесь наконец получить ответы на свои вопросы. Вы узнаете, что такое поисковые роботы, сколько различных типов поисковых роботов используются основными поисковыми системами, и что представляет собой процесс индексации поиска. Вы также узнаете, как все это повлияет на результаты поисковых систем и как владельцы веб-сайтов могут указать поисковым роботам индексировать контент в соответствии с их пожеланиями. Давайте узнаем больше об этой технологии, которую поисковые системы используют для точного предоставления миллиардов релевантных результатов поиска людям, которые ищут информацию во всемирной паутине.

Что такое веб-сканеры или поисковые роботы?

Боты-сканеры, также известные как пауки, представляют собой автоматизированные программы, которые такие компании, как Google и Microsoft, используют для обучения своих поисковых систем тому, что присутствует на каждой доступной веб-странице каждого веб-сайта, который они могут найти в Интернете. Только узнав, какая информация содержится на веб-странице, эти поисковые системы могут точно получить эту информацию, когда один из их пользователей вводит поисковый запрос, запрашивающий информацию по определенной теме.

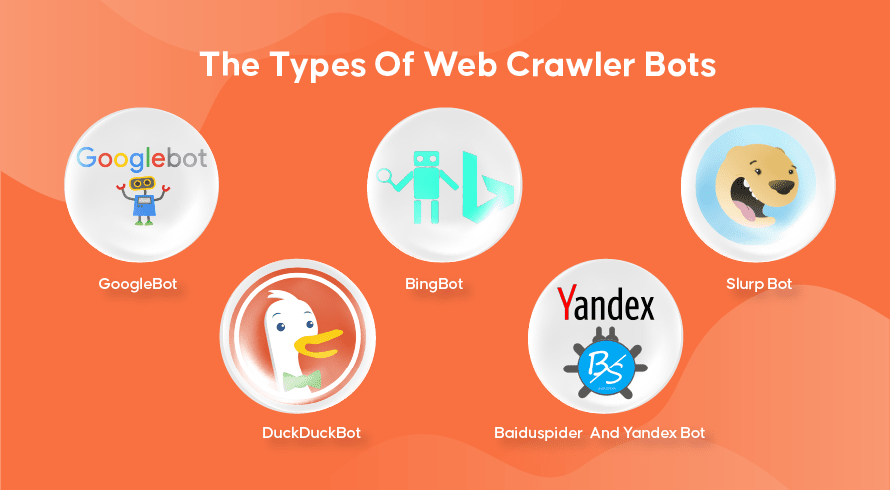

Типы поисковых роботов

У каждой поисковой системы есть свои поисковые роботы. Вот некоторые из наиболее широко используемых.

GoogleBot

Google является самой популярной поисковой системой на планете и использует две версии поисковых роботов для индексации сотен миллиардов веб-страниц. GoogleBot Desktop будет просматривать страницы, имитирующие поведение человека, использующего настольный компьютер для работы в Интернете, в то время как GoogleBot Mobile будет делать то же самое для пользователей смартфонов.

GoogleBot — один из самых эффективных типов поисковых ботов, когда-либо созданных, он может быстро сканировать и индексировать веб-страницы. Однако у него есть некоторые проблемы со сканированием очень сложных структур веб-сайтов. Кроме того, роботу GoogleBot может потребоваться много дней или недель, чтобы просканировать недавно опубликованную веб-страницу, а это означает, что она некоторое время не будет отображаться в релевантных результатах.

Бингбот

Bingbot — это ответ Microsoft на их собственную поисковую систему Bing. Это работает аналогично поисковому роботу Google и даже включает инструмент выборки, который указывает, как бот будет сканировать страницу, позволяя вам увидеть, есть ли здесь какие-либо проблемы.

Сларп-бот

Slurp Bot — это поисковый робот, используемый Yahoo, хотя они также используют Bingbot для доставки результатов своей поисковой системы. Владелец веб-сайта должен разрешить доступ Slurp Bot, если он хочет, чтобы содержимое его веб-страницы отображалось в результатах поиска Yahoo Mobile. Кроме того, Slurp Bot также может получить доступ к партнерским сайтам Yahoo для добавления контента на их веб-сайты Yahoo News, Yahoo Sports и Yahoo Finance.

УткаУткаБот

Это веб-сканер, используемый DuckDuckGo, поисковой системой, известной тем, что обеспечивает непревзойденный уровень конфиденциальности для своих пользователей, не отслеживая их действия, как это делают многие популярные. Они предоставляют результаты поиска, полученные с их DuckDuckBot, а также с краудсорсинговых веб-сайтов, таких как Wikipedia и других поисковых систем.

Baiduspider и бот Яндекса

Это поисковые роботы, используемые поисковыми системами Baidu из Китая и Яндексом из России соответственно. Baidu принадлежит более 80% рынка поисковых систем материкового Китая.

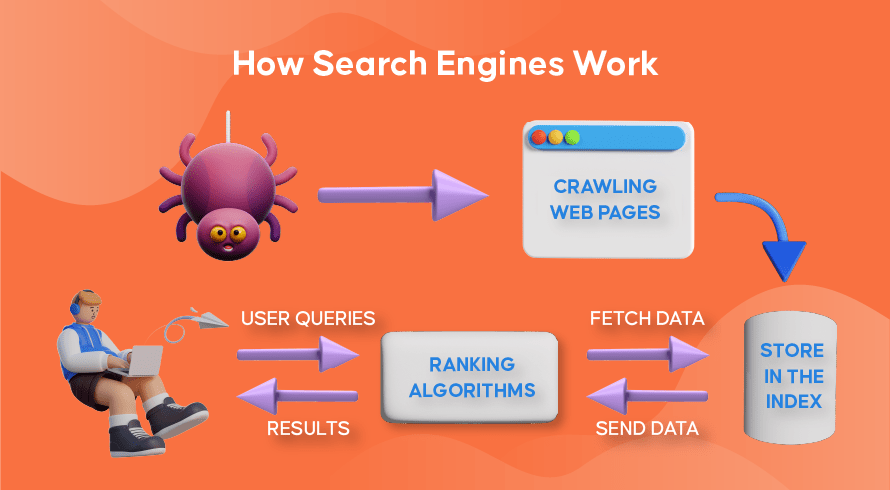

Как работает веб-сканирование, поисковая индексация и ранжирование в поисковых системах

Теперь давайте рассмотрим, как большинство поисковых систем используют поисковые роботы для поиска, хранения, систематизации и извлечения информации, содержащейся на веб-сайтах.

Как работают поисковые роботы

Процесс поиска как нового, так и обновленного контента на веб-сайтах называется «веб-сканированием», отсюда и название программ, выполняющих эту функцию. Боты сначала начнут сканировать несколько веб-страниц, найдут их содержимое, а затем перейдут по гиперссылкам, включенным в эту веб-страницу, чтобы обнаружить новые URL-адреса, ведущие к еще большему содержанию.

Как работает поисковая индексация

После того, как боты обнаруживают новый или обновленный контент посредством веб-сканирования, все, что они находят, добавляется в огромную базу данных, называемую «индексом поисковой системы». Это похоже на библиотеку, где книги похожи на веб-страницы, организованные таким образом, чтобы их можно было легко найти позже. Содержит в каждой книге большую часть текста, содержащегося на веб-странице, которую мы видим (за исключением таких слов, как «а», «ан» и «то»), а также метаданные, которые видят только поисковые роботы. Метаданные — это то, что поисковые системы используют для понимания содержимого веб-страницы. Мета-заголовок и мета-описание являются примерами метаданных.

Как работает ранжирование в поиске

Всякий раз, когда пользователь вводит поисковый запрос, соответствующая поисковая система проверяет его индекс, находит наиболее релевантную информацию, соответствующую этому запросу, организует список веб-ссылок, содержащих соответствующий контент, и представляет его пользователю в поисковой системе. страницы результатов (SERP).

Такая организация SERP называется «поисковым рейтингом» и выполняется алгоритмом поиска, который учитывает собранные данные, включая метаданные, надежность веб-сайта (авторитет), а также ключевые слова и ссылки. Веб-сайты, которые считаются очень надежными источниками и содержат релевантный контент, который будет полезен пользователям, будут иметь высокий рейтинг, получая самые высокие результаты в поисковой выдаче. Вот почему у каждого владельца веб-сайта есть стратегии для ранжирования своего веб-сайта в поисковой выдаче.

Как поисковая оптимизация (SEO) входит в картину

Владельцы веб-сайтов могут оптимизировать содержимое своих страниц таким образом, чтобы поисковые системы легче распознавали их как релевантные и полезные для своих пользователей. Это поднимет эти страницы на вершину поисковой выдачи, привлекая больше органического трафика на сайт. Стратегическое включение релевантных ключевых слов в копию страницы, создание ссылок и использование оригинальных изображений и видео — вот некоторые из способов использования методов SEO.

Кроме того, веб-сайты также могут использовать различные инструменты, такие как SEMrush, для поиска и устранения различных проблем на своих страницах, таких как неработающие ссылки, что еще больше улучшит их рейтинг в глазах поисковых систем.

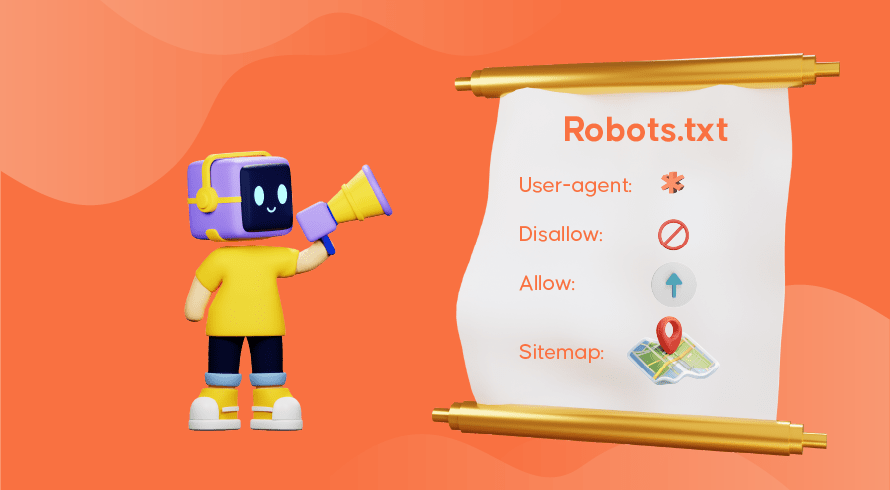

Расскажите поисковым системам, как сканировать ваш сайт

Иногда вы обнаружите, что поисковые роботы неадекватно выполняют свою функцию, в результате чего важные страницы вашего веб-сайта отсутствуют в индексе. Это означает, что релевантные поисковые запросы не будут представлены вместе с вашим контентом, что затрудняет поиск потенциальных клиентов на ваших страницах. К счастью, есть способы связи с поисковыми системами, позволяющие немного контролировать, что индексируется, а что игнорируется.

Файл robots.txt, хранящийся в корневом каталоге вашего веб-сайта, сообщает поисковым роботам, какие страницы вы хотите сканировать, какие игнорировать и как устроена архитектура вашего веб-сайта. Вы можете запретить индексацию определенных страниц, если они используются для тестирования, или специальные рекламные акции и повторяющиеся URL-адреса, используемые в электронной коммерции.

Например, робот GoogleBot продолжит сканирование веб-сайта в полном объеме, даже если файл robots.txt отсутствует. Обнаружив ваш файл robots.txt, робот GoogleBot будет следовать вашим инструкциям при сканировании. Если у него возникают проблемы с обнаружением файла или возникает ошибка, он может не сканировать ваш веб-сайт. Вы должны правильно использовать файл robots.txt, организовать архитектуру своего веб-сайта и использовать передовые методы SEO на странице, чтобы избежать проблем со сканированием. Вы можете выполнить аудит веб-сайта, чтобы проанализировать и выявить любые проблемы, которые беспокоят ваш веб-сайт.

Нужны услуги SEO для вашего сайта?

Если вы ищете поставщика услуг, который понимает, как поисковые роботы и поисковая индексация работают для повышения рейтинга вашего веб-сайта, то Inquivix — это SEO-партнер, которого вы искали. Мы предоставляем полный набор услуг SEO на странице от создания контента до оптимизации архитектуры сайта и анализа производительности веб-сайта, чтобы постоянно улучшать качество вашего веб-сайта. Чтобы узнать больше, посетите SEO-услуги Inquivix уже сегодня!

Часто задаваемые вопросы

Поисковые системы используют программы, называемые «веб-краулерами», также известные как «пауки» или «боты», для обнаружения как нового, так и обновленного контента на страницах веб-сайта. Затем он будет следовать ссылкам, включенным в страницу, чтобы найти больше страниц. Контент, найденный на странице, сохраняется в индексе, который используется для извлечения информации для результатов поиска, когда пользователь ее запрашивает.

GoogleBot Desktop и GoogleBot Mobile — самые популярные поисковые роботы в большинстве стран, за ними следуют Bingbot, Slurp Bot и DuckDuckBot. Baiduspider используется в основном в Китае, а Yandex Bot — в России.