การป้องกันการล่มสลายของโมเดล AI: การจัดการกับความเสี่ยงโดยธรรมชาติของชุดข้อมูลสังเคราะห์

เผยแพร่แล้ว: 2023-10-05ปัญญาประดิษฐ์ (AI) ได้เปลี่ยนแปลงชีวิตประจำวันของเราอย่างมีนัยสำคัญด้วยการแนะนำเนื้อหาส่วนบุคคลบนแพลตฟอร์มสตรีมมิ่งและเปิดใช้งานผู้ช่วยดิจิทัลบนสมาร์ทโฟน ปัจจุบัน ความก้าวหน้าเหล่านี้เกิดขึ้นได้ด้วยโมเดล AI ที่ซับซ้อนซึ่งเรียนรู้จากข้อมูลจำนวนมหาศาล

ตามรายงานต่างๆ เนื้อหาที่สร้างโดย AI กำลังแพร่หลายมากขึ้นบนอินเทอร์เน็ต ซึ่งอาจประกอบด้วยข้อมูลออนไลน์มากถึง 90% ในอีกไม่กี่ปีข้างหน้า

ด้วยข้อมูลที่ไหลเข้ามาอย่างล้นหลาม เราสามารถพูดได้อย่างง่ายดายว่าในโลกที่อุดมไปด้วยข้อมูลในปัจจุบัน AI เผชิญกับความท้าทายที่ไม่เหมือนใคร และนั่นก็ทำให้ปริมาณข้อมูลที่มีอยู่ไม่เพียงพอ

รายงานยังชี้ให้เห็นอีกว่าเนื้อหาที่สร้างโดย AI จำนวนมากอาจทำให้ผู้คนได้รับข้อมูลที่มากเกินไป ทำให้ยากสำหรับพวกเขาในการระบุสิ่งที่น่าเชื่อถือและสร้างขึ้นโดยมนุษย์ นอกจากนี้ ยังมีความกังวลเกี่ยวกับการสูญเสียงานในสาขาสร้างสรรค์ เช่น ศิลปะ วารสารศาสตร์ และการเขียน ทั้งหมดนี้เป็นเพราะ AI มีความสามารถในการผลิตเนื้อหาที่มนุษย์สร้างขึ้นแบบดั้งเดิมมากขึ้น

เมื่อมาถึงระบบ AI เอง ก็มีปัญหาใหม่ๆ เกิดขึ้น เช่น “การล่มสลายของโมเดล” ซึ่งหมายถึงปัญหาที่โมเดล AI ที่ได้รับการฝึกบนชุดข้อมูลขนาดใหญ่จะสร้างผลลัพธ์ที่มีคุณภาพต่ำลงโดยจัดลำดับความสำคัญของตัวเลือกคำทั่วไปมากกว่าทางเลือกที่สร้างสรรค์ “ความผิดปกติของการกินโมเดลอัตโนมัติ” หรือ “Habsburg AI” เป็นอีกหนึ่งข้อกังวลที่ระบบ AI ที่ได้รับการฝึกมากเกินไปเกี่ยวกับผลลัพธ์ของโมเดล AI อื่นๆ อาจแสดงคุณสมบัติที่ไม่พึงประสงค์หรืออาจมีอคติได้

ความท้าทายเหล่านี้อาจส่งผลเสียต่อคุณภาพและความน่าเชื่อถือของเนื้อหาที่สร้างโดย AI ทำลายความไว้วางใจในระบบดังกล่าว และทำให้ข้อมูลโอเวอร์โหลดแย่ลง

บล็อกของเราจะช่วยให้คุณเข้าใจทุกสิ่งที่เกี่ยวข้องกับการจัดการกับการป้องกันการล่มสลายของโมเดล AI ในขณะที่การปฏิวัติ AI เจนเนอเรชั่นดำเนินไป ก็นำมาซึ่งความท้าทายและความไม่แน่นอนที่สำคัญสำหรับภูมิทัศน์ข้อมูลออนไลน์ เอาล่ะ เรามาเจาะลึกรายละเอียดกันดีกว่า

ทำความเข้าใจการล่มสลายของโมเดล AI

ในแมชชีนเลิร์นนิง “การล่มสลายของโมเดล” หมายถึงสถานการณ์ที่โมเดล AI ไม่สามารถให้ผลลัพธ์ที่เป็นประโยชน์ได้หลากหลาย แต่กลับสร้างชุดผลลัพธ์ที่ซ้ำกันหรือคุณภาพต่ำในวงแคบๆ ปัญหานี้อาจเกิดขึ้นได้ในโมเดลต่างๆ แต่มักพบเห็นได้ในระหว่างการฝึกโมเดลที่ซับซ้อน เช่น generative adversarial network (GAN) การล่มสลายของโมเดลอาจขัดขวางความสามารถของโมเดลในการสร้างผลลัพธ์ที่หลากหลายและมีคุณค่า ซึ่งส่งผลกระทบต่อประสิทธิภาพโดยรวม

เรามาแสดงตัวอย่างการล่มสลายของโมเดลกัน ลองนึกภาพนักเรียนศิลปะที่มีความกระตือรือร้นอย่างมากซึ่งเป็นตัวแทนของโมเดล AI ของเรา ซึ่งได้รับมอบหมายให้สร้างภาพวาดม้าลาย ในช่วงแรกงานศิลปะของพวกเขาดูน่าประทับใจและมีลักษณะคล้ายม้าลายอย่างชัดเจน อย่างไรก็ตาม ภาพวาดของพวกเขาจะค่อยๆ สูญเสียความคล้ายคลึงกับม้าลายไปในขณะที่ยังคงดำเนินต่อไป และคุณภาพก็ลดลง สิ่งนี้คล้ายกับ “การล่มสลายของโมเดล” ในแมชชีนเลิร์นนิง ซึ่งโมเดล AI เช่นเดียวกับนักเรียนศิลปะของเรา ในตอนแรกทำงานได้ดี แต่จากนั้นก็ประสบปัญหาเพื่อรักษาคุณลักษณะสำคัญที่ออกแบบมาเพื่อดำเนินการ

ตามความก้าวหน้าล่าสุดของ AI นักวิจัยเริ่มให้ความสนใจอย่างมากในการใช้ข้อมูลประดิษฐ์หรือข้อมูลสังเคราะห์เพื่อฝึกโมเดล AI ใหม่ในการสร้างรูปภาพและข้อความ อย่างไรก็ตาม แนวคิดที่เรียกว่า 'Model Autophagy Disorder' (MAD) จะเปรียบเทียบกระบวนการนี้กับวงจรการทำลายตนเอง

เว้นแต่ว่าเราจะเพิ่มข้อมูลโลกแห่งความเป็นจริงที่สดใหม่เป็นประจำ คุณภาพและความหลากหลายของโมเดล AI ที่เราสร้างโดยใช้ข้อมูลสังเคราะห์อาจแย่ลงเมื่อเวลาผ่านไป ดังนั้นจึงจำเป็นอย่างยิ่งที่จะต้องสร้างสมดุลระหว่างข้อมูลสังเคราะห์และข้อมูลจริงเพื่อให้โมเดล AI ทำงานได้ดี

ความสมดุลนี้มีความสำคัญอย่างยิ่งในการป้องกันไม่ให้คุณภาพและความหลากหลายของแบบจำลองลดลงในขณะที่พวกเขาเรียนรู้ต่อไป การค้นหาวิธีใช้ข้อมูลสังเคราะห์อย่างมีประสิทธิภาพสำหรับการป้องกันการล่มสลายของโมเดล AI ถือเป็นความท้าทายอย่างต่อเนื่องเมื่อพูดถึงวิวัฒนาการของ Generative AI และการใช้ข้อมูลสังเคราะห์

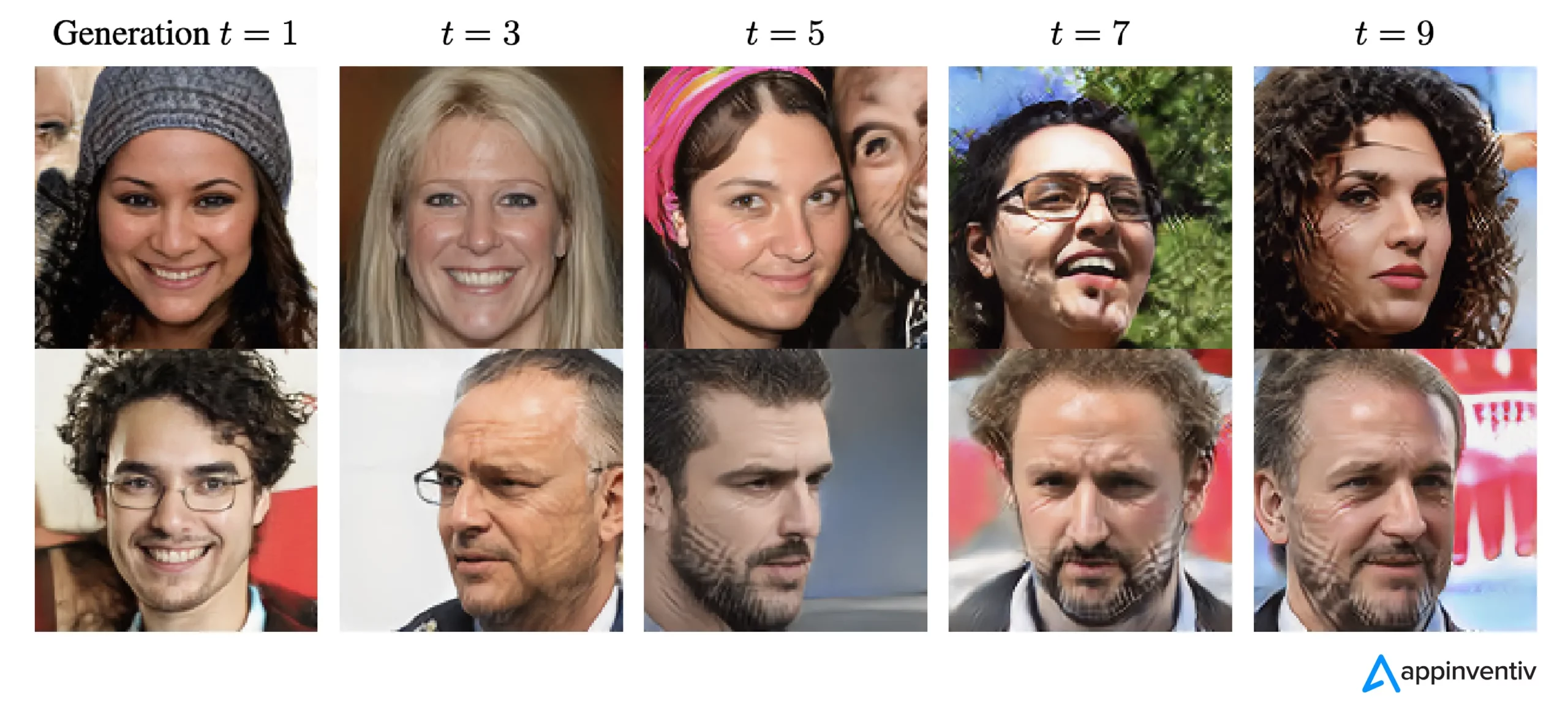

ตามรายงานของ The New Yorker หาก ChatGPT ถือเป็นเวอร์ชันกะทัดรัดของอินเทอร์เน็ต คล้ายกับไฟล์ JPEG ที่บีบอัดรูปถ่าย การฝึกแชทบอตในอนาคตเกี่ยวกับผลลัพธ์ของ ChatGPT จะเทียบเท่าทางดิจิทัลกับการถ่ายเอกสารซ้ำๆ เหมือนกับ วันเก่า ๆ. พูดง่ายๆ ก็คือคุณภาพของภาพจะแย่ลงในการวนซ้ำแต่ละครั้ง

ดังนั้น เพื่อเอาชนะความท้าทายนี้ องค์กรต่างๆ จำเป็นต้องมุ่งเน้นไปที่การปรับปรุงแนวทางของตนเพื่อให้แน่ใจว่าผลิตภัณฑ์ AI สร้างสรรค์เหล่านี้ยังคงให้การตอบสนองที่แม่นยำในภูมิทัศน์ดิจิทัลนี้

[อ่านเพิ่มเติม: AI ที่มีความรับผิดชอบ - จัดการกับความท้าทายในการนำไปใช้ด้วยหลักการและกลยุทธ์ที่เป็นแนวทาง]

โมเดล AI ล่มสลายเกิดขึ้นได้อย่างไร?

การล่มสลายของโมเดลเกิดขึ้นเมื่อโมเดล AI ใหม่ได้รับการฝึกฝนโดยใช้ข้อมูลที่สร้างโดยโมเดลรุ่นเก่า โมเดลใหม่เหล่านี้อาศัยรูปแบบที่เห็นในข้อมูลที่สร้างขึ้น การล่มสลายของโมเดลมีรากฐานมาจากแนวคิดที่ว่าโมเดลเชิงกำเนิดมีแนวโน้มที่จะทำซ้ำรูปแบบที่พวกเขาได้เรียนรู้ไปแล้ว และข้อมูลที่พวกเขาสามารถดึงออกมาจากรูปแบบเหล่านี้มีข้อจำกัด

ในกรณีของการล่มสลายของโมเดล เหตุการณ์ที่มีแนวโน้มว่าจะเกิดขึ้นจะถูกพูดเกินจริง ในขณะที่เหตุการณ์ที่มีโอกาสน้อยกว่าจะถูกประเมินต่ำเกินไป ในช่วงหลายชั่วอายุคน เหตุการณ์ที่น่าจะเกิดขึ้นจะครอบงำข้อมูล และส่วนที่ไม่ค่อยพบเห็นแต่ยังคงมีความสำคัญของข้อมูลที่เรียกว่าส่วนท้าย (tails) ก็ลดน้อยลง ส่วนท้ายเหล่านี้จำเป็นต่อการรักษาความแม่นยำและความหลากหลายของเอาท์พุตของโมเดล เมื่อคนรุ่นต่างๆ ดำเนินไป ข้อผิดพลาดก็ครอบงำข้อมูล และแบบจำลองก็ตีความข้อมูลผิดมากขึ้นเรื่อยๆ

จากการวิจัยพบว่าการล่มสลายของโมเดลมีสองประเภท: ช่วงต้นและช่วงปลาย การล่มสลายของโมเดลในช่วงแรกเกี่ยวข้องกับโมเดลที่สูญเสียข้อมูลเกี่ยวกับเหตุการณ์ที่เกิดขึ้นได้ยาก ในการล่มสลายของโมเดลช่วงหลัง โมเดลจะเบลอรูปแบบที่แตกต่างกันในข้อมูล ส่งผลให้ผลลัพธ์มีความคล้ายคลึงกับข้อมูลต้นฉบับเพียงเล็กน้อย

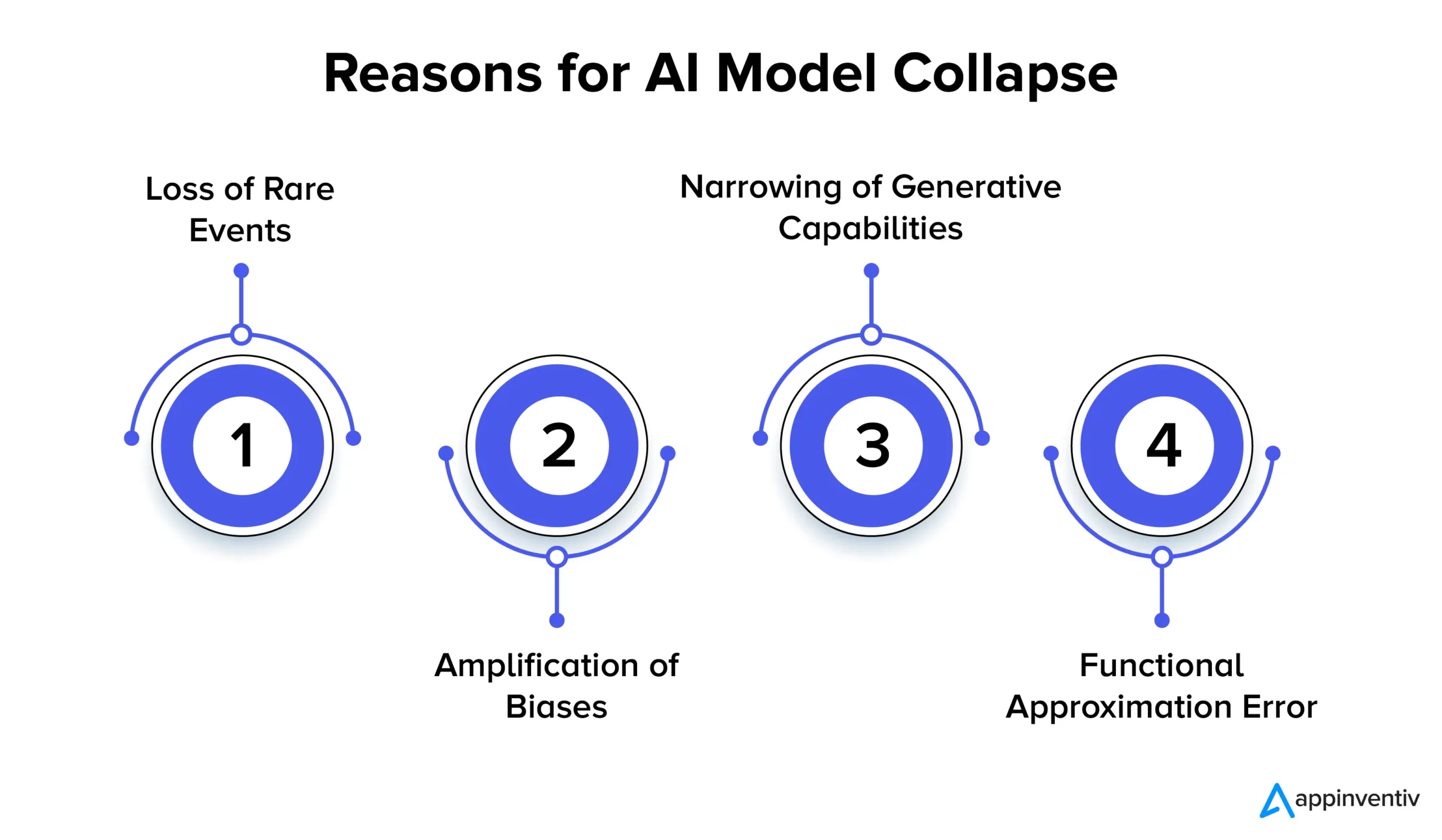

ให้เราดูสาเหตุหลายประการที่ทำให้โมเดล AI ล่มสลายโดยละเอียดด้านล่าง:

การสูญเสียเหตุการณ์ที่หายาก

เมื่อโมเดล AI ได้รับการฝึกซ้ำๆ เกี่ยวกับข้อมูลที่สร้างจากเวอร์ชันก่อนหน้า โมเดลเหล่านี้จะพยายามมุ่งเน้นไปที่รูปแบบทั่วไปและลืมเหตุการณ์ที่เกิดขึ้นได้ยาก ปรากฏการณ์นี้คล้ายกับแบบจำลองที่สูญเสียความทรงจำระยะยาว เหตุการณ์ที่เกิดขึ้นไม่บ่อยมักมีความสำคัญอย่างมาก เช่น การระบุความผิดปกติในกระบวนการผลิต หรือการตรวจจับธุรกรรมที่ฉ้อโกง ตัวอย่างเช่น เมื่อพูดถึงการตรวจจับการฉ้อโกง รูปแบบภาษาเฉพาะอาจส่งสัญญาณถึงพฤติกรรมการฉ้อโกง ทำให้จำเป็นอย่างยิ่งที่จะต้องรักษาและเรียนรู้รูปแบบที่หายากเหล่านี้

การขยายอคติ

การทำซ้ำการฝึกอบรมแต่ละครั้งกับข้อมูลที่สร้างโดย AI สามารถขยายอคติที่มีอยู่ในข้อมูลการฝึกอบรมได้ เนื่องจากเอาท์พุตของโมเดลมักจะสะท้อนถึงข้อมูลที่ได้รับการฝึก ความลำเอียงใดๆ ภายในข้อมูลนั้นจึงสามารถเกินจริงตามเวลาได้ สิ่งนี้สามารถนำไปสู่การขยายอคติในแอปพลิเคชัน AI ต่างๆ ตัวอย่างเช่น ผลลัพธ์อาจนำไปสู่ปัญหาต่างๆ เช่น การเลือกปฏิบัติ อคติทางเชื้อชาติ และเนื้อหาบนโซเชียลมีเดียที่มีอคติ ดังนั้นการใช้การควบคุมเพื่อตรวจจับและบรรเทาอคติจึงถือเป็นสิ่งสำคัญอย่างยิ่ง

การลดความสามารถในการกำเนิด

เนื่องจากโมเดล AI ยังคงเรียนรู้จากข้อมูลที่สร้างขึ้น ความสามารถในการสร้างของโมเดลจึงอาจแคบลง โมเดลนี้ค่อนข้างได้รับอิทธิพลจากการตีความความเป็นจริงของตัวเอง ทำให้มีเนื้อหาที่คล้ายคลึงกันมากขึ้นเรื่อยๆ ซึ่งขาดความหลากหลายและการเป็นตัวแทนของเหตุการณ์ที่เกิดขึ้นได้ยาก สิ่งนี้สามารถนำไปสู่การสูญเสียความคิดริเริ่ม ตัวอย่างเช่น เมื่อพูดถึง Large Language Models (LLM) รูปแบบดังกล่าวจะทำให้นักเขียนหรือศิลปินแต่ละคนมีน้ำเสียงและสไตล์ที่แตกต่างกันออกไป

การวิจัยชี้ให้เห็นว่าหากไม่มีการเพิ่มข้อมูลใหม่เป็นประจำในระหว่างกระบวนการฝึกอบรม โมเดล AI ในอนาคตอาจมีความแม่นยำน้อยลงหรือให้ผลลัพธ์ที่แตกต่างกันน้อยลงเมื่อเวลาผ่านไป

ข้อผิดพลาดในการประมาณการทำงาน

ข้อผิดพลาดในการประมาณฟังก์ชันอาจเกิดขึ้นเมื่อตัวประมาณฟังก์ชันที่ใช้ในแบบจำลองไม่แสดงออกเพียงพอ แม้ว่าข้อผิดพลาดนี้สามารถบรรเทาลงได้โดยใช้โมเดลที่แสดงออกชัดเจนมากขึ้น แต่ก็อาจทำให้เกิดเสียงรบกวนและนำไปสู่การสวมอุปกรณ์มากเกินไปได้ การสร้างสมดุลที่เหมาะสมระหว่างการแสดงออกของโมเดลและการควบคุมสัญญาณรบกวนเป็นสิ่งสำคัญอย่างยิ่งในการป้องกันข้อผิดพลาดเหล่านี้

ผลกระทบของการล่มสลายของโมเดล: เหตุใดความเสถียรของโมเดล AI จึงมีความสำคัญ

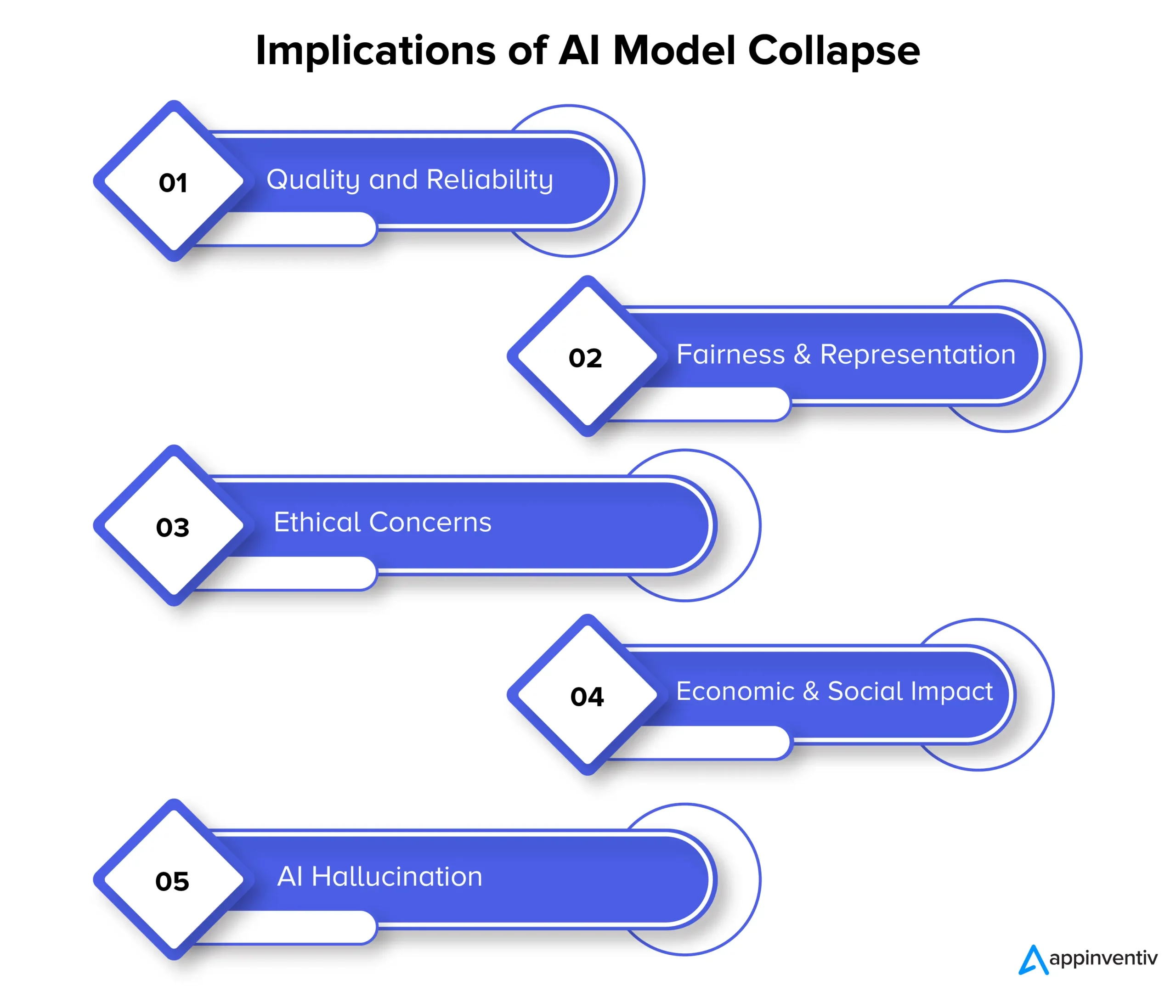

การล่มสลายของโมเดลในท้ายที่สุดอาจส่งผลกระทบต่อคุณภาพ ความน่าเชื่อถือ และความยุติธรรมของเนื้อหาที่สร้างโดย AI ซึ่งอาจก่อให้เกิดความเสี่ยงหลายประการต่อองค์กรอีกด้วย ให้เราดูความหมายของการล่มสลายของโมเดลโดยละเอียดด้านล่าง:

คุณภาพและความน่าเชื่อถือ

เมื่อโมเดล AI เสื่อมถอยในการเรียนรู้ เนื้อหาที่สร้างขึ้นจึงมีความน่าเชื่อถือน้อยลง และคุณภาพก็ลดลง สิ่งนี้เกิดขึ้นเมื่อแบบจำลองแยกตัวออกจากการกระจายข้อมูลดั้งเดิมและอาศัยการตีความความเป็นจริงของตนเองมากขึ้น ตัวอย่างเช่น โมเดล AI ที่ออกแบบมาเพื่อการสร้างข่าวอาจผลิตบทความข่าวที่ไม่ถูกต้องหรือประดิษฐ์ขึ้นทั้งหมด

ความเป็นธรรมและการเป็นตัวแทน

การล่มสลายของโมเดลยังเป็นสาเหตุให้เกิดความกังวลในเรื่องของความเป็นธรรมและการเป็นตัวแทนของเนื้อหาที่สร้างขึ้น เมื่อโมเดลลืมเหตุการณ์ที่เกิดขึ้นได้ยากและจำกัดความสามารถในการสร้าง เนื้อหาที่เกี่ยวข้องกับหัวข้อที่ไม่ค่อยพบบ่อยอาจถูกนำเสนออย่างไม่เพียงพอ สิ่งนี้นำไปสู่อคติ การเหมารวม และการกีดกันมุมมองบางอย่าง

ข้อกังวลด้านจริยธรรม

การล่มสลายของโมเดลก่อให้เกิดข้อกังวลด้านจริยธรรมที่สำคัญ โดยเฉพาะอย่างยิ่งเมื่อเนื้อหาที่สร้างโดย AI มีอำนาจในการมีอิทธิพลต่อการตัดสินใจ ผลที่ตามมาของการล่มสลายของโมเดล ได้แก่ การแพร่กระจายของเนื้อหาที่มีอคติและไม่ถูกต้อง ซึ่งอาจส่งผลกระทบอย่างมีนัยสำคัญต่อชีวิต ความคิดเห็น และการเข้าถึงโอกาสของผู้คน

ผลกระทบทางเศรษฐกิจและสังคม

ในระดับเศรษฐกิจและสังคม การล่มสลายของโมเดลสามารถมีอิทธิพลต่อความไว้วางใจและการนำเทคโนโลยี AI มาใช้ หากไม่สามารถพึ่งพาเนื้อหาที่สร้างโดย AI ธุรกิจและผู้บริโภคอาจลังเลที่จะใช้เทคโนโลยีเหล่านี้ สิ่งนี้อาจมีผลกระทบทางเศรษฐกิจ และความไว้วางใจในเทคโนโลยี AI ก็สามารถขัดขวางได้ตามมา

AI ภาพหลอน

ภาพหลอน AI เกิดขึ้นเมื่อโมเดล AI สร้างเนื้อหาเชิงจินตนาการหรือไม่สมจริงที่ไม่สอดคล้องกับข้อเท็จจริงหรือเชื่อมโยงกันในทางใดทางหนึ่ง ซึ่งอาจส่งผลให้เกิดข้อมูลที่ไม่ถูกต้อง อาจทำให้เกิดข้อมูลที่ผิดหรือความสับสนได้ เป็นปัญหาอย่างมากในการใช้งาน เช่น การสร้างข่าวสาร การวินิจฉัยสภาวะทางการแพทย์ หรือการสร้างเอกสารทางกฎหมายที่ความถูกต้องและความน่าเชื่อถือเป็นสิ่งสำคัญอย่างยิ่ง

ให้เราอธิบายบริบทด้วยตัวอย่างภาพหลอนของ AI สมมติว่ามีโมเดล AI ที่ได้รับการฝึกฝนให้สร้างภาพสัตว์ต่างๆ ตอนนี้ เมื่อขอภาพสัตว์ แบบจำลองอาจสร้างภาพ "zebroid" ซึ่งเป็นลูกผสมระหว่างม้าลายและม้า แม้ว่าภาพนี้อาจให้ความรู้สึกเหมือนจริงทางสายตา แต่สิ่งสำคัญคือต้องเข้าใจว่าภาพนี้เป็นเพียงการสร้างสรรค์จากจินตนาการของโมเดล AI เท่านั้น เนื่องจากไม่มีสัตว์ชนิดนี้อยู่ในโลกแห่งความเป็นจริง

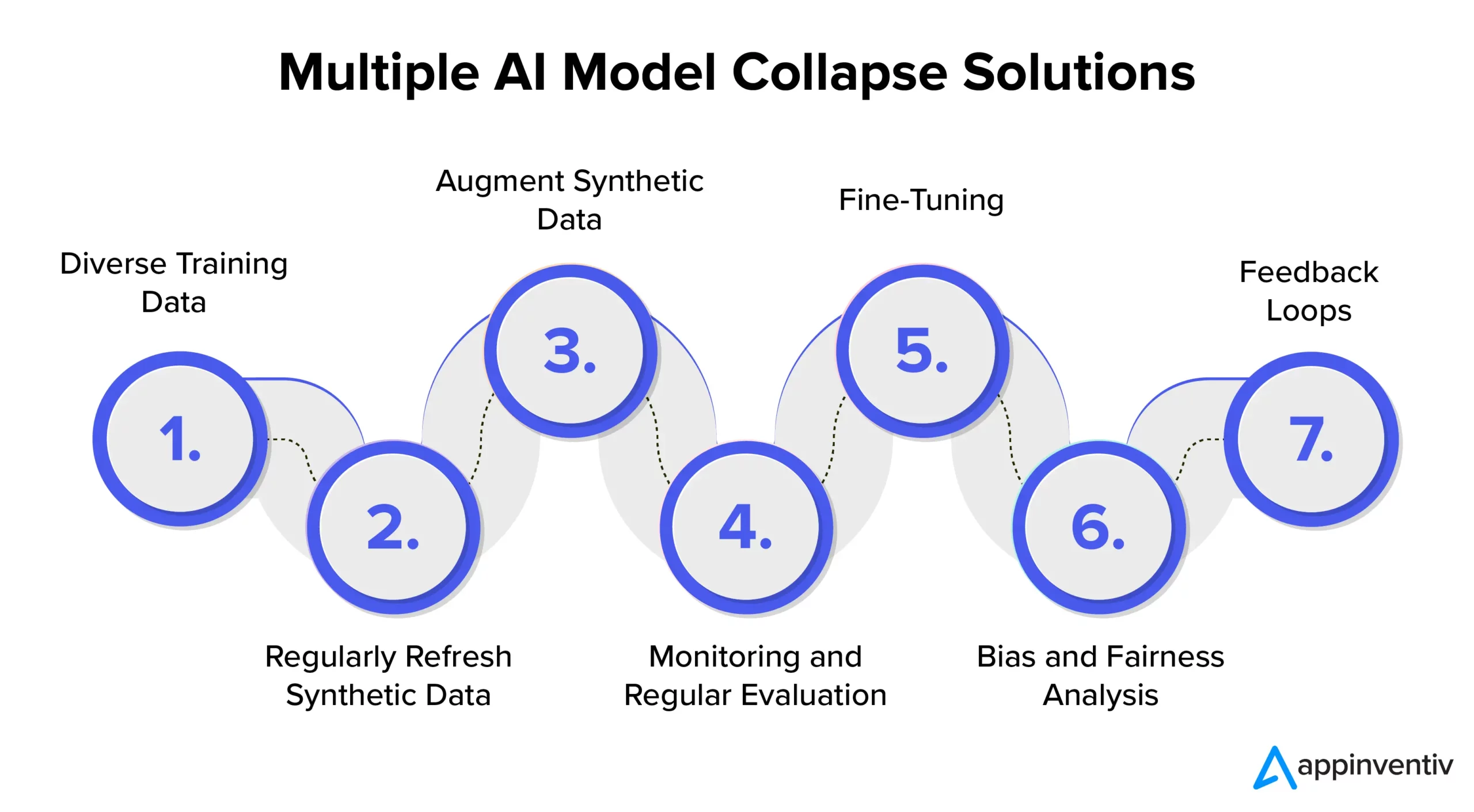

การป้องกันการล่มสลายของโมเดล AI: ทำความเข้าใจกับโซลูชันการล่มสลายของโมเดล AI

เพื่อให้มั่นใจถึงความเสถียรและความน่าเชื่อถือของโมเดล AI จำเป็นอย่างยิ่งที่จะต้องสำรวจกลยุทธ์และแนวทางปฏิบัติที่ดีที่สุดในการจัดการกับการป้องกันการล่มสลายของโมเดล AI อย่างมีประสิทธิภาพ ดังนั้นจึงขอแนะนำให้ร่วมมือกับบริษัทพัฒนา AI โดยเฉพาะ เช่น Appinventiv ซึ่งสามารถให้ความเชี่ยวชาญและคำแนะนำในการใช้มาตรการป้องกันเหล่านี้ ในขณะเดียวกันก็ทำให้มั่นใจว่าระบบ AI ของคุณจะให้ผลลัพธ์คุณภาพสูงอย่างสม่ำเสมอ

ข้อมูลการฝึกอบรมที่หลากหลาย

เพื่อจัดการกับการล่มสลายของโมเดล AI อย่างมีประสิทธิภาพและป้องกันผลลัพธ์ที่ไม่พึงประสงค์ การดูแลชุดข้อมูลการฝึกอบรมที่มีแหล่งข้อมูลและประเภทต่างๆ ถือเป็นสิ่งสำคัญ ชุดข้อมูลนี้ควรประกอบด้วยทั้งข้อมูลสังเคราะห์ที่สร้างขึ้นโดยแบบจำลองและข้อมูลในโลกแห่งความเป็นจริงที่แสดงถึงความซับซ้อนของปัญหาได้อย่างแม่นยำ การอัปเดตชุดข้อมูลนี้ด้วยข้อมูลใหม่ที่เกี่ยวข้องเป็นประจำเป็นสิ่งสำคัญ แบบจำลองนี้เปิดรับรูปแบบที่หลากหลายโดยผสมผสานข้อมูลการฝึกที่หลากหลาย ซึ่งจะช่วยป้องกันความซบเซาของข้อมูล

รีเฟรชข้อมูลสังเคราะห์เป็นประจำ

การล่มสลายของโมเดลถือเป็นความเสี่ยงเมื่อโมเดล AI ต้องอาศัยข้อมูลที่สร้างขึ้นเองอย่างมาก เพื่อการลดความเสี่ยงใน AI อย่างมีประสิทธิภาพ สิ่งสำคัญคือต้องแนะนำข้อมูลใหม่ที่แท้จริงและในโลกแห่งความเป็นจริงเข้าสู่ขั้นตอนการฝึกอบรมอย่างสม่ำเสมอ แนวทางปฏิบัตินี้ช่วยให้แน่ใจว่าโมเดลยังคงปรับตัวได้ และหลีกเลี่ยงการติดอยู่ในลูปซ้ำๆ สิ่งนี้สามารถช่วยในการสร้างผลลัพธ์ที่หลากหลายและเกี่ยวข้องได้

เพิ่มข้อมูลสังเคราะห์

การปรับปรุงข้อมูลสังเคราะห์ผ่านเทคนิคการเพิ่มข้อมูลเป็นวิธีการที่ได้รับการพิสูจน์แล้วว่าป้องกันการล่มสลายของแบบจำลอง เทคนิคเหล่านี้ทำให้เกิดความแปรปรวนในข้อมูลสังเคราะห์โดยใช้ความแปรผันตามธรรมชาติของข้อมูลในโลกแห่งความเป็นจริง การเพิ่มสัญญาณรบกวนที่มีการควบคุมให้กับข้อมูลที่สร้างขึ้นจะช่วยกระตุ้นให้โมเดลเรียนรู้รูปแบบที่หลากหลายมากขึ้น ซึ่งช่วยลดโอกาสในการสร้างเอาต์พุตที่ซ้ำกัน

การติดตามและการประเมินผลอย่างสม่ำเสมอ

การตรวจสอบและประเมินประสิทธิภาพของโมเดล AI เป็นประจำเป็นสิ่งสำคัญสำหรับการตรวจจับการล่มสลายของโมเดลตั้งแต่เนิ่นๆ การใช้กรอบการทำงาน MLOps ช่วยให้มั่นใจได้ว่ามีการติดตามและสอดคล้องกับเป้าหมายขององค์กรอย่างต่อเนื่อง ดังนั้นจึงช่วยให้มีการแทรกแซงและปรับเปลี่ยนได้ทันท่วงที

[อ่านเพิ่มเติม: วิธีหลีกเลี่ยงการละเมิดการปฏิบัติตามข้อกำหนดในขณะที่พัฒนาผลิตภัณฑ์ AI]

การปรับแต่งแบบละเอียด

สิ่งสำคัญคือต้องพิจารณาใช้กลยุทธ์การปรับแต่งเพื่อรักษาเสถียรภาพของโมเดลและป้องกันการล่มสลาย กลยุทธ์เหล่านี้ในการป้องกันความล้มเหลวของโมเดล AI ช่วยให้โมเดลสามารถปรับตัวเข้ากับข้อมูลใหม่ในขณะที่ยังคงรักษาความรู้เดิมไว้ได้

การวิเคราะห์อคติและความเป็นธรรม

อคติที่เข้มงวดและการวิเคราะห์ความเป็นธรรมมีความสำคัญอย่างยิ่งในการป้องกันการล่มสลายของโมเดลและปัญหาด้านจริยธรรม การระบุและแก้ไขอคติในผลลัพธ์ของแบบจำลองเป็นสิ่งสำคัญ คุณสามารถรักษาผลลัพธ์ของแบบจำลองที่เชื่อถือได้และเป็นกลางได้โดยการจัดการข้อกังวลเหล่านี้อย่างจริงจัง

ข้อเสนอแนะลูป

การใช้ฟีดแบ็กลูปที่รวมฟีดแบ็กของผู้ใช้เป็นสิ่งสำคัญในการป้องกันการล่มสลายของโมเดล ด้วยการรวบรวมข้อมูลเชิงลึกของผู้ใช้อย่างสม่ำเสมอ จึงสามารถปรับเปลี่ยนผลลัพธ์ของแบบจำลองได้อย่างมีข้อมูล กระบวนการปรับแต่งนี้รับประกันว่าโมเดลยังคงมีความเกี่ยวข้อง เชื่อถือได้ และสอดคล้องกับความคาดหวังของผู้ใช้

Appinventiv สามารถช่วยลดความเสี่ยงในโมเดล AI ได้อย่างไร

ในภูมิทัศน์ที่เปลี่ยนแปลงไปของ AI ความท้าทายที่เกิดจากการล่มสลายของโมเดลเป็นข้อกังวลสำหรับทั้งยักษ์ใหญ่ด้านเทคโนโลยีและผู้สร้างนวัตกรรม ความเสื่อมถอยในระยะยาวของชุดข้อมูลโมเดลภาษาและการจัดการเนื้อหาได้ทิ้งร่องรอยไว้ในระบบนิเวศดิจิทัลนี้

เมื่อ AI ก้าวหน้า การแยกความแตกต่างระหว่างข้อมูลที่สร้างขึ้นโดยมนุษย์และเนื้อหาที่มนุษย์สร้างขึ้นจึงมีความสำคัญ เส้นแบ่งระหว่างเนื้อหาของแท้กับสิ่งที่สร้างโดยเครื่องกำลังเบลอมากขึ้น

ท่ามกลางความท้าทายเหล่านี้และการป้องกันความล้มเหลวของโมเดล AI การเป็นพันธมิตรกับบริษัทพัฒนา AI โดยเฉพาะอย่าง Appinventiv สามารถมอบสิ่งปลอบใจที่จำเป็นให้กับคุณได้มาก ด้วยความเชี่ยวชาญในการพัฒนาโมเดล AI และความมุ่งมั่นทุ่มเทในแนวทางปฏิบัติด้านจริยธรรมของ AI เราสามารถช่วยคุณนำทางความซับซ้อนของ AI ขณะเดียวกันก็รับประกันความน่าเชื่อถือและความสมบูรณ์ของระบบ AI ของคุณ

ผู้เชี่ยวชาญของเราสามารถทำงานร่วมกับคุณในการจัดการกับการป้องกันการล่มสลายของโมเดล AI ได้อย่างมีประสิทธิภาพ ส่งเสริมความโปร่งใส และสร้างอนาคตด้วยเนื้อหาที่แท้จริงที่ไม่กระทบต่อความถูกต้องของเนื้อหาที่มนุษย์สร้างขึ้น

เราเข้าใจดีว่าการฝึกโมเดล AI ด้วยข้อมูลที่สดใหม่และหลากหลายถือเป็นสิ่งสำคัญเพื่อป้องกันการเสื่อมสภาพของโมเดล การประเมินโมเดล AI เป็นขั้นตอนสำคัญในกระบวนการพัฒนาโมเดลของเรา ซึ่งใช้หน่วยวัดเพื่อประเมินประสิทธิภาพ ระบุจุดอ่อน และรับประกันการคาดการณ์ในอนาคตที่มีประสิทธิภาพ

ทีมผู้เชี่ยวชาญของเราสามารถช่วยให้แน่ใจว่าระบบ AI ของคุณยังคงเรียนรู้และปรับให้เข้ากับภูมิทัศน์ดิจิทัลที่กำลังพัฒนาอยู่ ติดต่อผู้เชี่ยวชาญของเราเพื่อลดความเสี่ยงที่เกี่ยวข้องกับการล่มสลายของโมเดลและรับรองประสิทธิภาพ

คำถามที่พบบ่อย

ถาม การล่มสลายของโมเดล AI คืออะไร

A. การล่มสลายของโมเดล AI ในการเรียนรู้ของเครื่องหมายถึงความล้มเหลวของโมเดล AI ในการสร้างผลลัพธ์ที่มีประโยชน์ที่หลากหลาย แต่กลับสร้างผลลัพธ์ที่ซ้ำหรือมีคุณภาพต่ำ ปัญหานี้อาจเกิดขึ้นได้ในโมเดลประเภทต่างๆ แต่จะสังเกตได้เป็นพิเศษในระหว่างการฝึกโมเดลที่ซับซ้อน เช่น generative adversarial network (GAN)

ถาม: สาเหตุทั่วไปของการล่มสลายของโมเดล AI คืออะไร

A. สาเหตุทั่วไปของการล่มสลายของโมเดล AI ได้แก่ การสูญเสียเหตุการณ์ที่เกิดขึ้นได้ยาก การขยายอคติ ความสามารถในการกำเนิดที่แคบลง ข้อผิดพลาดในการประมาณฟังก์ชัน ฯลฯ ปัจจัยเหล่านี้สามารถนำไปสู่แบบจำลองที่สร้างผลลัพธ์ที่ต่ำกว่ามาตรฐาน

ถาม ฉันจะป้องกันไม่ให้โมเดล AI ล่มสลายได้อย่างไร

ตอบ: เพื่อการป้องกันการล่มสลายของโมเดล AI ที่มีประสิทธิภาพ การใช้ข้อมูลการฝึกอบรมที่แตกต่างและเหมือนจริงเป็นสิ่งสำคัญ การติดตามและประเมินข้อมูลอย่างต่อเนื่อง แก้ไขอคติใดๆ และดำเนินการทดสอบและควบคุมคุณภาพอย่างเข้มงวด การเป็นพันธมิตรกับผู้เชี่ยวชาญด้าน AI ที่ Appinventiv สามารถนำเสนอข้อมูลเชิงลึกและโซลูชันอันมีค่าแก่คุณเพื่อลดความเสี่ยงในการล่มสลายของโมเดล