เทคนิคการรวบรวมข้อมูลเว็บที่มีประสิทธิภาพสำหรับแอปพลิเคชันข้อมูลขนาดใหญ่

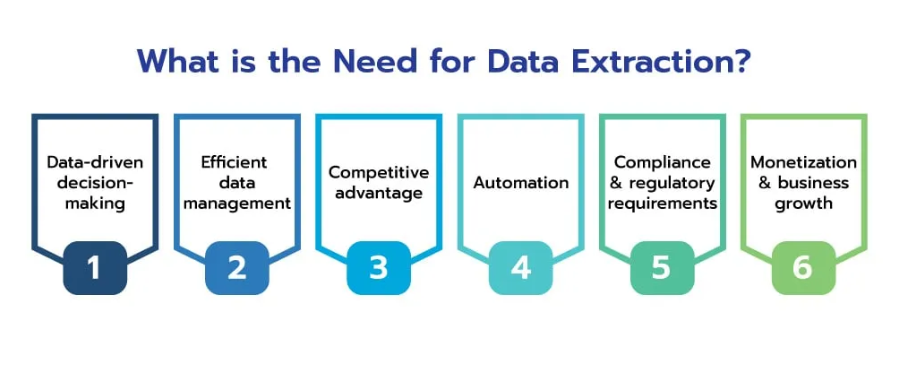

เผยแพร่แล้ว: 2024-06-06ในยุคของข้อมูลขนาดใหญ่ การรวบรวมข้อมูลเว็บไซต์กลายเป็นกระบวนการที่ขาดไม่ได้สำหรับธุรกิจที่มุ่งหวังที่จะควบคุมความมั่งคั่งของข้อมูลออนไลน์ ด้วยการรวบรวม ประมวลผล และวิเคราะห์ข้อมูลเว็บในวงกว้างอย่างมีประสิทธิภาพ บริษัทต่างๆ จึงสามารถปลดล็อกข้อมูลเชิงลึกอันมีค่าและได้เปรียบในการแข่งขันในอุตสาหกรรมต่างๆ

ข้อมูลเว็บมีศักยภาพมหาศาล โดยให้ข้อมูลเชิงลึกเกี่ยวกับแนวโน้มของตลาด พฤติกรรมผู้บริโภค และภาพรวมการแข่งขัน ความสามารถในการรวบรวมและวิเคราะห์ข้อมูลนี้ได้อย่างมีประสิทธิภาพสามารถเปลี่ยนข้อมูลดิบให้เป็นข้อมูลอัจฉริยะที่นำไปใช้ได้จริง ขับเคลื่อนการตัดสินใจเชิงกลยุทธ์และการเติบโตของธุรกิจ

ที่มา: scrapehero

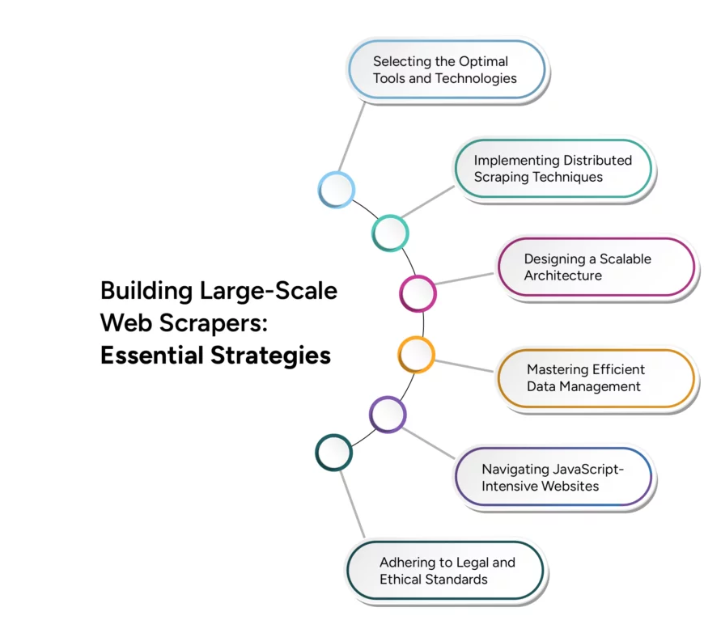

อย่างไรก็ตาม การเปลี่ยนจากการขูดเว็บขนาดเล็กไปเป็นการรวบรวมข้อมูลเว็บขนาดใหญ่ ถือเป็นความท้าทายทางเทคนิคที่สำคัญ การปรับขนาดที่มีประสิทธิภาพต้องพิจารณาปัจจัยต่างๆ อย่างรอบคอบ รวมถึงโครงสร้างพื้นฐาน การจัดการข้อมูล และประสิทธิภาพการประมวลผล บทความนี้เจาะลึกเทคนิคและกลยุทธ์ขั้นสูงที่จำเป็นในการเอาชนะความท้าทายเหล่านี้ เพื่อให้มั่นใจว่าการดำเนินการรวบรวมข้อมูลเว็บของคุณสามารถเติบโตเพื่อตอบสนองความต้องการของแอปพลิเคชันข้อมูลขนาดใหญ่

ความท้าทายของการรวบรวมข้อมูลเว็บไซต์สำหรับแอปพลิเคชันข้อมูลขนาดใหญ่

การรวบรวมข้อมูลเว็บไซต์สำหรับแอปพลิเคชันข้อมูลขนาดใหญ่ทำให้เกิดความท้าทายที่สำคัญหลายประการที่ธุรกิจต้องจัดการเพื่อควบคุมพลังของข้อมูลออนไลน์อันกว้างใหญ่อย่างมีประสิทธิภาพ การทำความเข้าใจและเอาชนะความท้าทายเหล่านี้เป็นสิ่งสำคัญสำหรับการสร้างโครงสร้างพื้นฐานการรวบรวมข้อมูลเว็บที่แข็งแกร่งและปรับขนาดได้

หนึ่งในความท้าทายหลักคือปริมาณที่แท้จริงและความหลากหลายของข้อมูลบนเว็บ ซึ่งยังคงเติบโตแบบทวีคูณ นอกจากนี้ ความหลากหลายของประเภทข้อมูล ตั้งแต่ข้อความและรูปภาพไปจนถึงวิดีโอและเนื้อหาแบบไดนามิกเพิ่มความซับซ้อนให้กับกระบวนการรวบรวมข้อมูลเว็บไซต์ เว็บไซต์สมัยใหม่มักใช้เนื้อหาแบบไดนามิกที่สร้างโดย JavaScript และ AJAX ทำให้เป็นเรื่องยาก

โปรแกรมรวบรวมข้อมูลแบบดั้งเดิมเพื่อรวบรวมข้อมูลที่เกี่ยวข้องทั้งหมด นอกจากนี้ เว็บไซต์อาจกำหนดอัตราจำกัดหรือบล็อกที่อยู่ IP เพื่อป้องกันการรวบรวมข้อมูลมากเกินไป ซึ่งอาจขัดขวางความพยายามในการรวบรวมข้อมูล

การรับรองความถูกต้องของข้อมูลและความสม่ำเสมอของข้อมูลที่รวบรวมจากแหล่งต่างๆ อาจเป็นเรื่องยาก โดยเฉพาะอย่างยิ่งเมื่อต้องจัดการกับชุดข้อมูลขนาดใหญ่ การปรับขนาดการดำเนินการรวบรวมข้อมูลเว็บเพื่อรองรับการโหลดข้อมูลที่เพิ่มขึ้นโดยไม่กระทบต่อประสิทธิภาพถือเป็นความท้าทายทางเทคนิคที่สำคัญ นอกจากนี้ การปฏิบัติตามหลักเกณฑ์ทางกฎหมายและจริยธรรมในการรวบรวมข้อมูลเว็บไซต์ถือเป็นสิ่งสำคัญอย่างยิ่งในการหลีกเลี่ยงปัญหาทางกฎหมายที่อาจเกิดขึ้นและรักษาชื่อเสียงที่ดี การจัดการทรัพยากรการประมวลผลอย่างมีประสิทธิภาพเพื่อสร้างสมดุลระหว่างความเร็วในการรวบรวมข้อมูลและความคุ้มค่าก็เป็นสิ่งสำคัญเช่นกัน

เทคนิคการดึงข้อมูลอย่างมีประสิทธิภาพ

การใช้เทคนิคการแยกข้อมูลขั้นสูงช่วยให้มั่นใจได้ว่าข้อมูลที่รวบรวมมีความเกี่ยวข้อง ถูกต้อง และพร้อมสำหรับการวิเคราะห์ ต่อไปนี้เป็นเทคนิคสำคัญบางประการในการเพิ่มประสิทธิภาพในการดึงข้อมูล:

- การประมวลผลแบบขนาน : ใช้การประมวลผลแบบขนานเพื่อกระจายงานการแยกข้อมูลไปยังเธรดหรือเครื่องต่างๆ เพิ่มความเร็วในการดึงข้อมูลโดยการจัดการคำขอหลายรายการพร้อมกัน และลดเวลาโดยรวมที่ต้องใช้ในการรวบรวมข้อมูล

- การรวบรวมข้อมูลส่วนเพิ่ม : ใช้การรวบรวมข้อมูลส่วนเพิ่มเพื่ออัปเดตเฉพาะส่วนของชุดข้อมูลที่มีการเปลี่ยนแปลงนับตั้งแต่การรวบรวมข้อมูลครั้งล่าสุด ลดปริมาณข้อมูลที่ประมวลผลและโหลดบนเว็บเซิร์ฟเวอร์ ทำให้กระบวนการรวบรวมข้อมูลมีประสิทธิภาพมากขึ้นและใช้ทรัพยากรน้อยลง

- เบราว์เซอร์แบบไม่มีส่วนหัว : ใช้เบราว์เซอร์แบบไม่มีส่วนหัว เช่น Puppeteer หรือ Selenium เพื่อเรนเดอร์และโต้ตอบกับเนื้อหาเว็บแบบไดนามิก ช่วยให้สามารถดึงข้อมูลจากเว็บไซต์ที่ต้องอาศัย JavaScript และ AJAX จำนวนมากได้อย่างแม่นยำ ทำให้มั่นใจได้ว่าการรวบรวมข้อมูลจะครอบคลุม

- การจัดลำดับความสำคัญของเนื้อหา : จัดลำดับความสำคัญของเนื้อหาตามความเกี่ยวข้องและความสำคัญ โดยเน้นไปที่ข้อมูลที่มีมูลค่าสูงเป็นอันดับแรก เพื่อให้มั่นใจว่าข้อมูลที่สำคัญที่สุดจะถูกรวบรวมทันที และเพิ่มประสิทธิภาพการใช้ทรัพยากรและความเกี่ยวข้องของข้อมูล

- นโยบายการตั้งเวลา URL และนโยบายความสุภาพ : ใช้การตั้งเวลา URL อัจฉริยะและนโยบายความสุภาพเพื่อจัดการความถี่ของการร้องขอไปยังเซิร์ฟเวอร์เดียว ป้องกันเว็บเซิร์ฟเวอร์ที่ทำงานหนักเกินไป และลดความเสี่ยงของการบล็อก IP เพื่อให้มั่นใจถึงการเข้าถึงแหล่งข้อมูลอย่างยั่งยืน

- การขจัดข้อมูลซ้ำซ้อน : ใช้เทคนิคการขจัดข้อมูลซ้ำซ้อนเพื่อกำจัดรายการที่ซ้ำกันในระหว่างกระบวนการแยกข้อมูล ปรับปรุงคุณภาพข้อมูล และลดความต้องการในการจัดเก็บข้อมูลโดยรับรองว่าจะมีการจัดเก็บและประมวลผลเฉพาะข้อมูลที่ไม่ซ้ำกันเท่านั้น

โซลูชั่นการรวบรวมข้อมูลเว็บแบบเรียลไทม์

ที่มา: ปานกลาง

ในโลกดิจิทัลที่เปลี่ยนแปลงอย่างรวดเร็วในปัจจุบัน ความสามารถในการแยกและประมวลผลข้อมูลแบบเรียลไทม์คือ

สำคัญสำหรับธุรกิจที่ต้องการรักษาความได้เปรียบทางการแข่งขัน โซลูชันการรวบรวมข้อมูลเว็บแบบเรียลไทม์ช่วยให้สามารถรวบรวมข้อมูลได้อย่างต่อเนื่องและทันที ทำให้สามารถวิเคราะห์และดำเนินการได้ทันที การใช้สถาปัตยกรรมที่ขับเคลื่อนด้วยเหตุการณ์สามารถเพิ่มประสิทธิภาพความสามารถแบบเรียลไทม์ได้อย่างมาก โดยที่โปรแกรมรวบรวมข้อมูลจะถูกกระตุ้นโดยเหตุการณ์เฉพาะหรือการเปลี่ยนแปลงบนเว็บ ทำให้มั่นใจได้ว่าข้อมูลจะถูกรวบรวมทันทีที่พร้อมใช้งาน

ความสามารถในการปรับขนาดในการรวบรวมข้อมูลเว็บหลายภาษา

ธรรมชาติของอินเทอร์เน็ตทั่วโลกทำให้จำเป็นต้องมีความสามารถในการรวบรวมข้อมูลและประมวลผลข้อมูลในหลายภาษา ทำให้เกิดความท้าทายเฉพาะตัวที่ต้องใช้โซลูชันเฉพาะทาง การรวบรวมข้อมูลการดำเนินการของเว็บไซต์เพื่อจัดการเนื้อหาหลายภาษาเกี่ยวข้องกับการใช้อัลกอริธึมการตรวจจับภาษาเพื่อระบุภาษาของหน้าเว็บโดยอัตโนมัติ และให้แน่ใจว่ามีการใช้เทคนิคการประมวลผลเฉพาะภาษาที่เหมาะสม การใช้ไลบรารีการแยกวิเคราะห์และเฟรมเวิร์กที่รองรับหลายภาษา เช่น BeautifulSoup มอบเครื่องมือที่มีประสิทธิภาพสำหรับการดึงเนื้อหาจากหน้าเว็บที่หลากหลาย การรวมบริการแปลที่ปรับขนาดได้ เช่น Google Cloud Translation เข้ากับไปป์ไลน์การประมวลผลข้อมูลทำให้สามารถแปลเนื้อหาได้แบบเรียลไทม์ ช่วยให้วิเคราะห์ภาษาต่างๆ ได้อย่างราบรื่น

บทสรุป

ที่มา: groupbwt

เมื่อเราก้าวเข้าสู่ยุคดิจิทัลมากขึ้น ความสำคัญของการรวบรวมข้อมูลเว็บไซต์สำหรับแอปพลิเคชันข้อมูลขนาดใหญ่ยังคงเพิ่มขึ้นอย่างต่อเนื่อง อนาคตของการรวบรวมข้อมูลเว็บอยู่ที่ความสามารถในการปรับขนาดอย่างมีประสิทธิภาพ ปรับให้เข้ากับสภาพแวดล้อมเว็บแบบไดนามิก และให้ข้อมูลเชิงลึกแบบเรียลไทม์ ความก้าวหน้าในปัญญาประดิษฐ์และการเรียนรู้ของเครื่องจักรจะมีบทบาทสำคัญในการเพิ่มขีดความสามารถของโปรแกรมรวบรวมข้อมูลเว็บ ทำให้ฉลาดขึ้นและมีประสิทธิภาพมากขึ้นในการประมวลผลข้อมูลจำนวนมหาศาล

การบูรณาการระบบแบบกระจายและโครงสร้างพื้นฐานบนคลาวด์จะช่วยปรับปรุงความสามารถในการปรับขนาดให้ดียิ่งขึ้น ช่วยให้ธุรกิจสามารถจัดการชุดข้อมูลที่มีขนาดใหญ่ขึ้นได้อย่างง่ายดาย เนื่องจากเทคโนโลยีการรวบรวมข้อมูลเว็บยังคงมีการพัฒนาอย่างต่อเนื่อง เทคโนโลยีเหล่านี้จะไม่เพียงปรับปรุงกระบวนการรวบรวมข้อมูลเท่านั้น แต่ยังรับประกันว่าธุรกิจต่างๆ จะสามารถรักษาความได้เปรียบทางการแข่งขันในภูมิทัศน์ทางดิจิทัลที่เปลี่ยนแปลงอยู่ตลอดเวลา

การเปิดรับความก้าวหน้าเหล่านี้ไม่ได้เป็นเพียงทางเลือก แต่เป็นความจำเป็นสำหรับองค์กรที่มุ่งหวังที่จะใช้ประโยชน์จากข้อมูลขนาดใหญ่อย่างมีประสิทธิภาพ อนาคตของการรวบรวมข้อมูลเว็บสัญญาว่าจะเป็นพลังแห่งการเปลี่ยนแปลง ขับเคลื่อนนวัตกรรม และมอบเครื่องมือที่จำเป็นในการปลดล็อกศักยภาพของระบบนิเวศข้อมูลเว็บอันกว้างใหญ่

ยกระดับแอปพลิเคชันข้อมูลขนาดใหญ่ของคุณไปอีกระดับด้วยบริการขูดเว็บที่ปรับแต่งได้ของ PromptCloud พร้อมการผสานรวมและความสามารถในการปรับขนาดที่ราบรื่น ติดต่อเราวันนี้เพื่อควบคุมพลังของการรวบรวมข้อมูลเว็บขั้นสูงสำหรับธุรกิจของคุณ