AI ที่อธิบายได้สามารถปลดล็อกการพัฒนาปัญญาประดิษฐ์ที่มีความรับผิดชอบและมีจริยธรรมได้อย่างไร

เผยแพร่แล้ว: 2023-09-01ด้วยช่วงเวลาแห่งการเปลี่ยนแปลงที่ผสมผสานนวัตกรรมและความเฉลียวฉลาดเข้าด้วยกัน เช่น การเปิดตัว ChatGPT ของ OpenAI ในเดือนพฤศจิกายน 2565 วิสัยทัศน์ของ AI ที่ควบคุมชีวิตของเราจึงไม่ใช่นิยายวิทยาศาสตร์อีกต่อไป

ช่วงเวลาสำคัญในการเปิดตัว ChatGPT นำมาซึ่งสิ่งที่อุตสาหกรรมเรียกว่า 'AI Cambrian Explosion'

อย่างไรก็ตาม เป็นมากกว่าการใช้ AI เพื่อผลประโยชน์ทางธุรกิจ ซึ่งเป็นจุดสนใจในปัจจุบันของการระเบิดครั้งนี้ หัวใจสำคัญของวิวัฒนาการนี้คือการเรียกร้องให้มุ่งเน้นไปที่ความสามารถในการอธิบายของ AI นั่นจะช่วยให้มั่นใจได้ว่าความก้าวหน้าใน AI นั้นทั้งทรงพลังและโปร่งใส ซึ่งเป็นพื้นฐานสำหรับการพัฒนา AI อย่างมีจริยธรรม

ปัญญาประดิษฐ์กำลังตัดสินใจแทนเราในหลายๆ ด้านแล้ว แต่การไม่เข้าใจว่า AI เข้าถึงการตัดสินใจเหล่านั้นได้อย่างไรยังคงเป็นปัญหาคอขวด นี่คือข้อดีประการหนึ่งของ AI ที่สามารถอธิบายได้ซึ่งผู้ประกอบการและผู้เชี่ยวชาญด้านเทคโนโลยีไม่สามารถละเลยได้

เมื่อเทคโนโลยีก้าวหน้าไป ความท้าทายของผู้เชี่ยวชาญด้านเทคโนโลยีก็เพิ่มขึ้นเป็นสองเท่า นั่นคือ การผลักดันขอบเขตของสิ่งที่ AI สามารถทำได้ ขณะเดียวกันก็รับประกันว่าการทำงานของ AI จะโปร่งใส มีความรับผิดชอบ และมีจริยธรรม สิ่งนี้เน้นให้เห็นถึงบทบาทของ AI ที่อธิบายได้ในเทคโนโลยีสมัยใหม่

ศักยภาพทางเศรษฐกิจของ AI

ศักยภาพของ Generative AI ในการปฏิวัติประสิทธิภาพการผลิตไม่ได้เป็นเพียงทฤษฎีเท่านั้น คาดว่าจะมีการกระจายสาขาทางเศรษฐกิจที่จับต้องได้ในระดับโลก ตามรายงานเดือนมิถุนายน 2566 หัวข้อ “ศักยภาพทางเศรษฐกิจของ generative AI: ขอบเขตการผลิตครั้งต่อไป” ที่เผยแพร่โดย McKinsey generative AI สามารถเพิ่มมูลค่าได้ตั้งแต่ 2.6 ล้านล้านดอลลาร์ถึง 4.4 ล้านล้านดอลลาร์ต่อปีในกรณีการใช้งานที่วิเคราะห์ 63 กรณี นอกจากนี้ยังมีกรณีการใช้งาน AI ที่อธิบายได้ซึ่งเป็นประโยชน์ต่ออุตสาหกรรมในรูปแบบใหม่ๆ มากมาย

อ่านเพิ่มเติม: Generative AI สำหรับธุรกิจกำลังกำหนดรูปแบบอุตสาหกรรมอย่างไร

หนังสือพิมพ์วอชิงตันโพสต์รายงานว่าบริษัทมากกว่า 11,000 แห่งใช้เครื่องมือ OpenAI ที่แผนกคลาวด์ของ Microsoft มอบให้ โดยเน้นถึงแนวโน้มการใช้งานที่มาพร้อมกับศักยภาพนี้ ตัวเลขเหล่านี้แสดงถึงโอกาสและความรับผิดชอบสำหรับผู้นำด้านเทคโนโลยีที่ต้องรับมือกับภูมิทัศน์ที่เปลี่ยนแปลงไปนี้

เมื่อศักยภาพในการเปลี่ยนแปลงของ AI ปรากฏชัด จึงมีการเน้นมากขึ้นเรื่อยๆ ในหลักการ AI ที่อธิบายได้ เพื่อให้มั่นใจว่าเครื่องมืออันทรงพลังเหล่านี้ทำงานด้วยความชัดเจน การกำกับดูแล และการพิจารณาตามหลักจริยธรรม แอปพลิเคชัน AI ที่สามารถอธิบายได้ถูกกำหนดให้เป็นรากฐานที่สำคัญในอุตสาหกรรมเทคโนโลยี

อย่างไรก็ตาม การทำความเข้าใจคุณประโยชน์ของ AI ที่อธิบายได้และแง่มุมอื่นๆ ที่เกี่ยวข้องเป็นเพียงจุดเริ่มต้นเท่านั้น ดังนั้น ก่อนที่เราจะพูดถึงความแตกต่างของการพัฒนา AI ที่อธิบายได้โดยละเอียด เราต้องเข้าใจก่อนว่าเหตุใดจึงจำเป็น

ความลึกลับของโมเดล AI: การนำทาง 'กล่องดำ'

เช่นเดียวกับความก้าวหน้าที่สำคัญทั้งหมด AI นำมาซึ่งความท้าทาย บางอย่างเกี่ยวข้องกับโครงสร้างของมันอย่างลึกซึ้ง ด้านหนึ่งของความลึกลับนี้คือ 'กล่องดำ' เป็นตัวแทนของโมเดลการดำเนินงานแบบปิดซึ่งใช้งานได้ แต่บางครั้งนักพัฒนาก็ไม่สามารถอธิบายวิธีการทำงานได้ สิ่งนี้เรียกว่าปริศนากล่องดำในอุตสาหกรรม AI

การขาดความโปร่งใสนี้เป็นสิ่งที่ยอมรับไม่ได้สำหรับหลาย ๆ คน โดยเฉพาะผู้ที่รับผิดชอบต่อการตัดสินใจทางธุรกิจหรือการตัดสินใจทางสังคมที่สำคัญ AI ที่ทำงานโดยไม่มีคำอธิบายอาจเสี่ยงต่อการทำลายความไว้วางใจ โดยเฉพาะอย่างยิ่งเมื่อสูญเสียทั้งทางกายภาพและทางวัตถุ

ผลที่ตามมาที่คาดไม่ถึง: เมื่อ AI หลุดออกจากราง

ผลที่ตามมาจากการตัดสินใจของ AI ที่ไม่สามารถอธิบายได้อาจมีตั้งแต่ความไร้ประสิทธิภาพเล็กน้อยไปจนถึงผลกระทบทางสังคมที่สำคัญ พิจารณาภาคการเงิน: ระบบ AI อาจปฏิเสธการให้กู้ยืมแก่บุคคลโดยไม่ต้องให้เหตุผลที่ชัดเจน

การตัดสินใจดังกล่าวซึ่งปราศจากความโปร่งใส อาจนำไปสู่ปัญหาทางกฎหมายและความเสียหายต่อชื่อเสียงได้ ในวงกว้างในการดูแลสุขภาพ AI ที่ไม่น่าเชื่อถืออาจจัดลำดับความสำคัญของผู้ป่วยรายหนึ่งมากกว่าอีกรายหนึ่งเพื่อรับการรักษา โดยมีการเปลี่ยนแปลงชีวิตหรือแม้แต่การแตกสาขาที่สิ้นสุดชีวิต

ตัวอย่างผลลัพธ์ AI ที่ไม่คาดคิดและอุบัติเหตุในโลกแห่งความเป็นจริง

เหตุการณ์ต่างๆ มากมายเน้นย้ำถึงผลลัพธ์ที่ไม่คาดคิดของ AI เหตุการณ์โศกนาฏกรรมในปี 2018 ที่เกี่ยวข้องกับรถยนต์ไร้คนขับของ Uber ตอกย้ำผลกระทบร้ายแรงเมื่อ AI ตีความสภาพแวดล้อมของตนผิด อัลกอริธึมด้านการดูแลสุขภาพที่โดดเด่นซึ่งพบว่ามีอคติทางเชื้อชาติเป็นเครื่องเตือนใจว่า AI แม้จะก้าวหน้าไปมากเพียงใด ก็สามารถขยายอคติของมนุษย์โดยไม่ตั้งใจได้ หากไม่เข้าใจและติดตามอย่างเพียงพอ

รายชื่อดังกล่าวดำเนินต่อไป ตั้งแต่ Tay ของ Microsoft ที่ทวีตข้อความต่างๆ เช่น “ฮิตเลอร์พูดถูก” ไปจนถึงชาวอเมริกันที่ได้รับใบเรียกเก็บเงินค่าบัตรเครดิตมากมาย หากไม่มีราวกั้นและความสามารถในการตีความการตัดสินใจของ AI เหตุการณ์ดังกล่าวจะเกิดขึ้นต่อไป ดังนั้นจึงจำเป็นต้องมีคำอธิบาย

กรณีธุรกิจ: ประโยชน์ของ AI ที่อธิบายได้

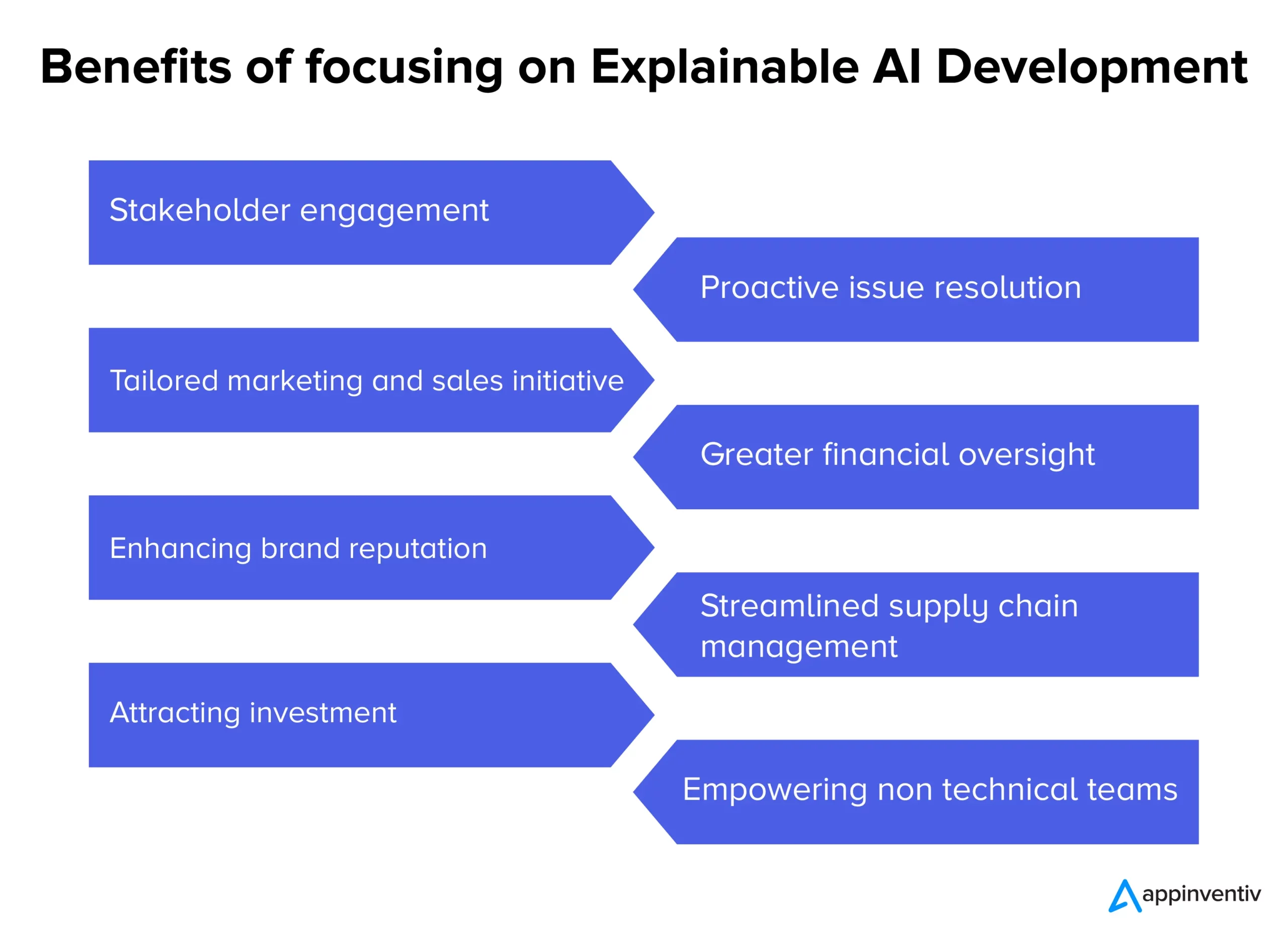

ในขณะที่ระบบ AI ขับเคลื่อนความทะเยอทะยานมากขึ้น ความคลุมเครือโดยธรรมชาติของพวกมันได้กระตุ้นให้เกิดการสนทนาเกี่ยวกับความจำเป็นเพื่อความโปร่งใส นอกเหนือจากวาทกรรมทางเทคนิคแล้ว ยังมีเหตุผลทางธุรกิจที่แข็งแกร่งซึ่งสนับสนุนการนำ AI ที่สามารถอธิบายได้มาใช้ ต่อไปนี้คือคุณประโยชน์ต่างๆ ของ AI ที่สามารถอธิบายได้สำหรับธุรกิจในอุตสาหกรรมต่างๆ

- การมีส่วนร่วมและความมั่นใจของผู้มีส่วนได้ส่วนเสีย: กระบวนการตัดสินใจของ AI ที่โปร่งใสสามารถส่งเสริมความรู้สึกมีส่วนร่วมและความมั่นใจอย่างลึกซึ้งยิ่งขึ้นระหว่างทีมภายในและพันธมิตรภายนอก

- การแก้ไขปัญหาเชิงรุก: ก่อนที่ปัญหาจะบานปลาย AI ที่อธิบายได้สามารถเน้นประเด็นที่อาจน่ากังวล ทำให้เกิดการแทรกแซงและแนวทางแก้ไขได้ทันท่วงที

- ความคิดริเริ่มด้านการตลาดและการขายที่ปรับให้เหมาะสม: ธุรกิจสามารถสร้างแคมเปญที่เป็นส่วนตัวและมีประสิทธิภาพมากขึ้น โดยการทำความเข้าใจ 'สาเหตุ' ที่อยู่เบื้องหลังข้อมูลเชิงลึกของผู้บริโภคที่ขับเคลื่อนด้วย AI

- การกำกับดูแลทางการเงินที่มากขึ้น: เมื่อแบบจำลองทางการเงินและการคาดการณ์ที่ขับเคลื่อนด้วย AI มีความโปร่งใส ความผิดปกติที่อาจเกิดขึ้นหรือขอบเขตการเติบโตจะสามารถระบุและแก้ไขได้ง่ายขึ้น

- การเพิ่มชื่อเสียงของแบรนด์: บริษัทที่รู้จักกันดีในเรื่องการใช้งาน AI อย่างมีจริยธรรมและโปร่งใส มีแนวโน้มที่จะได้รับชื่อเสียงของแบรนด์ที่เพิ่มมากขึ้น

- การจัดการห่วงโซ่อุปทานที่คล่องตัว: ด้วยข้อมูลเชิงลึกที่ขับเคลื่อนด้วย AI ที่ชัดเจน กระบวนการห่วงโซ่อุปทานสามารถเพิ่มประสิทธิภาพได้อย่างมีประสิทธิภาพมากขึ้น ตั้งแต่การจัดการสินค้าคงคลังไปจนถึงการขนส่ง

- การดึงดูดการลงทุน: สำหรับนักลงทุน ความโปร่งใสใน AI สามารถบ่งบอกถึงความมุ่งมั่นของบริษัทในการสร้างนวัตกรรมที่มีความรับผิดชอบ ทำให้กลายเป็นข้อเสนอการลงทุนที่น่าดึงดูดยิ่งขึ้น

- เสริมศักยภาพให้กับทีมที่ไม่ใช่ด้านเทคนิค: AI ที่อธิบายได้ทำให้มั่นใจได้ว่าข้อมูลเชิงลึกและการตัดสินใจที่ขับเคลื่อนด้วย AI สามารถเข้าถึงได้และดำเนินการได้สำหรับทีมที่ไม่มีความเชี่ยวชาญทางเทคนิคเชิงลึก ส่งเสริมการทำงานร่วมกันข้ามแผนก

ในขณะที่บริษัทต่างๆ ต้องเผชิญกับภูมิทัศน์ที่ซับซ้อนในยุคสมัยใหม่ การพึ่งพาโซลูชันกล่องดำอาจเป็นการพนันได้ การเติมความโปร่งใสเข้าไปในกระบวนการ AI ไม่ใช่แค่การอัพเกรดทางเทคโนโลยีเท่านั้น มันเป็นความจำเป็นทางธุรกิจ เพื่อให้แน่ใจว่าการเคลื่อนไหวที่ได้รับการสนับสนุนจาก AI ทุกครั้งจะสอดคล้องกับวัตถุประสงค์และค่านิยมขององค์กรที่กว้างขึ้น ซึ่งแสดงถึงบทบาทของ AI ที่สามารถอธิบายได้ นี่เป็นกรณีการใช้งาน AI ที่สามารถอธิบายได้ซึ่งผู้ประกอบการและนักพัฒนา AI มักให้ความสำคัญ

พิมพ์เขียวสำหรับโมเดล AI ที่สามารถอธิบายได้

ขณะนี้ผลกระทบของ AI ในชีวิตประจำวันของเราเริ่มชัดเจนมากขึ้นในแต่ละวันที่ผ่านไป สิ่งสำคัญคือต้องแน่ใจว่าเครื่องจักรที่เราไว้วางใจในการตัดสินใจที่สำคัญนั้นถูกต้องและโปร่งใสในการทำงาน

การพัฒนาโมเดล AI ที่อธิบายได้ไม่ใช่แค่การเขียนโค้ดเท่านั้น เป็นกระบวนการที่เกี่ยวข้องกับการวางแผนเชิงกลยุทธ์ การทดสอบที่เข้มงวด และการปรับแต่งซ้ำตามหลักการ AI ที่อธิบายได้และเครื่องมือ AI ที่อธิบายได้ ต่อไปนี้เป็นคำแนะนำทีละขั้นตอนและเทคนิค AI ที่อธิบายได้ เพื่อให้แน่ใจว่าโมเดล AI ที่เราพัฒนานั้นสามารถอธิบายและตีความได้ ในขณะเดียวกันก็ปฏิบัติตามกฎหมายด้วย

- การทำความเข้าใจขอบเขตของปัญหา: ก่อนที่จะเจาะลึกถึงการพัฒนาแบบจำลอง เราเข้าใจอย่างชัดเจนถึงขอบเขตของปัญหาและผู้มีส่วนได้ส่วนเสียที่เกี่ยวข้อง ผู้ใช้คาดหวังอะไร? AI จะทำการตัดสินใจอะไร และการตัดสินใจเหล่านี้จะมีผลกระทบอย่างไรคือคำถามบางข้อที่เราพบคำตอบ

- การเลือกข้อมูลที่เหมาะสม: คุณภาพและความเกี่ยวข้องของข้อมูลส่งผลโดยตรงต่อความสามารถของ AI ในความแม่นยำและอธิบายได้ ในการพัฒนาโมเดล AI ของเรา เรารับรองว่าข้อมูลจะสะอาด หลากหลาย และปราศจากอคติ

- การเลือกโมเดลที่เหมาะสม: แม้ว่าบางโมเดล เช่น โครงข่ายประสาทเทียมระดับลึก จะซับซ้อนกว่าและตีความได้ยากกว่า แต่โมเดลอื่นๆ เช่น แผนผังการตัดสินใจหรือการถดถอยเชิงเส้น สามารถให้ความโปร่งใสได้มากกว่า เราเลือกความสมดุลระหว่างความซับซ้อนและความชัดเจนในขณะที่พัฒนาโมเดล AI ที่อธิบายได้

- การทดสอบซ้ำ: เราทดสอบโมเดลด้วยชุดข้อมูลที่หลากหลายเป็นประจำเพื่อให้มั่นใจถึงประสิทธิภาพที่สม่ำเสมอ ผลตอบรับจากการทดสอบเหล่านี้สามารถแจ้งถึงการปรับแต่งและการปรับปรุงได้

- การบูรณาการเครื่องมือที่สามารถอธิบายได้: เครื่องมืออย่าง LIME หรือ SHAP ช่วยแยกย่อยการทำนายแบบจำลอง โดยให้ข้อมูลเชิงลึกว่าคุณลักษณะใดมีอิทธิพลต่อการตัดสินใจโดยเฉพาะ

- เอกสารประกอบ: เอกสารที่ครอบคลุมช่วยเราในการตรวจสอบโมเดล การตรวจสอบความถูกต้อง และการปรับใช้ ช่วยให้ผู้มีส่วนได้ส่วนเสียทั้งหมดเข้าใจการทำงานและข้อจำกัดของ AI ตั้งแต่นักพัฒนาไปจนถึงผู้ใช้ปลายทาง

ปรับสมดุลประสิทธิภาพของโมเดลด้วยการตีความ

หนึ่งในความท้าทายที่สำคัญที่สุดในการพัฒนาซอฟต์แวร์ AI ที่สามารถอธิบายได้คือการสร้างสมดุลระหว่างประสิทธิภาพของโมเดลและความสามารถในการตีความ แม้ว่าโมเดลที่ซับซ้อนอาจให้ความแม่นยำที่สูงกว่า แต่ก็มักจะทำเช่นนั้นโดยแลกกับความโปร่งใส ในทางกลับกัน โมเดลที่เรียบง่ายอาจเข้าใจได้ง่ายกว่า แต่อาจไม่สามารถจับความแตกต่างภายในข้อมูลได้อย่างมีประสิทธิภาพ เพื่อให้เกิดความสมดุลที่เหมาะสม เราจะพิจารณาสิ่งต่อไปนี้:

- ความเรียบง่ายของโมเดลเทียบกับความซับซ้อน: เรากำหนดระดับความซับซ้อนขั้นต่ำที่จำเป็นเพื่อให้ได้ประสิทธิภาพที่น่าพอใจ หากแบบจำลองที่ง่ายกว่านั้นเพียงพอ อาจเป็นทางเลือกที่ดีกว่าเพื่อให้มั่นใจว่าสามารถอธิบายได้

- การใช้เทคนิคการอธิบาย: เทคนิคเช่นการจัดอันดับความสำคัญของคุณลักษณะหรือวิธีการไม่เชื่อเรื่องโมเดลสามารถช่วยทำให้โมเดลที่ซับซ้อนสามารถตีความได้มากขึ้น

- ลูปคำติชม: เรารักษาลูปคำติชมอย่างต่อเนื่องกับผู้ใช้ปลายทางเพื่อทำความเข้าใจว่าการตัดสินใจของ AI นั้นชัดเจนหรือไม่ และมีพื้นที่สำหรับเพิ่มความโปร่งใสหรือไม่

แม้ว่าการเดินทางไปสู่การบรรลุ AI ที่อธิบายได้อาจดูซับซ้อน แต่ก็จำเป็น ในขณะที่เรารวม AI เข้ากับระบบและกระบวนการของเราเพิ่มเติม การรับรองว่าโมเดลประสิทธิภาพสูงและโปร่งใสเหล่านี้จะมีความสำคัญอย่างยิ่งต่อความไว้วางใจและประสิทธิภาพที่ยั่งยืน

Appinventiv จะช่วยคุณในการพัฒนาโมเดล AI ที่สามารถอธิบายได้อย่างไร

ด้วยประสบการณ์เกือบเก้าปีในการพัฒนาผลิตภัณฑ์ AI พวกเราที่ Appinventiv เข้าใจความซับซ้อนต่างๆ ที่เกี่ยวข้องกับการพัฒนาแบบจำลอง AI และคุณประโยชน์ของ AI ที่สามารถอธิบายได้ หลังจากพัฒนาแพลตฟอร์มและแอปที่ใช้ AI มากมาย รวมถึง Mudra (แอปการเงินส่วนบุคคลที่ขับเคลื่อนด้วย AI) วิศวกรของเราจึงมีความเชี่ยวชาญเฉพาะด้านและกำกับดูแลเพื่อก้าวไปสู่การพัฒนา AI ที่สามารถอธิบายได้

ไม่ว่าโครงการ AI ของคุณจะเป็นเช่นไร เราในฐานะบริษัทพัฒนา AI ชั้นนำ สามารถปลดล็อกความสามารถในการตีความและการอธิบายสำหรับโมเดล AI ของคุณ เพื่อให้คุณสามารถไว้วางใจการตัดสินใจของโมเดลได้อย่างมั่นใจ ติดต่อวันนี้เพื่อเริ่มต้นการเดินทางสู่ AI ที่มีความรับผิดชอบ

คำถามที่พบบ่อย

ถาม AI ที่อธิบายได้คืออะไร

A. AI ที่อธิบายได้คือการเปลี่ยนกระบวนทัศน์ในการพัฒนา AI ที่เรียกร้องให้มีการพัฒนาโมเดล AI ในลักษณะที่สามารถย้อนการตัดสินใจของโมเดล AI ได้ และผู้ใช้สามารถเข้าใจได้ว่าโมเดล AI ตัดสินใจอย่างไร

ถาม AI ที่อธิบายได้ทำงานอย่างไร

A. AI ที่อธิบายได้ทำงานโดยการรวมองค์ประกอบสำคัญของความสามารถในการอธิบายเข้ากับโมเดล AI ในระหว่างการพัฒนา ซึ่งสามารถช่วยระบุได้ว่าโมเดล AI บรรลุการตัดสินใจโดยเฉพาะได้อย่างไร

ถาม เหตุใด AI ที่อธิบายได้จึงมีความสำคัญ

ตอบ AI ที่อธิบายได้มีความสำคัญเนื่องจากการไม่เข้าใจว่าโมเดล AI ตัดสินใจแทนเราได้อย่างไร อาจนำไปสู่ผลลัพธ์ร้ายแรง และในกรณีที่เลวร้ายที่สุด อาจหมายถึงความเสียหายที่จับต้องได้ต่อบริษัทหรือผู้ใช้โมเดล AI ที่เป็นปัญหา