วิธีหลีกเลี่ยงการละเมิดข้อกำหนดในขณะที่พัฒนาผลิตภัณฑ์ AI

เผยแพร่แล้ว: 2023-06-12ปัญญาประดิษฐ์ยังคงเป็นเทรนด์เทคโนโลยีอันดับต้น ๆ เป็นเวลาหลายปีผ่านการมีส่วนร่วมในภาคข้อมูลและเครื่องจักรที่เข้มข้น เช่น การผลิต การดูแลสุขภาพ และการเงิน อย่างไรก็ตาม ในช่วงสองปีที่ผ่านมาเทคโนโลยีได้รับความสนใจอย่างสูงจากผู้ใช้ปลายทาง ด้วยแอปพลิเคชัน เช่น โปรแกรมสร้างภาพและข้อความ ผู้คนสามารถสร้างภาพและข้อความได้ในคลิกเดียว

แม้ว่าดูเหมือนว่าแพลตฟอร์ม AI เหล่านี้กำลังผลิตเนื้อหาตั้งแต่ต้น แต่นั่นไม่ใช่เลย – แพลตฟอร์ม AI เหล่านี้ได้รับการฝึกอบรมเกี่ยวกับส่วนย่อยของคำถามและ Data Lake ที่ทำงานโดยการประมวลผลที่เก็บถาวรของข้อความและรูปภาพจากอินเทอร์เน็ต แม้ว่าจะมีประโยชน์สำหรับผู้ใช้ปลายทาง แต่แนวทางดังกล่าวก็มาพร้อมกับความเสี่ยงทางกฎหมาย เช่น การละเมิดลิขสิทธิ์ การไม่ปฏิบัติตามใบอนุญาตโอเพ่นซอร์ส และการละเมิดทรัพย์สินทางปัญญา เป็นต้น ความเสี่ยงเหล่านี้ที่เกิดจาก AI กำเนิดไม่ได้มองไม่เห็นโดยรัฐบาลทั่วโลกซึ่งกำลังเกิดขึ้นอย่างต่อเนื่อง ด้วยกฎใหม่และบทลงโทษเกี่ยวกับโมเดล AI ที่ผิดจรรยาบรรณ

สำหรับบริษัทที่เตรียมเปิดตัวโครงการ AI จำเป็นอย่างยิ่งที่จะต้องเข้าใจความเสี่ยงและสร้างระบบที่ไม่อยู่ภายใต้เรดาร์ทางกฎหมายที่อยู่เบื้องหลังประเด็นด้านจริยธรรมเหล่านี้ ในบทความนี้ เราจะเจาะลึกแง่มุมต่างๆ ของการปฏิบัติตามข้อกำหนดของ AI ในระหว่างการพัฒนาซอฟต์แวร์ – ประเภทของปัญหาทางกฎหมาย วิธีเตรียมตัวสำหรับกฎระเบียบของ AI และการดำเนินการของ AI ตามภูมิภาคต่างๆ

AI Compliance คืออะไร?

เป็นกระบวนการที่ทำให้แอปพลิเคชันที่ขับเคลื่อนด้วย AI เป็นไปตามข้อบังคับและกฎหมายของภูมิภาคที่ดำเนินการอยู่ ต่อไปนี้คือปัจจัยต่างๆ การตรวจสอบการปฏิบัติตามข้อกำหนดของ AI ประกอบด้วย –

ปัญหาทางกฎหมายกับปัญญาประดิษฐ์

ในระดับจุลภาค อาจปรากฏว่าปัญหาเกี่ยวกับการใช้ AI ของผู้ใช้ปลายทางจำกัดอยู่ที่การลอกเลียนแบบหรือการเข้าถึงข้อมูลที่ไม่เปิดเผย แต่ในระดับมหภาคการไม่ปฏิบัติตามข้อกำหนดของ AI ทำให้เกิดความท้าทายที่ใหญ่กว่า

ภัยคุกคามที่เกิดจากการใช้ระบบ AI ที่สร้างขึ้นมาไม่ดีอาจส่งผลต่อการแข่งขันที่เป็นธรรม ความปลอดภัยในโลกไซเบอร์ การคุ้มครองผู้บริโภค และแม้แต่สิทธิพลเมือง ดังนั้นจึงเป็นเรื่องสำคัญที่บริษัทและรัฐบาลจะต้องสร้างแบบจำลองที่ยุติธรรมและมีจริยธรรม

ลิขสิทธิ์

เมื่อเริ่มมี AI กำเนิด ธุรกิจต่างๆ ได้เริ่มสร้างเนื้อหาลิขสิทธิ์ผ่านเทคโนโลยี ปัญหาของเรื่องนี้อยู่ที่การไม่เข้าใจว่าข้อมูลนั้นถูกสร้างขึ้นด้วยความคิดสร้างสรรค์ของผู้เขียนหรือไม่ หรือ AI เป็นผู้เขียนหรือไม่

เพื่อให้การดำเนินการนี้เป็นไปตามกฎหมาย สำนักงานลิขสิทธิ์ได้ออกคำแนะนำเกี่ยวกับการตรวจสอบและการลงทะเบียนงานที่มีเนื้อหาที่สร้างโดย AI มันระบุต่อไปนี้ -

- ลิขสิทธิ์สามารถปกป้องเนื้อหาที่เกิดจากความคิดสร้างสรรค์ของมนุษย์เท่านั้น

- ในกรณีของผลงานที่มีเนื้อหาเป็น AI จะมีการพิจารณาว่าผลงาน AI เป็นผลมาจาก "การผลิตซ้ำเชิงกล" หรือเป็น "แนวคิดดั้งเดิมของผู้เขียนเอง ซึ่งพวกเขาให้รูปแบบที่มองเห็นได้ผ่าน AI

- ผู้สมัครมีหน้าที่เปิดเผยความเกี่ยวข้องของเนื้อหาเกี่ยวกับ AI ในเอกสารที่ยื่นขอลงทะเบียน

อ่านเพิ่มเติม: ค่าใช้จ่ายในการพัฒนาเครื่องมือตรวจจับเนื้อหา AI ในปี 2566

โอเพ่นซอร์ส

เครื่องกำเนิดโค้ดที่ขับเคลื่อนด้วย AI มักใช้ AI เพื่อช่วยนักพัฒนาในการเติมข้อความอัตโนมัติหรือแนะนำโค้ดที่ด้านหลังของการทดสอบหรืออินพุตของนักพัฒนาซอฟต์แวร์ ต่อไปนี้คือความท้าทายบางประการที่เกี่ยวข้องกับการพัฒนาโมเดล AI ที่สอดคล้องกับตัวสร้างโค้ด

- การฝึกอบรมแบบจำลอง AI ด้วยรหัสโอเพ่นซอร์สหมายถึงการละเมิดหรือไม่?

- ใครเป็นผู้รับผิดชอบในการปฏิบัติตามเกณฑ์การปฏิบัติตามโอเพนซอร์ส – ผู้พัฒนาหรือผู้ใช้

- โค้ดที่ใช้ AI จะใช้โดยนักพัฒนาซอฟต์แวร์ที่สร้างซอฟต์แวร์ใหม่จำเป็นต้องให้แอปพลิเคชันได้รับอนุญาตภายใต้โอเพ่นซอร์สหรือไม่

การละเมิดทรัพย์สินทางปัญญา

มีการยื่นฟ้องการละเมิดลิขสิทธิ์หลายครั้งกับเครื่องมือ AI ทั่วโลก โดยกล่าวหาว่าพวกเขากำลังฝึกฝนแบบจำลองหรือสร้างผลลัพธ์บนพื้นฐานของเนื้อหาที่มีการป้องกัน IP ของบุคคลที่สาม

อคติทางจริยธรรม

มีเหตุการณ์มากมายที่เทคโนโลยีการจดจำใบหน้าของ AI นำไปสู่การเลือกปฏิบัติทางเชื้อชาติ ไม่ว่าจะเป็นกรณีที่ในปี 2020 คนผิวดำถูกจับเพราะความผิดพลาดของคอมพิวเตอร์ หรือ Google Photos ระบุว่าคนผิวดำเป็น “กอริลลา” ไม่ว่าเทคโนโลยีจะฉลาดเพียงใด ก็ไม่อาจละเลยได้ว่ามันถูกสร้างขึ้นโดยมนุษย์ที่มีอคติ

สำหรับบริษัทที่ต้องการสร้างโซลูชันที่คล้ายกัน จำเป็นอย่างยิ่งที่จะต้องไม่ปล่อยให้อคติเหล่านี้เข้ามาในระบบ

การปฏิบัติตาม GDPR สำหรับโครงการ AI

จากที่กล่าวมานี้ สิ่งสำคัญคือต้องเข้าใจว่าเหตุใดธุรกิจจึงไม่สามารถสร้างโมเดล AI ที่สอดคล้องได้แม้จะมีกฎระเบียบที่เข้มงวดก็ตาม อาจมีสาเหตุหลายประการ ตั้งแต่การไม่สามารถทราบการปฏิบัติตามข้อกำหนด การขาดความเข้าใจของนักพัฒนา และบางครั้งความไม่รู้ง่ายๆ อย่างไรก็ตาม อาจมีเหตุผลด้านการทำงานบางอย่างอยู่เบื้องหลังเช่นกัน

ให้เราพิจารณาบางส่วนจากมุมมองของการปฏิบัติตาม GDPR สำหรับโครงการ AI

ข้อจำกัดของวัตถุประสงค์

หลักการ GDPR ทำให้ธุรกิจจำเป็นต้องแจ้งให้เจ้าของข้อมูลทราบถึงวัตถุประสงค์ในการรวบรวมและประมวลผลข้อมูลของตน ความท้าทายในเรื่องนี้คือเทคโนโลยีใช้ข้อมูลเพื่อค้นหารูปแบบและรับข้อมูลเชิงลึกใหม่ๆ แต่นั่นอาจไม่ใช่จุดประสงค์ที่แท้จริงของข้อมูลนั้น

การเลือกปฏิบัติ

GDPR กำหนดให้นักพัฒนา AI ดำเนินการเพื่อต่อต้านผลกระทบจากการเลือกปฏิบัติที่เทคโนโลยีสามารถดำเนินการได้ แม้ว่าจะเป็นความต้องการด้านจริยธรรมในชั่วโมงนี้ แต่สำหรับนักพัฒนาที่ดำเนินสถานการณ์ทางสังคมที่เปลี่ยนแปลงอย่างรวดเร็ว การเตรียมโมเดล AI เพื่อรับมือกับการเลือกปฏิบัติและผลลัพธ์ที่ผิดศีลธรรมอาจกลายเป็นเรื่องท้าทาย

การย่อขนาดข้อมูล

GDPR กล่าวว่าข้อมูลที่รวบรวมควร "เพียงพอ จำกัด และมีความเกี่ยวข้อง" ซึ่งหมายความว่าทีมพัฒนา AI ควรระมัดระวังอย่างมากเมื่อใช้ข้อมูลสำหรับโมเดลของตน และต้องมีความชัดเจนเกี่ยวกับปริมาณข้อมูลที่จำเป็นสำหรับโครงการของตน

อย่างไรก็ตาม สิ่งนี้ไม่สามารถคาดเดาได้ ดังนั้นทีมจึงต้องประเมินประเภทข้อมูลและจำนวนข้อมูลอย่างสม่ำเสมอ ซึ่งพวกเขาต้องการเพื่อตอบสนองความต้องการในการลดข้อมูลให้เหลือน้อยที่สุด

ความโปร่งใส

ประการสุดท้าย ผู้ใช้ควรทราบว่าข้อมูลของพวกเขาถูกใช้โดยบุคคลที่สามอย่างไร ด้วยเหตุนี้ ธุรกิจต่างๆ จะต้องมีความชัดเจนว่าพวกเขาใช้ข้อมูลใดและอย่างไร

ปัญหาคือโมเดล AI ส่วนใหญ่ทำงานในกล่องดำ และยังไม่ชัดเจนว่าจะตัดสินใจอย่างไร โดยเฉพาะอย่างยิ่งเมื่อเราพูดถึงซอฟต์แวร์ขั้นสูง

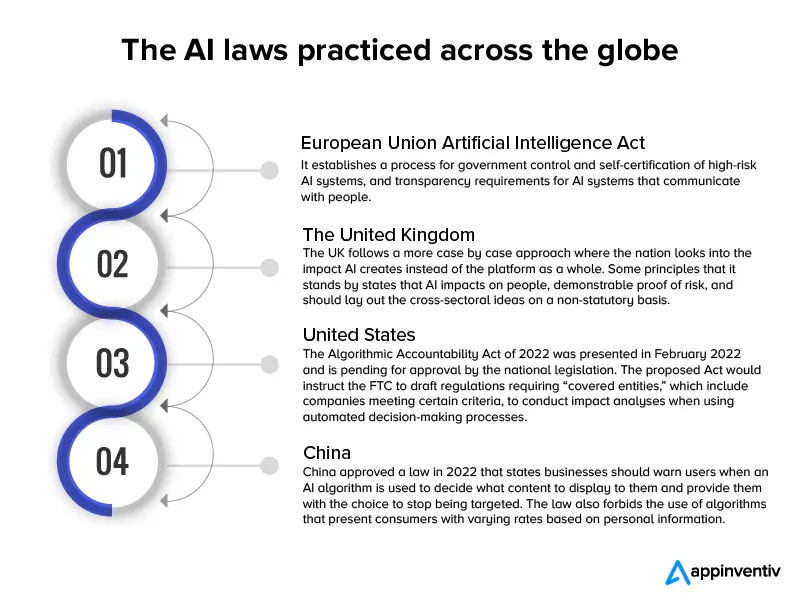

แม้ว่าสิ่งเหล่านี้ล้วนเป็นปัญหาทางเทคนิคที่แท้จริง แต่เมื่อพูดถึงจริยธรรมด้านไอที สิ่งสำคัญคือธุรกิจต่างๆ จะไม่ใช้สิ่งเหล่านี้เป็นเกราะป้องกันเพื่อพัฒนาโมเดล AI ที่มีข้อบกพร่อง เพื่อให้แน่ใจว่าการปฏิบัติจะไม่กลายเป็นกระแสหลัก กฎหมายเกี่ยวกับ AI หลายฉบับได้ถูกนำมาใช้ในระดับโลก

เกือบ 60 ประเทศได้เปิดตัวกฎหมายและข้อบังคับด้านปัญญาประดิษฐ์ตั้งแต่ปี 2560 ซึ่งเป็นแนวปฏิบัติที่สอดคล้องกับความเร็วของการนำโมเดล AI ใหม่มาใช้

นี่คืออินโฟกราฟิกที่ให้มุมมองสั้น ๆ เกี่ยวกับกฎหมายเหล่านั้น

ตอนนี้เราได้พิจารณาถึงความท้าทายของการพัฒนา AI จากมุมมองทางกฎหมายและร่างกฎหมายที่บังคับใช้อย่างคร่าว ๆ ในระดับโลกแล้ว ให้เรามาดูวิธีสร้างแอปพลิเคชัน AI ที่สอดคล้องกัน

อ่านเพิ่มเติม: การพัฒนา chatbot ที่เป็นไปตามกฎหมายเช่น ChatGPT มีค่าใช้จ่ายเท่าใด

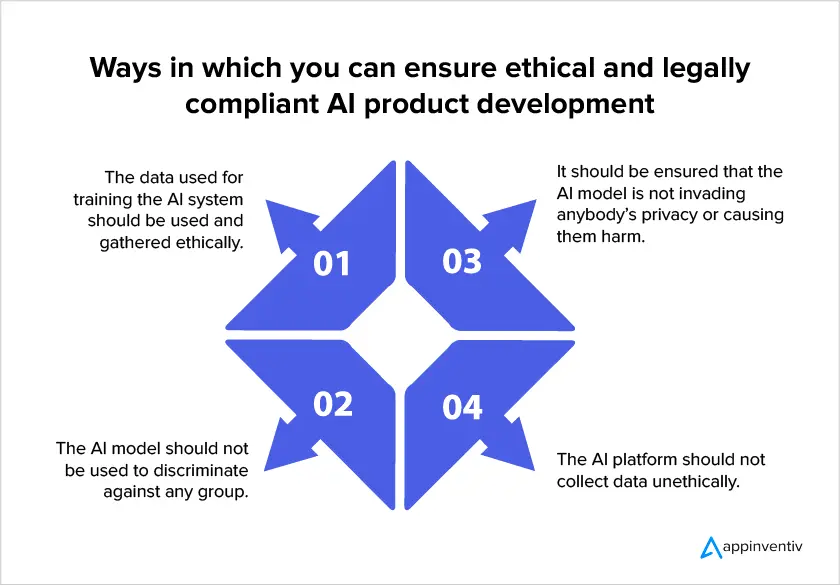

วิธีพัฒนาโมเดล AI ที่เป็นมิตรต่อการปฏิบัติตามข้อกำหนด

เนื่องจากกฎระเบียบด้าน AI ที่เพิ่มขึ้นในระดับโลก จึงกลายเป็นเรื่องสำคัญสำหรับธุรกิจที่ต้องให้ความสำคัญกับการปฏิบัติตามกฎหมายเมื่อสร้างโมเดล AI ต่อไปนี้คือวิธีที่บริษัทสามารถมั่นใจได้ว่าโครงการของตนเป็นไปตามกฎหมายเมื่อลงทุนในบริการพัฒนา AI

- ตรวจสอบว่าคุณได้รับอนุญาตให้ใช้ข้อมูล

การปฏิบัติตามข้อกำหนดของ AI ระบุว่าความเป็นส่วนตัวของผู้ใช้ควรเป็นแนวทางหลักในการออกแบบโมเดล ซึ่งหมายความว่าคุณควรรักษาจำนวนข้อมูลที่คุณต้องการรวบรวมให้น้อยที่สุด ระบุเหตุผลที่แน่นอนในการรวบรวมข้อมูล พร้อมทั้งเวลาจนถึงเวลาที่คุณจะใช้ข้อมูลของพวกเขา ท้ายที่สุด สิ่งสำคัญคือต้องทราบว่าผู้ใช้ควรให้ความยินยอมในการรวบรวมข้อมูล

- วิธีการ AI ที่อธิบายได้

แนวทางนี้ช่วยแก้ปัญหาผลกระทบจากกล่องดำโดยช่วยให้มนุษย์เข้าใจสิ่งที่อยู่ภายในระบบ AI และวิธีการตัดสินใจของโมเดล ซึ่งจะช่วยให้นักวิจัยทราบจำนวนข้อมูลที่แน่นอนซึ่งจำเป็นต้องใช้ในการปรับปรุงความแม่นยำของแบบจำลองเพื่อให้เป็นไปตามข้อกำหนดในการย่อขนาดข้อมูล

- ติดตามข้อมูลที่รวบรวมได้

การปฏิบัติตามข้อกำหนดของ AI กำหนดให้ธุรกิจต้องทราบตำแหน่งและการใช้ PII ที่เก็บรวบรวม จำเป็นต้องมีการจัดประเภทข้อมูลที่ถูกต้องเพื่อให้สอดคล้องกับสิทธิ์ของผู้ใช้ในการป้องกันข้อมูล อีกทั้งธุรกิจต้องมีแนวทางที่จะรู้ว่าข้อมูลใดจัดเก็บอยู่ในชุดข้อมูลใดเพื่อเตรียมมาตรการรักษาความปลอดภัยที่ถูกต้อง

- ทำความเข้าใจกฎการรับส่งข้อมูลระหว่างประเทศ

เมื่อมีการถ่ายโอนข้อมูลข้ามพรมแดนในระบบ AI ผู้พัฒนาควรพิจารณากฎระเบียบที่จะใช้ในประเทศผู้รับและสร้างกลไกการถ่ายโอนข้อมูลที่เหมาะสมตามนั้น ตัวอย่างเช่น หาก GDPR มีผลบังคับใช้กับการประมวลผลข้อมูลและข้อมูลส่วนบุคคลได้รับการถ่ายโอนไปยังประเทศที่ไม่ใช่ EEA ควรดำเนินการประเมินผลกระทบการถ่ายโอนที่เหมาะสม

การใช้วิธีการดังกล่าวเมื่อพัฒนาแอปพลิเคชัน AI ช่วยให้มั่นใจได้ว่าความเสี่ยงที่เกี่ยวข้องกับเทคโนโลยีได้รับการแก้ไขอย่างเหมาะสม อย่างไรก็ตาม บริษัทและหน่วยงานกำกับดูแลควรคำนึงถึงข้อเท็จจริงที่ว่ามันเป็นไปไม่ได้ที่จะปกป้องแอปพลิเคชันจากความเสี่ยงที่อาจเกิดขึ้นได้ เนื่องจากบริบทของอุตสาหกรรมทำงานในรูปแบบกรณีต่อกรณี ด้วยเหตุนี้ บทบาทของผู้จัดการความเสี่ยงของ AI จะยังคงมีความสำคัญ เนื่องจากพวกเขาจะสามารถวัดได้เมื่อจำเป็นต้องมีการแทรกแซง

เราหวังว่าบทความนี้จะช่วยให้คุณเข้าใจถึงสิ่งที่คาดหวังจากโครงสร้างทางกฎหมายที่เกี่ยวข้องกับเทคโนโลยี AI ในอนาคตอันใกล้ และวิธีในการเตรียมตัวให้พร้อมสำหรับโมเดล AI ที่สอดคล้อง

คำถามที่พบบ่อย

ถาม มีปัญหาทางกฎหมายเกี่ยวกับปัญญาประดิษฐ์หรือไม่?

ตอบ ใช่ อาจมีปัญหาทางกฎหมายและจริยธรรมหลายประการที่เกี่ยวข้องกับโมเดลปัญญาประดิษฐ์ที่สร้างขึ้นมาไม่ดี

- ลิขสิทธิ์

- การใช้ใบอนุญาตโอเพ่นซอร์สในทางที่ผิด

- การละเมิดทรัพย์สินทางปัญญา

- อคติทางจริยธรรมเช่นการเลือกปฏิบัติทางเชื้อชาติ

ถาม ทำไมการสร้างโมเดล AI ที่เป็นไปตามกฎหมายจึงเป็นเรื่องยาก

ตอบ ด้านเทคนิค การสร้าง AI ที่ถูกต้องตามกฎหมายอาจเป็นเรื่องยาก เพราะในขณะที่เทคโนโลยีใช้ข้อมูลของลูกค้าเพื่อค้นหารูปแบบและรับข้อมูลเชิงลึกใหม่ๆ ก็ยังยากที่จะระบุวัตถุประสงค์ที่แท้จริงของข้อมูลดังกล่าว ต่อไป ทีมพัฒนา AI จะไม่แน่ใจเกี่ยวกับปริมาณข้อมูลที่จำเป็นสำหรับโครงการของตน ประการสุดท้าย โมเดล AI ส่วนใหญ่ทำงานในกล่องดำ และยังไม่ชัดเจนว่าพวกเขาตัดสินใจอย่างไร โดยเฉพาะอย่างยิ่งเมื่อเราพูดถึงซอฟต์แวร์ขั้นสูง

ถาม จะตรวจสอบการปฏิบัติตามกฎหมายใน AI ได้อย่างไร

ตอบ แม้ว่ากฎหมายและข้อบังคับเกี่ยวกับการปฏิบัติตามกฎหมายของ AI จะมีการพัฒนาอย่างต่อเนื่อง แต่นี่คือบางสิ่งที่คุณสามารถทำได้เพื่อให้แน่ใจว่าโมเดลของคุณใกล้เคียงกับการปฏิบัติตามมากที่สุด –

- ตรวจสอบว่าคุณได้รับอนุญาตให้ใช้ข้อมูล

- วิธีการ AI ที่อธิบายได้

- ติดตามข้อมูลที่รวบรวมได้

- ทำความเข้าใจกฎการรับส่งข้อมูลระหว่างประเทศ