AI ที่มีความรับผิดชอบ – จัดการกับความท้าทายในการนำไปใช้ด้วยหลักการและกลยุทธ์ที่เป็นแนวทาง

เผยแพร่แล้ว: 2023-09-08ในยุคที่การนำโซลูชัน AI มาใช้อย่างแพร่หลาย การจัดลำดับความสำคัญของกระบวนการพัฒนาที่มีความรับผิดชอบ ขณะเดียวกันก็ยึดมั่นในหลักการด้านความปลอดภัยและจริยธรรมนั้นค่อนข้างมีความสำคัญ เนื่องจากระบบ AI เหล่านี้ยังคงเติบโตในด้านขีดความสามารถและค้นหาแอปพลิเคชันในกลุ่มอุตสาหกรรมต่างๆ การรับรองว่าการสร้างสรรค์จะสอดคล้องกับมาตรการความปลอดภัยที่เข้มงวดจะต้องเป็นหนึ่งในลำดับความสำคัญสูงสุดขององค์กร

แล้วเราจะแน่ใจได้อย่างไรว่าระบบที่ใช้ AI นั้นมีจริยธรรมและจะไม่ก่อให้เกิดผลตามมาที่ไม่ได้ตั้งใจ คำตอบง่ายๆ สำหรับปริศนานี้คือการปฏิบัติตามหลักการ Responsible AI

AI ที่มีความรับผิดชอบ (RAI) หมายถึงกรอบการทำงานที่ครอบคลุมในด้านปัญญาประดิษฐ์ ซึ่งการพิจารณาด้านจริยธรรมและสวัสดิการสังคมถือเป็นศูนย์กลาง โดยมีการพัฒนาอย่างมีความรับผิดชอบและการประยุกต์ใช้ระบบ AI ที่ออกแบบมาให้สอดคล้องกับหลักการพื้นฐาน

หลักการของ Responsible AI ช่วยให้องค์กรมุ่งเน้นไปที่ความโปร่งใส ทำให้ผู้ใช้และผู้มีส่วนได้ส่วนเสียสามารถเข้าใจการทำงานภายในของระบบ AI ได้ ความโปร่งใสนี้ปูทางไปสู่ความไว้วางใจและความรับผิดชอบที่เพิ่มขึ้น ช่วยให้บุคคลเข้าใจว่าการตัดสินใจของ AI เกิดขึ้นได้อย่างไร RAI ยังจัดการอคติภายในอัลกอริธึม AI อย่างจริงจังด้วยการจัดการข้อมูลอย่างชาญฉลาดและรวมเอามาตรการด้านความเป็นธรรมเพื่อให้แน่ใจว่าผลลัพธ์จะเป็นกลางและเป็นกลาง

บล็อกนี้จะช่วยให้คุณเข้าใจหลักการ AI ที่มีความรับผิดชอบห้าข้อ และการยึดมั่นในหลักการดังกล่าวจะทำให้ระบบ AI ของคุณยุติธรรมและเฉพาะต่อผู้ใช้ได้อย่างไร นอกเหนือจากการพิจารณาถึงประโยชน์ของการนำ AI ที่มีความรับผิดชอบมาใช้กับธุรกิจแล้ว เรายังช่วยให้คุณเข้าใจความท้าทายต่างๆ ที่สามารถจัดการได้ด้วยการนำแนวทางที่ได้รับการปรับปรุงมาใช้

ความจำเป็นในการปรับใช้กลยุทธ์ AI ที่มีความรับผิดชอบ: การลดความเสี่ยงด้าน AI

ในเดือนมีนาคม 2559 Microsoft ได้เปิดตัวแชทบอท AI ชื่อ Tay บน Twitter จุดประสงค์ของ Tay คือการเรียนรู้จากการโต้ตอบกับผู้ใช้ น่าเสียดายที่มีบุคคลบางคนเริ่มโพสต์เนื้อหาที่ไม่เหมาะสมไปยังบอท ส่งผลให้ Tay โต้ตอบด้วยภาษาที่ไม่เหมาะสม ภายในไม่กี่ชั่วโมง Tay ก็กลายร่างเป็นบอทที่ส่งเสริมคำพูดแสดงความเกลียดชังและการเลือกปฏิบัติ Microsoft รีบออฟไลน์ Tay และขอโทษสำหรับทวีตที่ไม่เหมาะสมของบอท เหตุการณ์นี้เป็นตัวอย่างที่ชัดเจนว่า AI สามารถผิดพลาดได้อย่างไร และมีกรณีที่คล้ายกันเกิดขึ้นมากมายตั้งแต่นั้นมา

AI มีศักยภาพมหาศาลในการสร้างประโยชน์ให้กับสังคม แต่ดังที่ลุงเบนกล่าวไว้ “พลังที่ยิ่งใหญ่มาพร้อมกับความรับผิดชอบที่ยิ่งใหญ่”

เมื่อคุณใช้ AI สำหรับการตัดสินใจทางธุรกิจที่สำคัญที่เกี่ยวข้องกับข้อมูลที่ละเอียดอ่อน สิ่งสำคัญที่ควรทราบ:

- AI กำลังทำอะไร และเพราะเหตุใด

- มีการตัดสินใจที่ถูกต้องและยุติธรรมหรือไม่?

- เป็นการเคารพความเป็นส่วนตัวของผู้คนหรือไม่?

- คุณสามารถควบคุมและจับตาดูเทคโนโลยีอันทรงพลังนี้ได้หรือไม่?

องค์กรต่างๆ ทั่วโลกตระหนักถึงความสำคัญของกลยุทธ์ AI ที่มีความรับผิดชอบ แต่พวกเขาอยู่ในจุดที่แตกต่างกันในการเดินทางเพื่อปรับใช้ การยอมรับหลักการของ Responsible AI (RAI) เป็นกลยุทธ์ที่มีประสิทธิภาพมากที่สุดในการลดความเสี่ยงที่เกี่ยวข้องกับ AI

ดังนั้นจึงถึงเวลาประเมินแนวทางปฏิบัติในปัจจุบันของคุณและให้แน่ใจว่าข้อมูลถูกใช้อย่างมีความรับผิดชอบและมีจริยธรรม การนำ RAI มาใช้ตั้งแต่เนิ่นๆ ไม่เพียงแต่จะช่วยลดความเสี่ยงที่เกี่ยวข้องกับแนวปฏิบัติเท่านั้น แต่ยังจะวางตำแหน่งองค์กรให้เหนือกว่าคู่แข่ง ทำให้พวกเขามีความได้เปรียบในการแข่งขันที่อาจเป็นสิ่งที่ท้าทายที่จะก้าวข้ามไปในอนาคต

จากการสำรวจของ MIT Sloan พบว่า 52% ของบริษัทกำลังก้าวไปสู่แนวทางปฏิบัติด้าน AI ที่มีความรับผิดชอบ อย่างไรก็ตาม มากกว่า 79% ของบริษัทเหล่านี้ยอมรับว่าความพยายามของตนมีจำกัดทั้งในด้านขนาดและขอบเขต รายงานดังกล่าวเน้นย้ำถึงความสำคัญที่เพิ่มขึ้นสำหรับธุรกิจในการจัดการกับความท้าทายและจัดลำดับความสำคัญของ Responsible AI (RAI) เนื่องจากบทบาทของ AI ในบริษัทต่างๆ ยังคงเพิ่มขึ้นอย่างต่อเนื่อง เพื่อกำหนดอนาคตที่ขับเคลื่อนด้วย AI ที่ยั่งยืนและมีความรับผิดชอบ การสร้างกรอบจริยธรรมที่แข็งแกร่งไม่ได้เป็นเพียงทางเลือกแต่จำเป็น

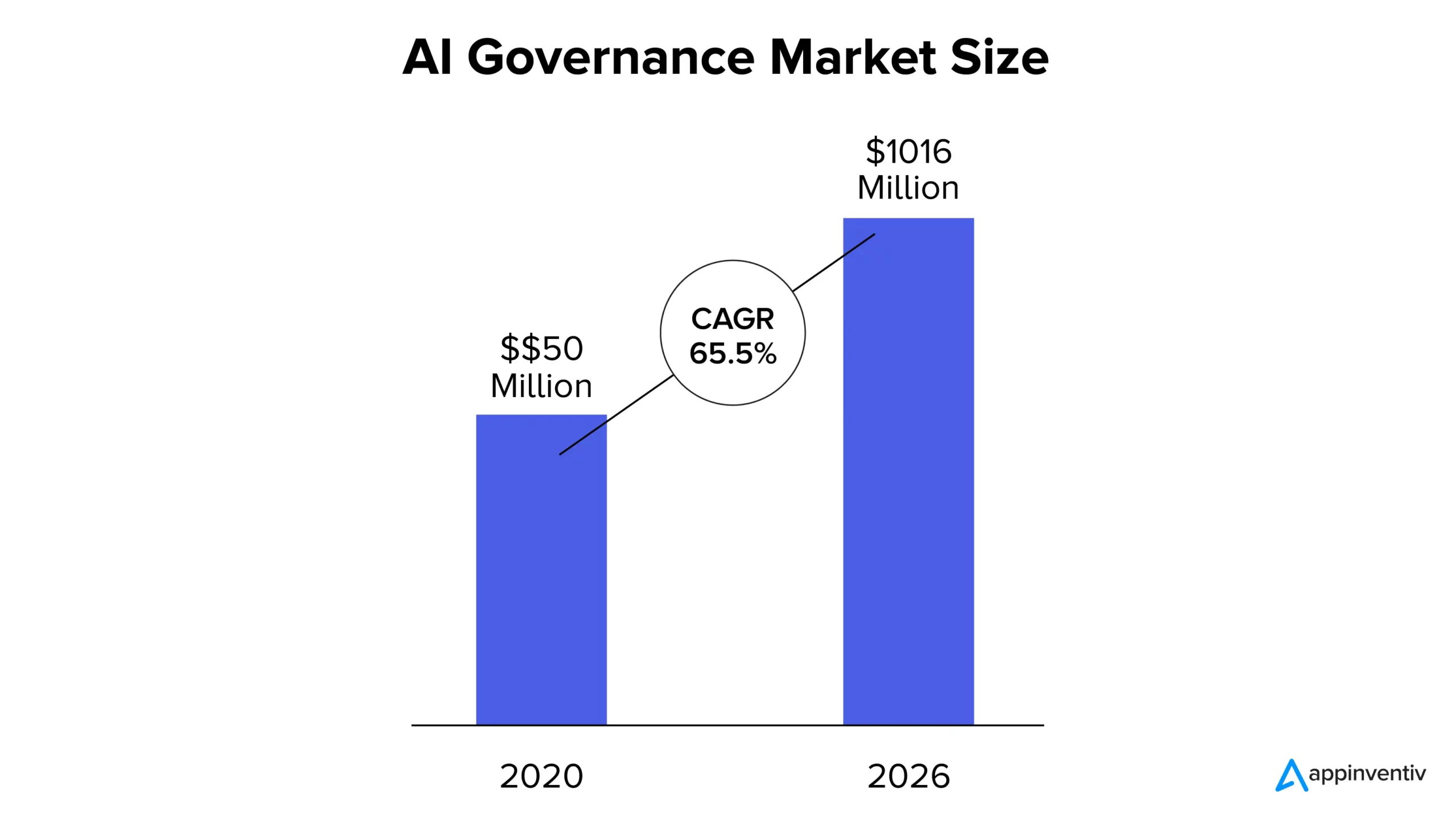

ตามรายงานของ MarketsandMarkets ตลาดการกำกับดูแล AI มีมูลค่า 50 ล้านดอลลาร์ในปี 2563 และคาดว่าจะสูงถึง 1,016 ล้านดอลลาร์ภายในปี 2569 โดยมี CAGR ที่ 65.5% ส่วนแบ่งการตลาดที่เพิ่มขึ้นเป็นผลมาจากการเติบโตที่เพิ่มขึ้นของความโปร่งใสในระบบ AI การยึดมั่นในการปฏิบัติตามกฎระเบียบ และความต้องการความไว้วางใจที่เพิ่มขึ้นในโซลูชันที่ใช้ AI

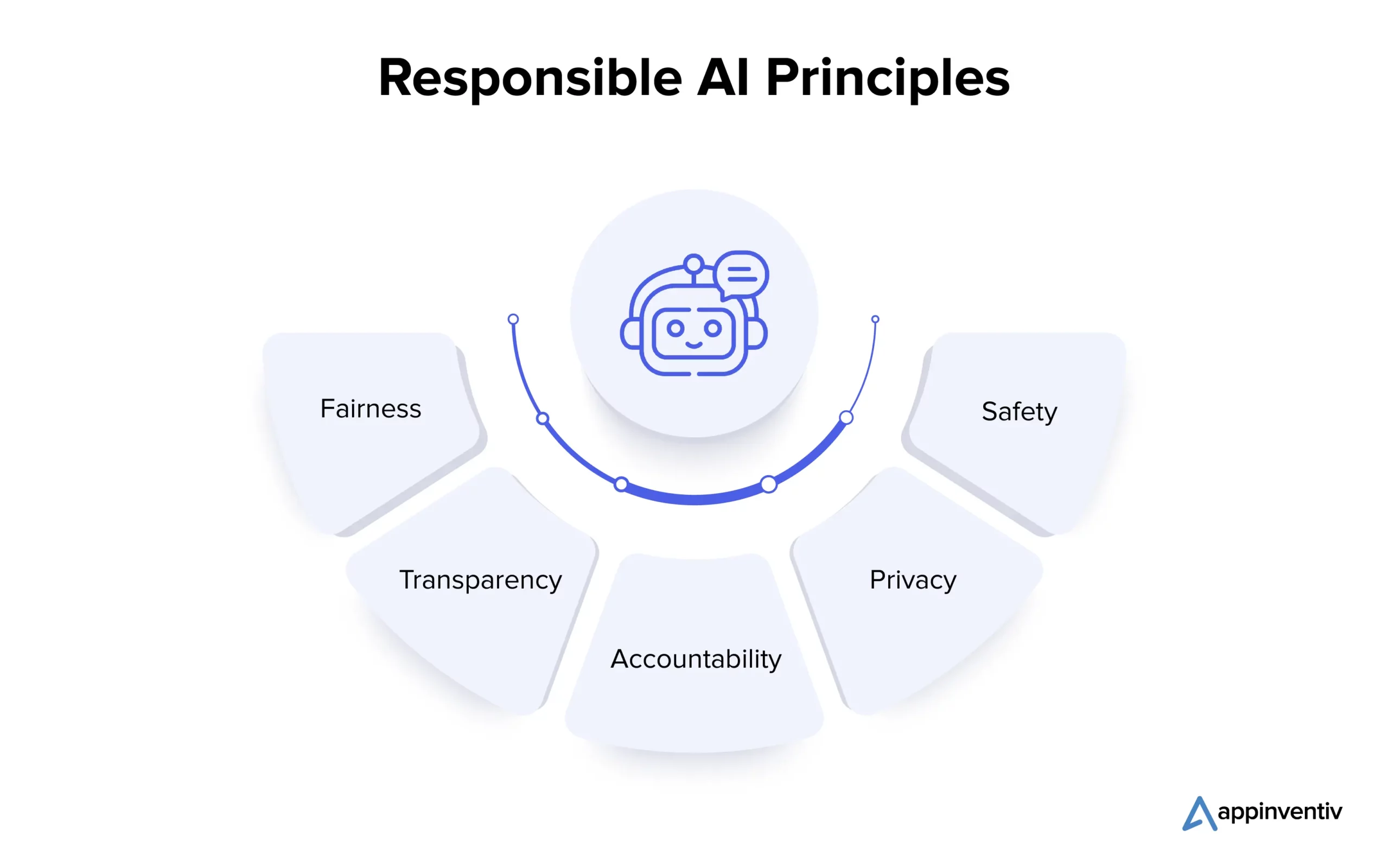

หลักการ AI ที่มีความรับผิดชอบคืออะไร?

การทำความเข้าใจหลักการสำคัญของ AI ที่มีความรับผิดชอบถือเป็นสิ่งสำคัญสำหรับองค์กรที่ต้องการนำทางภูมิทัศน์ AI ที่ซับซ้อนอย่างมีจริยธรรม ให้เราดูรายละเอียดหลักการหลายประการด้านล่าง:

1. ความเป็นธรรม

ความเป็นธรรมใน AI เป็นหลักการพื้นฐานที่จัดการกับอคติในระบบ AI อคติอาจเกิดขึ้นได้ในระหว่างการสร้างอัลกอริทึมหรือเนื่องจากข้อมูลการฝึกอบรมที่บิดเบือนความจริง นักวิทยาศาสตร์ข้อมูลใช้เทคนิคต่างๆ เช่น การวิเคราะห์ข้อมูล เพื่อตรวจจับและแก้ไขอคติ เพื่อให้มั่นใจว่าระบบ AI จะตัดสินใจอย่างเป็นกลางและส่งเสริมผลลัพธ์ที่เท่าเทียมกัน

2. ความโปร่งใส

ความโปร่งใสใน AI เกี่ยวข้องกับการจัดทำเอกสารและการอธิบายขั้นตอนที่ดำเนินการในการพัฒนาและการปรับใช้ ซึ่งทำให้ผู้มีส่วนได้ส่วนเสียสามารถเข้าใจได้ เทคนิคต่างๆ เช่น แมชชีนเลิร์นนิงที่ตีความได้เผยให้เห็นตรรกะเบื้องหลังการตัดสินใจของ AI ในขณะที่การกำกับดูแลของมนุษย์ช่วยให้มั่นใจได้ถึงการจัดตำแหน่งตามหลักจริยธรรมและความสมเหตุสมผล

3. ความรับผิดชอบ

ความรับผิดชอบมีความเชื่อมโยงอย่างใกล้ชิดกับความโปร่งใส และครอบคลุมถึงการสร้างกลไกเพื่อให้นักพัฒนา AI และผู้ใช้รับผิดชอบต่อผลลัพธ์และผลกระทบของระบบ AI ซึ่งเกี่ยวข้องกับการนำแนวปฏิบัติด้านจริยธรรมไปใช้ การใช้เครื่องมือติดตาม และการดำเนินการตรวจสอบ มาตรการเหล่านี้ช่วยให้มั่นใจได้ว่าระบบ AI จะให้ผลลัพธ์ตามที่ต้องการ ป้องกันอันตรายที่ไม่ได้ตั้งใจ และรักษาความน่าเชื่อถือ

4. ความเป็นส่วนตัว

ความเป็นส่วนตัวถือเป็นสิ่งสำคัญในการปกป้องข้อมูลส่วนบุคคลของบุคคล ระบบนิเวศ AI เกี่ยวข้องกับการได้รับความยินยอมในการรวบรวมข้อมูล การรวบรวมเฉพาะข้อมูลที่จำเป็น และการใช้งานตามวัตถุประสงค์ที่ตั้งใจไว้เท่านั้น เทคนิคการรักษาความเป็นส่วนตัว เช่น ความเป็นส่วนตัวที่แตกต่างและเทคนิคการเข้ารหัสถูกนำมาใช้เพื่อปกป้องข้อมูลส่วนบุคคลในระหว่างการพัฒนาและการผลิตแบบจำลอง AI

5. ความปลอดภัย

นักพัฒนาจะต้องให้ความสำคัญกับความปลอดภัยใน AI ที่มีความรับผิดชอบ รวมถึงความเป็นอยู่ที่ดีทั้งทางกายภาพและไม่ใช่ทางกายภาพ เพื่อให้บรรลุเป้าหมายนี้ ควรบูรณาการข้อพิจารณาด้านความปลอดภัยในทุกขั้นตอนของการพัฒนาระบบ AI ในขั้นตอนการออกแบบ การมีส่วนร่วมของผู้มีส่วนได้ส่วนเสียที่หลากหลายเพื่อระบุและทำความเข้าใจความเสี่ยงที่อาจเกิดขึ้นเป็นสิ่งสำคัญ การประเมินความเสี่ยง การทดสอบภายใต้สภาวะที่แตกต่างกัน การกำกับดูแลโดยมนุษย์ และการติดตามและปรับปรุงอย่างต่อเนื่องในระหว่างการผลิต มีความสำคัญในการป้องกันอันตรายและรักษาความน่าเชื่อถือในระบบ AI

หลังจากดูหลักการหลายประการของ Responsible AI แล้ว ให้เราก้าวไปข้างหน้าและทำความเข้าใจกับความท้าทายที่เกี่ยวข้องกับการนำโซลูชันไปใช้

อะไรคือความท้าทายในการนำโซลูชั่น AI ที่มีความรับผิดชอบมาใช้?

การนำ AI ที่มีความรับผิดชอบมาใช้นั้นเป็นการเดินทางที่น่าหวังพร้อมผลตอบแทนที่ยอดเยี่ยมสำหรับธุรกิจ แต่ความท้าทายที่สำคัญนั้นต้องการการพิจารณาอย่างรอบคอบและวิธีแก้ปัญหาเชิงรุก ให้เราดูรายละเอียดด้านล่าง:

อธิบายได้และความโปร่งใส

ระบบ AI จะต้องสามารถชี้แจงได้ว่าทำไมและอย่างไรจึงสร้างผลลัพธ์ที่เฉพาะเจาะจงเพื่อรักษาความไว้วางใจ การขาดความโปร่งใสสามารถลดความเชื่อมั่นในระบบเหล่านี้ได้

ความปลอดภัยส่วนบุคคลและสาธารณะ

ระบบอัตโนมัติเช่นรถยนต์และหุ่นยนต์ที่ขับเคลื่อนด้วยตนเองอาจทำให้เกิดความเสี่ยงต่อความปลอดภัยของมนุษย์ การดูแลความเป็นอยู่ที่ดีของมนุษย์ในบริบทดังกล่าวเป็นสิ่งสำคัญ

ระบบอัตโนมัติและการควบคุมของมนุษย์

แม้ว่า AI จะสามารถเพิ่มประสิทธิภาพการทำงานได้ แต่ก็อาจลดการมีส่วนร่วมและความเชี่ยวชาญของมนุษย์ลง การสร้างสมดุลเพื่อให้แน่ใจว่าการควบคุมและการกำกับดูแลของมนุษย์ถือเป็นความท้าทาย

อคติและการเลือกปฏิบัติ

แม้ว่าระบบ AI ได้รับการออกแบบมาให้เป็นกลาง แต่ก็ยังคงสืบทอดอคติจากข้อมูลการฝึกอบรมได้ ซึ่งอาจนำไปสู่การเลือกปฏิบัติโดยไม่ได้ตั้งใจ การป้องกันอคติดังกล่าวเป็นสิ่งสำคัญ

ความรับผิดชอบและกฎระเบียบ

ด้วยการเติบโตของการมีอยู่ของ AI โดยรวม คำถามเกี่ยวกับความรับผิดชอบและความรับผิดอาจเกิดขึ้นได้ การตัดสินว่าใครเป็นผู้รับผิดชอบในการใช้งานระบบ AI และการใช้งานในทางที่ผิดนั้นมีความซับซ้อน

ความปลอดภัยและความเป็นส่วนตัว

AI ต้องการการเข้าถึงข้อมูลอย่างกว้างขวางซึ่งสามารถเพิ่มความกังวลเกี่ยวกับความเป็นส่วนตัวของข้อมูลและการละเมิดความปลอดภัยได้ การปกป้องข้อมูลที่ใช้สำหรับการฝึกอบรม AI ถือเป็นสิ่งสำคัญในการปกป้องความเป็นส่วนตัวโดยรวมของแต่ละบุคคล

ปัจจุบัน การเป็นพันธมิตรกับบริษัทพัฒนาแอป AI ที่มีชื่อเสียง (เช่น Appinventiv) ซึ่งปฏิบัติตามหลักการ AI ที่มีความรับผิดชอบในระหว่างกระบวนการพัฒนา สามารถช่วยธุรกิจต่างๆ ลดความท้าทายและความเสี่ยงที่เกี่ยวข้องได้อย่างมีประสิทธิภาพ

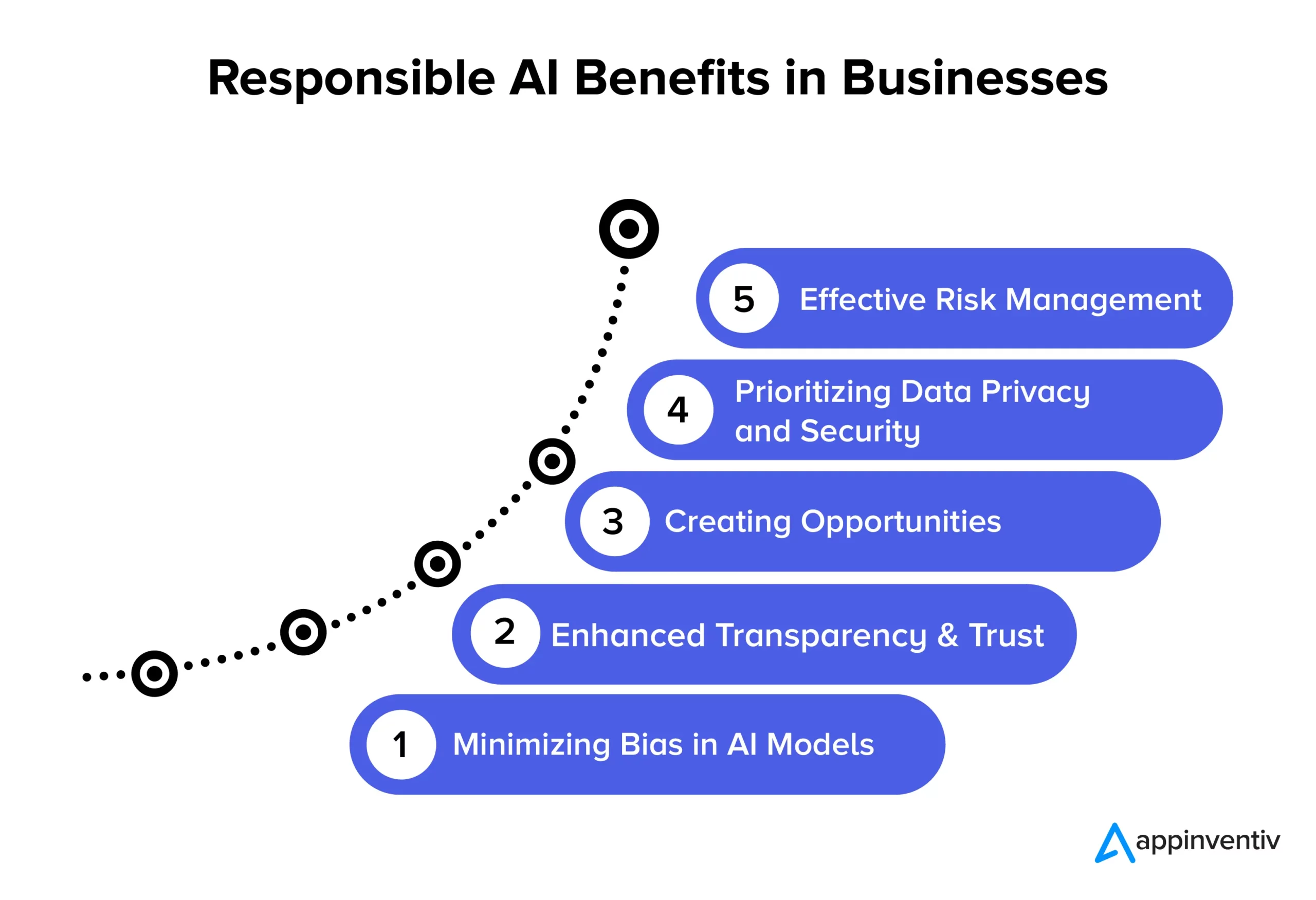

ประโยชน์ของ AI ที่มีความรับผิดชอบสำหรับธุรกิจ

การนำหลักการ AI ที่มีความรับผิดชอบมาใช้ปูทางไปสู่ข้อได้เปรียบที่สำคัญหลายประการสำหรับธุรกิจและสังคม มาสำรวจโดยละเอียดด้านล่าง:

การลดอคติในโมเดล AI

ด้วยการยึดมั่นในหลักการ Responsible AI ธุรกิจต่างๆ จึงสามารถลดอคติในโมเดล AI และข้อมูลพื้นฐานที่ใช้ในการฝึกอบรมได้อย่างมีประสิทธิภาพ การลดอคตินี้ทำให้มั่นใจได้ว่าระบบ AI จะให้ผลลัพธ์ที่แม่นยำและยุติธรรมมากขึ้น ซึ่งถูกต้องตามหลักจริยธรรมและลดความเสี่ยงของการเปลี่ยนแปลงข้อมูลเมื่อเวลาผ่านไป นอกจากนี้ การลดอคติยังช่วยให้องค์กรหลีกเลี่ยงอันตรายที่อาจเกิดขึ้นกับผู้ใช้ที่อาจเกิดขึ้นจากผลลัพธ์ของโมเดล AI ที่มีอคติ เพิ่มชื่อเสียงและลดความรับผิดชอบ

ความโปร่งใสและความน่าเชื่อถือที่เพิ่มขึ้น

แนวทางปฏิบัติของ AI ที่มีความรับผิดชอบช่วยเพิ่มความชัดเจนและความโปร่งใสของโมเดล AI ซึ่งจะช่วยในการเสริมสร้างความไว้วางใจระหว่างธุรกิจและลูกค้าของพวกเขา นอกจากนี้ AI ยังพร้อมใช้งานและเข้าใจได้มากขึ้นสำหรับผู้ชมในวงกว้างขึ้น ซึ่งเป็นประโยชน์ต่อองค์กรและผู้ใช้ปลายทางด้วยการเปิดใช้งานแอปพลิเคชันที่หลากหลายขึ้น และปรับปรุงการใช้งานเทคโนโลยี AI อย่างมีประสิทธิภาพ

การสร้างโอกาส

การปฏิบัติตามหลักการ Responsible AI ช่วยให้นักพัฒนาและผู้ใช้สามารถสนทนาอย่างเปิดเผยเกี่ยวกับระบบ AI นี่เป็นหนึ่งในผลประโยชน์ด้าน AI ที่มีความรับผิดชอบและเป็นที่ต้องการมากที่สุดในธุรกิจ สร้างพื้นที่ที่ผู้คนสามารถแสดงความคิดเห็นและข้อกังวลเกี่ยวกับเทคโนโลยี AI ซึ่งช่วยให้ธุรกิจต่างๆ สามารถจัดการกับปัญหาเหล่านี้ในเชิงรุกได้ แนวทางการทำงานร่วมกันในการพัฒนา AI นี้ส่งผลให้เกิดการสร้างโซลูชัน AI ที่ถูกต้องตามหลักจริยธรรมและมีความรับผิดชอบต่อสังคม ซึ่งสามารถเพิ่มชื่อเสียงและความสามารถในการแข่งขันของบริษัทได้

การจัดลำดับความสำคัญของความเป็นส่วนตัวและความปลอดภัยของข้อมูล

โซลูชัน AI ที่มีความรับผิดชอบช่วยให้ธุรกิจมุ่งเน้นไปที่การปกป้องความเป็นส่วนตัวและความปลอดภัยของข้อมูลได้อย่างมาก ซึ่งหมายความว่าข้อมูลส่วนบุคคลหรือข้อมูลที่ละเอียดอ่อนได้รับการจัดการด้วยความระมัดระวัง ปกป้องสิทธิ์ของบุคคล และป้องกันการละเมิดข้อมูล เมื่อธุรกิจปฏิบัติตามหลักการ Responsible AI ธุรกิจเหล่านี้จะลดโอกาสในการใช้ข้อมูลในทางที่ผิด ละเมิดกฎระเบียบ และสร้างความเสียหายต่อชื่อเสียงของตน เป็นวิธีที่ชาญฉลาดในการรักษาข้อมูลให้ปลอดภัยและรักษาความไว้วางใจของลูกค้า

การบริหารความเสี่ยงที่มีประสิทธิผล

แนวทางปฏิบัติของ AI ที่มีความรับผิดชอบจะกำหนดกฎเกณฑ์ทางจริยธรรมและกฎหมายที่ชัดเจนสำหรับระบบ AI ซึ่งช่วยลดโอกาสที่จะเกิดผลลัพธ์ที่เป็นอันตราย การลดความเสี่ยงนี้เป็นประโยชน์ต่อองค์กรหลายแห่ง เช่น ธุรกิจ พนักงาน และสังคม องค์กรสามารถหลีกเลี่ยงการฟ้องร้องที่มีราคาแพงและสร้างความเสียหายต่อชื่อเสียงขององค์กรได้เมื่อต้องแก้ไขปัญหาด้านจริยธรรมและกฎหมายที่อาจเกิดขึ้นได้

ตัวอย่างการใช้งาน AI อย่างมีความรับผิดชอบที่ประสบความสำเร็จ

ต่อไปนี้เป็นตัวอย่างขององค์กรในโลกแห่งความเป็นจริงที่ให้ความสำคัญกับแนวทางปฏิบัติด้าน AI ที่มีจริยธรรมและเป็นกลาง:

เครื่องมือสรรหา AI ที่น่าเชื่อถือของ IBM

บริษัทรายใหญ่ในสหรัฐฯ ร่วมมือกับ IBM เพื่อทำให้กระบวนการจ้างงานเป็นแบบอัตโนมัติ และจัดลำดับความสำคัญของความยุติธรรมในกระบวนการสรรหาบุคลากรที่ขับเคลื่อนด้วย AI เป้าหมายของพวกเขาคือการอำนวยความสะดวกในความหลากหลายและการไม่แบ่งแยก ในขณะเดียวกันก็รักษาความสมบูรณ์ของโมเดลการเรียนรู้ของเครื่องเอาไว้ ด้วยการใช้ IBM Watson Studio ซึ่งเป็นเครื่องมือติดตามและจัดการ AI พวกเขาระบุและจัดการกับอคติในการจ้างงานได้สำเร็จ ขณะเดียวกันก็ได้รับข้อมูลเชิงลึกอันมีค่าเกี่ยวกับการตัดสินใจของ AI

กรอบงาน AI ที่มีความรับผิดชอบของ State Farm

State Farm ซึ่งเป็นบริษัทประกันภัยชั้นนำในสหรัฐอเมริกา ได้รวม AI เข้ากับกระบวนการจัดการการเรียกร้องสินไหม และใช้กลยุทธ์ AI ที่มีความรับผิดชอบ พวกเขาสร้างระบบการกำกับดูแลเพื่อกำหนดความรับผิดชอบสำหรับ AI ส่งผลให้การตัดสินใจรวดเร็วและมีข้อมูลมากขึ้น แบบจำลอง AI แบบจำลองการประเมินยานพาหนะแบบไดนามิก (DVAM) ของ State Farm คาดการณ์การสูญเสียทั้งหมดได้อย่างมีประสิทธิภาพ และนำความโปร่งใสมาสู่การประมวลผลการเคลมประกัน

ทีม AI ที่มีความรับผิดชอบและรายการตรวจสอบของ H&M Group

H&M Group ผู้ค้าปลีกสินค้าแฟชั่นระดับโลกได้บูรณาการ AI เข้ากับการดำเนินงานเพื่อขับเคลื่อนความยั่งยืน เพิ่มประสิทธิภาพห่วงโซ่อุปทาน และปรับปรุงประสบการณ์ของลูกค้าแบบเฉพาะตัว บริษัทได้จัดตั้งทีมงาน AI ที่มีความรับผิดชอบโดยเฉพาะในปี 2561 เพื่อให้แน่ใจว่าการใช้งาน AI อย่างมีความรับผิดชอบ ทีมนี้พัฒนารายการตรวจสอบที่ใช้ได้จริงซึ่งระบุและบรรเทาอันตรายที่อาจเกิดขึ้นจาก AI และปฏิบัติตามหลักการ Responsible AI อย่างเต็มที่

ความเป็นธรรมของ Google ในการเรียนรู้ของเครื่อง

Google ยังทำงานอย่างแข็งขันเพื่อรวมมาตรการด้านความเป็นธรรมใน AI และการเรียนรู้ของเครื่อง พวกเขาได้พัฒนาเครื่องมือและทรัพยากรเพื่อช่วยให้นักพัฒนาระบุและลดอคติในโมเดลการเรียนรู้ของเครื่อง

GPT-3 ของ OpenAI

OpenAI ซึ่งเป็นบริษัทที่อยู่เบื้องหลัง GPT-3 ยังเป็นผู้นำสำคัญในการใช้แนวทางที่มีความรับผิดชอบในการปรับใช้ AI พวกเขาใช้กลไกการปรับแต่งอย่างละเอียดเพื่อหลีกเลี่ยงผลลัพธ์ที่เป็นอันตรายและลำเอียง ซึ่งพิสูจน์ให้เห็นถึงความมุ่งมั่นของพวกเขาต่อ AI ที่มีจริยธรรม แม้กระทั่งในโมเดล NLP ขั้นสูง

อนาคตของ AI ที่มีความรับผิดชอบกับ Appinventiv

อนาคตของ Responsible AI คือการเดินทางที่กำลังดำเนินไป โดยองค์กรต่างๆ จะต้องอยู่ในขั้นตอนต่างๆ ของการพัฒนาด้านจริยธรรมเกี่ยวกับเทคโนโลยีและการใช้ข้อมูล เป็นสาขาที่มีพลวัตซึ่งมุ่งเน้นไปที่การสร้างแนวทางที่เป็นมาตรฐานสำหรับอุตสาหกรรมที่หลากหลาย เพื่อนำทางหลักการ Responsible AI สำหรับธุรกิจของคุณ การเป็นพันธมิตรกับ Appinventiv เป็นตัวเลือกที่ดีที่สุดที่ธุรกิจสามารถทำได้ เราสามารถช่วยคุณสร้างโซลูชัน AI ที่มีจริยธรรม เป็นกลาง และแม่นยำซึ่งปรับให้เหมาะกับความต้องการของคุณ

ในฐานะบริษัทพัฒนา AI โดยเฉพาะ นักพัฒนาของเรามีความเชี่ยวชาญหลายปีในการพัฒนาโซลูชัน AI โดยให้ความสำคัญกับจริยธรรมและความรับผิดชอบ ด้วยประวัติที่ได้รับการพิสูจน์แล้วของโครงการ AI ที่ประสบความสำเร็จซึ่งครอบคลุมขอบเขตอุตสาหกรรมจำนวนมาก เราเข้าใจถึงความสำคัญของการปรับโซลูชัน AI ให้สอดคล้องกับค่านิยมหลักและหลักจริยธรรมที่จำเป็น เราสามารถช่วยคุณใช้มาตรการความเป็นธรรมเพื่อให้แน่ใจว่าโซลูชันทางธุรกิจที่ใช้ AI ของคุณสามารถตัดสินใจได้อย่างเป็นกลาง

เมื่อเร็วๆ นี้เราได้พัฒนา YouComm ซึ่งเป็นแอปการดูแลสุขภาพที่ใช้ AI ซึ่งเชื่อมต่อผู้ป่วยกับพยาบาลในโรงพยาบาลด้วยท่าทางมือและคำสั่งเสียง ขณะนี้โซลูชันดังกล่าวได้รับการติดตั้งแล้วในเครือข่ายโรงพยาบาลมากกว่า 5 แห่งทั่วสหรัฐอเมริกา

ติดต่อผู้เชี่ยวชาญด้าน AI ของเราเพื่อสร้างโซลูชัน AI ที่ให้ผลลัพธ์ที่แม่นยำและเป็นไปตามมาตรฐานทางจริยธรรม

คำถามที่พบบ่อย

ถาม ตัวอย่าง AI ที่มีความรับผิดชอบมีอะไรบ้าง

A. ต่อไปนี้คือตัวอย่าง AI ที่มีความรับผิดชอบในขอบเขตอุตสาหกรรมต่างๆ:

- อัลกอริทึมที่ยุติธรรม: ระบบ AI ที่ออกแบบมาให้มีความยุติธรรม ลดอคติในการตัดสินใจ

- AI ที่อธิบายได้ (XAI): ทำให้การตัดสินใจของ AI เป็นเรื่องที่เข้าใจได้

- การบรรเทาอคติ: ติดตามและลดอคติใน AI อย่างต่อเนื่อง

- คณะกรรมการจริยธรรม AI: การจัดตั้งคณะกรรมการตรวจสอบภายในสำหรับ AI ที่มีจริยธรรม

- AI ที่รักษาความเป็นส่วนตัว: การปกป้องข้อมูลที่ละเอียดอ่อนในขณะที่ใช้สำหรับ AI

- รายงานความโปร่งใส: แบ่งปันวิธีการทำงานของระบบ AI และการตัดสินใจ

- การศึกษา AI ที่มีความรับผิดชอบ: การฝึกอบรมผู้เชี่ยวชาญด้าน AI เกี่ยวกับจริยธรรมและความรับผิดชอบ

ถาม: กรณีการใช้งาน Responsible AI ที่ประสบความสำเร็จมีอะไรบ้าง

ตอบ: ตัวอย่างการใช้งาน Responsible AI ที่ประสบความสำเร็จมีดังนี้:

- การวินิจฉัยด้านการดูแลสุขภาพ: ใช้เพื่อปรับปรุงผลลัพธ์ทางการแพทย์ด้วยความเป็นธรรมและความเป็นส่วนตัวของผู้ป่วย

- บริการทางการเงิน: สามารถขจัดความเสี่ยงที่เกี่ยวข้องกับการฉ้อโกงและมัลแวร์ได้ โซลูชันที่ใช้ AI ที่รับผิดชอบสามารถปกป้องข้อมูลลูกค้าเพิ่มเติมและรับประกันการให้สินเชื่อที่เท่าเทียมกัน

- การสรรหาบุคลากร: ช่วยลดอคติในขณะเดียวกันก็ปูทางไปสู่การยอมรับความหลากหลายและโอกาสที่เท่าเทียมกันในหมู่ผู้ใช้

- ยานพาหนะขับเคลื่อนอัตโนมัติ: ช่วยในการจัดลำดับความสำคัญด้านความปลอดภัยและปฏิบัติตามมาตรฐานทางจริยธรรม

ถาม Responsible AI เป็นกระบวนการที่กำลังดำเนินอยู่ หรือธุรกิจสามารถนำไปใช้เพียงครั้งเดียวแล้วลืมไปได้เลย

A. AI ที่มีความรับผิดชอบเป็นกระบวนการต่อเนื่องที่ต้องมีการตรวจสอบ อัปเดต และปรับตัวให้เข้ากับมาตรฐานและกฎระเบียบทางจริยธรรมที่เปลี่ยนแปลงอย่างต่อเนื่อง ดังนั้นจึงแนะนำให้ร่วมมือกับบริษัทพัฒนา AI โดยเฉพาะที่สามารถช่วยให้คุณท่องไปในน่านน้ำอย่างระมัดระวังได้