เทคนิคการขูดเว็บ 2023 – คู่มือฉบับสมบูรณ์

เผยแพร่แล้ว: 2023-07-06ในโลกที่กว้างใหญ่ของการล่าสมบัติออนไลน์ การขูดเว็บได้กลายเป็นเครื่องมือขั้นสูงสุดในการดึงข้อมูลอันมีค่าออกมา ไม่ว่าคุณจะเป็นนักผจญภัยคนเดียวหรือองค์กรที่ต้องการข้อมูล การขูดเว็บคือพลั่วที่ไว้ใจได้ในชุดเครื่องมือดิจิทัลของคุณ

อย่างไรก็ตาม เทคนิคการขูดเว็บนั้นไม่ได้ถูกสร้างขึ้นมาเท่ากันทั้งหมด ก็เหมือนกับการเลือกเบ็ดตกปลาที่สมบูรณ์แบบสำหรับงานที่ทำอยู่ ท้ายที่สุด คุณจะไม่นำตะขอเล็กๆ ไปจับสิ่งมีชีวิตขนาดมหึมาอย่าง Moby Dick ใช่ไหม? ในบล็อกนี้ เราจะเปิดเผยความลับเบื้องหลังเทคนิคการขูดเว็บด้วยตนเอง แบบอัตโนมัติ และขั้นสูง

ลองนึกภาพการรวมทีมฮีโร่ซึ่งแต่ละคนมีพลังพิเศษและจุดอ่อนของตัวเอง ในทำนองเดียวกัน วิธีการขูดแต่ละวิธีก็มีจุดแข็งและข้อจำกัด

แต่อย่าลืมความสำคัญของการกระทำที่รับผิดชอบในการขูดเว็บ เช่นเดียวกับที่อัศวินจะไม่มีวันผิดคำสาบาน สิ่งสำคัญคือต้องขูดอย่างมีจริยธรรมและเคารพเงื่อนไขการให้บริการของเว็บไซต์ที่คุณต้องการขูด

เทคนิคการขูดเว็บอัตโนมัติ

การขูดเว็บอัตโนมัติหมายถึงกระบวนการใช้ซอฟต์แวร์หรือเครื่องมือเพื่อดึงข้อมูลจากเว็บไซต์โดยอัตโนมัติ วิธีการอัตโนมัตินี้ช่วยลดความจำเป็นในการคัดลอกและวางข้อมูลด้วยตนเอง ทำให้สามารถรวบรวมข้อมูลขนาดใหญ่ได้อย่างมีประสิทธิภาพจากแหล่งข้อมูลออนไลน์ต่างๆ

1. ห้องสมุดขูดเว็บ

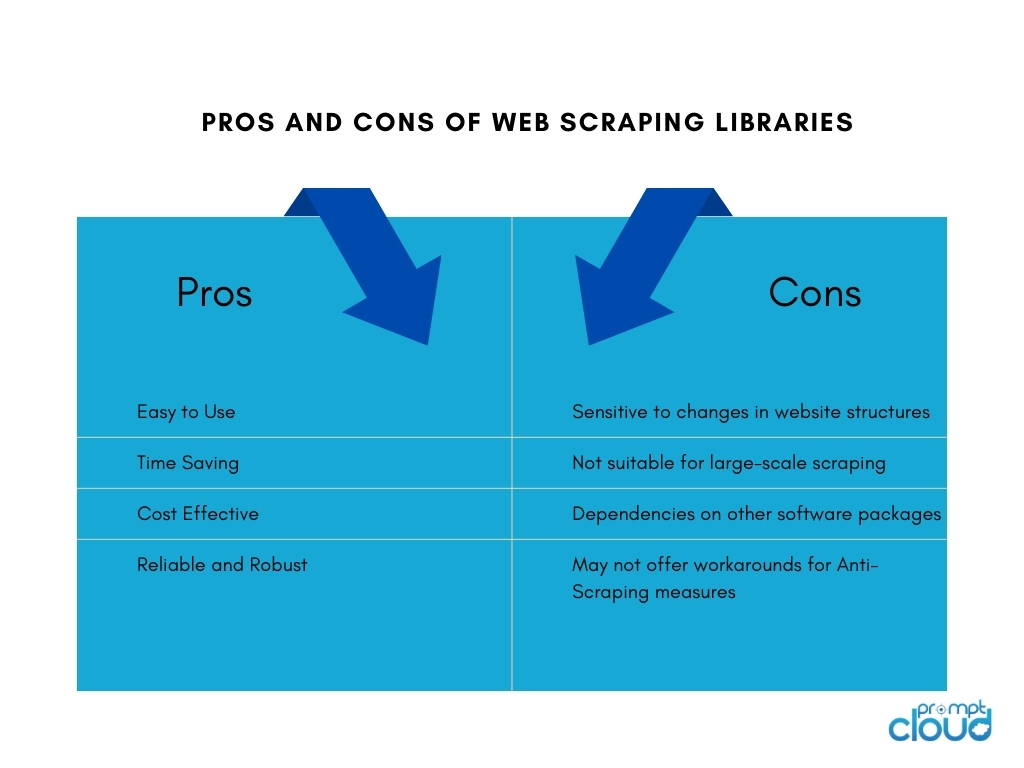

ไลบรารีการขูดเว็บเป็นเครื่องมือซอฟต์แวร์หรือเฟรมเวิร์กที่มีฟังก์ชันและยูทิลิตี้ที่สร้างไว้ล่วงหน้าเพื่ออำนวยความสะดวกในงานขูดเว็บ พวกเขานำเสนอวิธีที่ง่ายและมีประสิทธิภาพในการขูดเว็บโดยไม่จำเป็นต้องเขียนทุกอย่างใหม่หมด ช่วยประหยัดเวลา เพิ่มผลผลิต และทำให้สามารถรวบรวมข้อมูลจากแหล่งข้อมูลออนไลน์ที่หลากหลายได้อย่างมีประสิทธิภาพมากขึ้น

ไลบรารีการขูดเว็บยอดนิยมบางส่วน ได้แก่ :

- BeautifulSoup: ไลบรารี Python ที่ใช้กันอย่างแพร่หลายสำหรับการขูดเว็บ ซึ่งมี API ที่ใช้งานง่ายในการแยกวิเคราะห์เอกสาร HTML และ XML ทำให้ผู้ใช้สามารถนำทางและแยกข้อมูลได้อย่างง่ายดาย

- Scrapy: เฟรมเวิร์ก Python อันทรงพลังสำหรับการขูดเว็บที่มีชุดเครื่องมือที่ครอบคลุมสำหรับการสร้างโปรแกรมรวบรวมข้อมูลเว็บที่ปรับขนาดได้และมีประสิทธิภาพ พร้อมด้วยคุณสมบัติต่างๆ เช่น การควบคุมคำขออัตโนมัติ ไปป์ไลน์รายการ และการสนับสนุนในตัวสำหรับการจัดการเลขหน้า

- Selenium: ไลบรารีอเนกประสงค์ที่ช่วยให้การโต้ตอบของเบราว์เซอร์อัตโนมัติสำหรับการขูดเว็บ มีประโยชน์อย่างยิ่งเมื่อต้องจัดการกับเนื้อหาแบบไดนามิกและเว็บไซต์ที่ใช้ JavaScript เป็นหลัก

- Puppeteer: ไลบรารี Node.js ที่ให้ API ระดับสูงเพื่อควบคุมเบราว์เซอร์ Chrome หรือ Chromium ที่ไม่มีส่วนหัว เปิดใช้งานการขูดเว็บและการโต้ตอบกับหน้าเว็บโดยใช้ JavaScript

2. เครื่องมือและบริการขูดเว็บ

เครื่องมือขูดเว็บ

เครื่องมือขูดเว็บคือแอปพลิเคชันซอฟต์แวร์หรือแพลตฟอร์มที่ออกแบบมาโดยเฉพาะสำหรับการทำงานอัตโนมัติและทำให้กระบวนการขูดเว็บง่ายขึ้น เครื่องมือเหล่านี้มักมีส่วนต่อประสานที่เป็นมิตรกับผู้ใช้ซึ่งช่วยให้ผู้ใช้สามารถระบุข้อมูลที่ต้องการดึงจากเว็บไซต์โดยไม่ต้องมีความรู้ด้านการเขียนโปรแกรมมากนัก

โดยทั่วไปจะมีคุณลักษณะต่างๆ เช่น การเลือกองค์ประกอบข้อมูลแบบชี้และคลิก ความสามารถในการตั้งเวลาและการตรวจสอบ และตัวเลือกการส่งออกข้อมูล เครื่องมือขูดเว็บสามารถเป็นประโยชน์สำหรับบุคคลหรือธุรกิจที่ต้องการการดึงข้อมูลโดยไม่ต้องใช้ทรัพยากรการเขียนโค้ดหรือการพัฒนาที่กว้างขวาง

สร้างเครื่องมือขูดเว็บภายในองค์กร

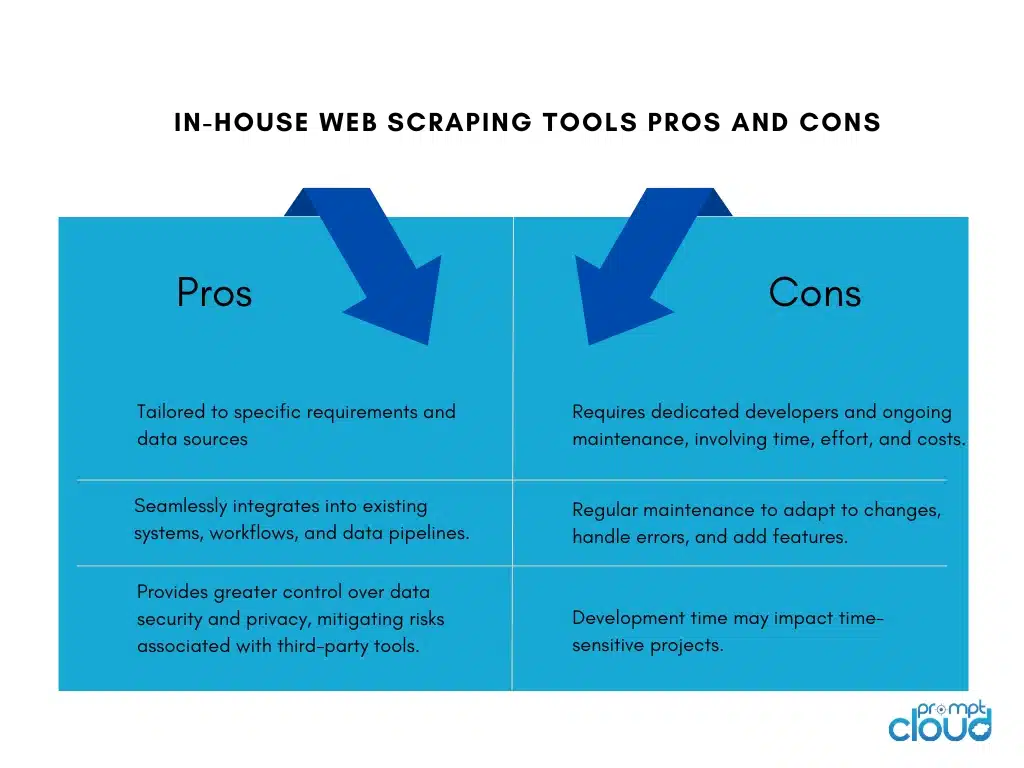

การสร้างเครื่องมือขูดเว็บสำหรับบริษัทมีข้อดีและข้อเสีย:

บริการขูดเว็บ

ผู้ให้บริการขูดเว็บเสนอบริการพิเศษสำหรับการดึงข้อมูลจากเว็บไซต์ ผู้ให้บริการเหล่านี้มักจะมีโครงสร้างพื้นฐาน เครื่องมือ และความเชี่ยวชาญเฉพาะสำหรับจัดการงานการขูดเว็บในนามของลูกค้า

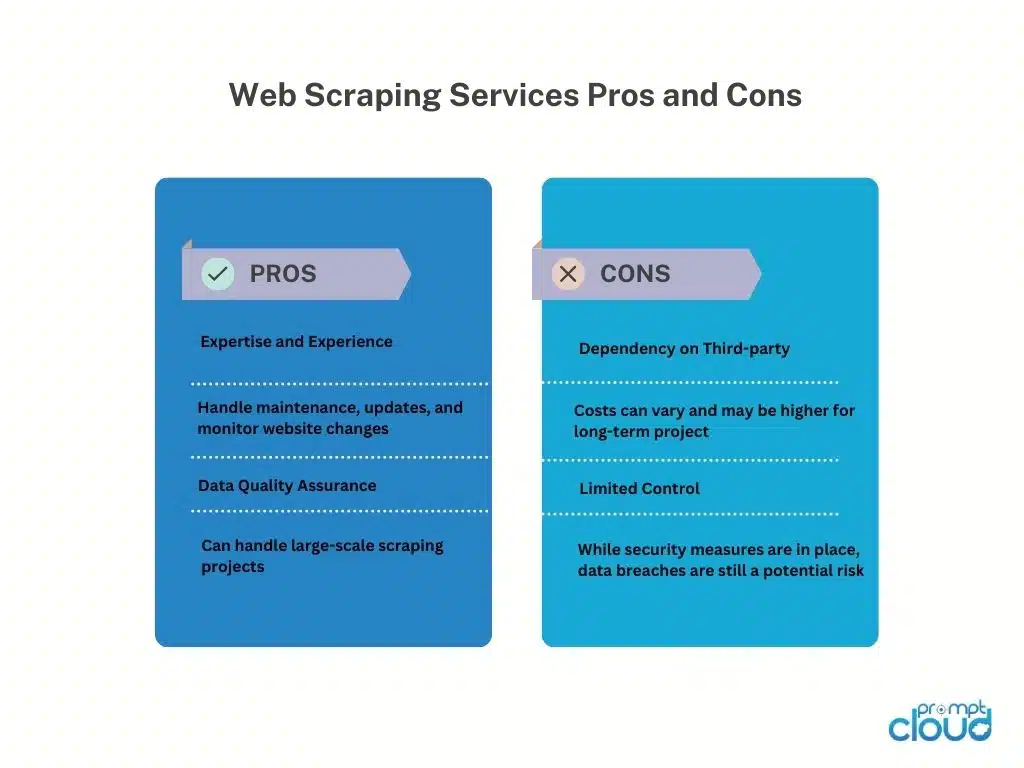

นี่คือข้อดีและข้อเสียของการใช้ผู้ให้บริการขูดเว็บ:

API การขูดเว็บ

API การขูดเว็บมีอินเทอร์เฟซแบบโปรแกรมที่ช่วยให้นักพัฒนาสามารถเข้าถึงและดึงข้อมูลจากเว็บไซต์โดยใช้วิธีการที่เป็นมาตรฐาน API เหล่านี้นำเสนอแนวทางที่มีโครงสร้างและควบคุมได้มากขึ้นในการขูดเว็บ เมื่อเทียบกับเทคนิคการขูดแบบดั้งเดิม นักพัฒนาสามารถส่งคำขอไปยัง API ระบุข้อมูลที่ต้องการและรับข้อมูลที่คัดลอกมาในรูปแบบที่มีโครงสร้าง เช่น JSON หรือ XML

ข้อดี

API การขูดเว็บทำให้กระบวนการขูดข้อมูลง่ายขึ้น ช่วยให้นักพัฒนามุ่งเน้นไปที่การผสานรวม API และจัดการข้อมูล พวกเขามีความน่าเชื่อถือและประสิทธิภาพเนื่องจากการบำรุงรักษาของผู้ให้บริการ และอาจรวมถึงคุณลักษณะต่างๆ เช่น การรับรองความถูกต้องและการจำกัดอัตรา API ยังช่วยให้ปฏิบัติตามข้อกำหนดในการให้บริการและข้อกำหนดทางกฎหมาย

ข้อเสีย

การใช้ API การขูดเว็บมีข้อจำกัด ความพร้อมใช้งานและความสามารถของข้อมูลขึ้นอยู่กับผู้ให้บริการ API โดยมีข้อจำกัดที่เป็นไปได้ในเว็บไซต์ที่รองรับและขีดจำกัดการคัดลอก การพึ่งพา API ภายนอกทำให้ต้องพึ่งพาความพร้อมใช้งานและประสิทธิภาพของผู้ให้บริการ ซึ่งส่งผลต่อการดึงข้อมูล นอกจากนี้ อาจมีค่าใช้จ่ายที่เกี่ยวข้องกับปริมาณมากหรือการใช้งานเชิงพาณิชย์

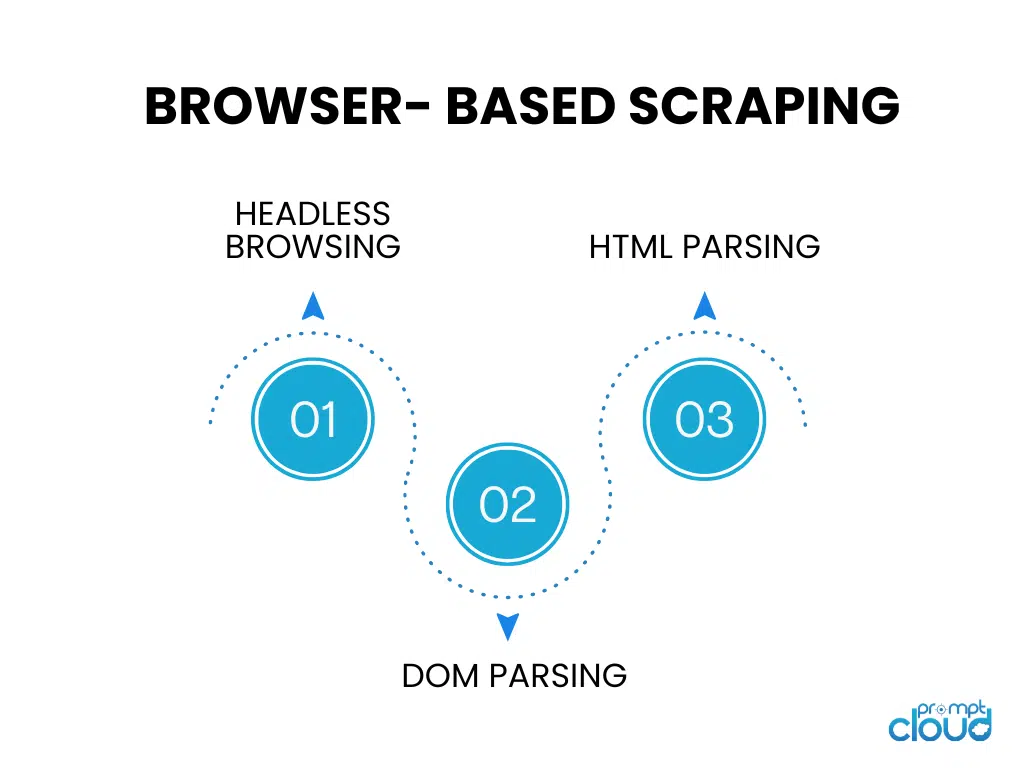

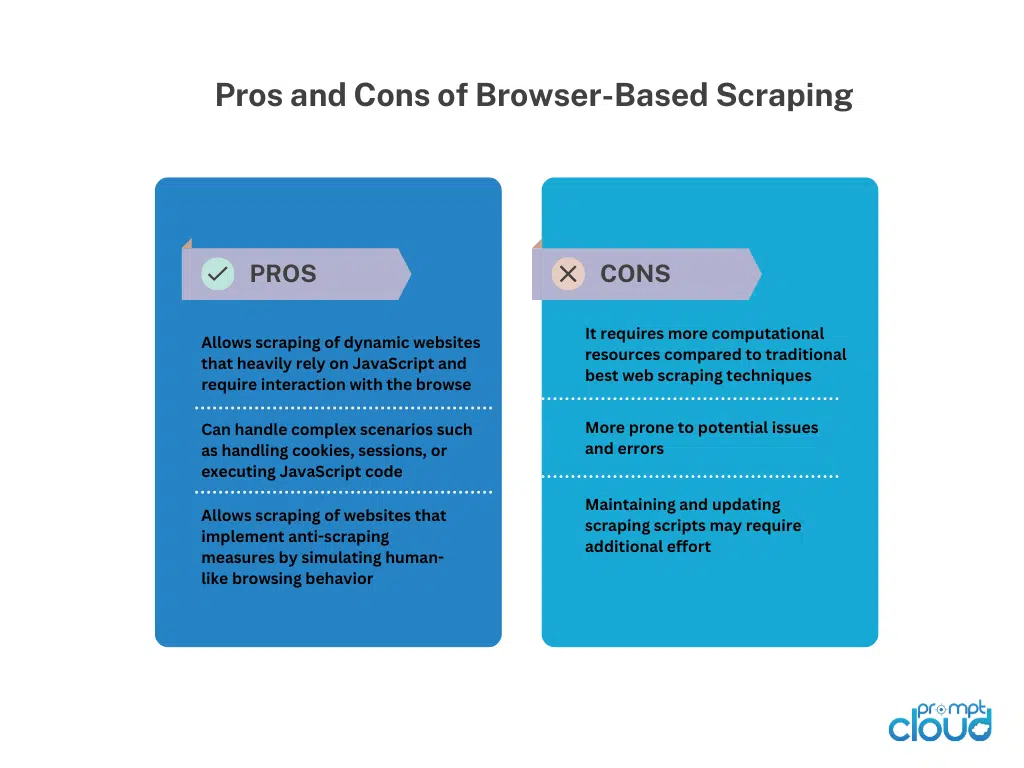

การขูดบนเบราว์เซอร์

การเรียกดูแบบไร้หัว

การท่องเว็บแบบไร้ส่วนหัวเรียกใช้เว็บเบราว์เซอร์โดยไม่มีอินเทอร์เฟซผู้ใช้แบบกราฟิก ทำให้สามารถเรียกดูอัตโนมัติและโต้ตอบกับเว็บไซต์โดยใช้โค้ด เหมาะอย่างยิ่งสำหรับการคัดลอกเว็บไซต์แบบไดนามิกที่ต้องพึ่งพาการแสดงผลฝั่งไคลเอ็นต์เป็นหลัก

การแยกวิเคราะห์ DOM

การแยกวิเคราะห์ DOM เกี่ยวข้องกับการจัดการโครงสร้าง HTML ของหน้าเว็บโดยการเข้าถึง Document Object Model ซึ่งช่วยให้สามารถแยกองค์ประกอบ คุณลักษณะ หรือข้อความตามเป้าหมายโดยทางโปรแกรมได้

การแยกวิเคราะห์ HTML

การแยกวิเคราะห์ HTML จะวิเคราะห์ซอร์สโค้ด HTML ของหน้าเว็บเพื่อดึงข้อมูลที่ต้องการ ใช้ไลบรารีหรือโปรแกรมแยกวิเคราะห์เพื่อตีความโครงสร้าง HTML และระบุแท็ก คุณลักษณะ หรือรูปแบบเฉพาะสำหรับการดึงข้อมูล การแยกวิเคราะห์ HTML มักใช้สำหรับการคัดลอกหน้าเว็บแบบสแตติกโดยไม่ต้องเรียกใช้ JavaScript

เทคนิคการขูดเว็บด้วยตนเอง

เทคนิคการขูดเว็บด้วยตนเอง

การขูดเว็บด้วยตนเองหมายถึงกระบวนการแยกข้อมูลจากเว็บไซต์ด้วยตนเอง โดยไม่ต้องใช้เครื่องมือหรือสคริปต์อัตโนมัติ มันเกี่ยวข้องกับการแทรกแซงของมนุษย์เพื่อไปยังส่วนต่างๆ ของเว็บไซต์ ค้นหาข้อมูลที่เกี่ยวข้อง และดึงข้อมูลโดยใช้เทคนิคต่างๆ

เทคนิคการขูดเว็บด้วยตนเอง:

การจับภาพหน้าจอ: เทคนิคนี้เกี่ยวข้องกับการจับภาพหน้าจอหรือวิดีโอของหน้าเว็บเพื่อดึงข้อมูลภาพ เช่น รูปภาพ แผนภูมิ หรือตารางที่แยกวิเคราะห์ทางโปรแกรมได้ยากการสกัดด้วยตนเองจากสื่อที่บันทึกช่วยให้สามารถดึงข้อมูลได้

การป้อนข้อมูล: ในการป้อนข้อมูล ข้อมูลที่จำเป็นจะถูกคัดลอกด้วยตนเองจากหน้าเว็บและป้อนในรูปแบบที่ต้องการ เช่น สเปรดชีตหรือฐานข้อมูลมันเกี่ยวข้องกับการนำทางเว็บเพจ การเลือกข้อมูล และป้อนข้อมูลลงในปลายทางเป้าหมาย การป้อนข้อมูลเหมาะสำหรับข้อมูลที่มีโครงสร้างที่สามารถคัดลอกและวางได้ง่าย

การขูดเว็บแบบแมนนวลให้ความยืดหยุ่นเมื่อต้องจัดการกับเว็บไซต์ที่ซับซ้อน การโต้ตอบด้วย JavaScript หรือมาตรการต่อต้านการขูด อย่างไรก็ตาม ใช้เวลานาน ไม่เหมาะกับงานขนาดใหญ่ และมีแนวโน้มที่จะเกิดข้อผิดพลาดจากมนุษย์ ต้องใช้ความพยายามของมนุษย์ ความใส่ใจในรายละเอียด และการดำเนินการอย่างระมัดระวัง

เทคนิคการขูดเว็บแบบไฮบริด

การขูดเว็บแบบผสมผสานผสมผสานเครื่องมืออัตโนมัติและการแทรกแซงด้วยตนเองเพื่อการดึงข้อมูลที่มีประสิทธิภาพและแม่นยำจากเว็บไซต์ เครื่องมืออัตโนมัติจัดการกับงานซ้ำๆ เช่น การนำทางและการดึงข้อมูลที่มีโครงสร้าง ในขณะที่เทคนิคแบบแมนนวล เช่น การจับภาพหน้าจอหรือการป้อนข้อมูล จะจัดการกับสถานการณ์ที่ซับซ้อนและข้อมูลภาพ/ไม่มีโครงสร้าง

Hybrid Web Scraping มอบความสามารถในการปรับขนาดและความเร็วของระบบอัตโนมัติ พร้อมด้วยความยืดหยุ่นในการตัดสินโดยมนุษย์ เหมาะกับเว็บไซต์ที่มีโครงสร้างหลากหลาย เนื้อหาแบบไดนามิก หรือมาตรการป้องกันการขูด ตัวเลือกขึ้นอยู่กับความซับซ้อน ประเภทข้อมูล และทรัพยากรที่มีอยู่ของเว็บไซต์ ซึ่งให้แนวทางที่สมดุลสำหรับการดึงข้อมูลที่ครอบคลุม