เครื่องมือค้นหาใช้เทคโนโลยีใดในการรวบรวมข้อมูลเว็บไซต์

เผยแพร่แล้ว: 2023-03-02

หากคุณเคยสงสัยว่าเสิร์ชเอ็นจิ้นใช้เทคโนโลยีใดในการรวบรวมข้อมูลเว็บไซต์ เตรียมตัวให้พร้อมเพื่อรับคำตอบสำหรับคำถามของคุณ คุณจะรู้ว่าโปรแกรมรวบรวมข้อมูลเว็บคืออะไร โปรแกรมรวบรวมข้อมูลเว็บประเภทต่างๆ มากมายที่ใช้โดยเครื่องมือค้นหาหลัก และกระบวนการจัดทำดัชนีการค้นหานั้นเกี่ยวกับอะไร คุณจะได้เรียนรู้ว่าสิ่งเหล่านี้จะส่งผลต่อผลลัพธ์ของเครื่องมือค้นหาอย่างไร และเจ้าของเว็บไซต์สามารถบอกโปรแกรมรวบรวมข้อมูลเว็บของเครื่องมือค้นหาให้จัดทำดัชนีเนื้อหาตามความต้องการของพวกเขาได้อย่างไร มาดูข้อมูลเพิ่มเติมเกี่ยวกับเทคโนโลยีนี้ที่เสิร์ชเอ็นจิ้นใช้ในการแสดงผลการค้นหาที่เกี่ยวข้องนับพันล้านรายการแก่ผู้คนที่กำลังมองหาข้อมูลบนเวิลด์ไวด์เว็บอย่างถูกต้องแม่นยำ

Web Crawlers หรือ Search Engine Bots คืออะไร?

บอทโปรแกรมรวบรวมข้อมูลเว็บหรือที่เรียกว่าสไปเดอร์เป็นโปรแกรมอัตโนมัติที่บริษัทต่างๆ เช่น Google และ Microsoft ใช้เพื่อสอนเครื่องมือค้นหาของตนถึงสิ่งที่มีอยู่ในทุกหน้าเว็บที่เข้าถึงได้ของทุกเว็บไซต์ที่พวกเขาสามารถค้นหาบนอินเทอร์เน็ต มีเพียงการเรียนรู้ว่าข้อมูลใดรวมอยู่ในหน้าเว็บเท่านั้นที่เครื่องมือค้นหาเหล่านี้จะสามารถดึงข้อมูลนี้ได้อย่างถูกต้อง เมื่อผู้ใช้คนใดคนหนึ่งพิมพ์ข้อความค้นหาเพื่อขอทราบเกี่ยวกับหัวข้อใดหัวข้อหนึ่ง

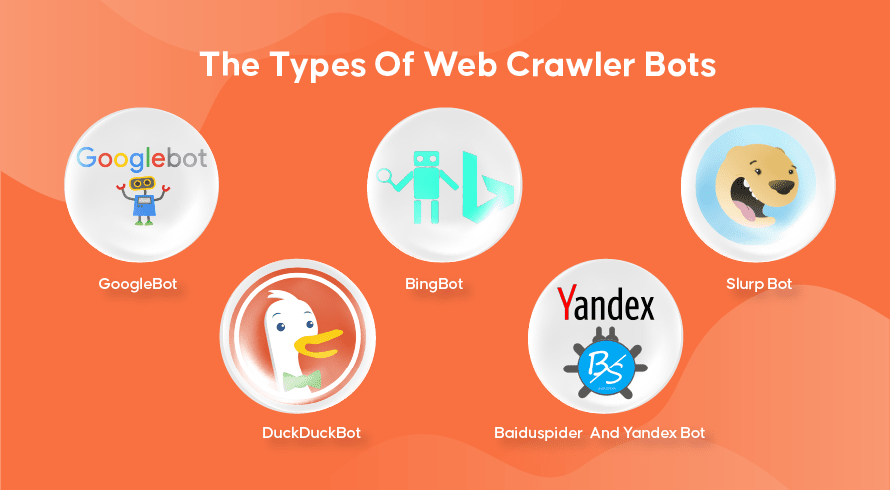

ประเภทของบอทโปรแกรมรวบรวมข้อมูลเว็บ

เครื่องมือค้นหาทุกแห่งมีโปรแกรมรวบรวมข้อมูลเว็บ นี่คือบางส่วนที่ใช้กันอย่างแพร่หลาย

กูเกิลบอต

Google เป็นเครื่องมือค้นหาที่ได้รับความนิยมมากที่สุดในโลกและใช้โปรแกรมรวบรวมข้อมูลเว็บสองรุ่นในการจัดทำดัชนีหน้าเว็บหลายแสนล้านหน้า GoogleBot Desktop จะดูหน้าเว็บที่เลียนแบบพฤติกรรมของคนที่ใช้คอมพิวเตอร์เดสก์ท็อปเพื่อท่องอินเทอร์เน็ต ในขณะที่ GoogleBot Mobile จะทำเช่นเดียวกันกับผู้ใช้สมาร์ทโฟน

GoogleBot เป็นหนึ่งในประเภทของบอทการค้นหาที่มีประสิทธิภาพที่สุดเท่าที่เคยมีมา และสามารถรวบรวมข้อมูลและจัดทำดัชนีหน้าเว็บได้อย่างรวดเร็ว อย่างไรก็ตาม มีปัญหาในการรวบรวมข้อมูลโครงสร้างเว็บไซต์ที่ซับซ้อนมาก นอกจากนี้ บ่อยครั้งที่ GoogleBot อาจใช้เวลาหลายวันหรือหลายสัปดาห์ในการรวบรวมข้อมูลหน้าเว็บที่เพิ่งเผยแพร่ ซึ่งหมายความว่าหน้าเว็บนั้นจะไม่ปรากฏในผลลัพธ์ที่เกี่ยวข้องสักระยะหนึ่ง

บิงบอต

Bingbot คือคำตอบของ Microsoft ที่มีต่อ Google บนเสิร์ชเอ็นจิ้น Bing ของพวกเขาเอง ซึ่งทำงานคล้ายกับโปรแกรมรวบรวมข้อมูลเว็บของ Google และยังมีเครื่องมือดึงข้อมูลที่ระบุว่าบอตจะรวบรวมข้อมูลหน้าเว็บอย่างไร ช่วยให้คุณเห็นว่ามีปัญหาใดๆ หรือไม่

Slurp Bot

Slurp Bot เป็นโปรแกรมรวบรวมข้อมูลเว็บที่ Yahoo ใช้ แม้ว่าพวกเขาจะใช้ Bingbot เช่นกันเพื่อส่งผลลัพธ์ของเครื่องมือค้นหา เจ้าของเว็บไซต์ต้องอนุญาตให้ Slurp Bot เข้าถึงได้ หากต้องการให้เนื้อหาของหน้าเว็บปรากฏในผลการค้นหาของ Yahoo Mobile นอกจากนี้ Slurp Bot ยังสามารถเข้าถึงไซต์พันธมิตรของ Yahoo เพื่อเพิ่มเนื้อหาไปยังเว็บไซต์ Yahoo News, Yahoo Sports และ Yahoo Finance

DuckDuckบอต

นี่คือโปรแกรมรวบรวมข้อมูลเว็บที่ใช้โดย DuckDuckGo ซึ่งเป็นเครื่องมือค้นหาที่รู้จักกันว่าให้ความเป็นส่วนตัวในระดับที่ไม่มีใครเทียบสำหรับผู้ใช้โดยไม่ติดตามกิจกรรมของพวกเขาเหมือนที่คนนิยมทำกัน พวกเขาให้ผลการค้นหาที่ได้รับจาก DuckDuckBot เช่นเดียวกับเว็บไซต์ที่มาจากฝูงชนเช่น Wikipedia และเครื่องมือค้นหาอื่น ๆ

Baiduspider และ Yandex Bot

เหล่านี้คือบอทโปรแกรมรวบรวมข้อมูลที่ใช้โดยเครื่องมือค้นหา Baidu จากประเทศจีน และ Yandex จากรัสเซียตามลำดับ ไป่ตู้มีส่วนแบ่งมากกว่า 80% ของตลาดเสิร์ชเอ็นจิ้นในจีนแผ่นดินใหญ่

การรวบรวมข้อมูลเว็บ การสร้างดัชนีการค้นหา และการจัดอันดับของเครื่องมือค้นหาทำงานอย่างไร

ตอนนี้มาสำรวจวิธีที่เครื่องมือค้นหาส่วนใหญ่ใช้โปรแกรมรวบรวมข้อมูลเว็บเพื่อค้นหา จัดเก็บ จัดระเบียบ และดึงข้อมูลที่อยู่ในเว็บไซต์

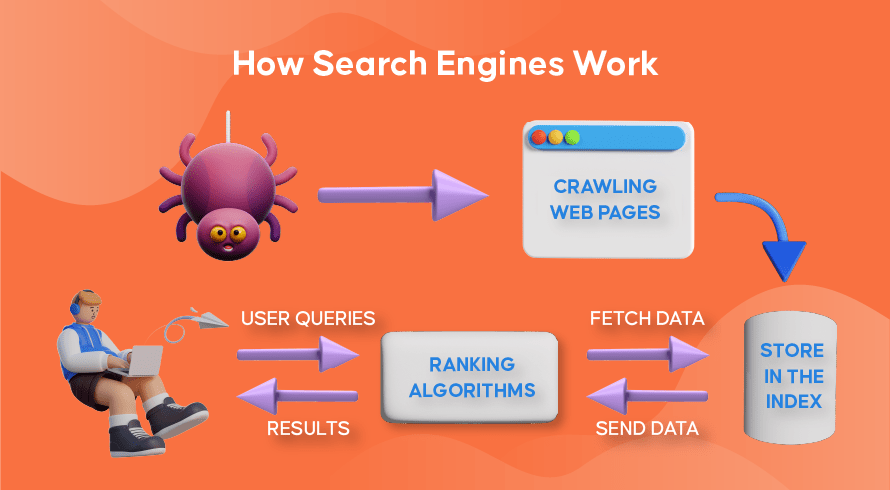

โปรแกรมรวบรวมข้อมูลเว็บทำงานอย่างไร

กระบวนการค้นหาทั้งเนื้อหาใหม่และเนื้อหาที่อัปเดตบนเว็บไซต์เรียกว่า 'การรวบรวมข้อมูลเว็บ' ซึ่งเป็นชื่อสำหรับโปรแกรมซอฟต์แวร์ที่ทำหน้าที่นี้ บอทจะเริ่มรวบรวมข้อมูลหน้าเว็บสองสามหน้า ค้นหาเนื้อหา จากนั้นไปตามไฮเปอร์ลิงก์ที่รวมอยู่ในหน้าเว็บนั้นเพื่อค้นหา URL ใหม่ ซึ่งนำไปสู่เนื้อหาเพิ่มเติม

การจัดทำดัชนีของเครื่องมือค้นหาทำงานอย่างไร

หลังจากที่บอทค้นพบเนื้อหาใหม่หรือเนื้อหาที่อัปเดตผ่านการรวบรวมข้อมูลเว็บ ทุกสิ่งที่พวกเขาพบจะถูกเพิ่มลงในฐานข้อมูลขนาดใหญ่ที่เรียกว่า 'ดัชนีเครื่องมือค้นหา' ที่นี่เปรียบเสมือนห้องสมุดที่หนังสือเปรียบเสมือนเว็บเพจ จัดระเบียบเพื่อเรียกค้นได้ง่ายในภายหลัง หนังสือแต่ละเล่มมีข้อความส่วนใหญ่ในหน้าเว็บที่เราสามารถเห็นได้ (ยกเว้นคำเช่น 'a', 'an' และ 'the') รวมถึงข้อมูลเมตาที่โปรแกรมรวบรวมข้อมูลเท่านั้นที่จะเห็น ข้อมูลเมตาคือสิ่งที่เครื่องมือค้นหาใช้เพื่อทำความเข้าใจเนื้อหาของหน้าเว็บ ชื่อเมตาและคำอธิบายเมตาคือตัวอย่างของข้อมูลเมตา

การจัดอันดับการค้นหาทำงานอย่างไร

เมื่อใดก็ตามที่ผู้ใช้พิมพ์ข้อความค้นหา เครื่องมือค้นหาที่เกี่ยวข้องจะตรวจสอบดัชนี ค้นหาข้อมูลที่เกี่ยวข้องมากที่สุดที่ตรงกับคำขอนี้ จัดระเบียบรายการลิงก์เว็บที่มีเนื้อหาที่เกี่ยวข้อง และนำเสนอสิ่งนี้แก่ผู้ใช้ในเครื่องมือค้นหา หน้าผลลัพธ์ (SERPs)

องค์กรของ SERPs นี้เรียกว่า 'การจัดอันดับการค้นหา' และดำเนินการโดยอัลกอริทึมการค้นหาที่คำนึงถึงข้อมูลที่รวบรวมรวมถึงข้อมูลเมตา ความน่าเชื่อถือของเว็บไซต์ (ผู้มีอำนาจ) ตลอดจนคำหลักและลิงก์ เว็บไซต์ที่ถือว่าเป็นแหล่งข้อมูลที่น่าเชื่อถือและมีเนื้อหาที่เกี่ยวข้องสูงซึ่งจะเป็นประโยชน์ต่อผู้ใช้จะได้รับการจัดอันดับสูงและได้รับผลลัพธ์สูงสุดใน SERPs นั่นคือเหตุผลที่เจ้าของเว็บไซต์ทุกคนมีกลยุทธ์ในการจัดอันดับเว็บไซต์ของตนบน SERP

วิธีเพิ่มประสิทธิภาพกลไกค้นหา (SEO) เข้าสู่รูปภาพ

เจ้าของเว็บไซต์สามารถเพิ่มประสิทธิภาพเนื้อหาบนหน้าของพวกเขาในลักษณะที่เครื่องมือค้นหาจะจดจำได้ง่ายขึ้นว่ามีความเกี่ยวข้องและมีประโยชน์ต่อผู้ใช้ สิ่งนี้จะผลักดันหน้าเหล่านี้ให้อยู่ด้านบนสุดของ SERP ทำให้มีการเข้าชมเว็บไซต์มากขึ้น การรวมคำหลักที่เกี่ยวข้องอย่างมีชั้นเชิงในการคัดลอกหน้า การสร้างลิงก์ และการใช้รูปภาพและวิดีโอต้นฉบับเป็นวิธีการบางส่วนที่สามารถใช้เทคนิค SEO ได้

นอกจากนี้ เว็บไซต์ยังสามารถใช้เครื่องมือต่าง ๆ เช่น SEMrush เพื่อค้นหาและแก้ไขปัญหาต่าง ๆ ในหน้าของพวกเขา เช่น ลิงก์เสีย ซึ่งจะช่วยปรับปรุงอันดับของพวกเขาในสายตาของเครื่องมือค้นหา

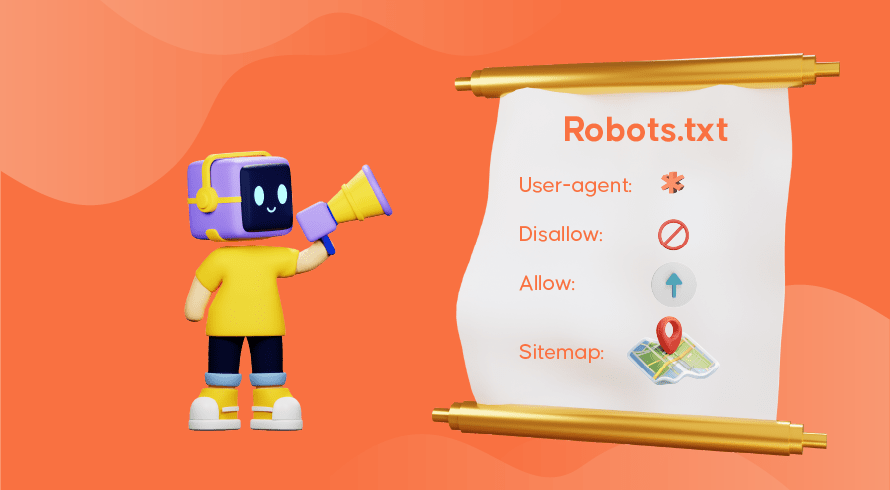

บอกเครื่องมือค้นหาวิธีการรวบรวมข้อมูลเว็บไซต์ของคุณ

บางครั้งคุณจะพบว่าโปรแกรมรวบรวมข้อมูลเว็บยังทำหน้าที่ของตนได้ไม่ดีพอ ทำให้หน้าสำคัญในเว็บไซต์ของคุณหายไปจากดัชนี ซึ่งหมายความว่าข้อความค้นหาที่เกี่ยวข้องจะไม่แสดงพร้อมกับเนื้อหาของคุณ ทำให้ผู้มีโอกาสเป็นลูกค้าหาทางไปยังหน้าเว็บของคุณได้ยาก โชคดีที่มีวิธีสื่อสารกับเครื่องมือค้นหา ช่วยให้คุณควบคุมสิ่งที่ได้รับการจัดทำดัชนีและสิ่งที่ถูกละเว้นได้เล็กน้อย

ไฟล์ robots.txt ที่จัดเก็บไว้ในไดเรกทอรีรากของเว็บไซต์ของคุณเป็นสิ่งที่บอกโปรแกรมรวบรวมข้อมูลเว็บว่าคุณต้องการรวบรวมข้อมูลหน้าใด หน้าใดที่ควรละเว้น และวิธีจัดเรียงสถาปัตยกรรมเว็บไซต์ของคุณ คุณอาจต้องการป้องกันไม่ให้มีการจัดทำดัชนีหน้าเว็บบางหน้าหากกำลังใช้งานสำหรับการทดสอบ หรือใช้โปรโมชันพิเศษและ URL ที่ซ้ำกันในอีคอมเมิร์ซ

ตัวอย่างเช่น GoogleBot จะยังคงดำเนินการรวบรวมข้อมูลเว็บไซต์ทั้งหมดหากไม่มีไฟล์ robots.txt อยู่ เมื่อตรวจพบไฟล์ robots.txt GoogleBot จะทำตามคำแนะนำของคุณขณะรวบรวมข้อมูล หากมีปัญหาในการตรวจหาไฟล์หรือพบข้อผิดพลาด ระบบอาจไม่รวบรวมข้อมูลเว็บไซต์ของคุณ คุณต้องใช้ไฟล์ robots.txt อย่างถูกต้อง จัดระเบียบสถาปัตยกรรมเว็บไซต์ของคุณ และใช้แนวทางปฏิบัติที่ดีที่สุดสำหรับ SEO ในหน้าเว็บเพื่อหลีกเลี่ยงปัญหาใดๆ กับการรวบรวมข้อมูล คุณสามารถทำการตรวจสอบเว็บไซต์เพื่อวิเคราะห์และระบุปัญหาใดๆ ก็ตามที่รบกวนเว็บไซต์ของคุณ

ต้องการบริการ SEO สำหรับเว็บไซต์ของคุณหรือไม่

หากคุณกำลังมองหาผู้ให้บริการที่เข้าใจว่าโปรแกรมรวบรวมข้อมูลเว็บและการจัดทำดัชนีการค้นหาทำงานอย่างไรเพื่อปรับปรุงอันดับเว็บไซต์ของคุณ Inquivix คือพันธมิตร SEO ที่คุณกำลังมองหา เราให้บริการ SEO บนหน้าเว็บที่ครอบคลุมตั้งแต่การสร้างเนื้อหา การเพิ่มประสิทธิภาพสถาปัตยกรรมเว็บไซต์ และการวิเคราะห์ประสิทธิภาพเว็บไซต์เพื่อปรับปรุงคุณภาพของประสบการณ์เว็บไซต์ของคุณ หากต้องการเรียนรู้เพิ่มเติม เยี่ยมชม Inquivix On-Page SEO Services วันนี้!

คำถามที่พบบ่อย

เครื่องมือค้นหาใช้โปรแกรมที่เรียกว่า 'โปรแกรมรวบรวมข้อมูลเว็บ' หรือที่เรียกว่า 'สไปเดอร์' หรือ 'บอท' เพื่อค้นหาทั้งเนื้อหาใหม่และเนื้อหาที่อัปเดตบนหน้าเว็บไซต์ จากนั้นจะไปตามลิงก์ที่รวมอยู่ในหน้าเพื่อค้นหาหน้าเพิ่มเติม เนื้อหาที่พบในเพจจะถูกบันทึกไว้ในดัชนีซึ่งใช้เพื่อดึงข้อมูลสำหรับผลการค้นหาเมื่อผู้ใช้ร้องขอ

GoogleBot Desktop และ GoogleBot Mobile เป็นโปรแกรมรวบรวมข้อมูลเว็บที่ได้รับความนิยมสูงสุดในประเทศส่วนใหญ่ ตามมาด้วย Bingbot, Slurp Bot และ DuckDuckBot Baiduspider ส่วนใหญ่ใช้ในประเทศจีนในขณะที่ Yandex Bot ใช้ในรัสเซีย