Büyük Veri Çağında Web Verisi Kazıma: Fırsatlar ve Etik İkilemler

Yayınlanan: 2024-05-29Web Veri Kazıma ve Büyük Veri Analitiği

Web veri kazıma, çevrimiçi veri toplamak için önemli bir mekanizma olarak ortaya çıkmıştır. Bu süreç, web sitelerinden bilgilerin otomatik olarak alınmasını ve yapılandırılmamış web'in analiz için hazır, zengin bir yapılandırılmış veri zenginliğine dönüştürülmesini içerir.

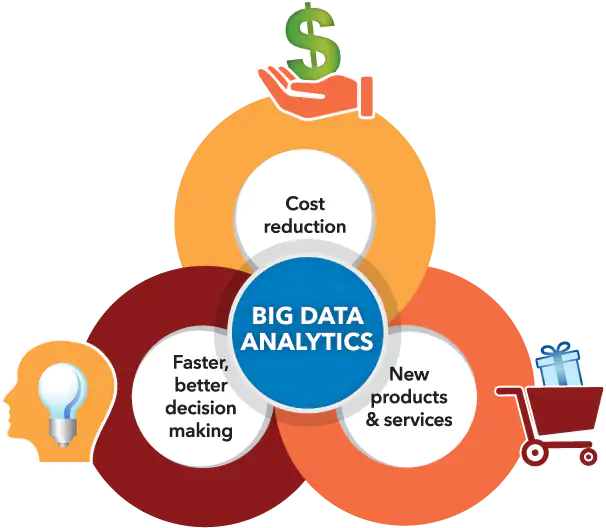

Resim Kaynağı: https://www.sas.com/

Aynı zamanda, büyük veri analitiği, genellikle web verilerinin kazınması yoluyla biriken büyük veri kümelerinden kalıpları, eğilimleri ve içgörüleri ayırt etme konusunda bir niş oluşturdu. Büyük miktarda veri (her gün yaklaşık 2,5 kentilyon bayt veri üretiliyor) daha erişilebilir hale geldikçe, web veri kazımasının büyük veri analitiği ile sentezi işletmeler, araştırmacılar ve politika yapıcılar için sayısız olasılığın kilidini açıyor.

Bu teknolojik yetenekleri ustalıkla birleştirerek, kendilerini veri odaklı karar alma sürecinden faydalanacak, hizmet yeniliklerini teşvik edecek ve hedeflerine göre uyarlanmış stratejik girişimler şekillendirecek şekilde konumlandırıyorlar. Bununla birlikte, bu gelişmiş araçlar arasındaki sinerjik ilişkiden kaynaklanan etik ikilemlerin yüzeye çıktığını kabul etmek önemlidir.

Veri değerinin en üst düzeye çıkarılması ile bireylerin gizlilik haklarının korunması arasındaki kritik denge konusunda ince bir çizginin dikkatli bir şekilde aşılması ve her iki yönün de diğerini gölgede bırakmaması gerekir.

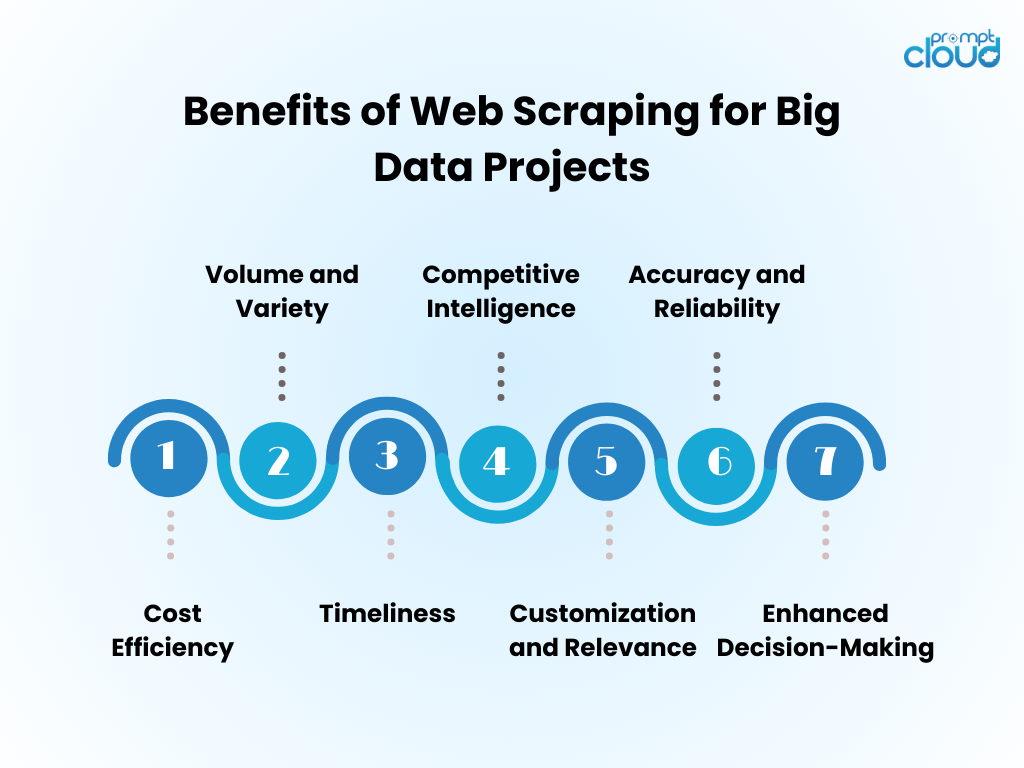

Büyük Veri Projeleri İçin Web Veri Kazımanın Faydaları

- Maliyet Verimliliği : Web kazıma yoluyla veri toplamanın otomatikleştirilmesi, insan işgücü maliyetlerini önemli ölçüde azaltır ve içgörü elde etme süresini hızlandırır.

- Hacim ve Çeşitlilik : Büyük veri analitiğini beslemek için kritik öneme sahip, çeşitli kaynaklardan büyük miktarda verinin yakalanmasına olanak tanır.

- Zamanlılık : Web kazıma, gerçek zamanlı veya gerçek zamanlıya yakın veriler sağlayarak pazar eğilimlerine daha çevik yanıtlar verilmesine olanak tanır.

- Rekabetçi İstihbarat : Organizasyonlara rakipleri ve sektördeki değişiklikleri yakından takip etme yeteneği kazandırır.

- Özelleştirme ve Uygunluk : Veriler, analizin amacına uygun ve odaklanmış olmasını sağlayacak şekilde özel ihtiyaçlara göre uyarlanabilir.

- Doğruluk ve Güvenilirlik : Otomatik kazıma, insan hatasını en aza indirerek daha doğru veri kümelerine yol açar.

- Gelişmiş Karar Verme : Zamanında, ilgili verilere erişim, bilinçli karar almayı ve stratejik planlamayı destekler.

Web Kazıma Teknikleri: Temelden İleri Seviyeye

Görüntü Kaynağı: oturum açma çalışmaları

Web veri kazıma, veri karmaşıklığı arttıkça ilerleyen temel tekniklerle başlayarak teknolojiyle birlikte gelişti.

- Temel Teknikler : Başlangıçta, kazıyıcılar, HTML sayfalarını elde etmek için basit HTTP isteklerini kullanarak verileri alır ve içeriği Python'daki Beautiful Soup gibi kitaplıklar aracılığıyla ayrıştırır. Bu araçlar karmaşık olmayan web sitelerini yeterince işleyebilir.

- Orta Düzey Teknikler : Dinamik içerik için teknikler, JavaScript ile etkileşime girebilen ve tarayıcı davranışını taklit edebilen Selenium gibi otomasyon araçlarını içerecek şekilde gelişir.

- Gelişmiş Teknikler : Gelişmiş kazımaya doğru ilerleyen yöntemler, kazımaya karşı önlemler arasında gezinmek için başsız tarayıcıları ve proxy sunucuları içerir. Veri çıkarma, makine öğrenimi algoritmaları, bilgi almak için doğal dil ve görüntülerin işlenmesiyle karmaşık hale gelir.

- Etik Hususlar : Teknik karmaşıklığa bakılmaksızın, veri erişimi ile mahremiyet ve mülkiyete saygı arasında bir denge gerektiren etik ikilemler devam etmektedir.

Web'den Toplanan Verileri Büyük Veri Analitiğine Dahil Etme

Web'den alınan veriler, büyük veri analitiğine entegre edildiğinde kapsamlı pazar öngörülerini ve tüketici eğilimlerini ortaya çıkarabilir. Analistler, web'den kazınmış bilgileri mevcut veri kümeleriyle birleştirerek analitik sonuçların derinliğini ve kapsamını artırır. Bu birleşme, gelişmiş öngörü modellerine, özel pazarlama stratejilerine ve rafine tüketici profillerine yol açıyor.

- Veri Temizleme: Kazınmış veriler, analitikte doğruluğu sağlamak için titiz bir temizlik gerektirir.

- Veri Entegrasyonu: Kazınmış verilerin diğer kaynaklarla birleştirilmesi, ileri veri entegrasyon tekniklerini gerektirir.

- Analiz Geliştirme: Ek verilerle makine öğrenimi algoritmaları daha incelikli kalıpları ortaya çıkarabilir.

- Etik Hususlar: Analistler web veri kullanımının yasal ve etik standartlara uygun olmasını sağlamalıdır.

Artırılmış veri havuzu yeniliği teşvik ediyor ancak aynı zamanda sıkı bir metodoloji ve etik gözetim gerektiriyor.

Verimli Web Scraping için En İyi Uygulamalar

- robots.txt protokollerine saygı gösterin; Buna izin vermeyen siteleri robot dosyaları aracılığıyla kazımayın.

- Hedef sunucunun performansı üzerindeki etkiyi en aza indirmek için kazıma etkinliklerini yoğun olmayan zamanlarda planlayın.

- Aynı içeriğin yeniden kazınmasını önlemek, web sitesinin verilerine saygı duymak ve bant genişliğinden tasarruf etmek için önbelleğe almayı kullanın.

- Kazıyıcınızın çökmesini önlemek ve hata durumunda çok fazla istek gönderilmesini önlemek için uygun hata işlemeyi uygulayın.

- Engellenmeyi önlemek için kullanıcı aracılarını ve IP adreslerini döndürerek daha doğal tarama davranışını simüle edin.

- Kazıma faaliyetlerinizin telif haklarını veya gizlilik yasalarını ihlal etmediğinden emin olarak yasal ve etik web kazıma uygulamaları hakkında bilgi sahibi olun.

- Kodu verimli olacak şekilde optimize edin ve hem kazıma sistemindeki hem de hedef web sitelerindeki yükü azaltın.

- Veri alımınızın etkinliğini ve doğruluğunu koruyarak, web sitesi düzeni veya teknolojisindeki herhangi bir değişikliğe uyum sağlamak için kazıma kodunu düzenli olarak güncelleyin.

- Toplanan verileri güvenli bir şekilde saklayın ve ilgili tüm veri koruma düzenlemelerine uygun şekilde yönetin.

Büyük Veri Çağında Web Scraping'in Geleceği

Büyük Veri genişlemeye devam ettikçe, web verilerinin kazınması, veri analizi ve iş zekası açısından daha da tamamlayıcı hale gelmeye hazırlanıyor. Gelecek muhtemelen şunları görecek:

- Kazıma yoluyla elde edilen geniş veri kümeleriyle eğitilen gelişmiş makine öğrenimi modelleri, doğruluğu ve öngörüleri artırır.

- İşletmelerin daha hızlı, veriye dayalı kararlar almasına olanak tanıyan gerçek zamanlı veri kazıma talebinin artması.

- Kazımayı önleyici teknolojilerde gezinmek ve etik veri toplama uygulamalarını sürdürmek için daha karmaşık kazıma araçlarının geliştirilmesi.

- Web verilerini kazıma yöntemlerini şekillendiren, verilerin sorumlu bir şekilde ve rıza alınarak toplanmasını sağlayan daha katı düzenlemeler ve gizlilik yasaları.

- Her boyuttaki işletme için özel veri çıkarma olanağı sunan hizmet olarak kazıma platformlarının ortaya çıkışı.

Bu gelişmelerle birlikte web kazıma, Büyük Veri araç setinde kritik bir araç olmaya devam edecek.

Manuel web kazıma göz korkutucu geliyorsa veya değerli verilerin elde edilmesiyle ilgili karmaşık zorlukları çözmek için yardıma ihtiyaç duyulursa, PromptCloud'un yardıma hazır olduğundan emin olabilirsiniz!

Güvenilir, büyük ölçekli veri çıkarımı sağlayarak, büyük veri girişimleri için özel olarak tasarlanmış kapsamlı web kazıma çözümleri sunma konusunda uzmanız.

Güçlü ve anlamlı veri kümeleri kullanarak iyi bilgilendirilmiş seçimler oluşturmaya odaklanmanızı sağlayacak zorlu yönlerin üstesinden gelmemiz için bize güvenin. Uzmanlığımızın büyük veri oyun planınızı nasıl güçlendirebileceğini keşfetmek için sales@promptcloud.com adresinden bizimle iletişime geçin!