Web Scraping Techniques 2023 – Eksiksiz Bir Kılavuz

Yayınlanan: 2023-07-06Çevrimiçi hazine avcılığının uçsuz bucaksız dünyasında, web kazıma, değerli bilgi cevherlerini çıkarmak için nihai araç haline geldi. İster yalnız bir maceracı olun, ister veriye aç bir kuruluş olun, web scraping, dijital araç setinizdeki güvenilir kazmadır.

Ancak, tüm web kazıma teknikleri eşit yaratılmamıştır. Eldeki görev için mükemmel oltayı seçmek gibi. Ne de olsa Moby Dick gibi devasa bir yaratığı yakalamak için küçük bir kanca getirmezsin, değil mi? Bu blogda manuel, otomatik ve gelişmiş web kazıma tekniklerinin ardındaki sırları açıklayacağız.

Her birinin kendi özel güçleri ve zayıflıkları olan bir süper kahraman ekibi oluşturduğunuzu hayal edin. Aynı şekilde, her kazıma yaklaşımının da güçlü yanları ve sınırlamaları vardır.

Ancak web kazımada sorumlu eylemlerin önemini unutmayalım. Tıpkı bir şövalyenin yeminini asla bozmayacağı gibi, kazımak istediğiniz web sitelerinin hizmet şartlarına etik olarak kazımak ve saygı duymak çok önemlidir.

Otomatik Web Kazıma Teknikleri

Otomatik web kazıma, web sitelerinden verileri otomatik olarak çıkarmak için yazılım veya araçlar kullanma sürecini ifade eder. Bu otomatikleştirilmiş yaklaşım, verilerin manuel olarak kopyalanması ve yapıştırılması ihtiyacını ortadan kaldırarak çeşitli çevrimiçi kaynaklardan verimli ve büyük ölçekli veri toplamaya olanak tanır.

1. Web kazıma Kitaplıkları

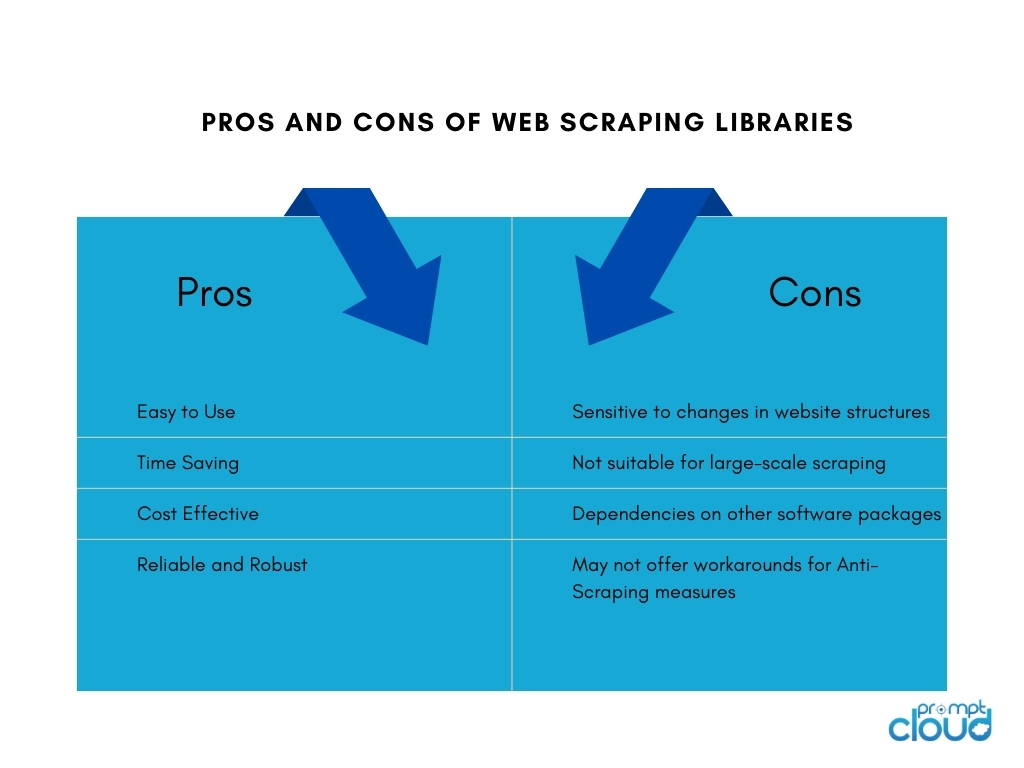

Web kazıma kitaplıkları, web kazıma görevlerini kolaylaştırmak için önceden oluşturulmuş işlevler ve yardımcı programlar sağlayan yazılım araçları veya çerçeveleridir. Her şeyi sıfırdan yazmaya gerek kalmadan web kazıma gerçekleştirmenin basitleştirilmiş ve verimli bir yolunu sunarlar. Zaman kazandırır, üretkenliği artırır ve çeşitli çevrimiçi kaynaklardan daha verimli veri toplamayı mümkün kılar.

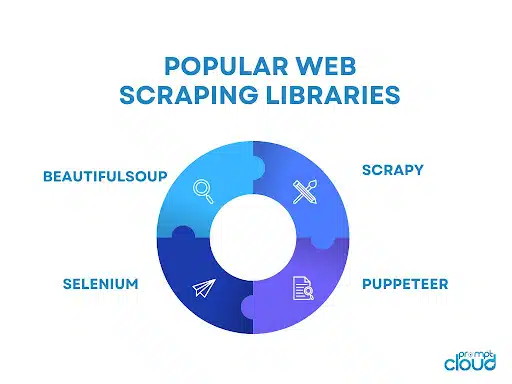

Popüler web kazıma kitaplıklarından bazıları şunlardır:

- BeautifulSoup: HTML ve XML belgelerini ayrıştırmak için sezgisel bir API sağlayan ve kullanıcıların zahmetsizce gezinmesine ve verileri ayıklamasına olanak tanıyan, web kazıma için yaygın olarak kullanılan bir Python kitaplığı.

- Scrapy: Otomatik istek azaltma, öğe ardışık düzenleri ve sayfalandırmayı işlemek için yerleşik destek gibi özelliklerle ölçeklenebilir ve verimli web tarayıcıları oluşturmak için kapsamlı bir araç seti sağlayan web kazıma için güçlü bir Python çerçevesi.

- Selenyum: Web kazıma için otomatik tarayıcı etkileşimlerine izin veren, özellikle dinamik içerik ve JavaScript ağırlıklı web siteleriyle uğraşırken yararlı olan çok yönlü bir kitaplık.

- Puppeteer: Başsız bir Chrome veya Chromium tarayıcıyı kontrol etmek için üst düzey bir API sağlayan, JavaScript kullanarak web kazıma ve web sayfalarıyla etkileşime olanak tanıyan bir Node.js kitaplığı.

2. Web Kazıma Araçları ve Hizmetleri

Web kazıma Araçları

Web kazıma araçları, web kazıma sürecini otomatikleştirmek ve basitleştirmek için özel olarak tasarlanmış yazılım uygulamaları veya platformlardır. Bu araçlar genellikle, kullanıcıların kapsamlı programlama bilgisi gerektirmeden web sitelerinden çıkarmak istedikleri verileri belirlemelerine olanak tanıyan kullanıcı dostu bir arayüz sağlar.

Tipik olarak veri öğelerinin işaretle ve tıkla seçimi, zamanlama ve izleme yetenekleri ve veri dışa aktarma seçenekleri gibi özellikler sunarlar. Web kazıma araçları, kapsamlı kodlama veya geliştirme kaynaklarına ihtiyaç duymadan veri ayıklamaya ihtiyaç duyan bireyler veya işletmeler için faydalı olabilir.

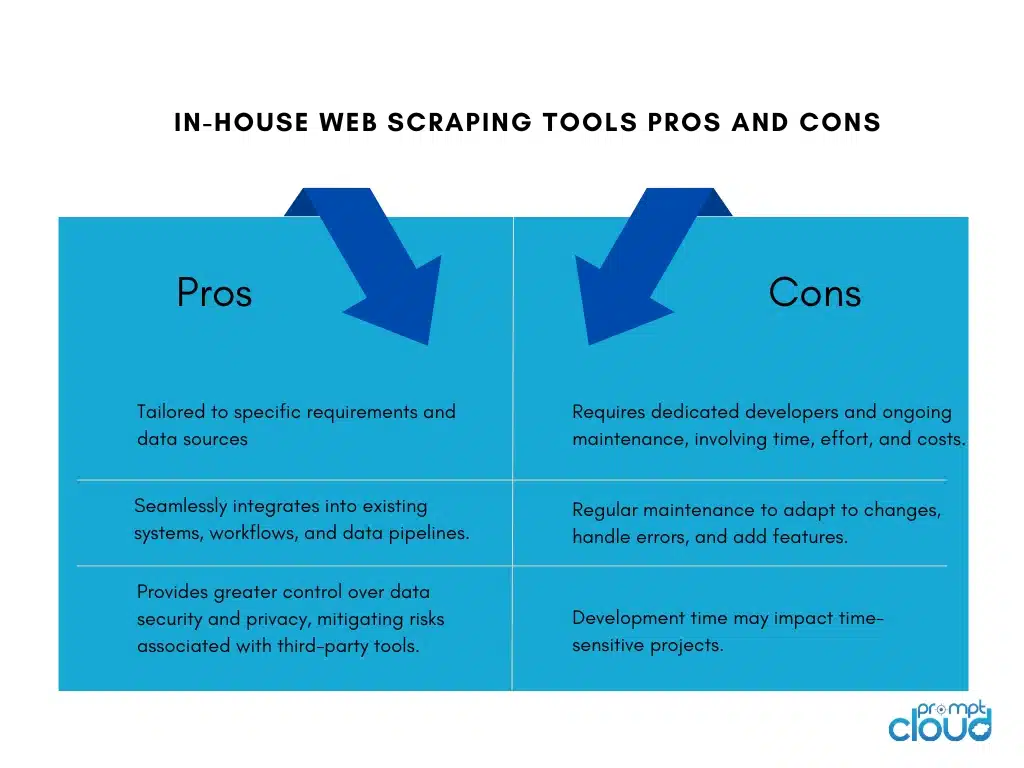

Şirket İçi Web Kazıma Araçları Oluşturma

Bir şirket için şirket içi bir web kazıma aracı oluşturmanın artıları ve eksileri vardır:

Web kazıma hizmetleri

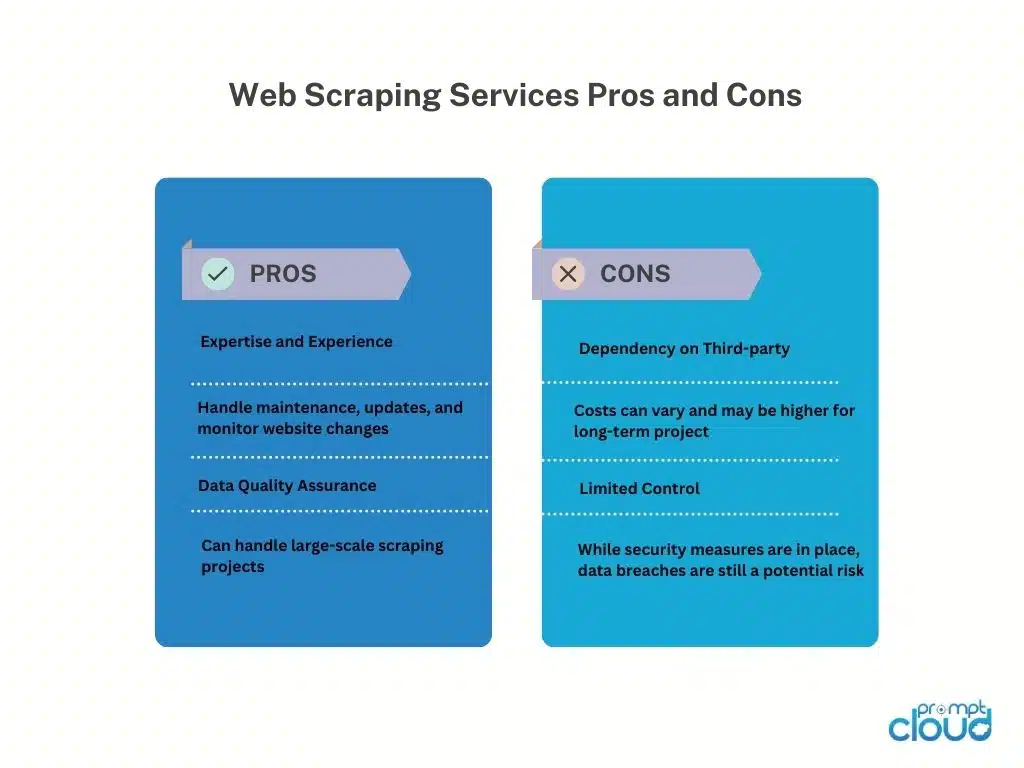

Web kazıma servis sağlayıcıları, web sitelerinden veri çıkarma için özel hizmetler sunar. Bu sağlayıcılar tipik olarak, müşteriler adına web kazıma görevlerini yerine getirmeye adanmış altyapıya, araçlara ve uzmanlığa sahiptir.

İşte web kazıma servis sağlayıcılarını kullanmanın artıları ve eksileri:

Web Scraping API'leri

Web kazıma API'leri, geliştiricilerin standartlaştırılmış yöntemler kullanarak web sitelerine erişmesine ve bu web sitelerinden veri almasına olanak tanıyan programatik bir arayüz sağlar. Bu API'ler, geleneksel kazıma tekniklerine kıyasla web kazımaya daha yapılandırılmış ve kontrollü bir yaklaşım sunar. Geliştiriciler, ihtiyaç duydukları verileri belirterek ve kazınmış verileri JSON veya XML gibi yapılandırılmış bir biçimde alarak API'ye istekler gönderebilir.

Artıları

Web kazıma API'leri, kazıma sürecini basitleştirerek geliştiricilerin API'yi entegre etmeye ve verileri işlemeye odaklanmasına olanak tanır. Sağlayıcı bakımı nedeniyle güvenilirlik ve performans sunarlar ve kimlik doğrulama ve oran sınırlama gibi özellikler içerebilirler. API'ler ayrıca hizmet şartları ve yasal gerekliliklerle uyumluluğa yardımcı olur.

Eksileri

Web kazıma API'lerini kullanmanın sınırlamaları vardır. Veri kullanılabilirliği ve yetenekler, desteklenen web sitelerindeki olası kısıtlamalar ve kazıma limitleri ile birlikte API sağlayıcısına bağlıdır. Harici API bağımlılığı, sağlayıcı kullanılabilirliği ve performansına bağımlılık getirerek veri alımını etkiler. Ayrıca, yüksek hacimli veya ticari kullanımla ilişkili maliyetler olabilir.

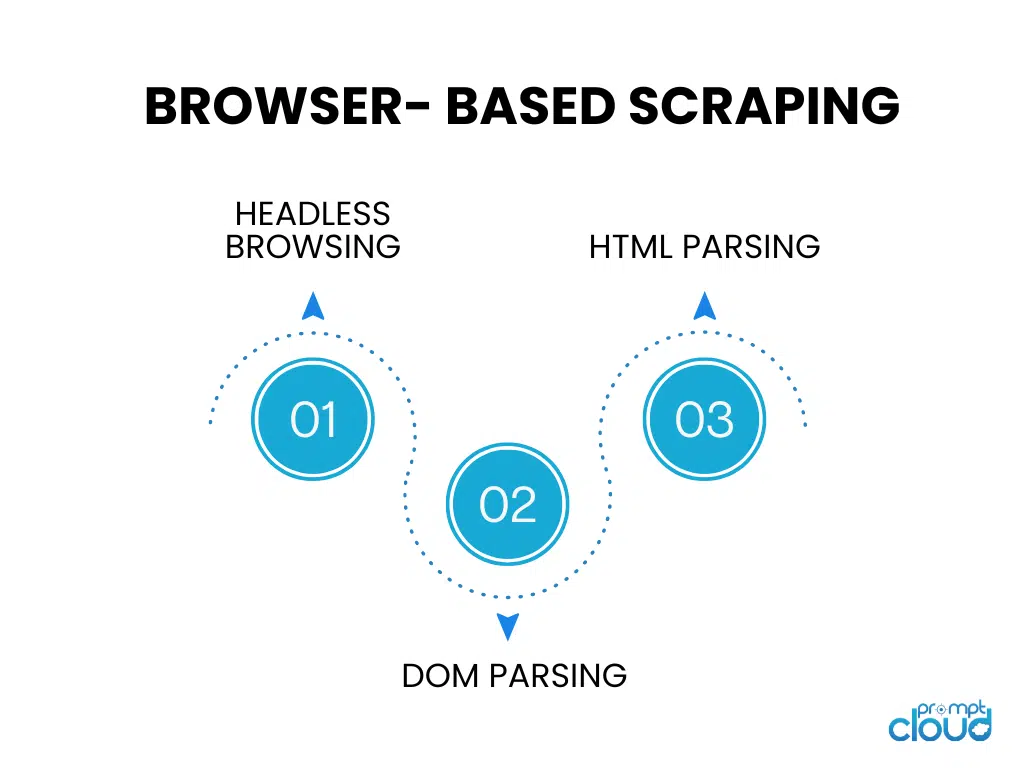

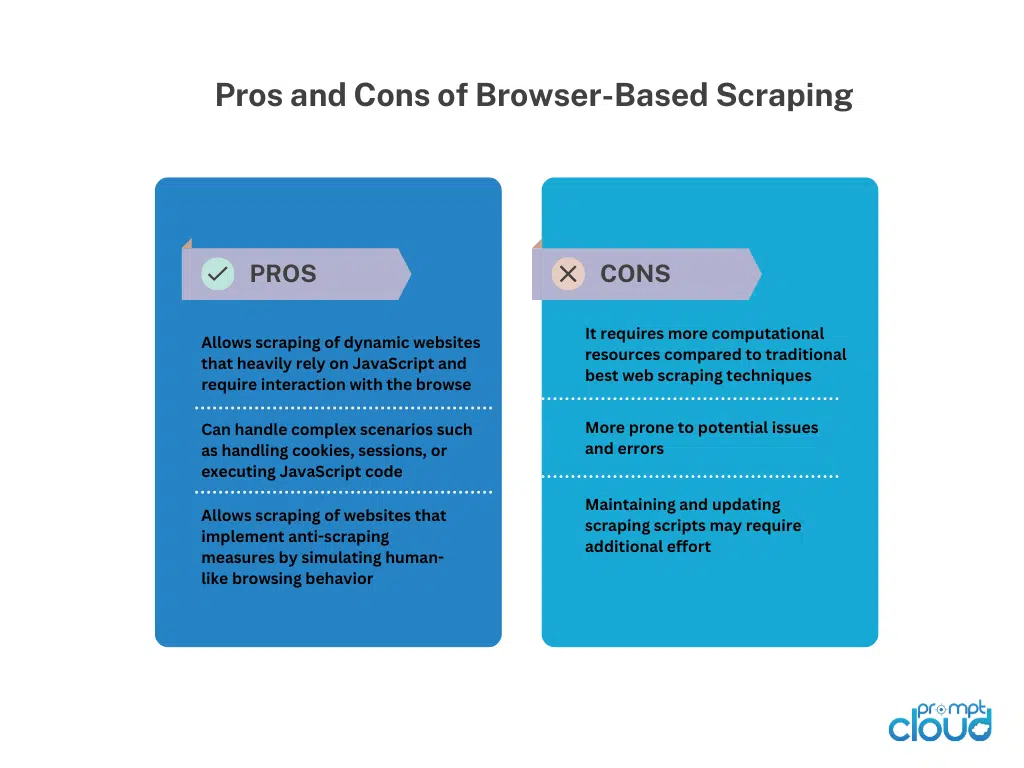

Tarayıcı Tabanlı Scraping

Başsız Tarama

Başsız tarama, grafik kullanıcı arabirimi olmayan bir web tarayıcısı çalıştırarak otomatik taramaya ve kod kullanan web siteleriyle etkileşime izin verir. Büyük ölçüde istemci tarafı oluşturmaya dayanan dinamik web sitelerini kazımak için idealdir.

DOM Ayrıştırma

DOM ayrıştırma, Belge Nesne Modeli'ne erişerek bir web sayfasının HTML yapısını değiştirmeyi içerir. Bu, programlı olarak öğelerin, niteliklerin veya metnin hedefli olarak çıkarılmasını sağlar.

HTML Ayrıştırma

HTML ayrıştırma, istenen verileri çıkarmak için bir web sayfasının HTML kaynak kodunu analiz eder. HTML yapısını yorumlamak ve veri ayıklamak için belirli etiketleri, nitelikleri veya kalıpları tanımlamak için kitaplıkları veya ayrıştırıcıları kullanır. HTML ayrıştırma, statik web sayfalarını JavaScript yürütmeden kazımak için yaygın olarak kullanılır.

Manuel Web Kazıma Teknikleri

Manuel Web Kazıma Teknikleri

Manuel web kazıma, otomatik araçlar veya komut dosyaları kullanılmadan web sitelerinden manuel olarak veri çıkarma sürecini ifade eder. Web sitelerinde gezinmek, ilgili bilgileri aramak ve çeşitli teknikler kullanarak veri çıkarmak için insan müdahalesini içerir.

Manuel Web Kazıma Teknikleri:

Ekran Yakalama: Bu teknik, programlı olarak ayrıştırılması zor olan resimler, grafikler veya tablolar gibi görsel verileri çıkarmak için web sayfalarının ekran görüntülerini veya videolarını yakalamayı içerir.Yakalanan ortamdan manuel çıkarma, veri alımını sağlar.

Veri Girişi: Veri girişinde, gerekli bilgiler web sayfalarından manuel olarak kopyalanarak elektronik tablo veya veri tabanı gibi istenilen formatta girilir.Web sayfalarında gezinmeyi, veri seçmeyi ve onu hedef hedefe girmeyi içerir. Veri girişi, kolayca kopyalanıp yapıştırılabilen yapılandırılmış veriler için uygundur.

Manuel web kazıma, karmaşık web siteleri, JavaScript etkileşimi veya kazıma önleme önlemleri ile uğraşırken esneklik sunar. Ancak zaman alıcıdır, büyük ölçekli görevler için daha az uygundur ve insan hatalarına açıktır. İnsan çabası, detaylara dikkat ve dikkatli uygulama gerektirir.

Hibrit Web Kazıma Teknikleri

Hibrit web kazıma, web sitelerinden verimli ve doğru veri çıkarma için otomatik araçları ve manuel müdahaleyi birleştirir. Otomatik araçlar, gezinme ve yapılandırılmış veri çıkarma gibi tekrarlayan görevleri yerine getirirken, ekran yakalama veya veri girişi gibi manuel teknikler, karmaşık senaryoları ve görsel/yapılandırılmamış verileri ele alır.

Hibrit Web Scraping, insan muhakemesi esnekliğinin yanı sıra ölçeklenebilirlik ve otomasyon hızı sunar. Farklı yapılara, dinamik içeriğe veya kazıma önleme önlemlerine sahip web sitelerine uygundur. Seçim, web sitesinin karmaşıklığına, veri türüne ve mevcut kaynaklara bağlıdır ve kapsamlı veri çıkarma için dengeli bir yaklaşım sağlar.