可解释的人工智能如何开启人工智能的负责任和道德发展

已发表: 2023-09-01随着创新与独创性相结合的变革时刻的出现,例如 2022 年 11 月 OpenAI 的 ChatGPT 的推出,人工智能控制我们生活的愿景不再是科幻小说。

ChatGPT 的推出,迎来了业界所谓的“AI 寒武纪大爆发”的分水岭。

然而,这不仅仅是利用人工智能获取商业收益,这是当前爆炸式增长的焦点。 这一演变的核心是呼吁关注人工智能的可解释性。 这将确保人工智能的进步既强大又透明——这是人工智能发展道德的基础。

人工智能已经在许多领域为我们做出决策。 但不了解人工智能如何做出这些决策仍然是一个瓶颈。 这是企业家和技术专家不能忽视的一项可以解释的人工智能优势。

随着技术的进步,技术专家面临双重挑战:突破人工智能所能实现的界限,同时确保其工作透明、负责且符合道德规范。 这凸显了可解释的人工智能在现代技术中的作用。

人工智能的经济潜力

生成式人工智能彻底改变生产力的潜力不仅仅是理论上的,而且是现实的。 它将在全球范围内产生切实的经济影响。 根据麦肯锡 2023 年 6 月发布的题为“生成式 AI 的经济潜力:下一个生产力前沿”的报告,在 63 个分析用例中,生成式 AI 每年可以增加 2.6 万亿美元至 4.4 万亿美元的价值。 还有一些可解释的人工智能用例可以通过多种新颖的方式使行业受益。

另请阅读:商业生成人工智能如何塑造行业

《华盛顿邮报》报道称,超过 11,000 家公司已经使用了微软云部门提供的 OpenAI 工具,凸显了伴随这一潜力的采用趋势。 这些数字代表了技术领导者在不断变化的环境中驾驭的机会和责任。

随着人工智能的变革潜力变得显而易见,人们越来越重视可解释的人工智能原则,以确保这些强大的工具在清晰、监督和道德考虑的情况下运行。 可解释的人工智能应用程序将成为科技行业的基石。

然而,了解可解释的人工智能优势和其他相关方面仅仅是一个开始。 因此,在我们详细讨论可解释人工智能开发的细微差别之前,我们必须首先了解它为何如此重要。

人工智能模型之谜:探索“黑匣子”

与所有重大进步一样,人工智能也带来了挑战,其中一些挑战与其结构密切相关。 这个谜团的一个方面就是“黑匣子”。 代表一个可行的封闭操作模型,但即使是开发人员有时也无法解释它是如何工作的。 这在人工智能行业被称为黑匣子难题。

对于许多人来说,这种缺乏透明度是不可接受的,尤其是那些负责关键业务或社会决策的人。 无法解释的人工智能可能会削弱信任,尤其是在可能发生物理和物质损失的情况下。

不可预见的后果:当人工智能偏离轨道时

无法解释的人工智能决策的后果可能是轻微的效率低下,也可能是重大的社会影响。 以金融部门为例:人工智能系统可能会在没有提供明确理由的情况下拒绝向个人提供贷款。

这种缺乏透明度的决定可能会导致法律纠纷和声誉受损。 从更大的范围来看,在医疗保健领域,一个难以理解的人工智能可能会优先考虑一名患者而不是另一名患者进行治疗,从而改变生活甚至结束生命。

人工智能意外结果和事故的真实例子

几起事件凸显了人工智能不可预见的后果。 2018 年涉及 Uber 自动驾驶汽车的悲惨事件凸显了人工智能误解其环境时所产生的可怕影响。 一个被发现存在种族偏见的著名医疗算法清楚地提醒我们,无论人工智能多么先进,如果没有得到充分理解和监控,它都可能在无意中延续人类偏见。

这样的例子不胜枚举,从发推文“希特勒是对的”之类的微软泰伊,到收到巨额信用卡账单的美国国民。 如果没有护栏和解释人工智能所做决策的能力,此类情况将会不断发生,因此需要可解释性。

商业案例:可解释的人工智能优势

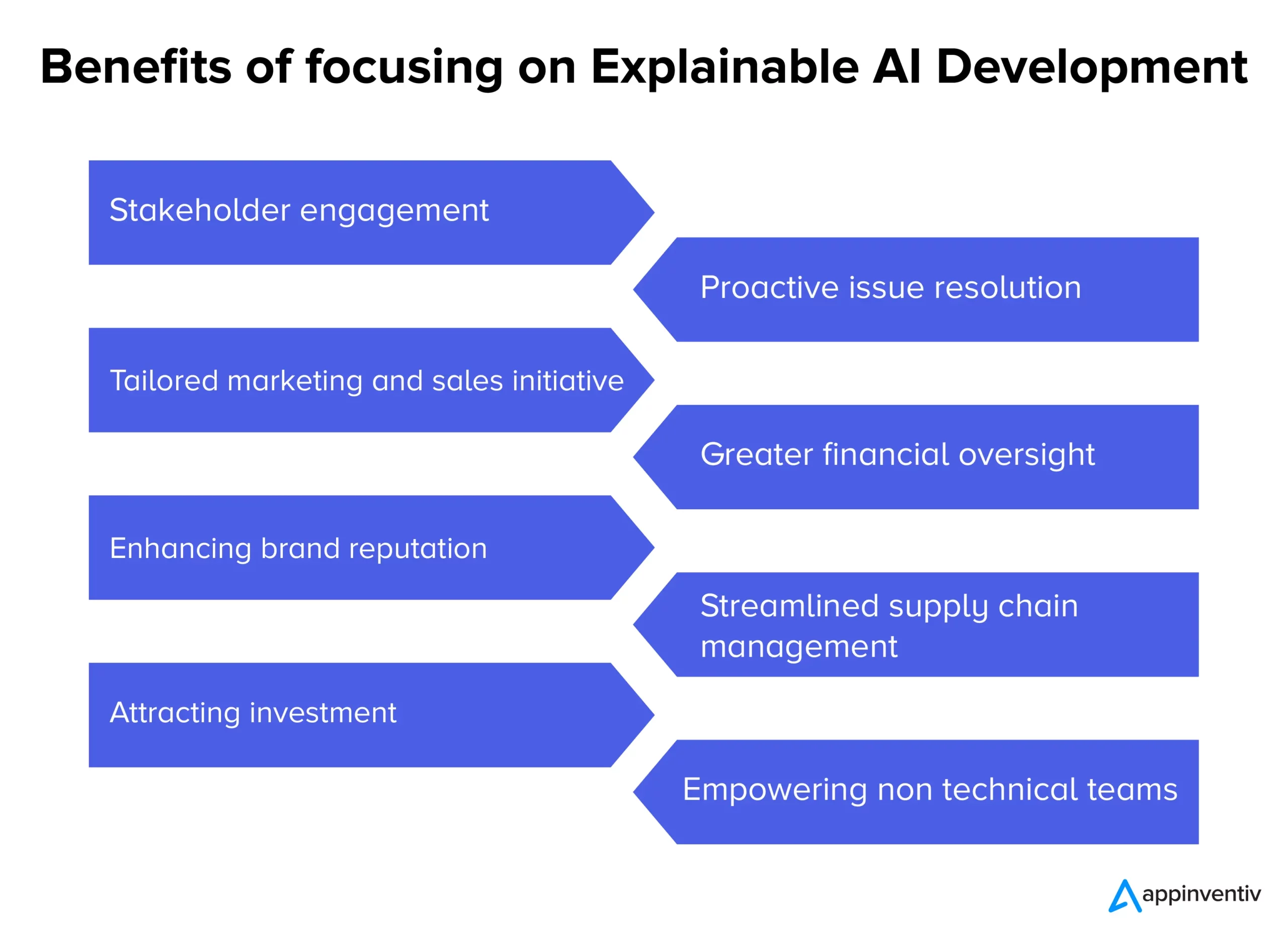

随着人工智能系统越来越雄心勃勃,其固有的不透明性引发了围绕透明度必要性的讨论。 除了技术讨论之外,还有强有力的商业理由支持采用可解释的人工智能。 以下是人工智能为各行业企业带来的各种可解释的好处。

- 利益相关者的参与和信心:透明的人工智能决策流程可以在内部团队和外部合作伙伴之间培养更深刻的参与感和保证感。

- 主动解决问题:在问题升级之前,可解释的人工智能可以突出潜在的关注领域,从而实现及时干预和解决方案。

- 量身定制的营销和销售计划:通过了解人工智能驱动的消费者洞察背后的“原因”,企业可以制定更加个性化和有效的营销活动。

- 更大的财务监督:当人工智能驱动的财务模型和预测透明时,可以更容易地识别和解决潜在的异常或增长领域。

- 提高品牌声誉:以道德和透明的人工智能部署而闻名的公司可能会享有更高的品牌声誉。

- 简化的供应链管理:借助清晰的人工智能驱动洞察,可以更有效地优化从库存管理到物流的供应链流程。

- 吸引投资:对于投资者来说,人工智能的透明度可以表明公司对负责任创新的承诺,使其成为更具吸引力的投资主张。

- 为非技术团队赋能:可解释的人工智能可确保没有深厚技术专业知识的团队可以获取并可操作人工智能驱动的见解和决策,从而促进跨部门协作。

当公司在现代复杂的环境中航行时,依赖黑盒解决方案可能是一场赌博。 人工智能流程的透明度不仅仅是技术升级,更是技术升级。 这是一种业务必要性,确保每项人工智能支持的举措都符合更广泛的组织目标和价值观,这标志着可解释的人工智能的作用。 这些也是企业家和人工智能开发人员通常关注的可解释的人工智能用例。

可解释的人工智能模型的蓝图

如今,人工智能对我们日常生活的影响日益明显,确保我们信任的能够做出关键决策的机器在工作中准确且透明变得至关重要。

开发可解释的人工智能模型不仅仅涉及编码;还涉及编码。 这是一个涉及战略规划、严格测试和基于可解释的人工智能原理和可解释的人工智能工具的迭代完善的过程。 这是分步指南和可解释的人工智能技术,可确保我们开发的人工智能模型可解释和解释,同时也符合法律规定。

- 了解问题领域:在深入模型开发之前,我们清楚地了解问题领域和所涉及的利益相关者。 用户期望什么? 人工智能将做出哪些决策,以及这些决策将产生什么影响,这些是我们寻找答案的一些问题。

- 选择适当的数据:数据的质量和相关性直接影响人工智能的准确性和可解释性。 在我们的人工智能模型开发中,我们确保数据干净、多样化且没有偏见。

- 选择正确的模型:虽然某些模型(例如深度神经网络)更复杂且更难以解释,但其他模型(例如决策树或线性回归)可以提供更高的透明度。 在开发可解释的人工智能模型时,我们选择复杂性和清晰度之间的平衡。

- 迭代测试:我们定期使用不同的数据集测试模型,以确保性能一致。 这些测试的反馈可以为改进和改进提供信息。

- 集成可解释性工具: LIME 或 SHAP 等工具有助于分解模型预测,提供有关哪些特征影响特定决策的见解。

- 文档:全面的文档可帮助我们进行模型验证、验证和部署。 它确保从开发人员到最终用户的所有利益相关者都了解人工智能的工作原理和局限性。

平衡模型性能与可解释性

可解释的人工智能软件开发中最重大的挑战之一是平衡模型的性能和可解释性。 虽然复杂的模型可能会提供更高的准确性,但它们通常会以透明度为代价。 相反,更简单的模型可能更容易理解,但可能无法有效捕捉数据中的细微差别。 为了达到适当的平衡,我们考虑以下因素:

- 模型简单性与复杂性:我们确定实现令人满意的性能所需的最低复杂性级别。 如果更简单的模型就足够了,那么它可能是确保可解释性的更好选择。

- 使用可解释性技术:特征重要性排序或模型无关方法等技术可以帮助使复杂模型更易于解释。

- 反馈循环:我们与最终用户保持持续的反馈循环,以了解人工智能的决策是否明确以及是否有提高透明度的空间。

虽然实现可解释的人工智能的过程可能看起来很复杂,但这是必要的。 随着我们进一步将人工智能集成到我们的系统和流程中,确保这些高性能和透明的模型对于持续的信任和效率至关重要。

Appinventiv 如何帮助您开发可解释的人工智能模型?

Appinventiv 拥有近九年的人工智能产品开发经验,了解与人工智能模型开发相关的各种复杂性和可解释的人工智能优势。 我们的工程师开发了许多基于人工智能的平台和应用程序,包括 Mudra(一款人工智能驱动的个人理财应用程序),拥有领域专业知识和监督,可以实现可解释的人工智能开发。

无论您的人工智能项目是什么,作为领先的人工智能开发公司,我们都可以解锁您的人工智能模型的可解释性和可解释性,以便您可以自信地信任模型做出的决策。 立即联系我们,踏上负责任的人工智能之旅。

经常问的问题

问:什么是可解释的人工智能?

A.可解释的人工智能是人工智能开发的范式转变,它要求以这样的方式开发人工智能模型:人工智能模型做出的决策可以被追溯,并且用户可以理解人工智能模型是如何做出决策的。

问:可解释的人工智能是如何工作的?

答:可解释的人工智能的工作原理是在开发过程中将可解释性的关键要素集成到人工智能模型中,这有助于确定人工智能模型如何做出特定的决策。

问:为什么可解释的人工智能很重要?

答:可解释的人工智能很重要,因为不了解人工智能模型如何为我们做出决策可能会导致一些可怕的后果,在最坏的情况下,可能会对相关人工智能模型的公司或用户造成切实的伤害。