如何在开发 AI 产品时避免合规性违规

已发表: 2023-06-12多年来,人工智能凭借其在制造、医疗保健和金融等数据和机器密集型领域的贡献,一直保持着顶级技术趋势。 然而,直到最近两年,该技术才引起最终用户的高度关注。 借助图像和文本生成器等应用程序,人们现在只需单击一下即可生成视觉效果和文本。

虽然这些人工智能平台看起来像是从头开始生产材料,但事实并非如此——这些人工智能平台已经接受了问题片段和数据湖的培训,这些平台通过处理来自互联网的文本和图像档案来工作。 尽管对最终用户有用,但该方法会带来版权侵权、不遵守开源许可证和知识产权侵权等法律风险。全球各国政府并非没有看到生成人工智能带来的这些风险,这些风险不断涌现围绕不道德的 AI 模型制定新的规则和处罚。

对于准备启动其 AI 项目的公司而言,至关重要的是,他们了解风险并构建一个不会因这些道德问题而受到法律监管的系统。 在本文中,我们将深入探讨软件开发过程中 AI 合规性的多个方面——法律问题的类型、为 AI 监管做准备的方法,以及不同地区遵循的 AI 行为。

什么是 AI 合规性?

这是一个确保 AI 驱动的应用程序符合其运行所在地区的法规和法律的过程。以下是 AI 合规性检查的不同因素:

人工智能的法律问题

虽然在微观层面上,最终用户使用人工智能的问题似乎仅限于剽窃或访问不可共享的数据,但在宏观层面上,不合规人工智能会带来更大的挑战。

使用构建不当的人工智能系统所带来的威胁会影响公平竞争、网络安全、消费者保护,甚至公民权利。 因此,企业和政府建立公平、合乎道德的模式至关重要。

版权

随着生成式 AI 的出现,企业已开始通过技术创建版权材料。 这样做的问题在于无法理解数据是由作者的创造力生成的,还是作者是人工智能。

为了使其符合法律要求,版权局发布了关于审查和注册包含 AI 生成材料的作品的指南。 它指出以下内容 -

- 版权只能保护人类创造力产生的材料。

- 对于使用基于 AI 的材料的作品,将考虑 AI 的贡献是来自“机械复制”还是作者的“自己的原创概念,他们通过 AI 赋予其可见的形式”。

- 申请人有义务在提交注册的材料中披露基于人工智能的内容。

另请阅读:2023 年开发 AI 内容检测工具的成本

开源

AI 驱动的代码生成器通常使用 AI 来协助开发人员自动完成或在开发人员测试或输入后建议代码。 以下是与围绕代码生成器开发合规人工智能模型相关的一些挑战——

- 用开源代码训练AI模型是否构成侵权?

- 谁负责满足开源合规性标准——开发人员还是用户?

- 开发人员使用基于 AI 的代码创建新软件是否需要应用程序获得开源许可?

知识产权侵权

在全球范围内,针对 AI 工具提起了多起侵权诉讼,指控它们基于第三方受 IP 保护的内容来训练模型或生成输出。

道德偏见

AI人脸识别技术导致种族歧视的事件不胜枚举。 无论是在 2020 年,黑人因电脑错误被捕,还是谷歌照片将黑人标记为“大猩猩”。 无论技术多么聪明,都不能忽视它是由带有偏见的人创造的

对于希望构建类似解决方案的公司来说,不要让这些偏见进入系统至关重要。

人工智能项目的 GDPR 合规性

话虽这么说,但了解为什么企业在严格监管的情况下仍无法构建合规的 AI 模型至关重要。 其背后可能有多种原因,包括无法了解合规性、开发人员缺乏理解,有时甚至是简单的无知。 但是,其背后也可能有一些功能性原因。

让我们从 AI 项目的 GDPR 合规性的角度来研究其中的一些。

目的限制

GDPR 原则要求企业有必要告知数据主体收集和处理其信息的目的。 挑战在于该技术使用数据来寻找模式并获得新的见解,但这可能不是该数据的真正目的。

歧视

GDPR 要求 AI 开发人员采取措施应对该技术可能带来的歧视性影响。 虽然这是当下的道德需求,但对于运营快速变化的社会场景的开发人员来说,针对每一种歧视和不道德的输出准备 AI 模型可能会变得具有挑战性。

数据最小化

GDPR 规定收集的信息应该“充分、有限且相关”。 这意味着人工智能开发团队在为他们的模型使用数据时应该非常小心,并且必须清楚他们的项目所需的数据量。

然而,这是不可预测的,因此团队必须定期评估满足数据最小化要求所需的数据类型和数量。

透明度

最后,用户应该对第三方如何使用他们的数据有发言权,为此,企业需要清楚他们正在使用什么数据以及如何使用。

这样做的问题是,大多数人工智能模型都是在黑匣子中运行的,并且不清楚它们是如何做出决策的,尤其是当我们谈论高级软件时。

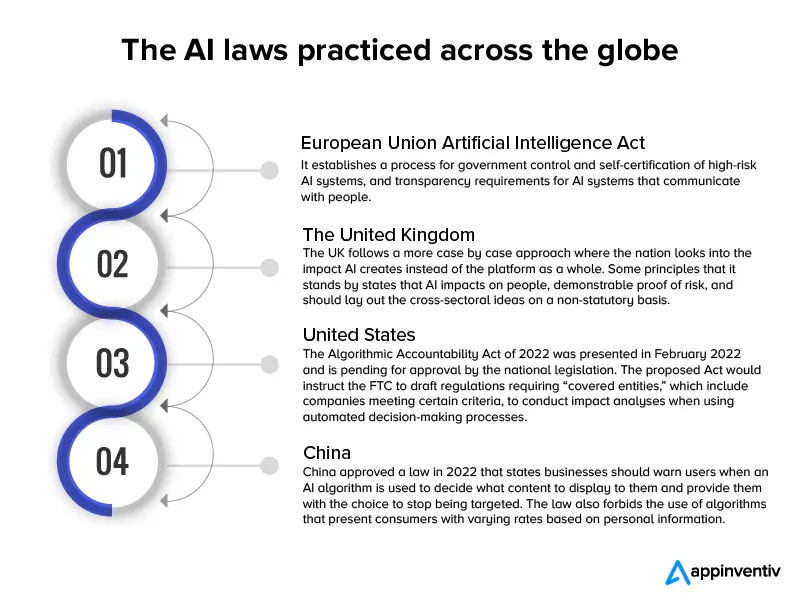

尽管这些都是真正的技术问题,但在涉及 IT 道德时,企业不要将它们用作开发有缺陷的 AI 模型的盾牌,这一点至关重要。 为了确保这种做法不会成为主流,已经在全球范围内制定了几项人工智能法律。

自 2017 年以来,近 60 个国家出台了人工智能法律法规,其行动路线与新人工智能模型的实施速度相匹配。

这是一张信息图,简要介绍了这些法律。

既然我们已经从法律的角度和全球适用法律的粗略草案研究了 AI 发展的挑战,让我们开始讨论构建合规 AI 应用程序的方法。

另请阅读:开发像 ChatGPT 这样合法合规的聊天机器人需要多少钱

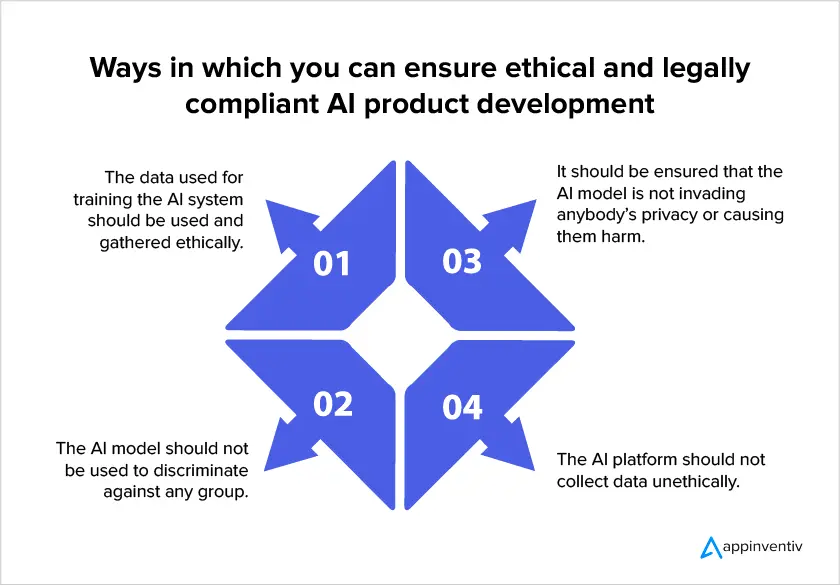

如何开发合规友好的 AI 模型

由于全球范围内人工智能法规的增多,企业在构建人工智能模型时关注法律合规性变得至关重要。 以下是公司在投资 AI 开发服务时可以确保其项目合法合规的一些方法。

- 确保您被允许使用数据

人工智能合规性规定,用户隐私应该是模型设计的指导原则。 这意味着您应该将需要收集的数据量保持在最低限度,指定收集数据的确切原因,以及您将使用他们的数据的时间。 最后,重要的是要注意用户应该同意数据收集。

- 可解释的人工智能方法

这种方法通过帮助人类了解 AI 系统内部的内容以及模型如何做出决策来帮助解决黑盒效应。 反过来,这有助于研究人员了解他们需要的确切数据量,以提高模型准确性以满足数据最小化要求。

- 跟踪收集的数据

AI 合规性要求企业了解收集的 PII 的位置和用途。 需要正确的数据分类以符合用户对受保护信息的权利。 此外,企业必须有一种方法来了解哪些信息存储在哪些数据集中,以准备准确的安全措施。

- 了解跨国数据传输规则

当人工智能系统中存在数据跨境传输时,开发者应考虑接收国适用的法规,并据此建立适当的数据传输机制。 例如,如果 GDPR 适用于数据处理并且个人数据被传输到非 EEA 国家/地区,则应进行适当的传输影响评估。

在开发 AI 应用程序时使用此类方法对确保妥善解决与该技术相关的风险大有帮助。 然而,公司和监管机构应该注意这样一个事实,即不可能保护应用程序免受每一个潜在风险,因为行业环境是在个案模型上运作的。 正因为如此,人工智能风险管理者的作用将仍然至关重要,因为他们将能够判断何时需要干预。

我们希望本文能帮助您了解未来对人工智能技术的法律结构有何期待,以及如何为合规的人工智能模型做好准备。

常见问题

问:人工智能是否存在任何法律问题?

答:是的。 构建不良的人工智能模型可能会引发许多法律和伦理问题。

- 版权

- 开源许可证滥用

- 知识产权侵权

- 种族歧视等道德偏见。

Q. 为什么做一个合法合规的AI模型这么难?

答:在技术方面,构建合法合规的 AI 可能很困难,因为虽然该技术使用客户的数据来寻找模式并获得新的见解,但很难确定该数据的真正用途。 其次,人工智能开发团队永远无法确定他们的项目所需的数据量。 最后,大多数 AI 模型都在黑匣子中运行,并且不清楚它们是如何做出决策的,尤其是当我们谈论高级软件时。

Q. 如何确保人工智能的合法合规性?

答:尽管有关 AI 合规性的法律法规在不断发展,但您可以采取以下措施来确保您的模型最接近合规性——

- 确保您被允许使用数据

- 可解释的人工智能方法

- 跟踪收集的数据

- 了解跨国数据传输规则