2023 年网页抓取技术 – 完整指南

已发表: 2023-07-06在广阔的在线寻宝世界中,网络抓取已成为提取有价值的信息宝石的终极工具。 无论您是孤独的冒险家还是渴求数据的企业,网络抓取都是您数字工具包中值得信赖的镐。

然而,并非所有网络抓取技术都是一样的。 这就像为手头的任务选择完美的钓鱼竿一样。 毕竟,你不会用一个小鱼钩来捕捉像莫比迪克这样的巨大生物,对吧? 在这篇博客中,我们将揭开手动、自动和高级网络抓取技术背后的秘密。

想象一下组建一支超级英雄团队,每个人都有自己的特殊能力和弱点。 同样,每种抓取方法都有其优点和局限性。

但我们不要忘记在网络抓取中负责任的行为的重要性。 正如骑士永远不会违背誓言一样,以道德方式进行抓取并尊重您想要抓取的网站的服务条款至关重要。

自动网页抓取技术

自动网页抓取是指使用软件或工具自动从网站中提取数据的过程。 这种自动化方法消除了手动复制和粘贴数据的需要,从而可以从各种在线来源高效且大规模地收集数据。

1. 网页抓取库

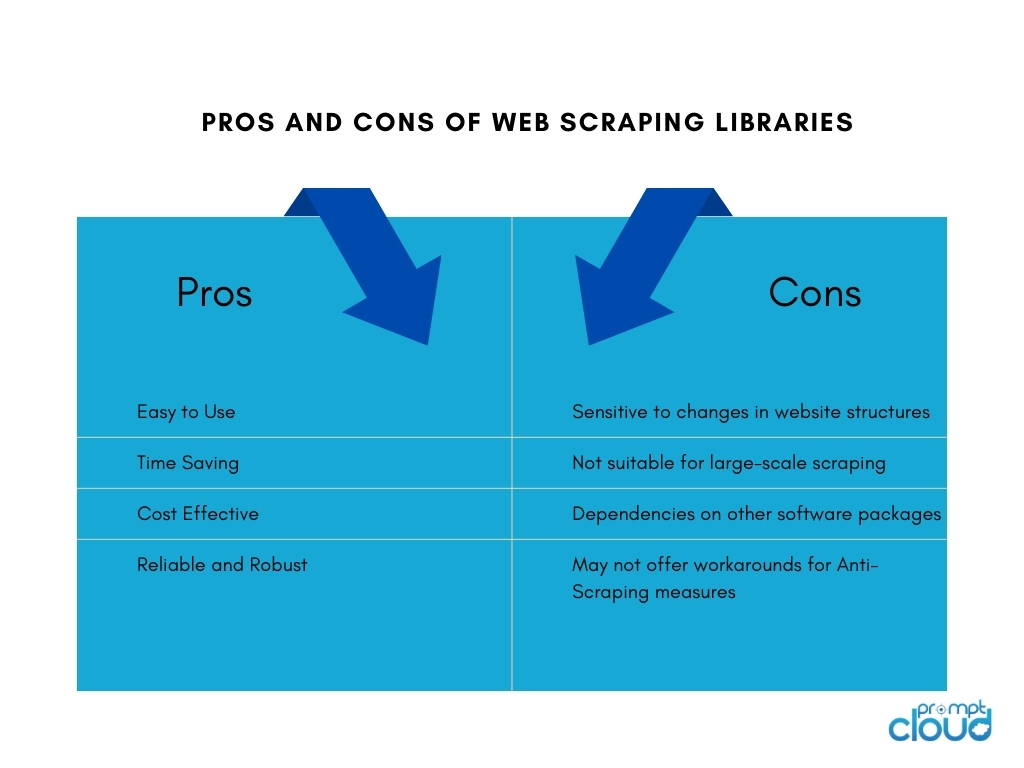

网页抓取库是提供预构建功能和实用程序以促进网页抓取任务的软件工具或框架。 它们提供了一种简单而有效的方法来执行网页抓取,而无需从头开始编写所有内容。 它们可以节省时间、提高生产力,并能够更有效地从不同的在线来源收集数据。

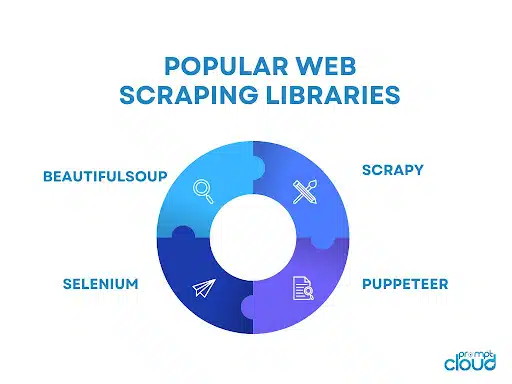

一些流行的网络抓取库包括:

- BeautifulSoup:广泛使用的用于网页抓取的 Python 库,提供直观的 API 来解析 HTML 和 XML 文档,允许用户轻松导航和提取数据。

- Scrapy:一个强大的 Python 网络抓取框架,提供了一套全面的工具来构建可扩展且高效的网络爬虫,具有自动请求限制、项目管道和处理分页的内置支持等功能。

- Selenium:一个多功能库,允许自动浏览器交互进行网页抓取,在处理动态内容和 JavaScript 密集型网站时特别有用。

- Puppeteer:一个 Node.js 库,提供高级 API 来控制无头 Chrome 或 Chromium 浏览器,支持使用 JavaScript 进行网页抓取和与网页交互。

2. 网页抓取工具和服务

网页抓取工具

网页抓取工具是专门为自动化和简化网页抓取过程而设计的软件应用程序或平台。 这些工具通常提供用户友好的界面,允许用户指定他们想要从网站提取的数据,而无需广泛的编程知识。

它们通常提供诸如点击式选择数据元素、调度和监控功能以及数据导出选项等功能。 网络抓取工具对于需要数据提取而无需大量编码或开发资源的个人或企业来说可能是有益的。

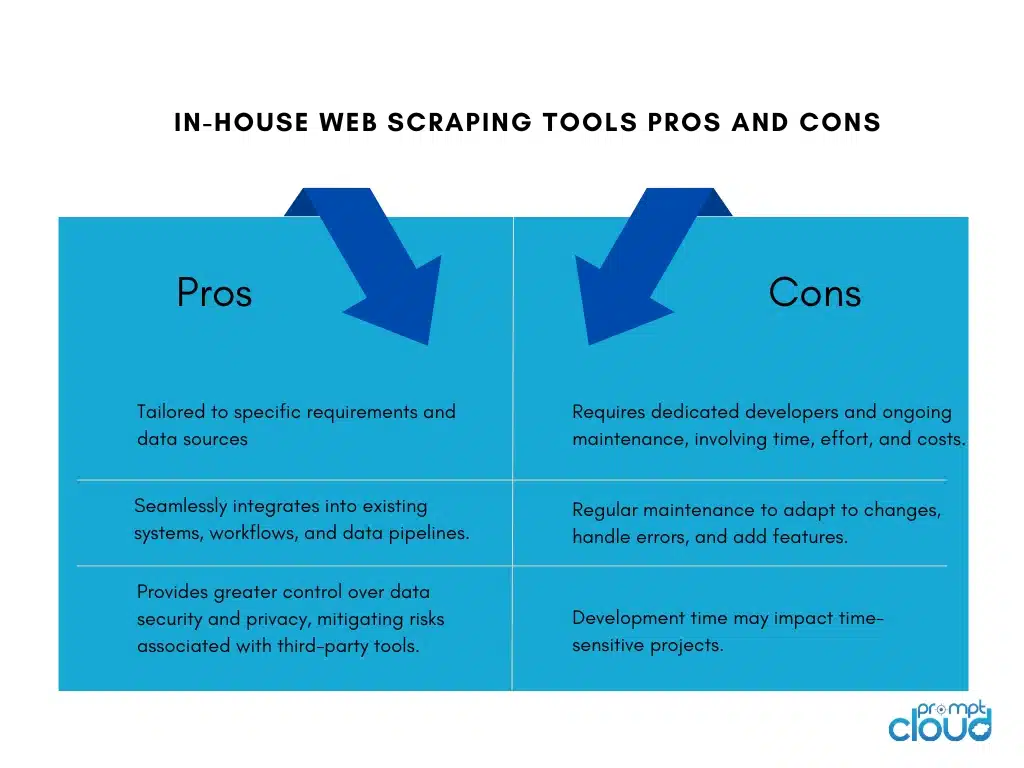

构建内部网络抓取工具

为公司构建内部网络抓取工具有其优点和缺点:

网页抓取服务

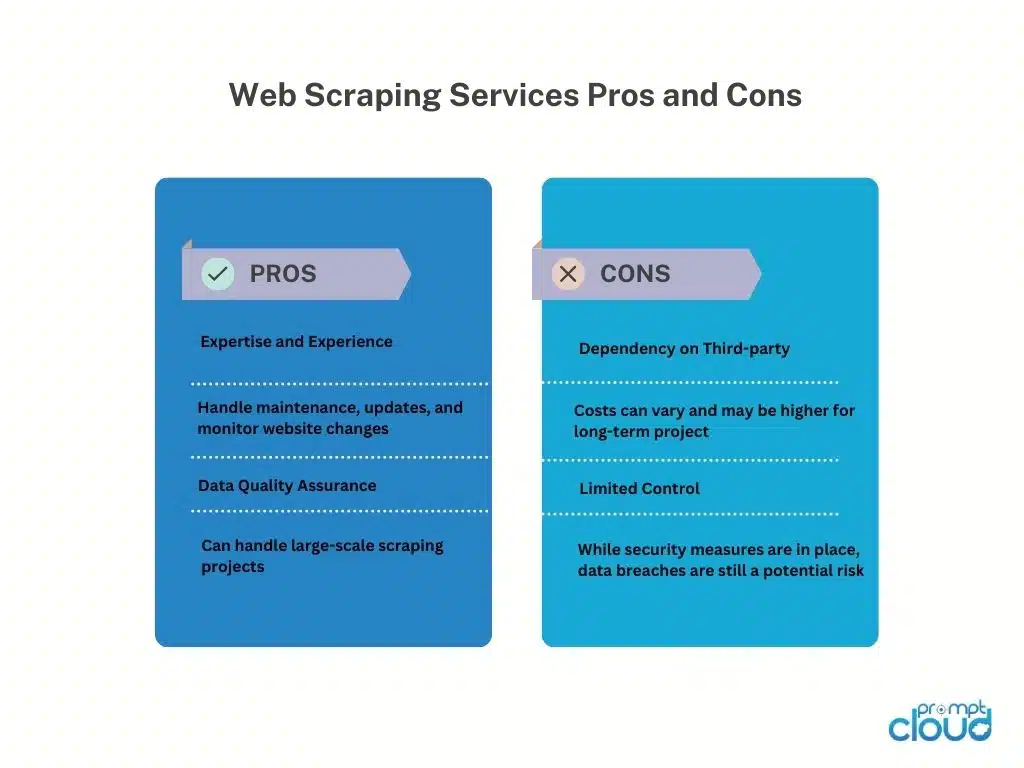

网络抓取服务提供商提供从网站提取数据的专业服务。 这些提供商通常拥有专门代表客户处理网络抓取任务的基础设施、工具和专业知识。

以下是使用网络抓取服务提供商的优点和缺点:

网页抓取 API

Web 抓取 API 提供了一个编程接口,允许开发人员使用标准化方法从网站访问和检索数据。 与传统的抓取技术相比,这些 API 提供了一种更加结构化和可控的网络抓取方法。 开发人员可以向 API 发送请求,指定所需的数据,并以结构化格式(例如 JSON 或 XML)接收抓取的数据。

优点

Web 抓取 API 简化了抓取过程,使开发人员能够专注于集成 API 和处理数据。 由于提供商的维护,它们提供可靠性和性能,并且可能包括身份验证和速率限制等功能。 API 还有助于遵守服务条款和法律要求。

缺点

使用网页抓取 API 有局限性。 数据可用性和功能取决于 API 提供商,可能对支持的网站和抓取限制有限制。 外部 API 依赖引入了对提供商可用性和性能的依赖,从而影响数据检索。 此外,可能存在与大批量或商业用途相关的成本。

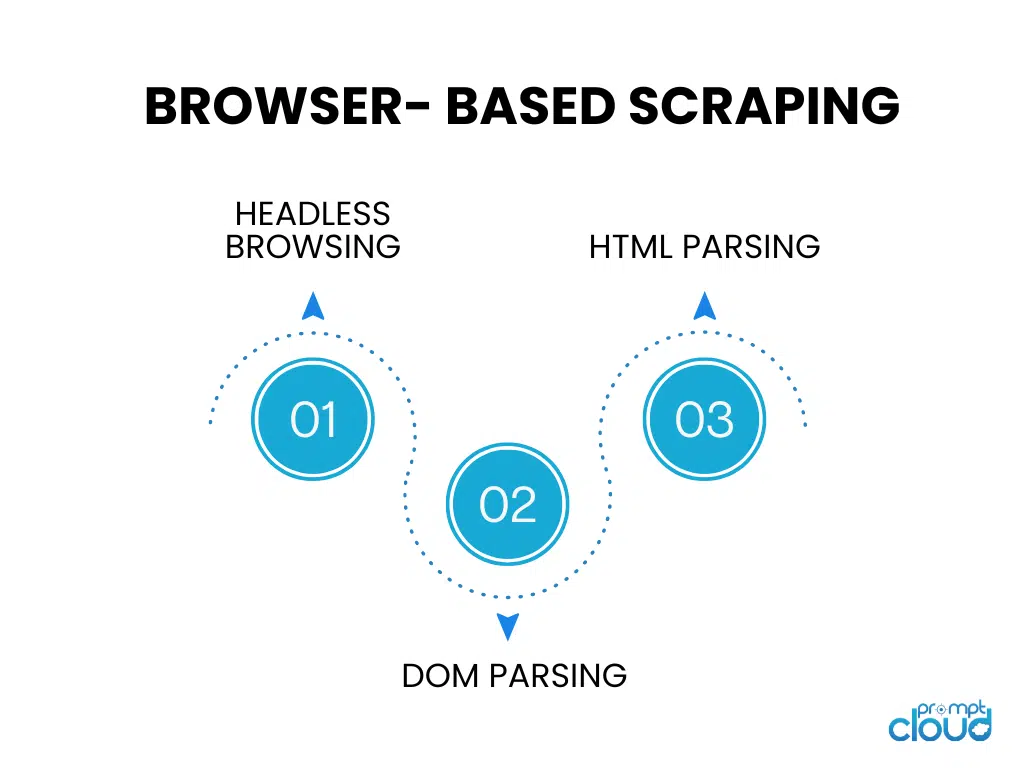

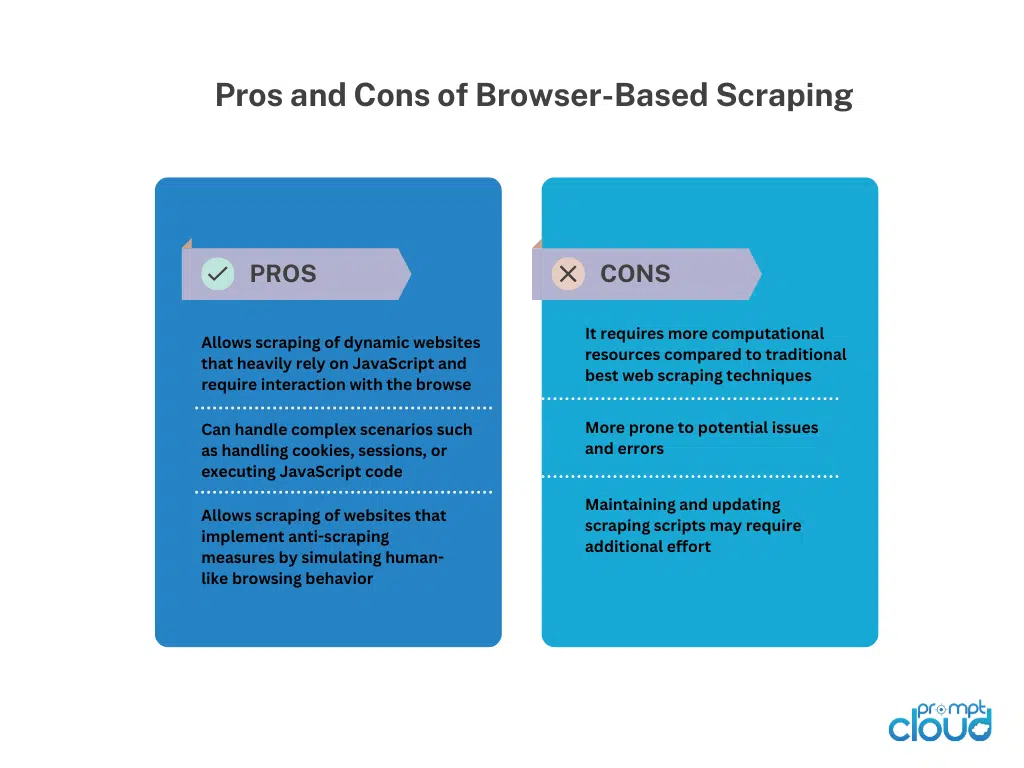

基于浏览器的抓取

无头浏览

无头浏览运行没有图形用户界面的网络浏览器,允许使用代码自动浏览网站并与之交互。 它非常适合抓取严重依赖客户端渲染的动态网站。

DOM解析

DOM 解析涉及通过访问文档对象模型来操作网页的 HTML 结构。 这使得能够以编程方式有针对性地提取元素、属性或文本。

HTML解析

HTML解析分析网页的HTML源代码以提取所需的数据。 它使用库或解析器来解释 HTML 结构并识别特定的标签、属性或数据提取模式。 HTML 解析通常用于在不执行 JavaScript 的情况下抓取静态网页。

手动网页抓取技术

手动网页抓取技术

手动网络抓取是指在不使用自动化工具或脚本的情况下手动从网站提取数据的过程。 它涉及人工干预来浏览网站、搜索相关信息以及使用各种技术提取数据。

手动网页抓取技术:

屏幕捕获:此技术涉及捕获网页的屏幕截图或视频,以提取难以以编程方式解析的视觉数据,例如图像、图表或表格。从捕获的媒体中手动提取可以进行数据检索。

数据输入:在数据输入中,需要从网页手动复制所需信息,并将其输入到所需的格式(例如电子表格或数据库)中。它涉及浏览网页、选择数据并将其输入目标目的地。 数据输入适用于易于复制和粘贴的结构化数据。

手动网页抓取在处理复杂网站、JavaScript 交互性或反抓取措施时提供了灵活性。 然而,它非常耗时,不太适合大规模任务,并且容易出现人为错误。 它需要人力、对细节的关注和仔细的执行。

混合网络抓取技术

混合网络抓取结合了自动化工具和手动干预,可以从网站中高效、准确地提取数据。 自动化工具处理重复性任务,例如导航和结构化数据提取,而手动技术(例如屏幕捕获或数据输入)则处理复杂的场景和视觉/非结构化数据。

混合网页抓取提供了自动化的可扩展性和速度,以及人类判断的灵活性。 它适合具有不同结构、动态内容或反抓取措施的网站。 选择取决于网站的复杂性、数据类型和可用资源,为全面的数据提取提供平衡的方法。