可解釋的人工智能如何開啟人工智能的負責任和道德發展

已發表: 2023-09-01隨著創新與獨創性相結合的變革時刻的出現,例如 2022 年 11 月 OpenAI 的 ChatGPT 的推出,人工智能控制我們生活的願景不再是科幻小說。

ChatGPT 的推出,迎來了業界所謂的“AI 寒武紀大爆發”的分水嶺。

然而,這不僅僅是利用人工智能獲取商業收益,這是當前爆炸式增長的焦點。 這一演變的核心是呼籲關注人工智能的可解釋性。 這將確保人工智能的進步既強大又透明——這是人工智能發展道德的基礎。

人工智能已經在許多領域為我們做出決策。 但不了解人工智能如何做出這些決策仍然是一個瓶頸。 這是企業家和技術專家不能忽視的一項可以解釋的人工智能優勢。

隨著技術的進步,技術專家面臨雙重挑戰:突破人工智能所能實現的界限,同時確保其工作透明、負責且符合道德規範。 這凸顯了可解釋的人工智能在現代技術中的作用。

人工智能的經濟潛力

生成式人工智能徹底改變生產力的潛力不僅僅是理論上的,而且是現實的。 它將在全球範圍內產生切實的經濟影響。 根據麥肯錫2023 年6 月發布的題為“生成式AI 的經濟潛力:下一個生產力前沿”的報告,在63 個分析用例中,生成式AI 每年可以增加2.6 萬億美元至4.4 萬億美元的價值。 還有一些可解釋的人工智能用例可以通過多種新穎的方式使行業受益。

另請閱讀:商業生成人工智能如何塑造行業

《華盛頓郵報》報導稱,超過 11,000 家公司已經使用了微軟雲部門提供的 OpenAI 工具,凸顯了伴隨這一潛力的採用趨勢。 這些數字代表了技術領導者在不斷變化的環境中駕馭的機會和責任。

隨著人工智能的變革潛力變得顯而易見,人們越來越重視可解釋的人工智能原則,以確保這些強大的工具在清晰、監督和道德考慮的情況下運行。 可解釋的人工智能應用程序將成為科技行業的基石。

然而,了解可解釋的人工智能優勢和其他相關方面僅僅是一個開始。 因此,在我們詳細討論可解釋人工智能開發的細微差別之前,我們必須首先了解它為何如此重要。

人工智能模型之謎:探索“黑匣子”

與所有重大進步一樣,人工智能也帶來了挑戰,其中一些挑戰與其結構密切相關。 這個謎團的一個方面就是“黑匣子”。 代表一個可行的封閉操作模型,但即使是開發人員有時也無法解釋它是如何工作的。 這在人工智能行業被稱為黑匣子難題。

對於許多人來說,這種缺乏透明度是不可接受的,尤其是那些負責關鍵業務或社會決策的人。 無法解釋的人工智能可能會削弱信任,尤其是在可能發生物理和物質損失的情況下。

不可預見的後果:當人工智能偏離軌道時

無法解釋的人工智能決策的後果可能是輕微的效率低下,也可能是重大的社會影響。 以金融部門為例:人工智能係統可能會在沒有提供明確理由的情況下拒絕向個人提供貸款。

這種缺乏透明度的決定可能會導致法律糾紛和聲譽受損。 從更大的範圍來看,在醫療保健領域,一個難以捉摸的人工智能可能會優先考慮一名患者而不是另一名患者進行治療,從而改變生活甚至結束生命。

人工智能意外結果和事故的真實例子

幾起事件凸顯了人工智能不可預見的後果。 2018 年涉及 Uber 自動駕駛汽車的悲慘事件凸顯了人工智能誤解其環境時所產生的可怕影響。 一項被發現存在種族偏見的著名醫療算法清楚地提醒我們,無論人工智能多麼先進,如果沒有得到充分理解和監控,人工智能都可能會無意中延續人類偏見。

這樣的例子不勝枚舉,從發推文“希特勒是對的”之類的微軟泰伊,到收到巨額信用卡賬單的美國國民。 如果沒有護欄和解釋人工智能所做決策的能力,此類情況將會不斷發生,因此需要可解釋性。

商業案例:可解釋的人工智能優勢

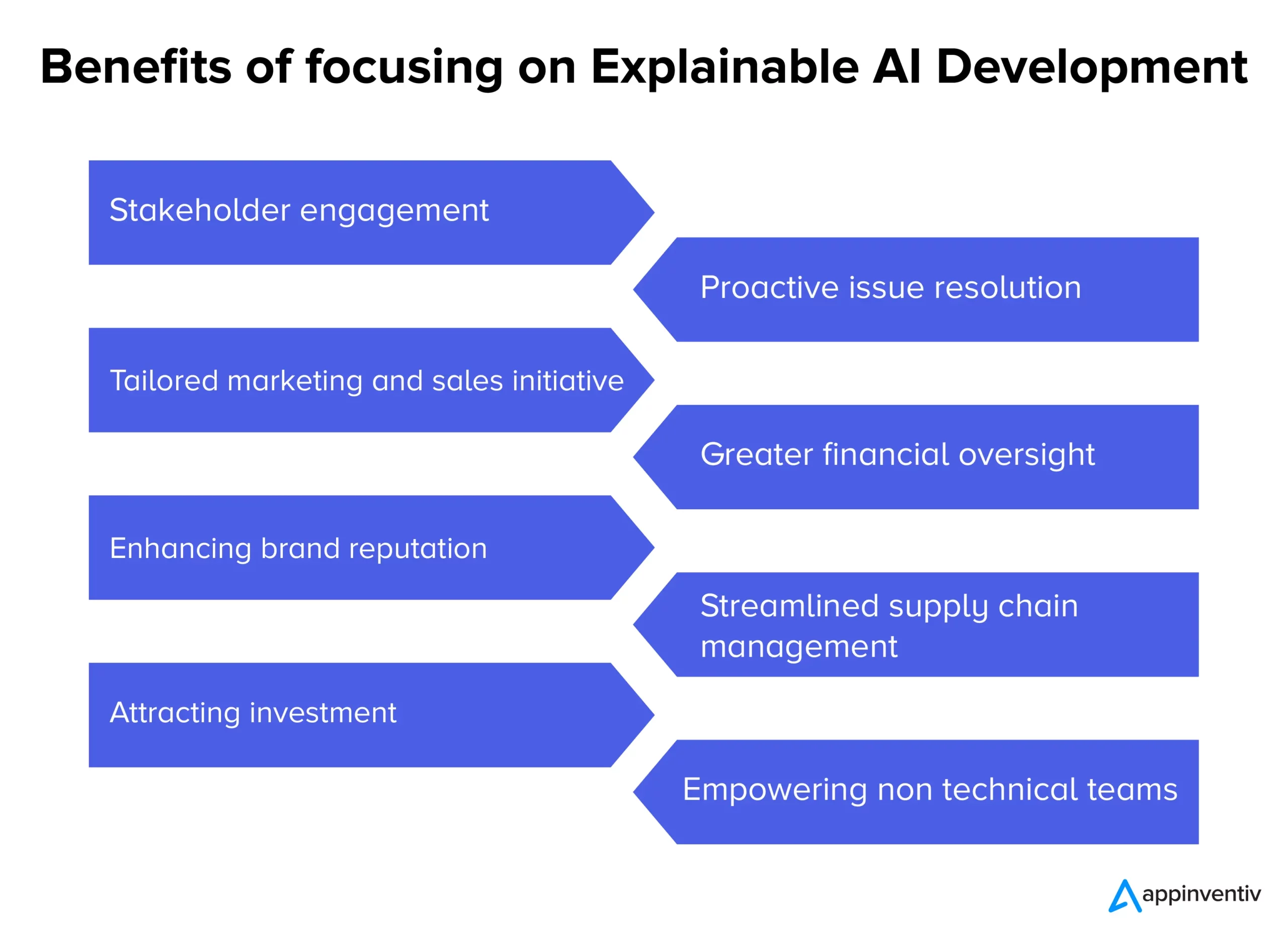

隨著人工智能係統越來越雄心勃勃,其固有的不透明性引發了圍繞透明度必要性的討論。 除了技術討論之外,還有強有力的商業理由支持採用可解釋的人工智能。 以下是人工智能為各行業企業帶來的各種可解釋的好處。

- 利益相關者的參與和信心:透明的人工智能決策流程可以在內部團隊和外部合作夥伴之間培養更深刻的參與感和保證感。

- 主動解決問題:在問題升級之前,可解釋的人工智能可以突出潛在的關注領域,從而實現及時干預和解決方案。

- 量身定制的營銷和銷售計劃:通過了解人工智能驅動的消費者洞察背後的“原因”,企業可以製定更加個性化和有效的營銷活動。

- 更大的財務監督:當人工智能驅動的財務模型和預測透明時,可以更容易地識別和解決潛在的異常或增長領域。

- 提高品牌聲譽:以道德和透明的人工智能部署而聞名的公司可能會享有更高的品牌聲譽。

- 簡化的供應鏈管理:借助清晰的人工智能驅動洞察,可以更有效地優化從庫存管理到物流的供應鏈流程。

- 吸引投資:對於投資者來說,人工智能的透明度可以表明公司對負責任創新的承諾,使其成為更具吸引力的投資主張。

- 為非技術團隊賦能:可解釋的人工智能可確保沒有深厚技術專業知識的團隊可以獲取並可操作人工智能驅動的見解和決策,從而促進跨部門協作。

當公司在現代複雜的環境中航行時,依賴黑盒解決方案可能是一場賭博。 人工智能流程的透明度不僅僅是技術升級,更是技術升級。 這是一種業務必要性,確保每項人工智能支持的舉措都符合更廣泛的組織目標和價值觀,這標誌著可解釋的人工智能的作用。 這些也是企業家和人工智能開發人員通常關注的可解釋的人工智能用例。

可解釋的人工智能模型的藍圖

如今,人工智能對我們日常生活的影響日益明顯,確保我們信任的能夠做出關鍵決策的機器在工作中準確且透明變得至關重要。

開發可解釋的人工智能模型不僅僅涉及編碼;還涉及編碼。 這是一個涉及戰略規劃、嚴格測試和基於可解釋的人工智能原理和可解釋的人工智能工具的迭代完善的過程。 這是分步指南和可解釋的人工智能技術,可確保我們開發的人工智能模型可解釋和解釋,同時也符合法律規定。

- 了解問題領域:在深入模型開發之前,我們清楚地了解問題領域和所涉及的利益相關者。 用戶期望什麼? 人工智能將做出哪些決策,以及這些決策將產生什麼影響,這些是我們尋找答案的一些問題。

- 選擇適當的數據:數據的質量和相關性直接影響人工智能的準確性和可解釋性。 在我們的人工智能模型開發中,我們確保數據乾淨、多樣化且沒有偏見。

- 選擇正確的模型:雖然某些模型(例如深度神經網絡)更複雜且更難以解釋,但其他模型(例如決策樹或線性回歸)可以提供更高的透明度。 在開發可解釋的人工智能模型時,我們選擇複雜性和清晰度之間的平衡。

- 迭代測試:我們定期使用不同的數據集測試模型,以確保性能一致。 這些測試的反饋可以為改進和改進提供信息。

- 集成可解釋性工具: LIME 或 SHAP 等工具有助於分解模型預測,提供有關哪些特徵影響特定決策的見解。

- 文檔:全面的文檔可幫助我們進行模型驗證、驗證和部署。 它確保從開發人員到最終用戶的所有利益相關者都了解人工智能的工作原理和局限性。

平衡模型性能與可解釋性

可解釋的人工智能軟件開發中最重大的挑戰之一是平衡模型的性能和可解釋性。 雖然複雜的模型可能會提供更高的準確性,但它們通常會以透明度為代價。 相反,更簡單的模型可能更容易理解,但可能無法有效捕捉數據中的細微差別。 為了達到適當的平衡,我們考慮以下因素:

- 模型簡單性與復雜性:我們確定實現令人滿意的性能所需的最低複雜性級別。 如果更簡單的模型就足夠了,那麼它可能是確保可解釋性的更好選擇。

- 使用可解釋性技術:特徵重要性排序或模型無關方法等技術可以幫助使復雜模型更易於解釋。

- 反饋循環:我們與最終用戶保持持續的反饋循環,以了解人工智能的決策是否明確以及是否有提高透明度的空間。

雖然實現可解釋的人工智能的過程可能看起來很複雜,但這是必要的。 隨著我們進一步將人工智能集成到我們的系統和流程中,確保這些高性能和透明的模型對於持續的信任和效率至關重要。

Appinventiv 如何幫助您開發可解釋的人工智能模型?

Appinventiv 擁有近九年的人工智能產品開發經驗,了解與人工智能模型開發相關的各種複雜性和可解釋的人工智能優勢。 我們的工程師開發了許多基於人工智能的平台和應用程序,包括 Mudra(一款人工智能驅動的個人理財應用程序),擁有領域專業知識和監督,可以實現可解釋的人工智能開發。

無論您的人工智能項目是什麼,作為領先的人工智能開發公司,我們都可以解鎖您的人工智能模型的可解釋性和可解釋性,以便您可以自信地信任模型做出的決策。 立即聯繫我們,踏上負責任的人工智能之旅。

經常問的問題

問:什麼是可解釋的人工智能?

A.可解釋的人工智能是人工智能開發的範式轉變,它要求以這樣的方式開發人工智能模型:人工智能模型做出的決策可以被追溯,並且用戶可以理解人工智能模型是如何做出決策的。

問:可解釋的人工智能是如何工作的?

答:可解釋的人工智能的工作原理是在開發過程中將可解釋性的關鍵要素集成到人工智能模型中,這有助於確定人工智能模型如何做出特定的決策。

問:為什麼可解釋的人工智能很重要?

答:可解釋的人工智能很重要,因為不了解人工智能模型如何為我們做出決策可能會導致一些可怕的後果,在最壞的情況下,可能會對相關人工智能模型的公司或用戶造成切實的傷害。