如何在開發 AI 產品時避免合規性違規

已發表: 2023-06-12多年來,人工智能憑藉其在製造、醫療保健和金融等數據和機器密集型領域的貢獻,一直保持著頂級技術趨勢。 然而,直到最近兩年,該技術才引起最終用戶的高度關注。 借助圖像和文本生成器等應用程序,人們現在只需單擊一下即可生成視覺效果和文本。

雖然這些人工智能平台看起來像是從頭開始生產材料,但事實並非如此——這些人工智能平台已經接受了問題片段和數據湖的培訓,這些平台通過處理來自互聯網的文本和圖像檔案來工作。 儘管對最終用戶有用,但該方法會帶來版權侵權、不遵守開源許可證和知識產權侵權等法律風險。全球各國政府並非沒有看到生成人工智能帶來的這些風險,這些風險不斷湧現圍繞不道德的 AI 模型製定新的規則和處罰。

對於準備啟動其 AI 項目的公司而言,至關重要的是,他們了解風險並構建一個不會因這些道德問題而受到法律監管的系統。 在本文中,我們將深入探討軟件開發過程中 AI 合規性的多個方面——法律問題的類型、為 AI 監管做準備的方法,以及不同地區遵循的 AI 行為。

什麼是 AI 合規性?

這是一個確保 AI 驅動的應用程序符合其運行所在地區的法規和法律的過程。以下是 AI 合規性檢查的不同因素:

人工智能的法律問題

雖然在微觀層面上,最終用戶使用人工智能的問題似乎僅限於剽竊或訪問不可共享的數據,但在宏觀層面上,不合規人工智能會帶來更大的挑戰。

使用構建不當的人工智能係統所帶來的威脅會影響公平競爭、網絡安全、消費者保護,甚至公民權利。 因此,企業和政府建立公平、合乎道德的模式至關重要。

版權

隨著生成式 AI 的出現,企業已開始通過技術創建版權材料。 這樣做的問題在於無法理解數據是由作者的創造力生成的,還是作者是人工智能。

為了使其符合法律要求,版權局發布了關於審查和註冊包含 AI 生成材料的作品的指南。 它指出以下內容 -

- 版權只能保護人類創造力產生的材料。

- 對於使用基於 AI 的材料的作品,將考慮 AI 的貢獻是來自“機械複製”還是作者的“自己的原創概念,他們通過 AI 賦予其可見的形式”。

- 申請人有義務在提交註冊的材料中披露基於人工智能的內容。

另請閱讀:2023 年開發 AI 內容檢測工具的成本

開源

AI 驅動的代碼生成器通常使用 AI 來協助開發人員自動完成或在開發人員測試或輸入後建議代碼。 以下是與圍繞代碼生成器開發合規人工智能模型相關的一些挑戰——

- 用開源代碼訓練AI模型是否構成侵權?

- 誰負責滿足開源合規性標準——開發人員還是用戶?

- 開發人員使用基於 AI 的代碼創建新軟件是否需要應用程序獲得開源許可?

知識產權侵權

在全球範圍內,針對 AI 工具提起了多起侵權訴訟,指控它們基於第三方受 IP 保護的內容來訓練模型或生成輸出。

道德偏見

AI人臉識別技術導致種族歧視的事件不勝枚舉。 無論是在 2020 年,黑人因電腦錯誤被捕,還是谷歌照片將黑人標記為“大猩猩”。 無論技術多麼聰明,都不能忽視它是由帶有偏見的人創造的

對於希望構建類似解決方案的公司來說,不要讓這些偏見進入系統至關重要。

人工智能項目的 GDPR 合規性

話雖這麼說,但了解為什麼企業在嚴格監管的情況下仍無法構建合規的 AI 模型至關重要。 其背後可能有多種原因,包括無法了解合規性、開發人員缺乏理解,有時甚至是簡單的無知。 但是,其背後也可能有一些功能性原因。

讓我們從 AI 項目的 GDPR 合規性的角度來研究其中的一些。

目的限制

GDPR 原則要求企業有必要告知數據主體收集和處理其信息的目的。 挑戰在於該技術使用數據來尋找模式並獲得新的見解,但這可能不是該數據的真正目的。

歧視

GDPR 要求 AI 開發人員採取措施應對該技術可能帶來的歧視性影響。 雖然這是當下的道德需求,但對於運營快速變化的社會場景的開發人員來說,針對每一種歧視和不道德的輸出準備 AI 模型可能會變得具有挑戰性。

數據最小化

GDPR 規定收集的信息應該“充分、有限且相關”。 這意味著人工智能開發團隊在為他們的模型使用數據時應該非常小心,並且必須清楚他們的項目所需的數據量。

然而,這是不可預測的,因此團隊必須定期評估滿足數據最小化要求所需的數據類型和數量。

透明度

最後,用戶應該對第三方如何使用他們的數據有發言權,為此,企業需要清楚他們正在使用什麼數據以及如何使用。

這樣做的問題是,大多數人工智能模型都是在黑匣子中運行的,並且不清楚它們是如何做出決策的,尤其是當我們談論高級軟件時。

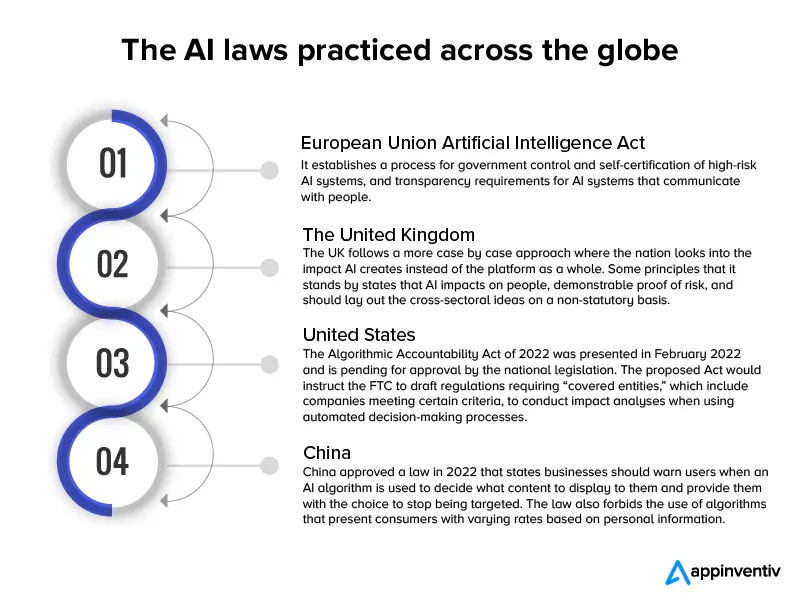

儘管這些都是真正的技術問題,但在涉及 IT 道德時,企業不要將它們用作開發有缺陷的 AI 模型的盾牌,這一點至關重要。 為了確保這種做法不會成為主流,已經在全球範圍內製定了幾項人工智能法律。

自 2017 年以來,近 60 個國家出台了人工智能法律法規,其行動路線與新人工智能模型的實施速度相匹配。

這是一張信息圖,簡要介紹了這些法律。

既然我們已經從法律的角度和全球適用法律的粗略草案研究了 AI 發展的挑戰,讓我們開始討論構建合規 AI 應用程序的方法。

另請閱讀:開發像 ChatGPT 這樣合法合規的聊天機器人需要多少錢

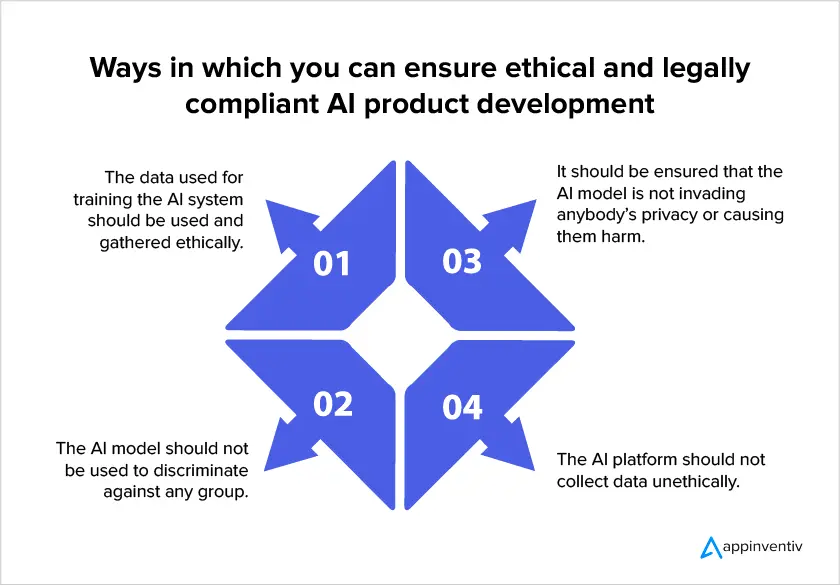

如何開發合規友好的 AI 模型

由於全球範圍內人工智能法規的增多,企業在構建人工智能模型時關注法律合規性變得至關重要。 以下是公司在投資 AI 開發服務時可以確保其項目合法合規的一些方法。

- 確保您被允許使用數據

人工智能合規性規定,用戶隱私應該是模型設計的指導原則。 這意味著您應該將需要收集的數據量保持在最低限度,指定收集數據的確切原因,以及您將使用他們的數據的時間。 最後,重要的是要注意用戶應該同意數據收集。

- 可解釋的人工智能方法

這種方法通過幫助人類了解 AI 系統內部的內容以及模型如何做出決策來幫助解決黑盒效應。 反過來,這有助於研究人員了解他們需要的確切數據量,以提高模型準確性以滿足數據最小化要求。

- 跟踪收集的數據

AI 合規性要求企業了解收集的 PII 的位置和用途。 需要正確的數據分類以符合用戶對受保護信息的權利。 此外,企業必須有一種方法來了解哪些信息存儲在哪些數據集中,以準備準確的安全措施。

- 了解跨國數據傳輸規則

當人工智能係統中存在數據跨境傳輸時,開發者應考慮接收國適用的法規,並據此建立適當的數據傳輸機制。 例如,如果 GDPR 適用於數據處理並且個人數據被傳輸到非 EEA 國家/地區,則應進行適當的傳輸影響評估。

在開發 AI 應用程序時使用此類方法對確保妥善解決與該技術相關的風險大有幫助。 然而,公司和監管機構應該注意這樣一個事實,即不可能保護應用程序免受每一個潛在風險,因為行業環境是在個案模型上運作的。 正因為如此,人工智能風險管理者的作用將仍然至關重要,因為他們將能夠判斷何時需要干預。

我們希望本文能幫助您了解未來對人工智能技術的法律結構有何期待,以及如何為合規的人工智能模型做好準備。

常見問題

問:人工智能是否存在任何法律問題?

答:是的。 構建不良的人工智能模型可能會引發許多法律和倫理問題。

- 版權

- 開源許可證濫用

- 知識產權侵權

- 種族歧視等道德偏見。

Q. 為什麼做一個合法合規的AI模型這麼難?

答:在技術方面,構建合法合規的 AI 可能很困難,因為雖然該技術使用客戶的數據來尋找模式並獲得新的見解,但很難確定該數據的真正用途。 其次,人工智能開發團隊永遠無法確定他們的項目所需的數據量。 最後,大多數 AI 模型都在黑匣子中運行,並且不清楚它們是如何做出決策的,尤其是當我們談論高級軟件時。

Q. 如何確保人工智能的合法合規性?

答:儘管有關 AI 合規性的法律法規在不斷發展,但您可以採取以下措施來確保您的模型最接近合規性——

- 確保您被允許使用數據

- 可解釋的人工智能方法

- 跟踪收集的數據

- 了解跨國數據傳輸規則